Archivado de notas de la versión

Resumen

Azure HDInsight es uno de los servicios más populares entre los clientes de empresa para el análisis de código abierto en Azure. Suscríbase a las notas de la versión de HDInsight para obtener información actualizada sobre HDInsight y todas las versiones de HDInsight.

Para suscribirse, haga clic en el botón "inspeccionar" en el banner y esté atento a las versiones de HDInsight.

Información de la versión

Fecha de publicación: 22 de octubre de 2024

Nota:

Se trata de una versión de revisión y mantenimiento para el proveedor de recursos. Para obtener más información, consulte Proveedor de recursos.

Azure HDInsight publica periódicamente actualizaciones de mantenimiento para ofrecer correcciones de errores, mejoras de rendimiento y revisiones de seguridad, lo que garantiza mantenerse al día con estas actualizaciones garantiza un rendimiento y confiabilidad óptimos.

Esta nota de versión se aplica a

Versión de HDInsight 5.1.

Versión de HDInsight 5.0.

Versión de HDInsight 4.0.

La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta nota de la versión es aplicable al número de imagen 2409240625. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

Para ver versiones específicas de la carga de trabajo, consulte Versiones de componentes de HDInsight 5.x.

Actualizado

Compatibilidad con la autenticación basada en MSI disponible para Azure Blob Storage.

- Azure HDInsight ahora admite la autenticación basada en OAuth para acceder a Azure Blob Storage aprovechando Azure Active Directory (AAD) e identidades administradas (MSI). Con esta mejora, HDInsight usa identidades administradas asignadas por el usuario para acceder a Azure Blob Storage. Para más información, consulte Identidades administradas para los recursos de Azure.

El servicio HDInsight ha realizando la transición para usar equilibradores de carga estándar para todas sus configuraciones de clúster debido al anuncio de desuso del equilibrador de carga básico de Azure.

Nota:

Este cambio está disponible en todas las regiones. Vuelva a crear el clúster para consumir este cambio. Para obtener ayuda, póngase en contacto con el equipo de soporte técnico.

Importante

Cuando utilice su propia red virtual (VNet personalizada) durante la creación del clúster, tenga en cuenta que la creación del clúster no se realizará correctamente una vez que se habilite este cambio. Se recomienda hacer referencia a la guía de migración para volver a crear el clúster. Para obtener ayuda, póngase en contacto con el equipo de soporte técnico.

Próximamente

Próximamente

Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

Notificaciones de retirada para HDInsight 4.0 y HDInsight 5.0.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A.

Estamos escuchando: Le invitamos a agregar más ideas y otros temas aquí y votarlos: Ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight.

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de lanzamiento: 30 de agosto de 2024

Nota:

Se trata de una versión de revisión y mantenimiento para el proveedor de recursos. Para obtener más información, consulte Proveedor de recursos.

Azure HDInsight publica periódicamente actualizaciones de mantenimiento para ofrecer correcciones de errores, mejoras de rendimiento y revisiones de seguridad, lo que garantiza mantenerse al día con estas actualizaciones garantiza un rendimiento y confiabilidad óptimos.

Esta nota de versión se aplica a

Versión de HDInsight 5.1.

Versión de HDInsight 5.0.

Versión de HDInsight 4.0.

La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta nota de versión es aplicable al número de imagen 2407260448. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

Para ver versiones específicas de la carga de trabajo, consulte Versiones de componentes de HDInsight 5.x.

Problema corregido

- Corrección de errores de base de datos predeterminada.

Próximamente

-

Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

- Notificaciones de retirada para HDInsight 4.0 y HDInsight 5.0.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A.

Estamos escuchando: Le invitamos a agregar más ideas y otros temas aquí y votarlos: Ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight.

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de lanzamiento: 09 de agosto de 2024

Esta nota de versión se aplica a

Versión de HDInsight 5.1.

Versión de HDInsight 5.0.

Versión de HDInsight 4.0.

La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta nota de versión es aplicable al número de imagen 2407260448. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

Para ver versiones específicas de la carga de trabajo, consulte Versiones de componentes de HDInsight 5.x.

Actualizaciones

Adición del agente de Azure Monitor para Log Analytics en HDInsight

Adición de SystemMSI y DCR automatizado para Log Analytics, dada la desuso de Nueva experiencia de Azure Monitor (versión preliminar).

Nota:

El número de imagen efectivo 2407260448, los clientes que usan el portal para análisis de registros tendrán una experiencia predeterminada de Agente de Azure Monitor. En caso de que desee cambiar a la experiencia de Azure Monitor (versión preliminar), puede anclar los clústeres a imágenes antiguas mediante la creación de una solicitud de soporte técnico.

Fecha de lanzamiento: 05 de julio de 2024

Nota:

Se trata de una versión de revisión y mantenimiento para el proveedor de recursos. Para obtener más información, consulte Proveedor de recursos

Problemas corregidos

Las etiquetas HOBO sobrescriben las etiquetas de usuario.

- Las etiquetas HOBO sobrescriben etiquetas de usuario en subrecursos en la creación de clústeres de HDInsight.

Fecha de lanzamiento: 19 de junio de 2024

Esta nota de versión se aplica a

Versión de HDInsight 5.1.

Versión de HDInsight 5.0.

Versión de HDInsight 4.0.

La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta nota de versión es aplicable al número de imagen 2406180258. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

Para ver versiones específicas de la carga de trabajo, consulte Versiones de componentes de HDInsight 5.x.

Problemas corregidos

Mejoras de seguridad

Mejoras en Log Analytics de HDInsight con compatibilidad con identidad administrada del sistema para el proveedor de recursos de HDInsight.

Adición de una nueva actividad para actualizar la versión del agente de

mdsdpara la imagen anterior (creada antes de 2024).Habilitación de MISE en la puerta de enlace como parte de las mejoras continuas de Migración de MSAL.

Incorpore Spark Thrift Server

Httpheader hiveConfa Jetty HTTP ConnectionFactory.Revierte RANGER-3753 y RANGER-3593.

La implementación

setOwnerUserdada en la versión de Ranger 2.3.0 tiene un problema de regresión crítico cuando Hive lo usa. En Ranger 2.3.0, cuando HiveServer2 intenta evaluar las directivas, Ranger Client intenta obtener el propietario de la tabla de hive llamando a metastore en la función setOwnerUser que básicamente realiza una llamada al almacenamiento para comprobar el acceso a esa tabla. Este problema hace que las consultas se ejecuten lentamente cuando Hive se ejecuta en 2.3.0 Ranger.

Nuevas regiones agregadas

- Norte de Italia

- Centro de Israel

- Centro de España

- Centro de México

- JIO de India central

Agregar a las notas de archivo de junio de 2024

Próximamente

-

Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

- Notificaciones de retirada para HDInsight 4.0 y HDInsight 5.0.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A.

Estamos escuchando: Le invitamos a agregar más ideas y otros temas aquí y votarlos: Ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight.

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de publicación: 16 de mayo de 2024

Esta nota de versión se aplica a

Versión de HDInsight 5.0.

Versión de HDInsight 4.0.

La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta nota de versión es aplicable al número de imagen 2405081840. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

Para ver versiones específicas de la carga de trabajo, consulte Versiones de componentes de HDInsight 5.x.

Problemas corregidos:

- Se ha agregado la API en la puerta de enlace para obtener el token de Keyvault, como parte de la iniciativa SFI.

- En la nueva tabla monitor de registro

HDInsightSparkLogs, para el tipo de registroSparkDriverLog, faltaban algunos de los campos. Por ejemplo,LogLevel & Message. Esta versión agrega los campos que faltan a los esquemas y corrige el formato deSparkDriverLog. - Los registros de Livy no están disponibles en la tabla de supervisión

SparkDriverLogde Log Analytics, lo que se debe a un problema con la ruta de acceso del origen del registro de Livy y el análisis de registros regex en las configuracionesSparkLivyLog. - Cualquier clúster de HDInsight, con ADLS Gen2 como cuenta de almacenamiento principal, puede aprovechar el acceso basado en MSI a cualquiera de los recursos de Azure (por ejemplo, SQL, Keyvaults) que se usa en el código de la aplicación.

Próximamente

-

Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

- Notificaciones de retirada para HDInsight 4.0 y HDInsight 5.0.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A.

Estamos escuchando: Le invitamos a agregar más ideas y otros temas aquí y votarlos: Ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight.

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de versión: 15 de abril de 2024

Esta nota de versión se aplica a la versión de HDInsight 5.1.

La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta nota de versión es aplicable al número de imagen 2403290825. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

Para ver versiones específicas de la carga de trabajo, consulte Versiones de componentes de HDInsight 5.x.

Problemas corregidos:

- Correcciones de errores para Ambari DB, Hive Warehouse Controller (HWC), Spark, HDFS

- Correcciones de errores para el módulo de Log Analytics para HDInsightSparkLogs

- Correcciones de CVE para Proveedor de recursos de HDInsight.

Próximamente

-

Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

- Notificaciones de retirada para HDInsight 4.0 y HDInsight 5.0.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A.

Estamos escuchando: Le invitamos a agregar más ideas y otros temas aquí y votarlos: Ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight.

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de lanzamiento: 15 de febrero de 2024

Esta versión se aplica a las versiones de HDInsight 4.x y 5.x. La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta versión es aplicable al número de imagen 2401250802. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

En el caso de las versiones específicas de la carga de trabajo, consulte

Nuevas características

- Compatibilidad de Apache Ranger con Spark SQL en Spark 3.3.0 (HDInsight versión 5.1) con el paquete de seguridad Enterprise. Obtenga más información al respecto aquí.

Problemas corregidos:

- Correcciones de seguridad de los componentes de Ambari y Oozie

Próximamente

Próximamente

- Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A

Estamos escuchando: Le damos la bienvenida para agregar más ideas y otros temas aquí y votarlos: ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Pasos siguientes

- Azure HDInsight: Preguntas más frecuentes

- Configuración de la programación de aplicación de revisiones del SO para clústeres de HDInsight basado en Linux

- Notas de la versión anteriores

Azure HDInsight es uno de los servicios más populares entre los clientes de empresa para el análisis de código abierto en Azure. Si quiere suscribirse a las notas de la versión, vea las versiones de este repositorio de GitHub.

Fecha de publicación: 10 de enero de 2024

Esta versión de revisión se aplica a las versiones de HDInsight 4.x y 5.x. La versión de HDInsight se pondrá a disposición de todas las regiones durante varios días. Esta versión es aplicable al número de imagen 2401030422. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota:

Ubuntu 18.04 es compatible con el mantenimiento extendido de seguridad (ESM) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

En el caso de las versiones específicas de la carga de trabajo, consulte

Problemas corregidos

- Correcciones de seguridad de los componentes de Ambari y Oozie

Próximamente

Próximamente

- Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A

Estamos escuchando: Le damos la bienvenida para agregar más ideas y otros temas aquí y votarlos: ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de publicación: 26 de octubre de 2023

Esta versión se aplica a la versión de HDInsight 4.x y 5.x. HDInsight estará disponible para todas las regiones durante varios días. Esta versión es aplicable al número de imagen 2310140056. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

En el caso de las versiones específicas de la carga de trabajo, consulte

Novedades

HDInsight anuncia la disponibilidad general de HDInsight 5.1 a partir del 1 de noviembre de 2023. Esta versión incluye una actualización de pila completa a los componentes de código abierto y las integraciones de Microsoft.

- Últimas versiones de código abierto: HDInsight 5.1 viene con la última versión estable de código abierto disponible. Los clientes pueden beneficiarse de todas las características de código abierto más recientes, mejoras de rendimiento de Microsoft y correcciones de errores.

- Seguro: las últimas versiones incluyen las correcciones de seguridad más recientes, tanto de código abierto como de Microsoft.

- Menor TCO: con mejoras de rendimiento, los clientes pueden reducir el costo operativo, junto con la escalabilidad automática mejorada.

Permisos de clúster para un almacenamiento seguro

- Los clientes pueden especificar (durante la creación del clúster) si se debe usar un canal seguro para los nodos de clúster de HDInsight para conectar la cuenta de almacenamiento.

Creación de clústeres de HDInsight con redes virtuales personalizadas.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

Microsoft Network/virtualNetworks/subnets/join/actionpara realizar operaciones de creación. El cliente podría enfrentar errores de creación si esta comprobación no está habilitada.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

Clústeres ABFS que no son ESP [Permisos de clúster para lectura de Word]

- Los clústeres ABFS que no son de ESP restringen a los usuarios de grupos que no son de Hadoop a ejecutar comandos de Hadoop para las operaciones de almacenamiento. Este cambio mejora la posición de seguridad del clúster.

Actualización de cuota insertada.

- Ahora puede solicitar un aumento de cuota directamente desde la página Mi cuota. Con la llamada a la API directa es mucho más rápido. En caso de que se produzca un error en la llamada API, puede crear una nueva solicitud de soporte técnico para el aumento de la cuota.

Próximamente

Próximamente

La longitud máxima del nombre del clúster se cambiará de 59 a 45 caracteres para mejorar la posición de seguridad de los clústeres. Este cambio se implementará en todas las regiones a partir de la próxima versión.

Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024, retiraremos las máquinas virtuales básicas y estándar de la serie A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD).

- Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A

Estamos escuchando: Le damos la bienvenida para agregar más ideas y otros temas aquí y votarlos: ideas de HDInsight y seguirnos para obtener más actualizaciones sobre Comunidad de AzureHDInsight

Nota:

Esta versión aborda los siguientes CVE publicados por MSRC el 12 de septiembre de 2023. La acción es actualizar a la imagen más reciente 2308221128 o 2310140056. Se recomienda a los clientes planear en consecuencia.

| CVE | severity | Título de CVE | Comentario |

|---|---|---|---|

| CVE-2023-38156 | Importante | Vulnerabilidad de elevación de privilegios de Apache Ambari de Azure HDInsight | Se incluye en 2308221128 de imagen o 2310140056 |

| CVE-2023-36419 | Importante | Vulnerabilidad de elevación de privilegios de Apache Oozie Workflow Scheduler de Azure HDInsight | Aplicar acción Script en los clústeres o actualizar a la imagen 2310140056 |

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de publicación: 7 de septiembre de 2023

Esta versión se aplica a la versión de HDInsight 4.x y 5.x. HDInsight estará disponible para todas las regiones durante varios días. Esta versión es aplicable al número de imagen 2308221128. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

En el caso de las versiones específicas de la carga de trabajo, consulte

Importante

Esta versión aborda los siguientes CVE publicados por MSRC el 12 de septiembre de 2023. La acción es actualizar a la imagen más reciente 2308221128. Se recomienda a los clientes planear en consecuencia.

| CVE | severity | Título de CVE | Comentario |

|---|---|---|---|

| CVE-2023-38156 | Importante | Vulnerabilidad de elevación de privilegios de Apache Ambari de Azure HDInsight | Incluida en la imagen de 2308221128 |

| CVE-2023-36419 | Importante | Vulnerabilidad de elevación de privilegios de Apache Oozie Workflow Scheduler de Azure HDInsight | Aplicación de la acción Script en los clústeres |

Próximamente

- La longitud máxima del nombre del clúster se cambiará de 59 a 45 caracteres para mejorar la posición de seguridad de los clústeres. Este cambio se implementará el 30 de septiembre de 2023.

- Permisos de clúster para un almacenamiento seguro

- Los clientes pueden especificar (durante la creación del clúster) si se debe usar un canal seguro para que los nodos de clúster de HDInsight se comuniquen con la cuenta de almacenamiento.

- Actualización de cuota insertada.

- Las cuotas de solicitud aumentan directamente desde la página Mi cuota, que será una llamada API directa, que es más rápida. Si se produce un error en la llamada API, los clientes deben crear una nueva solicitud de soporte técnico para aumentar la cuota.

- Creación de clústeres de HDInsight con redes virtuales personalizadas.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

Microsoft Network/virtualNetworks/subnets/join/actionpara realizar operaciones de creación. Los clientes deberán planificar en consecuencia, ya que este cambio será una comprobación obligatoria para evitar errores en la creación de clústeres antes del 30 de septiembre de 2023.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

- Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024 retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD). Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

- Clústeres ABFS que no son ESP [Permisos de clúster para lectura de Word]

- Planee introducir un cambio en los clústeres de ABFS que no son de ESP, lo que impide que los usuarios que no son de Hadoop ejecuten comandos de Hadoop para las operaciones de almacenamiento. Este cambio para mejorar la posición de seguridad del clúster. Los clientes deben planear las actualizaciones antes del 30 de septiembre de 2023.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A

Le invitamos a agregar más propuestas e ideas y otros temas aquí y votar por ello: HDInsight Community (azure.com).

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de publicación: 25 de julio de 2023

Esta versión se aplica a la versión de HDInsight 4.x y 5.x. HDInsight estará disponible para todas las regiones durante varios días. Esta versión es aplicable al número de imagen 2307201242. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

En el caso de las versiones específicas de la carga de trabajo, consulte

Novedades

Novedades

- HDInsight 5.1 ahora es compatible con el clúster de ESP.

- La versión actualizada de Ranger 2.3.0 y Oozie 5.2.1 ahora forman parte de HDInsight 5.1

- El clúster de Spark 3.3.1 (HDInsight 5.1) viene con Hive Warehouse Connector (HWC) 2.1, que funciona junto con el clúster de Interactive Query (HDInsight 5.1).

- Ubuntu 18.04 es compatible con ESM (mantenimiento extendido de seguridad) por el equipo Azure Linux para Azure HDInsight de julio de 2023, versiones posteriores.

Importante

Esta versión aborda los siguientes CVE publicados por MSRC el 8 de agosto de 2023. La acción es actualizar a la imagen más reciente 2307201242. Se recomienda a los clientes planear en consecuencia.

| CVE | severity | Título de CVE |

|---|---|---|

| CVE-2023-35393 | Importante | Vulnerabilidad de suplantación de identidad de Apache Hive |

| CVE-2023-35394 | Importante | Vulnerabilidad de suplantación de identidad de Azure HDInsight Jupyter Notebook |

| CVE-2023-36877 | Importante | Vulnerabilidad de suplantación de identidad de Azure Apache Oozie |

| CVE-2023-36881 | Importante | Vulnerabilidad de suplantación de identidad de Azure Apache Ambari |

| CVE-2023-38188 | Importante | Vulnerabilidad de suplantación de identidad de Azure Apache Hadoop |

Próximamente

Próximamente

- La longitud máxima del nombre del clúster se cambiará de 59 a 45 caracteres para mejorar la posición de seguridad de los clústeres. Los clientes deben planear las actualizaciones antes del 30 de septiembre de 2023.

- Permisos de clúster para un almacenamiento seguro

- Los clientes pueden especificar (durante la creación del clúster) si se debe usar un canal seguro para que los nodos de clúster de HDInsight se comuniquen con la cuenta de almacenamiento.

- Actualización de cuota insertada.

- Las cuotas de solicitud aumentan directamente desde la página Mi cuota, que será una llamada API directa, que es más rápida. Si se produce un error en la llamada API, los clientes deben crear una nueva solicitud de soporte técnico para aumentar la cuota.

- Creación de clústeres de HDInsight con redes virtuales personalizadas.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

Microsoft Network/virtualNetworks/subnets/join/actionpara realizar operaciones de creación. Los clientes deberán planificar en consecuencia, ya que este cambio será una comprobación obligatoria para evitar fallas en la creación de clústeres antes del 30 de septiembre de 2023.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

- Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024, retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD). Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

- Clústeres ABFS que no son ESP [Permisos de clúster para lectura de Word]

- Planee introducir un cambio en los clústeres de ABFS que no son de ESP, lo que impide que los usuarios que no son de Hadoop ejecuten comandos de Hadoop para las operaciones de almacenamiento. Este cambio para mejorar la posición de seguridad del clúster. Los clientes deben planear las actualizaciones antes del 30 de septiembre de 2023.

Si tiene más preguntas, póngase en contacto con el Soporte técnico de Azure.

Puede obtener más información sobre HDInsight en Azure HDInsight: Microsoft Q&A

Le damos la bienvenida para agregar más propuestas e ideas y otros temas aquí y votar por ellos: HDInsight Community (azure.com) y seguirnos para obtener más actualizaciones sobre X

Nota:

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de publicación: 8 de mayo de 2023

Esta versión se aplica a la versión de HDInsight 4.x y 5.x. HDInsight está disponible para todas las regiones durante varios días. Esta versión es aplicable al número de imagen 2304280205. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

En el caso de las versiones específicas de la carga de trabajo, consulte

![]()

Azure HDInsight 5.1 actualizado con

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

Nota:

- Todos los componentes están integrados con Hadoop 3.3.4 y ZK 3.6.3

- Todos los componentes actualizados anteriores ahora están disponibles en clústeres que no son ESP para la versión preliminar pública.

![]()

Escalabilidad automática mejorada para HDInsight

Azure HDInsight ha realizado importantes mejoras de estabilidad y latencia en la escalabilidad automática, Entre los cambios esenciales se encuentran la mejora del bucle de comentarios para las decisiones de escalado, una mejora significativa de la latencia del escalado y la compatibilidad con la retirada de los nodos retirados, Más información sobre las mejoras, cómo configurar y migrar el clúster a la escalabilidad automática mejorada. La funcionalidad de escalabilidad automática mejorada está disponible a partir del 17 de mayo de 2023 en todas las regiones admitidas.

Azure HDInsight ESP para Apache Kafka 2.4.1 ahora está disponible con carácter general.

Azure HDInsight ESP para Apache Kafka 2.4.1 se encuentra en versión preliminar pública desde abril de 2022. Después de mejoras importantes en las correcciones y la estabilidad de CVE, Azure HDInsight ESP Kafka 2.4.1 ahora está disponible con carácter general y está listo para cargas de trabajo de producción. Obtenga más información sobre la configuración y la migración.

Administración de cuotas para HDInsight

HDInsight asigna actualmente la cuota a las suscripciones de cliente en un nivel regional. Los núcleos asignados a los clientes son genéricos y no se clasifican en un nivel de familia de máquinas virtuales (por ejemplo,

Dv2,Ev3,Eav4, etc.).HDInsight introdujo una vista mejorada, que proporciona un detalle y una clasificación de cuotas para máquinas virtuales de nivel familiar. Esta característica permite a los clientes ver las cuotas actuales y restantes de una región en el nivel de familia de máquinas virtuales. Con la vista mejorada, los clientes tienen una visibilidad más completa para planear cuotas y una mejor experiencia de usuario. Esta característica está disponible actualmente en HDInsight 4.x y 5.x para la región Este de EE. UU. EUAP. Más adelante estará disponible en más regiones.

Para más información, consulte Planeamiento de la capacidad del clúster en Azure HDInsight | Microsoft Learn.

![]()

- Centro de Polonia

- La longitud máxima del nombre del clúster se cambia de 59 a 45 caracteres para mejorar la posición de seguridad de los clústeres.

- Permisos de clúster para un almacenamiento seguro

- Los clientes pueden especificar (durante la creación del clúster) si se debe usar un canal seguro para que los nodos de clúster de HDInsight se comuniquen con la cuenta de almacenamiento.

- Actualización de cuota insertada.

- Las cuotas de solicitud aumentan directamente desde la página Mi cuota, que es una llamada API directa, que es más rápida. Si se produce un error en la llamada API, los clientes deben crear una nueva solicitud de soporte técnico para aumentar la cuota.

- Creación de clústeres de HDInsight con redes virtuales personalizadas.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

Microsoft Network/virtualNetworks/subnets/join/actionpara realizar operaciones de creación. Los clientes tendrían que planear en consecuencia, ya que sería una comprobación obligatoria para evitar errores de creación de clústeres.

- Para mejorar la posición de seguridad general de los clústeres de HDInsight, los clústeres de HDInsight que usan redes virtuales personalizadas deben asegurarse de que el usuario debe tener permiso para

- Retirada de máquinas virtuales de la serie A Básica y Estándar.

- El 31 de agosto de 2024, retiraremos las máquinas virtuales de las series Basic y Standard A. Antes de esa fecha, deberá migrar las cargas de trabajo a máquinas virtuales de la serie Av2, que proporcionan más memoria por vCPU y almacenamiento más rápido en unidades de estado sólido (SSD). Para evitar interrupciones del servicio, migre las cargas de trabajo de las máquinas virtuales de la serie A Básica y Estándar a las máquinas virtuales de la serie Av2 antes del 31 de agosto de 2024.

- Clústeres de ABFS que no son ESP [permisos de clúster para lectura mundial]

- Planee introducir un cambio en los clústeres de ABFS que no son de ESP, lo que impide que los usuarios que no son de Hadoop ejecuten comandos de Hadoop para las operaciones de almacenamiento. Este cambio para mejorar la posición de seguridad del clúster. Los clientes deben planear las actualizaciones.

Fecha de publicación: 28 de febrero de 2023

Esta versión se aplica a HDInsight 4.0. y 5.0, 5.1. La versión de HDInsight está disponible en todas las regiones durante varios días. Esta versión es aplicable al número de imagen 2302250400. ¿Cómo comprobar el número de imagen?

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

En el caso de las versiones específicas de la carga de trabajo, consulte

Importante

Microsoft ha emitido CVE-2023-23408, que se corrige en la versión actual y se recomienda a los clientes actualizar sus clústeres a la imagen más reciente.

![]()

HDInsight 5.1

Hemos empezado a implementar una nueva versión de HDInsight 5.1. Todas las nuevas versiones de código abierto se agregan como versiones incrementales en HDInsight 5.1.

Para más información, vea la sección Versión de HDInsight 5.1.0.

![]()

Actualización de Kafka 3.2.0 (versión preliminar)

- Kafka 3.2.0 incluye varias características y mejoras importantes.

- Se ha actualizado Zookeeper a la versión 3.6.3

- Compatibilidad con Kafka Streams

- Garantías de entrega más sólidas para el productor de Kafka habilitado de forma predeterminada.

-

log4j1.x se reemplaza conreload4j. - Envíe una sugerencia al líder de la partición para recuperarla.

-

JoinGroupRequestyLeaveGroupRequesttienen una razón adjunta. - Se han agregado métricas8 de recuento de agente.

- Mejoras en el reflejo de

Maker2.

Actualización de HBase 2.4.11 (versión preliminar)

- Esta versión tiene nuevas características, como la adición de nuevos tipos de mecanismos de almacenamiento en caché para la caché de bloques, la capacidad de modificar

hbase:meta tabley ver la tablahbase:metadesde la interfaz de usuario web de HBase.

Actualización de Phoenix 5.1.2 (versión preliminar)

- Se ha actualizado la versión de Phoenix a la versión 5.1.2 en esta versión. Esta actualización incluye Phoenix Query Server. El servidor proxy de Phoenix Query Server está formado por el controlador JDBC de Phoenix estándar y proporciona un protocolo de conexión compatible con versiones anteriores para invocar ese controlador JDBC.

CV de Ambari

- Se han corregido varios CV de Ambari.

Nota:

ESP no es compatible con Kafka y HBase en esta versión.

![]()

Pasos siguientes

- Escalado automático

- Escalabilidad automática con una latencia mejorada y varias mejoras

- Limitación del cambio de nombre del clúster

- La longitud máxima del nombre del clúster se cambia de 59 a 45 en Public, Azure China y Azure Government.

- Permisos de clúster para un almacenamiento seguro

- Los clientes pueden especificar (durante la creación del clúster) si se debe usar un canal seguro para que los nodos de clúster de HDInsight se comuniquen con la cuenta de almacenamiento.

- Clústeres de ABFS que no son ESP [permisos de clúster para lectura mundial]

- Planee introducir un cambio en los clústeres de ABFS que no son de ESP, lo que impide que los usuarios que no son de Hadoop ejecuten comandos de Hadoop para las operaciones de almacenamiento. Este cambio para mejorar la posición de seguridad del clúster. Los clientes deben planear las actualizaciones.

- Actualizaciones de código abierto

- Apache Spark 3.3.0 y Hadoop 3.3.4 están en desarrollo en HDInsight 5.1 e incluyen varias características nuevas, rendimiento y otras mejoras importantes.

Nota

Recomendamos a los clientes que usen las versiones más recientes de imágenes de HDInsight, ya que aportan lo mejor de código abierto actualizaciones, actualizaciones de Azure y correcciones de seguridad. Para obtener más información, consulte Procedimientos recomendados.

Fecha de publicación: 12 de diciembre de 2022

Esta versión se aplica a HDInsight 4.0. y la versión 5.0 de HDInsight se pone a disposición de todas las regiones durante varios días.

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

Versiones del SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

![]()

- Log Analytics: los clientes pueden habilitar la supervisión clásica para obtener la versión 14.19 de OMS más reciente. Para quitar versiones anteriores, deshabilite y habilite la supervisión clásica.

- Cierre de sesión automático de la interfaz de usuario de Ambari debido a la inactividad. Para más información, consulte aquí.

- Spark: en esta versión se incluye una versión nueva y optimizada de Spark 3.1.3. Hemos probado Apache Spark 3.1.2 (versión anterior) y Apache Spark 3.1.3 (versión actual) mediante el banco de pruebas TPC-DS. La prueba se realizó mediante la SKU E8 V3, para Apache Spark en una carga de trabajo de 1 TB. Apache Spark 3.1.3 (versión actual) superó el rendimiento de Apache Spark 3.1.2 (versión anterior) en más del 40 % en tiempo de ejecución total de consultas para las consultas TPC-DS con las mismas especificaciones de hardware. El equipo de Microsoft Spark agregó optimizaciones disponibles en Azure Synapse con Azure HDInsight. Para más información, consulte Aceleración de las cargas de trabajo de datos con actualizaciones de rendimiento a Apache Spark 3.1.2 en Azure Synapse

![]()

- Centro de Catar

- Norte de Alemania

![]()

HDInsight se ha alejado de Azul Zulu Java JDK 8 a

Adoptium Temurin JDK 8, que admite entornos de ejecución certificados por TCK de alta calidad y tecnología asociada para su uso en todo el ecosistema de Java.HDInsight se ha migrado a

reload4j. Los cambios delog4json aplicables a- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Spark de Apache

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache Hive

- Apache Tez

- HBase Apache

- OMI

- Apache Pheonix

![]()

HDInsight implementa TLS1.2 de ahora en adelante y las versiones anteriores se actualizan en la plataforma. Si ejecuta cualquier aplicación sobre HDInsight y usa TLS 1.0 y 1.1, actualice a TLS 1.2 para evitar cualquier interrupción en los servicios.

Para obtener más información, consulte Habilitación de la seguridad de la capa de transporte (TLS).

![]()

Fin de la compatibilidad con clústeres de Azure HDInsight en Ubuntu 16.04 LTS desde el 30 de noviembre de 2022. HDInsight ha comenzado a publicar imágenes de clúster con Ubuntu 18.04 desde el 27 de junio de 2021. Se recomienda a nuestros clientes que ejecutan clústeres con Ubuntu 16.04 recompilar sus clústeres con las imágenes de HDInsight más recientes antes del 30 de noviembre de 2022.

Para obtener más información sobre cómo comprobar la versión de Ubuntu del clúster, consulte aquí.

Ejecute el comando "lsb_release -a" en el terminal.

Si el valor de la propiedad "Description" en la salida es "Ubuntu 16.04 LTS", esta actualización se aplica al clúster.

![]()

- Compatibilidad con una selección de Availability Zones para clústeres de Kafka y HBase (acceso de escritura).

Correcciones de errores de código abierto

Correcciones de errores de Hive

| Correcciones de errores | JIRA de Apache |

|---|---|

| HIVE-26127 | Error INSERT OVERWRITE: archivo no encontrado |

| HIVE-24957 | Resultados incorrectos cuando la subconsulta tiene COALESCE en el predicado de correlación |

| HIVE-24999 | HiveSubQueryRemoveRule genera un plan no válido para la subconsulta IN con varias correlaciones. |

| HIVE-24322 | Si hay inserción directa, el id. de intento debe comprobarse al leer los errores del manifiesto |

| HIVE-23363 | Actualización de la dependencia DataNucleus a la versión 5.2 |

| HIVE-26412 | Creación de una interfaz para capturar ranuras disponibles y agregar el valor predeterminado |

| HIVE-26173 | Actualización de derbi a 10.14.2.0 |

| HIVE-25920 | Subir Xerce2 a 2.12.2. |

| HIVE-26300 | Actualización de la versión de enlace de datos de Jackson a la versión 2.12.6.1+ para evitar CVE-2020-36518 |

Fecha de lanzamiento: 10/08/2022

Esta versión se aplica a HDInsight 4.0. La versión de HDInsight se pone a disposición de todas las regiones durante varios días.

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

![]()

Nueva característica

1. Conexión de discos externos en clústeres de Hadoop/Spark de HDI

El clúster de HDInsight incluye espacio en disco predefinido basado en SKU. Este espacio puede no ser suficiente en escenarios de trabajo grandes.

Esta nueva característica permite agregar más discos en el clúster, que se usa como directorio local del administrador de nodos. Agregue el número de discos a los nodos de trabajo durante la creación del clúster de HIVE y Spark, mientras que los discos seleccionados forman parte de los directorios locales del administrador de nodos.

Nota

Los discos agregados solo están configurados para los directorios locales del administrador de nodos.

Para más información, consulte aquí.

2. Análisis de registro selectivo

El análisis de registro selectivo ahora está disponible en todas las regiones para la versión preliminar pública. Puede conectar el clúster a un área de trabajo de Log Analytics. Una vez habilitado, puede ver los registros y las métricas, como registros de seguridad de HDInsight, Yarn Resource Manager, métricas del sistema, etc. Puede supervisar las cargas de trabajo y ver cómo afectan a la estabilidad del clúster. El registro selectivo permite habilitar o deshabilitar todas las tablas o habilitar tablas selectivas en el área de trabajo de Log Analytics. Puede ajustar el tipo de origen de cada tabla, ya que en la nueva versión de la supervisión de Geneva una tabla tiene varios orígenes.

- El sistema de supervisión de Geneva utiliza mdsd (demonio MDS), que es un agente de supervisión fluido para recopilar registros mediante una capa de registro unificada.

- El registro selectivo usa la acción de script para deshabilitar o habilitar tablas y sus tipos de registro. Puesto que no abre ningún puerto nuevo ni cambia ninguna configuración de seguridad existente, no hay cambios de seguridad.

- La acción de script se ejecuta en paralelo en todos los nodos especificados y cambia los archivos de configuración para deshabilitar o habilitar tablas y sus tipos de registro.

Para más información, consulte aquí.

![]()

Fijo

Análisis de registros de actividad de Azure AD con registros de Azure Monitor

Log Analytics integrado con Azure HDInsight que ejecuta OMS versión 13 requiere una actualización a la versión 14 de OMS para aplicar las actualizaciones de seguridad más recientes. Los clientes que usan la versión anterior del clúster con la versión 13 de OMS deben instalar la versión 14 de OMS para cumplir los requisitos de seguridad. (Cómo comprobar la versión e instalar la 14)

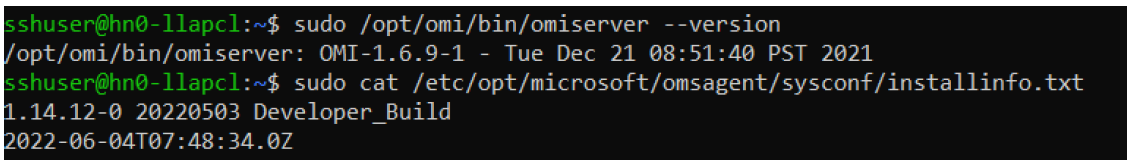

Cómo comprobar su versión actual de OMS

- Inicie sesión en el clúster con SSH.

- Ejecute el siguiente comando en el cliente de SSH.

sudo /opt/omi/bin/ominiserver/ --version

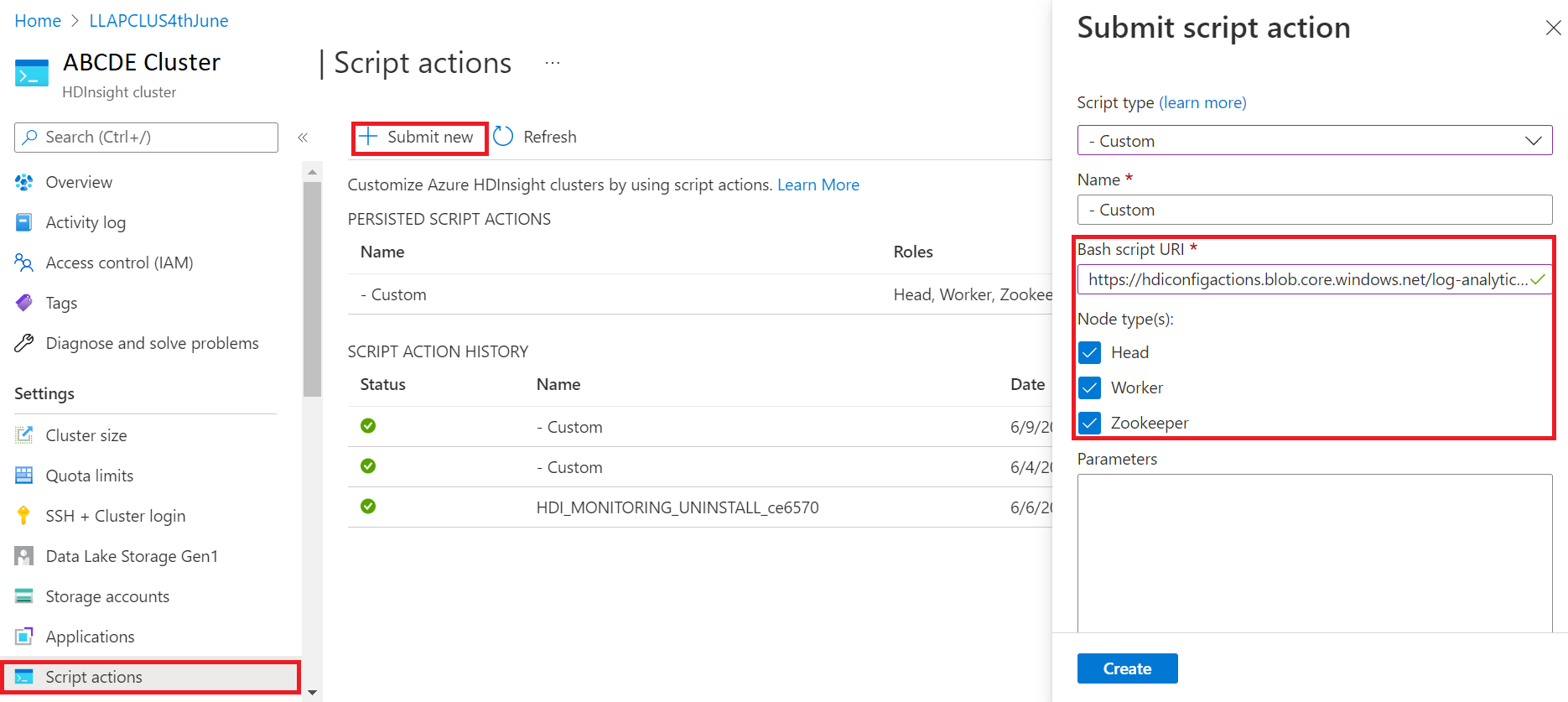

Cómo actualizar su versión de OMS de 13 a 14.

- Inicie sesión en el Portal de Azure

- En el grupo de recursos, seleccione el recurso de clúster de HDInsight.

- Seleccione Acciones de script

- En el panel Enviar acción de script, elija Tipo de script como personalizado.

- Pegue el siguiente vínculo en el cuadro de URL del script de Bash: https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Seleccione Tipos de nodo.

- Seleccione Crear

Compruebe la correcta instalación del parche mediante los pasos siguientes:

Inicie sesión en el clúster con SSH.

Ejecute el siguiente comando en el cliente de SSH.

sudo /opt/omi/bin/ominiserver/ --version

Otras correcciones de errores.

- La CLI del registro de Yarn no puede recuperar los registros si hay algún

TFiledañado o vacío. - Se ha resuelto un error de detalles de la entidad de servicio no válida al obtener el token de OAuth de Azure Active Directory.

- Se ha mejorado la confiabilidad de la creación de clústeres cuando se configuran más de 100 nodos trabajados.

Correcciones de errores de código abierto

Corrección de errores de TEZ

| Correcciones de errores | JIRA de Apache |

|---|---|

| Error de compilación de Tez: no se encontró FileSaver.js | TEZ-4411 |

Excepción de FS incorrecta cuando el almacenamiento y el scratchdir están en FS diferentes |

TEZ-4406 |

| TezUtils.createConfFromByteString en la configuración de más de 32 MB produce una excepción com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils::createByteStringFromConf debe usar snappy en lugar de DeflaterOutputStream | TEZ-4113 |

| Actualización de la dependencia protobuf a 3.x | TEZ-4363 |

Correcciones de errores de Hive

| Correcciones de errores | JIRA de Apache |

|---|---|

| Optimizaciones de rendimiento en la generación dividida ORC | HIVE-21457 |

| Evita leer la tabla como ACID cuando el nombre de la tabla comience por "delta", pero la tabla no es transaccional y se usa la estrategia de división de BI | HIVE-22582 |

| Elimina una llamada de FS#exists de AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorización de OrcAcidRowBatchReader.computeOffset y optimización de cubos | HIVE-17917 |

Problemas conocidos

HDInsight es compatible con Apache HIVE 3.1.2. Debido a un error en esta versión, la versión de Hive se muestra como 3.1.0 en interfaces de Hive. Sin embargo, no hay ningún impacto en la funcionalidad.

Fecha de lanzamiento: 10/08/2022

Esta versión se aplica a HDInsight 4.0. La versión de HDInsight se pone a disposición de todas las regiones durante varios días.

HDInsight usa prácticas de implementación segura que implican la implementación gradual de regiones. Pueden pasar hasta 10 días hábiles hasta que haya una nueva versión disponible en todas las regiones.

![]()

Nueva característica

1. Conexión de discos externos en clústeres de Hadoop/Spark de HDI

El clúster de HDInsight incluye espacio en disco predefinido basado en SKU. Este espacio puede no ser suficiente en escenarios de trabajo grandes.

Esta nueva característica permite agregar más discos en el clúster, que se usarán como directorio local del administrador de nodos. Agregue el número de discos a los nodos de trabajo durante la creación del clúster de HIVE y Spark, mientras que los discos seleccionados forman parte de los directorios locales del administrador de nodos.

Nota

Los discos agregados solo están configurados para los directorios locales del administrador de nodos.

Para más información, consulte aquí.

2. Análisis de registro selectivo

El análisis de registro selectivo ahora está disponible en todas las regiones para la versión preliminar pública. Puede conectar el clúster a un área de trabajo de Log Analytics. Una vez habilitado, puede ver los registros y las métricas, como registros de seguridad de HDInsight, Yarn Resource Manager, métricas del sistema, etc. Puede supervisar las cargas de trabajo y ver cómo afectan a la estabilidad del clúster. El registro selectivo permite habilitar o deshabilitar todas las tablas o habilitar tablas selectivas en el área de trabajo de Log Analytics. Puede ajustar el tipo de origen de cada tabla, ya que en la nueva versión de la supervisión de Geneva una tabla tiene varios orígenes.

- El sistema de supervisión de Geneva utiliza mdsd (demonio MDS), que es un agente de supervisión fluido para recopilar registros mediante una capa de registro unificada.

- El registro selectivo usa la acción de script para deshabilitar o habilitar tablas y sus tipos de registro. Puesto que no abre ningún puerto nuevo ni cambia ninguna configuración de seguridad existente, no hay cambios de seguridad.

- La acción de script se ejecuta en paralelo en todos los nodos especificados y cambia los archivos de configuración para deshabilitar o habilitar tablas y sus tipos de registro.

Para más información, consulte aquí.

![]()

Fijo

Análisis de registros de actividad de Azure AD con registros de Azure Monitor

Log Analytics integrado con Azure HDInsight que ejecuta OMS versión 13 requiere una actualización a la versión 14 de OMS para aplicar las actualizaciones de seguridad más recientes. Los clientes que usan la versión anterior del clúster con la versión 13 de OMS deben instalar la versión 14 de OMS para cumplir los requisitos de seguridad. (Cómo comprobar la versión e instalar la 14)

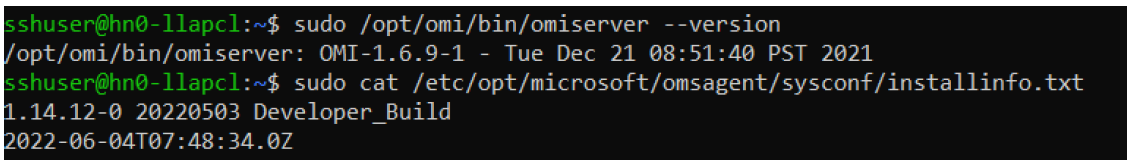

Cómo comprobar su versión actual de OMS

- Inicie sesión en el clúster con SSH.

- Ejecute el siguiente comando en el cliente de SSH.

sudo /opt/omi/bin/ominiserver/ --version

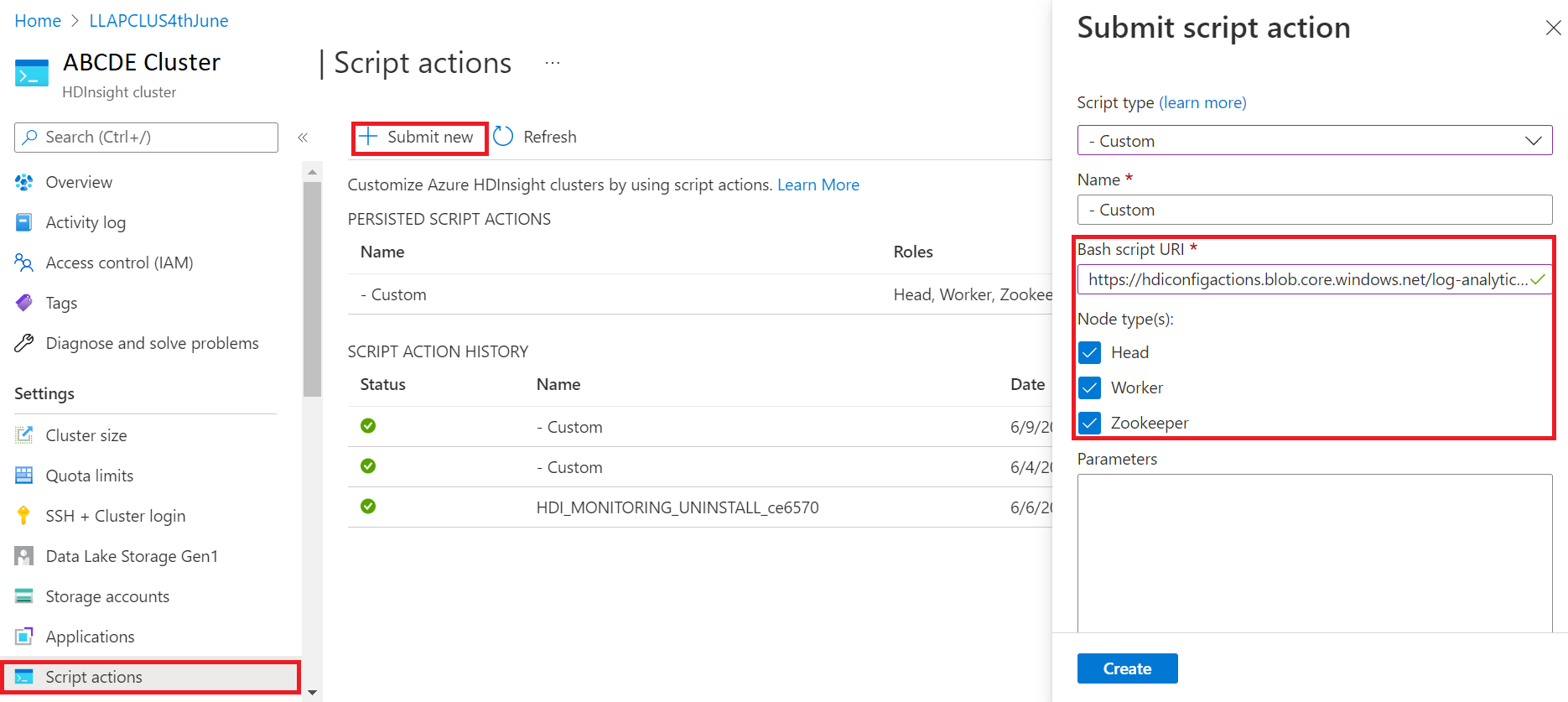

Cómo actualizar su versión de OMS de 13 a 14.

- Inicie sesión en el Portal de Azure

- En el grupo de recursos, seleccione el recurso de clúster de HDInsight.

- Seleccione Acciones de script

- En el panel Enviar acción de script, elija Tipo de script como personalizado.

- Pegue el siguiente vínculo en el cuadro de URL del script de Bash: https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Seleccione Tipos de nodo.

- Seleccione Crear

Compruebe la correcta instalación del parche mediante los pasos siguientes:

Inicie sesión en el clúster con SSH.

Ejecute el siguiente comando en el cliente de SSH.

sudo /opt/omi/bin/ominiserver/ --version

Otras correcciones de errores.

- La CLI del registro de Yarn no puede recuperar los registros si hay algún

TFiledañado o vacío. - Se ha resuelto un error de detalles de la entidad de servicio no válida al obtener el token de OAuth de Azure Active Directory.

- Se ha mejorado la confiabilidad de la creación de clústeres cuando se configuran más de 100 nodos trabajados.

Correcciones de errores de código abierto

Corrección de errores de TEZ

| Correcciones de errores | JIRA de Apache |

|---|---|

| Error de compilación de Tez: no se encontró FileSaver.js | TEZ-4411 |

Excepción de FS incorrecta cuando el almacenamiento y el scratchdir están en FS diferentes |

TEZ-4406 |

| TezUtils.createConfFromByteString en la configuración de más de 32 MB produce una excepción com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils::createByteStringFromConf debe usar snappy en lugar de DeflaterOutputStream | TEZ-4113 |

| Actualización de la dependencia protobuf a 3.x | TEZ-4363 |

Correcciones de errores de Hive

| Correcciones de errores | JIRA de Apache |

|---|---|

| Optimizaciones de rendimiento en la generación dividida ORC | HIVE-21457 |

| Evita leer la tabla como ACID cuando el nombre de la tabla comience por "delta", pero la tabla no es transaccional y se usa la estrategia de división de BI | HIVE-22582 |

| Elimina una llamada de FS#exists de AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorización de OrcAcidRowBatchReader.computeOffset y optimización de cubos | HIVE-17917 |

Problemas conocidos

HDInsight es compatible con Apache HIVE 3.1.2. Debido a un error en esta versión, la versión de Hive se muestra como 3.1.0 en interfaces de Hive. Sin embargo, no hay ningún impacto en la funcionalidad.

Fecha de lanzamiento: 03/06/2022

Esta versión se aplica a HDInsight 4.0. La versión de HDInsight se pone a disposición de todas las regiones durante varios días. Esta fecha de lanzamiento indica la fecha de lanzamiento de la primera región. Si no ve los cambios siguientes, espere unos días a que la versión se active en su región.

Cambios destacados

El conector de Hive Warehouse (HWC) en Spark v3.1.2

El conector de Hive Warehouse (HWC) le permite aprovechar las ventajas de las características exclusivas de Hive y Spark para crear aplicaciones eficaces de macrodatos. HWC solo se admite actualmente para Spark v2.4. Esta característica agrega valor empresarial al permitir transacciones ACID en tablas de Hive mediante Spark. Esta característica es útil para los clientes que usan Hive y Spark en su patrimonio de datos. Para obtener más información, consulte Apache Spark y Hive - Hive Warehouse Connector - Azure HDInsight | Microsoft Docs

Ambari

- Cambios en la mejora del escalado y el aprovisionamiento

- HDI Hive ahora es compatible con la versión 3.1.2 del OSS

La versión de HDI Hive 3.1 se ha actualizado a OSS Hive 3.1.2. Esta versión tiene todas las correcciones y características disponibles en la versión de Hive 3.1.2. en código abierto.

Nota

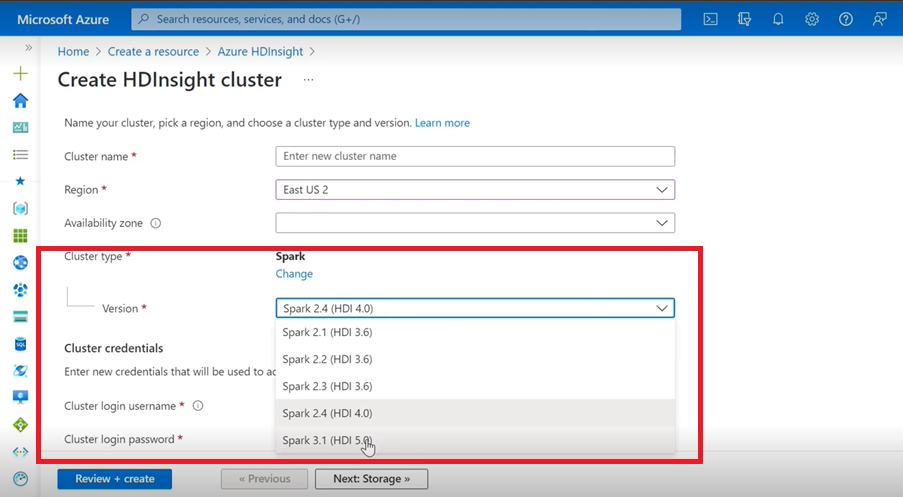

Spark

- Si usa la interfaz de usuario de Azure para crear un clúster de Spark para HDInsight, verá en la lista desplegable otra versión de Spark 3.1. (HDI 5.0) junto con las versiones anteriores. Esta versión es una versión con el nombre de Spark 3.1. (HDI 4.0). Es solo un cambio de nivel de interfaz de usuario, que no afecta en nada a los usuarios existentes o a los usuarios que ya usan la plantilla de ARM.

Nota

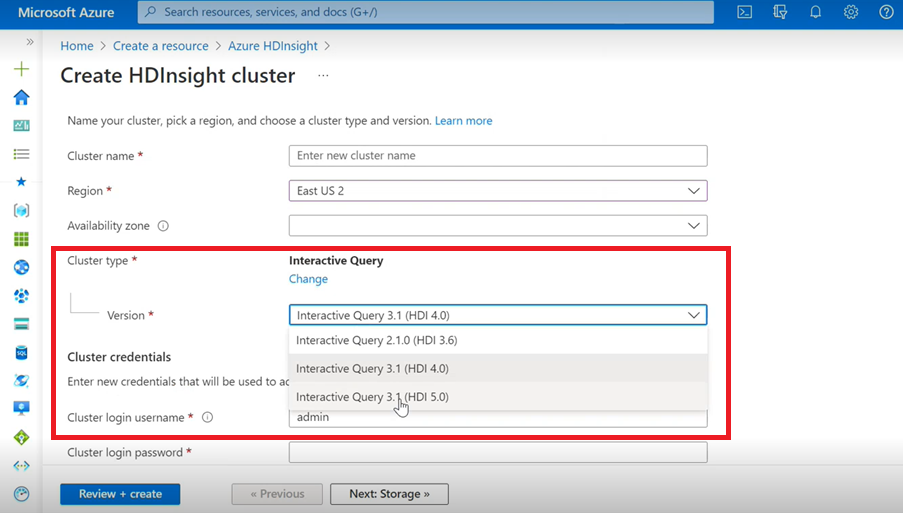

Interactive Query

- Si va a crear un clúster de Interactive Query, verá en la lista desplegable otra versión como Interactive Query 3.1 (HDI 5.0).

- Si va a usar la versión de Spark 3.1 junto con Hive que requiere compatibilidad con ACID, debe seleccionar esta versión, Interactive Query 3.1 (HDI 5.0).

Corrección de errores de TEZ

| Correcciones de errores | JIRA de Apache |

|---|---|

| TezUtils.createConfFromByteString en la configuración de más de 32 MB produce una excepción com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils createByteStringFromConf debe usar snappy en lugar de DeflaterOutputStream | TEZ-4113 |

Correcciones de errores de HBase

| Correcciones de errores | JIRA de Apache |

|---|---|

TableSnapshotInputFormat debe usar ReadType.STREAM para examinar HFiles |

HBASE-26273 |

| Agregar opción para deshabilitar scanMetrics en TableSnapshotInputFormat | HBASE-26330 |

| Corrección para ArrayIndexOutOfBoundsException cuando se ejecuta el equilibrador | HBASE-22739 |

Correcciones de errores de Hive

| Correcciones de errores | JIRA de Apache |

|---|---|

| Excepción de puntero nulo al insertar datos con la cláusula «distribute by» con la optimización de ordenación dynpart | HIVE-18284 |

| Se produce un error en el comando MSCK REPAIR con filtrado de particiones mientras se quitan particiones | HIVE-23851 |

| Se ha iniciado una excepción incorrecta si capacidad<=0 | HIVE-25446 |

| Compatibilidad con la carga en paralelo para HastTables: interfaces | HIVE-25583 |

| Incluir MultiDelimitSerDe en HiveServer2 de forma predeterminada | HIVE-20619 |

| Quitar las clases glassfish.jersey y mssql-jdbc de jdbc-standalone jar | HIVE-22134 |

| Excepción de puntero nulo al ejecutar la compactación en una tabla MM. | HIVE-21280 |

Se produce un error en la consulta de gran volumen de Hive a través de knox cuando se produce un error de escritura de canalización rota |

HIVE-22231 |

| Agregar la capacidad de usuario para establecer el usuario de enlace | HIVE-21009 |

| Implementar UDF para interpretar la fecha y la marca de tiempo mediante su representación interna y el calendario híbrido Gregoriano-Juliano | HIVE-22241 |

| Opción Beeline para mostrar o no mostrar el informe de ejecución | HIVE-22204 |

| Tez: SplitGenerator intenta buscar archivos de plan, que no existen para Tez | HIVE-22169 |

Quitar registro costoso de la caché hotpath de LLAP |

HIVE-22168 |

| UDF: FunctionRegistry se sincroniza en la clase org.apache.hadoop.hive.ql.udf.UDFType | HIVE-22161 |

| Impedir la creación del appender de enrutamiento de consultas si la propiedad está establecida en FALSE | HIVE-22115 |

| Eliminar la sincronización entre consultas para partition-eval | HIVE-22106 |

| Omitir la configuración del directorio temporal de Hive durante la planeación | HIVE-21182 |

| Omitir la creación de directorios temporales para Tez si RPC está activado | HIVE-21171 |

Cambiar los UDF de Hive para usar el motor regex Re2J |

HIVE-19661 |

| Las tablas en clúster migradas mediante bucketing_version 1 en Hive 3 usan bucketing_version 2 para las inserciones | HIVE-22429 |

| Creación de depósitos: la versión 1 de la creación de depósitos está realizando particiones de datos de manera incorrecta | HIVE-21167 |

| Agregar el encabezado de licencia de ASF al archivo recién agregado | HIVE-22498 |

| Mejoras de la herramienta de esquema para admitir mergeCatalog | HIVE-22498 |

| Hive con TEZ UNION ALL y UDTF da como resultado la pérdida de datos | HIVE-21915 |

| Dividir archivos de texto incluso si existe encabezado o pie de página | HIVE-21924 |

| MultiDelimitSerDe devuelve resultados incorrectos en la última columna cuando el archivo cargado tiene más columnas de las que están presentes en el esquema de tabla | HIVE-22360 |

| Cliente externo de LLAP: es necesario reducir la superficie de LlapBaseInputFormat#getSplits() | HIVE-22221 |

| El nombre de columna con palabra clave reservada no ha escapado al reescribir la consulta que incluye la combinación con la tabla que tiene la columna de máscara (Zoltan Matyus a través de Zoltan Haindrich) | HIVE-22208 |

Impedir el apagado de LLAP en la excepción RuntimeException relacionada con AMReporter |

HIVE-22113 |

| El controlador de servicio de estado de LLAP puede quedarse bloqueado con un Id. de aplicación de Yarn incorrecto | HIVE-21866 |

| OperationManager.queryIdOperation no limpia correctamente varios queryIds | HIVE-22275 |

| Reducir un administrador de nodos bloquea el reinicio del servicio LLAP | HIVE-22219 |

| StackOverflowError cuando se quitan muchas particiones | HIVE-15956 |

| Error en la comprobación de acceso cuando se quita un directorio temporal | HIVE-22273 |

| Corrección de los resultados incorrectos y de la excepción ArrayOutOfBound en combinaciones externas izquierdas de mapa con condiciones de límite específicas | HIVE-22120 |

| Eliminación de la etiqueta de administración de distribución de pom.xml | HIVE-19667 |

| El tiempo de análisis puede ser alto si hay subconsultas profundamente anidadas | HIVE-21980 |

Para ALTER TABLE t SET TBLPROPERTIES ('EXTERNAL'='TRUE'); los cambios de atributo de TBL_TYPE no se reflejan para texto sin mayúsculas |

HIVE-20057 |

JDBC: HiveConnection sombrea las interfaces log4j |

HIVE-18874 |

Actualización de las direcciones URL del repositorio en poms: versión 3.1 de la rama |

HIVE-21786 |

Pruebas de DBInstall interrumpidas en master y branch-3.1 |

HIVE-21758 |

| Cargar datos en una tabla en depósitos está ignorando las especificaciones de particiones y carga los datos en la partición predeterminada | HIVE-21564 |

| Las consultas con la condición de combinación de tener marca de tiempo o marca de tiempo con zona horaria local literal inician la excepción SemanticException | HIVE-21613 |

| Analizar estadísticas de proceso cuando la columna no elimina el directorio de almacenamiento provisional en HDFS | HIVE-21342 |

| Cambio incompatible en el cálculo del depósito de Hive | HIVE-21376 |

| Proporcionar un autorizador de reserva cuando no haya ningún otro autorizador en uso | HIVE-20420 |

| Algunas invocaciones alterPartitions inician 'NumberFormatException: null' | HIVE-18767 |

| HiveServer2: en algunos casos, el asunto autenticado previamente para el transporte http no se conserva durante toda la duración de la comunicación http | HIVE-20555 |

Fecha de lanzamiento: 10/03/2022

Esta versión se aplica a HDInsight 4.0. La versión de HDInsight se pone a disposición de todas las regiones durante varios días. Esta fecha de lanzamiento indica la fecha de lanzamiento de la primera región. Si no ve los cambios siguientes, espere unos días a que la versión se active en su región.

Las versiones del sistema operativo de esta versión son:

- HDInsight 4.0: Ubuntu 18.04.5

Spark 3.1 ya está disponible con carácter general

Spark 3.1 ahora está disponible con carácter general en la versión HDInsight 4.0. Esta versión incluye:

- Ejecución de consultas adaptables

- Conversión de la unión mediante combinación de ordenación en combinación hash de difusión

- Optimizador de Catalyst para Spark

- Recorte dinámico de particiones

- Los clientes podrán crear nuevos clústeres de Spark 3.1 y no clústeres de Spark 3.0 (versión preliminar).

Para obtener más información, consulte Apache Spark 3.1 ya está disponible con carácter general en HDInsight en Microsoft Tech Community.

Para obtener una lista completa de las mejoras, consulte las Notas de la versión de Apache Spark 3.1.

Para obtener más información sobre migración, consulte la guía de migración.

Kafka 2.4 ya está disponible con carácter general

Kafka 2.4.1 ya está disponible con carácter general. Para obtener más información, consulte las Notas de la versión de Kafka 2.4.1. Otras características incluyen la disponibilidad de MirrorMaker 2, nueva métrica y categoría de la partición del tema AtMinIsr, mejora en el tiempo de actividad del agente por carga lenta de mmap a petición de los archivos de índice, más métricas de consumidor para observar el comportamiento del sondeo de usuarios.

El tipo de datos Map en HWC ahora se admite en HDInsight 4.0

Esta versión incluye compatibilidad con tipos de datos Map para HWC 1.0 (Spark 2.4) a través de la aplicación spark-shell y todos los demás clientes de Spark compatibles con HWC. Las siguientes mejoras se incluyen como cualquier otro tipo de datos:

Un usuario puede:

- Crear una tabla de Hive con cualquier columna que contenga el tipo de datos Map, insertar datos en ella y leer los resultados de ella.

- Crear un dataframe de Apache Spark con el tipo Map y realizar lecturas y escrituras por lotes o secuencias.

Nuevas regiones

HDInsight ha ampliado su presencia geográfica a dos nuevas regiones: Este de China 3 y Norte de China 3.

Cambios de portabilidad con versiones anteriores de OSS

La portabilidad con versiones anteriores de OSS que se incluye en Hive, incluido HWC 1.0 (Spark 2.4), que admite el tipo de datos Map.

Estas son las instancias de JIRA de Apache de esta versión portadas a una versión anterior de OSS:

| Característica afectada | JIRA de Apache |

|---|---|

| Las consultas SQL directas de metastore con IN/(NOT IN) deben dividirse en función de los parámetros máximos permitidos por SQL DB. | HIVE-25659 |

Actualizar log4j 2.16.0 a 2.17.0 |

HIVE-25825 |

Actualizar versión de Flatbuffer |

HIVE-22827 |

| Compatibilidad con el tipo de datos Map de forma nativa en formato Arrow | HIVE-25553 |

| Cliente externo de LLAP: controla los valores anidados cuando la estructura primaria es NULL | HIVE-25243 |

| Actualización de la versión de Arrow a 0.11.0 | HIVE-23987 |

Avisos sobre elementos en desuso

Azure Virtual Machine Scale Sets en HDInsight

HDInsight ya no usará Azure Virtual Machine Scale Sets para aprovisionar los clústeres, no se espera ningún cambio importante. Los clústeres de HDInsight existentes en conjuntos de escalado de máquinas virtuales no se ven afectados, ya que los clústeres nuevos de las imágenes más recientes ya no usarán Virtual Machine Scale Sets.

El escalado de cargas de trabajo de Azure HDInsight HBase ahora solo se admitirán mediante el escalado manual

A partir del 1 de marzo de 2022, HDInsight solo admitirá el escalado manual para HBase, los clústeres en ejecución no se verán afectados. Los nuevos clústeres de HBase no podrán habilitar el escalado automático basado en programación. Para obtener más información sobre cómo escalar manualmente un clúster de HBase, consulte nuestra documentación sobre Escalado manual de clústeres de Azure HDInsight.

Fecha de lanzamiento: 27/12/2021

Esta versión se aplica a HDInsight 4.0. La versión de HDInsight se pone a disposición de todas las regiones durante varios días. Esta fecha de lanzamiento indica la fecha de lanzamiento de la primera región. Si no ve los cambios siguientes, espere unos días a que la versión se active en su región.

Las versiones del sistema operativo de esta versión son:

- HDInsight 4.0: Ubuntu 18.04.5 LTS

La imagen de HDInsight 4.0 se ha actualizado para mitigar la vulnerabilidad de Log4j, como se describe en la Respuesta de Microsoft a CVE-2021-44228 Apache Log4j 2.

Nota:

- Los clústeres de HDI 4.0 creados después del 27 de diciembre de 2021 a las 00:00 UTC se crean con una versión actualizada de la imagen que mitiga las vulnerabilidades de