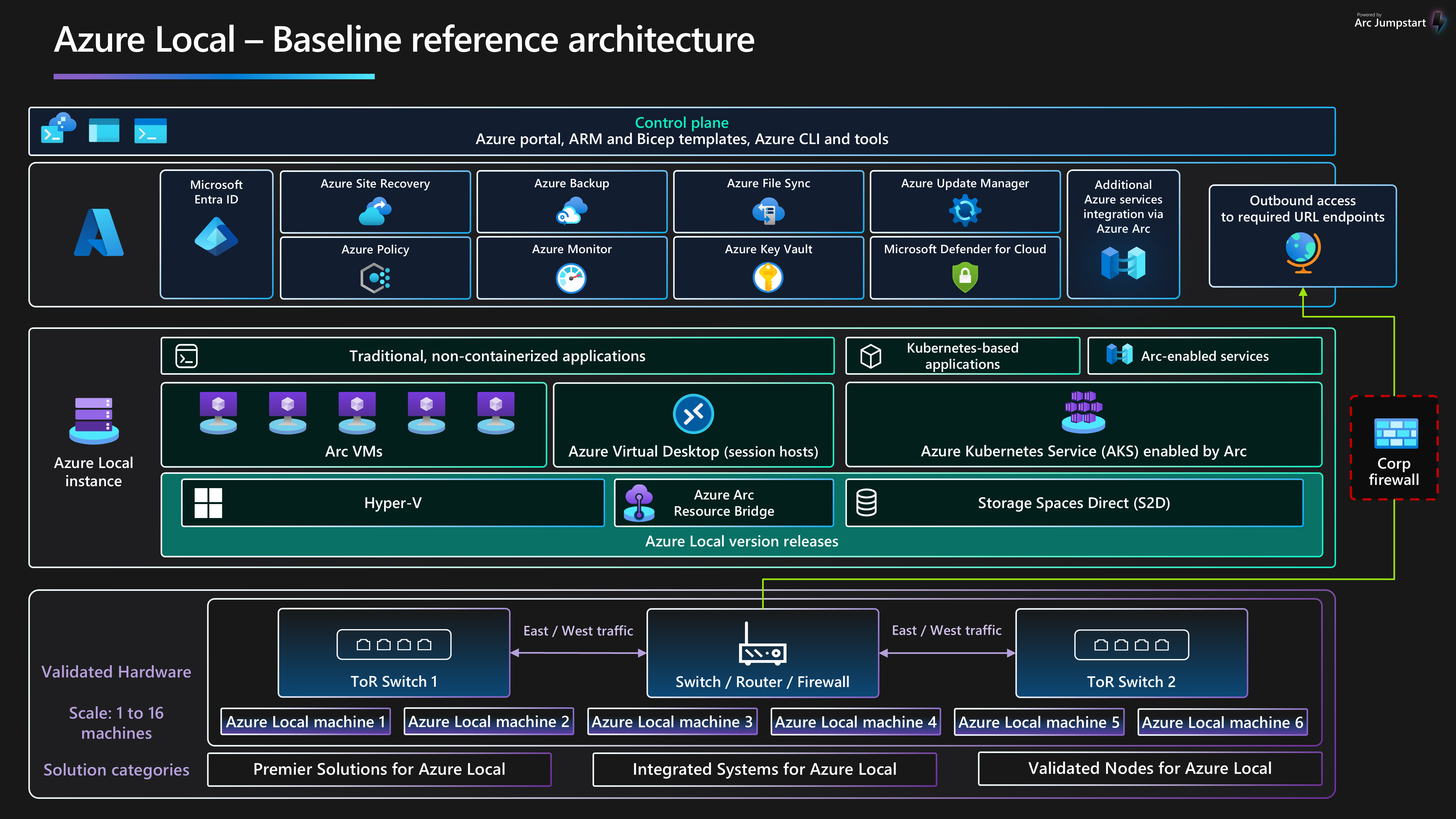

Esta arquitectura de referencia de línea de base proporciona instrucciones y recomendaciones independientes de la carga de trabajo para configurar Azure Local, versión 23H2, versión 2311 y una infraestructura posterior para garantizar una plataforma confiable que pueda implementar y administrar cargas de trabajo virtualizadas y en contenedores de alta disponibilidad. En esta arquitectura se describen los componentes de recursos y las opciones de diseño del clúster para los nodos físicos que proporcionan características locales de proceso, almacenamiento y redes. También se describe cómo usar los servicios de Azure para simplificar y simplificar la administración diaria de Azure Local.

Para más información sobre los patrones de arquitectura de carga de trabajo que están optimizados para ejecutarse en Azure Local, consulte el contenido que se encuentra en el menú de navegación cargas de trabajo locales de Azure

Esta arquitectura es un punto de partida para usar el diseño de red conmutada de almacenamiento para implementar una instancia local de Azure local de varios nodos. Las aplicaciones de carga de trabajo implementadas en una instancia local de Azure deben estar bien diseñadas. Las aplicaciones de carga de trabajo bien diseñadas deben implementarse mediante varias instancias o alta disponibilidad de cualquier servicio de carga de trabajo crítico y tener los controles adecuados de continuidad empresarial y recuperación ante desastres (BCDR). Estos controles BCDR incluyen copias de seguridad periódicas y funcionalidades de conmutación por error de recuperación ante desastres. Para centrarse en la plataforma de infraestructura de HCI, estos aspectos de diseño de cargas de trabajo se excluyen intencionadamente de este artículo.

Para más información sobre las directrices y recomendaciones de los cinco pilares de Azure Well-Architected Framework, consulte la guía del servicio azure Local Well-Architected Framework de .

Diseño del artículo

| Arquitectura | Decisiones de diseño | Enfoque de Well-Architected Framework |

|---|---|---|

| ▪ de arquitectura de ▪ posibles casos de uso ▪ Detalles del escenario ▪ recursos de Platform ▪ recursos compatibles con la plataforma ▪ Implementación de este escenario |

▪ opciones de diseño de clústeres ▪ unidades de disco físico ▪ de diseño de red de ▪ ▪ |

▪ confiabilidad ▪ Security ▪ de optimización de costos de ▪ ▪ rendimiento |

Propina

La plantilla local de Azure muestra cómo usar una plantilla de Administración de recursos de Azure (plantilla de ARM) y un archivo de parámetros para implementar una implementación conmutada de varios servidores de Azure Local. Como alternativa, el ejemplo de Bicep muestra cómo usar una plantilla de Bicep para implementar una instancia local de Azure y sus recursos de requisitos previos.

Arquitectura

Para obtener más información, consulte Recursos relacionados.

Casos de uso potenciales

Entre los casos de uso típicos de Azure Local se incluye la capacidad de ejecutar cargas de trabajo de alta disponibilidad (HA) en ubicaciones locales o perimetrales, que proporciona una solución para satisfacer los requisitos de carga de trabajo. Puedes:

Proporcione una solución de nube híbrida que se implemente en el entorno local para abordar los requisitos de soberanía, regulación y cumplimiento de los datos o latencia.

Implemente y administre cargas de trabajo perimetrales virtualizadas o basadas en contenedores que se implementan en una sola ubicación o en varias ubicaciones. Esta estrategia permite que las aplicaciones y los servicios críticos para la empresa funcionen de forma resistente, rentable y escalable.

Reduzca el costo total de propiedad (TCO) mediante soluciones certificadas por Microsoft, implementación basada en la nube, administración centralizada y supervisión y alertas.

Proporcione una funcionalidad de aprovisionamiento centralizada mediante Azure y Azure Arc para implementar cargas de trabajo en varias ubicaciones de forma coherente y segura. Las herramientas como Azure Portal, la CLI de Azure o la infraestructura como código (IaC) usan Kubernetes para la contenedorización o la virtualización de cargas de trabajo tradicional para impulsar la automatización y la repetibilidad.

Cumplir los requisitos estrictos de seguridad, cumplimiento y auditoría. Azure Local se implementa con una posición de seguridad protegida configurada de forma predeterminada o de forma segura de forma predeterminada. Azure Local incorpora hardware certificado, arranque seguro, módulo de plataforma segura (TPM), seguridad basada en virtualización (VBS), Credential Guard y directivas de control de aplicaciones de Windows Defender aplicadas. También se integra con servicios modernos de seguridad y administración de amenazas basados en la nube, como Microsoft Defender for Cloud y Microsoft Sentinel.

Detalles del escenario

En las secciones siguientes se proporciona más información sobre los escenarios y los posibles casos de uso de esta arquitectura de referencia. Estas secciones incluyen una lista de ventajas empresariales y tipos de recursos de carga de trabajo de ejemplo que puede implementar en Azure Local.

Uso de Azure Arc con Azure Local

Azure Local se integra directamente con Azure mediante Azure Arc para reducir el TCO y la sobrecarga operativa. Azure Local se implementa y administra a través de Azure, que proporciona integración integrada de Azure Arc mediante la implementación del componente puente de recursos de Azure Arc. Este componente se instala durante el proceso de implementación del clúster de HCI. Los nodos de clúster local de Azure están inscritos con Azure Arc para servidores como requisito previo para iniciar la implementación basada en la nube del clúster. Durante la implementación, las extensiones obligatorias se instalan en cada nodo de clúster, como Lifecycle Manager, Administración de dispositivos microsoft Edge y Telemetría y diagnósticos. Puede usar Azure Monitor y Log Analytics para supervisar el clúster de HCI después de la implementación habilitando Insights para Azure Local. actualizaciones de características de Azure Local se publican periódicamente para mejorar la experiencia del cliente. Las actualizaciones se controlan y administran mediante azure Update Manager.

Puede implementar recursos de carga de trabajo, como máquinas virtuales (VM) de Azure Arc, azure Kubernetes Service (AKS) habilitado para Azure Arcy hosts de sesión de Azure Virtual Desktop que usan Azure Portal seleccionando una ubicación personalizada de instancia local de Azure como destino para la implementación de cargas de trabajo. Estos componentes proporcionan administración, administración y soporte técnico centralizados. Si tiene Software Assurance activo en las licencias principales de Windows Server Datacenter existentes, puede reducir aún más los costos aplicando la Ventaja híbrida de Azure a azure Local, las máquinas virtuales Windows Server y los clústeres de AKS. Esta optimización ayuda a administrar los costos de forma eficaz para estos servicios.

La integración de Azure y Azure Arc amplían las funcionalidades de las cargas de trabajo virtualizadas y en contenedores de Azure para incluir:

máquinas virtuales de Azure Arc para aplicaciones o servicios tradicionales que se ejecutan en máquinas virtuales en Azure Local.

AKS en Azure Local para aplicaciones o servicios en contenedores que se benefician del uso de Kubernetes como plataforma de orquestación.

azure Virtual Desktop para implementar los hosts de sesión para cargas de trabajo de Azure Virtual Desktop en Azure Local (local). Puede usar el plano de control y administración en Azure para iniciar la creación y configuración del grupo de hosts.

servicios de datos habilitados para Azure Arc para Azure SQL Managed Instance en contenedor o un servidor de Azure Database for PostgreSQL que use AKS habilitado para Azure Arc hospedado en Azure Local.

La extensión de Azure Event Grid habilitada para Azure Arc

para Kubernetes para implementar los componentes agente de Event Grid y agente de Event Grid. Esta implementación permite funcionalidades como temas y suscripciones de Event Grid para el procesamiento de eventos. de aprendizaje automático habilitado para Azure Arc con un clúster de AKS implementado en Azure Local como destino de proceso para ejecutar Azure Machine Learning. Puede usar este enfoque para entrenar o implementar modelos de aprendizaje automático en el perímetro.

Las cargas de trabajo conectadas a Azure Arc proporcionan una mayor coherencia y automatización de Azure Para implementaciones locales, como automatizar la configuración del sistema operativo invitado con extensiones de máquina virtual de Azure Arc o evaluar el cumplimiento de las normativas del sector o los estándares corporativos a través de Azure Policy. Puede activar Azure Policy a través de Azure Portal o automatización de IaC.

Aproveche la configuración de seguridad predeterminada de Azure Local.

La configuración de seguridad predeterminada de Azure Local proporciona una estrategia de defensa en profundidad para simplificar los costos de seguridad y cumplimiento. La implementación y administración de servicios de TI para escenarios de venta al por menor, fabricación y oficina remota presenta desafíos únicos de seguridad y cumplimiento. La protección de cargas de trabajo frente a amenazas internas y externas es fundamental en entornos que tienen compatibilidad de TI limitada o falta o centros de datos dedicados. Azure Local tiene la protección de seguridad predeterminada y la integración profunda con los servicios de Azure para ayudarle a abordar estos desafíos.

El hardware certificado local de Azure garantiza el arranque seguro integrado, la interfaz de firmware extensible unificada (UEFI) y la compatibilidad con TPM. Use estas tecnologías en combinación con VBS para ayudar a proteger las cargas de trabajo sensibles a la seguridad. Puede usar el cifrado de unidad BitLocker para cifrar volúmenes de disco de arranque y espacios de almacenamiento directos en reposo. El cifrado de bloque de mensajes de servidor (SMB) proporciona cifrado automático del tráfico entre servidores del clúster (en la red de almacenamiento) y la firma del tráfico SMB entre los nodos del clúster y otros sistemas. El cifrado SMB también ayuda a evitar ataques de retransmisión y facilita el cumplimiento de los estándares normativos.

Puede incorporar máquinas virtuales locales de Azure en Defender for Cloud para activar el análisis de comportamiento basado en la nube, la detección de amenazas y la corrección, las alertas y los informes. Administre máquinas virtuales locales de Azure en Azure Arc para que pueda usar Azure Policy para evaluar su cumplimiento con las normativas del sector y los estándares corporativos.

Componentes

Esta arquitectura consta de hardware de servidor físico que puede usar para implementar instancias locales de Azure en ubicaciones locales o perimetrales. Para mejorar las funcionalidades de la plataforma, Azure Local se integra con Azure Arc y otros servicios de Azure que proporcionan recursos auxiliares. Azure Local proporciona una plataforma resistente para implementar, administrar y operar aplicaciones de usuario o sistemas empresariales. Los recursos y servicios de la plataforma se describen en las secciones siguientes.

Recursos de la plataforma

La arquitectura requiere los siguientes recursos y componentes obligatorios:

Azure Local es una solución de infraestructura hiperconvergida (HCI) que se implementa localmente o en ubicaciones perimetrales mediante el hardware físico del servidor y la infraestructura de red. Azure Local proporciona una plataforma para implementar y administrar cargas de trabajo virtualizadas, como máquinas virtuales, clústeres de Kubernetes y otros servicios habilitados por Azure Arc. Las instancias locales de Azure pueden escalar desde una implementación de un solo nodo a un máximo de dieciséis nodos mediante categorías de hardware validadas, integradas o premium proporcionadas por asociados fabricantes de equipos originales (OEM).

Azure Arc es un servicio basado en la nube que amplía el modelo de administración basado en Azure Resource Manager a Azure Local y otras ubicaciones que no son de Azure. Azure Arc usa Azure como plano de control y administración para habilitar la administración de varios recursos, como máquinas virtuales, clústeres de Kubernetes y datos en contenedores y servicios de aprendizaje automático.

azure Key Vault es un servicio en la nube que puede usar para almacenar y acceder a secretos de forma segura. Un secreto es todo lo que desea restringir estrechamente el acceso, como claves de API, contraseñas, certificados, claves criptográficas, credenciales de administrador local y claves de recuperación de BitLocker.

testigo en la nube es una característica de Azure Storage que actúa como cuórum de clúster de conmutación por error. Los nodos de clúster local de Azure usan este cuórum para votar, lo que garantiza una alta disponibilidad para el clúster. La cuenta de almacenamiento y la configuración del testigo se crean durante el proceso de implementación de la nube local de Azure.

Update Manager es un servicio unificado diseñado para administrar y controlar las actualizaciones de Azure Local. Puede usar Update Manager para administrar las cargas de trabajo que se implementan en Azure Local, incluido el cumplimiento de actualizaciones del sistema operativo invitado para máquinas virtuales Windows y Linux. Este enfoque unificado simplifica la administración de revisiones en azure, entornos locales y otras plataformas en la nube a través de un único panel.

Recursos compatibles con la plataforma

La arquitectura incluye los siguientes servicios auxiliares opcionales para mejorar las funcionalidades de la plataforma:

Monitor es un servicio basado en la nube para recopilar, analizar y actuar sobre registros de diagnóstico y telemetría de las cargas de trabajo locales y en la nube. Puede usar Monitor para maximizar la disponibilidad y el rendimiento de las aplicaciones y los servicios a través de una solución de supervisión completa. Implemente Insights para Azure Local para simplificar la creación de la regla de recopilación de datos (DCR) de Monitor y habilitar rápidamente la supervisión de instancias locales de Azure.

azure Policy es un servicio que evalúa los recursos locales y de Azure. Azure Policy evalúa los recursos mediante la integración con Azure Arc mediante las propiedades de esos recursos para las reglas de negocio, denominadas definiciones de directiva , para determinar el cumplimiento o las funcionalidades que puede usar para aplicar la configuración de invitado de máquina virtual mediante la configuración de directiva.

defender for Cloud es un sistema completo de administración de seguridad de la infraestructura. Mejora la posición de seguridad de los centros de datos y ofrece protección contra amenazas avanzada para cargas de trabajo híbridas, tanto si residen en Azure como en otros lugares y en entornos locales.

Azure Backup es un servicio basado en la nube que proporciona una solución sencilla, segura y rentable para realizar copias de seguridad de los datos y recuperarlos de microsoft Cloud. Azure Backup Server se usa para realizar copias de seguridad de las máquinas virtuales que se implementan en Azure Local y almacenarlas en el servicio Backup.

site Recovery es un servicio de recuperación ante desastres que proporciona funcionalidades de BCDR al permitir que las aplicaciones empresariales y las cargas de trabajo conmuten por error si se produce un desastre o una interrupción. Site Recovery administra la replicación y la conmutación por error de las cargas de trabajo que se ejecutan en servidores físicos y máquinas virtuales entre su sitio primario (local) y una ubicación secundaria (Azure).

Opciones de diseño de clúster

Es importante comprender los requisitos de rendimiento y resistencia de la carga de trabajo al diseñar una instancia local de Azure. Estos requisitos incluyen el objetivo de tiempo de recuperación (RTO) y los tiempos de objetivo de punto de recuperación (RPO), los requisitos de proceso (CPU), memoria y almacenamiento para todas las cargas de trabajo que se implementan en la instancia local de Azure. Varias características de la carga de trabajo afectan al proceso de toma de decisiones e incluyen:

Funcionalidades de arquitectura de la unidad de procesamiento central (CPU), incluidas las características de la tecnología de seguridad de hardware, el número de CPU, la frecuencia de GHz (velocidad) y el número de núcleos por socket de CPU.

Requisitos de la unidad de procesamiento de gráficos (GPU) de la carga de trabajo, como la inteligencia artificial o el aprendizaje automático, la inferencia o la representación de gráficos.

Memoria por nodo o la cantidad de memoria física necesaria para ejecutar la carga de trabajo.

Número de nodos físicos del clúster de 1 a 16 nodos a escala. El número máximo de nodos es tres cuando se usa la arquitectura de red sin conmutador de almacenamiento .

Para mantener la resistencia de proceso, debe reservar al menos N+1 nodos de capacidad en el clúster. Esta estrategia permite la purga de nodos para las actualizaciones o la recuperación de interrupciones repentinas, como interrupciones de energía o errores de hardware.

En el caso de las cargas de trabajo críticas o críticas para la empresa, considere la posibilidad de reservar N+2 nodos de capacidad para aumentar la resistencia. Por ejemplo, si dos nodos del clúster están sin conexión, la carga de trabajo puede permanecer en línea. Este enfoque proporciona resistencia para escenarios en los que un nodo que ejecuta una carga de trabajo se desconecta durante un procedimiento de actualización planeado y da como resultado que dos nodos estén sin conexión simultáneamente.

Requisitos de resistencia, capacidad y rendimiento de almacenamiento:

de resistencia: se recomienda implementar tres o más nodos para habilitar la creación de reflejo triple, que proporciona tres copias de los datos, para los volúmenes de infraestructura y usuario. La creación de reflejo triple aumenta el rendimiento y la confiabilidad máxima para el almacenamiento.

Capacidad: se tiene en cuenta el almacenamiento utilizable total necesario después de la tolerancia a errores o copias. Este número es aproximadamente 33% del espacio de almacenamiento sin procesar de los discos de nivel de capacidad cuando se usa la creación de reflejo triple.

rendimiento: operaciones de entrada y salida por segundo (IOPS) de la plataforma que determina las funcionalidades de rendimiento de almacenamiento de la carga de trabajo cuando se multiplican por el tamaño de bloque de la aplicación.

Para diseñar y planear una implementación local de Azure, se recomienda usar el herramienta de ajuste de tamaño local de Azure y crear un New Project para cambiar el tamaño de los clústeres de HCI. El uso de la herramienta de ajuste de tamaño requiere que comprenda los requisitos de carga de trabajo. Al considerar el número y el tamaño de las máquinas virtuales de carga de trabajo que se ejecutan en el clúster, asegúrese de tener en cuenta factores como el número de vCPU, los requisitos de memoria y la capacidad de almacenamiento necesaria para las máquinas virtuales.

La herramienta de ajuste de tamaño preferencias sección le guía a través de preguntas relacionadas con el tipo de sistema (Premier, Integrated System o Validated Node) y las opciones de familia de CPU. También le ayuda a seleccionar los requisitos de resistencia del clúster. Asegúrese de:

Reserve un mínimo de N+1 nodos de capacidad o un nodo en el clúster.

Reserve N+2 nodos por capacidad en todo el clúster para lograr resistencia adicional. Esta opción permite al sistema resistir un error de nodo durante una actualización u otro evento inesperado que afecte simultáneamente a dos nodos. También garantiza que haya suficiente capacidad en el clúster para que la carga de trabajo se ejecute en los nodos en línea restantes.

Este escenario requiere el uso de la creación de reflejo triple para los volúmenes de usuario, que es el valor predeterminado para los clústeres que tienen tres o más nodos físicos.

La salida de la herramienta de ajuste de tamaño local de Azure es una lista de las SKU de solución de hardware recomendadas que pueden proporcionar la capacidad de carga de trabajo necesaria y los requisitos de resistencia de la plataforma en función de los valores de entrada del proyecto Sizer. Para más información sobre las soluciones de asociados de hardware oem disponibles, consulte catálogo de soluciones locales de Azure. Para ayudar a rightsize las SKU de solución para satisfacer sus requisitos, póngase en contacto con el proveedor de soluciones de hardware o el asociado de integración del sistema (SI).

Unidades de disco físicas

Espacios de almacenamiento directo admite varios tipos de unidad de disco físico que varían en el rendimiento y la capacidad. Al diseñar una instancia local de Azure, trabaje con el asociado oem de hardware elegido para determinar los tipos de unidad de disco físico más adecuados para satisfacer los requisitos de capacidad y rendimiento de la carga de trabajo. Algunos ejemplos incluyen unidades de disco duro giratorias (HDD) o unidades de estado sólido (SSD) y unidades NVMe. Estas unidades a menudo se denominan unidades flash, o almacenamiento de memoria persistente (PMem), que se conoce como memoria de clase de almacenamiento (SCM).

La confiabilidad de la plataforma depende del rendimiento de las dependencias críticas de la plataforma, como los tipos de disco físico. Asegúrese de elegir los tipos de disco adecuados para sus requisitos. Use soluciones de almacenamiento all-flash, como unidades NVMe o SSD para cargas de trabajo que tengan requisitos de alto rendimiento o baja latencia. Estas cargas de trabajo incluyen, entre otras, tecnologías de base de datos transaccionales, clústeres de AKS de producción o cargas de trabajo críticas o críticas para la empresa que tengan requisitos de almacenamiento de baja latencia o alto rendimiento. Use implementaciones all-flash para maximizar el rendimiento del almacenamiento. All-NVMe unidad o configuraciones de unidad SSD, especialmente a pequeña escala, mejorar la eficiencia del almacenamiento y maximizar el rendimiento porque no se usan unidades como un nivel de cachéPara obtener más información, consulte almacenamiento basado en Todo flash.

Para cargas de trabajo de uso general, una configuración de almacenamiento híbrido, como unidades NVMe o SSD para caché y HDD para capacidad, podría proporcionar más espacio de almacenamiento. El inconveniente es que los discos giratorios tienen un rendimiento menor si la carga de trabajo supera el conjunto de trabajo de caché de y los DISCOS HDD tienen un tiempo medio inferior entre el valor de error en comparación con las unidades NVMe y SSD.

El rendimiento del almacenamiento en clúster se ve afectado por el tipo de unidad de disco físico, que varía en función de las características de rendimiento de cada tipo de unidad y del mecanismo de almacenamiento en caché que elija. El tipo de unidad de disco físico es una parte integral de cualquier diseño y configuración de Espacios de almacenamiento directo. Según los requisitos de carga de trabajo local de Azure y las restricciones presupuestarias, puede elegir maximizar el rendimiento, maximizar la capacidado implementar una configuración de tipo de unidad mixta que equilibre el rendimiento y la capacidad.

Espacios de almacenamiento directo proporciona una integrada, persistente, en tiempo real, lectura, escritura, caché del lado servidor que maximiza el rendimiento del almacenamiento. La memoria caché debe tener el tamaño y la configuración para adaptarse al conjunto de trabajo de de las aplicaciones y las cargas de trabajo. Los discos virtuales de Espacios de almacenamiento directo o los volúmenes de , se usan en combinación con la memoria caché de lectura de volumen compartido de clúster (CSV) para mejorar Hyper-V rendimiento, especialmente para el acceso de entrada sin búfer a los archivos de disco duro virtual (VHD) o disco duro virtual v2 (VHDX).

Propina

Para cargas de trabajo sensibles a la latencia o alto rendimiento, se recomienda usar una configuración de almacenamiento all-flash (todo NVMe o ssd)

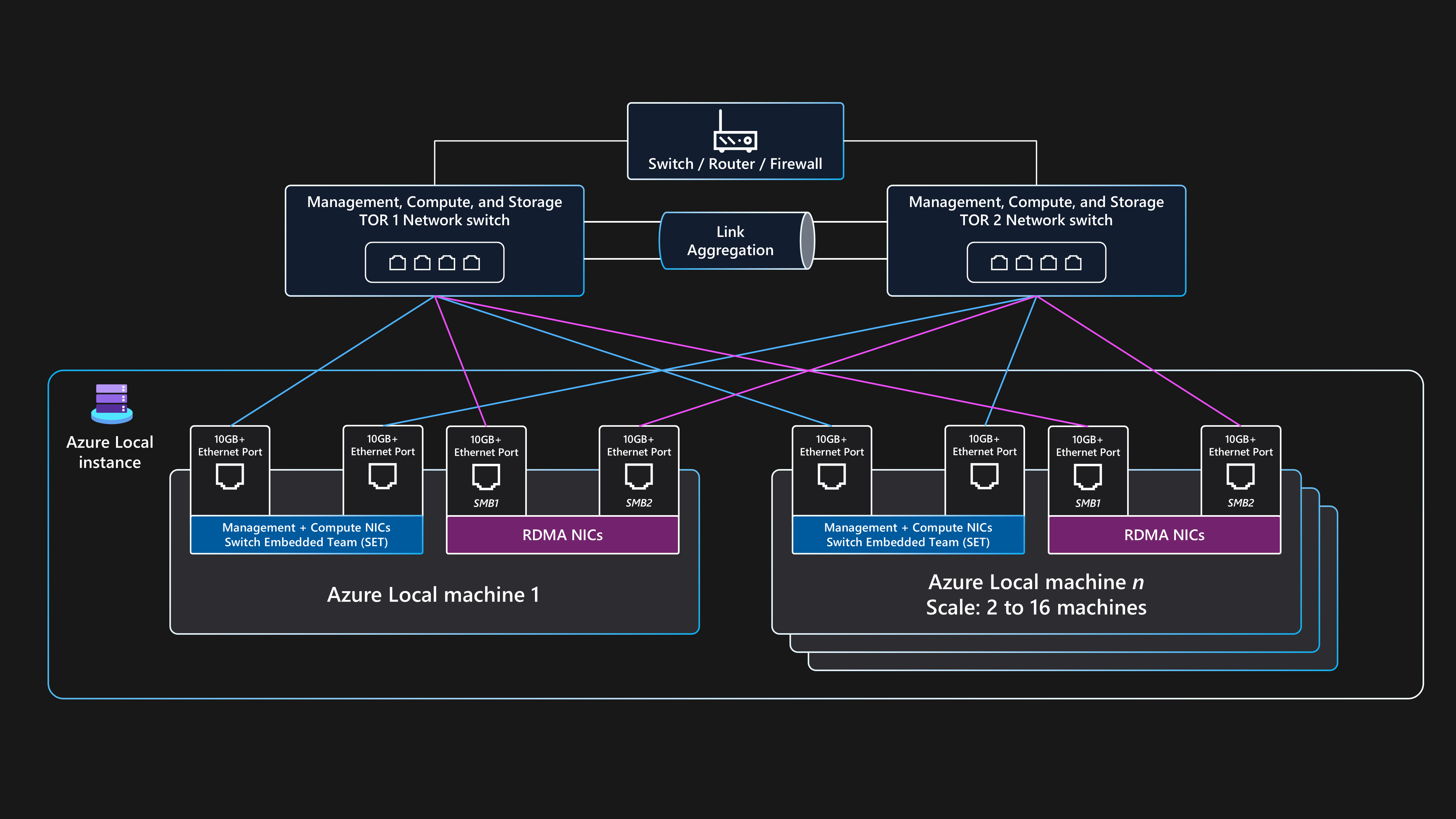

Diseño de red

El diseño de red es la disposición general de los componentes dentro de la infraestructura física de la red y las configuraciones lógicas. Puede usar los mismos puertos de tarjeta de interfaz de red física (NIC) para todas las combinaciones de intenciones de red de administración, proceso y almacenamiento. El uso de los mismos puertos NIC para todos los propósitos relacionados con la intención se denomina configuración de red totalmente convergente.

Aunque se admite una configuración de red totalmente convergente, la configuración óptima para el rendimiento y la confiabilidad es que la intención de almacenamiento use puertos de adaptador de red dedicados. Por lo tanto, esta arquitectura de línea de base proporciona instrucciones de ejemplo sobre cómo implementar una instancia local de Azure multinodo mediante la arquitectura de red conmutada de almacenamiento con dos puertos de adaptador de red convergentes para las intenciones de administración y proceso y dos puertos de adaptador de red dedicados para la intención de almacenamiento. Para más información, consulte Consideraciones de red para las implementaciones en la nube de Azure Local.

Esta arquitectura requiere dos o más nodos físicos y hasta un máximo de 16 nodos a escala. Cada nodo requiere cuatro puertos de adaptador de red que están conectados a dos conmutadores de la parte superior del bastidor (ToR). Los dos conmutadores ToR deben estar interconectados a través de vínculos de vínculo de varios chasis (MLAG). Los dos puertos de adaptador de red que se usan para el tráfico de intención de almacenamiento deben admitir acceso directo a memoria remota (RDMA). Estos puertos requieren una velocidad de vínculo mínima de 10 Gbps, pero se recomienda una velocidad de 25 Gbps o superior. Los dos puertos de adaptador de red que se usan para las intenciones de administración y proceso se convergen mediante la tecnología de formación de equipos insertadas (SET). La tecnología SET proporciona redundancia de vínculos y funcionalidades de equilibrio de carga. Estos puertos requieren una velocidad de vínculo mínima de 1 Gbps, pero se recomienda una velocidad de 10 Gbps o superior.

Topología de red física

La siguiente topología de red física muestra las conexiones físicas reales entre los nodos y los componentes de red.

Necesita los siguientes componentes al diseñar un almacenamiento multinodo conmutado de implementación local de Azure que usa esta arquitectura de línea de base:

Conmutadores tor duales:

Los conmutadores de red tor duales son necesarios para la resistencia de red y la capacidad de atender o aplicar actualizaciones de firmware, a los conmutadores sin incurrir en tiempo de inactividad. Esta estrategia impide un único punto de error (SPoF).

Los conmutadores ToR duales se usan para el almacenamiento o el tráfico este-oeste. Estos conmutadores usan dos puertos Ethernet dedicados que tienen redes de área local virtuales de almacenamiento específicas (VLAN) y clases de tráfico de control de flujo de prioridad (PFC) definidas para proporcionar comunicación RDMA sin pérdida.

Estos conmutadores se conectan a los nodos a través de cables Ethernet.

Dos o más nodos físicos y hasta un máximo de 16 nodos:

Cada nodo es un servidor físico que ejecuta el sistema operativo azure Stack HCI.

Cada nodo requiere cuatro puertos de adaptador de red en total: dos puertos compatibles con RDMA para el almacenamiento y dos puertos de adaptador de red para la administración y el tráfico de proceso.

Storage usa los dos puertos de adaptador de red compatibles con RDMA dedicados que se conectan con una ruta de acceso a cada uno de los dos conmutadores ToR. Este enfoque proporciona redundancia de ruta de acceso de vínculo y ancho de banda prioritario dedicado para el tráfico de almacenamiento directo de SMB.

La administración y el proceso usan dos puertos de adaptador de red que proporcionan una ruta de acceso a cada uno de los dos conmutadores ToR para la redundancia de la ruta de acceso de vínculo.

Conectividad externa:

Los conmutadores ToR duales se conectan a la red externa, como la LAN corporativa interna, para proporcionar acceso a las direcciones URL de salida necesarias mediante el dispositivo de red de borde perimetral. Este dispositivo puede ser un firewall o enrutador. Estos conmutadores enrutan el tráfico que entra y sale de la instancia local de Azure o del tráfico norte-sur.

La conectividad del tráfico norte-sur externo admite la intención de administración de clústeres y las intenciones de proceso. Esto se logra mediante dos puertos de conmutador y dos puertos de adaptador de red por nodo que se convergen a través de la formación de equipos insertada (SET) del conmutador y un conmutador virtual dentro de Hyper-V para garantizar la resistencia. Estos componentes funcionan para proporcionar conectividad externa para máquinas virtuales de Azure Arc y otros recursos de carga de trabajo implementados en las redes lógicas que se crean en Resource Manager mediante Azure Portal, la CLI o las plantillas de IaC.

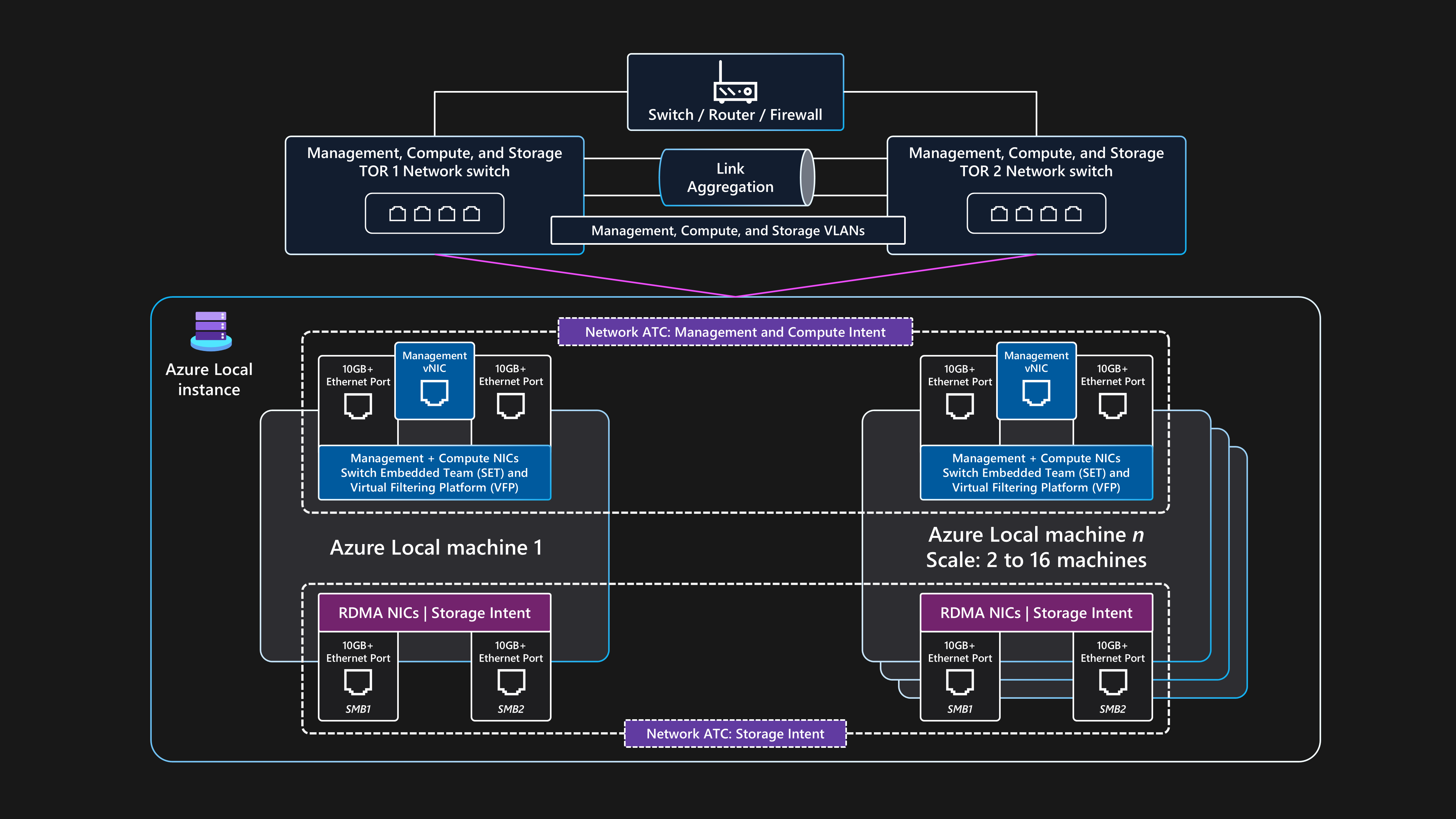

Topología de red lógica

La topología de red lógica muestra información general sobre cómo fluyen los datos de red entre dispositivos, independientemente de sus conexiones físicas.

Un resumen de la configuración lógica para esta arquitectura de línea de base conmutada de almacenamiento multinodo para Azure Local es el siguiente:

Conmutadores tor duales:

- Antes de implementar el clúster, los dos conmutadores de red ToR deben configurarse con los identificadores de VLAN necesarios, la configuración máxima de la unidad de transmisión y la configuración de puente del centro de datos para la administración de , procesoy puertos de almacenamiento. Para obtener más información, consulte Requisitos de red física para Azure Localo solicite ayuda al proveedor de hardware del conmutador o al asociado de SI.

Azure Local usa el enfoque de Network ATC para aplicar la automatización de red y la configuración de red basada en intenciones.

Network ATC está diseñado para garantizar una configuración de red óptima y el flujo de tráfico mediante el tráfico de red intenciones. Network ATC define qué puertos de adaptador de red físicos se usan para las diferentes intenciones de tráfico de red (o tipos), como para la administración del clúster , la carga de trabajo procesoy el clúster las intenciones de almacenamiento.

Las directivas basadas en intenciones simplifican los requisitos de configuración de red mediante la automatización de la configuración de red del nodo en función de las entradas de parámetro que se especifican como parte del proceso de implementación de la nube local de Azure.

Comunicación externa:

Cuando los nodos o la carga de trabajo necesitan comunicarse externamente mediante el acceso a la LAN corporativa, Internet u otro servicio, se enrutan mediante los conmutadores toR duales. Este proceso se describe en la sección anterior topología de red física.

Cuando los dos conmutadores ToR actúan como dispositivos de nivel 3, controlan el enrutamiento y proporcionan conectividad más allá del clúster al dispositivo de borde perimetral, como el firewall o el enrutador.

La intención de red de administración usa la interfaz virtual del equipo SET convergente, que permite que la dirección IP de administración del clúster y los recursos del plano de control se comuniquen externamente.

Para la intención de red de proceso, puede crear una o varias redes lógicas en Azure con los identificadores de VLAN específicos para su entorno. Los recursos de carga de trabajo, como las máquinas virtuales, usan estos identificadores para conceder acceso a la red física. Las redes lógicas usan los dos puertos de adaptador de red físicos que convergen mediante un equipo SET para las intenciones de proceso y administración.

Tráfico de almacenamiento:

Los nodos físicos se comunican entre sí mediante dos puertos de adaptador de red dedicados que están conectados a los conmutadores ToR para proporcionar un alto ancho de banda y resistencia para el tráfico de almacenamiento.

Los puertos de SMB1 y SMB2 se conectan a dos redes independientes no enrutables (o capa 2). Cada red tiene un identificador de VLAN específico configurado que debe coincidir con la configuración de los puertos de conmutador en el identificadores de VLAN de almacenamiento predeterminados: 711 y 712.

No hay ninguna puerta de enlace predeterminada configurada en los dos puertos de adaptador de red de intención de almacenamiento dentro del sistema operativo Azure Stack HCI.

Cada nodo puede acceder a las funcionalidades de Espacios de almacenamiento directo del clúster, como discos físicos remotos que se usan en el grupo de almacenamiento, los discos virtuales y los volúmenes. El acceso a estas funcionalidades se facilita a través del protocolo RDMA de SMB-Direct a través de los dos puertos de adaptador de red de almacenamiento dedicados que están disponibles en cada nodo. SMB multicanal se usa para la resistencia.

Esta configuración proporciona una velocidad de transferencia de datos suficiente para las operaciones relacionadas con el almacenamiento, como mantener copias coherentes de datos para volúmenes reflejados.

Requisitos del conmutador de red

Los conmutadores Ethernet deben cumplir las distintas especificaciones requeridas por Azure Local y establecidas por el Institute of Electrical and Electronics Engineers Standards Association (IEEE SA). Por ejemplo, para implementaciones conmutadas de almacenamiento multinodo, la red de almacenamiento se usa para RDMA a través de RoCE v2 o iWARP. Este proceso requiere IEEE 802.1Qbb PFC para garantizar la comunicación sin pérdida para la clase de tráfico de almacenamiento . Los conmutadores ToR deben proporcionar compatibilidad con IEEE 802.1Q para VLAN y IEEE 802.1AB para el Protocolo de detección de capas de vínculo.

Si tiene previsto usar conmutadores de red existentes para una implementación local de Azure, revise la lista de de las especificaciones y estándares DE IEEE obligatorios que deben proporcionar los conmutadores de red y la configuración. Al comprar nuevos conmutadores de red, revise la lista de modelos de conmutador certificados por el proveedor de hardware que admiten los requisitos de red local de Azure.

Requisitos de direcciones IP

En una implementación conmutada de almacenamiento de varios nodos, el número de direcciones IP necesarias aumenta con la adición de cada nodo físico, hasta un máximo de 16 nodos dentro de un único clúster. Por ejemplo, para implementar una configuración conmutada de almacenamiento de dos nodos de Azure Local, la infraestructura del clúster requiere que se asignen 11 x direcciones IP como mínimo. Se requieren más direcciones IP si usa microsegmentación o redes definidas por software. Para más información, consulte Revisión de los requisitos de dirección IP del patrón de referencia de almacenamiento de dos nodos para Azure Local.

Cuando diseñe y planee los requisitos de dirección IP para Azure Local, recuerde tener en cuenta las direcciones IP adicionales o los intervalos de red necesarios para la carga de trabajo más allá de las necesarias para los componentes de infraestructura e instancia local de Azure. Si tiene previsto implementar AKS en Azure Local, consulte AKS habilitado por los requisitos de red de Azure Arc.

Monitorización

Para mejorar la supervisión y las alertas, habilite Monitor Insights en Azure Local. Insights se puede escalar para supervisar y administrar varios clústeres locales mediante una experiencia coherente de Azure. Insights usa contadores de rendimiento del clúster y canales de registro de eventos para supervisar las características clave de Azure Local. El DCR recopila los registros que se configuran a través de Monitor y Log Analytics.

Insights para Azure Local se crea mediante Monitor y Log Analytics, lo que garantiza una solución siempre up-to-date y escalable que es altamente personalizable. Insights proporciona acceso a libros predeterminados con métricas básicas, junto con libros especializados creados para supervisar características clave de Azure Local. Estos componentes proporcionan una solución de supervisión casi en tiempo real y permiten la creación de gráficos, la personalización de las visualizaciones a través de la agregación y el filtrado, y la configuración de reglas de alertas personalizadas de Resource Health.

Administración de actualizaciones

Las instancias locales de Azure y los recursos de carga de trabajo implementados, como las máquinas virtuales de Azure Arc, deben actualizarse y revisarse periódicamente. Al aplicar actualizaciones periódicamente, asegúrese de que su organización mantiene una posición de seguridad sólida y mejora la confiabilidad general y la compatibilidad de su patrimonio. Se recomienda usar evaluaciones manuales automáticas y periódicas para la detección temprana y la aplicación de revisiones de seguridad y actualizaciones del sistema operativo.

Actualizaciones de infraestructura

Azure Local se actualiza continuamente para mejorar la experiencia del cliente y agregar nuevas características y funcionalidades. Este proceso se administra a través de los trenes de versión, que proporcionan nuevas compilaciones de línea base trimestrales. Las compilaciones de línea base se aplican a las instancias locales de Azure para mantenerlos actualizados. Además de las actualizaciones de compilación de línea base normales, Azure Local se actualiza con las actualizaciones mensuales de seguridad y confiabilidad del sistema operativo.

Update Manager es un servicio de Azure que puede usar para aplicar, ver y administrar actualizaciones para Azure Local. Este servicio proporciona un mecanismo para ver todas las instancias locales deAzure en toda la infraestructura y las ubicaciones perimetrales mediante Azure Portal para proporcionar una experiencia de administración centralizada. Para obtener más información, consulte los siguientes recursos:

Es importante comprobar si hay nuevas actualizaciones de controladores y firmware con regularidad, como cada tres a seis meses. Si usa una versión de categoría de solución Premier para el hardware local de Azure, las actualizaciones del paquete de extensión Solution Builder se integran con Update Manager para proporcionar una experiencia de actualización simplificada. Si usa nodos validados o una categoría de sistema integrada, puede haber un requisito para descargar y ejecutar un paquete de actualización específico del OEM que contenga las actualizaciones de firmware y controladores para el hardware. Para determinar cómo se proporcionan las actualizaciones para el hardware, póngase en contacto con el oem de hardware o el asociado de SI.

Aplicación de revisiones del sistema operativo invitado de carga de trabajo

Puede inscribir máquinas virtuales de Azure Arc que se implementan en Azure Local mediante azure Update Manager (AUM) para proporcionar una experiencia unificada de administración de revisiones mediante el mismo mecanismo que se usa para actualizar los nodos físicos del clúster local de Azure. Puede usar AUM para crear configuraciones de mantenimiento de invitado . Estas opciones de control de configuraciones, como la configuración reiniciar reiniciar si es necesario, la programación (fechas, horas y opciones de repetición) y una lista dinámica (suscripción) o estática de las máquinas virtuales de Azure Arc para el ámbito. Esta configuración controla la configuración de cuándo se instalan las revisiones de seguridad del sistema operativo dentro del sistema operativo invitado de la máquina virtual de carga de trabajo.

Consideraciones

Estas consideraciones implementan los pilares de Azure Well-Architected Framework, que es un conjunto de principios rectores que se pueden usar para mejorar la calidad de una carga de trabajo. Para obtener más información, consulte Microsoft Azure Well-Architected Framework.

Fiabilidad

La confiabilidad garantiza que la aplicación pueda cumplir los compromisos que realice para sus clientes. Para obtener más información, vea Lista de comprobación de revisión de diseño para lade confiabilidad.

Identificar los posibles puntos de error

Cada arquitectura es susceptible a errores. Puede prever errores y prepararse con mitigaciones con el análisis del modo de error. En la tabla siguiente se describen cuatro ejemplos de posibles puntos de error en esta arquitectura:

| Componente | Riesgo | Probabilidad | Efecto,mitigación/nota | Interrupción |

|---|---|---|---|---|

| Interrupción de la instancia local de Azure | Error de alimentación, red, hardware o software | Medio | Para evitar una interrupción prolongada de la aplicación causada por el error de una instancia local de Azure para casos de uso empresariales o críticos, la carga de trabajo debe diseñarse mediante los principios de alta disponibilidad y recuperación ante desastres. Por ejemplo, puede usar tecnologías de replicación de datos de carga de trabajo estándar del sector para mantener varias copias de datos de estado persistentes que se implementan mediante varias máquinas virtuales de Azure Arc o instancias de AKS que se implementan en instancias locales de Azure independientes y en ubicaciones físicas independientes. | Posible interrupción |

| Interrupción de un solo nodo físico local de Azure | Error de energía, hardware o software | Medio | Para evitar una interrupción prolongada de la aplicación causada por el error de una sola máquina local de Azure, la instancia local de Azure debe tener varios nodos físicos. Los requisitos de capacidad de carga de trabajo durante la fase de diseño del clúster determinan el número de nodos. Se recomienda tener tres o más nodos. También se recomienda usar la creación de reflejo triple, que es el modo de resistencia de almacenamiento predeterminado para los clústeres con tres o más nodos. Para evitar un SPoF y aumentar la resistencia de la carga de trabajo, implemente varias instancias de la carga de trabajo mediante dos o más máquinas virtuales o pods de contenedor de Azure Arc que se ejecutan en varios nodos de trabajo de AKS. Si se produce un error en un solo nodo, las máquinas virtuales de Azure Arc y los servicios de carga de trabajo o aplicación se reinician en los nodos físicos en línea restantes del clúster. | Posible interrupción |

| Máquina virtual de Azure Arc o nodo de trabajo de AKS (carga de trabajo) | Configuración incorrecta | Medio | Los usuarios de la aplicación no pueden iniciar sesión ni acceder a la aplicación. Se deben detectar errores de configuración durante la implementación. Si estos errores se producen durante una actualización de configuración, el equipo de DevOps debe revertir los cambios. Si es necesario, puede volver a implementar la máquina virtual. La reimplementación tarda menos de 10 minutos en implementarse, pero puede tardar más en función del tipo de implementación. | Posible interrupción |

| Conectividad a Azure | Interrupción de la red | Medio | El clúster debe alcanzar el plano de control de Azure con regularidad para las funcionalidades de facturación, administración y supervisión. Si el clúster pierde conectividad a Azure, funciona en un estado degradado. Por ejemplo, no sería posible implementar nuevas máquinas virtuales de Azure Arc ni clústeres de AKS si el clúster pierde conectividad con Azure. Las cargas de trabajo existentes que se ejecutan en el clúster de HCI siguen ejecutándose, pero debe restaurar la conexión en un plazo de 48 a 72 horas para garantizar una operación ininterrumpida. | Ninguno |

Para obtener más información, vea Recomendaciones para realizar el análisis del modo de error.

Destinos de confiabilidad

En esta sección se describe un escenario de ejemplo. Un cliente ficticio llamado Contoso Manufacturing usa esta arquitectura de referencia para implementar Azure Local. Quieren abordar sus requisitos e implementar y administrar cargas de trabajo en el entorno local. Contoso Manufacturing tiene un objetivo interno de objetivo de nivel de servicio (SLO) de 99,8% que las partes interesadas de la empresa y la aplicación coinciden en sus servicios.

Un SLO de 99.8% tiempo de actividad o disponibilidad, da como resultado los siguientes períodos de tiempo de inactividad permitidos, o falta de disponibilidad, para las aplicaciones que se implementan mediante máquinas virtuales de Azure Arc que se ejecutan en Azure Local:

Semanal: 20 minutos y 10 segundos

Mensual: 1 hora, 26 minutos y 56 segundos

Trimestral: 4 horas, 20 minutos y 49 segundos

Anual: 17 horas, 23 minutos y 16 segundos

Para ayudar a cumplir los objetivos de SLO, Contoso Manufacturing implementa el principio de privilegios mínimos (PoLP) para restringir el número de administradores de instancias locales de Azure a un pequeño grupo de usuarios de confianza y calificados. Este enfoque ayuda a evitar el tiempo de inactividad debido a las acciones involuntarias o accidentales realizadas en los recursos de producción. Además, los registros de eventos de seguridad de los controladores de dominio de Active Directory Domain Services (AD DS) locales se supervisan para detectar e informar de los cambios de pertenencia a grupos de cuentas de usuario, conocidos como agregar y quitar acciones de, para los administradores de instancias locales de Azure grupo mediante una solución de administración de eventos de información de seguridad (SIEM). La supervisión aumenta la confiabilidad y mejora la seguridad de la solución.

Para obtener más información, consulte Recomendaciones para la administración de identidades y acceso.

procedimientos estrictos de control de cambios están en vigor para los sistemas de producción de Contoso Manufacturing. Este proceso requiere que todos los cambios se prueben y validen en un entorno de prueba representativo antes de la implementación en producción. Todos los cambios enviados al proceso semanal del consejo de asesoramiento de cambios deben incluir un plan de implementación detallado (o vínculo al código fuente), una puntuación de nivel de riesgo, un plan de reversión completo, pruebas posteriores a la versión y comprobación, y criterios claros de éxito para que se revise o apruebe un cambio.

Para obtener más información, consulte recomendaciones de para procedimientos de implementación seguros.

las revisiones de seguridad mensuales y las actualizaciones trimestrales de línea base se aplican a la instancia local de Azure de producción solo después de que el entorno de preproducción valide. Update Manager y la característica de actualización compatible con el clúster automatizan el proceso de uso de migración en vivo de máquinas virtuales para minimizar el tiempo de inactividad de las cargas de trabajo críticas para la empresa durante las operaciones de mantenimiento mensuales. Los procedimientos operativos estándar de Contoso Manufacturing requieren que las actualizaciones de compilación de seguridad, confiabilidad o base de referencia se apliquen a todos los sistemas de producción en un plazo de cuatro semanas a partir de su fecha de lanzamiento. Sin esta directiva, los sistemas de producción no pueden mantenerse al día con las actualizaciones mensuales del sistema operativo y de seguridad. Los sistemas obsoletos afectan negativamente a la confiabilidad y seguridad de la plataforma.

Para obtener más información, consulte Recomendaciones para establecer una línea base de seguridad.

Contoso Manufacturing implementa diariamente, copias de seguridad semanales y mensuales conservar los últimos 6 x días de copias de seguridad diarias (de lunes a sábado), las últimas 3 x semanales (cada domingo) y 3 x copias de seguridad mensuales, con cada semana 4 de domingo 4 conservarse para convertirse en las copias de seguridad del mes 1, mes 2 y mes 3 mediante un programación basada en calendario gradual que se documenta y auditable. Este enfoque cumple los requisitos de fabricación de Contoso para obtener un equilibrio adecuado entre el número de puntos de recuperación de datos disponibles y reducir los costos del servicio de almacenamiento de copia de seguridad en la nube o fuera del sitio.

Para obtener más información, consulte Recomendaciones para diseñar una estrategia de recuperación ante desastres.

los procesos de copia de seguridad y recuperación de datos se prueban para cada sistema empresarial cada seis meses. Esta estrategia garantiza que los procesos de BCDR son válidos y que la empresa está protegida si se produce un desastre en un centro de datos o un incidente cibernético.

Para obtener más información, consulte Recomendaciones para diseñar una estrategia de pruebas de confiabilidad.

Los procesos operativos y los procedimientos descritos anteriormente en el artículo y las recomendaciones de la guía del servicio Well-Architected Framework para Azure Local, habilite Contoso Manufacturing para cumplir su destino de SLO 99.8% y escale y administre de forma eficaz las implementaciones de Azure Local y de cargas de trabajo en varios sitios de fabricación distribuidos en todo el mundo.

Para obtener más información, consulte recomendaciones de para definir destinos de confiabilidad.

Redundancia

Considere una carga de trabajo que implemente en una sola instancia local de Azure como una implementación con redundancia local. El clúster proporciona alta disponibilidad en el nivel de plataforma, pero debe implementar el clúster en un único bastidor. En el caso de casos de uso críticos o críticos para la empresa, se recomienda implementar varias instancias de una carga de trabajo o servicio en dos o más instancias locales de Azure independientes, idealmente en ubicaciones físicas independientes.

Use patrones de alta disponibilidad estándar del sector para cargas de trabajo que proporcionan replicación activa/pasiva, replicación sincrónica o replicación asincrónica, como SQL Server AlwaysOn. También puede usar una tecnología externa de equilibrio de carga de red (NLB) que enruta las solicitudes de usuario a través de varias instancias de carga de trabajo que se ejecutan en instancias locales de Azure que se implementan en ubicaciones físicas independientes. Considere la posibilidad de usar un dispositivo NLB externo asociado. También puede evaluar las opciones de equilibrio de carga que admiten el enrutamiento de tráfico para servicios híbridos y locales, como una instancia de Azure Application Gateway que usa Azure ExpressRoute o un túnel VPN para conectarse a un servicio local.

Para obtener más información, consulte recomendaciones de para diseñar la redundancia.

Seguridad

La seguridad proporciona garantías contra ataques deliberados y el abuso de sus valiosos datos y sistemas. Para obtener más información, vea Lista de comprobación de revisión de diseño para security.

Entre las consideraciones de seguridad se incluyen:

Una base segura para la plataforma local de Azure: Azure Local es un producto seguro de forma predeterminada que usa componentes de hardware validados con un TPM, UEFI y arranque seguro para crear una base segura para la seguridad de la plataforma local y de la carga de trabajo de Azure. Cuando se implementa con la configuración de seguridad predeterminada, Azure Local tiene habilitado el Control de aplicaciones de Windows Defender, Credential Guard y BitLocker. Para simplificar la delegación de permisos mediante poLP, use roles de control de acceso basado en rol (RBAC) integrados de Azure local como administrador local de Azure para administradores de plataformas y colaborador de máquina virtual local de Azure o lector de máquinas virtuales locales de Azure para operadores de carga de trabajo.

configuración de seguridad predeterminada: valor predeterminado de seguridad local de Azure aplica la configuración de seguridad predeterminada para la instancia local de Azure durante la implementación y habilita el control de desfase para mantener los nodos en un estado correcto conocido. Puede usar la configuración predeterminada de seguridad para administrar la seguridad del clúster, el control de desfase y la configuración del servidor principal protegido en el clúster.

Registros de eventos de seguridad: el reenvío de syslog local de Azure se integra con soluciones de supervisión de seguridad mediante la recuperación de registros de eventos de seguridad pertinentes para agregar y almacenar eventos para la retención en su propia plataforma SIEM.

Protección frente a amenazas y vulnerabilidades: Defender for Cloud protege la instancia local de Azure frente a diversas amenazas y vulnerabilidades. Este servicio ayuda a mejorar la posición de seguridad del entorno local de Azure y puede protegerse frente a amenazas existentes y en evolución.

detección y corrección de amenazas: Microsoft Advanced Threat Analytics detecta y corrige amenazas, como las que tienen como destino AD DS, que proporcionan servicios de autenticación a los nodos de instancia local de Azure y sus cargas de trabajo de máquina virtual de Windows Server.

aislamiento de red: aísle las redes si es necesario. Por ejemplo, puede aprovisionar varias redes lógicas que usan VLAN independientes y intervalos de direcciones de red. Al usar este enfoque, asegúrese de que la red de administración pueda llegar a cada red lógica y VLAN para que los nodos de instancia local de Azure puedan comunicarse con las redes VLAN a través de los conmutadores o puertas de enlace de ToR. Esta configuración es necesaria para la administración de la carga de trabajo, como permitir que los agentes de administración de infraestructura se comuniquen con el sistema operativo invitado de carga de trabajo.

Para obtener más información, consulte recomendaciones de para crear una estrategia de segmentación.

Optimización de costos

La optimización de costos consiste en examinar formas de reducir los gastos innecesarios y mejorar las eficiencias operativas. Para obtener más información, consulte Lista de comprobación de revisión de diseño para la optimización de costos.

Entre las consideraciones de optimización de costos se incluyen:

modelo de facturación de estilo de nube para licencias: los precios locales de Azure siguen el modelo de facturación de la suscripción mensual con una tarifa plana por núcleo de procesador físico en una instancia local de Azure. Se aplican cargos de uso adicionales si usa otros servicios de Azure. Si posee licencias básicas locales para Windows Server Datacenter Edition con Software Assurance activo, puede optar por intercambiar estas licencias para activar las cuotas de suscripción de máquina virtual de Azure Local y Windows Server.

aplicación automática de revisiones de invitado de máquina virtual para máquinas virtuales de Azure Arc: esta característica ayuda a reducir la sobrecarga de aplicación de revisiones manuales y los costos de mantenimiento asociados. Esta acción no solo ayuda a que el sistema sea más seguro, sino que también optimiza la asignación de recursos y contribuye a la eficiencia global de los costos.

consolidación de la supervisión de costos: para consolidar los costos de supervisión, use Insights para Azure Local y la revisión mediante Update Manager para Azure Local. Insights usa Monitor para proporcionar métricas enriquecidas y funcionalidades de alertas. El componente del administrador del ciclo de vida de Azure Localintegrates con Update Manager para simplificar la tarea de mantener actualizados los clústeres mediante la consolidación de flujos de trabajo de actualización para varios componentes en una sola experiencia. Use Monitor y Update Manager para optimizar la asignación de recursos y contribuir a la eficiencia global de los costos.

Para obtener más información, consulte recomendaciones de para optimizar el tiempo del personal.

Capacidad inicial de carga de trabajo y crecimiento: al planear la implementación local de Azure, tenga en cuenta la capacidad inicial de la carga de trabajo, los requisitos de resistencia y las consideraciones de crecimiento futuras. Considere si el uso de una arquitectura sin conmutador de almacenamiento de dos o tres nodos podría reducir los costos, como quitar la necesidad de adquirir conmutadores de red de clase de almacenamiento. La protección de conmutadores de red de clase de almacenamiento adicionales puede ser un componente costoso de las nuevas implementaciones de instancias locales de Azure. En su lugar, puede usar conmutadores existentes para redes de administración y proceso, lo que simplifica la infraestructura. Si la capacidad de carga de trabajo y las necesidades de resistencia no se escalan más allá de una configuración de tres nodos, considere si puede usar conmutadores existentes para las redes de administración y proceso y use la arquitectura sin conmutador de almacenamiento de tres nodos para implementar Azure Local.

Para obtener más información, consulte recomendaciones de para optimizar los costos de los componentes.

Propina

Puede ahorrar costos con ventaja híbrida de Azure si tiene licencias de Centro de datos de Windows Server con Software Assurance activo. Para más información, consulte Ventaja híbrida de Azure para Azure Local.

Excelencia operativa

La excelencia operativa abarca los procesos de operaciones que implementan una aplicación y lo mantienen en ejecución en producción. Para obtener más información, vea Lista de comprobación de revisión de diseño para la excelencia operativa.

Entre las consideraciones de excelencia operativa se incluyen:

experiencia simplificada de aprovisionamiento y administración integrada con Azure: la implementación basada en la nube de en Azure proporciona una interfaz controlada por asistentes que muestra cómo crear una instancia local de Azure. Del mismo modo, Azure simplifica el proceso de administrar instancias locales de Azure y máquinas virtuales de Azure Arc. Puede automatizar la implementación basada en el portal de la instancia local de Azure mediante la plantilla de ARM. Esta plantilla proporciona coherencia y automatización para implementar Azure Local a escala, específicamente en escenarios perimetrales, como tiendas minoristas o sitios de fabricación que requieren una instancia local de Azure para ejecutar cargas de trabajo críticas para la empresa.

funcionalidades de Automatización para máquinas virtuales: Azure Local proporciona una amplia gama de funcionalidades de automatización para administrar cargas de trabajo, como máquinas virtuales de Azure Arc, con la implementación automatizada de máquinas virtuales de Azure Arc mediante la CLI de Azure, ARM o la plantilla de Bicep, con actualizaciones del sistema operativo de máquina virtual mediante la extensión de Azure Arc para actualizaciones y Azure Update Manager para actualizar cada instancia local de Azure. Azure Local también proporciona compatibilidad con de administración de máquinas virtuales de Azure Arc mediante la CLI de Azure y máquinas virtuales que no son de Azure Arc mediante Windows PowerShell. Puede ejecutar comandos de la CLI de Azure localmente desde una de las máquinas locales de Azure o de forma remota desde un equipo de administración. La integración con azure Automation y Azure Arc facilita una amplia gama de escenarios de automatización adicionales para cargas de trabajo de máquina virtual a través de extensiones de Azure Arc.

Para obtener más información, consulte recomendaciones de para usar iaC.

funcionalidades de Automatización para contenedores en AKS: Azure Local proporciona una amplia gama de funcionalidades de automatización para administrar cargas de trabajo, como contenedores, en AKS. Puede automatizar la implementación de clústeres de AKS mediante la CLI de Azure. Actualice los clústeres de cargas de trabajo de AKS mediante la extensión de Azure Arc para actualizaciones de Kubernetes. También puede administrar de AKS habilitado para Azure Arc mediante la CLI de Azure. Puede ejecutar comandos de la CLI de Azure localmente desde una de las máquinas locales de Azure o de forma remota desde un equipo de administración. Integración con Azure Arc para una amplia gama de escenarios de automatización adicionales para cargas de trabajo en contenedores a través de extensiones de Azure Arc.

Para obtener más información, consulte recomendaciones de para habilitar la automatización.

Eficiencia del rendimiento

La eficiencia del rendimiento es la capacidad de la carga de trabajo para satisfacer las demandas que los usuarios ponen en ella de forma eficaz. Para obtener más información, vea Lista de comprobación de revisión de diseño para la eficiencia del rendimiento.

Entre las consideraciones de eficiencia del rendimiento se incluyen las siguientes:

rendimiento del almacenamiento de cargas de trabajo : considere la posibilidad de usar la herramienta diskSpd depara probar las funcionalidades de rendimiento del almacenamiento de cargas de trabajo de una instancia local de Azure. Puede usar la herramienta VMFleet para generar la carga y medir el rendimiento de un subsistema de almacenamiento. Evalúe si debe usar vmFleet para medir el rendimiento del subsistema de almacenamiento. Se recomienda establecer una base de referencia para el rendimiento de las instancias locales de Azure antes de implementar cargas de trabajo de producción. DiskSpd usa varios parámetros de línea de comandos que permiten a los administradores probar el rendimiento de almacenamiento del clúster. La función principal de DiskSpd es emitir operaciones de lectura y escritura y métricas de rendimiento de salida, como latencia, rendimiento e IOPS.

Para obtener más información, consulte Recomendaciones para pruebas de rendimiento.

resistencia del almacenamiento de cargas de trabajo: tenga en cuenta las ventajas de resistencia de almacenamiento, eficiencia de uso (o capacidad) y rendimiento. La planeación de volúmenes locales de Azure incluye la identificación del equilibrio óptimo entre resistencia, eficiencia de uso y rendimiento. Es posible que sea difícil optimizar este equilibrio porque maximizar una de estas características suele tener un efecto negativo en una o varias de las otras características. Aumentar la resistencia reduce la capacidad utilizable. Como resultado, el rendimiento puede variar, en función del tipo de resistencia seleccionado. Cuando la resistencia y el rendimiento son la prioridad y, cuando se usan tres o más nodos, la configuración de almacenamiento predeterminada emplea la creación de reflejo triple para los volúmenes de infraestructura y de usuario.

Para obtener más información, consulte recomendaciones de para planear la capacidad.

Optimización del rendimiento de red: considere la posibilidad de optimizar el rendimiento de la red. Como parte del diseño, asegúrese de incluir asignación de ancho de banda de tráfico de red proyectado al determinar el configuración óptima del hardware de red.

Para optimizar el rendimiento del proceso en Azure Local, puede usar la aceleración de GPU. La aceleración de GPU es beneficiosa para cargas de trabajo de inteligencia artificial o aprendizaje automático de alto rendimiento que implican información o inferencia de datos. Estas cargas de trabajo requieren implementación en ubicaciones perimetrales debido a consideraciones como la gravedad de los datos o los requisitos de seguridad. En una implementación híbrida o una implementación local, es importante tener en cuenta los requisitos de rendimiento de la carga de trabajo, incluidas las GPU. Este enfoque le ayuda a seleccionar los servicios adecuados al diseñar y adquirir las instancias locales de Azure.

Para obtener más información, consulte recomendaciones de para seleccionar los servicios adecuados.

Implementación de este escenario

En la sección siguiente se proporciona una lista de ejemplo de las tareas de alto nivel o el flujo de trabajo típico que se usa para implementar Azure Local, incluidas las tareas y consideraciones de requisitos previos. Esta lista de flujo de trabajo solo está pensada como guía de ejemplo. No es una lista exhaustiva de todas las acciones necesarias, que pueden variar en función de los requisitos organizativos, geográficos o específicos del proyecto.

escenario: hay un proyecto o un requisito de caso de uso para implementar una solución de nube híbrida en una ubicación local o perimetral proporcionar un proceso local para las funcionalidades de procesamiento de datos y un deseo de usar experiencias de facturación y administración coherentes con Azure. Se describen más detalles en la sección posibles casos de uso de este artículo. En los pasos restantes se supone que Azure Local es la solución de plataforma de infraestructura elegida para el proyecto.

Recopilar requisitos de carga de trabajo y casos de uso de las partes interesadas pertinentes. Esta estrategia permite al proyecto confirmar que las características y funcionalidades de Azure Local cumplen los requisitos de escala, rendimiento y funcionalidad de la carga de trabajo. Este proceso de revisión debe incluir comprender la escala o el tamaño de la carga de trabajo y las características necesarias, como máquinas virtuales de Azure Arc, AKS, Azure Virtual Desktop o Data Services habilitados para Azure Arc o Machine Learning Service habilitados para Azure Arc. Los valores de RTO y RPO de carga de trabajo (confiabilidad) y otros requisitos no funcionales (escalabilidad de rendimiento/carga) deben documentarse como parte de este paso de recopilación de requisitos.

Revise la salida del tamaño local de Azure para la solución de asociado de hardware recomendada. Esta salida incluye detalles de la marca y modelo de hardware del servidor físico recomendado, el número de nodos físicos y las especificaciones de la configuración de CPU, memoria y almacenamiento de cada nodo físico necesario para implementar y ejecutar las cargas de trabajo.

Use la herramienta de ajuste de tamaño local de azure para crear un nuevo proyecto que modele el tipo de carga de trabajo y escale. Este proyecto incluye el tamaño y el número de máquinas virtuales y sus requisitos de almacenamiento. Estos detalles se introducen junto con opciones para el tipo de sistema, la familia de CPU preferida y los requisitos de resistencia para la alta disponibilidad y la tolerancia a errores de almacenamiento, como se explica en la sección anterior Opciones de diseño de clústeres.

Revise la salida de Azure Local Sizer para la solución de asociado de hardware recomendada. Esta solución incluye detalles del hardware de servidor físico recomendado (marca y modelo), el número de nodos físicos y las especificaciones de la configuración de CPU, memoria y almacenamiento de cada nodo físico necesario para implementar y ejecutar las cargas de trabajo.

Póngase en contacto con el asociado de HARDWARE OEM o SI para calificar aún más la idoneidad de la versión de hardware recomendada frente a los requisitos de carga de trabajo. Si está disponible, use herramientas de ajuste de tamaño específicas de OEM para determinar los requisitos de ajuste de tamaño de hardware específicos del OEM para las cargas de trabajo previstas. Este paso suele incluir discusiones con el oem de hardware o asociado de SI para los aspectos comerciales de la solución. Estos aspectos incluyen presupuestos, disponibilidad del hardware, tiempos de entrega y cualquier servicio profesional o de valor añadido que proporcione el asociado para ayudar a acelerar el proyecto o los resultados empresariales.

Implemente dos conmutadores ToR para la integración de red. Para las soluciones de alta disponibilidad, los clústeres de HCI requieren que se implementen dos conmutadores ToR. Cada nodo físico requiere cuatro NIC, dos de las cuales deben ser compatibles con RDMA, que proporciona dos vínculos de cada nodo a los dos conmutadores ToR. Dos NIC, una conectada a cada conmutador, se convergen para la conectividad saliente norte-sur para las redes de proceso y administración. Las otras dos NIC compatibles con RDMA están dedicadas al tráfico este-oeste de almacenamiento. Si planea usar conmutadores de red existentes, asegúrese de que la marca y el modelo de los conmutadores se encuentran en la lista aprobada de conmutadores de red admitidos por Azure Local.

Trabaje con el asociado de HARDWARE OEM o SI para organizar la entrega del hardware. A continuación, el asociado de SI o los empleados deben integrar el hardware en el centro de datos local o la ubicación perimetral, como el bastidor y apilar el hardware, la red física y el cableado de la unidad de fuente de alimentación para los nodos físicos.

Realizar la implementación de la instancia local de Azure. En función de la versión de la solución elegida (solución Premier, sistema integrado o Nodos validados), el asociado de hardware, el asociado de SI o los empleados pueden implementar el software local de Azure. Este paso comienza incorporando los nodos físicos del sistema operativo Azure Stack HCI en servidores habilitados para Azure Arc y, a continuación, iniciando el proceso de implementación en la nube local de Azure. Los clientes y asociados pueden generar una solicitud de soporte técnico directamente con Microsoft en el Azure Portal seleccionando el icono soporte técnico y solución de problemas o poniéndose en contacto con su asociado oem o SI de hardware, en función de la naturaleza de la solicitud y la categoría de solución de hardware.

Propina

La implementación de referencia del sistema Azure Stack HCI, versión 23H2 muestra cómo implementar una implementación multiservidor conmutada de Azure Local mediante un archivo de plantilla y parámetros de ARM. Como alternativa, el ejemplo de Bicep muestra cómo usar una plantilla de Bicep para implementar una instancia local de Azure, incluidos sus recursos de requisitos previos.

Implementación de cargas de trabajo de alta disponibilidad en Azure Local mediante Azure Portal, LA CLI o plantillas de ARM + Azure Arc para la automatización. Use el ubicación personalizada recurso del nuevo clúster de HCI como región de destino cuando implementar recursos de carga de trabajo como máquinas virtuales de Azure Arc, AKS, hosts de sesión de Azure Virtual Desktop u otros servicios habilitados para Azure Arc que puede habilitar a través de extensiones de AKS y contenedorización en Azure Local.

Instalar actualizaciones mensuales para mejorar la seguridad y confiabilidad de la plataforma. Para mantener actualizadas las instancias locales de Azure, es importante instalar actualizaciones de software de Microsoft y actualizaciones de firmware y controladores oem de hardware. Estas actualizaciones mejoran la seguridad y confiabilidad de la plataforma. Update Manager aplica las actualizaciones y proporciona una solución centralizada y escalable para instalar actualizaciones en un único clúster o en varios clústeres. Consulte con el asociado oem de hardware para determinar el proceso de instalación de actualizaciones de controladores de hardware y firmware, ya que este proceso puede variar en función del tipo de categoría de solución de hardware elegido (solución Premier, Sistema integrado o Nodos validados). Para obtener más información, consulte Actualizaciones de infraestructura.

Recursos relacionados

- diseño de arquitectura híbrida

- opciones híbridas de Azure

- Automation en un entorno híbrido

- state Configuration de Azure Automation

- Optimizar la administración de instancias de SQL Server en entornos locales y multinube mediante Azure Arc

Pasos siguientes

Documentación del producto:

- información de versión del sistema operativo de Azure Stack HCI, versión 23H2

- AKS en Azure Local

- Azure Virtual Desktop para Azure Local

- ¿Qué es la supervisión local de Azure?

- proteger las cargas de trabajo de máquina virtual con Site Recovery en Azure Local

- monitor de información general

- introducción al seguimiento de cambios e inventario

- información general de Update Manager

- ¿Qué son los servicios de datos habilitados para Azure Arc?

- ¿Qué son los servidores habilitados para Azure Arc?

- ¿Qué es el servicio backup?

Documentación del producto para más información sobre servicios específicos de Azure:

- azure local

- azure Arc

- key Vault

- de Azure Blob Storage

- Monitor

- de Azure Policy

- de Azure Container Registry

- Defender for Cloud

- site Recovery

- de copia de seguridad de

Módulos de Microsoft Learn:

- Configurar monitor

- Diseño de la solución de recuperación de sitios en Azure

- Introducción a los servidores habilitados para Azure Arc

- Introducción a los servicios de datos habilitados para Azure Arc

- Introducción a AKS

- implementación de modelos de escalado con Machine Learning en cualquier lugar: blog de tech community

- Realizing Machine Learning anywhere with AKS and Azure Arc-enabled Machine Learning - Tech Community Blog

- Aprendizaje automático en AKS híbrido y Stack HCI mediante el aprendizaje automático habilitado para Azure Arc: blog de tech Community

- Introducción al destino de proceso de Kubernetes en Machine Learning

- Mantener actualizadas las máquinas virtuales

- Proteger la configuración de la máquina virtual con la configuración de estado de Automation

- Proteger las máquinas virtuales mediante de copia de seguridad