Einführung in instinktive Interaktionen

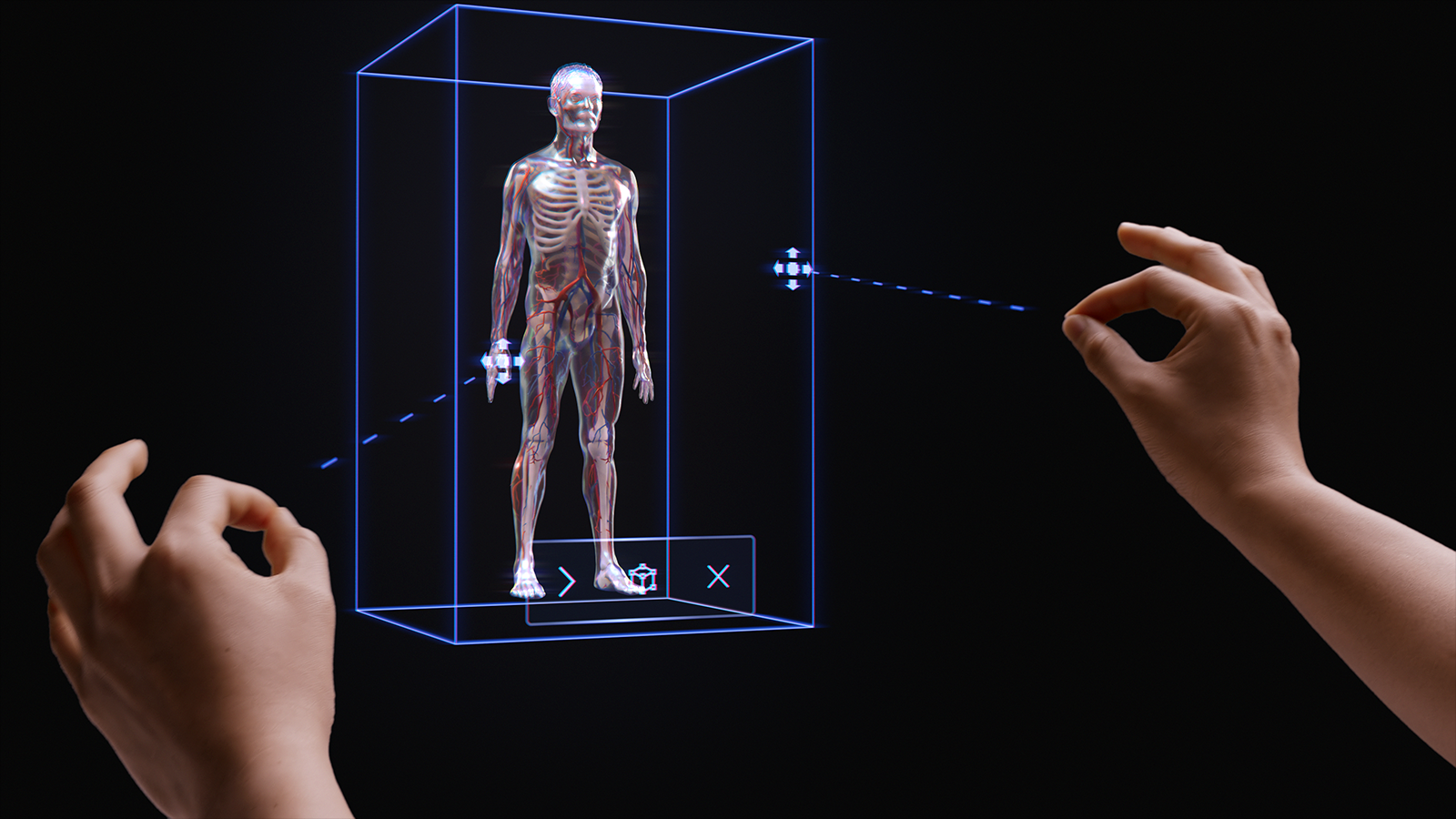

Die Philosophie der einfachen, instinktiven Interaktionen ist in der gesamten Mixed Reality-Plattform (MR) verwoben. Wir haben drei Schritte unternommen, um sicherzustellen, dass Anwendungsdesigner und Entwickler ihren Kunden einfache und intuitive Interaktionen bieten können.

Erstens haben wir sichergestellt, dass unsere Sensoren und Eingabetechnologien zu multimodalen Interaktionsmodellen kombiniert werden. Diese Interaktionsmodelle umfassen Hand- und Eyetracking sowie Eingaben in natürlicher Sprache. Basierend auf unserer Forschung ist das Entwerfen und Entwickeln innerhalb eines multimodalen Rahmens (und nicht basierend auf individuellen Eingaben) der Schlüssel für instinktive Erfahrungen.

Zweitens erkennen wir, dass viele Entwickler mehrere HoloLens-Geräte als Ziel verwenden, z. B. HoloLens 2 und HoloLens (1. Generation) oder HoloLens und VR. Daher haben wir unsere Interaktionsmodelle so konzipiert, dass sie geräteübergreifend funktionieren, auch wenn die Eingabetechnologie auf jedem Gerät variiert. Beispielsweise werden bei der Ferninteraktion auf einem Windows Immersive-Headset mit einem 6DoF-Controller und HoloLens 2 identische Angebote und Muster verwendet. Dies erleichtert die geräteübergreifende Anwendungsentwicklung und bietet ein natürliches Gefühl für Benutzerinteraktionen.

Obwohl wir wissen, dass es Tausende von effektiven, ansprechenden und magischen Interaktionen in MR gibt, haben wir festgestellt, dass die absichtliche Verwendung eines einzigen Interaktionsmodells in einer Anwendung die beste Möglichkeit ist, sicherzustellen, dass Benutzer erfolgreich sind und eine großartige Erfahrung haben. Zu diesem Zweck haben wir drei Dinge in diesen Interaktionsleitfaden aufgenommen:

- Spezifische Anleitung zu den drei primären Interaktionsmodellen und den jeweils erforderlichen Komponenten und Mustern.

- Zusätzliche Anleitungen zu anderen Vorteilen, die unsere Plattform bietet.

- Allgemeine Anleitungen zur Auswahl des geeigneten Interaktionsmodells für Ihr Entwicklungsszenario.

Demo zu grundlegenden Handnachverfolgungen und instinktiven Interaktionen

Sehen Sie sich unten unsere Videodemo Entwerfen von Hologrammen – Head Tracking und Eye Tracking an, und fahren Sie dann mit spezifischeren Themen fort:

Dieses Video stammt aus der App "Designing Holograms" HoloLens 2. Laden Sie hier herunter, und genießen Sie die gesamte Erfahrung.

Multimodale Interaktionsmodelle

Basierend auf unserer Recherche und unserem Feedback von Kunden haben wir festgestellt, dass drei primäre Interaktionsmodelle für die meisten Mixed Reality-Umgebungen geeignet sind. In vielerlei Hinsicht ist das Interaktionsmodell das mentale Modell des Benutzers, um einen Workflow abzuschließen. Jedes dieser Interaktionsmodelle ist für eine Reihe von Kundenanforderungen optimiert und ist bei richtiger Verwendung bequem, leistungsstark und verwendbar.

Das folgende Diagramm enthält eine vereinfachte Übersicht. Ausführliche Informationen zur Verwendung der einzelnen Interaktionsmodelle sind auf den folgenden Seiten mit Bildern und Codebeispielen verknüpft.

| Model | Beispielszenarien | Fit | Hardware |

| Hände und Motion-Controller | Räumliche 3D-Umgebungen, z. B. räumliches Layout und Entwurf, Inhaltsbearbeitung oder Simulation. | Ideal für neue Benutzer gekoppelt mit Stimme, Eyetracking oder Kopfanvisieren. Niedrige Lernkurve. Konsistente UX für Handtracking und 6DoF-Controller. | HoloLens 2 Immersive Headsets |

| Freisprechen | Kontextbezogene Erfahrungen, in denen die Hände eines Benutzers besetzt sind, z. B. Lernen und Wartung am Arbeitsplatz. | Einige Lerninhalte sind erforderlich. Wenn die Hände nicht verfügbar sind, kann das Gerät gut mit Sprache und natürlicher Sprache gekoppelt werden. | HoloLens 2 HoloLens (1. Generation) Immersive Headsets |

| Anvisieren und Committen | Durchklicken von Oberflächen, z. B. 3D-Präsentationen, Demos. | Erfordert Training auf HMDs, aber nicht auf Mobilgeräten. Am besten geeignet für zugängliche Controller. Am besten geeignet für HoloLens (1. Generation). | HoloLens 2 HoloLens (1. Generation) Immersive Headsets Mobile AR |

Um Lücken in der Benutzerinteraktion zu vermeiden, empfiehlt es sich, die Anleitung für ein einzelnes Modell von Anfang bis Ende zu befolgen.

In den folgenden Abschnitten werden die Schritte zum Auswählen und Implementieren eines dieser Interaktionsmodelle beschrieben.

Am Ende dieser Seite werden Sie unsere Anleitungen zu folgenden Themen verstehen:

- Auswählen eines Interaktionsmodells für Ihren Kunden

- Implementieren des Interaktionsmodells

- Übergang zwischen Interaktionsmodellen

- Entwurf der nächsten Schritte

Auswählen eines Interaktionsmodells für Ihren Kunden

In der Regel haben Entwickler und Ersteller die Arten von Interaktionen durchdacht, die ihre Kunden haben können. Zur Förderung eines kundenorientierten Entwurfsansatzes empfehlen wir die folgende Anleitung für die Auswahl des für Ihren Kunden optimierten Interaktionsmodells.

Warum sollten Sie diese Anleitung befolgen?

- Wir testen unsere Interaktionsmodelle auf objektive und subjektive Kriterien, einschließlich körperlicher und kognitiver Anstrengung, Intuitivität und Erlernbarkeit.

- Da Interaktionen unterschiedlich sind, können visuelle/audio-Angebote und Objektverhalten zwischen Interaktionsmodellen unterschiedlich sein.

- Durch das Kombinieren von Teilen mehrerer Interaktionsmodelle entsteht das Risiko konkurrierender Angebote, wie z. B. gleichzeitige Handstrahlen und ein Kopf-Anvisieren-Cursor. Dies kann Benutzer überwältigen und verwirren.

Im Folgenden finden Sie einige Beispiele dafür, wie Angebote und Verhaltensweisen für jedes Interaktionsmodell optimiert werden. Wir sehen oft, dass neue Benutzer ähnliche Fragen haben, z. B. "Woher weiß ich, dass das System funktioniert", "Woher weiß ich, was ich tun kann" und "Wie weiß ich, ob es verstanden hat, was ich gerade getan habe?"

| Model | Gewusst wie wissen, dass es funktioniert? | Gewusst wie wissen, was ich tun kann? | Gewusst wie wissen, was ich gerade getan habe? |

| Hände und Motion-Controller | Ich sehe ein Handgitter, ein Fingerspitzenangebot oder Hand-/Controllerstrahlen. | Ich sehe ziehbare Ziehpunkte oder ein Begrenzungsrahmen wird angezeigt, wenn sich meine Hand in der Nähe eines Objekts befindet. | Ich höre hörbare Töne und sehe Animationen beim Greifen und Loslassen. |

| Anvisieren mit dem Kopf und Commit | In der Mitte meines Sichtfelds wird ein Cursor angezeigt. | Der Cursor ändert den Zustand, wenn er sich über bestimmten Objekten befindet. | Ich sehe/höre visuelle und akustische Bestätigungen, wenn ich maßnahmen. |

| Freisprecheinrichtung (Anvisieren und Verweilen mit dem Kopf) | In der Mitte meines Sichtfelds wird ein Cursor angezeigt. | Ich sehe eine Statusanzeige, wenn ich auf einem interagierbaren Objekt verweile. | Ich sehe/höre visuelle und akustische Bestätigungen, wenn ich maßnahmen. |

| Freisprecheinrichtung (Sprachbefehl) | Ich sehe eine Lauschanzeige und Beschriftungen, die zeigen, was das System gehört hat. | Ich erhalte Sprachansagen und Hinweise. Wenn ich sage: "Was kann ich sagen?" Ich sehe Feedback. | Ich sehe/höre visuelle und hörbare Bestätigungen, wenn ich einen Befehl gebe, oder erhalte bei Bedarf eine UX-Benutzeroberfläche zur Mehrdeutigkeit. |

Im Folgenden finden Sie Fragen, die wir gefunden haben, um Teams bei der Auswahl eines Interaktionsmodells zu helfen:

F: Möchten meine Benutzer Hologramme berühren und präzise holografische Manipulationen durchführen?

A: Wenn ja, sehen Sie sich das Interaktionsmodell hands and motion controller (Hands and Motion Controller) an, um präzise Ziele und Manipulationen zu finden.F: Müssen meine Benutzer ihre Hände für reale Aufgaben freihalten?

A: Wenn ja, werfen Sie einen Blick auf das Freisprech-Interaktionsmodell, das eine großartige Freisprecherfahrung durch Anvisieren und sprachbasierte Interaktionen bietet.F: Haben meine Benutzer Zeit, Interaktionen für meine MR-Anwendung zu erlernen, oder benötigen sie die Interaktionen mit der niedrigsten Lernkurve?

A: Für die niedrigste Lernkurve und die intuitivsten Interaktionen empfehlen wir das Modell "Hands" und "Motion Controller", solange Benutzer ihre Hände für die Interaktion verwenden können.F: Verwenden meine Benutzer Motion-Controller zum Zeigen und Bearbeiten?

A: Das Modell der Hands- und Motion-Controller enthält alle Anleitungen für eine großartige Erfahrung mit Motion-Controllern.F: Verwenden meine Benutzer einen Barrierefreiheitscontroller oder einen allgemeinen Bluetooth-Controller, z. B. einen Clicker?

A: Wir empfehlen das Head-Gaze-and-Commit-Modell für alle nicht nachverfolgten Controller. Es ist so konzipiert, dass ein Benutzer eine gesamte Benutzeroberfläche mit einem einfachen "Ziel- und Commit"-Mechanismus durchlaufen kann.F: Durchlaufen meine Benutzer eine Benutzeroberfläche nur durch "Durchklicken" (z. B. in einer 3D-Diashow-ähnlichen Umgebung), anstatt in dichten Layouts von UI-Steuerelementen zu navigieren?

A: Wenn Benutzer nicht viele Benutzeroberflächen steuern müssen, bietet head-gaze and commit eine erlernbare Option, bei der benutzer sich keine Gedanken über die Zielausrichtung machen müssen.F: Verwenden meine Benutzer sowohl HoloLens (1. Generation) als auch HoloLens 2/Windows Mixed Reality immersive Headsets (VR)?

A: Da Head-Gaze und Commit das Interaktionsmodell für HoloLens (1. Generation) sind, wird empfohlen, dass Ersteller, die HoloLens (1. Generation) unterstützen, head-gaze and commit für alle Features oder Modi verwenden, die Benutzern auf einem HoloLens-Headset (1. Generation) angezeigt werden. Im nächsten Abschnitt zum Übergang von Interaktionsmodellen finden Sie Weitere Informationen zum Erstellen einer hervorragenden Erfahrung für mehrere HoloLens-Generationen.F: Was ist mit Benutzern, die mobil sind, einen großen Raum abdecken oder sich zwischen Räumen bewegen, im Gegensatz zu Benutzern, die tendenziell in einem einzigen Bereich arbeiten?

A: Jedes der Interaktionsmodelle funktioniert für diese Benutzer.

Hinweis

Weitere Anleitungen speziell für das App-Design sind in Kürze verfügbar.

Übergangsinteraktionsmodelle

Es gibt auch Anwendungsfälle, bei denen möglicherweise mehr als ein Interaktionsmodell verwendet werden muss. Der Erstellungsablauf Ihrer Anwendung verwendet beispielsweise das Interaktionsmodell "Hände und Bewegungscontroller" , sie möchten jedoch einen Freisprechmodus für Außendiensttechniker verwenden. Wenn Ihre Erfahrung mehrere Interaktionsmodelle erfordert, haben Benutzer möglicherweise Schwierigkeiten beim Übergang von einem Modell zu einem anderen, insbesondere wenn sie noch nicht mit Mixed Reality vertraut sind.

Hinweis

Wir arbeiten ständig an weiteren Anleitungen, die Entwicklern und Designern zur Verfügung stehen, und informieren sie darüber, wie, wann und warum mehrere MR-Interaktionsmodelle verwendet werden.