Weiterleiten von Datenströmen basierend auf Inhalten in Fabric-Eventstreams

Dieser Artikel beschreibt die Vorgehensweise zum Weiterleiten von Ereignissen basierend auf Inhalten in Microsoft Fabric-Eventstreams.

Sie können nun über den No-Code-Editor im Hauptkollaborationsbereich des Fabric-Eventstreams eine komplexe Streamverarbeitungslogik erstellen, ohne Code zu schreiben. Mit diesem Feature können Sie Ihre Streams einfacher anpassen, transformieren und verwalten. Nachdem Sie Ihre Vorgänge zum Verarbeiten von Streams festgelegt haben, können Sie Ihre Streams entsprechend dem spezifischen Schema und den Streamdaten problemlos an verschiedene Ziele senden.

Unterstützte Vorgänge

Hier ist die Liste der für die Echtzeitdatenverarbeitung unterstützten Vorgänge:

Aggregieren: Unterstützen von SUMME-, AVG-, MIN- und MAX-Funktionen, die Berechnungen für eine Spalte mit Werten ausführen und ein einzelnes Ergebnis zurückgeben.

Erweitern: Erweitern eines Array-Werts und Erstellen einer neuen Zeile für jeden Wert innerhalb eines Arrays.

Filtern: Auswählen oder Filtern bestimmter Zeilen aus dem Stream basierend auf einer Bedingung.

Gruppieren nach: Aggregieren aller Ereignisdaten innerhalb eines bestimmten Zeitfensters, mit der Option zum Gruppieren einer oder mehrerer Spalten.

Felder verwalten: Hinzufügen, Entfernen oder Ändern des Datentyps eines Felds oder einer Spalte Ihrer Streams.

Vereinigen: Verbinden von zwei oder mehr Streams mit freigegebenen Feldern des gleichen Namens und Datentyps in einem Stream. Nicht übereinstimmende Felder werden weggelassen.

Verknüpfen: Kombinieren Sie von Daten aus zwei Datenströmen basierend auf einer gemeinsamen übereinstimmenden Bedingung.

Unterstützte Ziele

Die unterstützten Ziele sind:

Lakehouse: Dieses Ziel bietet Ihnen die Möglichkeit, Ihre Echtzeitereignisse vor der Erfassung in Ihr Lakehouse zu transformieren. Echtzeitereignisse werden in das Delta Lake-Format konvertiert und dann in den angegebenen Lakehouse-Tabellen gespeichert. Dieses Ziel ist hilfreich für Data Warehouse-Szenarien.

Eventhouse: Mit diesem Ziel können Sie Ihre Echtzeit-Ereignisdaten in ein Eventhouse einspeisen, wo Sie die leistungsstarke Kusto Query Language (KQL) zur Abfrage und Analyse der Daten verwenden können. Mit den Daten in Eventhouse können Sie tiefere Einblicke in Ihre Ereignisdaten gewinnen und umfangreiche Berichte und Dashboards erstellen.

Fabric-Aktivator: Mit diesem Ziel können Sie Ihre Echtzeitereignisdaten direkt mit einem Fabric Activator verbinden. Ein Aktivator ist eine Art intelligenter Agent, der alle erforderlichen Informationen enthält, um eine Verbindung mit Daten herzustellen, auf Bedingungen zu überwachen und zu handeln. Wenn die Daten bestimmte Schwellenwerte erreichen oder mit anderen Mustern übereinstimmen, führt Aktivator automatisch geeignete Maßnahmen aus und warnt beispielsweise Benutzer*innen oder startet Power Automate-Workflows.

Benutzerdefinierter Endpunkt (früher benutzerdefinierte App): Mit diesem Ziel können Sie Ihre Echtzeitereignisse ganz einfach an eine benutzerdefinierte Anwendung weiterleiten. Mit diesem Ziel können Sie Ihre eigenen Anwendungen mit dem Eventstream verbinden und die Ereignisdaten in Echtzeit nutzen. Es ist nützlich, wenn Sie Echtzeitdaten an ein externes System außerhalb von Microsoft Fabric ausgeben möchten.

Stream: Dieses Ziel stellt den standardmäßigen unformatierten Eventstream dar, der von einer Reihe von Vorgängen transformiert wird, und wird auch als abgeleiteter Stream bezeichnet. Nach der Erstellung können Sie den Stream über den Echtzeithub anzeigen.

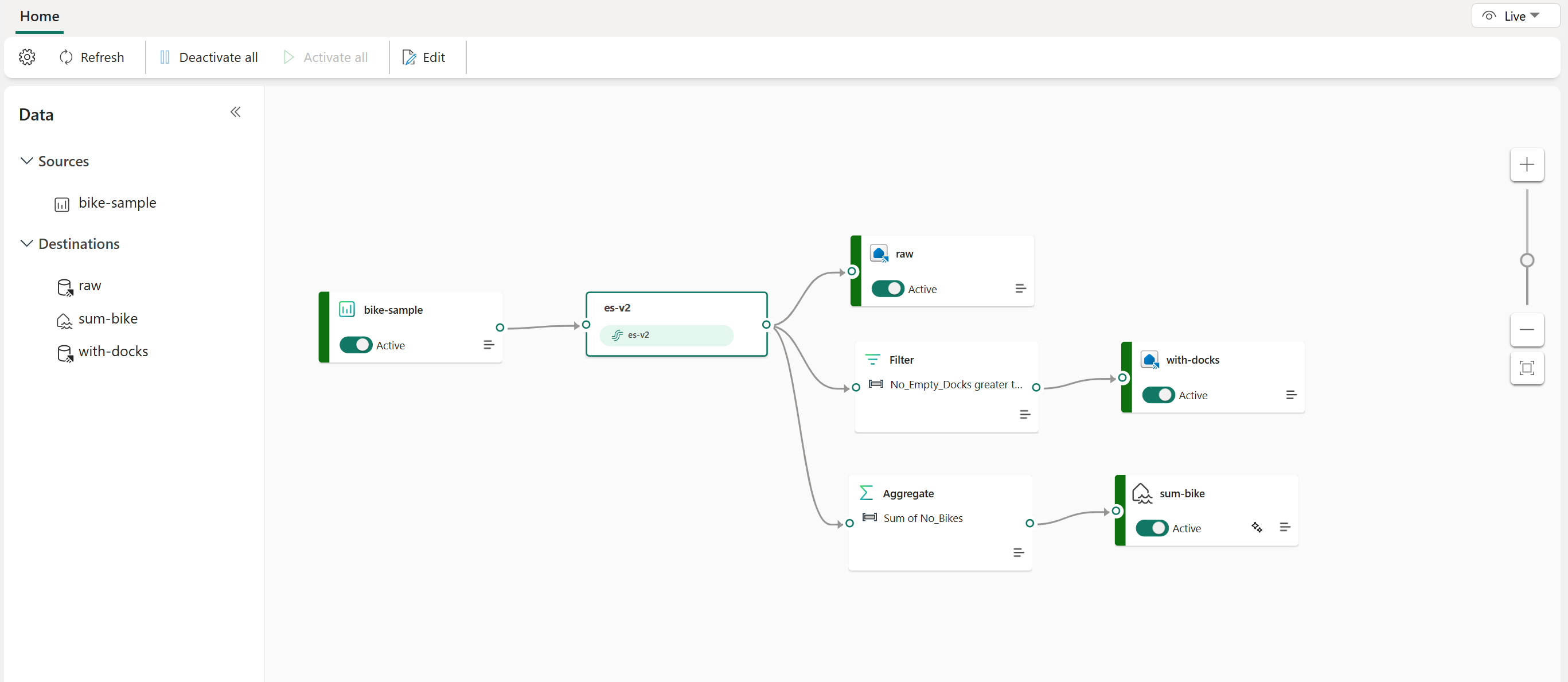

Das folgende Beispiel zeigt, wie drei unterschiedliche Fabric-Eventstreamziele für separate Funktionen für eine einzelne Streamquelle dienen können. One Eventhouse ist für das Speichern von Rohdaten bestimmt, ein zweites Eventhouse dient zum Aufbewahren gefilterter Datenströme, und das Lakehouse wird zum Speichern aggregierter Werte verwendet.

Gehen Sie zum Transformieren und Weiterleiten Ihres Streams basierend auf Inhalten nach den Schritten unter Bearbeiten und veröffentlichen eines Eventstreams vor und beginnen Sie mit dem Entwerfen der Streamverarbeitungslogik für Ihren Stream.