Was ist Data Science in Microsoft Fabric?

Microsoft Fabric bietet Data Science-Erfahrungen, um Benutzern die Möglichkeit zu bieten, End-to-End Data Science-Workflows für den Zweck der Datenerweiterung und geschäftserkenntnisse abzuschließen. Sie können eine breite Palette von Aktivitäten im gesamten Data Science-Prozess durchführen, von der Datenerkundung, Vorbereitung und Reinigung bis hin zu Experimentierung, Modellierung, Modellbewertung und Bereitstellung von predictive Insights für BI-Berichte.

Microsoft Fabric-Benutzer können auf eine Data Science-Homepage zugreifen. Von dort aus können sie verschiedene relevante Ressourcen entdecken und darauf zugreifen. Sie können z. B. Machine Learning Experimente, Modelle und Notizbücher erstellen. Sie können auch vorhandene Notizbücher auf der Data Science-Startseite importieren.

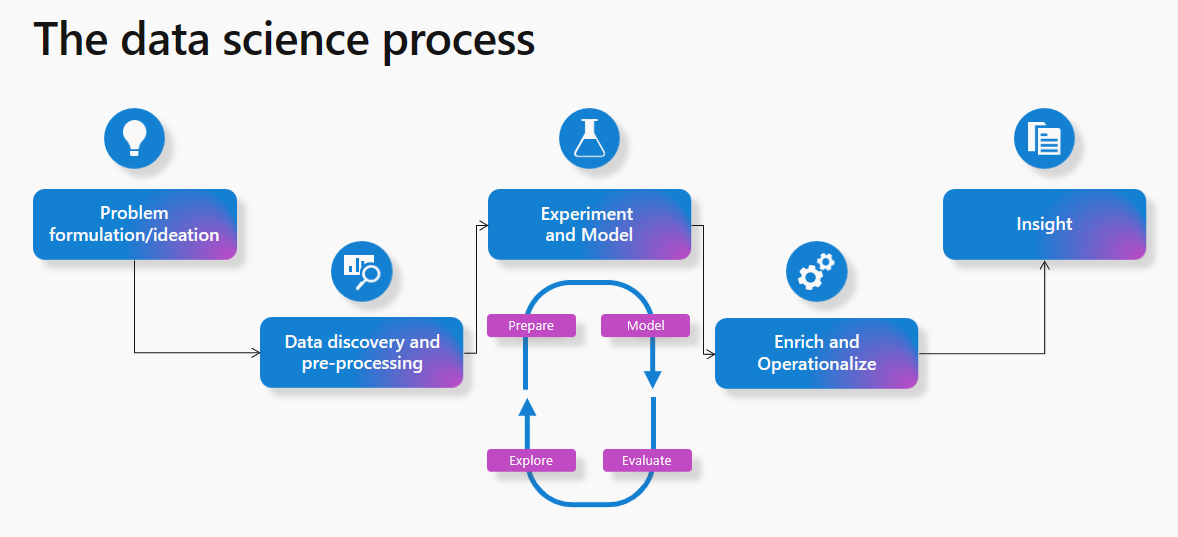

Möglicherweise wissen Sie, wie ein typischer Data Science-Prozess funktioniert. Als bekannter Prozess wird er von den meisten maschinellen Lernprojekten verfolgt.

Auf hoher Ebene umfasst der Prozess die folgenden Schritte:

- Problemformulierung und Idee

- Datenermittlung und Vorverarbeitung

- Experimentieren und Modellieren

- Bereichern und Operationalisieren

- Gewinnen Sie Einblicke

In diesem Artikel werden die Microsoft Fabric Data Science-Funktionen aus sicht eines Data Science-Prozesses beschrieben. Für jeden Schritt im Data Science-Prozess fasst dieser Artikel die Microsoft Fabric-Funktionen zusammen, die Ihnen helfen können.

Problemformulierung und Idee

Data Science-Benutzer in Microsoft Fabric arbeiten auf derselben Plattform wie Geschäftsbenutzer und Analysten. Die Datenfreigabe und Zusammenarbeit zwischen verschiedenen Rollen werden dadurch nahtloser. Analysten können Power BI-Berichte und -Datasets ganz einfach mit Data Science-Experten teilen. Die einfache Zusammenarbeit in Verschiedenen Rollen in Microsoft Fabric erleichtert die Übergabe während der Problemformulierungsphase erheblich.

Datenermittlung und Vorverarbeitung

Microsoft Fabric-Benutzer können mithilfe des Lakehouse-Elements mit Daten in OneLake interagieren. Lakehouse lässt sich leicht an ein Notizbuch anschließen, um Daten zu durchsuchen und zu interagieren.

Benutzer können Daten aus einem Lakehouse einfach direkt in einen Pandas-Datenframe lesen. Für Erkundungszwecke ermöglicht dies nahtlose Daten-Lesevorgänge aus OneLake.

Ein leistungsstarker Satz von Tools steht für Pipelines zur Datenaufnahme, Datenorchestrierung sowie Datenintegration zur Verfügung – ein nativer Bestandteil von Microsoft Fabric. Einfach zu erstellende Datenpipelinen können auf die Daten zugreifen und sie in ein Format umwandeln, das maschinelles Lernen nutzen kann.

Durchsuchen von Daten

Ein wichtiger Bestandteil des maschinellen Lernprozesses ist das Verständnis von Daten durch Exploration und Visualisierung.

Je nach Datenspeicherort bietet Microsoft Fabric eine Reihe verschiedener Tools zum Untersuchen und Vorbereiten der Daten für Analysen und maschinelles Lernen. Notizbücher werden zu einer der schnellsten Möglichkeiten, mit der Datensuche zu beginnen.

Apache Spark und Python zur Datenvorbereitung

Microsoft Fabric bietet Funktionen zum Transformieren, Vorbereiten und Untersuchen Ihrer Daten im großen Maßstab. Mit Spark können Benutzer PySpark/Python, Scala und SparkR/SparklyR-Tools für die Datenvorverarbeitung im großen Maßstab nutzen. Leistungsstarke Open-Source-Visualisierungsbibliotheken können die Datenerkundung verbessern, um die Daten besser zu verstehen.

Daten-Wrangler für nahtlose Datenbereinigung

Die Microsoft Fabric-Notizbuchoberfläche hat ein Feature zur Verwendung von Data Wrangler hinzugefügt, einem Codetool, das Daten vorbereitet und Python-Code generiert. Diese Erfahrung erleichtert es, mühsame und mundane Aufgaben zu beschleunigen – z. B. Datenbereinigungen und Erstellen von Wiederholbarkeit und Automatisierung durch generierten Code. Erfahren Sie mehr über Data Wrangler im Abschnitt "Data Wrangler" dieses Dokuments.

Experimentieren und ML-Modellierung

Mit Tools wie PySpark/Python, SparklyR/R, können Notizbücher maschinelle Lernmodellschulungen verarbeiten.

ML-Algorithmen und Bibliotheken können dabei helfen, Machine Learning-Modelle zu trainieren. Bibliotheksverwaltungstools können diese Bibliotheken und Algorithmen installieren. Benutzer haben daher die Möglichkeit, eine vielzahl beliebter Machine Learning-Bibliotheken zu nutzen, um ihre ML-Modellschulung in Microsoft Fabric abzuschließen.

Darüber hinaus können beliebte Bibliotheken wie Scikit Learn auch Modelle entwickeln.

MLflow-Experimente und -Läufe können die ML-Modellschulung nachverfolgen. Microsoft Fabric bietet eine integrierte MLflow-Erfahrung, mit der Benutzer interagieren können, um Experimente und Modelle zu protokollieren. Erfahren Sie mehr über die Verwendung von MLflow zum Nachverfolgen von Experimenten und zum Verwalten von Modellen in Microsoft Fabric.

SynapseML

Die Open-Source-Bibliothek SynapseML (früher als MMLSpark bezeichnet), die Microsoft besitzt und verwaltet, vereinfacht die Erstellung von massiven skalierbaren Machine Learning-Pipelines. Als Werkzeugökosystem erweitert es das Apache Spark Framework in verschiedene neue Richtungen. SynapseML vereint mehrere vorhandene Machine Learning Frameworks und neue Microsoft-Algorithmen in einer einzigen, skalierbaren API. Die Open-Source SynapseML-Bibliothek umfasst ein umfangreiches Ökosystem von ML-Tools für die Entwicklung von Prädiktiven Modellen sowie die Nutzung von vorab trainierten KI-Modellen aus Azure AI-Diensten. Erfahren Sie mehr über SynapseML.

Bereichern und Operationalisieren

Notizbücher können mithilfe von Open-Source-Bibliotheken zur Vorhersage oder der skalierbaren universellen Spark Predict-Funktion von Microsoft Fabric die Batchbewertung von Machine-Learning-Modellen durchführen. Diese Funktion unterstützt MLflow-verpackte Modelle in der Microsoft Fabric Modellregistrierung.

Gewinnen Sie Einblicke

In Microsoft Fabric können vorhergesagte Werte problemlos in OneLake geschrieben und nahtlos aus Power BI-Berichten mit dem Power BI Direct Lake-Modus genutzt werden. Dies erleichtert Es Data Science-Praktikern, Ergebnisse aus ihrer Arbeit mit den Projektbeteiligten zu teilen, und es vereinfacht auch die Operationalisierung.

Notebooks, die eine Batchbewertung enthalten, können mit den Notebook-Planungsfunktionen für die Ausführung geplant werden. Die Batchbewertung kann auch als Teil von Datenpipelineaktivitäten oder Spark-Aufträgen geplant werden. Power BI erhält automatisch die neuesten Vorhersagen, ohne dass die Daten geladen oder aktualisiert werden müssen, dank des Direct Lake-Modus in Microsoft Fabric.

Durchsuchen von Daten mit semantischer Verknüpfung

Data Scientists und Business Analysts verbringen viel Zeit damit, Daten zu verstehen, zu bereinigen und zu transformieren, bevor sie mit einer sinnvollen Analyse beginnen können. Business Analysts arbeiten in der Regel mit semantischen Modellen und codieren ihre Domänenkenntnisse und Geschäftslogik in Power BI-Measures. Andererseits können Datenwissenschaftler mit denselben Daten arbeiten, aber in der Regel in einer anderen Codeumgebung oder Sprache.

Mit der semantischen Verknüpfung können Datenwissenschaftler eine Verbindung zwischen Power BI-Semantikmodellen und der Synapse Data Science in Microsoft Fabric-Erfahrung über die SemPy Python-Bibliothekherstellen. SemPy vereinfacht die Datenanalyse, indem Datensemantik erfasst und genutzt wird, da Benutzer verschiedene Transformationen für die semantischen Modelle durchführen. Mithilfe der semantischen Verknüpfung können Datenwissenschaftler:

- vermeiden Sie, dass Geschäftslogik und Domänenwissen in ihrem Code neu implementiert werden müssen

- Einfacher Zugriff auf und Verwenden von Power BI-Measures in ihrem Code

- Verwenden von Semantik zum Nutzen neuer Erfahrungen, z. B. semantischer Funktionen

- Untersuchen und Überprüfen funktionaler Abhängigkeiten und Beziehungen zwischen Daten

Durch die Verwendung von SemPy können Organisationen folgendes sehen:

- Höhere Produktivität und schnellere Zusammenarbeit in Teams, die mit denselben Datasets arbeiten

- Förderung der übergreifenden Zusammenarbeit in Business Intelligence- und KI-Teams

- Reduzierte Mehrdeutigkeit und eine einfachere Lernkurve beim Onboarding in ein neues Modell oder Dataset

Weitere Informationen zur semantischen Verknüpfung finden Sie unter Was ist semantischer Link?.

Verwandte Inhalte

- Informationen zu den ersten Schritten mit umfassenden Data-Science-Beispielen finden Sie unter Data-Science-Tutorials.

- Weitere Informationen zur Datenvorbereitung und -reinigung mit Data Wrangler finden Sie unter Data Wrangler

- Weitere Informationen zum Nachverfolgen von Experimenten finden Sie unter Machine Learning Experiment

- Weitere Informationen zum Verwalten von Modellen finden Sie unter Machine Learning-Modell

- Weitere Informationen zur Batchbewertung mit Predict finden Sie unter Bewertung von Modellen mit PREDICT.

- Bereitstellen von Vorhersagen aus Lakehouse in Power BI mit dem Direct Lake-Modus