End-to-End-Szenario für Data Science: Einführung und Architektur

Diese Reihe von Lernprogrammen veranschaulicht ein Beispiel für ein End-to-End-Szenario in der Fabric Data Science-Erfahrung. Sie implementieren jeden Schritt von der Datenaufnahme, Reinigung und Vorbereitung, zum Trainieren von Machine Learning-Modellen und zum Generieren von Erkenntnissen und nutzen diese Erkenntnisse dann mithilfe von Visualisierungstools wie Power BI.

Wenn Sie noch nicht mit Microsoft Fabric arbeiten, lesen Sie Was ist Microsoft Fabric?.

Einleitung

Der Lebenszyklus eines Data Science-Projekts umfasst in der Regel die folgenden Schritte (häufig iterativ):

- Unternehmensverständnis

- Datenerfassung

- Datenerkundung, Reinigung, Vorbereitung und Visualisierung

- Modelltraining und Experimentnachverfolgung

- Modellbewertung und Generieren von Erkenntnissen.

Die Ziele und Erfolgskriterien jeder Phase hängen von der Zusammenarbeit, der Datenfreigabe und der Dokumentation ab. Die Fabric Data Science-Erfahrung besteht aus mehreren nativ entwickelten Funktionen, die Zusammenarbeit, Datenerfassung, Freigabe und Nutzung nahtlos ermöglichen.

In diesen Lernprogrammen übernehmen Sie die Rolle eines Datenwissenschaftlers, dem die Aufgabe gegeben wurde, einen Datensatz zu untersuchen, zu bereinigen und zu transformieren, der den Abwanderungsstatus von 10.000 Kunden bei einer Bank enthält. Anschließend erstellen Sie ein Machine Learning-Modell, um vorherzusagen, welche Bankkunden wahrscheinlich verlassen werden.

Sie lernen, die folgenden Aktivitäten auszuführen:

- Verwenden Sie die Fabric-Notizbücher für Data Science-Szenarien.

- Daten mithilfe von Apache Spark in ein Fabric Lakehouse importieren.

- Laden vorhandener Daten aus den Lakehouse-Delta-Tabellen

- Bereinigen und Transformieren von Daten mithilfe von Apache Spark- und Python-basierten Tools.

- Erstellen Sie Experimente und Läufe, um verschiedene Machine Learning-Modelle zu trainieren.

- Registrieren und verfolgen Sie trainierte Modelle mithilfe von MLflow und der Fabric UI.

- Ausführen einer Bewertung im großen Stil und Speichern von Vorhersagen und Rückschlussergebnissen im Lakehouse

- Visualisieren Sie Vorhersagen in Power BI mithilfe von DirectLake.

Architektur

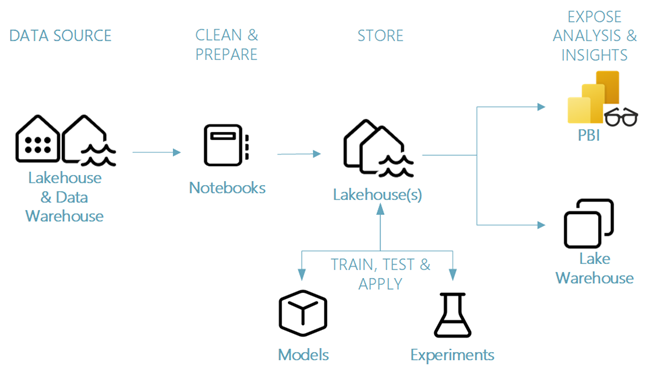

In dieser Lernprogrammreihe zeigen wir ein vereinfachtes End-to-End-Data Science-Szenario, das Folgendes umfasst:

- Erfassen von Daten aus einer externen Datenquelle

- Untersuchen und Bereinigen von Daten.

- Trainieren und Registrieren von Machine Learning Modellen.

- Führen Sie eine Batchbewertung durch und speichern Sie Vorhersagen.

- Visualisieren der Vorhersageergebnisse in Power BI.

Verschiedene Komponenten des Data Science-Szenarios

Datenquellen – Fabric erleichtert es, schnell eine Verbindung zu Azure Data Services, anderen Cloud-Plattformen und lokalen Datenquellen herzustellen, um Daten zu erfassen. Mithilfe von Fabric-Notizbüchern können Sie Daten aus den integrierten Lakehouse-, Data Warehouse-, semantischen Modellen und verschiedenen Apache Spark- und Python-unterstützten benutzerdefinierten Datenquellen aufnehmen. Diese Tutorialreihe konzentriert sich auf das Erfassen und Laden von Daten aus einem Lakehouse.

Erkunden, reinigen und vorbereiten – Die Data Science-Erfahrung von Fabric unterstützt Datenbereinigung, Transformation, Erkundung und Featurisierung mithilfe integrierter Erfahrungen auf Spark sowie Python-basierten Tools wie Data Wrangler und SemPy Library. In diesem Lernprogramm wird die Datenerkundung mithilfe von Python-Bibliothek seaborn und Datenbereinigung und -vorbereitung mithilfe von Apache Spark vorgestellt.

Modelle und Experimente – Mit Fabric können Sie Machine Learning-Modelle trainieren, auswerten und bewerten, indem Sie integrierte Experiment- und Modellelemente mit nahtloser Integration mit MLflow- für die Erfassung und Modellregistrierung/Bereitstellung von Experimenten verwenden. Fabric bietet außerdem Funktionen für modellvorhersage im Maßstab (PREDICT), um Geschäftseinblicke zu gewinnen und zu teilen.

Speicher: Fabric ist für Delta Lake standardisiert, sodass alle Engines von Fabric mit demselben, in einem Lakehouse gespeicherten Dataset interagieren können. Mit dieser Speicherebene können Sie sowohl strukturierte als auch unstrukturierte Daten speichern, die sowohl dateibasierte Speicher- als auch tabellarische Formate unterstützen. Auf die gespeicherten Datasets und Dateien kann einfach über alle Fabric-Erfahrungselemente wie Notizbücher und Pipelines zugegriffen werden.

Bereitstellen von Analysen und Erkenntnissen – Daten aus einem Lakehouse können von Power BI, dem führenden Business Intelligence-Tool, für Reporting und Visualisierung genutzt werden. Daten, die im Seehaus gespeichert sind, können auch in Notizbüchern mithilfe von Spark- oder Python nativen Visualisierungsbibliotheken wie matplotlib, seaborn, plotlyund mehr visualisiert werden. Daten können auch mithilfe der SemPy-Bibliothek visualisiert werden, die integrierte umfassende, aufgabenspezifische Visualisierungen für das semantische Datenmodell, für Abhängigkeiten und deren Verletzungen sowie für Klassifizierungs- und Regressionsanwendungsfälle unterstützt.