Optionen zum Abrufen von Daten im Fabric Lakehouse

Die Funktionalität für den Datenabruf deckt alle Benutzerszenarien zum Laden von Daten in das Lakehouse ab, darunter die folgenden:

- Herstellen einer Verbindung mit einer vorhandenen SQL Server-Instanz und Kopieren von Daten in eine Delta-Tabelle im Lakehouse

- Hochladen von Dateien von Ihrem Computer

- Kopieren und Zusammenführen mehrerer Tabellen aus anderen Lakehouses in eine neue Delta-Tabelle

- Herstellen einer Verbindung mit einer Streamingquelle, um Daten in ein Lakehouse zu laden

- Referenzieren von Daten, ohne sie aus anderen internen Lakehouses oder externen Quellen zu kopieren

Verschiedene Möglichkeiten zum Laden von Daten in ein Lakehouse

In Microsoft Fabric gibt es verschiedene Möglichkeiten, wie Sie Daten in ein Lakehouse laden können:

- Dateiupload vom lokalen Computer

- Ausführen eines Kopiertools in Pipelines

- Einrichten eines Dataflows

- Apache Spark-Bibliotheken im Notebookcode

- Streamen von Echtzeitereignissen mit Eventstreams

- Abrufen von Daten aus Eventhouses

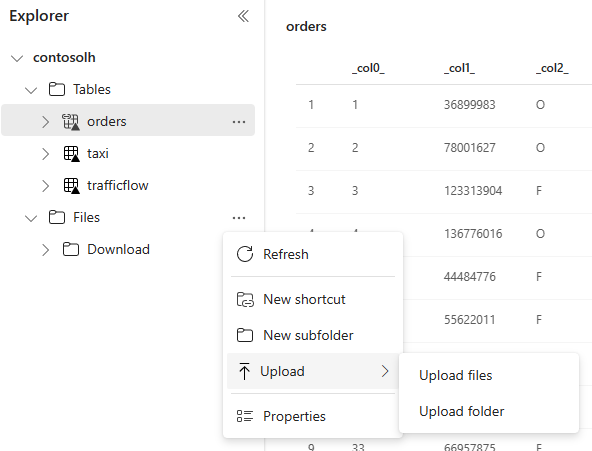

Lokaler Dateiupload

Sie können auch Daten hochladen, die auf Ihrem lokalen Computer gespeichert sind. Dies ist direkt im Lakehouse-Explorer möglich.

Kopiertool in Pipelines

Das Kopiertool ist eine hochgradig skalierbare Datenintegrationslösung, über die Sie eine Verbindung mit verschiedenen Datenquellen herstellen und die Daten entweder im Originalformat laden oder in eine Delta-Tabelle konvertieren können. Das Kopiertool ist Bestandteil von Pipelineaktivitäten, die Sie auf verschiedene Weise anpassen können, z. B. durch eine Planung oder Auslösung auf der Grundlage eines Ereignisses. Weitere Informationen finden Sie unter Kopieren von Daten mithilfe der Kopieraktivität.

Dataflows

Für Benutzer, die mit Power BI-Dataflows vertraut sind, steht dasselbe Tool zum Laden von Daten in Ihr Lakehouse zur Verfügung. Sie können über die Option „Daten abrufen“ im Lakehouse-Explorer schnell darauf zugreifen und Daten von über 200 Connectors laden. Weitere Informationen finden Sie unter Schnellstart: Erstellen Ihres ersten Dataflow zum Abrufen und Transformieren von Daten.

Notebookcode

Sie können verfügbare Spark-Bibliotheken nutzen, um eine direkte Verbindung mit einer Datenquelle herzustellen, Daten in einen Datenframe zu laden und sie dann in einem Lakehouse zu speichern. Diese Methode ist die transparenteste Art zum Laden von Daten in das Lakehouse, bei der der Benutzercode vollständig verwaltet wird.

Hinweis

Externe Delta-Tabellen, die mit Spark-Code erstellt wurden, sind für einen SQL-Analyseendpunkt nicht sichtbar. Verwenden Sie im Tabellenbereich Tastenkombinationen, um externe Delta-Tabellen für einen SQL-Analyseendpunkt sichtbar zu machen. Informationen darüber, wie Sie eine Verknüpfung erstellen können, finden Sie unter Erstellen einer Verknüpfung zu Dateien oder Tabellen.

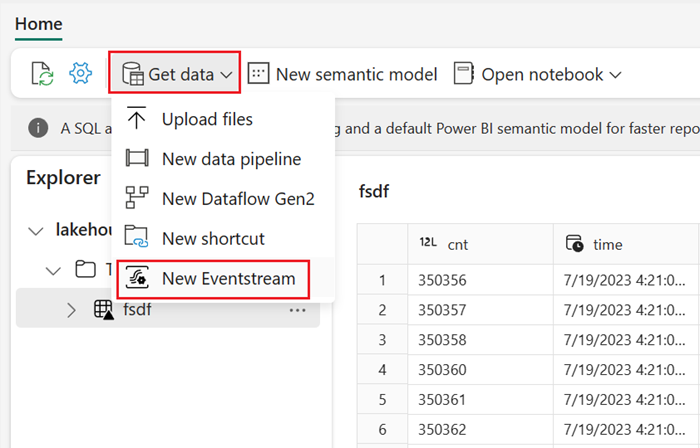

Streamen von Echtzeitereignissen mit Eventstreams

Mit einem Eventstream können Sie Ereignisse in Echtzeit aus einer Vielzahl von Quellen abrufen, verarbeiten und weiterleiten.

Weitere Informationen zum Hinzufügen von Lakehouses als Ziel für Eventstreams finden Sie unter Abrufen von Daten aus Eventstreams in ein Lakehouse.

Um eine optimale Streamingleistung zu erzielen, können Sie Daten aus einem Eventstream in ein Eventhouse streamen und dann die OneLake-Verfügbarkeit aktivieren.

Abrufen von Daten aus Eventhouses

Wenn Sie die OneLake-Verfügbarkeit für Daten in einem Eventhouse aktivieren, wird in OneLake eine Delta-Tabelle erstellt. Auf diese Delta-Tabelle kann von einem Lakehouse aus über eine Verknüpfung zugegriffen werden. Weitere Informationen finden Sie unter OneLake-Verknüpfungen. Weitere Informationen finden Sie unter OneLake-Verfügbarkeit für Eventhouses.

Überlegungen bei der Auswahl des Ansatzes zum Laden von Daten

| Anwendungsfälle | Empfehlung |

|---|---|

| Kleiner Dateiupload vom lokalen Computer | Verwenden Sie einen lokalen Dateiupload. |

| Geringer Datenumfang oder spezifische Connectors | Verwenden Sie Dataflows. |

| Große Datenquelle | Verwenden Sie das Kopiertool in Pipelines. |

| Komplexe Datentransformationen | Verwenden Sie Notebookcode. |

| Streamingdaten | Verwenden von Eventstreams zum Streamen von Daten in Eventhouses; Aktivieren der OneLake-Verfügbarkeit und Erstellen einer Verknüpfung aus einem Lakehouse |

| Zeitreihendaten | Abrufen von Daten aus Eventhouses |

Zugehöriger Inhalt

- Erkunden der Daten in Ihrem Lakehouse mit einem Notebook

- Schnellstart: Erstellen Ihrer ersten Pipeline zum Kopieren von Daten

- Kopieren von Daten mithilfe einer Kopieraktivität

- Verschieben von Daten aus Azure SQL-Datenbank in Lakehouse per Kopier-Assistent

- Hinzufügen eines Lakehouse-Ziels zu einem Eventstream

- Verfügbarkeit von Eventhouse OneLake