Microsoft Fabric-Integrationspfade für ISVs

Microsoft Fabric bietet drei unterschiedliche Pfade für Independent Software Vendors (ISV) für die nahtlose Integration mit Fabric. Für ISVs, die am Anfang dieser Integration Journey stehen, stellen wir im Folgenden verschiedene Ressourcen vor, die unter jedem dieser Pfade verfügbar sind.

Interoperabilität mit Fabric OneLake

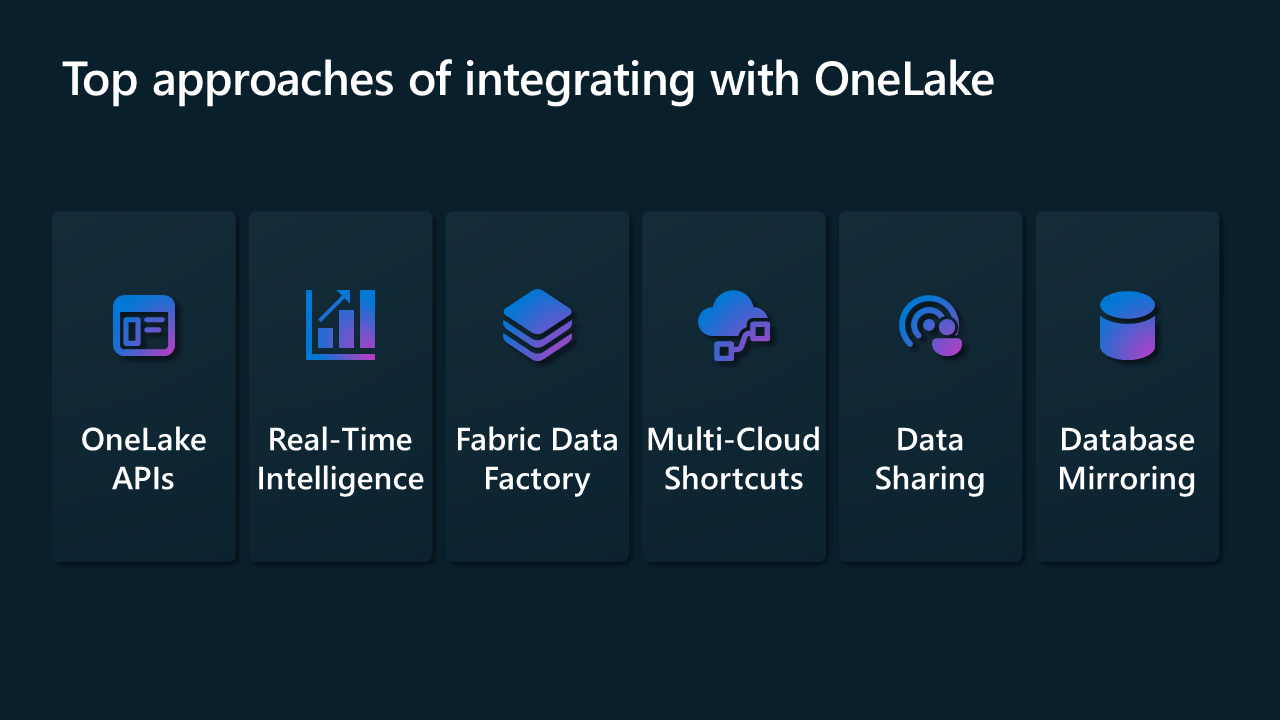

Das primäre Ziel des Interoperationsmodells besteht darin, ISVs die Integration ihrer Lösungen in die OneLake Foundation zu ermöglichen. Für die Interoperabilität mit Microsoft Fabric bieten wir die Integration mithilfe einer Vielzahl von Connectors in Data Factory und Real-Time Intelligence, REST-APIs für OneLake, Verknüpfungen in OneLake, Datenfreigabe über mehrere Fabric-Mandanten und Datenbankspiegelung.

In den folgenden Abschnitten werden einige der Möglichkeiten beschrieben, wie Sie mit diesem Modell beginnen können.

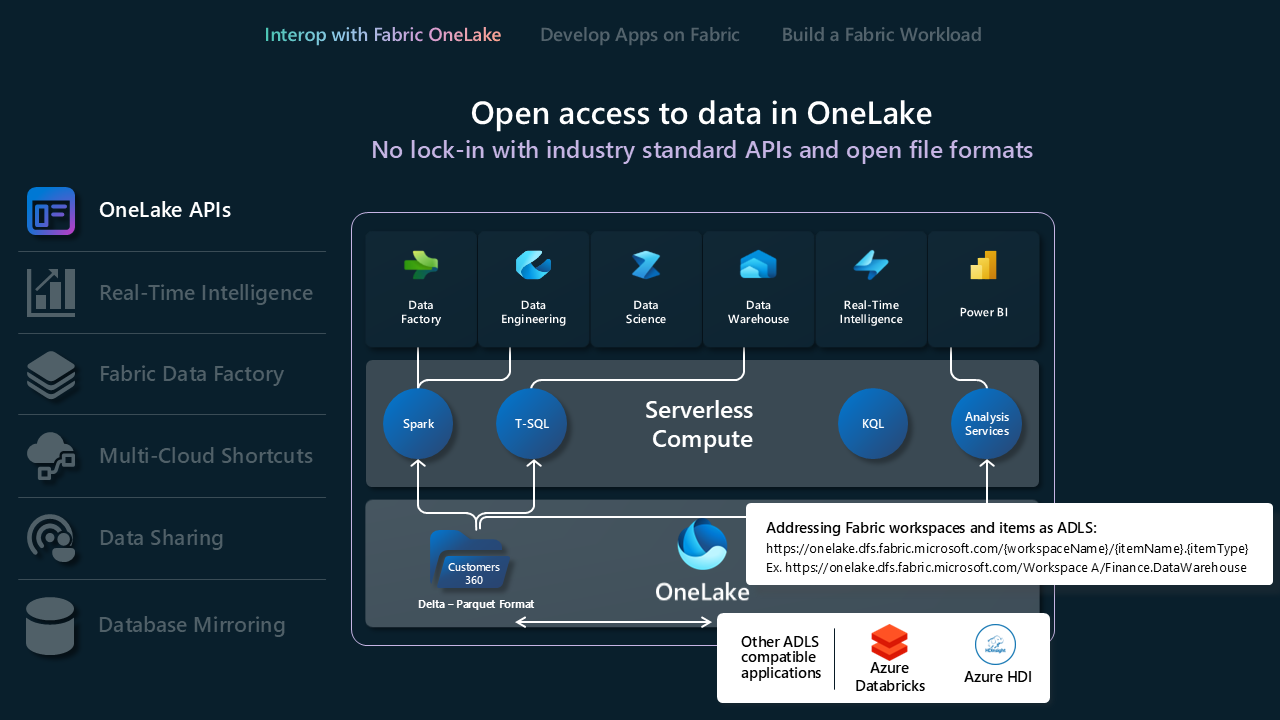

OneLake-APIs

- OneLake unterstützt die vorhandenen Azure Data Lake Storage (ADLS) Gen2-APIs für die direkte Interaktion, sodass Entwickler*innen ihre Daten in OneLake lesen, schreiben und verwalten können. Erfahren Sie mehr über ADLS Gen2-REST-APIs und das Herstellen einer Verbindung mit OneLake.

- Da sich nicht alle Funktionen in ADLS Gen2 direkt Funktionen in OneLake zuordnen lassen, erzwingt OneLake auch eine festgelegte Ordnerstruktur, um Fabric-Arbeitsbereiche und -Elemente zu unterstützen. Eine vollständige Liste der Unterschiede zwischen dem Verhalten von OneLake und ADLS Gen2 beim Aufrufen dieser APIs finden Sie unter OneLake-API-Parität.

- Wenn Sie Databricks verwenden und eine Verbindung mit Microsoft Fabric herstellen möchten, können Sie Databricks mit ADLS Gen2-APIs nutzen. Integrieren von OneLake in Azure Databricks.

- Machen Sie sich mit dem Format, der Tabellenoptimierung und der V-Reihenfolge vertraut, damit Sie die Vorteile des Delta Lake-Speicherformats bestmöglich nutzen können. Delta Lake-Tabellenoptimierung und V-Reihenfolge.

- Sobald sich die Daten in OneLake befinden, können Sie sie lokal mit dem OneLake-Datei-Explorer untersuchen. Der OneLake-Datei-Explorer integriert OneLake nahtlos mit dem Windows-Datei-Explorer. Diese Anwendung synchronisiert automatisch alle OneLake-Elemente, auf die Sie im Windows-Datei-Explorer Zugriff haben. Sie können auch jedes andere mit ADLS Gen2 kompatible Tool verwenden, z. B. Azure Storage-Explorer.

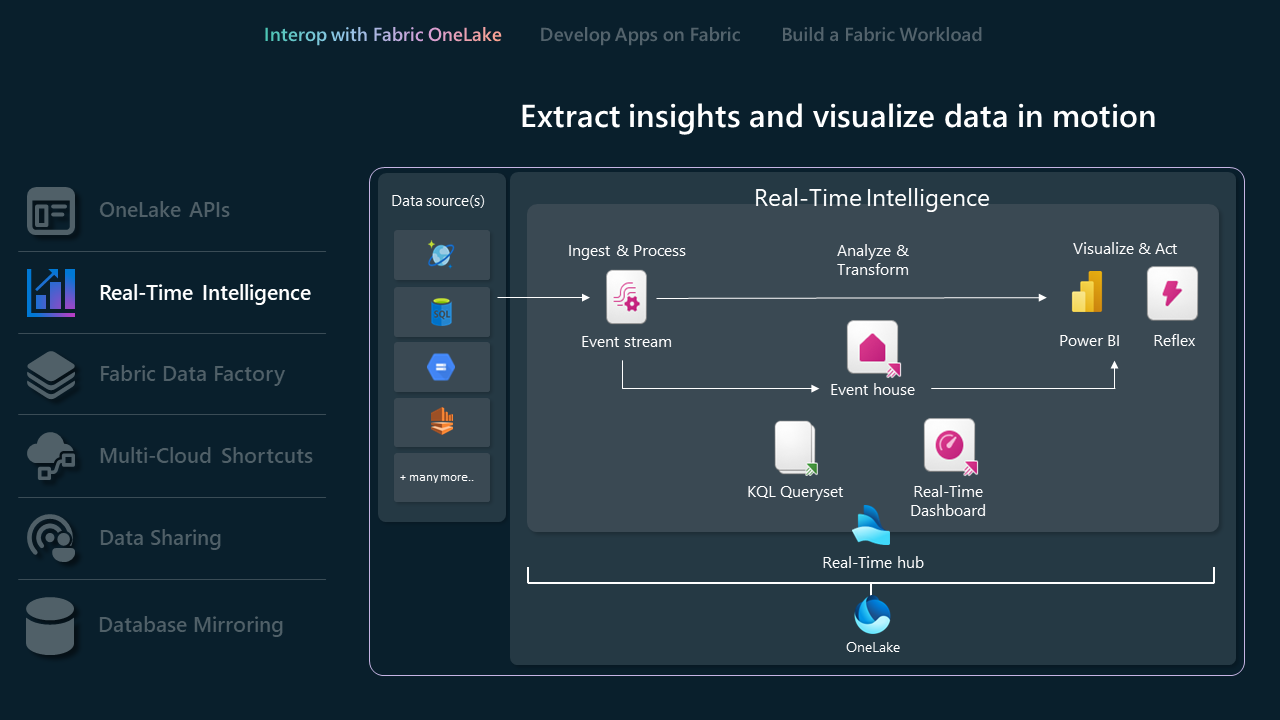

Echtzeitintelligenz-APIs

Echtzeitintelligenz optimiert Datenanalyse und Visualisierung und bietet eine zentrale Lösung für sofortige Einblicke und Aktionen zu Daten in einer Organisation. Sie verwaltet effizient große Datenmengen durch robuste Abfrage-, Transformations- und Speicherfunktionen.

- Eventhouses sind speziell für das Streaming von Daten konzipiert, kompatibel mit dem Echtzeit-Hub und ideal für zeitbasierte Ereignisse. Daten werden basierend auf der Erfassungszeit automatisch indiziert und partitioniert, sodass Sie unglaublich schnelle und komplexe Analyseabfragefunktionen für Daten mit hoher Granularität erhalten, auf die in OneLake für die Verwendung in der gesamten Fabric-Suite von Erfahrungen zugegriffen werden kann. Eventhouses unterstützen vorhandene Eventhouses-APIs und SDKs für direkte Interaktion, sodass Entwickler ihre Daten in Eventhouses lesen, schreiben und verwalten können. Erfahren Sie mehr über die REST-API.

- Mit Eventstreams können Sie Echtzeitereignisse aus verschiedenen Quellen empfangen und an verschiedene Ziele weiterleiten, z. B. OneLake, KQL-Datenbanken in Eventhouses und Fabric Activator. Weitere Informationen zuEventstreams und zur Eventstream-API

- Wenn Sie Databricks oder Jupyter Notebooks verwenden, können Sie die Kusto Python-Clientbibliothek verwenden, um mit KQL-Datenbanken in Fabric zu arbeiten. Weitere Informationen zum Kusto Python SDK.

- Sie können die vorhandenen Microsoft Logic Apps, Azure Data Factory oder Microsoft Power Automate-Connectors verwenden, um mit Ihren Eventhouses oder KQL-Datenbanken zu interagieren.

- Datenbankverknüpfungen in Real-Time Intelligence sind eingebettete Verweise auf eine Quelldatenbank innerhalb eines Eventhouse. Die Quelldatenbank kann entweder eine KQL-Datenbank in Real-Time Intelligence oder eine Azure Data Explorer-Datenbank sein. Verknüpfungen können für die inplace-Freigabe von Daten innerhalb desselben Mandanten oder über Mandanten hinweg verwendet werden. Erfahren Sie mehr über das Verwalten von Datenbankverknüpfungen mithilfe der API.

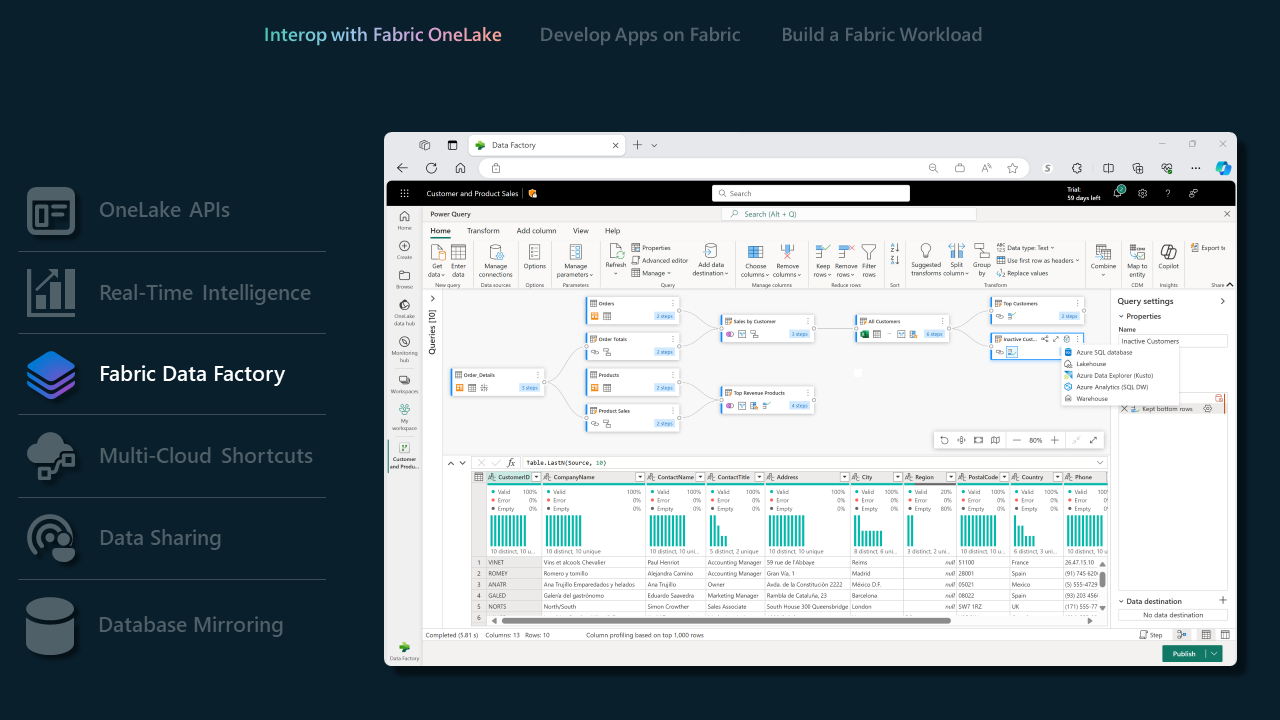

Data Factory in Fabric

- Datenpipelines verfügen über einen umfangreichen Satz von Connectors, sodass ISVs mühelos eine Verbindung mit unzähligen Datenspeichern herstellen können. Unsere Connectors stellen einen reibungslosen Integrationsprozess sicher, ganz gleich, ob Sie herkömmliche Datenbanken oder moderne cloudbasierte Lösungen verbinden. Übersicht über Connectors.

- Mit unseren unterstützten Dataflow Gen2-Connectors können ISVs die Leistungsfähigkeit von Fabric Data Factory nutzen, um komplexe Datenworkflows zu verwalten. Dieses Feature ist besonders nützlich für ISVs, die Aufgaben im Zusammenhang mit der Datenverarbeitung und -transformation optimieren möchten. Dataflow Gen2-Connectors in Microsoft Fabric.

- Eine vollständige Liste der Funktionen, die von Data Factory in Fabric unterstützt werden, finden Sie in diesem Blog zu Data Factory in Fabric.

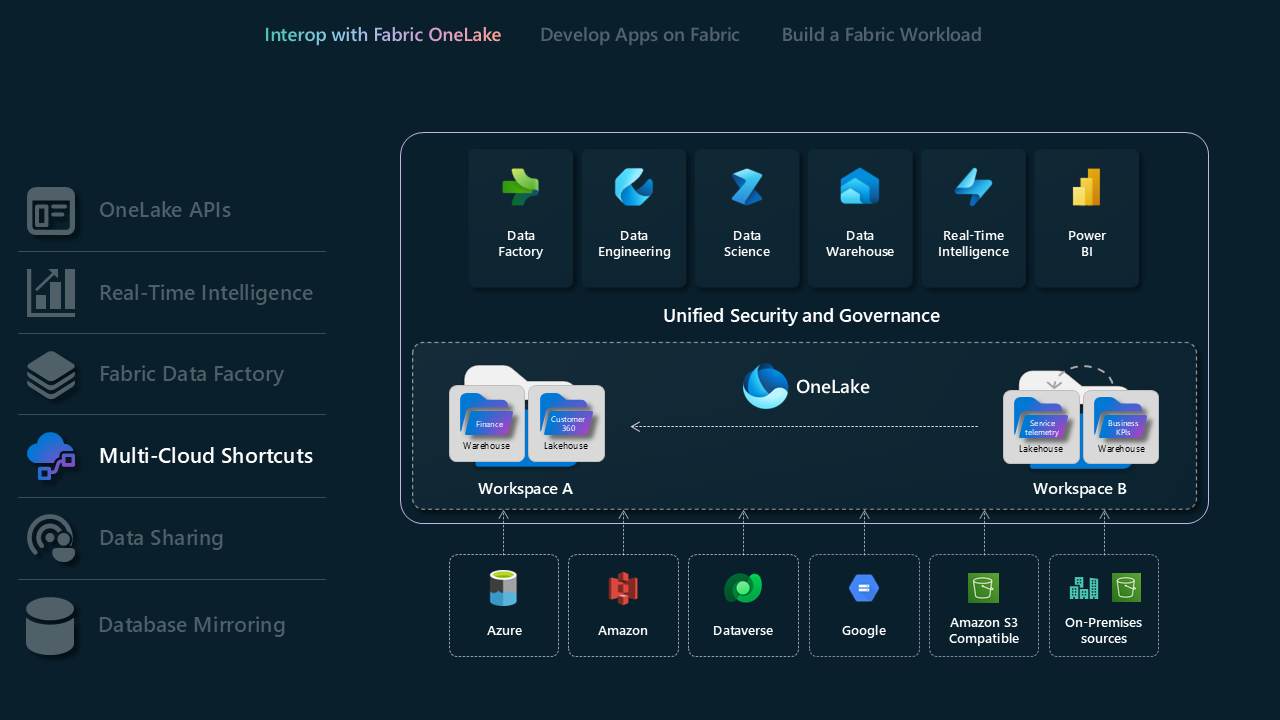

Verknüpfungen mit mehreren Clouds

Mit Verknüpfungen in Microsoft OneLake können Sie Ihre Daten domänen-, cloud- und kontoübergreifend vereinheitlichen, indem Sie einen einzelnen virtualisierten Data Lake für Ihr gesamtes Unternehmen erstellen. Alle Fabric-Funktionen und Analyse-Engines können über einen einheitlichen Namespace auf Ihre vorhandenen Datenquellen wie OneLake in einem anderen Mandanten, Azure Data Lake Storage (ADLS) Gen2,Amazon S3-Speicherkonten, Google Cloud Storage (GCS)S3-kompatible Datenquellen und Dataverse verweisen. OneLake bietet ISVs eine transformative Datenzugriffslösung, die eine nahtlose Integration über verschiedene Domänen und Cloudplattformen hinweg ermöglicht.

- Weitere Informationen zu OneLake-Verknüpfungen

- Weitere Informationen zu OneLake, eine logische Kopie

- Weitere Informationen zu KQL-Datenbankverknüpfungen

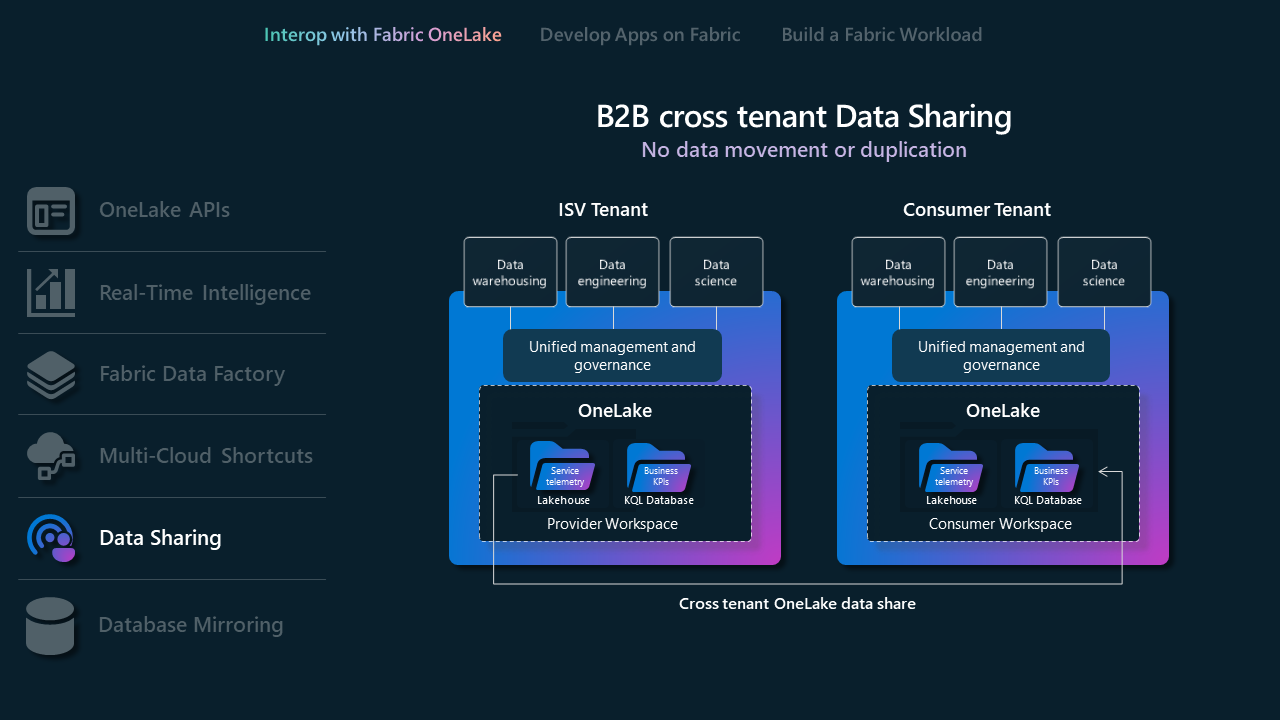

Datenfreigabe

Die Datenfreigabe ermöglicht es Fabric-Benutzern, Daten über verschiedene Fabric-Mandanten hinweg freizugeben, ohne sie zu duplizieren. Dieses Feature verbessert die Zusammenarbeit, indem Daten von OneLake-Speicherorten freigegeben werden können. Die Daten werden als schreibgeschützt freigegeben, auf die über verschiedene Fabric-Berechnungsmodule zugegriffen werden kann, einschließlich SQL, Spark, KQL und semantischen Modellen. Fabric-Administratoren müssen es für die freigebenden als auch die empfangenden Mandanten aktivieren. Der Prozess umfasst das Auswählen von Daten im OneLake-Datenhub oder -Arbeitsbereich, das Konfigurieren von Freigabeeinstellungen und das Senden einer Einladung an den vorgesehenen Empfänger.

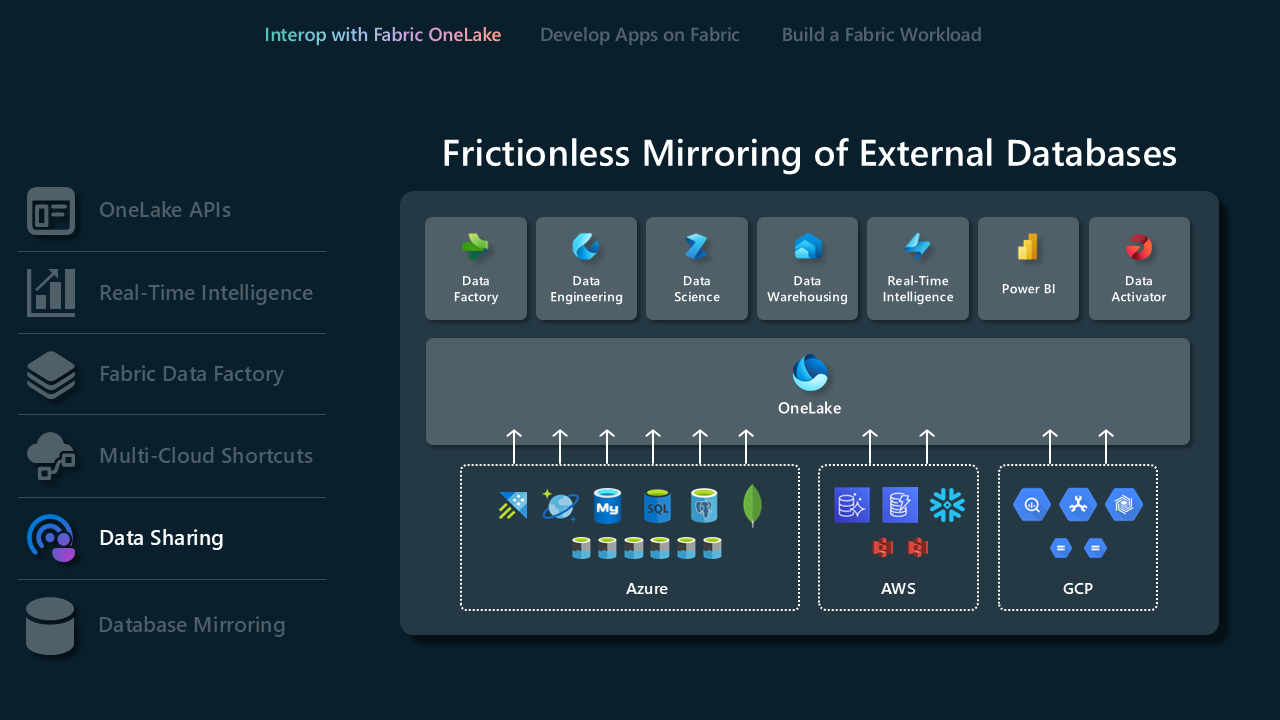

Datenbankspiegelung

Die Spiegelung ist eine moderne Methode zum kontinuierlichen und nahtlosen Abrufen von Daten aus externen Datenbanken oder Data Warehouses und Erfassen dieser Daten in der Data Warehousing-Benutzeroberfläche in Microsoft Fabric. Die Spiegelung erfolgt in Quasi-Echtzeit, sodass Benutzer sofort auf Änderungen in der Quelle zugreifen können. Erhalten Sie weitere Informationen zur Spiegelung und zu den unterstützten Datenbanken.

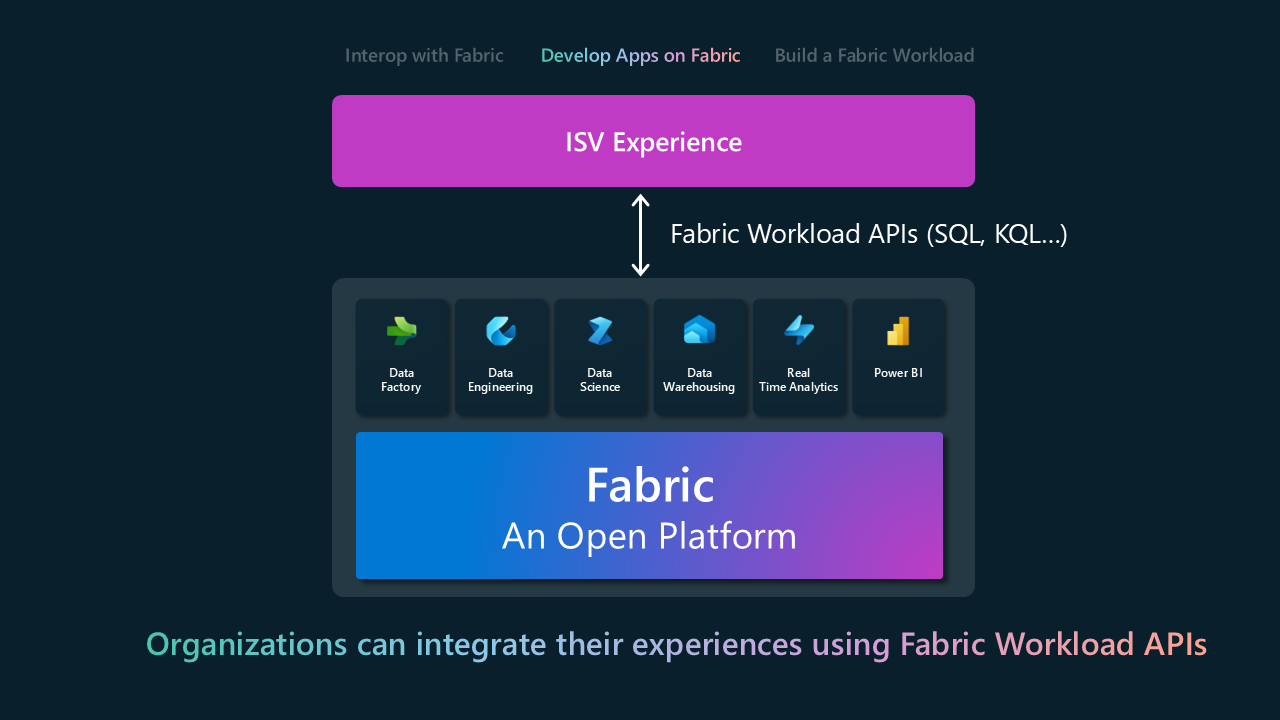

Entwickeln in Fabric

Mit dem Modell zum Entwickeln in Fabric können ISVs ihre Produkte und Dienste basierend auf Fabric erstellen oder Fabric-Funktionen nahtlos in ihre vorhandenen Anwendungen einbetten. Es ist ein Übergang von der grundlegenden Integration zur aktiven Anwendung der Funktionen von Fabric. Die Hauptoberfläche für die Integration sind REST-APIs für verschiedene Fabric-Umgebungen. Die folgende Tabelle zeigt eine Teilmenge von REST-APIs, die nach der Fabric-Oberfläche gruppiert sind. Eine vollständige Liste finden Sie in der REST-API-Dokumentation von Fabric.

| Fabric-Oberfläche | API |

|---|---|

| Data Warehouse | - Lagerort - Gespiegelter Lagerort |

| Datentechnik | - Lakehouse - Spark - Spark-Auftragsdefinition - Tabellen - Aufträge |

| Data Factory | - Datenpipeline |

| Real-Time Intelligence | - Eventhouse - KQL-Datenbank - KQL-Queryset - Eventstream |

| Data Science | - Notebook - ML-Experiment - ML-Modell |

| OneLake | - Tastenkombination - ADLS Gen2-APIs |

| Power BI | - Report - Dashboard - Semantikmodell |

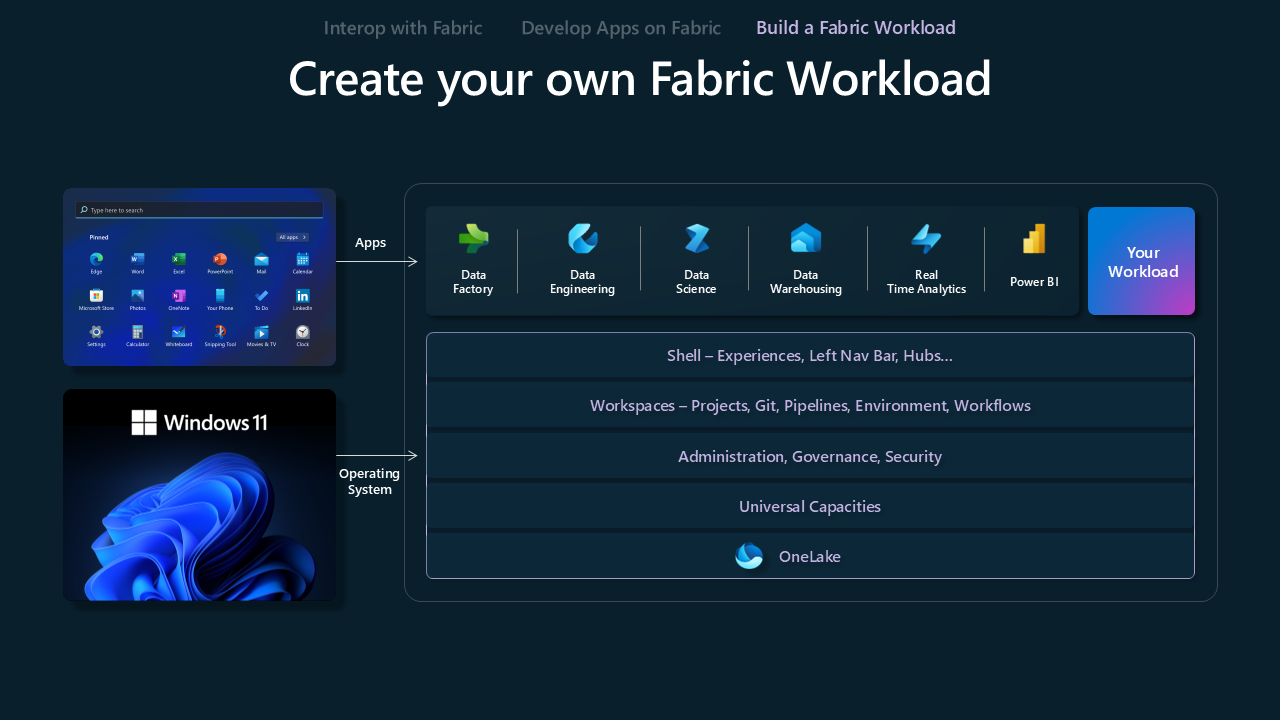

Erstellen einer Fabric-Workload

Das Erstellen eines Fabric-Workload-Modells ist dazu konzipiert, um ISVs dabei zu unterstützen, benutzerdefinierte Umgebungen auf der Fabric-Plattform zu erstellen. Es bietet ISVs die erforderlichen Tools und Funktionen, um ihre Angebote am Fabric-Ökosystem auszurichten und die Kombination ihrer einzigartigen Wertangebote mit den umfangreichen Funktionen von Fabric zu optimieren.

Das Microsoft Fabric Workload Development Kit bietet Entwicklern ein umfassendes Toolkit, um Anwendungen in den Microsoft Fabric Hub zu integrieren. Diese Integration ermöglicht das Hinzufügen neuer Funktionen direkt im Fabric-Arbeitsbereich, wodurch das Analyserlebnis für Benutzer verbessert wird. Sie bietet Entwicklern und ISVs eine neue Möglichkeit, Kunden zu erreichen, sowohl vertraute als auch neue Erfahrungen zu bieten und vorhandene Datenanwendungen zu nutzen. Fabric-Administratoren erhalten die Möglichkeit, den Zugriff auf den Workload-Hub zu verwalten, ihn für den gesamten Mandanten zu aktivieren oder ihm einen bestimmten Bereich zuzuweisen, um den Zugriff innerhalb des Unternehmens zu steuern.