Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Die Überwachung von Modellen in der Produktion ist ein wesentlicher Bestandteil des KI-Lebenszyklus. Änderungen im Daten- und Verbraucherverhalten können Ihre generative KI-Anwendung im Laufe der Zeit beeinflussen, was zu veralteten Systemen führt, die sich negativ auf die Geschäftsergebnisse auswirken und Organisationen Compliance-, wirtschaftlichen und Reputationsrisiken aussetzen.

Wichtig

Modellüberwachung für generative KI-Anwendungen befindet sich in der öffentlichen Vorschau. Diese Vorschauversionen werden ohne Servicelevel-Vereinbarung bereitgestellt und werden nicht für Produktionsworkloads empfohlen. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Die Überwachung des Azure Machine Learning-Modells für generative KI-Anwendungen erleichtert Ihnen die Überwachung Ihrer LLM-Anwendungen in der Produktion auf Sicherheit und Qualität in regelmäßigen Abständen, um maximale geschäftliche Auswirkungen zu gewährleisten. Die Überwachung trägt letztendlich dazu bei, die Qualität und Sicherheit Ihrer generativen KI-Anwendungen zu erhalten. Zu den Funktionen und Integrationen gehören:

- Das Sammeln von Produktionsdaten mithilfe des Modelldatensammlers

- Metriken für verantwortungsvolle KI-Auswertungen wie Fundiertheit, Kohärenz, Geläufigkeit, Relevanz und Ähnlichkeit, die mit Metriken der Azure Machine Learning-Promptflowauswertung interoperabel sind

- Die Fähigkeit, Warnungen für Verstöße basierend auf Organisationszielen zu konfigurieren und die Überwachung auf wiederkehrender Basis auszuführen

- Nutzen Sie Ergebnisse in einem umfangreichen Dashboard innerhalb eines Arbeitsbereichs im Azure Machine Learning Studio.

- Integration in Azure Machine Learning Prompt Flow Evaluatiosmetriken, Analyse gesammelter Produktionsdaten, um zeitnahe Warnungen und eine Visualisierung der Metriken im Zeitverlauf darzustellen

Grundlegende Konzepte der Modellüberwachung finden Sie unter Modellüberwachung mit Azure Machine Learning (Vorschauversion). In diesem Artikel erfahren Sie, wie Sie eine generative KI-Anwendung überwachen, die von einem verwalteten Onlineendpunkt unterstützt wird. Auszuführende Schritte:

- Konfigurieren der Voraussetzungen

- Erstellen Ihres Monitors

- Überwachungsstatus bestätigen

- Nutzen von Überwachungsergebnissen

Auswertungsmetriken

Metriken werden durch die folgenden modernen GPT-Sprachmodelle generiert, die mit spezifischen Auswertungsanweisungen (Promptvorlagen) konfiguriert sind, die als Auswertungsmodelle für Sequenzaufgaben fungieren. Diese Technik hat im Vergleich zu standardmäßigen generativen KI-Auswertungsmetriken starke empirische Ergebnisse und eine hohe Korrelation mit dem menschlichen Urteilsvermögen gezeigt. Weitere Informationen zur Promptflowauswertung finden Sie unter Übermitteln von Massentests und Auswerten eines Flows (Vorschau) für weitere Informationen zur Promptflowauswertung.

Diese GPT-Modelle werden unterstützt und als Ihre Azure OpenAI-Ressource konfiguriert:

- GPT-3.5-Turbo

- GPT-4

- GPT-4-32k

Die folgenden Metriken werden unterstützt. Ausführlichere Informationen zu den einzelnen Metriken finden Sie unter Beschreibungen und Anwendungsfälle zur Überwachung von Auswertungsmetriken

- Fundiertheit: wertet aus, wie gut die vom Modell generierten Antworten mit den Informationen aus der Eingabequelle zusammenpassen.

- Relevanz: misst das Ausmaß, in dem die vom Modell generierten Antworten relevant sind und in direktem Zusammenhang mit den vorgegebenen Fragen stehen.

- Kohärenz: bewertet, wie gut das Sprachmodell eine Ausgabe erzeugen kann, die sich flüssig und natürlich liest und der menschlichen Sprache ähnelt.

- Geläufigkeit: bewertet die Sprachkompetenz der vorhergesagten Antwort einer generativen KI. Sie bewertet, wie gut der generierte Text grammatikalische Regeln, syntaktische Strukturen und die angemessene Verwendung des Vokabulars einhält, was zu sprachlich korrekten und natürlich klingenden Antworten führt.

- Ähnlichkeit: wertet die Ähnlichkeit zwischen einem Basiswahrheitssatz (oder Dokument) und dem Vorhersagesatz, der von einem KI-Modell generiert wird aus.

Anforderungen an die Metrikkonfiguration

Die folgenden Eingaben (Datenspaltennamen) sind erforderlich, um die Sicherheit und Qualität generierter Inhalte zu messen:

- Aufforderungstext – die ursprüngliche Aufforderung (auch als „Eingaben“ oder „Frage“ bezeichnet)

- Vervollständigungstext – die endgültige Vervollständigung des zurückgegebenen API-Aufrufs (auch als „Ausgaben“ oder „Antwort“ bezeichnet)

- Kontexttext – Alle Kontextdaten, die an den API-Aufruf gesendet werden, zusammen mit der ursprünglichen Aufforderung. Wenn Sie beispielsweise hoffen, nur Suchergebnisse von bestimmten zertifizierten Informationsquellen/Websites zu erhalten, können Sie diese in den Auswertungsschritten definieren. Dies ist ein optionaler Schritt, der über den Prompt Flow konfiguriert werden kann.

- Grundwahrheitstext – der benutzerdefinierte Text als „Quelle der Wahrheit“ (optional)

Welche Parameter in Ihrer Datenressource konfiguriert sind, bestimmt, welche Metriken Sie gemäß dieser Tabelle erstellen können:

| Metrik | Prompt | Completion | Kontext | Grundwahrheit |

|---|---|---|---|---|

| Kohärenz | Erforderlich | Erforderlich | - | - |

| Geläufigkeit | Erforderlich | Erforderlich | - | - |

| Quellenübereinstimmung | Erforderlich | Erforderlich | Erforderlich | - |

| Relevance | Erforderlich | Erforderlich | Erforderlich | - |

| Ähnlichkeit | Erforderlich | Erforderlich | - | Erforderlich |

Voraussetzungen

- Azure OpenAI-Ressource: Sie müssen eine Azure OpenAI-Ressource haben, die mit einem ausreichenden Kontingent erstellt wurde. Diese Ressource wird als Auswertungsendpunkt verwendet.

- Verwaltete Identität: Erstellen Sie eine vom Benutzer zugewiesene verwaltete Identität (User Assigned Managed Identity, UAI), und fügen Sie sie an Ihren Arbeitsbereich an, indem Sie die Anleitung unter Anfügen von benutzerseitig zugewiesener verwalteter Identität mithilfe der CLI v2mit ausreichendem Rollenzugriff verwenden, wie im nächsten Schritt definiert.

- Rollenzugriff Um eine Rolle mit den erforderlichen Berechtigungen zuzuweisen, müssen Sie über die Besitzer oder Microsoft.Authorization/roleAssignments/write-Berechtigung für Ihre Ressource verfügen. Das Aktualisieren von Verbindungen und Berechtigungen kann einige Minuten dauern, um wirksam zu werden. Diese zusätzlichen Rollen müssen Ihrer UAI zugewiesen werden:

- Ressource: Arbeitsbereich

- Rolle: Azure Machine Learning-Rolle „Wissenschaftliche Fachkraft für Daten“

- Arbeitsbereichsverbindung: Gemäß dieser Anleitung verwenden Sie eine verwaltete Identität, welche die Anmeldeinformationen für den Azure OpenAI-Endpunkt darstellt, der zum Berechnen der Überwachungsmetriken verwendet wird. Löschen Sie die Verbindung NICHT, sobald sie im Flow verwendet wird.

- API-Version: 15.03.2023 Vorschauversion

- Bereitstellung von Promptflows: Erstellen Sie eine Promptflow-Runtime gemäß dieser Anleitung, führen Sie Ihren Flow aus, und konfigurieren Sie Ihre Bereitstellung mithilfe dieses Artikels als Leitfaden

- Floweingaben und -ausgaben: Sie müssen Ihre Flowausgaben entsprechend benennen und sich diese Spaltennamen beim Erstellen Ihres Monitors merken. In diesem Artikel werden die folgenden Begriffe verwendet:

- Eingaben (erforderlich): „Aufforderung“

- Outputs (erforderlich): "Abschluss"

- Ausgaben (optional): „Kontext“ | „Grundwahrheit“

- Datenerfassung: in der "Bereitstellung" (Schritt #2 des Assistenten für die Bereitstellung von Prompt Flows) muss der Schalter "Sammlung von Inferenzdaten" mit Modelldatenkollektor aktiviert werden

- Ausgaben: Bestätigen Sie in den Ausgaben (Schritt 3 des Assistenten für die Bereitstellung von Prompt Flows), dass Sie die oben aufgeführten erforderlichen Ausgaben (z. B. Abschluss | Kontext | ground_truth) ausgewählt haben, die Ihren metrischen Konfigurationsanforderungen entsprechen

- Floweingaben und -ausgaben: Sie müssen Ihre Flowausgaben entsprechend benennen und sich diese Spaltennamen beim Erstellen Ihres Monitors merken. In diesem Artikel werden die folgenden Begriffe verwendet:

Hinweis

Wenn sich Ihre Compute-Instanz hinter einem VNet befindet, sehen Sie unter Netzwerkisolierung im Prompt Flow nach.

Erstellen Ihres Monitors

Erstellen Sie Ihren Monitor in der Monitorübersichtsseite

Grundlegende Überwachungseinstellungen konfigurieren

Ändern Sie im Assistenten zum Erstellen der Überwachung den Modelltasktyp in Prompt und Vervollständigung, wie im Screenshot unter (A) gezeigt.

Konfigurieren der Datenressource

Wenn Sie den Modelldatencollector verwendet haben, wählen Sie Ihre beiden Datenressourcen (Eingaben und Ausgaben) aus.

Auswählen von Überwachungssignalen

- Konfigurieren der Arbeitsbereichsverbindung (A) im Screenshot.

- Geben Sie den Namen Ihrer Azure OpenAI-Evaluator-Bereitstellung (B) ein.

- (Optional) Verknüpfen Ihrer Produktionsdateneingaben und -ausgaben : Die Eingaben und Ausgaben Ihrer Produktionsmodelle werden automatisch vom Überwachungsdienst (C) verknüpft. Sie können dies bei Bedarf anpassen, aber es ist keine Aktion erforderlich. Standardmäßig ist die Joinspalte correlationid.

- (Optional) Konfigurieren von Metrikschwellenwerten: Eine akzeptable Bewertung pro Instanz wird auf 3/5 festgelegt. Sie können die zulässige Gesamterfolgsquote in % im Bereich [1,99] % anpassen.

Geben Sie manuell Spaltennamen aus Ihrem Promptflow (E) ein. Standardnamen sind („Prompt“ | „Vervollständigung“ | „Kontext“ | „ground_truth“). Sie können sie jedoch entsprechend Ihrem Datenobjekt konfigurieren.

(optional) Festlegen der Samplingrate (F)

Nach der Konfiguration zeigt Ihr Signal keine Warnung mehr an.

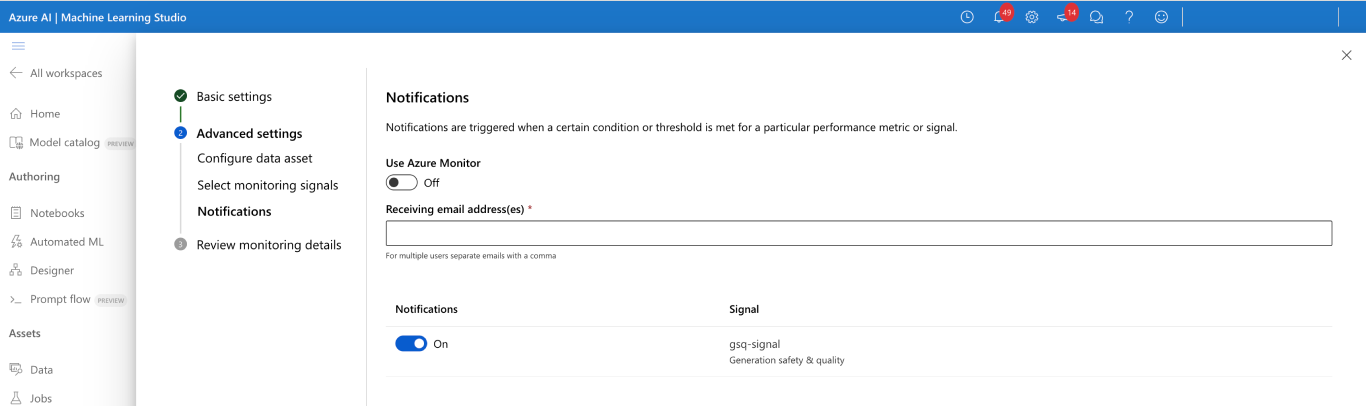

Konfigurieren von Benachrichtigungen

Es ist keine Aktion erforderlich. Sie können bei Bedarf weitere Empfänger konfigurieren.

Bestätigen der Konfiguration des Überwachungssignals

Nach einer erfolgreichen Konfiguration sollte Ihr Monitor folgendermaßen aussehen:

Status der Überwachung bestätigen

Nach einer erfolgreichen Konfiguration, sollte Ihr Auftrag für die Überwachungspipeline Folgendes anzeigen:

Nutzen von Ergebnissen

Monitorübersichtsseite

Ihre Monitorübersicht bietet einen Überblick über Ihre Signalleistung. Sie können Ihre Signaldetailseite eingeben, um weitere Informationen zu erhalten.

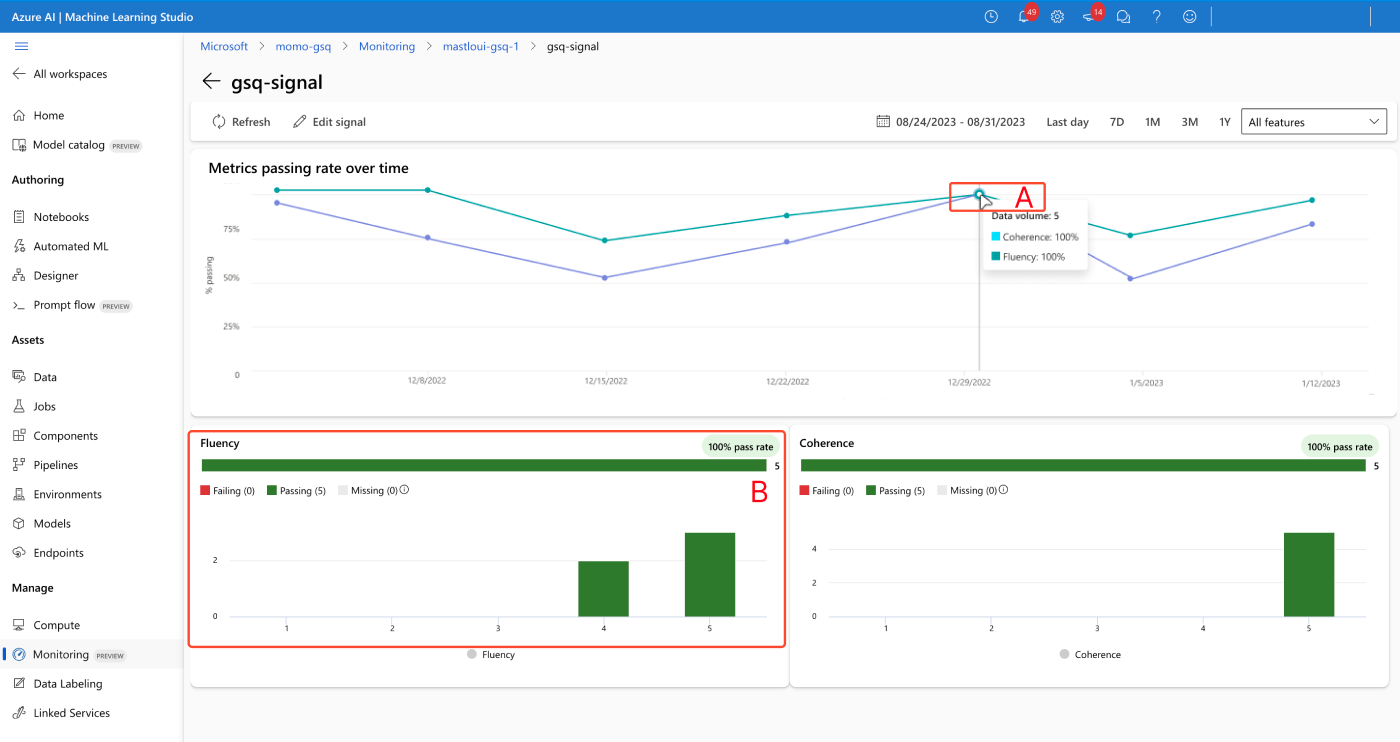

Seite zu Signaldetails

Auf der Seite „Signaldetails“ können Sie Metriken im Zeitverlauf (A) anzeigen und Histogramme der Verteilung (B) anzeigen.

Alarme auflösen

Es ist nur möglich, Signalschwellenwerte anzupassen. Die akzeptable Bewertung ist auf 3/5 festgelegt, und es ist nur möglich, das Feld „zulässige Gesamterfolgsquote in %“ anzupassen.