Übermitteln einer Batchausführung zur Auswertung eines Flows

Eine Batchausführung führt einen Prompt Flow mit einem großen Dataset aus und generiert Ausgaben für jede Datenzeile. Um zu bewerten, wie gut Ihr Prompt Flow mit einem großen Datensatz funktioniert, können Sie eine Batchausführung übermitteln und Auswertungsmethoden verwenden, um Scores und Metriken zur Leistung zu generieren.

Nach Abschluss des Batchflows werden die Auswertungsmethoden automatisch ausgeführt, um die Scores und Metriken zu berechnen. Sie können die Auswertungsmetriken verwenden, um die Ausgabe Ihres Flows anhand Ihrer Leistungskriterien und -ziele zu bewerten.

In diesem Artikel erfahren Sie, wie Sie eine Batchausführung übermitteln und eine Auswertungsmethode verwenden, um die Qualität Ihrer Flowausgabe zu messen. Sie erfahren, wie Sie das Auswertungsergebnis und die Metriken anzeigen und einen neuen Auswertungsdurchlauf mit einer anderen Methode oder einer Teilmenge von Varianten starten.

Voraussetzungen

Um eine Batchausführung mit einer Auswertungsmethode durchzuführen, benötigen Sie die folgenden Komponenten:

Einen funktionierenden Azure Machine Learning-Prompt Flow, für den Sie die Leistung testen möchten

Ein Testdataset, das für die Batchausführung verwendet werden soll

Das Testdataset muss im CSV-, TSV- oder JSONL-Format vorliegen und über Kopfzeilen verfügen, die den Eingabenamen Ihres Flows entsprechen. Sie können jedoch während des Setupvorgangs für die Auswertungsausführung den Eingabespalten verschiedene Datasetspalten zuordnen.

Erstellen und Übermitteln einer Auswertungsbatchausführung

Um eine Batchausführung zu übermitteln, wählen Sie das Dataset aus, mit dem Sie den Flow testen möchten. Sie können auch eine Auswertungsmethode auswählen, um Metriken für Ihre Flowausgabe zu berechnen. Wenn Sie keine Auswertungsmethode verwenden möchten, können Sie die Auswertungsschritte Schritt überspringen und die Batchausführung ohne Berechnung von Metriken durchführen. Sie können auch später einen Auswertungsdurchlauf ausführen.

Zum Starten einer Batchausführung mit oder ohne Auswertung wählen Sie oben auf der Prompt Flow-Seite die Option Auswerten aus.

Passen Sie im Assistenten für Batchausführung und -auswertung auf der Seite Basiseinstellungen ggf. den Namen unter Ausführungsanzeigename an, und geben Sie optional Werte für Ausführungsbeschreibung und Tags ein. Wählen Sie Weiter aus.

Wählen Sie auf der Seite Batchausführungseinstellungen das zu verwendende Dataset aus, und konfigurieren Sie die Eingabezuordnung.

prompt flow unterstützt die Zuordnung Ihrer Floweingabe zu einer bestimmten Datenspalte in Ihrem Dataset. Sie können mithilfe von

${data.<column>}einer bestimmten Eingabe eine Datasetspalte zuordnen. Wenn Sie einer Eingabe einen konstanten Wert zuweisen möchten, können Sie diesen Wert direkt eingeben.Sie können an diesem Punkt Überprüfen und übermitteln auswählen, um die Auswertungsschritte zu überspringen und den Batch auszuführen, ohne eine Auswertungsmethode zu verwenden. Die Batchausführung generiert dann einzelne Ausgaben für jedes Element in Ihrem Dataset. Sie können die Ausgaben manuell überprüfen oder zur weiteren Analyse exportieren.

Wählen Sie andernfalls Weiter aus, um eine Auswertungsmethode zum Überprüfen der Leistung dieser Ausführung zu verwenden. Sie können einer abgeschlossenen Batchausführung auch eine neue Auswertungsrunde hinzufügen.

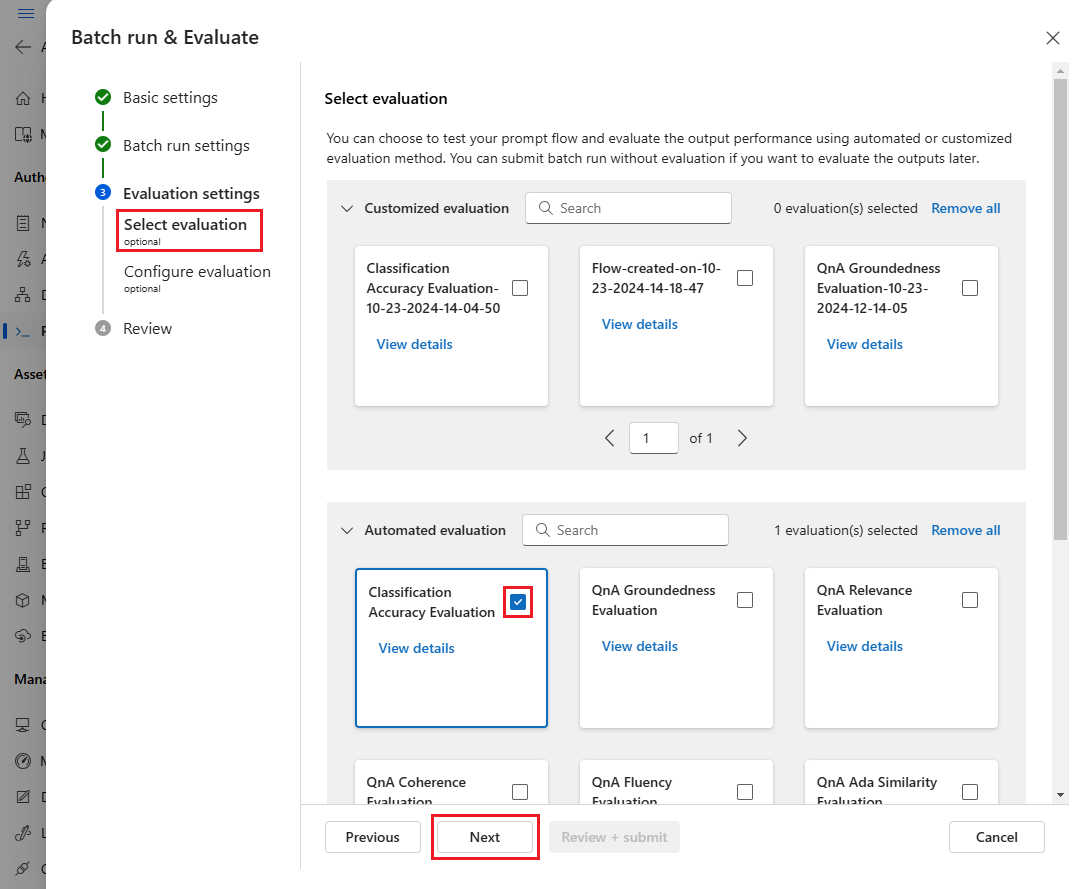

Wählen Sie auf der Seite Auswertung auswählen eine oder mehrere angepasste oder integrierte Auswertungen aus, die ausgeführt werden sollen. Sie können die Schaltfläche Details anzeigen auswählen, um weitere Informationen zur Auswertungsmethode zu erhalten, z. B. die von ihr erzeugten Metriken und die erforderlichen Verbindungen und Eingaben.

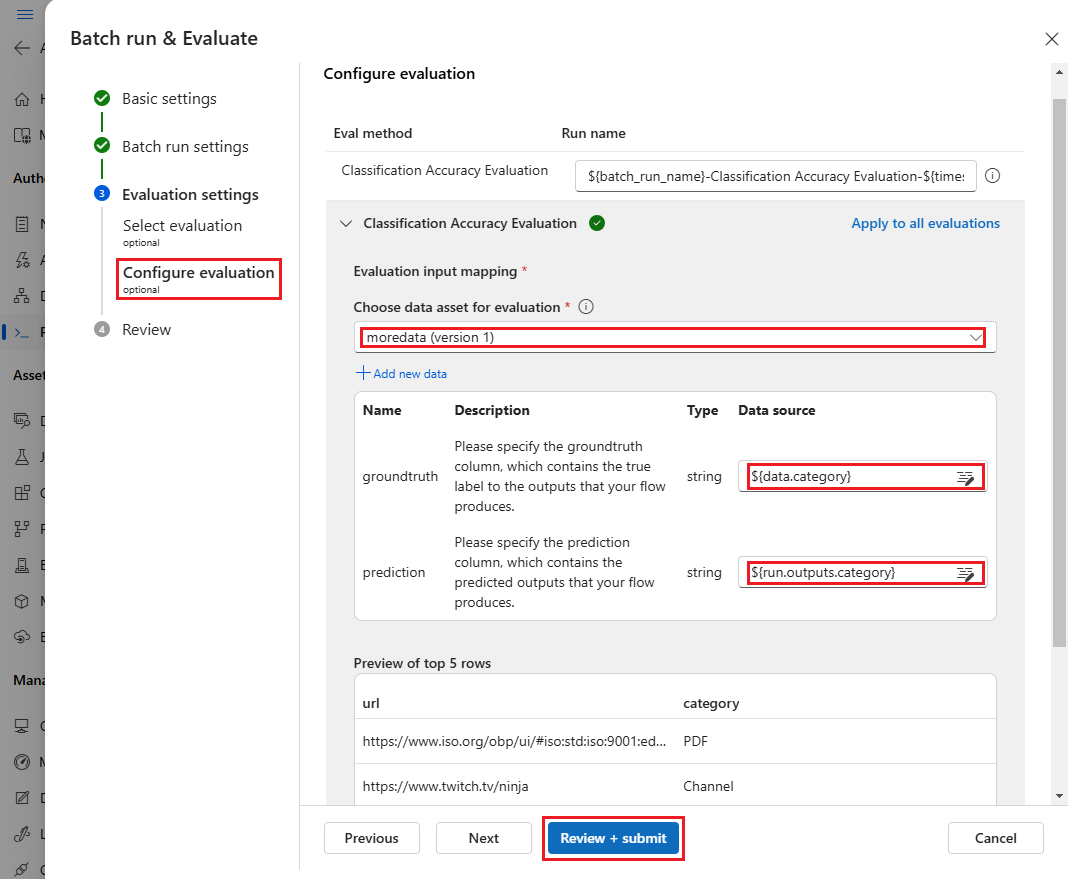

Geben Sie als Nächstes auf dem Bildschirm Auswertung konfigurieren die Quellen der erforderlichen Eingaben für die Auswertung an. Die Spalte mit der Grundwahrheit kann beispielsweise aus einem Dataset stammen. Standardmäßig verwendet die Auswertung dasselbe Dataset wie die gesamte Batchausführung. Wenn sich die entsprechenden Bezeichnungen oder Werte der Zielgrundwahrheit jedoch in einem anderen Dataset befinden, können Sie dieses verwenden.

Hinweis

Wenn Ihre Auswertungsmethode keine Daten aus einem Dataset erfordert, ist die Datasetauswahl eine optionale Konfiguration, die sich nicht auf Auswertungsergebnisse auswirkt. Sie müssen kein Dataset auswählen oder im Abschnitt mit der Eingabezuordnung auf Datasetspalten verweisen.

Geben Sie im Abschnitt Eingabezuordnung für Auswertung die Quellen der erforderlichen Eingaben für die Auswertung an.

- Wenn die Daten aus Ihrem Testdataset stammen, legen Sie die Quelle auf

${data.[ColumnName]}fest. - Wenn die Daten aus der Ausführungsausgabe stammen, legen Sie die Quelle auf

${run.outputs.[OutputName]}fest.

- Wenn die Daten aus Ihrem Testdataset stammen, legen Sie die Quelle auf

Einige Auswertungsmethoden erfordern LLMs (Large Language Models) wie GPT-4 oder GPT-3 oder benötigen andere Verbindungen, um Anmeldeinformationen oder Schlüssel zu nutzen. Für diese Methoden müssen Sie die Verbindungsdaten im Abschnitt Verbindung unten auf diesem Bildschirm eingeben, um den Auswertungsflow verwenden zu können. Weitere Informationen finden Sie unter Einrichten einer Verbindung.

Wählen Sie Überprüfen und übermitteln aus, um Ihre Einstellungen zu überprüfen. Wählen Sie anschließend Übermitteln aus, um die Batchausführung mit Auswertung zu starten.

Hinweis

- Einige Auswertungsprozesse nutzen viele Token, daher empfiehlt es sich, ein Modell zu verwenden, das mindestens 16.000 Token unterstützen kann.

- Batchausführung haben eine maximale Dauer von 10 Stunden. Wenn eine Batchausführung diesen Grenzwert überschreitet, wird sie beendet und als fehlerhaft angezeigt. Überwachen Sie Ihre LLM-Kapazität, um Drosselung zu vermeiden. Ziehen Sie bei Bedarf in Betracht, die Größe Ihrer Daten zu verringern. Wenn weiterhin Probleme auftreten, übermitteln Sie ein Antwortformular oder eine Supportanfrage.

Anzeigen von Auswertungsergebnissen und Metriken

Sie finden die Liste der übermittelten Batchausführungen auf der Azure Machine Learning Studio-Seite Prompt Flow auf der Registerkarte Ausführungen.

Um die Ergebnisse einer Batchausführung zu überprüfen, wählen Sie die Ausführung und dann Ausgaben visualisieren aus.

Auf dem Bildschirm Ausgaben visualisieren werden im Abschnitt Ausführungen und Metriken die Gesamtergebnisse für die Batchausführung und die Auswertungsausführung angezeigt. Im Abschnitt Ausgaben werden die Ausführungseingaben Zeile für Zeile in einer Ergebnistabelle angezeigt, die auch Zeilen-ID, Ausführung, Status und Systemmetriken enthält.

Wenn Sie das Symbol Ansicht neben der Auswertungsausführung im Abschnitt Ausführungen und Metriken aktivieren, werden in der Tabelle Ausgaben außerdem die Auswertungsscores oder -ergebnisse für jede Zeile angezeigt.

Wählen Sie das Symbol Details anzeigen neben jeder Zeile in der Tabelle Ausgaben aus, um die Ablaufverfolgungsansicht und Details für diesen Testfall zu beobachten und zu debuggen. In der Ansicht Ablaufverfolgung werden Informationen wie die Anzahl der Token und die Dauer für diesen Fall angezeigt. Erweitern Sie einen beliebigen Schritt, und wählen Sie ihn aus, um die Übersicht und Eingaben für diesen Schritt anzuzeigen.

Sie können Auswertungsausführungsergebnisse auch über den getesteten Prompt Flow anzeigen. Wählen Sie unter Batchausführungen anzeigen die Option Batchausführungen anzeigen aus, um die Liste der Batchausführungen für den Flow anzuzeigen. Oder wählen Sie Ausgaben der letzten Batchausführung anzeigen aus, um die Ausgaben für die letzte Ausführung anzuzeigen.

Wählen Sie in der Batchausführungsliste einen Batchausführungsnamen aus, um die Flowseite für diese Ausführung zu öffnen.

Wählen Sie auf der Flowseite für eine Auswertungsausführung Ausgaben anzeigen oder Details aus, um Details für den Flow anzuzeigen. Sie können den Flow auch klonen, um einen neuen Flow zu erstellen, oder ihn als Onlineendpunkt bereitstellen.

Auf dem Bildschirm Details:

Auf der Registerkarte Übersicht werden umfassende Informationen zur Ausführung angezeigt, einschließlich Ausführungseigenschaften, Eingabedatatset, Ausgabedataset, Tags und Beschreibung.

Auf der Registerkarte Ausgaben wird eine Zusammenfassung der Ergebnisse am oberen Rand der Seite angezeigt, gefolgt von der Tabelle mit den Batchausführungsergebnissen. Wenn Sie die Auswertungsausführung neben Verwandte Ergebnisse anfügen auswählen, werden in der Tabelle auch die Ergebnisse der Auswertungsausführung angezeigt.

Auf der Registerkarte Protokolle werden die Ausführungsprotokolle angezeigt, die für das detaillierte Debuggen von Ausführungsfehlern nützlich sein können. Sie können die Protokolldateien herunterladen.

Die Registerkarte Metriken enthält einen Link zu den Metriken für die Ausführung.

Auf der Registerkarte Ablaufverfolgung werden detaillierte Informationen wie die Anzahl der Token und die Dauer für jeden Testfall angezeigt. Erweitern Sie einen beliebigen Schritt, und wählen Sie ihn aus, um die Übersicht und Eingaben für diesen Schritt anzuzeigen.

Auf der Registerkarte Momentaufnahme werden die Dateien und der Code der Ausführung angezeigt. Sie können die Flowdefinition flow.dag.yaml anzeigen und eine der Dateien herunterladen.

Starten eines neuen Auswertungsdurchlaufs für dieselbe Ausführung

Sie können einen neuen Auswertungsdurchlauf ausführen, um Metriken für eine abgeschlossene Batchausführung zu berechnen, ohne den Flow erneut auszuführen. Dieser Prozess spart die Kosten für die erneute Ausführung Ihres Flows und ist in den folgenden Szenarien hilfreich:

- Sie haben beim Übermitteln einer Batchausführung keine Auswertungsmethode ausgewählt und möchten nun die Ausführungsleistung auswerten.

- Sie haben eine Auswertungsmethode zum Berechnen einer bestimmten Metrik verwendet und möchten nun eine andere Metrik berechnen.

- Bei der vorherigen Auswertung ist ein Fehler aufgetreten, aber die Batchausführung hat erfolgreich Ausgaben generiert, und Sie möchten die Auswertung erneut versuchen.

Wählen Sie zum Starten eines weiteren Auswertungsdurchlaufs oben auf der Seite mit dem Batchausführungsflow die Option Auswerten aus. Der Assistent Neue Auswertung wird auf dem Bildschirm Auswertung auswählen geöffnet. Schließen Sie das Setup ab, und übermitteln Sie die neue Auswertungsausführung.

Die neue Ausführung wird in der prompt flow-Liste Ausführung angezeigt, und Sie können mehrere Zeilen in der Liste und dann Ausgaben visualisieren auswählen, um die Ausgaben und Metriken zu vergleichen.

Vergleichen des Ausführungsverlaufs und der Metriken der Auswertung

Wenn Sie den Flow ändern, um seine Leistung zu verbessern, können Sie mehrere Batchausführungen übermitteln, um die Leistung der verschiedenen Flowversionen zu vergleichen. Sie können auch die Metriken vergleichen, die von verschiedenen Auswertungsmethoden berechnet werden, um zu ermitteln, welche Methode für Ihren Flow am besten geeignet ist.

Um den Ausführungsverlauf der Flowausführung zu überprüfen, wählen Sie oben auf der Flowseite die Option Batchausführungen anzeigen aus. Sie können jede Ausführung auswählen, um die Details zu überprüfen. Sie können auch mehrere Ausführungen und dann die Option Ausgaben visualisieren auswählen, um die Metriken und Ausgaben dieser Ausführungen zu vergleichen.

Grundlegendes zu integrierten Auswertungsmetriken

Azure Machine Learning prompt flow bietet verschiedene integrierte Auswertungsmethoden an, mit denen Sie die Leistung Ihrer Flowausgabe messen können. Jede Auswertungsmethode berechnet andere Metriken. In der folgenden Tabelle werden die verfügbaren integrierten Auswertungsmethoden beschrieben.

| Auswertungsmethode | Metrik | Beschreibung | Verbindung erforderlich? | Erforderliche Eingabe | Scorewerte |

|---|---|---|---|---|---|

| Auswertung der Klassifizierungsgenauigkeit | Genauigkeit | Misst die Leistung eines Klassifizierungssystems durch einen Vergleich seiner Ausgaben mit der Grundwahrheit. | No | Vorhersage, Grundwahrheit | Im Bereich [0, 1] |

| Auswertung der Übereinstimmung mit der QnA-Quelle | Quellenübereinstimmung | Misst, wie sehr die vorhergesagten Antworten des Modells mit der Eingabequelle übereinstimmen. Auch wenn die LLM-Antworten korrekt sind, gelten sie als nicht übereinstimmend, wenn sie nicht anhand der Quelle überprüft werden können. | Ja | Frage, Antwort, Kontext (keine Grundwahrheit) | 1 bis 5 (1 = schlechtester Wert, 5 = bester Wert) |

| Fragen und Antworten zur GPT-Ähnlichkeitsbewertung | GPT-Ähnlichkeit | Misst die Ähnlichkeit zwischen den vom Benutzer bereitgestellten Grundwahrheitsantworten und der vom Modell mit einem GPT-Modell vorhergesagten Antwort. | Ja | Frage, Antwort, Grundwahrheit (Kontext nicht erforderlich) | 1 bis 5 (1 = schlechtester Wert, 5 = bester Wert) |

| Auswertung der QnA-Relevanz | Relevance | Misst, wie relevant die vorhergesagten Antworten des Modells in Bezug auf die gestellten Fragen sind. | Ja | Frage, Antwort, Kontext (keine Grundwahrheit) | 1 bis 5 (1 = schlechtester Wert, 5 = bester Wert) |

| Auswertung der QnA-Kohärenz | Kohärenz | Misst die Qualität aller Sätze in der vorhergesagten Antwort eines Modells und wie sie auf natürliche Weise zusammenpassen. | Ja | Frage, Antwort (keine Grundwahrheit, kein Kontext) | 1 bis 5 (1 = schlechtester Wert, 5 = bester Wert) |

| Auswertung der QnA-Geläufigkeit | Geläufigkeit | Misst die grammatikalische und sprachliche Korrektheit der vorhergesagten Antwort des Modells. | Ja | Frage, Antwort (keine Grundwahrheit, kein Kontext) | 1 bis 5 (1 = schlechtester Wert, 5 = bester Wert) |

| Auswertung der QnA-F1-Scores | F1-Score | Misst das Verhältnis der Anzahl der übereinstimmenden Wörter zwischen der Modellvorhersage und der Grundwahrheit. | No | Frage, Antwort, Grundwahrheit (Kontext nicht erforderlich) | Im Bereich [0, 1] |

| Auswertung der QnA-Ada-Ähnlichkeit | Ada-Ähnlichkeit | Berechnet die Einbettungen auf Satzebene (Dokument) mithilfe der Ada-Einbettungs-API für die Grundwahrheit und Vorhersage und berechnet dann die Kosinusähnlichkeit zwischen ihnen (eine Gleitkommazahl) | Ja | Frage, Antwort, Grundwahrheit (Kontext nicht erforderlich) | Im Bereich [0, 1] |

Verbessern der Flowleistung

Wenn bei der Ausführung ein Fehler auftritt, überprüfen Sie die Ausgabe- und Protokolldaten, und debuggen Sie eventuelle Flowfehler. Um den Flow zu korrigieren oder die Leistung zu verbessern, versuchen Sie, den Flow Prompt, die Systemmeldung, die Flowparameter oder die Flowlogik zu ändern.

Eingabeaufforderungsengineering

Das Erstellen von Prompts kann schwierig sein. Weitere Informationen zu den Konzepten für die Prompterstellung finden Sie unter Übersicht über Prompts. Informationen zum Erstellen eines Prompts, mit dem Sie Ihre Ziele erreichen können, finden Sie unter Prompt-Engineering-Techniken.

Systemmeldung

Sie können die Systemnachricht, die manchmal auch als Meta-Prompt oder System-Prompt bezeichnet wird, verwenden, um das Verhalten eines KI-Systems zu steuern und die Systemleistung zu verbessern. Informationen zum Verbessern der Flowleistung mit Systemmeldungen finden Sie unter Bewährte Methoden für die schrittweise Erstellung.

Goldene Datasets

Die Erstellung eines Copilot, der LLMs verwendet, beinhaltet in der Regel die Verankerung des Modells in der Realität anhand von Quelldatensätzen. Mit einem goldenen Dataset kann sichergestellt werden, dass die LLMs die genauesten und nützlichsten Antworten auf Kundenanfragen geben.

Ein goldenes Dataset ist eine Sammlung realistischer Kundenfragen und professionell gestalteter Antworten, die als Qualitätssicherungsinstrument für die LLMs dienen, die Ihr Copilot verwendet. Goldene Datasets werden nicht zum Trainieren eines LLM oder zum Einfügen von Kontext in einen LLM-Prompt, sondern zum Bewerten der Qualität der vom LLM generierten Antworten verwendet.

Wenn Ihr Szenario einen Copilot beinhaltet oder Sie Ihren eigenen Copilot erstellen, finden Sie unter Erstellen goldener Datasets detaillierte Anleitungen und bewährte Methoden.