Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Artikel werden Methoden beschrieben, die Sie für die Modellinterpretierbarkeit in Azure Machine Learning verwenden können.

Wichtig

Mit der Veröffentlichung des Responsible AI-Dashboards, das die Modellinterpretierbarkeit umfasst, empfehlen wir Ihnen, auf die neue Oberfläche zu migrieren, da das ältere SDK v1-Dashboard für die Vorschaumodell-Interpretierbarkeit nicht mehr aktiv gepflegt wird.

Warum die Interpretierbarkeit von Modellen für das Debuggen von Modellen wichtig ist

Wenn Sie Machine Learning-Modelle in einer Weise einsetzen, die das Leben von Menschen beeinflusst, ist es von entscheidender Bedeutung zu verstehen, was das Verhalten der Modelle beeinflusst. Interpretierbarkeit hilft bei der Beantwortung von Fragen in Szenarien wie:

- Modell-Debugging: Warum hat mein Modell diesen Fehler gemacht? Wie kann ich mein Modell verbessern?

- Zusammenarbeit zwischen Mensch und KI: Wie kann ich die Entscheidungen des Modells verstehen und ihnen vertrauen?

- Einhaltung gesetzlicher Vorschriften: Erfüllt mein Modell die gesetzlichen Anforderungen?

Die Interpretierbarkeitskomponente des Responsible AI Dashboard trägt zur „Diagnose“-Phase des Modelllebenszyklus-Workflows bei, indem sie für Menschen verständliche Beschreibungen der Vorhersagen eines maschinellen Lernmodells generiert. Es bietet mehrere Einblicke in das Verhalten eines Modells:

- Globale Erläuterungen: Welche Merkmale beeinflussen beispielsweise das Gesamtverhalten eines Kreditvergabemodells?

- Lokale Erklärungen: Warum wurde beispielsweise der Kreditantrag eines Kunden genehmigt oder abgelehnt?

Sie können auch Modellerklärungen für eine ausgewählte Kohorte als Untergruppe von Datenpunkten beobachten. Dieser Ansatz ist wertvoll, wenn Sie beispielsweise die Fairness in Modellvorhersagen für Personen in einer bestimmten demografischen Gruppe bewerten. Die Registerkarte Lokale Erklärung dieser Komponente stellt auch eine vollständige Datenvisualisierung dar, die sich hervorragend für die allgemeine Betrachtung der Daten und die Betrachtung der Unterschiede zwischen korrekten und falschen Vorhersagen jeder Kohorte eignet.

Die Fähigkeiten dieser Komponente werden durch das InterpretML-Paket begründet, das Modellerklärungen generiert.

Verwenden Sie die Interpretierbarkeit, wenn Sie:

- Sie müssen ermitteln, wie vertrauenswürdig die Vorhersagen Ihres KI-Systems sind, indem Sie verstehen, welche Features für die Vorhersagen am wichtigsten sind.

- Gehen Sie an das Debugging Ihres Modells heran, indem Sie es zuerst verstehen und feststellen, ob das Modell gesunde Merkmale oder lediglich falsche Korrelationen verwendet.

- Entdecken Sie potenzielle Quellen von Unfairness, indem Sie verstehen, ob das Modell Vorhersagen auf sensiblen Funktionen oder auf Funktionen basiert, die stark mit ihnen korrelieren.

- Bauen Sie das Vertrauen der Benutzer in die Entscheidungen Ihres Modells auf, indem Sie lokale Erklärungen generieren, um deren Ergebnisse zu veranschaulichen.

- Sie müssen eine gesetzlich vorgeschriebene Überprüfung eines KI-Systems durchführen, um Modelle zu validieren und die Auswirkungen von Modellentscheidungen auf Menschen zu überwachen.

Interpretieren des Modells

Beim maschinellen Lernen sind Funktionen die Datenfelder, die Sie verwenden, um einen Zieldatenpunkt vorherzusagen. Um beispielsweise das Kreditrisiko vorherzusagen, können Sie Datenfelder für Alter, Kontogröße und Kontoalter verwenden. Hier sind Alter, Kontogröße und Kontoalter Funktionen. Die Wichtigkeit der Funktion gibt an, wie sich jedes Datenfeld auf die Vorhersagen des Modells auswirkt. Obwohl Sie beispielsweise das Alter in der Vorhersage stark verwenden, wirken sich die Kontogröße und das Kontoalter möglicherweise nicht wesentlich auf die Vorhersagewerte aus. Durch diesen Prozess können Datenwissenschaftler die resultierenden Vorhersagen so erklären, dass die Beteiligten einen Einblick in die wichtigsten Merkmale des Modells erhalten.

Durch die Verwendung der Klassen und Methoden im Responsible AI-Dashboard und durch die Verwendung von SDK v2 und CLI v2 können Sie:

- Erklären Sie die Modellvorhersage, indem Sie Wichtigkeitswerte der Funktion für das gesamte Modell (globale Erklärung) oder einzelne Datenpunkte (lokale Erklärung) generieren.

- Erzielen Sie die Interpretierbarkeit von Modellen in Datensätzen aus der realen Welt in großem Maßstab.

- Verwenden Sie ein interaktives Visualisierungs-Dashboard, um Muster in Ihren Daten und deren Erklärungen zur Trainingszeit zu entdecken.

Durch die Verwendung der Klassen und Methoden im SDK v1 können Sie:

- Erklären Sie die Modellvorhersage, indem Sie Wichtigkeitswerte der Funktion für das gesamte Modell oder einzelne Datenpunkte generieren.

- Erzielen Sie während des Trainings und der Inferenz Modellinterpretierbarkeit von Datensätzen aus der realen Welt in großem Maßstab.

- Verwenden Sie ein interaktives Visualisierungs-Dashboard, um Muster in Ihren Daten und deren Erklärungen zur Trainingszeit zu entdecken.

Hinweis

Modellinterpretierbarkeitsklassen werden über das SDK v1-Paket zur Verfügung gestellt. Weitere Informationen finden Sie unter Installieren von SDK-Paketen für Azure Machine Learning und azureml.interpret.

Unterstützte Techniken für die Modellinterpretierbarkeit

Das Responsible AI-Dashboard und azureml-interpret verwenden die Interpretierbarkeitstechniken, die in Interpret-Community entwickelt wurden, einem Open-Source-Python-Paket zum Trainieren interpretierbarer Modelle und zum Erklären von Opaque-Box-KI-Systemen. Undurchsichtige Modelle sind solche, die keine Informationen zu ihren internen Abläufen liefern.

Interpret-Community dient als Host für die folgenden unterstützten Erklärer und unterstützt derzeit die in den nächsten Abschnitten vorgestellten Interpretierbarkeitstechniken.

Unterstützt im Dashboard für verantwortungsvolle KI in Python SDK v2 und CLI v2

| Technik der Interpretierbarkeit | Beschreibung | Typ |

|---|---|---|

| Mimic Explainer (globales Surrogat) + SHAP-Struktur | Mimic Explainer basiert auf der Idee, globale Surrogatmodelle zu trainieren, um undurchsichtige Box-Modelle nachzuahmen. Ein globales Ersatzmodell ist ein intrinsisch interpretierbares Modell, das darauf trainiert ist, die Vorhersagen jedes Opak-Box-Modells so genau wie möglich zu approximieren. Data Scientists können das Surrogatmodell interpretieren, um Rückschlüsse in Bezug auf das undurchsichtige Modell zu ziehen. Das Responsible AI-Dashboard verwendet LightGBM (LGBMExplainableModel), gepaart mit dem SHAP (SHapley Additive exPlanations) Tree Explainer, der ein spezifischer Explainer für Bäume und Baumensembles ist. Die Kombination aus LightGBM und SHAP-Baum bietet modellunabhängige globale und lokale Erklärungen Ihrer Machine-Learning-Modelle. |

Modellagnostisch |

Unterstützte Techniken für die Modellinterpretierbarkeit bei Textmodellen

| Technik der Interpretierbarkeit | Beschreibung | type | Textaufgabe |

|---|---|---|---|

| SHAP-Text | SHAP (SHapley Additive exPlanations) ist eine beliebte Erklärungsmethode für Deep Neural Networks, die Erkenntnisse zum Beitrag der einzelnen Eingabefeatures zu einer bestimmten Vorhersage liefert. Sie basiert auf dem Konzept von Shapley-Werten – einer Methode, um den Beitrag einzelner Spieler*innen in einem kooperativen Spiel zu bestimmen. SHAP wendet dieses Konzept auf die Eingabefeatures eines neuronalen Netzwerks an, indem der durchschnittliche Beitrag jedes Features zur Ausgabe des Modells für alle möglichen Kombinationen von Features berechnet wird. Speziell für Text teilt SHAP Wörter hierarchisch auf, wobei jedes Wort oder Token als Feature behandelt wird. Dies führt zu einer Reihe von Attributionswerten, die die Relevanz jedes Worts oder Tokens für die jeweilige Vorhersage quantifizieren. Die endgültige Attributionszuordnung wird generiert, indem diese Werte als Wärmebild über dem ursprünglichen Textdokument visualisiert werden. SHAP ist eine modellunabhängige Methode und kann verwendet werden, um eine Vielzahl von Deep Learning-Modellen zu erklären – einschließlich Convolutional Neural Networks (CNNs), Recurrent Neural Networks (RNNs) und Transformatoren. Darüber hinaus bietet sie mehrere wünschenswerte Eigenschaften wie Konsistenz, Genauigkeit und Fairness. Dies macht sie zu einer zuverlässigen und interpretierbaren Technik, um den Entscheidungsprozess eines Modells zu verstehen. | Modellunabhängig | Textklassifizierung mit mehreren Klassen, Textklassifizierung mit mehreren Bezeichnungen |

Unterstützte Techniken für die Modellinterpretierbarkeit bei Bildmodellen

| Technik der Interpretierbarkeit | Beschreibung | type | Aufgabe für maschinelles Sehen |

|---|---|---|---|

| SHAP für maschinelles Sehen | SHAP (SHapley Additive exPlanations) ist eine beliebte Erklärungsmethode für Deep Neural Networks, die Erkenntnisse zum Beitrag der einzelnen Eingabefeatures zu einer bestimmten Vorhersage liefert. Sie basiert auf dem Konzept von Shapley-Werten – einer Methode, um den Beitrag einzelner Spieler*innen in einem kooperativen Spiel zu bestimmen. SHAP wendet dieses Konzept auf die Eingabefeatures eines neuronalen Netzwerks an, indem der durchschnittliche Beitrag jedes Features zur Ausgabe des Modells für alle möglichen Kombinationen von Features berechnet wird. Speziell für maschinelles Sehen teilt SHAP das Bild hierarchisch auf, wobei Superpixelbereiche des Bilds jeweils als Feature behandelt werden. Dies führt zu einer Reihe von Attributionswerten, die die Relevanz jedes Superpixel- oder Bildbereichs für die jeweilige Vorhersage quantifizieren. Die endgültige Attributionszuordnung wird generiert, indem diese Werte als Wärmebild visualisiert werden. SHAP ist eine modellunabhängige Methode und kann verwendet werden, um eine Vielzahl von Deep Learning-Modellen zu erklären – einschließlich Convolutional Neural Networks (CNNs), Recurrent Neural Networks (RNNs) und Transformatoren. Darüber hinaus bietet sie mehrere wünschenswerte Eigenschaften wie Konsistenz, Genauigkeit und Fairness. Dies macht sie zu einer zuverlässigen und interpretierbaren Technik, um den Entscheidungsprozess eines Modells zu verstehen. | Modellunabhängig | Bildklassifizierung mit mehreren Klassen, Bildklassifizierung mit mehreren Bezeichnungen |

| Geleitete Backpropagation | Die geleitete Backpropagation ist eine beliebte Erklärungsmethode für Deep Neural Networks, die Erkenntnisse zu den gelernten Darstellungen des Modells liefert. Sie generiert eine Visualisierung der Eingabefeatures, die ein bestimmtes Neuron im Modell aktivieren. Hierzu wird der Gradient der Ausgabe in Bezug auf das Eingabebild berechnet. Anders als bei anderen gradientbasierten Methoden wird bei der geleiteten Backpropagation nur eine Backpropagation für positive Gradienten durchgeführt und eine angepasste ReLU-Aktivierungsfunktion verwendet, um sicherzustellen, dass negative Gradienten die Visualisierung nicht beeinflussen. Dies führt zu einer besser interpretierbaren und hochauflösenden Salienzkarte, die die wichtigsten Features des Eingabebilds für eine bestimmte Vorhersage hervorhebt. Die geleitete Backpropagation kann verwendet werden, um eine Vielzahl von Deep Learning-Modellen zu erklären – einschließlich Convolutional Neural Networks (CNNs), Recurrent Neural Networks (RNNs) und Transformatoren. | AutoML | Bildklassifizierung mit mehreren Klassen, Bildklassifizierung mit mehreren Bezeichnungen |

| Geleitetes Grad-CAM | Geleitetes Grad-CAM ist eine beliebte Erklärungsmethode für Deep Neural Networks, die Erkenntnisse zu den gelernten Darstellungen des Modells liefert. Es generiert eine Visualisierung der Eingabefeatures, die am stärksten zu einer bestimmten Ausgabeklasse beitragen. Hierzu wird der gradientbasierte Ansatz der geleiteten Backpropagation mit dem Lokalisierungsansatz von Grad-CAM kombiniert. Bei diesem Verfahren werden die Gradienten der Ausgabeklasse in Bezug auf die Featurezuordnungen des letzten Convolutional Layers im Netzwerk berechnet und anschließend die einzelnen Featurezuordnungen gemäß der Relevanz ihrer Aktivierung für diese Klasse gewichtet. Dadurch entsteht ein hochauflösendes Wärmebild, das die am stärksten unterschiedlichen Regionen des Eingabebilds für die angegebene Ausgabeklasse hervorhebt. Geleitetes Grad-CAM kann verwendet werden, um eine Vielzahl von Deep Learning-Modellen zu erklären – einschließlich Convolutional Neural Networks (CNNs), Recurrent Neural Networks (RNNs) und Transformatoren. Darüber hinaus wird durch die Integration der geleiteten Backpropagation sichergestellt, dass die Visualisierung aussagekräftig und interpretierbar ist, wodurch falsche Aktivierungen und negative Beiträge vermieden werden. | AutoML | Bildklassifizierung mit mehreren Klassen, Bildklassifizierung mit mehreren Bezeichnungen |

| Integrierte Gradienten | Integrierte Gradienten sind eine beliebte Erklärungsmethode für Deep Neural Networks, die Erkenntnisse zum Beitrag der einzelnen Eingabefeatures zu einer bestimmten Vorhersage liefert. Sie berechnet das Integral des Gradienten der Ausgabeklasse in Bezug auf das Eingabebild entlang eines geraden Pfads zwischen einem Baselinebild und dem tatsächlichen Eingabebild. Dieser Pfad wird in der Regel als lineare Interpolation zwischen den beiden Bildern gewählt, wobei die Baseline ein neutrales Bild ohne saliente Features ist. Durch die Integration des Gradienten entlang dieses Pfads bieten integrierte Gradienten ein Maß für den Beitrag der einzelnen Eingabefeatures zur Vorhersage, um eine Attributionszuordnung zu generieren. Diese Karte hebt die einflussreichsten Eingabefeatures hervor und kann verwendet werden, um Erkenntnisse zum Entscheidungsprozess des Modells zu gewinnen. Integrierte Gradienten eignen sich zur Erklärung einer Vielzahl von Deep Learning-Modellen – einschließlich Convolutional Neural Networks (CNNs), Recurrent Neural Networks (RNNs) und Transformatoren. Darüber hinaus ist es eine theoretisch fundierte Technik mit einer Reihe wünschenswerter Eigenschaften wie Empfindlichkeit, Implementierungsbeständigkeit und Vollständigkeit. | AutoML | Bildklassifizierung mit mehreren Klassen, Bildklassifizierung mit mehreren Bezeichnungen |

| XRAI | XRAI ist eine neuartige bereichsbasierte Salienzmethode, die auf integrierten Gradienten (IG) basiert. Sie übersegmentiert das Bild und testet iterativ die Relevanz jeder Region, wobei kleinere Regionen basierend auf Attributionsscores zu größeren Segmenten zusammengefasst werden. Diese Strategie führt zu hochwertigen, eng begrenzten Salienzbereichen, die bestehende Salienztechniken übertreffen. XRAI kann mit jedem DNN-basierten Modell verwendet werden, solange es eine Möglichkeit gibt, die Eingabefeatures mithilfe einer Ähnlichkeitsmetrik in Segmenten zu gruppieren. | AutoML | Bildklassifizierung mit mehreren Klassen, Bildklassifizierung mit mehreren Bezeichnungen |

| D-RISE | D-RISE ist eine modellunabhängige Methode zum Erstellen visueller Erklärungen für die Vorhersagen von Objekterkennungsmodellen. Durch Berücksichtigung der Lokalisierungs- und Kategorisierungsaspekte der Objekterkennung kann D-RISE Salienzkarten erstellen, die Teile eines Bilds hervorheben, die am stärksten zur Vorhersage des Detektors beitragen. Im Gegensatz zu gradientbasierten Methoden ist D-RISE allgemeiner und benötigt keinen Zugriff auf das Innenleben des Objektdetektors. D-RISE benötigt lediglich Zugriff auf die Ein- und Ausgaben des Modells. Die Methode kann auf einstufige Detektoren (z. B. YOLOv3), zweistufige Detektoren (z. B. Faster-RCNN) und Vision Transformers (z. B. DETR, OWL-ViT) angewendet werden. D-RISE erstellt willkürliche Masken des Eingabebilds, um die Salienzkarte bereitzustellen, und sendet sie mit den willkürlichen Masken des Eingabebilds an den Objektdetektor. Durch die Bewertung der Veränderung der Punktzahl des Objektdetektors werden alle Erkennungen mit jeder Maske zusammengefasst und eine endgültige Salienzkarte erstellt. |

Modellunabhängig | Objekterkennung |

Unterstützt in Python SDK v1

| Technik der Interpretierbarkeit | Beschreibung | type |

|---|---|---|

| SHAP Tree Explainer | Der SHAP Tree Explainer, der sich auf einen polynomialen, zeitschnellen SHAP-Wertschätzungsalgorithmus konzentriert, der spezifisch für Bäume und Ensembles von Bäumen ist . | Modellspezifisch |

| SHAP Deep Explainer | Basierend auf der Erklärung von SHAP ist Deep Explainer ein „Hochgeschwindigkeits-Approximationsalgorithmus für SHAP-Werte in Deep-Learning-Modellen, der auf einer Verbindung mit DeepLIFT aufbaut, die im SHAP-NIPS-Paper beschrieben wird. TensorFlow-Modelle und Keras-Modelle, die das TensorFlow-Backend verwenden, werden unterstützt (es gibt auch vorläufige Unterstützung für PyTorch).“ | Modellspezifisch |

| SHAP Linear Explainer | Der SHAP Linear Explainer berechnet SHAP-Werte für ein lineares Modell und berücksichtigt optional Korrelationen zwischen Funktionen. | Modellspezifisch |

| SHAP Kernel Explainer | Der SHAP Kernel Explainer verwendet eine speziell gewichtete lokale lineare Regression, um die SHAP-Werte für jedes Modell zu schätzen. | Modellagnostisch |

| Mimic Explainer (Globaler Surrogat) | Mimic Explainer basiert auf der Idee, globale Surrogatmodelle zu trainieren, um undurchsichtige Box-Modelle nachzuahmen. Ein globales Ersatzmodell ist ein intrinsisch interpretierbares Modell, das darauf trainiert ist, die Vorhersagen jedes Opak-Box-Modells so genau wie möglich zu approximieren. Data Scientists können das Surrogatmodell interpretieren, um Rückschlüsse in Bezug auf das undurchsichtige Modell zu ziehen. Sie können eines der folgenden interpretierbaren Modelle als Ersatzmodell verwenden: LightGBM (LGBMExplainableModel), Lineare Regression (LinearExplainableModel), Stochastic Gradient Descent Explainable Model (SGDExplainableModel) oder Decision Tree (DecisionTreeExplainableModel). | Modellagnostisch |

| Permutation Feature Importance Explainer | Permutation Feature Importance ist ein Verfahren zum Erklären von Klassifizierungs- und Regressionsmodellen, das auf dem Random Forests Paper von Breiman (siehe Abschnitt 10) basiert. Die grobe Funktionsweise besteht darin, nach dem Zufallsprinzip die Daten des gesamten Datasets für jeweils ein Feature zu vermischen und dann zu berechnen, wie stark sich die gewünschte Leistungsmetrik ändert. Je größer die Änderung, desto wichtiger ist das Feature. PFI kann das Gesamtverhalten jedes zugrunde liegenden Modells erklären, aber nicht einzelne Vorhersagen. | Modellagnostisch |

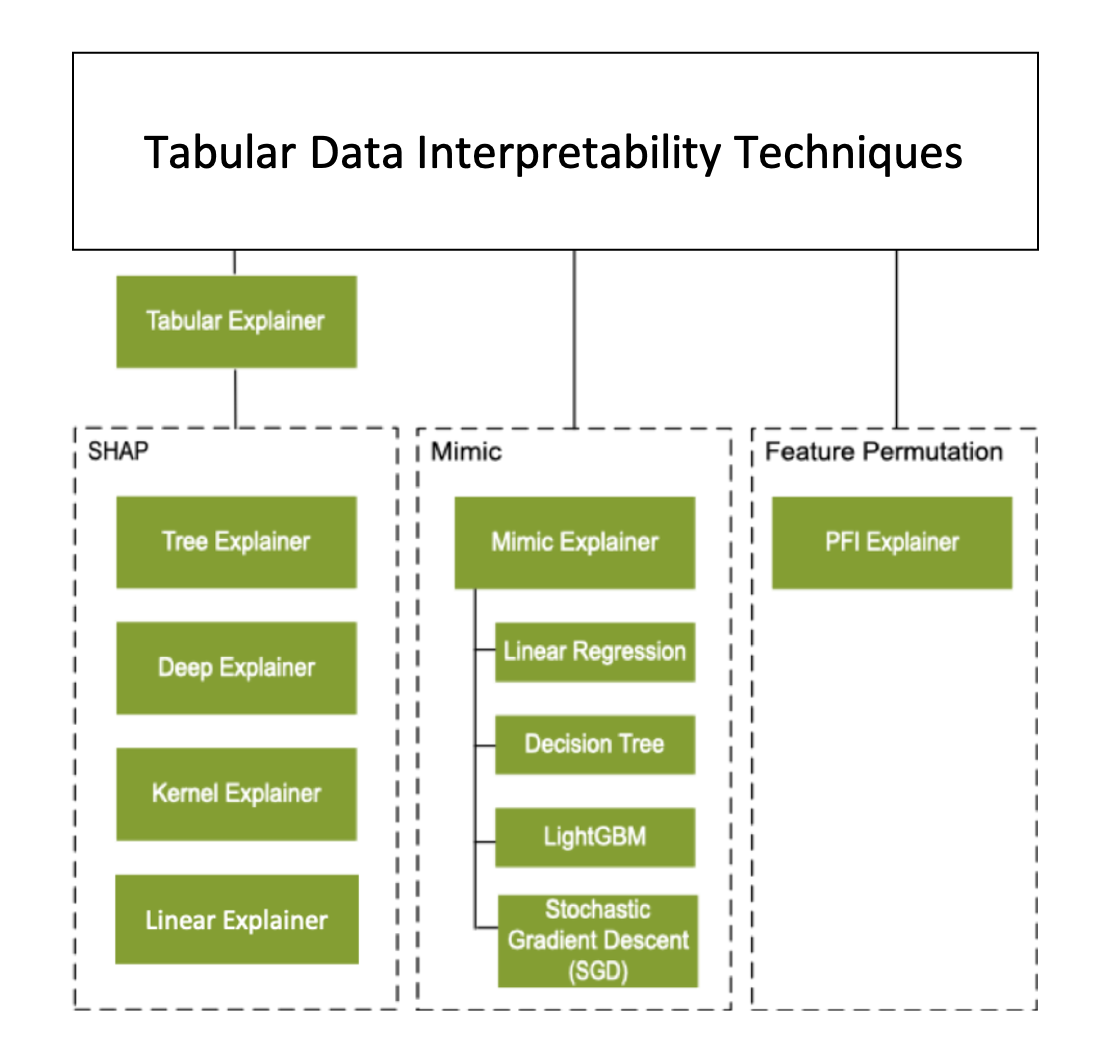

Neben den im vorigen Abschnitt beschriebenen Interpretationstechniken unterstützen wir einen weiteren SHAP-basierten Explainer mit dem Namen Tabular Explainer. Je nach Modell verwendet Tabular Explainer einen der unterstützten SHAP-Explainer:

- Tree Explainer für alle baumbasierten Modelle

- Deep Explainer für Deep Neural Network (DNN)-Modelle

- Linear Explainer für lineare Modelle

- Kernel Explainer für alle anderen Modelle

Tabular Explainer hat auch erhebliche Funktions- und Leistungsverbesserungen gegenüber den direkten SHAP-Erklärern vorgenommen:

- Zusammenfassung des Initialisierungsdatensatzes: Wenn die Erklärungsgeschwindigkeit am wichtigsten ist, fassen wir den Initialisierungsdatensatz zusammen und generieren einen kleinen Satz repräsentativer Stichproben. Dieser Ansatz beschleunigt die Generierung von Gesamt- und individuellen Funktionswichtigkeitswerten.

- Stichproben des Auswertungsdatensatzes: Wenn Sie eine große Menge an Auswertungsstichproben übergeben, aber nicht alle zur Auswertung benötigen, können Sie den Stichprobenparameter auf

truesetzen, um die Berechnung der gesamten Modellerklärungen zu beschleunigen.

Das folgende Diagramm zeigt die aktuelle Struktur der unterstützten Erklärer:

Unterstützte Machine Learning-Modelle

Das azureml.interpret-Paket des SDK unterstützt Modelle, die mit den folgenden Datensatzformaten trainiert werden:

numpy.arraypandas.DataFrameiml.datatypes.DenseDatascipy.sparse.csr_matrix

Die Erklärungsunktionen akzeptieren sowohl Modelle als auch Pipelines als Eingabe. Wenn ein Modell bereitgestellt wird, muss es die Vorhersagefunktion predict oder predict_proba implementieren, die der Scikit-Konvention entspricht. Wenn Ihr Modell dies nicht unterstützt, können Sie es in eine Funktion einschließen, die das gleiche Ergebnis wie predict oder predict_proba in Scikit generiert, und diese Wrapper-Funktion mit dem ausgewählten Explainer verwenden.

Wenn Sie eine Pipeline bereitstellen, geht die Erklärungsfunktion davon aus, dass das ausgeführte Pipelineskript eine Vorhersage zurückgibt. Wenn Sie diese Wrapping-Technik verwenden, kann azureml.interpret Modelle unterstützen, die mit PyTorch, TensorFlow, Keras Deep Learning Frameworks und klassischen Machine Learning-Modellen trainiert wurden.

Lokales- und Remotecomputeziel

Das Paket azureml.interpret funktioniert mit lokalen und Remotecomputezielen. Wenn Sie das Paket lokal ausführen, kontaktieren die SDK-Funktionen keine Azure-Dienste.

Sie können die Erläuterung remote auf Azure Machine Learning Compute ausführen und die Erläuterungsinformationen im Azure Machine Learning-Ausführungsverlaufsdienst protokollieren. Nachdem diese Informationen protokolliert wurden, stehen Berichte und Visualisierungen aus der Erläuterung in Azure Machine Learning Studio zur Analyse bereit.

Nächste Schritte

- Erfahren Sie, wie Sie das Responsible AI-Dashboard über CLI v2 und SDK v2 oder die Benutzeroberfläche von Azure Machine Learning Studio generieren.

- Erkunden Sie die unterstützten Interpretierbarkeitsvisualisierungen des Responsible AI-Dashboards.

- Erfahren Sie, wie Sie eine Scorecard für verantwortungsvolle KI auf Grundlage der im Dashboard für verantwortungsvolle KI beobachteten Erkenntnisse generieren.

- Erfahren Sie, wie Sie Interpretierbarkeit für automatisierte Machine Learning-Modelle (SDK v1) aktivieren.