Tutorial: Gewinnen von Erkenntnissen aus Ihren verarbeiteten Daten

In diesem Tutorial füllen Sie ein Echtzeitdashboard auf, um Erkenntnisse aus den OPC UA-Daten zu erhalten, die Sie im vorherigen Tutorial an Event Hubs gesendet haben. Mithilfe von Real-Time Intelligence von Microsoft Fabric bringen Sie Ihre Daten aus Event Hubs in Microsoft Fabric und ordnen sie einer KQL-Datenbank zu, die eine Quelle für Real-Time Dashboards sein kann. Anschließend erstellen Sie ein Dashboard, um diese Daten in visuellen Kacheln anzuzeigen, die Erkenntnisse erfassen und die Werte im Laufe der Zeit anzeigen.

Bei diesen Vorgängen handelt es sich um die letzten Schritte im umfassenden Beispiel für das Tutorial, das vom Bereitstellen einer Instanz von „Azure IoT Einsatz“ am Edge bis hin zum Abrufen von Erkenntnissen aus diesen Gerätedaten in der Cloud reicht.

Voraussetzungen

Bevor Sie mit diesem Tutorial beginnen, müssen Sie die Schritte unter Tutorial: Senden von Ressourcentelemetriedaten an die Cloud mithilfe eines Datenflusses ausführen.

Sie benötigen auch ein Microsoft Fabric-Abonnement. In Ihrem Abonnement benötigen Sie Zugriff auf einen Arbeitsbereich mit den Berechtigungen der Rolle Mitwirkender oder höheren Berechtigungen.

Darüber hinaus muss Ihr Fabric-Mandant die Erstellung von Echtzeitdashboards zulassen. Dies ist eine Einstellung, die von Ihrem Mandantenadministrator aktiviert werden kann. Weitere Informationen finden Sie unter Aktivieren von Mandanteneinstellungen im Verwaltungsportal.

Welches Problem werden wir lösen?

Sobald Ihre OPC UA-Daten in der Cloud angekommen sind, stehen Ihnen viele Informationen zur Verfügung, die analysiert werden können. Sie müssen diese Daten organisieren und Berichte erstellen, die Diagramme und Visualisierungen enthalten, um Erkenntnisse aus den Daten abzuleiten. Die Schritte in diesem Tutorial veranschaulichen, wie Sie diese Daten mit Echtzeitintelligenz verbinden und ein Echtzeitdashboard erstellen können.

Erfassen von Daten in Real-Time Intelligence

In diesem Abschnitt richten Sie einen Microsoft Fabric-Eventstream ein, um Ihren Event Hub mit einer KQL-Datenbank in Real-Time Intelligence zu verbinden. Dieser Vorgang umfasst das Einrichten einer Datenzuordnung zum Transformieren der Nutzlastdaten aus dem JSON-Format in Spalten in KQL.

Erstellen eines Ereignisstreams

In diesem Abschnitt erstellen Sie einen Eventstream, der verwendet wird, um Ihre Daten aus Event Hubs in Real-Time Intelligence von Microsoft Fabric und schließlich in eine KQL-Datenbank zu übertragen.

Navigieren Sie zunächst zur Real-Time Intelligence-Funktion in Microsoft Fabric, und öffnen Sie Ihren Fabric-Arbeitsbereich.

Führen Sie die Schritte unter Erstellen eines Eventstreams in Microsoft Fabric aus, um eine neue Eventstream-Ressource in Ihrem Arbeitsbereich zu erstellen.

Nachdem der Eventstream erstellt wurde, wird der Haupt-Editor angezeigt, in dem Sie mit dem Erstellen des Eventstreams beginnen können.

Hinzufügen des Event Hubs als Quelle

Fügen Sie als Nächstes Ihren Event Hub aus dem vorherigen Tutorial als Datenquelle für den Eventstream hinzu.

Führen Sie die Schritte unter Hinzufügen einer Azure Event Hubs-Quelle zu einem Eventstream aus, um die Ereignisquelle hinzuzufügen. Berücksichtigen Sie Folgendes:

- Sie erstellen eine neue Cloudverbindung mit der Authentifizierung mit freigegebenem Zugriffsschlüssel.

- Stellen Sie sicher, dass die lokale Authentifizierung auf Ihrem Event Hub aktiviert ist. Sie können dies auf der Seite "Übersicht" im Azure-Portal festlegen.

- Verwenden Sie für Consumergruppe die Standardauswahl ($Default).

- Wählen Sie für DatenformatJSON aus (ist möglicherweise schon standardmäßig ausgewählt).

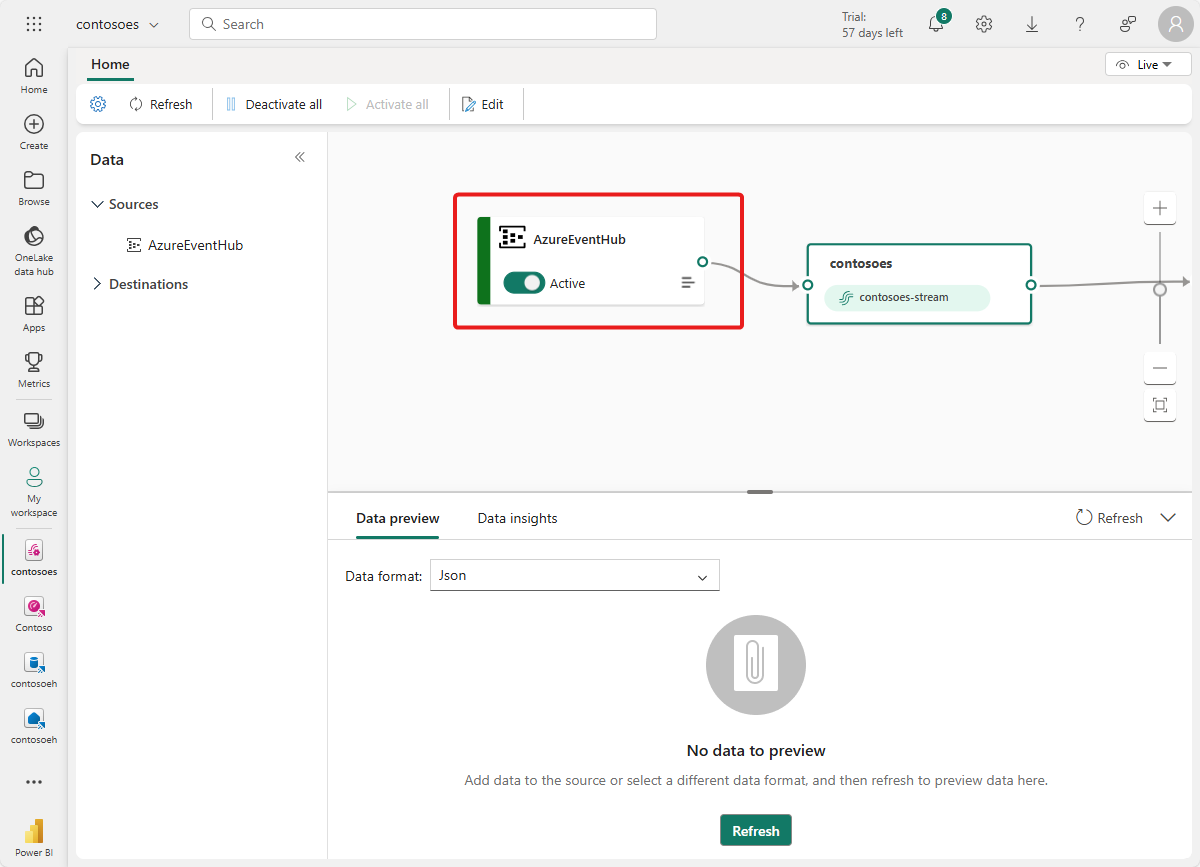

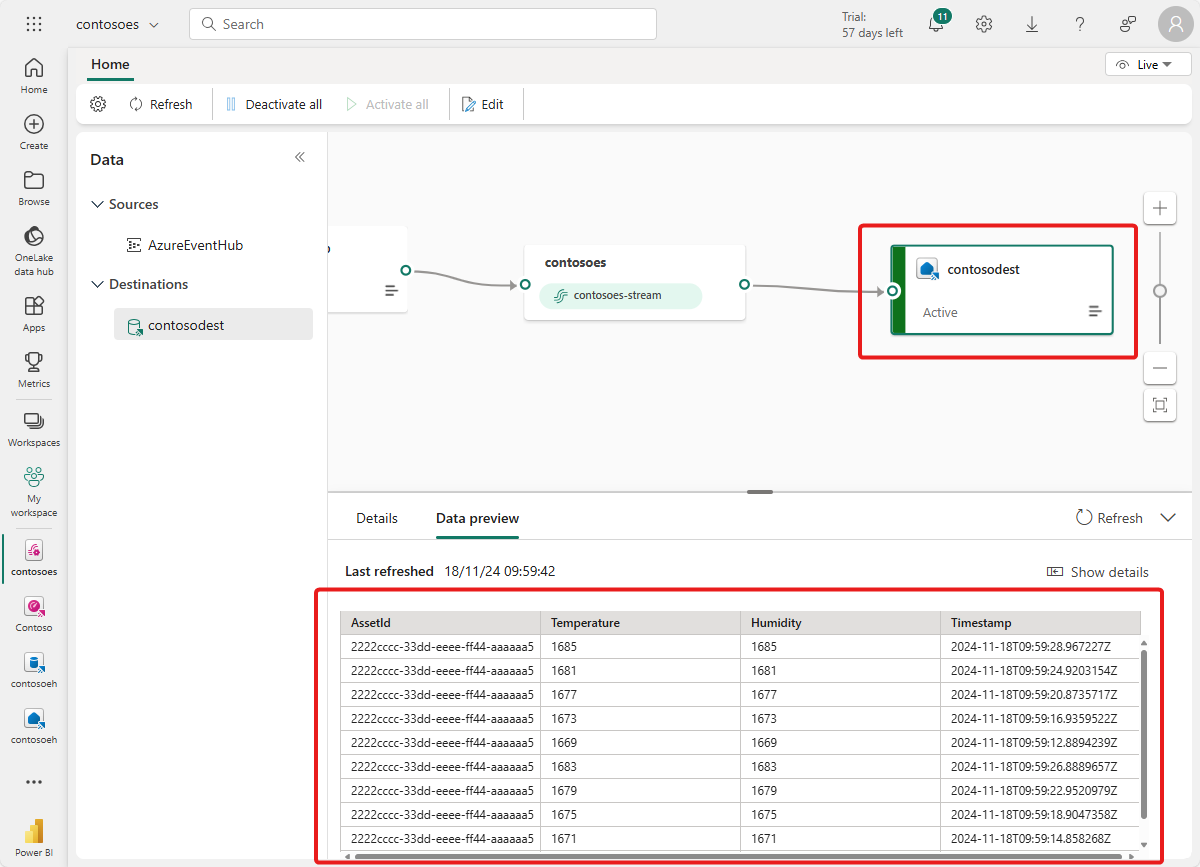

Nach Abschluss dieses Flows wird die Azure Event Hubs-Instanz in der Liveansicht „Eventstream“ als Quelle angezeigt.

Überprüfen des Datenflusses

Führen Sie die folgenden Schritte aus, um Ihre bisherige Arbeit zu überprüfen, und stellen Sie sicher, dass Daten in den Eventstream fließen.

Starten Sie Ihren Cluster, in dem Sie Azure IoT Einsatz in früheren Tutorials bereitgestellt haben. Der OPC PLC-Simulator, den Sie mit Ihrer Azure IoT Einsatz-Instanz bereitgestellt haben, sollte mit der Ausführung und dem Senden von Daten an den MQTT-Broker beginnen. Sie können diesen Teil des Flows wie unter Überprüfen des Dataflows beschrieben mithilfe von „mqttui“ überprüfen.

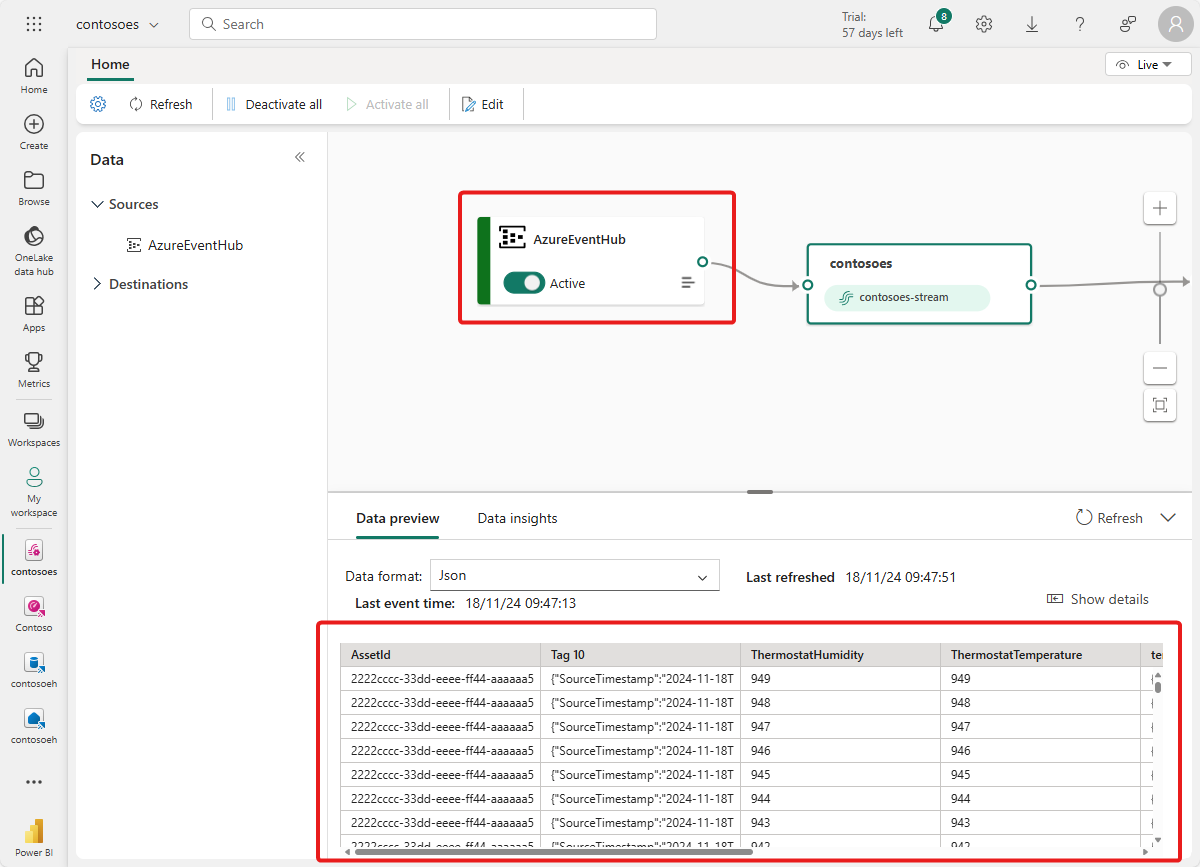

Warten Sie einige Minuten, bis Daten weitergeleitet werden. Wählen Sie dann in der Eventstream-Liveansicht die Quelle AzureEventHub aus, und aktualisieren Sie die Datenvorschau. In der Tabelle sollten JSON-Daten aus dem Simulator angezeigt werden.

Tipp

Wenn Daten nicht in Ihrem Eventstream angekommen sind, müssen Sie die Event-Hub-Aktivität überprüfen, um herauszufinden, ob Nachrichten empfangen werden. Auf diese Weise können Sie ermitteln, welcher Abschnitt des Flows debuggt werden muss.

Aufbereiten von KQL-Ressourcen

In diesem Abschnitt erstellen Sie eine KQL-Datenbank in Ihrem Microsoft Fabric-Arbeitsbereich, die als Ziel für Ihre Daten verwendet werden soll.

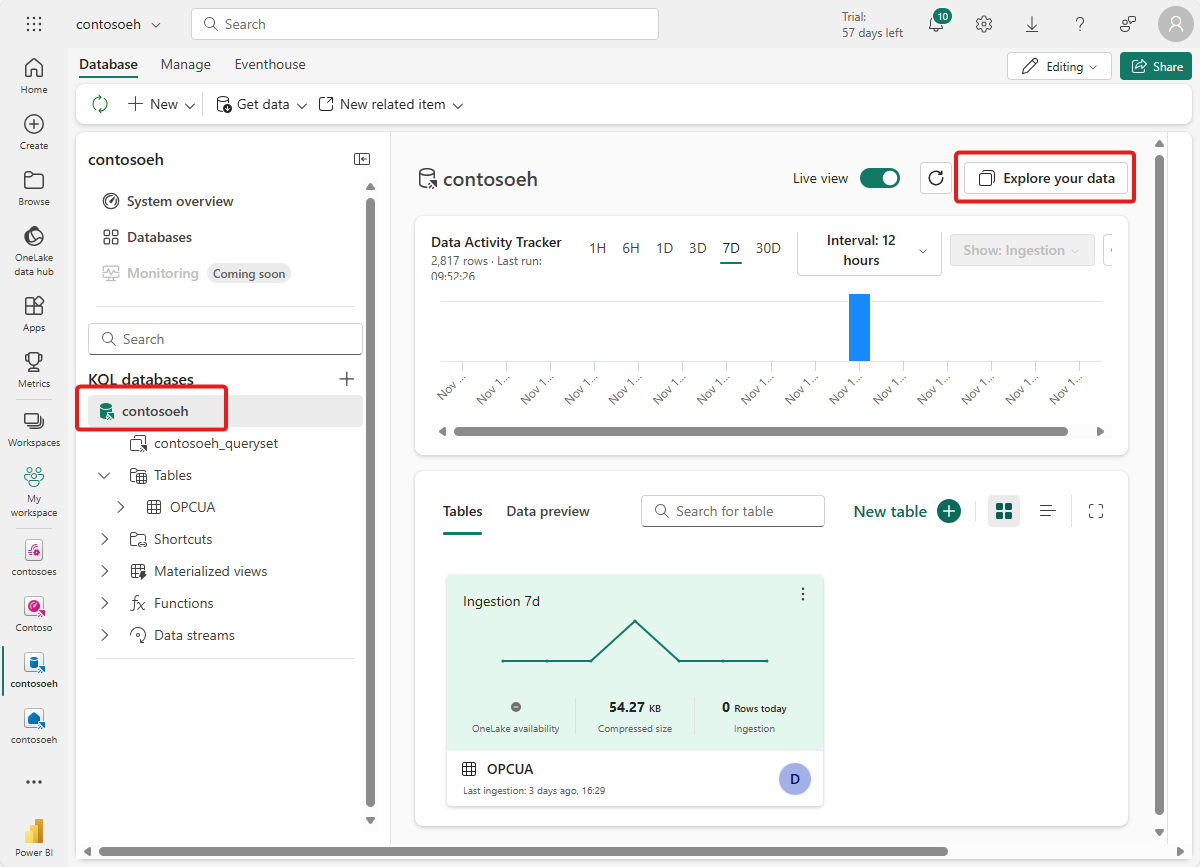

Führen Sie die Schritte unter Erstellen eines Eventhouse aus, um ein Real-Time Intelligence-Eventhouse mit einer untergeordneten KQL-Datenbank zu erstellen. Sie müssen nur den Abschnitt Erstellen eines Eventhouses abschließen.

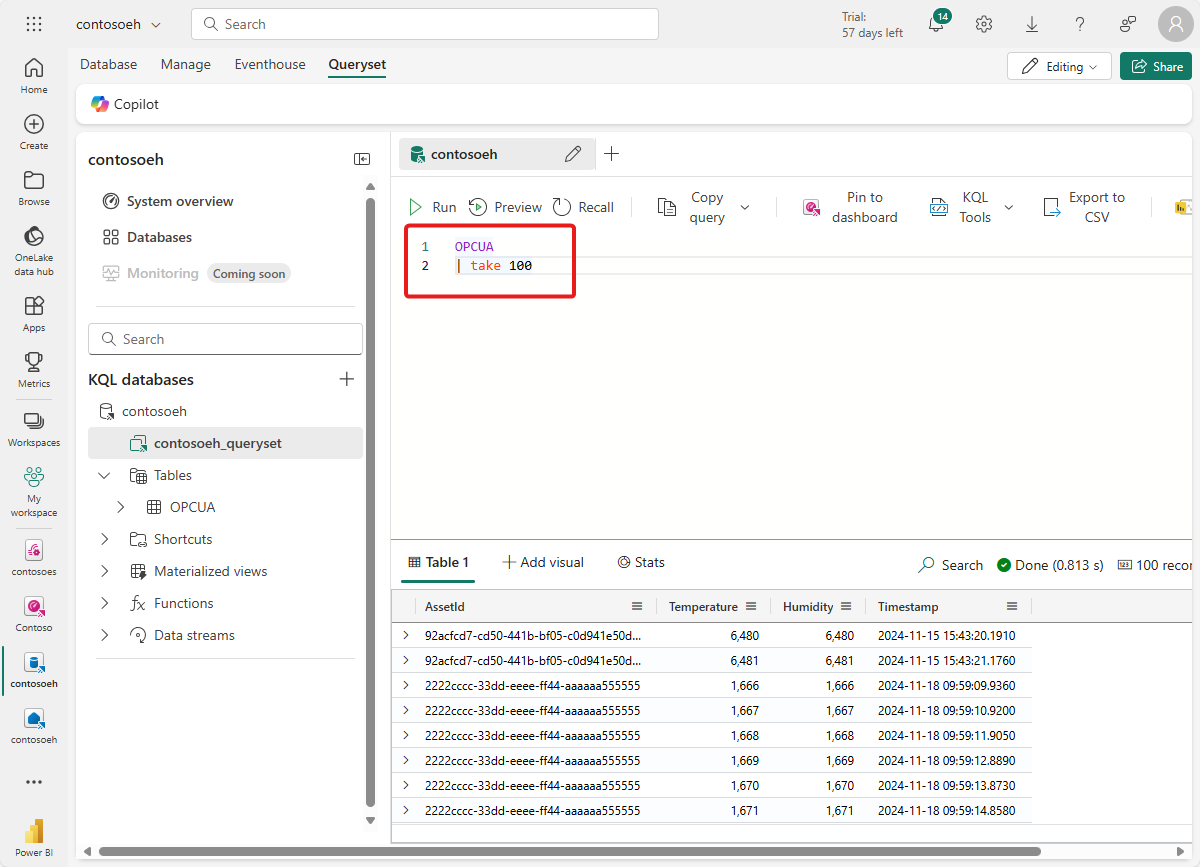

Erstellen Sie als nächstes eine Tabelle in Ihrer Datenbank. Nennen Sie sie OPCUA, und verwenden Sie die folgenden Spalten.

Spaltenname Datentyp AssetId Zeichenfolge Temperature Decimal Timestamp datetime Nachdem die OPCUA-Tabelle erstellt wurde, wählen Sie Ihre Datenbank aus, und verwenden Sie die Schaltfläche Abfrage mit Code, um ein Abfragefenster zu öffnen.

Löschen Sie den Beispielcode, und führen Sie die folgende KQL-Abfrage aus, um eine Datenzuordnung für Ihre Tabelle zu erstellen. Die Datenzuordnung wird opcua_mapping genannt.

.create table ['OPCUA'] ingestion json mapping 'opcua_mapping' '[{"column":"AssetId", "Properties":{"Path":"$[\'AssetId\']"}},{"column":"Temperature", "Properties":{"Path":"$[\'ThermostatTemperatureF\']"}},{"column":"Timestamp", "Properties":{"Path":"$[\'EventProcessedUtcTime\']"}}]'

Hinzufügen einer Datentabelle als Ziel

Wechseln Sie als Nächstes wieder zur Eventstream-Ansicht, in der Sie Ihre neue KQL-Tabelle als Eventstream-Ziel hinzufügen können.

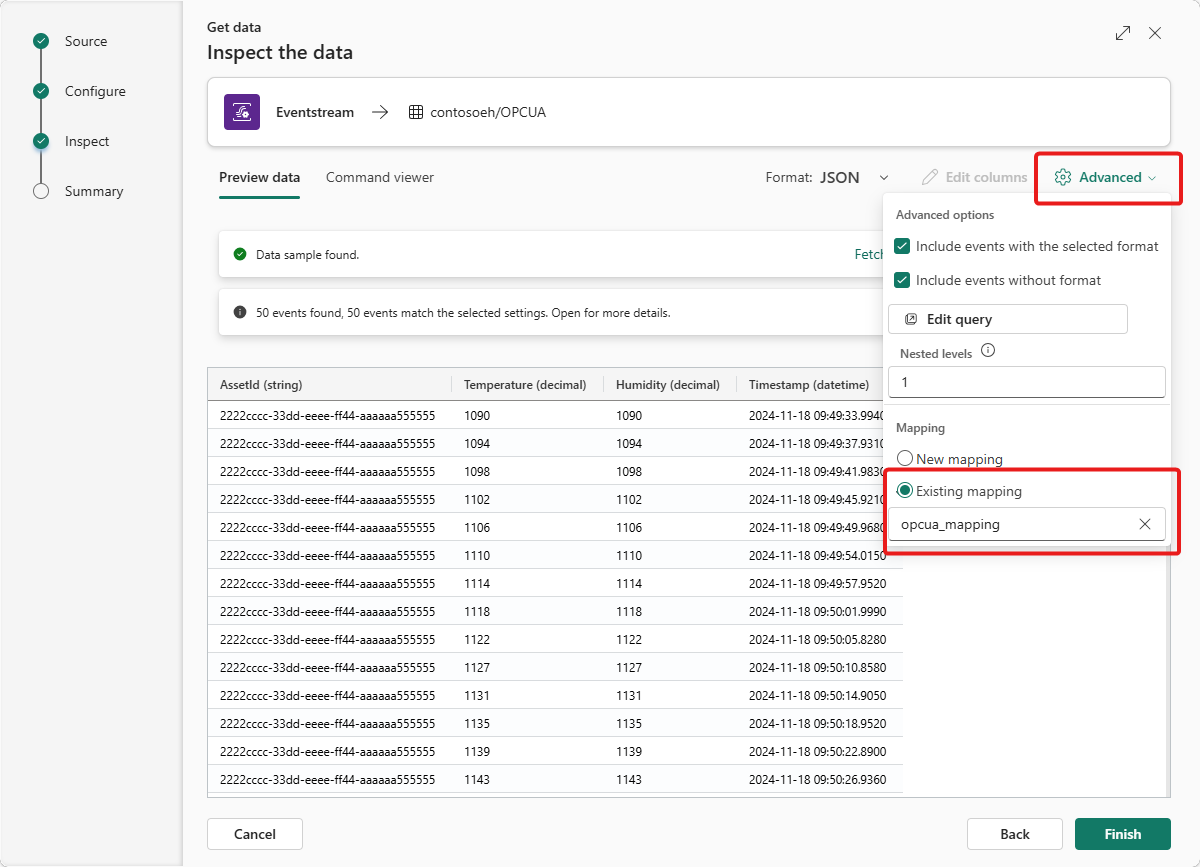

Führen Sie die Schritte unter Hinzufügen eines KQL-Datenbankziels zu einem Eventstream aus, um das Ziel hinzuzufügen. Berücksichtigen Sie Folgendes:

Verwenden Sie den direkten Erfassungsmodus.

Wählen Sie im Schritt Konfigurieren die Tabelle OPCUA aus, die Sie zuvor erstellt haben.

Wählen Sie im Schritt Untersuchen die Option opcua_mapping, anschließend Vorhandene Zuordnung und dann opcua_mapping aus.

Tipp

Wenn keine vorhandenen Zuordnungen gefunden werden, versuchen Sie, den Eventstream-Editor zu aktualisieren und die Schritte zum Hinzufügen des Ziels neu zu starten. Alternativ können Sie diesen Konfigurationsvorgang wie unter Abrufen von Daten aus einem Eventstream beschrieben über die KQL-Tabelle anstatt über den Eventstream initiieren.

Nach Abschluss dieses Flows wird die KQL-Tabelle in der Eventstream-Liveansicht als Ziel angezeigt.

Warten Sie einige Minuten, bis die Daten weitergegeben wurden und sich der Status des Ziels in Aktiv geändert hat.

Wenn Sie möchten, können Sie diese Daten auch direkt in Ihrer KQL-Datenbank anzeigen und abfragen.

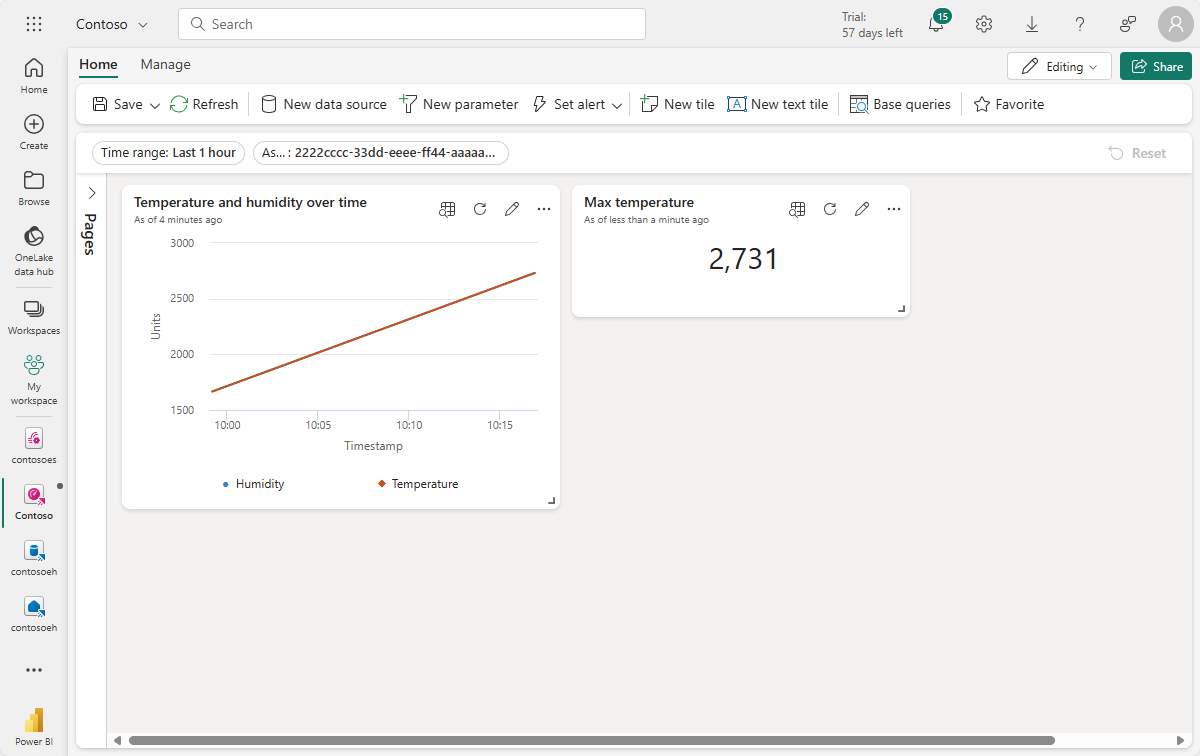

Erstellen von Echtzeitdashboards

In diesem Abschnitt erstellen Sie ein neues Echtzeitdashboard, um Ihre Tutorialdaten zu visualisieren. Das Dashboard ermöglicht das Filtern nach Ressourcen-ID und Zeitstempel und zeigt visuelle Zusammenfassungen von Temperatur- und Druckdaten an.

Hinweis

Sie können nur dann Real-Time Dashboards erstellen, wenn Ihr Mandantenadministrator die Erstellung von Real-Time Dashboards in Ihrem Fabric-Mandanten aktiviert hat. Weitere Informationen finden Sie unter Aktivieren von Mandanteneinstellungen im Verwaltungsportal.

Erstellen von Dashboards und Verbinden der Datenquelle

Führen Sie die Schritte im Abschnitt Erstellen eines neuen Dashboards aus, um ein neues Real-Time Dashboard über die Real-Time Intelligence-Funktionen zu erstellen.

Führen Sie dann die Schritte im Abschnitt Hinzufügen einer Datenquelle aus, um Ihre Datenbank als Datenquelle hinzuzufügen. Berücksichtigen Sie Folgendes:

- Im Bereich Datenquellen finden Sie Ihre Datenbank unter Eventhouse/KQL-Datenbank.

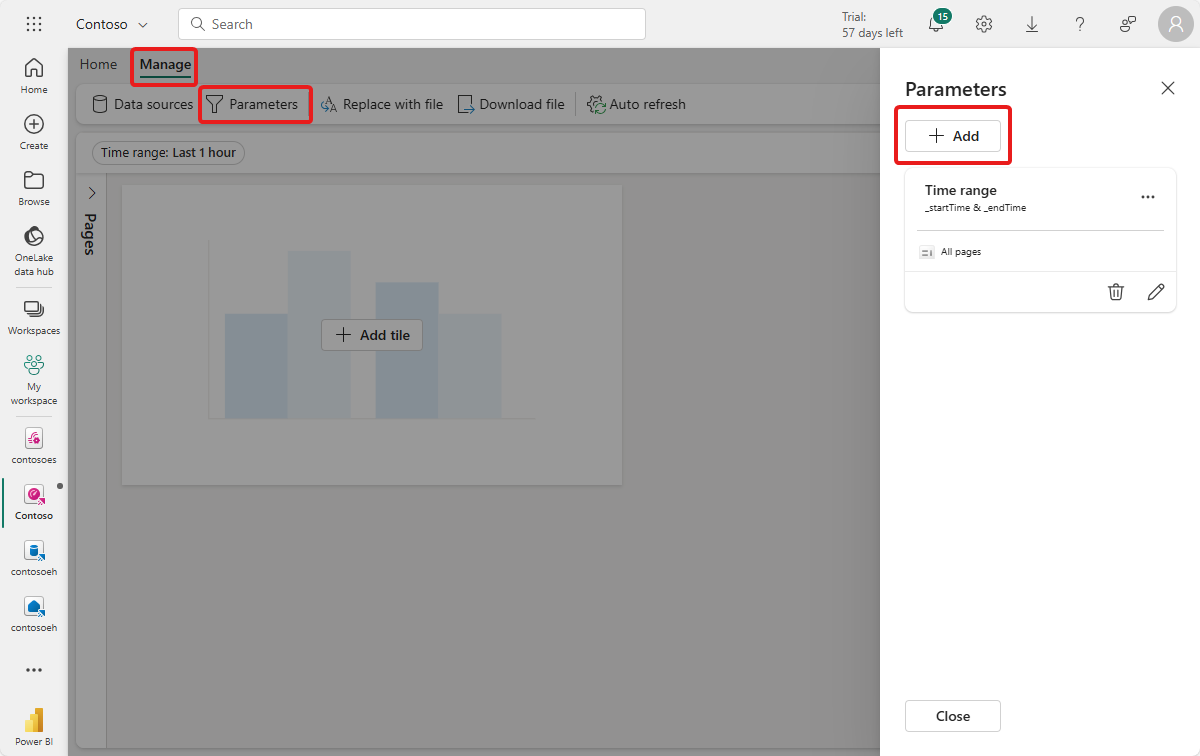

Parameter konfigurieren

Konfigurieren Sie als nächstes einige Parameter für Ihr Dashboard, damit die visuellen Elemente nach Ressourcen-ID und Zeitstempel gefiltert werden können. Das Dashboard verfügt über einen Standardparameter zum Filtern nach Zeitraum, sodass Sie nur einen erstellen müssen, der nach Objekt-ID filtern kann.

Wechseln Sie zur Registerkarte Verwalten, und wählen Sie Parameter aus. Wählen Sie + Hinzufügen aus, um einen neuen Parameter hinzuzufügen.

Erstellen Sie einen neuen Parameter mit den folgenden Merkmalen:

- Bezeichnung: Ressource

- Parametertyp: Einzelne Auswahl (standardmäßig bereits ausgewählt)

- Variablenname: _asset

- Datentyp: Zeichenfolge (standardmäßig bereits ausgewählt)

-

Quelle: Abfrage

Datenquelle: Ihre Datenbank (standardmäßig bereits ausgewählt)

Wählen Sie Abfrage bearbeiten aus, und fügen Sie die folgende KQL-Abfrage hinzu.

OPCUA | summarize by AssetId

- Wertspalte: AssetId

- Standardwert: Ersten Wert der Abfrage auswählen

Wählen Sie Fertig aus, um den Parameter zu speichern.

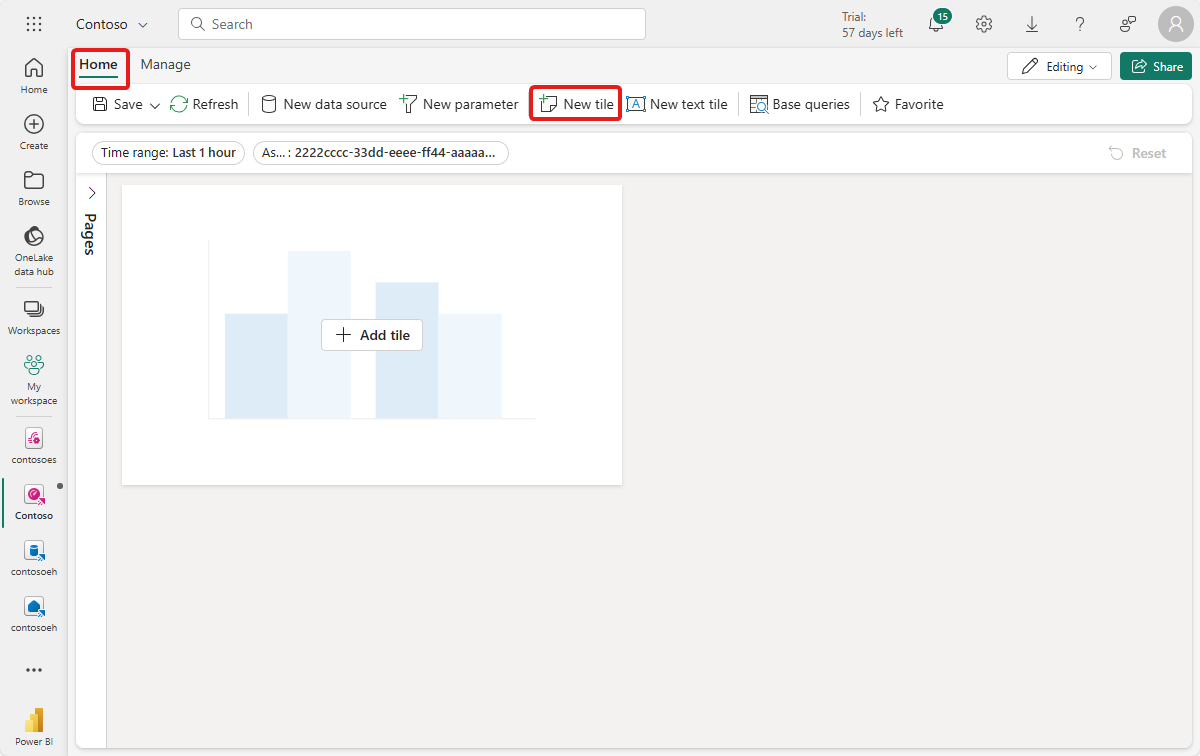

Erstellen einer Liniendiagrammkachel

Fügen Sie als Nächstes eine Kachel zu Ihrem Dashboard hinzu, um ein Liniendiagramm mit der Temperatur und der Luftfeuchtigkeit für die ausgewählte Ressource und den ausgewählten Zeitraum anzuzeigen.

Klicken Sie entweder auf + Kachel hinzufügen oder auf Neue Kachel, um eine neue Kachel hinzuzufügen.

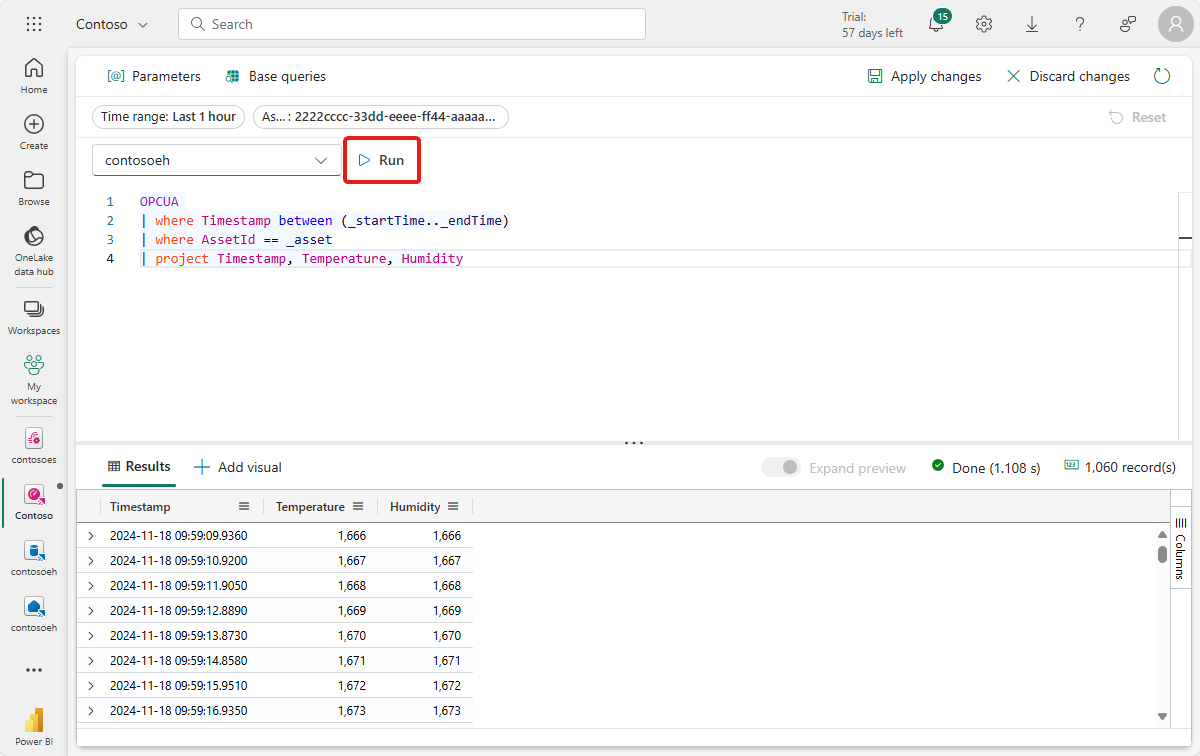

Geben Sie die folgende KQL-Abfrage für die Kachel ein. Diese Abfrage wendet Filterparameter aus den Dashboardauswahlen für den Zeitraum und die Ressource an und ruft die resultierenden Datensätze mit dem Zeitstempel, der Temperatur und der Luftfeuchtigkeit ab.

OPCUA | where Timestamp between (_startTime.._endTime) | where AssetId == _asset | project Timestamp, TemperatureKlicken Sie auf Ausführen, um die Abfrage auszuführen und zu überprüfen, ob Daten gefunden werden.

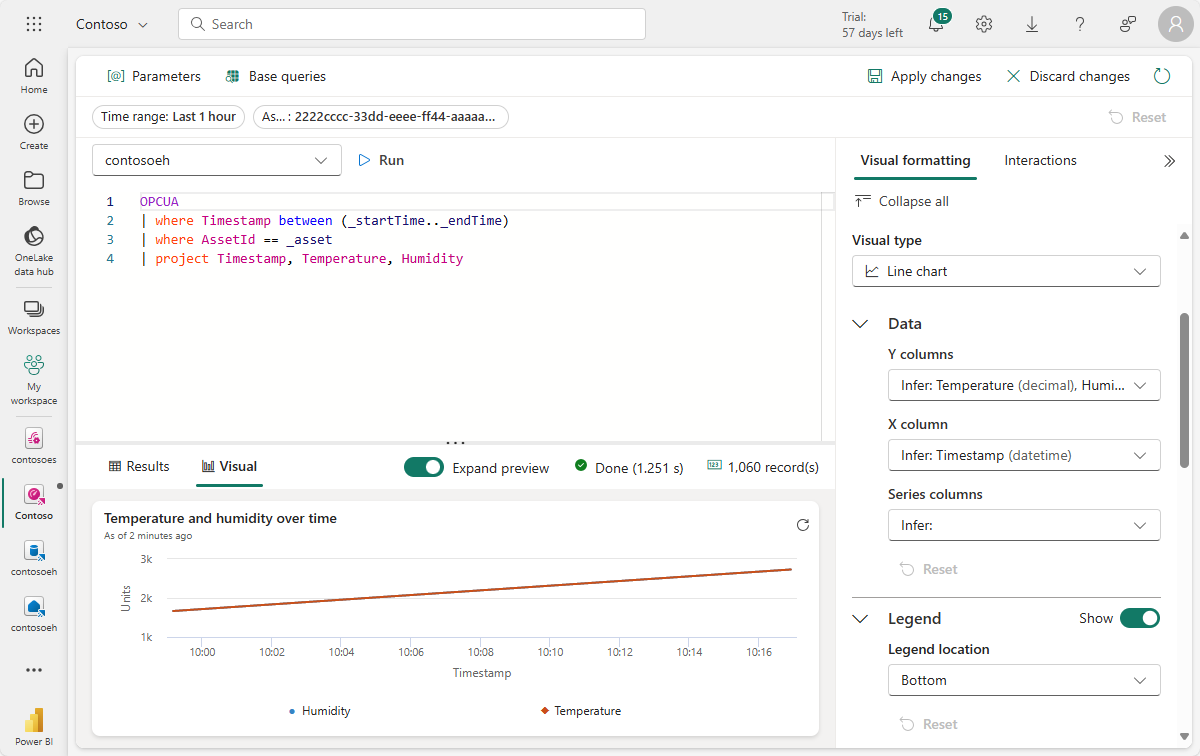

Klicken Sie auf + Visual hinzufügen neben den Abfrageergebnissen, um ein Visual für diese Daten hinzuzufügen. Erstellen Sie ein Visual mit den folgenden Merkmalen:

- Kachelname:Temperatur im Zeitverlauf

- Visualtyp:Liniendiagramm

-

Data:

- Y-Spalten:Temperatur (dezimal) (bereits standardmäßig abgeleitet)

- X-Spalten:Timestamp (datetime) (bereits standardmäßig abgeleitet)

-

Y-Achse:

- Bezeichnung:Units

-

X-Achse:

- Bezeichnung:Timestamp

Wählen Sie Änderungen anwenden aus, um die Kachel zu erstellen.

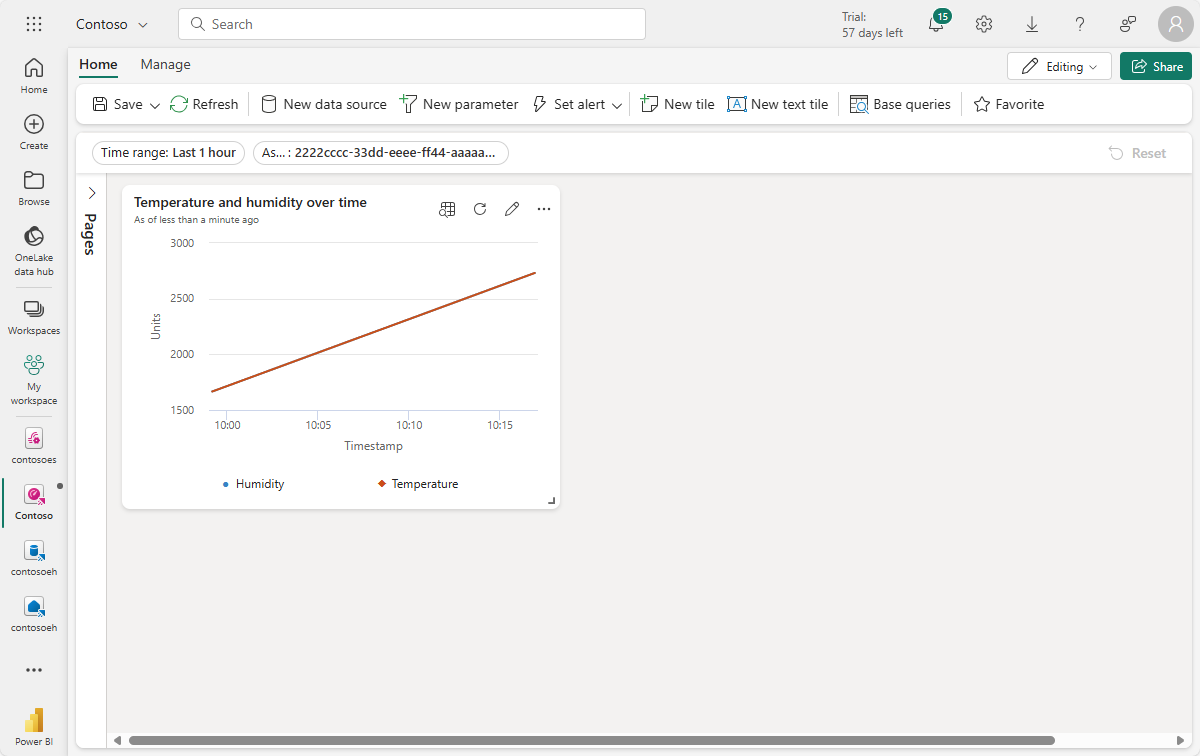

Zeigen Sie die fertige Kachel auf Ihrem Dashboard an.

Erstellen von Kacheln mit Maximalwerten

Erstellen Sie als Nächstes einige Kacheln, um die Maximalwerte von Temperatur und Luftfeuchtigkeit anzuzeigen.

Wählen Sie Neue Kachel aus, um eine neue Kachel zu erstellen.

Geben Sie die folgende KQL-Abfrage für die Kachel ein. Diese Abfrage wendet Filterparameter aus den Dashboardauswahlen für den Zeitbereich und die Ressource an und verwendet den höchsten Temperaturwert aus den resultierenden Datensätzen.

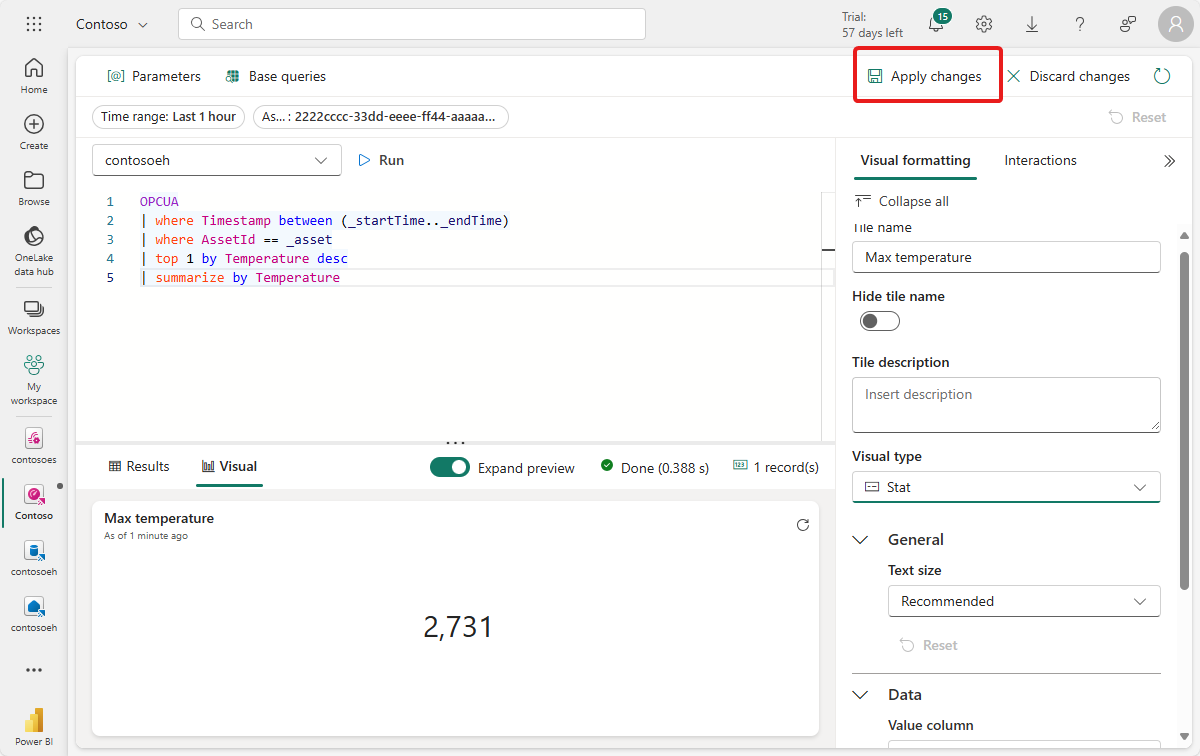

OPCUA | where Timestamp between (_startTime.._endTime) | where AssetId == _asset | top 1 by Temperature desc | summarize by TemperatureKlicken Sie auf Ausführen, um die Abfrage auszuführen und zu überprüfen, ob eine Maximaltemperatur ermittelt werden kann.

Klicken Sie auf + Visual hinzufügen, um ein Visual für diese Daten hinzuzufügen. Erstellen Sie ein Visual mit den folgenden Merkmalen:

- Kachelname:Max temperature

- Visualtyp:Stat

-

Data:

- Wertspalte:Temperature (decimal) (bereits standardmäßig abgeleitet)

Wählen Sie Änderungen anwenden aus, um die Kachel zu erstellen.

Zeigen Sie die fertige Kachel auf Ihrem Dashboard an (ggf. muss die Größe der Kachel geändert werden, sodass der vollständige Text sichtbar ist).

Speichern Sie das vervollständigte Dashboard.

Jetzt verfügen Sie über ein Dashboard, das verschiedene Arten von visuellen Elementen für die Ressourcendaten in diesen Tutorials anzeigt. Nun können Sie mit den Filtern experimentieren und weitere Kacheltypen hinzufügen, um herauszufinden, wie ein Dashboard Ihnen die Möglichkeit bietet, mehr mit Ihren Daten zu erreichen.

Wie haben wir das Problem gelöst?

In diesem Tutorial haben Sie einen Eventstream verwendet, um Ihre Event Hubs-Daten in einer KQL-Datenbank in Microsoft Fabric-Echtzeitintelligenz zu erfassen. Anschließend haben Sie ein Real-Time Dashboard erstellt, das auf diesen Daten basiert, wodurch die Änderung von Werten im Laufe der Zeit visuell nachverfolgt werden kann. Durch die Berücksichtigung von Edgedaten aus verschiedenen Quellen in Microsoft Fabric können Sie Berichte mit Visualisierungen und interaktiven Features erstellen, die tiefere Einblicke in die Integrität, Nutzung und operative Trends von Ressourcen bieten. Dies kann Ihnen helfen, die Produktivität zu verbessern, die Leistung von Ressourcen zu steigern und fundierte Entscheidungsfindungen für bessere Geschäftsergebnisse zu fördern.

Damit ist der letzte Schritt im Tutorialflow für die Verwendung von Azure IoT Einsatz zum Verwalten von Gerätedaten aus der Bereitstellung über die Analyse in der Cloud abgeschlossen.

Bereinigen von Ressourcen

Wenn Sie mit dem nächsten Tutorial fortfahren, sollten Sie alle Ihre Ressourcen beibehalten.

Wenn Sie die Azure IoT Einsatz-Bereitstellung entfernen, aber Ihren Cluster beibehalten möchten, verwenden Sie den Befehl az iot ops delete.

az iot ops delete --cluster $CLUSTER_NAME --resource-group $RESOURCE_GROUP

Wenn Sie alle im Rahmen dieser Schnellstartanleitung erstellten Ressourcen löschen möchten, löschen Sie den Kubernetes-Cluster, in dem Sie Azure IoT Einsatz bereitgestellt haben, und entfernen Sie dann die Azure-Ressourcengruppe, in der das Cluster enthalten war.

Wenn Sie Codespaces für diese Schnellstarts verwendet haben, löschen Sie Ihren Codespace aus GitHub.

Hinweis

Die Ressourcengruppe enthält den Event Hubs-Namespace, den Sie in diesem Tutorial erstellt haben.

Sie können auch Ihren Microsoft Fabric-Arbeitsbereich und/oder alle Ressourcen darin löschen, die diesem Tutorial zugeordnet sind (einschließlich Eventstream, Eventhouse und Echtzeitdashboard).