Sådan kommer du fra Dataflow Generation 1 til Dataflow Generation 2

Dataflow Gen2 er den nye generation af dataflow. Den nye generation af dataflow er placeret sammen med Power BI-dataflowet (Gen1) og giver nye funktioner og forbedrede oplevelser. I følgende afsnit kan du se en sammenligning mellem Dataflow Gen1 og Dataflow Gen2.

Oversigt over funktioner

| Funktion | Dataflow Gen2 | Dataflow Gen1 |

|---|---|---|

| Opret dataflow med Power Query | ✓ | ✓ |

| Kortere oprettelsesflow | ✓ | |

| Automatisk lagring og udgivelse i baggrunden | ✓ | |

| Datadestinationer | ✓ | |

| Forbedret overvågnings- og opdateringshistorik | ✓ | |

| Integration med datapipelines | ✓ | |

| Beregning i høj skala | ✓ | |

| Hent data via dataflowconnector | ✓ | ✓ |

| Direkte forespørgsel via dataflowconnector | ✓ | |

| Trinvis opdatering | ✓ | |

| Understøttelse af AI Insights | ✓ |

Kortere oprettelsesoplevelse

Det føles som at komme hjem, når du arbejder med Dataflow Gen2. Vi har bevaret den fulde Power Query-oplevelse, du er vant til i Power BI-dataflow. Når du indtaster oplevelsen, får du trinvis vejledning i, hvordan du henter dataene ind i dit dataflow. Vi forkorter også oprettelsesoplevelsen for at reducere antallet af trin, der kræves for at oprette dataflow, og vi har tilføjet et par nye funktioner for at gøre din oplevelse endnu bedre.

Ny oplevelse for lagring af dataflow

Med Dataflow Gen2 ændrede vi, hvordan lagring af et dataflow fungerer. Alle ændringer, der er foretaget i et dataflow, gemmes automatisk i cloudmiljøet. Så du kan når som helst afslutte oprettelsesoplevelsen og fortsætte, hvor du slap på et senere tidspunkt. Når du er færdig med at oprette dit dataflow, publicerer du dine ændringer, og disse ændringer bruges, når dataflowet opdateres. Derudover gemmer publicering af dataflowet dine ændringer og kører valideringer, der skal udføres i baggrunden. Med denne funktion kan du gemme dit dataflow uden at skulle vente på, at valideringen afsluttes.

Hvis du vil vide mere om den nye lagringsoplevelse, skal du gå til Gem en kladde af dit dataflow.

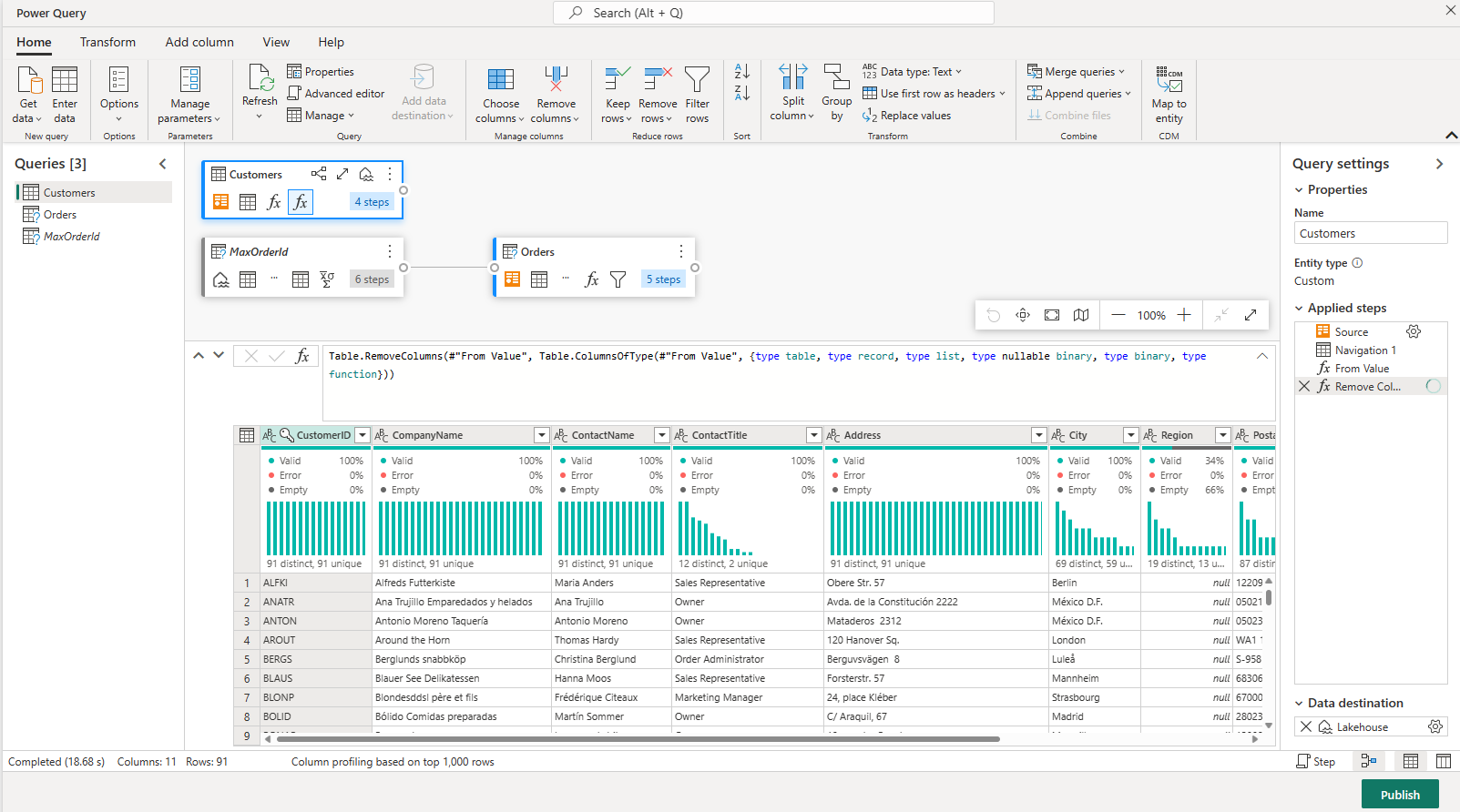

Datadestinationer

På samme måde som med Dataflow Gen1 giver Dataflow Gen2 dig mulighed for at transformere dine data til dataflowets interne/midlertidige lager, hvor det kan tilgås ved hjælp af dataflowconnectoren. Med Dataflow Gen2 kan du også angive en datadestination for dine data. Ved hjælp af denne funktion kan du nu adskille dit ETL-logik og destinationslager. Denne funktion er en fordel for dig på mange måder. Du kan f.eks. nu bruge et dataflow til at indlæse data i et lakehouse og derefter bruge en notesbog til at analysere dataene. Du kan også bruge et dataflow til at indlæse data i en Azure SQL-database og derefter bruge en datapipeline til at indlæse dataene i et data warehouse.

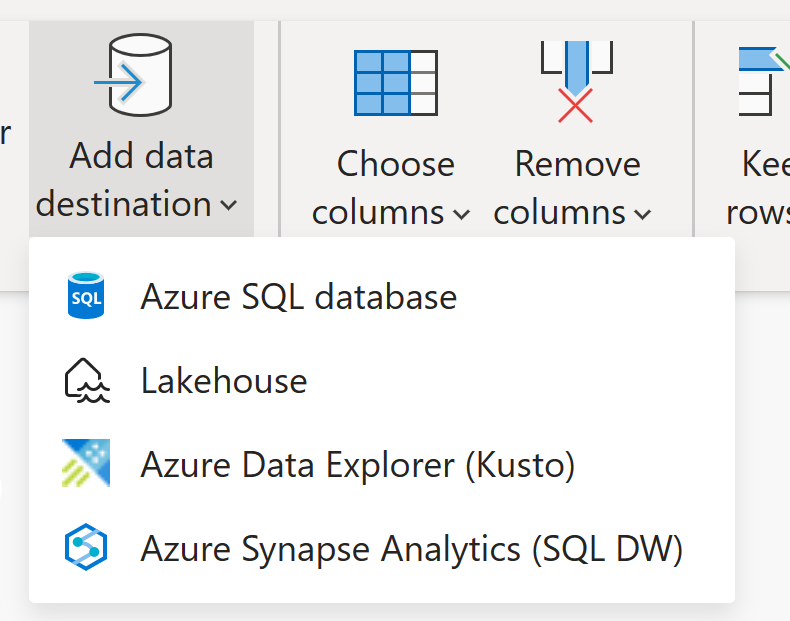

I Dataflow Gen2 har vi tilføjet understøttelse af følgende destinationer, og der kommer snart mange flere:

- Fabric Lakehouse

- Azure Data Explorer (Kusto)

- Azure Synapse Analytics (SQL DW)

- Azure SQL Database

Seddel

Hvis du vil indlæse dine data i Fabric Warehouse, kan du bruge Sql DW-connectoren (Azure Synapse Analytics) ved at hente SQL-forbindelsesstrengen. Flere oplysninger: Forbindelse til datawarehousing i Microsoft Fabric

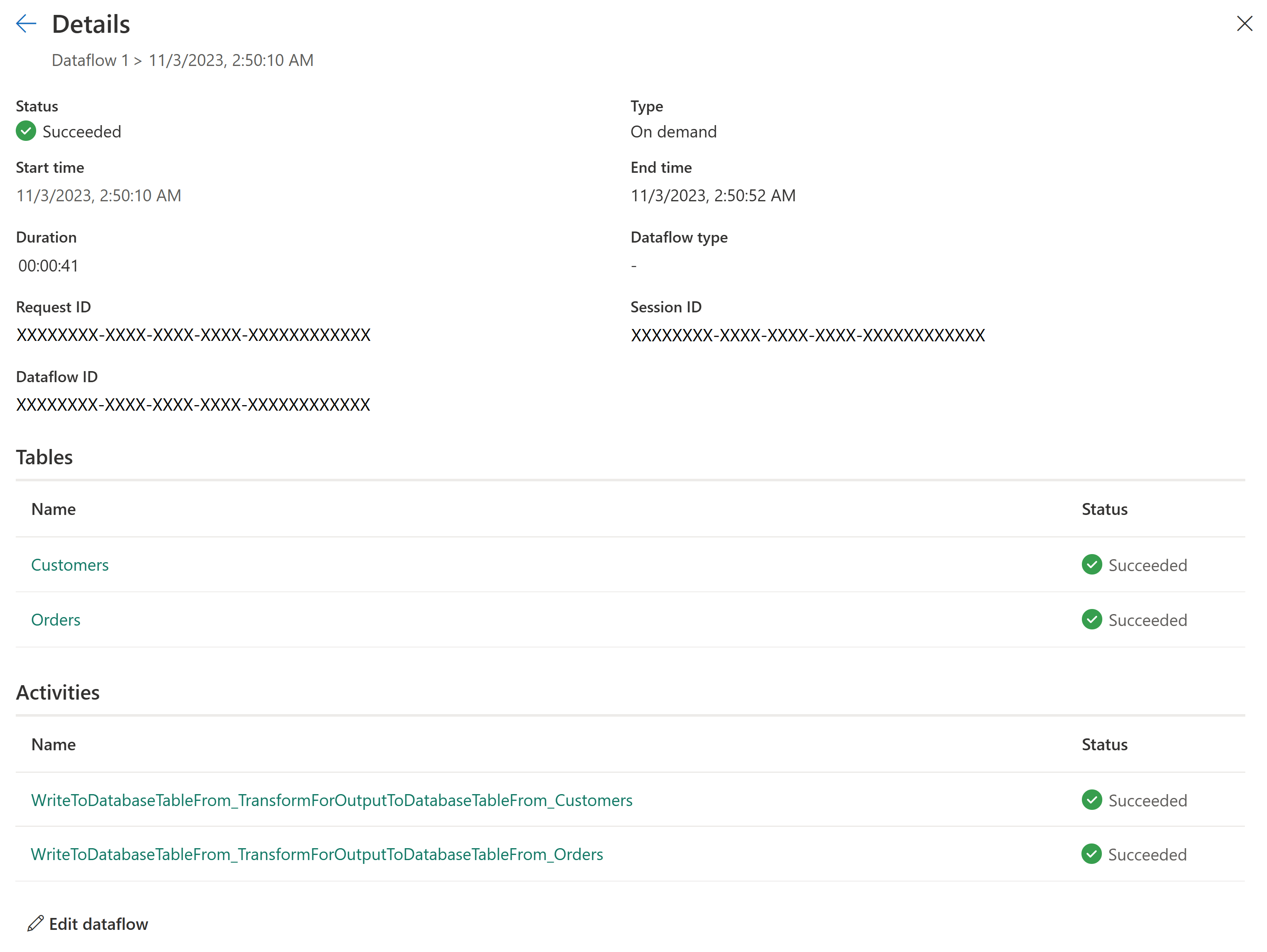

Ny opdateringshistorik og overvågning

Med Dataflow Gen2 introducerer vi en ny måde, hvorpå du kan overvåge dine dataflowopdateringer. Vi integrerer understøttelse af Overvågningshub- og giver vores Opdateringshistorik en større opgradering.

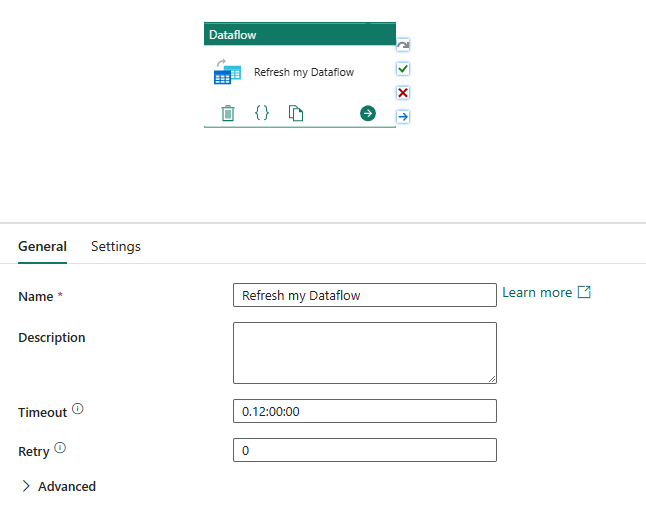

Integration med datapipelines

Med datapipelines kan du gruppere aktiviteter, der tilsammen udfører en opgave. En aktivitet er en arbejdsenhed, der kan udføres. En aktivitet kan f.eks. kopiere data fra én placering til en anden, køre en SQL-forespørgsel, udføre en lagret procedure eller køre en Python-notesbog.

En pipeline kan indeholde en eller flere aktiviteter, der er forbundet af afhængigheder. Du kan f.eks. bruge en pipeline til at indtage og rense data fra en Azure-blob og derefter starte et Dataflow Gen2 for at analysere logdataene. Du kan også bruge en pipeline til at kopiere data fra en Azure-blob til en Azure SQL-database og derefter køre en lagret procedure på databasen.

Gem som kladde

Med Dataflow Gen2 introducerer vi en problemfri oplevelse ved at fjerne behovet for publicering for at gemme dine ændringer. Med funktionen Gem som kladde gemmer vi en kladdeversion af dit dataflow, hver gang du foretager en ændring. Har du mistet forbindelsen til internettet? Har du ved et uheld lukket din browser? Ingen bekymringer; Vi passer på dig. Når du vender tilbage til dit dataflow, er dine seneste ændringer stadig der, og du kan fortsætte, hvor du slap. Dette er en problemfri oplevelse og kræver ikke input fra dig. Dette giver dig mulighed for at arbejde på dit dataflow uden at skulle bekymre dig om at miste dine ændringer eller at skulle rette alle forespørgselsfejlene, før du kan gemme dine ændringer. Hvis du vil vide mere om denne funktion, skal du gå til Gem en kladde af dit dataflow.

Beregning i høj skala

På samme måde som med Dataflow Gen1 har Dataflow Gen2 også et forbedret beregningsprogram til at forbedre ydeevnen af begge transformationer af refererede forespørgsler og hente datascenarier. For at opnå dette opretter Dataflow Gen2 både Lakehouse- og Warehouse-elementer i dit arbejdsområde og bruger dem til at gemme og få adgang til data for at forbedre ydeevnen for alle dine dataflow.

Licensering af dataflow Gen1 vs. Gen2

Dataflow Gen2 er den nye generation af dataflow, der er placeret sammen med Power BI-dataflowet (Gen1) og giver nye funktioner og forbedrede oplevelser. Det kræver en Fabric-kapacitet eller en Fabric-prøveversionskapacitet. Du kan få en bedre forståelse af, hvordan licenser fungerer for dataflow, ved at læse følgende artikel: Microsoft Fabric-begreber og -licenser

Prøv Dataflow Gen2 ved at genbruge dine forespørgsler fra Dataflow Gen1

Du har sandsynligvis mange Dataflow Gen1-forespørgsler, og du undrer dig over, hvordan du kan prøve dem i Dataflow Gen2. Vi har et par muligheder for at genskabe dine Gen1-dataflow som Dataflow Gen2.

Eksportér dine Dataflow Gen1-forespørgsler, og importér dem til Dataflow Gen2

Du kan nu eksportere forespørgsler i både oprettelsesoplevelsen Dataflow Gen1 og Gen2 og gemme dem i en PQT-fil, som du derefter kan importere til Dataflow Gen2. Du kan finde flere oplysninger ved at gå til Brug funktionen eksportskabelon.

Kopiér og indsæt i Power Query

Hvis du har et dataflow i Power BI eller Power Apps, kan du kopiere dine forespørgsler og indsætte dem i editoren for dit Dataflow Gen2. Denne funktionalitet giver dig mulighed for at overføre dit dataflow til Gen2 uden at skulle omskrive dine forespørgsler. Du kan få flere oplysninger ved at gå til Kopiér og indsæt eksisterende Dataflow Gen1-forespørgsler.