Začínáme používat data DICOM v analytických úlohách

Tento článek popisuje, jak začít používat data DICOM® v analytických úlohách se službou Azure Data Factory a Microsoft Fabric.

Požadavky

Než začnete, proveďte tyto kroky:

- Vytvoření účtu úložiště s funkcemi Azure Data Lake Storage Gen2 povolením hierarchického oboru názvů:

- Vytvořte kontejner pro ukládání metadat DICOM, například s názvem

dicom.

- Vytvořte kontejner pro ukládání metadat DICOM, například s názvem

- Nasaďte instanci služby DICOM.

- (Volitelné) Nasaďte službu DICOM se službou Data Lake Storage , abyste umožnili přímý přístup k souborům DICOM.

- Vytvoření instance služby Data Factory :

- Povolte spravovanou identitu přiřazenou systémem.

- Vytvořte v fabrice jezero .

- Přidejte přiřazení rolí ke spravované identitě přiřazené systémem služby DATA Factory pro službu DICOM a účet úložiště Data Lake Storage Gen2:

- Přidejte roli Čtenář dat DICOM pro udělení oprávnění ke službě DICOM.

- Přidejte roli Přispěvatel dat v objektu blob služby Storage, která udělí oprávnění k účtu Data Lake Storage Gen2.

Konfigurace kanálu Data Factory pro službu DICOM

V tomto příkladu se kanál Data Factory používá k zápisu atributů DICOM pro instance, řady a studie do účtu úložiště ve formátu tabulky Delta.

Na webu Azure Portal otevřete instanci služby Data Factory a začněte tím, že vyberete Spustit studio .

Vytvoření propojených služeb

Kanály služby Data Factory čtou ze zdrojů dat a zapisují se do jímek dat, což jsou obvykle jiné služby Azure. Tato připojení k jiným službám se spravují jako propojené služby.

Kanál v tomto příkladu čte data ze služby DICOM a zapisuje svůj výstup do účtu úložiště, takže propojená služba musí být vytvořena pro oba.

Vytvoření propojené služby pro službu DICOM

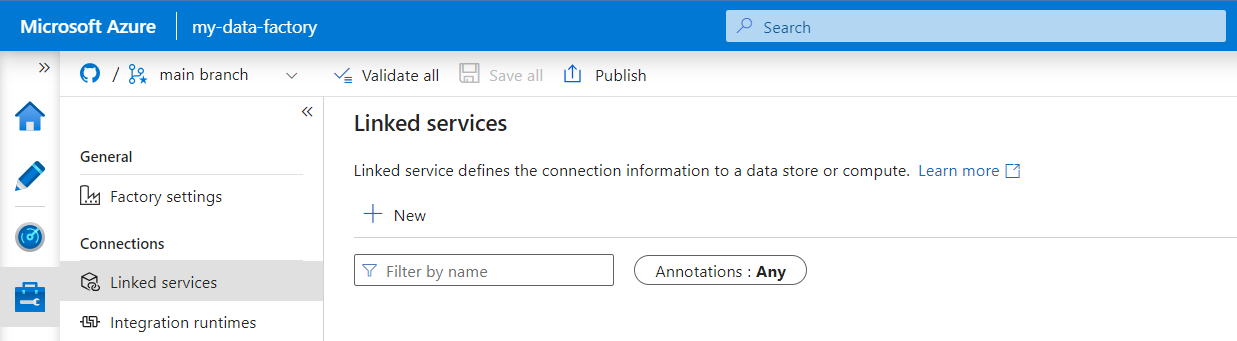

V nástroji Azure Data Factory Studio v nabídce vlevo vyberte Spravovat . V části Připojení vyberte Propojené služby a pak vyberte Nový.

V podokně Nová propojená služba vyhledejte REST. Vyberte dlaždici REST a pak vyberte Pokračovat.

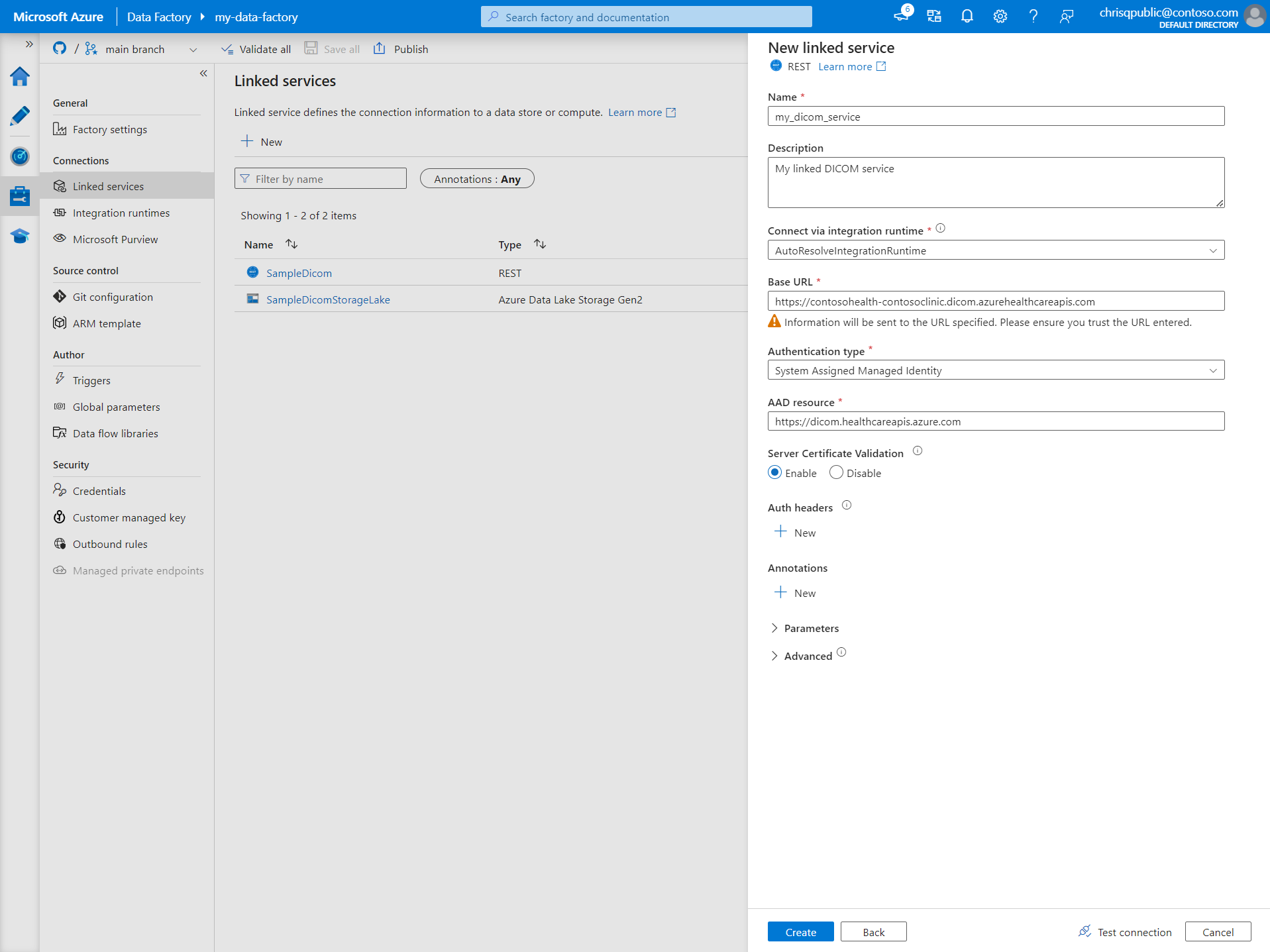

Zadejte název a popis propojené služby.

Do pole Základní adresa URL zadejte adresu URL služby pro vaši službu DICOM. Například služba DICOM pojmenovaná

contosoclinicvcontosohealthpracovním prostoru má adresu URLhttps://contosohealth-contosoclinic.dicom.azurehealthcareapis.comslužby .Jako typ ověřování vyberte spravovanou identitu přiřazenou systémem.

Jako prostředek AAD zadejte

https://dicom.healthcareapis.azure.com. Tato adresa URL je stejná pro všechny instance služby DICOM.Po vyplnění požadovaných polí vyberte Test připojení , abyste měli jistotu, že jsou role identity správně nakonfigurované.

Po úspěšném testu připojení vyberte Vytvořit.

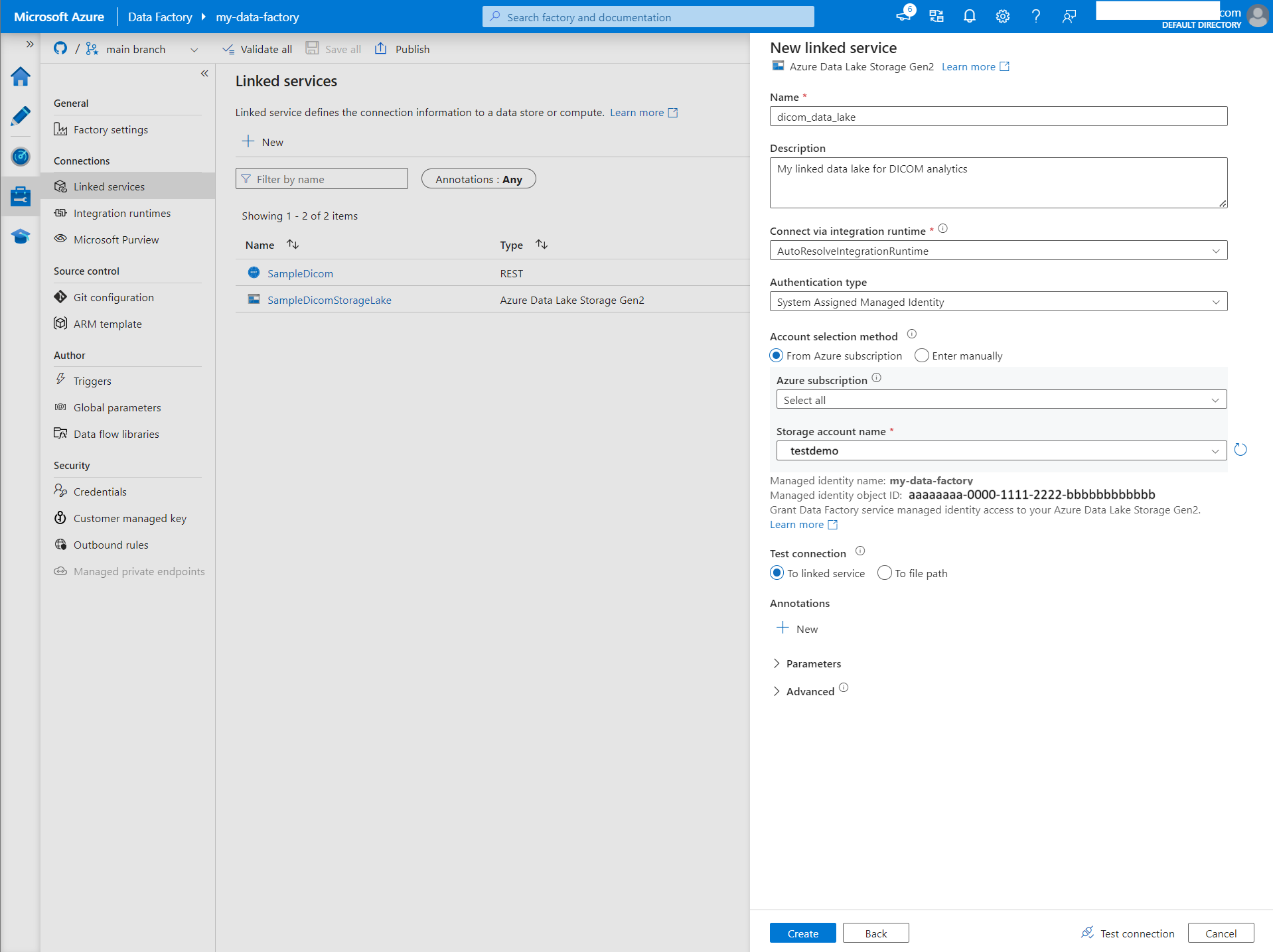

Vytvoření propojené služby pro Azure Data Lake Storage Gen2

V nástroji Data Factory Studio v nabídce vlevo vyberte Spravovat . V části Připojení vyberte Propojené služby a pak vyberte Nový.

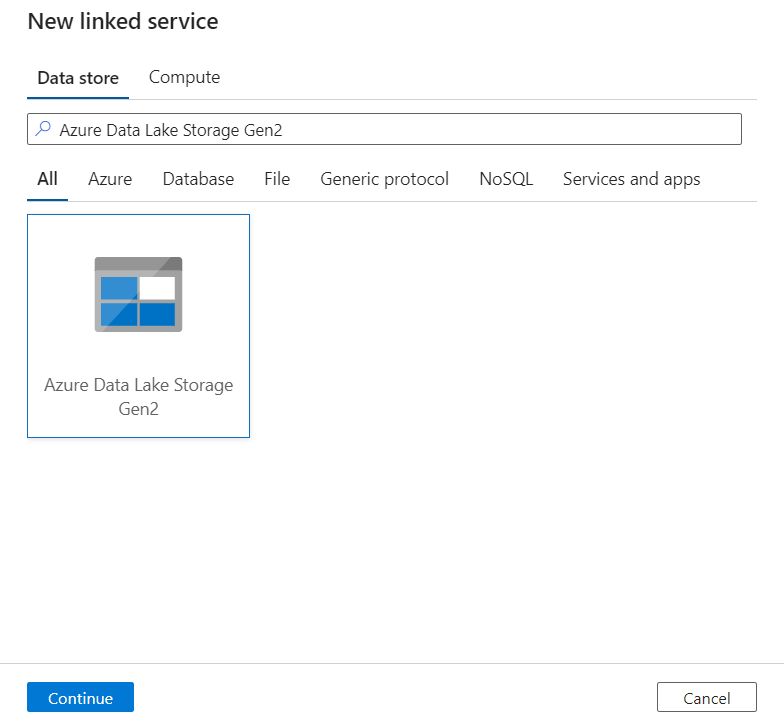

V podokně Nová propojená služba vyhledejte Azure Data Lake Storage Gen2. Vyberte dlaždici Azure Data Lake Storage Gen2 a pak vyberte Pokračovat.

Zadejte název a popis propojené služby.

Jako typ ověřování vyberte spravovanou identitu přiřazenou systémem.

Zadejte podrobnosti účtu úložiště tak, že zadáte adresu URL účtu úložiště ručně. V rozevíracích sadě můžete také vybrat předplatné Azure a účet úložiště.

Po vyplnění požadovaných polí vyberte Test připojení , abyste měli jistotu, že jsou role identity správně nakonfigurované.

Po úspěšném testu připojení vyberte Vytvořit.

Vytvoření kanálu pro data DICOM

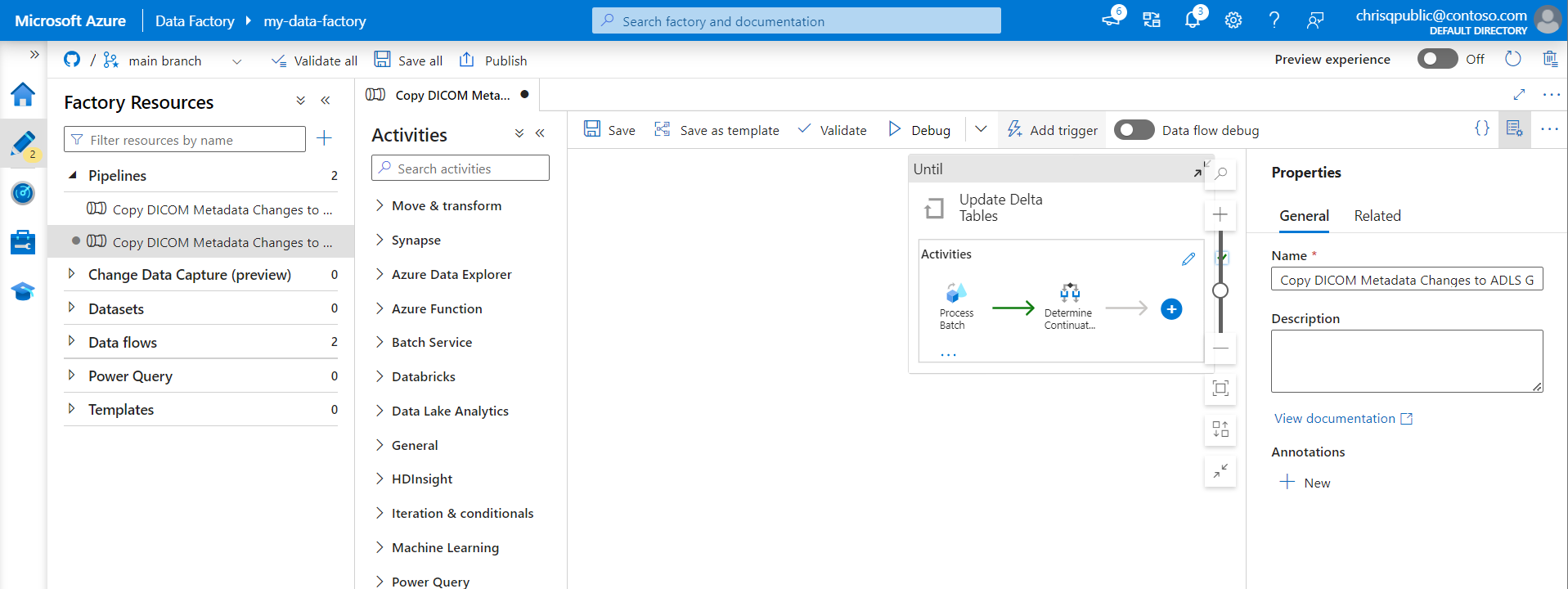

Kanály služby Data Factory jsou kolekce aktivit , které provádějí úlohu, jako je kopírování metadat DICOM do tabulek Delta. Tato část podrobně popisuje vytvoření kanálu, který pravidelně synchronizuje data DICOM s tabulkami Delta při přidávání, aktualizaci a odstranění ze služby DICOM.

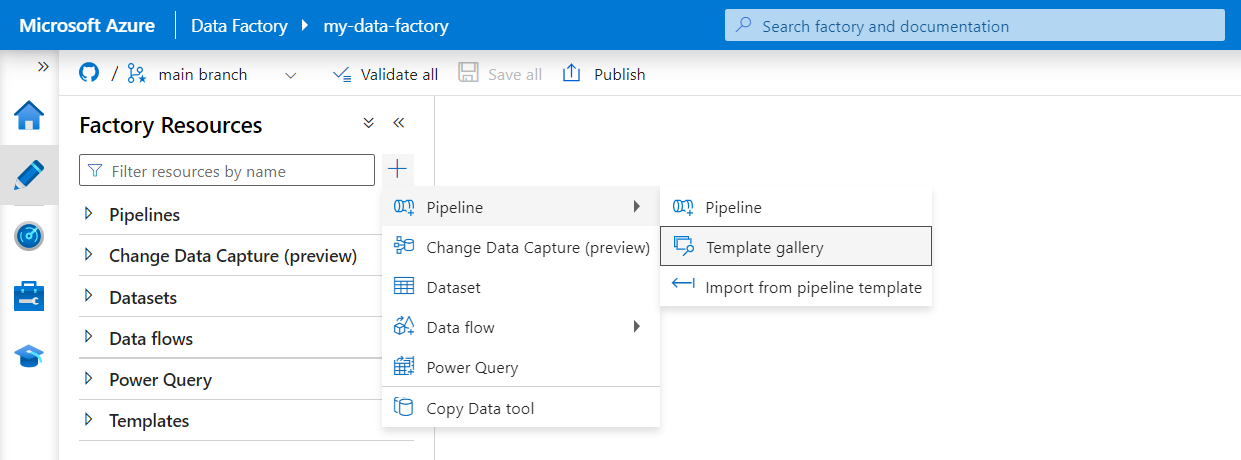

V nabídce vlevo vyberte Vytvořit . V podokně Prostředky továrny vyberte znaménko plus (+) a přidejte nový prostředek. Vyberte Kanál a pak v nabídce vyberte Galerii šablon.

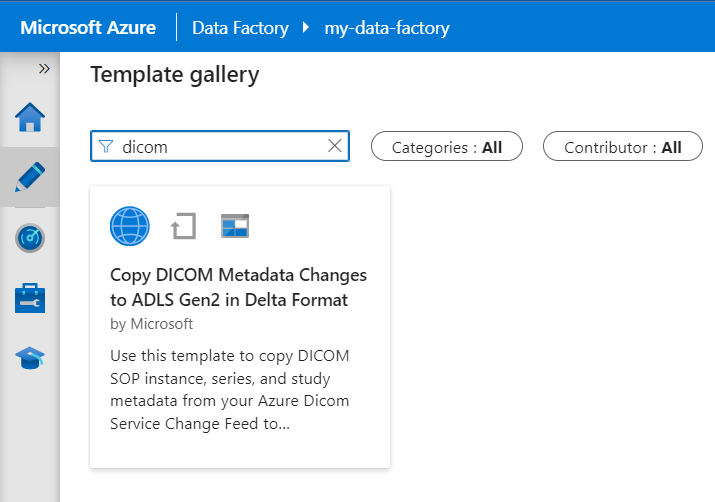

V galerii šablon vyhledejte DICOM. Vyberte dlaždici Kopírovat změny metadat DICOM v ADLS Gen2 a pak vyberte Pokračovat.

V části Vstupy vyberte dříve vytvořené propojené služby pro službu DICOM a účet Data Lake Storage Gen2.

Vyberte Použít tuto šablonu k vytvoření nového kanálu.

Vytvoření kanálu pro data DICOM

Pokud jste vytvořili službu DICOM se službou Azure Data Lake Storage místo použití šablony z galerie šablon, musíte k zahrnutí nového fileName parametru do kanálu metadat použít vlastní šablonu. Chcete-li nakonfigurovat kanál, postupujte podle těchto kroků.

Stáhněte si šablonu z GitHubu. Soubor šablony je komprimovaná (komprimovaná) složka. Soubory nemusíte extrahovat, protože jsou už nahrané v komprimovaném formátu.

V Azure Data Factory vyberte v nabídce vlevo možnost Vytvořit . V podokně Prostředky továrny vyberte znaménko plus (+) a přidejte nový prostředek. Vyberte Kanál a pak vyberte Importovat ze šablony kanálu.

V okně Otevřít vyberte šablonu, kterou jste stáhli. Vyberte Otevřít.

V části Vstupy vyberte propojené služby vytvořené pro službu DICOM a účet Azure Data Lake Storage Gen2.

Vyberte Použít tuto šablonu k vytvoření nového kanálu.

Naplánování kanálu

Kanály jsou naplánované aktivačními událostmi. Existují různé typy triggerů. Aktivační události plánu umožňují, aby se kanály aktivovaly v určitých časech dne, například každou hodinu nebo každý den o půlnoci. Ruční triggery aktivují kanály na vyžádání, což znamená, že se spouštějí vždy, když je chcete.

V tomto příkladu se trigger přeskakujícího okna používá k pravidelnému spuštění kanálu s daným výchozím bodem a pravidelným časovým intervalem. Další informace o triggerech najdete v tématu Spouštění kanálů a triggery ve službě Azure Data Factory nebo Azure Synapse Analytics.

Vytvoření nové aktivační události pro přeskakující okno

V nabídce vlevo vyberte Vytvořit . Vyberte kanál pro službu DICOM a v řádku nabídek vyberte Přidat trigger a Nový/Upravit .

V podokně Přidat triggery vyberte rozevírací seznam Zvolit aktivační událost a pak vyberte Nový.

Zadejte název a popis aktivační události.

Jako typ vyberte přeskakující okno.

Pokud chcete nakonfigurovat kanál, který běží každou hodinu, nastavte opakování na 1 hodinu.

Rozbalte část Upřesnit a zadejte zpoždění15 minut. Toto nastavení umožňuje dokončení všech čekajících operací na konci hodiny před zpracováním.

Nastavte maximální souběžnost na 1 , abyste zajistili konzistenci napříč tabulkami.

Pokud chcete pokračovat v konfiguraci parametrů spuštění triggeru, vyberte OK .

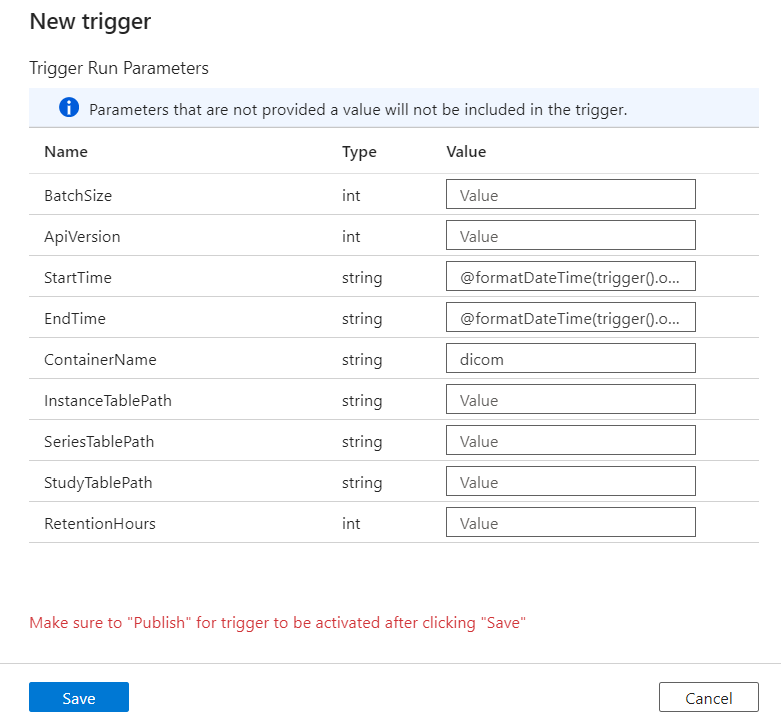

Konfigurace parametrů spuštění triggeru

Triggery definují, kdy se kanál spustí. Zahrnují také parametry , které jsou předány ke spuštění kanálu. Funkce Copy DICOM Metadata Changes to Delta template definuje parametry popsané v následující tabulce. Pokud během konfigurace není zadána žádná hodnota, použije se pro každý parametr uvedená výchozí hodnota.

| Název parametru | Popis | Default value |

|---|---|---|

| BatchSize | Maximální počet změn, které se mají načíst najednou z kanálu změn (maximálně 200) | 200 |

| ApiVersion | Verze rozhraní API pro službu Azure DICOM (minimálně 2) | 2 |

| Počáteční čas | Inkluzivní počáteční čas pro změny DICOM | 0001-01-01T00:00:00Z |

| EndTime | Exkluzivní koncový čas pro změny DICOM | 9999-12-31T23:59:59Z |

| ContainerName | Název kontejneru pro výsledné tabulky Delta | dicom |

| InstanceTablePath | Cesta, která obsahuje tabulku Delta pro instance DICOM SOP v rámci kontejneru | instance |

| SeriesTablePath | Cesta, která obsahuje tabulku Delta pro řadu DICOM v rámci kontejneru | series |

| StudyTablePath | Cesta, která obsahuje tabulku Delta pro studie DICOM v rámci kontejneru | study |

| Doba uchování | Maximální doba uchovávání dat v tabulkách Delta v hodinách | 720 |

V podokně Parametry spuštění triggeru zadejte hodnotu ContainerName , která odpovídá názvu kontejneru úložiště vytvořeného v požadavcích.

Pro StartTime použijte systémovou proměnnou

@formatDateTime(trigger().outputs.windowStartTime).Pro EndTime použijte systémovou proměnnou

@formatDateTime(trigger().outputs.windowEndTime).Poznámka:

Systémové proměnné podporují pouze triggery pro přeskakující okno:

-

@trigger().outputs.windowStartTimea -

@trigger().outputs.windowEndTime.

Aktivační události plánu používají různé systémové proměnné:

-

@trigger().scheduledTimea -

@trigger().startTime.

Přečtěte si další informace o typech triggerů.

-

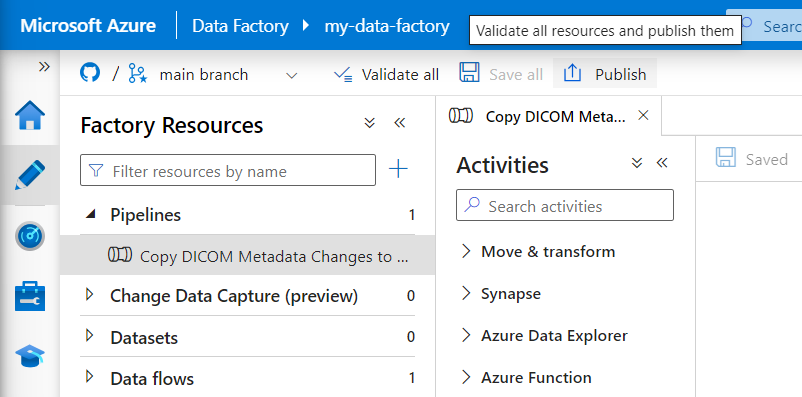

Výběrem možnosti Uložit vytvořte novou aktivační událost. Výběrem možnosti Publikovat zahájíte spouštění triggeru podle definovaného plánu.

Po publikování triggeru ji můžete aktivovat ručně pomocí možnosti Aktivační událost. Pokud byl čas spuštění nastaven pro hodnotu v minulosti, kanál se spustí okamžitě.

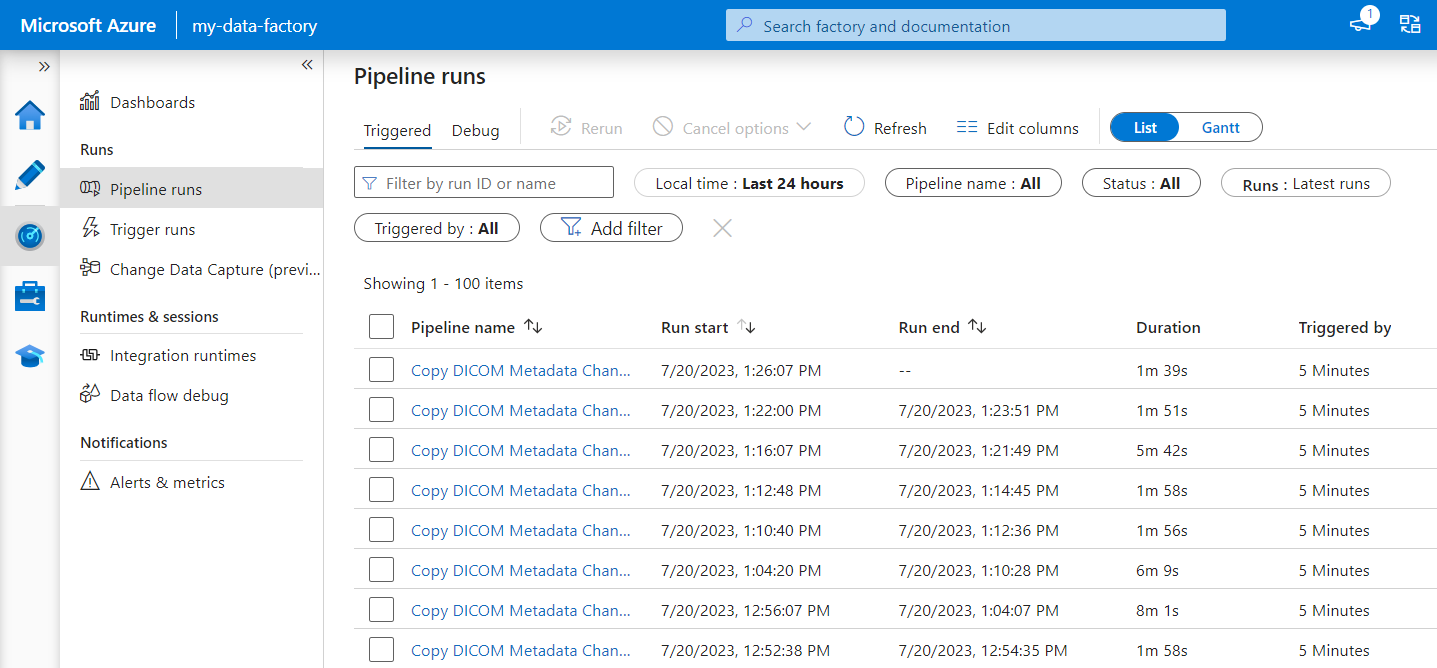

Monitorování spuštění kanálu

Aktivovaná spuštění můžete monitorovat a jejich přidružené spuštění kanálu na kartě Monitorování . Tady můžete procházet, kdy každý kanál běžel a jak dlouho trvalo jeho spuštění. Můžete také potenciálně ladit všechny problémy, které vznikly.

Microsoft Fabric

Fabric je analytické řešení typu all-in-one, které je nad Microsoft OneLake. Při použití objektu Fabric Lakehouse můžete spravovat, strukturovat a analyzovat data ve OneLake v jednom umístění. Všechna data mimo OneLake, zapsaná do Data Lake Storage Gen2, se dají připojit k OneLake pomocí klávesových zkratek a využít tak sadu nástrojů Fabric.

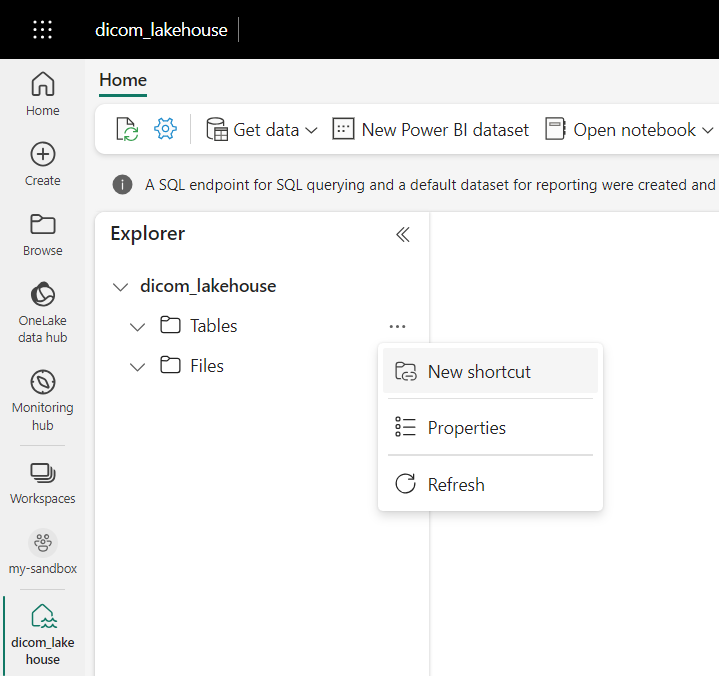

Vytváření zástupců tabulek metadat

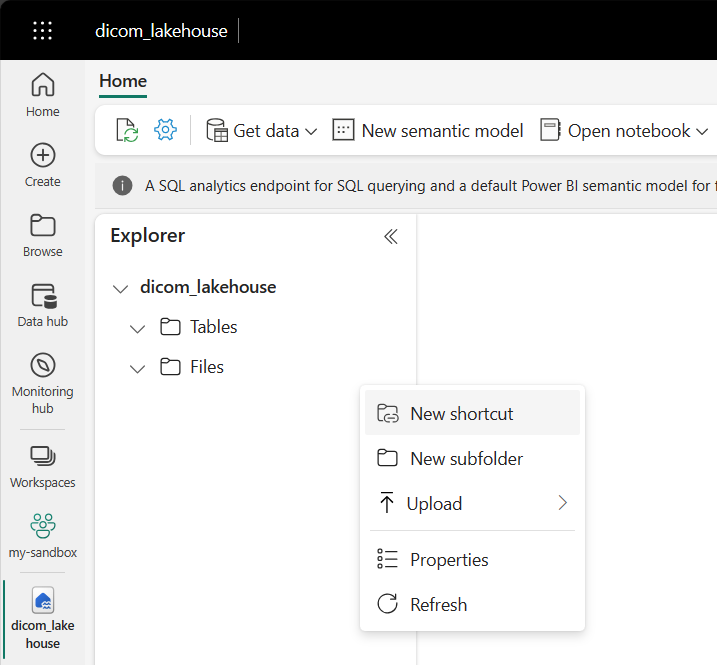

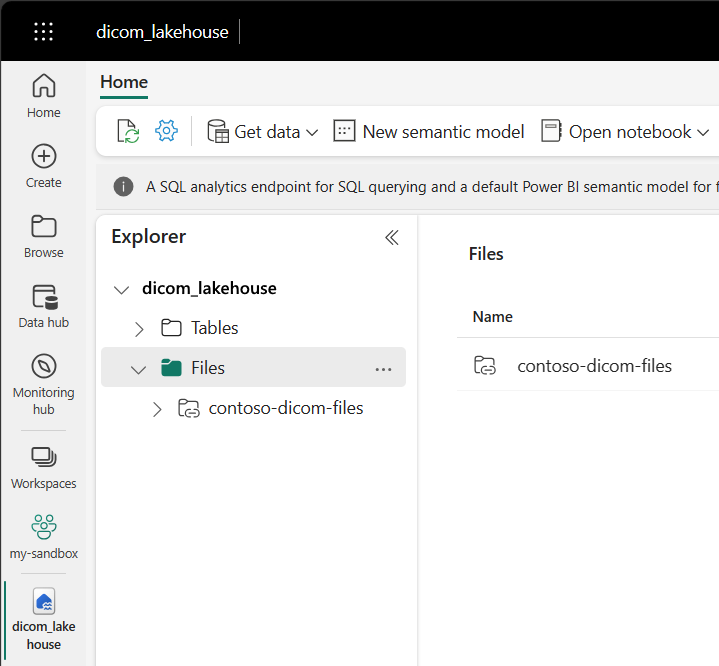

Přejděte do jezera vytvořeného v požadavcích. V zobrazení Průzkumníka vyberte nabídku se třemi tečkou (...) vedle složky Tabulky.

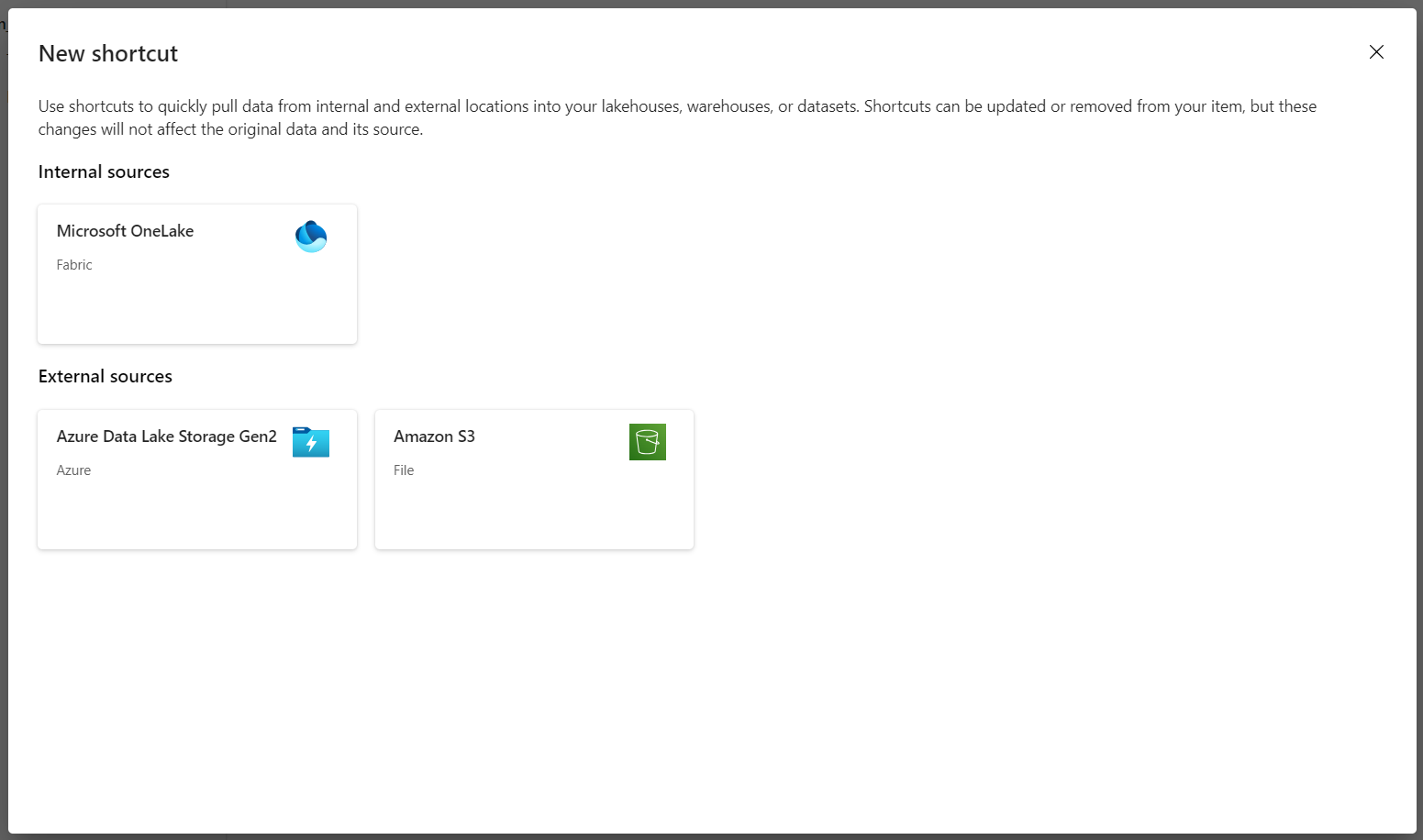

Výběrem možnosti Nový zástupce vytvořte nový zástupce účtu úložiště, který obsahuje analytická data DICOM.

Jako zdroj zástupce vyberte Azure Data Lake Storage Gen2 .

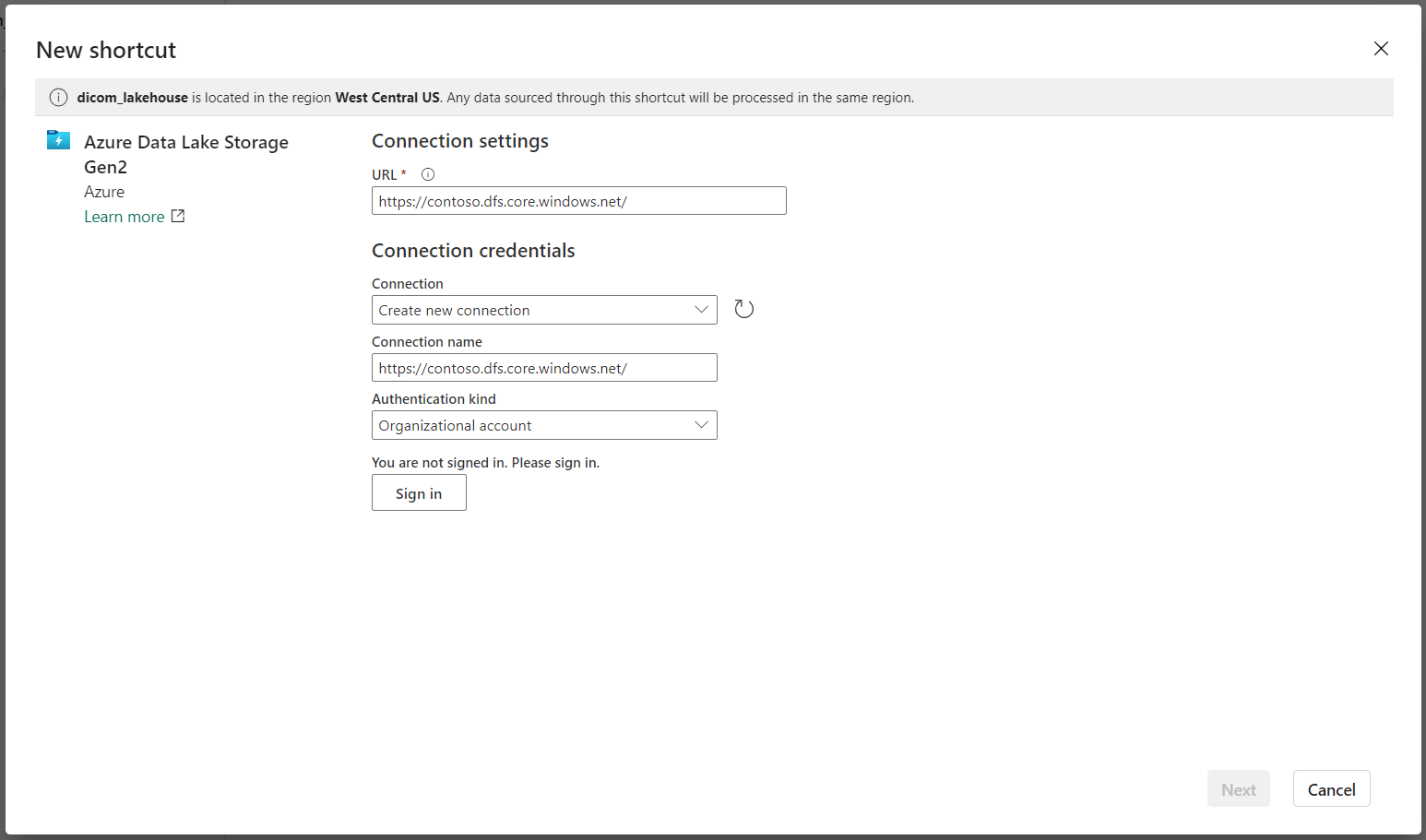

V části Nastavení připojení zadejte adresu URL , kterou jste použili v části Propojené služby .

Vyberte existující připojení nebo vytvořte nové připojení tak , že vyberete typ ověřování, který chcete použít.

Poznámka:

Existuje několik možností ověřování mezi Data Lake Storage Gen2 a Fabric. Můžete použít účet organizace nebo instanční objekt. Nedoporučujeme používat klíče účtu ani tokeny sdíleného přístupového podpisu.

Vyberte Další.

Zadejte název zástupce, který představuje data vytvořená kanálem služby Data Factory. Například pro

instancetabulku Delta by měl být název zástupce pravděpodobně instance.Zadejte dílčí cestu, která odpovídá parametru

ContainerNamez konfigurace parametrů spuštění a název tabulky zástupce. Například pro/dicom/instancetabulku Delta s cestouinstancev kontejnerudicom.Výběrem možnosti Vytvořit vytvořte zástupce.

Opakováním kroků 2 až 9 přidejte zbývající zástupce do ostatních tabulek Delta v účtu úložiště (například

seriesastudy).

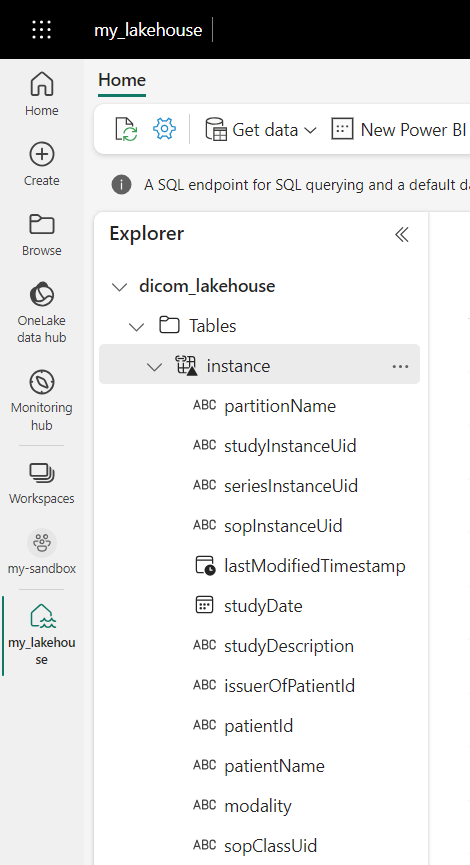

Po vytvoření zástupců rozbalte tabulku a zobrazte názvy a typy sloupců.

Vytváření zástupců souborů

Pokud používáte službu DICOM se službou Data Lake Storage, můžete také vytvořit zástupce dat souboru DICOM uložených v datovém jezeře.

Přejděte do jezera vytvořeného v požadavcích. V zobrazení Průzkumníka vyberte nabídku se třemi tečky (...) vedle složky Soubory.

Výběrem možnosti Nový zástupce vytvořte nového zástupce účtu úložiště, který obsahuje data DICOM.

Jako zdroj zástupce vyberte Azure Data Lake Storage Gen2 .

V části Nastavení připojení zadejte adresu URL , kterou jste použili v části Propojené služby .

Vyberte existující připojení nebo vytvořte nové připojení tak , že vyberete typ ověřování, který chcete použít.

Vyberte Další.

Zadejte název zástupce, který popisuje data DICOM. Například contoso-dicom-files.

Zadejte dílčí cestu, která odpovídá názvu kontejneru úložiště a složky používané službou DICOM. Pokud byste například chtěli vytvořit odkaz na kořenovou složku, bude podsložka /dicom/AHDS. Kořenová složka je vždy

AHDS, ale volitelně můžete propojit podřízenou složku pro konkrétní pracovní prostor nebo instanci služby DICOM.Výběrem možnosti Vytvořit vytvořte zástupce.

Spouštění poznámkových bloků

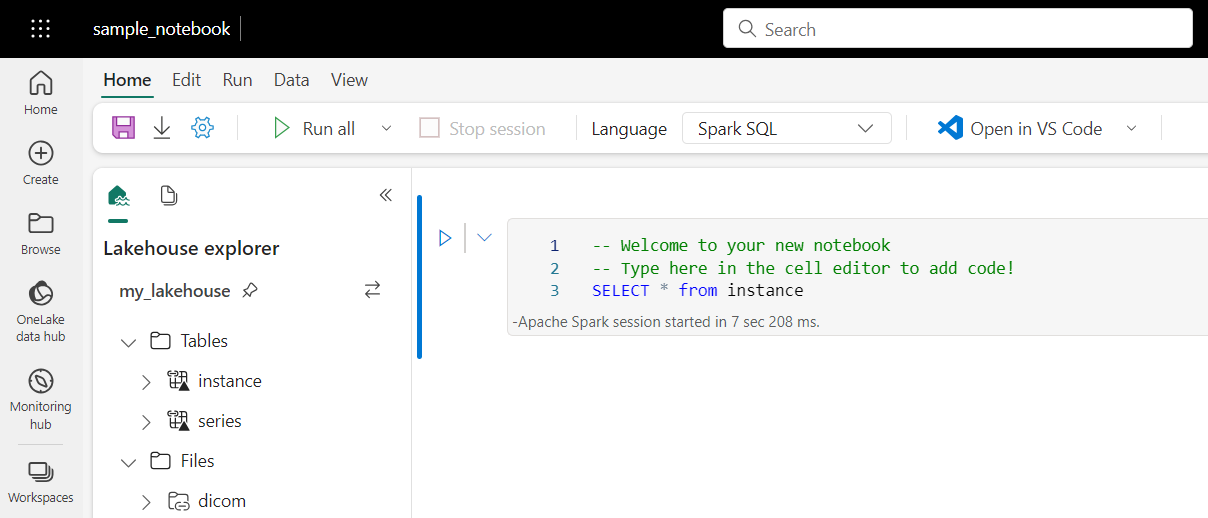

Po vytvoření tabulek v jezeře je můžete dotazovat z poznámkových bloků Fabric. Poznámkové bloky můžete vytvořit přímo z jezera tak, že v řádku nabídek vyberete Otevřít poznámkový blok .

Na stránce poznámkového bloku je možné obsah jezera zobrazit na levé straně včetně nově přidaných tabulek. V horní části stránky vyberte jazyk poznámkového bloku. Jazyk lze také nakonfigurovat pro jednotlivé buňky. Následující příklad používá Spark SQL.

Dotazování tabulek pomocí Spark SQL

V editoru buněk zadejte dotaz Spark SQL jako příkaz SELECT .

SELECT * from instance

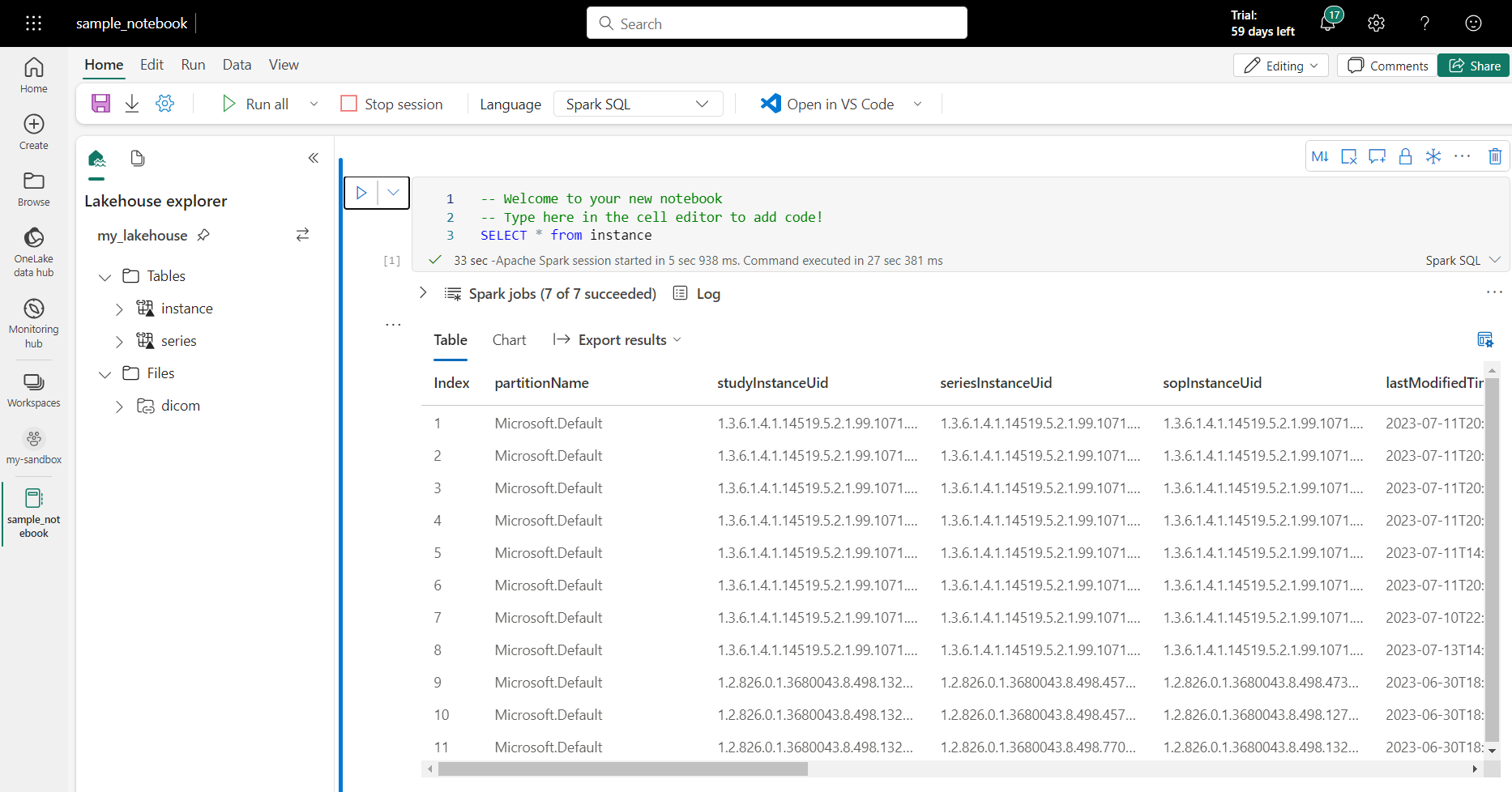

Tento dotaz vybere veškerý obsah tabulky instance . Až budete připraveni, vyberte Spustit buňku a spusťte dotaz.

Po několika sekundách se výsledky dotazu zobrazí v tabulce pod buňkou jako v následujícím příkladu. Čas může být delší, pokud je tento dotaz Sparku první v relaci, protože je potřeba inicializovat kontext Sparku.

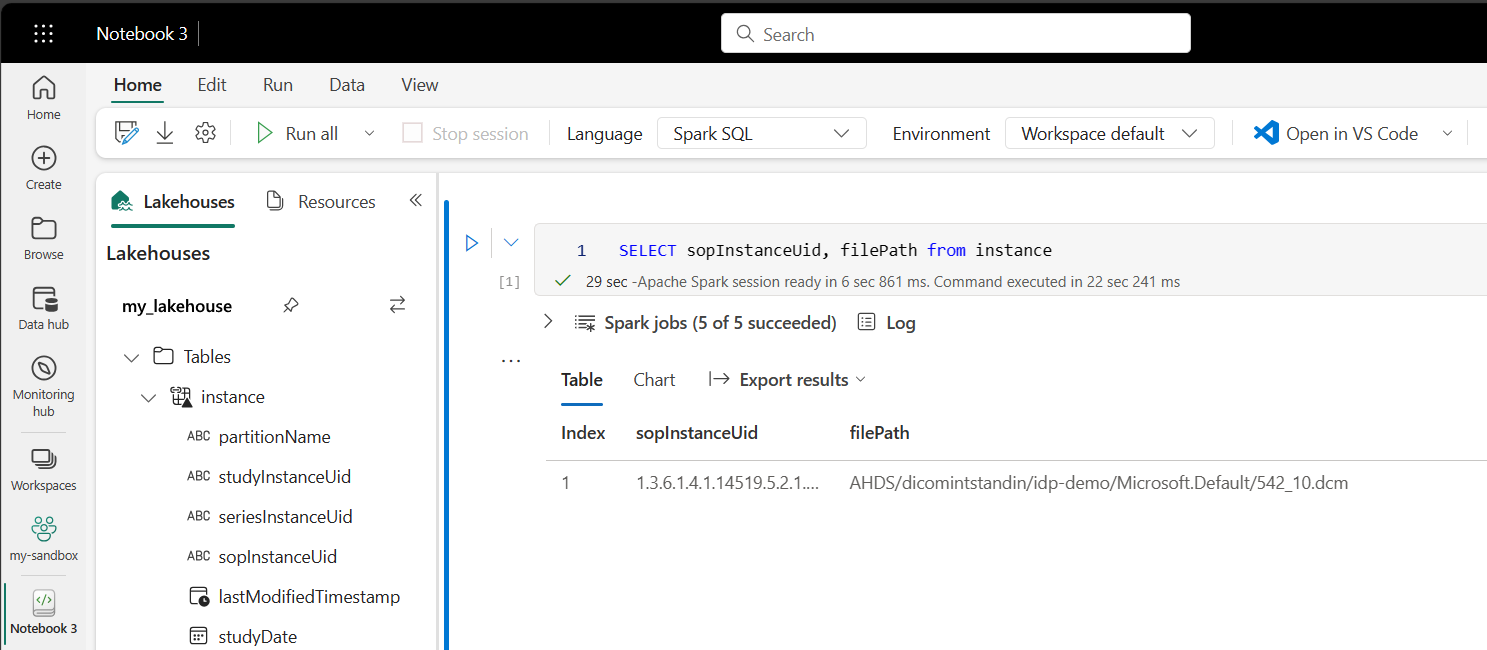

Přístup k datům souboru DICOM v poznámkových blocích

Pokud jste pomocí šablony vytvořili kanál a vytvořili zástupce dat souboru DICOM, můžete pomocí filePath sloupce v instance tabulce korelovat metadata instance s daty souboru.

SELECT sopInstanceUid, filePath from instance

Shrnutí

V tomto článku jste se naučili:

- Pomocí šablon Data Factory vytvořte kanál ze služby DICOM do účtu Data Lake Storage Gen2.

- Nakonfigurujte trigger pro extrakci metadat DICOM podle hodinového plánu.

- Pomocí zástupců připojte data DICOM v účtu úložiště k objektu Fabric Lakehouse.

- Pomocí poznámkových bloků můžete dotazovat data DICOM v jezeře.

Další kroky

Poznámka:

DICOM® je registrovaná ochranná známka asociace National Electrical Manufacturers Association pro publikace standardů týkající se digitální komunikace s lékařskými informacemi.