Vyhodnocení aplikací generativní AI

Důležité

Položky označené (Preview) v tomto článku jsou aktuálně ve verzi Public Preview. Tato verze Preview je poskytována bez smlouvy o úrovni služeb a nedoporučujeme ji pro produkční úlohy. Některé funkce se nemusí podporovat nebo mohou mít omezené možnosti. Další informace najdete v dodatečných podmínkách použití pro verze Preview v Microsoft Azure.

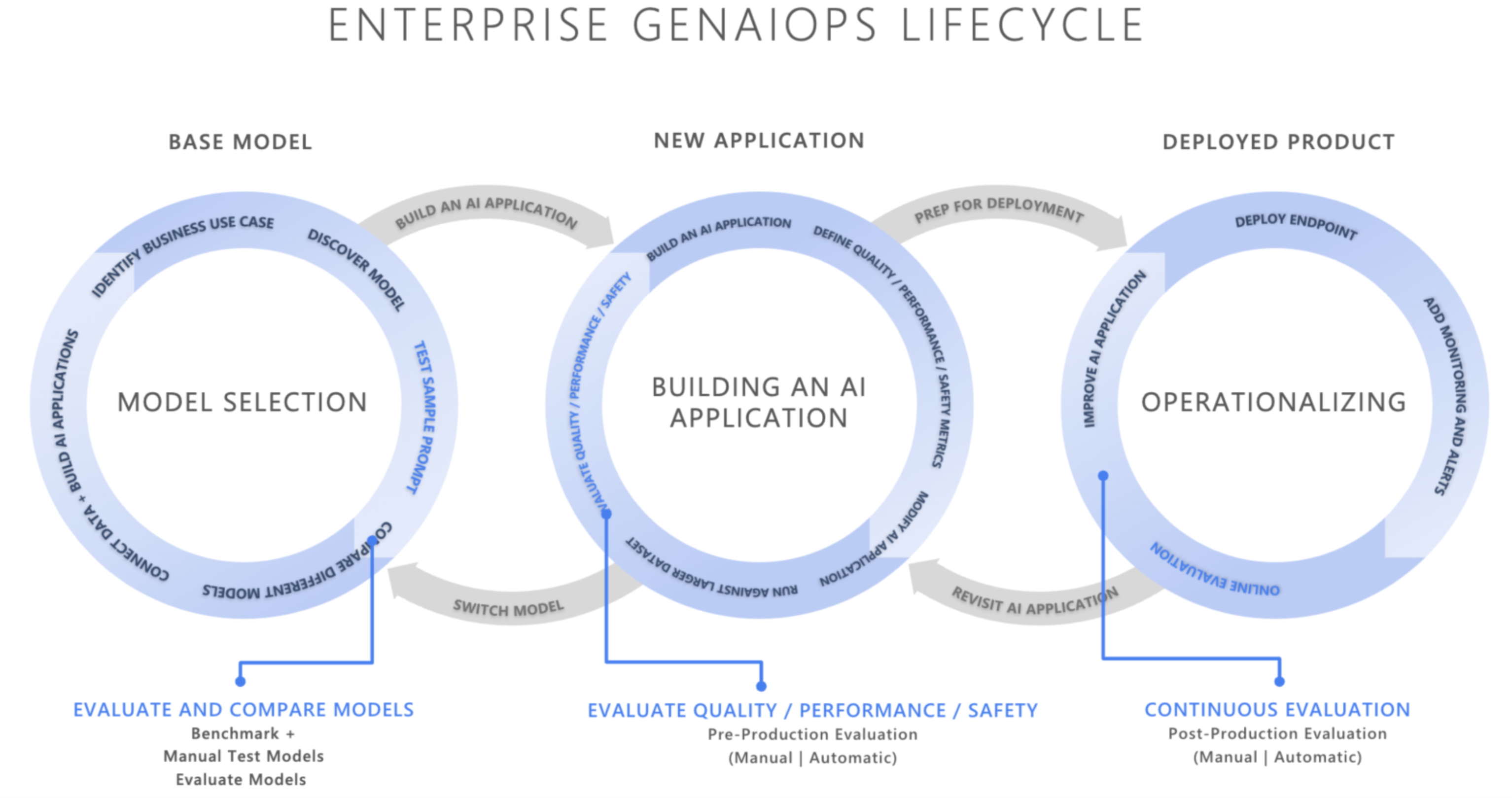

V rychle se vyvíjejícím prostředí umělé inteligence transformuje integrace operací Generative AI (GenAIOps) způsob vývoje a nasazování aplikací AI. Vzhledem k tomu, že firmy stále více spoléhají na AI, aby zlepšily rozhodování, zlepšily prostředí zákazníků a řídily inovace, význam robustního vyhodnocovací architektury se nedá přehodnotit. Vyhodnocení je základní součástí životního cyklu generující umělé inteligence pro budování spolehlivosti a důvěryhodnosti v aplikacích orientovaných na AI. Pokud nejsou navrženy pečlivě, mohou tyto aplikace vytvářet výstupy, které jsou vytvořené a neuzemněné v kontextu, irelevantní nebo nekoherentní, což vede k špatným zkušenostem zákazníků, nebo horším, zachování společenských stereotypů, propagaci minformace, zpřístupnění organizacím škodlivým útokům nebo široké škále dalších negativních dopadů.

Vyhodnocovače jsou užitečné nástroje pro posouzení četnosti a závažnosti rizik obsahu nebo nežádoucího chování v odpovědích umělé inteligence. Provádění iterativních, systematických hodnocení se správnými vyhodnocovači může týmům pomoct měřit a řešit potenciální kvalitu reakce, bezpečnost nebo bezpečnostní obavy v průběhu životního cyklu vývoje umělé inteligence od počátečního výběru modelu prostřednictvím monitorování po produkčním prostředí. Vyhodnocení v produkčním prostředí životního cyklu GenAI Ops

Díky pochopení a implementaci efektivních strategií hodnocení v jednotlivých fázích můžou organizace zajistit, aby jejich řešení umělé inteligence nejen splňovala počáteční očekávání, ale také se přizpůsobila a úspěšně v reálném prostředí prospívá. Pojďme se ponořit do toho, jak vyhodnocení zapadá do tří kritických fází životního cyklu AI.

Výběr základního modelu

První fáze životního cyklu AI zahrnuje výběr vhodného základního modelu. Modely generující AI se značně liší z hlediska schopností, silných stránek a omezení, takže je nezbytné určit, který model nejlépe vyhovuje vašemu konkrétnímu případu použití. Při vyhodnocování základního modelu si "prohlédnete" a porovnáte různé modely tím, že otestujete jejich výstupy s sadou kritérií relevantních pro vaši aplikaci.

Mezi klíčové aspekty v této fázi patří:

- Přesnost/kvalita: Jak dobře model generuje relevantní a koherentní odpovědi?

- Výkon u konkrétních úloh: Může model zpracovat typ výzev a obsahu vyžadovaných pro váš případ použití? Jak je její latence a náklady?

- Předsudky a etické aspekty: Vytváří model nějaké výstupy, které by mohly zachovat nebo podporovat škodlivé stereotypy?

- Riziko a bezpečnost: Existují nějaká rizika modelu, který generuje nebezpečný nebo škodlivý obsah?

Můžete prozkoumat srovnávací testyAzure AI Foundry, abyste mohli vyhodnotit a porovnat modely u veřejně dostupných datových sad a současně znovu vygenerovat výsledky srovnávacích testů na vlastních datech. Alternativně můžete vyhodnotit jeden z mnoha základních modelů generování AI prostřednictvím sady Azure AI Evaluation SDK, jak je znázorněno, viz ukázka vyhodnocení koncových bodů modelu.

Předprodukční vyhodnocení

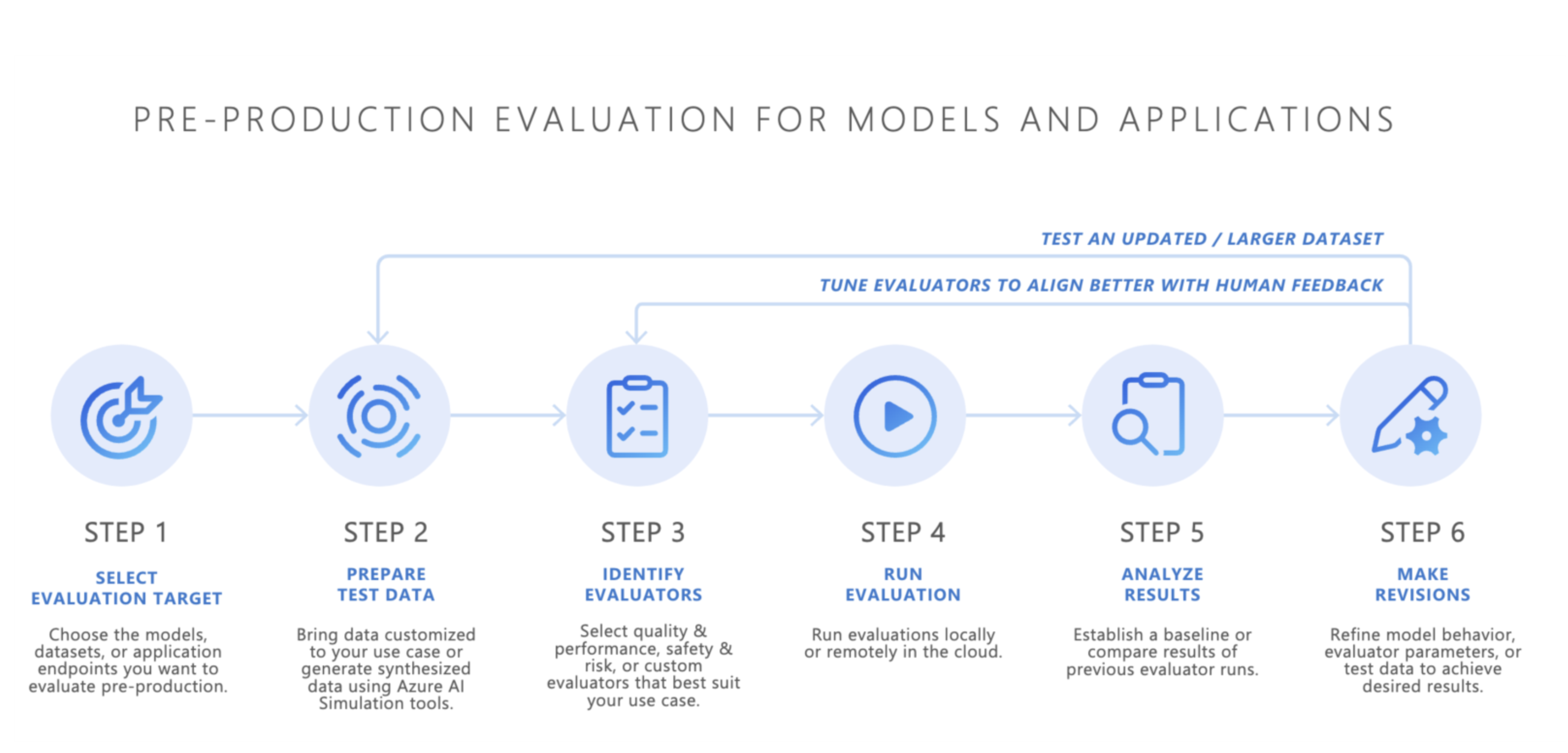

Po výběru základního modelu je dalším krokem vývoj aplikace AI, jako je chatovací robot využívající AI, aplikace rag (retrieval-augmented generation), agentská aplikace AI nebo jakýkoli jiný nástroj generující AI. Po dokončení vývoje začne předběžné vyhodnocení. Před nasazením aplikace v produkčním prostředí je důkladné testování nezbytné k zajištění toho, aby byl model skutečně připravený pro skutečné použití.

Předprodukční vyhodnocení zahrnuje:

- Testování pomocí zkušebních datových sad: Tyto datové sady simulují realistickou interakci uživatelů, aby aplikace AI fungovala podle očekávání.

- Identifikace hraničních případů: Vyhledání scénářů, ve kterých může kvalita odezvy aplikace AI snížit nebo způsobit nežádoucí výstupy.

- Posouzení robustnosti: Zajištění, aby model mohl zpracovávat řadu vstupních variací bez významných poklesů kvality nebo bezpečnosti.

- Měřeníklíčovýchchm metrikám: Metriky, jako je uzemnění odezvy, relevance a bezpečnost, se vyhodnocují, aby se potvrdila připravenost pro produkční prostředí

Předprodukční fáze funguje jako konečná kontrola kvality a snižuje riziko nasazení aplikace AI, která nesplňuje požadované standardy výkonu nebo bezpečnosti.

- Přineste si vlastní data: Aplikace AI můžete vyhodnotit v předprodukčním prostředí pomocí vlastních zkušebních dat s využitím sady Azure AI Foundry nebo podporovaných vyhodnocovačů sady Azure AI Evaluation SDK , včetně kvality generování, bezpečnosti nebo vlastních vyhodnocovačů, a zobrazit výsledky prostřednictvím portálu Azure AI Foundry.

- Simulátory: Pokud nemáte data vyhodnocení (testovací data), můžou simulátory sady AZURE AI Evaluation SDK pomoct generováním dotazů souvisejících s tématy nebo nežádoucími dotazy. Tyto simulátory testují odpověď modelu na odpovídající situace nebo dotazy podobné útoku (hraniční případy).

- Nežádoucí simulátor vloží dotazy, které napodobují potenciální bezpečnostní hrozby nebo se pokusí o jailbreaky, pomáhají identifikovat omezení a připravit model na neočekávané podmínky.

- Kontextové simulátory generují typické relevantní konverzace, které byste od uživatelů očekávali, aby otestovaly kvalitu odpovědí.

Alternativně můžete k testování generovaných aplikací AI použít také widget pro vyhodnocení Azure AI Foundry.

Po dosažení uspokojivých výsledků je možné aplikaci AI nasadit do produkčního prostředí.

Monitorování po produkčním prostředí

Po nasazení aplikace AI přejde do fáze poprodukčního vyhodnocení, která se označuje také jako online vyhodnocení nebo monitorování. V této fázi je model vložený do reálného produktu a reaguje na skutečné dotazy uživatelů. Monitorování zajišťuje, že se model bude chovat podle očekávání a přizpůsobí se všem změnám chování uživatele nebo obsahu.

- Průběžné sledování výkonu: Pravidelné měření odezvy aplikace AI pomocí klíčových metrik za účelem zajištění konzistentní kvality výstupu.

- Reakce na incidenty: Rychlá reakce na škodlivé, nespravedlivé nebo nevhodné výstupy, které mohou vzniknout během skutečného použití.

Nepřetržitým monitorováním chování aplikace AI v produkčním prostředí můžete udržovat vysoce kvalitní uživatelské prostředí a rychle řešit případné problémy, které se týkají.

Závěr

GenAIOps se týká vytvoření spolehlivého a opakovatelného procesu pro správu aplikací generující umělé inteligence v průběhu jejich životního cyklu. Hodnocení hraje zásadní roli v každé fázi, od výběru základního modelu prostřednictvím předprodukčního testování až po průběžné monitorování po produkční prostředí. Díky systémovému měření a řešení rizik a upřesnění systémů AI v každém kroku můžou týmy vytvářet generující řešení AI, která nejsou jen výkonná, ale také důvěryhodná a bezpečná pro skutečné použití.

Tahák:

| Účel | Zpracovat | Parametry |

|---|---|---|

| Co vyhodnocujete? | Identifikace nebo sestavení relevantních vyhodnocovačů |

-

Kvalita a výkon ( poznámkový blok s ukázkou kvality a výkonu) - Zabezpečení a zabezpečení (ukázkový poznámkový blok zabezpečení a zabezpečení) - Vlastní (vlastní ukázkový poznámkový blok) |

| Jaká data byste měli použít? | Nahrání nebo vygenerování relevantní datové sady |

Obecný simulátor pro měření kvality a výkonu (obecný ukázkový poznámkový blok simulátoru) - Nežádoucí simulátor pro měření bezpečnosti a zabezpečení (ukázkový poznámkový blok nežádoucího simulátoru) |

| Jaké zdroje by měly provést vyhodnocení? | Spustit vyhodnocení | – Místní spuštění – Vzdálené spuštění cloudu |

| Jak můj model nebo aplikace fungovaly? | Analýza výsledků | Zobrazení agregačních skóre, zobrazení podrobností, podrobností skóre, porovnání spuštění vyhodnocení |

| Jak můžu zlepšit? | Provádění změn modelu, aplikace nebo vyhodnocovačů | - Pokud výsledky vyhodnocení neodpočídaly lidské zpětné vazby, upravte vyhodnocovače. – Pokud výsledky hodnocení odpovídají lidské zpětné vazbě, ale nesplňují prahové hodnoty kvality a bezpečnosti, použijte cílené zmírnění rizik. |

Související obsah

- Vyhodnocení aplikací generující umělé inteligence prostřednictvím dětského hřiště

- Vyhodnocení generativních aplikací AI pomocí sady Azure AI Foundry SDK nebo portálu

- Vyhodnocení a monitorování metrik pro generování umělé inteligence

- Poznámka k transparentnosti pro vyhodnocení bezpečnosti Azure AI Foundry