將 Apache Kafka 來源新增至事件串流 (預覽)

本文說明如何將 Apache Kafka 來源新增至事件數據流。

Apache Kafka 是開放原始碼分散式平臺,可用於建置可調整的即時數據系統。 藉由將 Apache Kafka 整合到事件數據流中作為來源,您就可以順暢地從 Apache Kafka 引進即時事件,並在路由傳送至 Fabric 內的多個目的地之前加以處理。

注意

工作區容量的下列區域不支援此來源: 美國西部 3、 瑞士西部。

必要條件

- 具有參與者或更高許可權的網狀架構工作區存取權。

- 執行中的 Apache Kafka 叢集。

- 您的 Apache Kafka 必須可公開存取,且不得位於防火牆後方或虛擬網路中受到保護。

注意

一個 Eventstream 的來源和目的地數目上限為 11。

將 Apache Kafka 新增為來源

在 [網狀架構即時智慧] 中,選取 [Eventstream ] 以建立新的事件串流。

在下一個畫面上,選取新增外部來源。

設定並連線至 Apache Kafka

在 [ 選取數據源] 頁面上,選取 [Apache Kafka]。

![此螢幕快照顯示選取 Apache Kafka 作為 [取得事件精靈] 中的來源類型。](includes/media/apache-kafka-source-connector/select-apache-kafka.png)

在連線頁面上,選取新增連線。

![此螢幕快照顯示 [取得事件精靈] 的 [連線] 頁面上的 [新增連線] 鏈接選取專案。](includes/media/apache-kafka-source-connector/new-connection-link.png)

在 [ 連線設定 ] 區段中,針對 [啟動程序伺服器],輸入您的 Apache Kafka 伺服器位址。

![此螢幕快照顯示 [取得事件精靈] 的 [連線] 頁面上的 [啟動程式伺服器] 字段選取專案。](includes/media/apache-kafka-source-connector/bootstrap-server.png)

在 [連線認證] 區段中,如果您有 Apache Kafka 叢集的現有連線,請從 [連線] 下拉式清單中選取它。 否則,遵循下列步驟:

- 對於連線名稱 - 輸入連線的名稱。

- 針對 [ 驗證種類],確認已 選取 [API 金鑰 ]。

- 針對 [ 金鑰 和 密碼],輸入 API 金鑰和金鑰秘密。

選取 Connect。

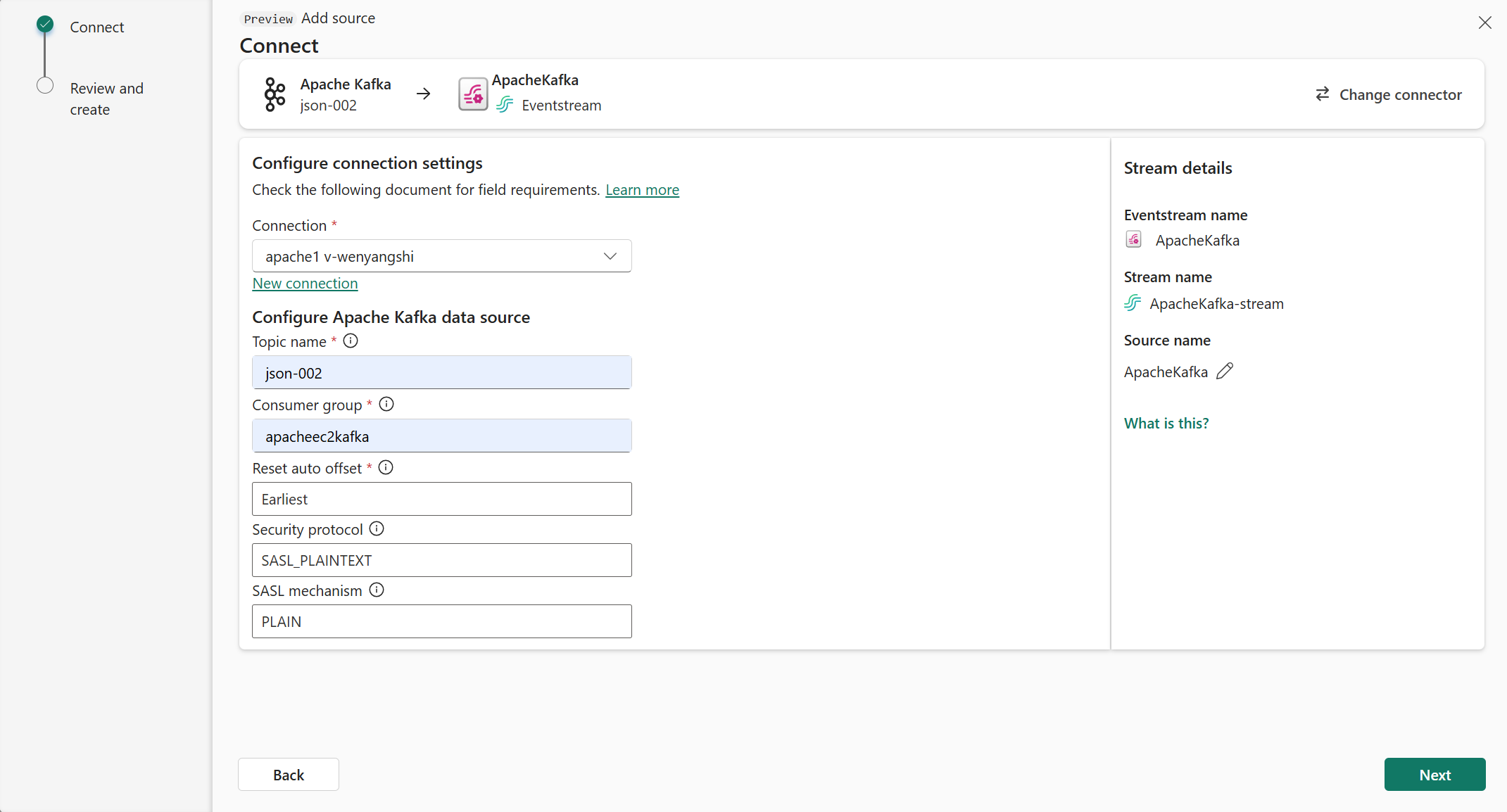

現在,在 [連線] 頁面上,遵循下列步驟。

針對 [主題],輸入 Kafka 主題。

針對 [ 取用者群組],輸入 Apache Kafka 叢集的取用者群組。 此欄位提供您取得事件的專用取用者群組。

選取 [ 重設自動位移 ],以指定在沒有認可時開始讀取位移的位置。

針對 安全性通訊協議,預設值為 SASL_PLAINTEXT。

注意

Apache Kafka 來源目前僅支援 Apache Kafka 叢集與 Eventstream 之間的未加密數據傳輸(SASL_PLAINTEXT和 PLAINTEXT)。 即將推出透過 SSL 加密資料傳輸的支援。

除非另有設定,否則預設 SASL機制 通常是 PLAIN。 您可以選取 符合您安全性需求的 SCRAM-SHA-256 或 SCRAM-SHA-512 機制。

選取 [下一步]。 在 [ 檢閱和建立] 畫面上檢閱摘要,然後選取 [ 新增]。

檢視更新的事件串流

您可以在編輯模式中看到新增至事件數據流的 Apache Kafka 來源。

完成這些步驟之後,Apache Kafka來源就可用於即時檢視中的視覺效果。

相關內容

其他連接器:

![顯示 [編輯] 檢視中 Apache Kafka 來源的螢幕快照。](media/add-source-apache-kafka/edit-view.png)