Microsoft Fabric 中 Apache Spark 的計費和使用率報告

適用於:✅Microsoft Fabric 中的 資料工程師 和 資料科學

本文說明 ApacheSpark 的計算使用率和報告,可支援 Microsoft Fabric 中的 Fabric 資料工程師 和 Science 工作負載。 計算使用率包括資料表預覽、載入至差異、筆記本從介面執行、排程執行、管線中筆記本步驟所觸發的執行程序,以及 Apache Spark 工作定義執行等 Lakehouse 作業。

與 Microsoft Fabric 中的其他體驗一樣,資料工程也使用與工作區關聯的容量來執行這些工作,並且整體容量費用會顯示在 Azure 入口網站中的 Microsoft 成本管理訂用帳戶下。 若要深入了解 Fabric 計費,請參閱<了解 Fabric 容量上的 Azure 帳單>。

Fabric 容量

身為使用者,您可以透過指定使用 Azure 訂用帳戶來從 Azure 購買 Fabric 容量。 容量的大小會決定可用的計算能力數量。 針對 Apache Spark for Fabric,每個購買的 CU 都會轉譯為 2 個 Apache Spark 虛擬核心。 例如,如果您購買 Fabric 容量 F128,這會轉譯為 256 個 Spark 虛擬核心。 Fabric 容量會在新增至其中的所有工作區之間共用,而且允許的 Apache Spark 計算總數會在從與容量相關聯的所有工作區提交的所有作業之間共用。 若要了解 Spark 上的不同 SKU、核心配置和節流,請參閱<適用於 Microsoft Fabric 的 Apache Spark 中的並行限制和佇列>。

Spark 計算組態設定和購買的容量

適用於 Fabric 的 Apache Spark 計算功能在計算組態設定方面提供兩個選項。

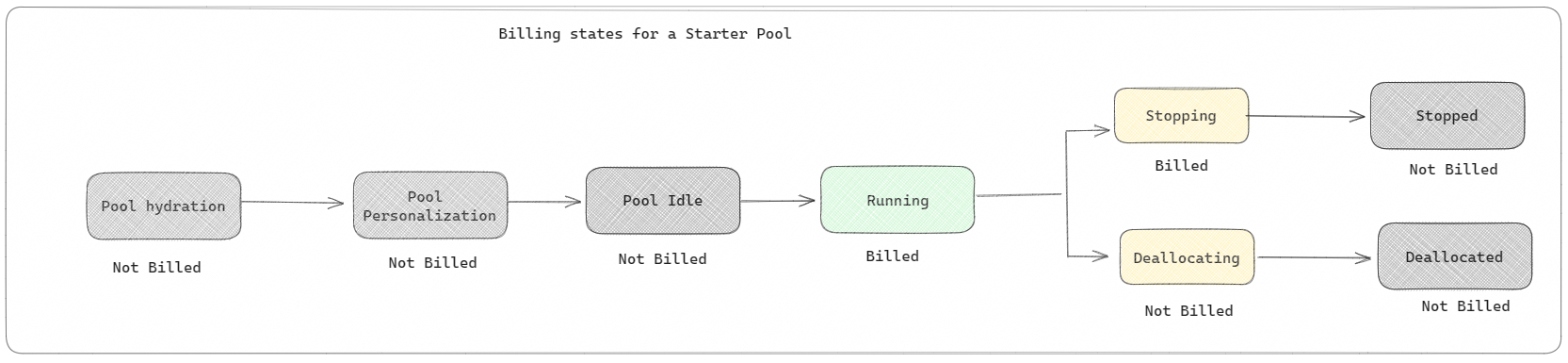

入門集區:這些預設的集區是一種快速且簡單的方法,數秒內即可在 Microsoft Fabric 平台上使用 Spark。 此方法可讓您立即使用 Spark 工作階段,而無需等待 Spark 為您設定節點,這可協助您使用資料進行更多作業,並更快速地取得深入解析。 在計費和容量使用量方面,當您開始執行筆記本或 Spark 工作定義或 Lakehouse 作業時,系統會向您收取費用。 在集區中閒置叢集的時間,您不需支付費用。

例如,如果您將筆記本作業提交至入門集區,則只會針對使用中筆記本工作階段的時間週期計費。 計費時間不包含閒置時間或使用 Spark 內容個人化工作階段所花費的時間。 若要深入了解如何根據購買的 Fabric 容量 SKU 設定入門集區,請瀏覽根據 Fabric 容量設定入門集區

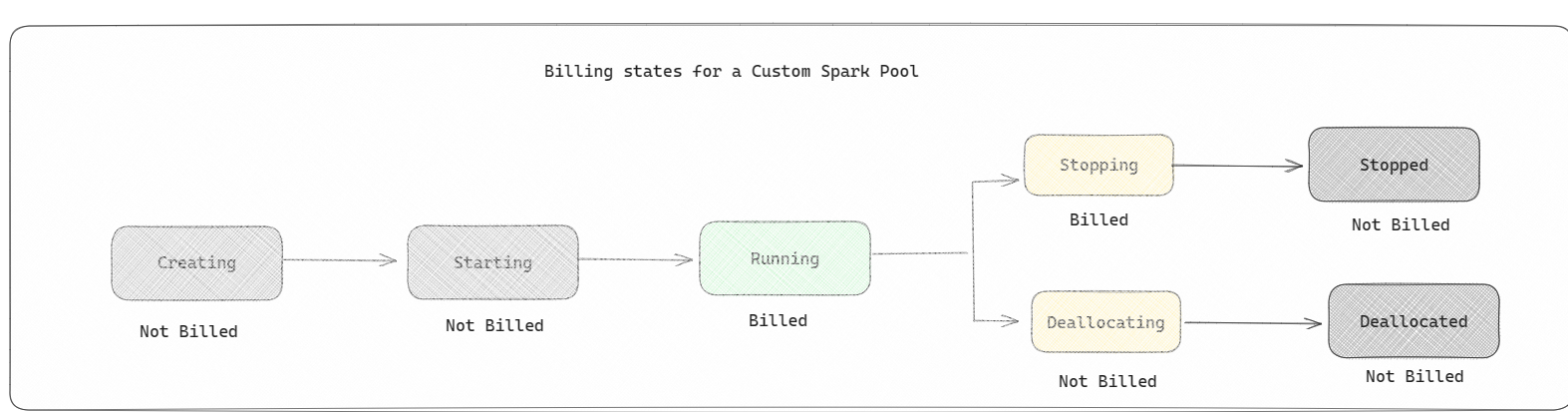

Spark 集區:這些是自訂集區,您可以在其中自訂資料分析工作所需的資源大小。 您可以為您的 Spark 集區指定名稱,並選擇節點數量和大小 (執行工作的機器) 數量。 您也可以告知 Spark 如何根據您擁有多少工作來調整節點數目。 建立 Spark 集區是免費的程序;僅當您在集區上執行 Spark 工作時,才會支付費用,然後 Spark 會為您設定節點。

- 在自訂 Spark 集區中能擁有的節點大小和數量取決於 Microsoft Fabric 容量。 您可以使用這些 Spark 虛擬核心來為自訂 Spark 集區建立不同大小的節點,只要 Spark 虛擬核心總數不超過 128 個。

- Spark 集區會像入門集區一樣計費;除非您已建立用於執行筆記本或 Spark 工作定義的作用中 Spark 工作階段,否則您不需支付您所建立的自訂 Spark 集區費用。 您只需支付作業執行期間的費用。 作業完成之後,您不會支付叢集建立和解除分配等階段的費用。

例如,如果您將筆記本作業提交至自定義 Spark 集區,則只會支付工作階段使用中期間的費用。 一旦 Spark 工作階段停止或過期,該筆記本工作階段的計費就會停止。 您不需要為從雲端取得叢集執行個體或初始化 Spark 內容所花費的時間支付費用。 若要深入了解如何根據購買的 Fabric 容量 SKU 設定 Spark 集區,請瀏覽根據 Fabric 容量設定集區

注意

您建立的入門集區和 Spark 集區的預設工作階段逾期時間週期會設定為 20 分鐘。 如果您的工作階段到期後 2 分鐘未使用 Spark 集區,您的 Spark 集區將會解除配置。 若要在工作階段到期期間之前完成筆記本執行之後停止工作階段和計費,您可以從筆記本首頁功能表按下停止工作階段按鈕,或移至監視中樞頁面,然後在該處停止工作階段。

Spark 計算使用量報告

Microsoft Fabric 容量計量應用程式可以在一個地方查看所有 Fabric 工作負載的容量使用量。 相較於購買的容量,容量管理員可以用來監視容量、工作負載的效能及其使用量。

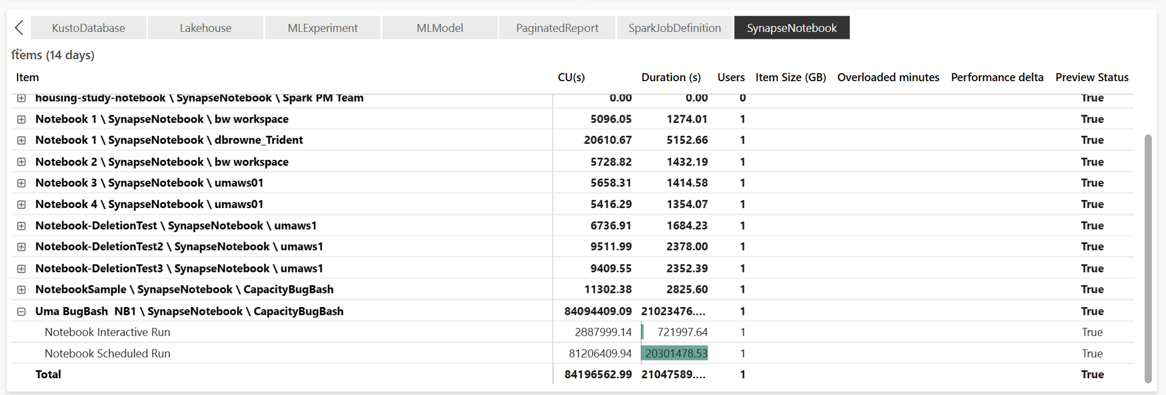

安裝應用程式之後,請從 [選取項目種類:] 下拉式清單中選取 [筆記本]、[Lakehouse]、[Spark 工作定義] 項目類型。 多重計量緞帶圖圖表現在可以調整為所需的時間範圍,以了解所有這些選取項目的使用量。

所有 Spark 相關作業都會分類為背景作業。 Spark 的容量使用量會顯示在筆記本、Spark 工作定義或 Lakehouse 下,並依作業名稱和項目彙總。 例如:如果執行筆記本工作,您可以在報告中查看筆記本執行、筆記本所使用的 CU (Spark 虛擬核心總數/2,因為 1 CU 可提供 2 個 Spark 虛擬核心)、工作持續時間。

若要深入了解 Spark 容量使用量報告,請參閱<監視 Apache Spark 容量耗用量>

若要深入了解 Spark 容量使用量報告,請參閱<監視 Apache Spark 容量耗用量>

計費範例

試想以下情況:

存在一個託管 Fabric 工作區 W1 的容量 C1,且此工作區包含 Lakehouse LH1 和 Notebook NB1。

- 筆記本 (NB1) 或 Lakehouse (LH1) 所執行的任何 Spark 作業均會針對容量 C1 報告。

將此範例延伸至存在另一個託管 Fabric 工作區 W2 的容量 C2 的案例,並假設此工作區包含 Spark 工作定義 (SJD1) 和 Lakehouse (LH2)。

- 如果工作區 (W2) 的 Spark 工作定義 (SDJ2) 從 Lakehouse (LH1) 讀取資料,則會針對容量 C2 (與託管項目的工作區 (W2) 相關聯) 報告使用量。

- 如果筆記本 (NB1) 從 Lakehouse (LH2) 執行讀取作業,則會針對容量 C1 (支援託管筆記本項目的工作區 W1) 報告容量使用量。