監視 Apache Spark 容量耗用量

本文的目的是要為想要監視其所管理容量中活動的系統管理員提供指引。 藉由利用 Microsoft Fabric 容量計量應用程式中提供的 Apache Spark 容量耗用量報告,系統管理員可以深入了解項目的可計費 Spark 容量耗用量,包括 Lakehouse、Notebook 和 Apache Spark 作業定義。 應用程式中不會報告某些 Spark 容量耗用量活動。

已報告的 Spark 容量使用量

lakehouse、筆記本和 Spark 作業定義的下列作業會被視為可計費的活動。

| 作業名稱 | 項目 | 註解 |

|---|---|---|

| Lakehouse 作業 | Lakehouse | Lakehouse 總管中的使用者預覽資料表。 |

| Lakehouse 資料表載入 | Lakehouse | 使用者在 Lakehouse 總管中載入差異資料表。 |

| 執行 Notebook | 筆記本 | 用戶手動執行筆記本。 |

| Notebook HC 執行 | 筆記本 | Notebook 會在高並行 Apache Spark 工作階段下執行。 |

| 筆記本排程執行 | 筆記本 | 筆記本執行是由筆記本排程事件所觸發。 |

| 筆記本管線執行 | 筆記本 | 由管線觸發的筆記本執行。 |

| Notebook VS Code 執行 | 筆記本 | 筆記本會在 VS Code 中執行。 |

| Spark 作業執行 | Spark 工作定義 | Spark 批次作業會由使用者提交起始。 |

| Spark 作業排程執行 | Spark 工作定義 | 由筆記本排程事件觸發的批次作業執行。 |

| Spark 作業管線執行 | Spark 工作定義 | 由管線觸發的批次作業執行。 |

| Spark 作業 VS Code 執行 | Spark 工作定義 | 從 VS Code 提交的 Spark 作業定義。 |

未報告的 Spark 容量耗用量

計量應用程式中沒有回報的一些Spark容量耗用量活動。 這些活動包括用於程式庫管理的系統 Spark 作業,以及 Spark Live 集區或即時工作階段的特定系統 Spark 作業。

連結庫管理 - 計量應用程式中不會報告與工作區層級連結庫管理相關聯的容量耗用量。

系統 Spark 作業 - 未與筆記本、Spark 作業定義或 Lakehouse 相關聯的 Spark 容量耗用量未包含在容量報告中。

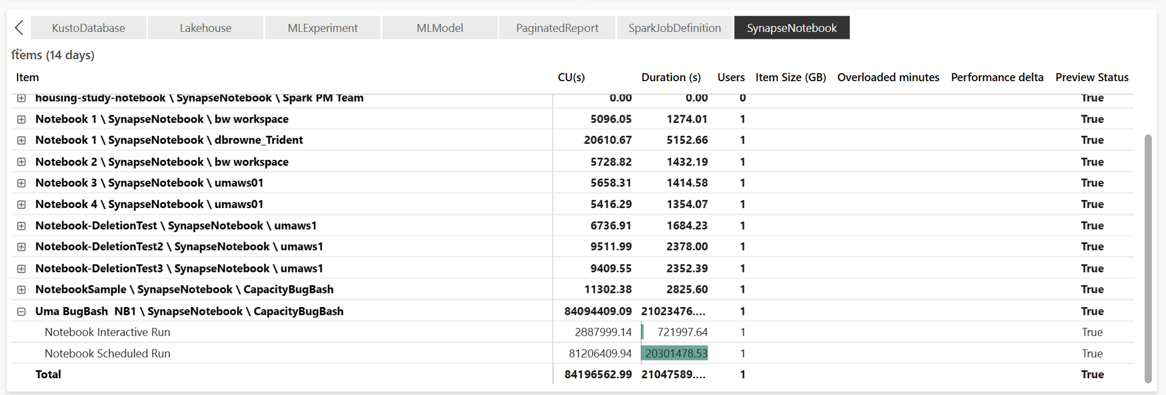

產能使用報告

所有Spark相關作業都會分類為 背景作業。 Spark 的容量耗用量會顯示在筆記本、Spark 作業定義或 Lakehouse 底下,並依作業名稱和項目彙總。

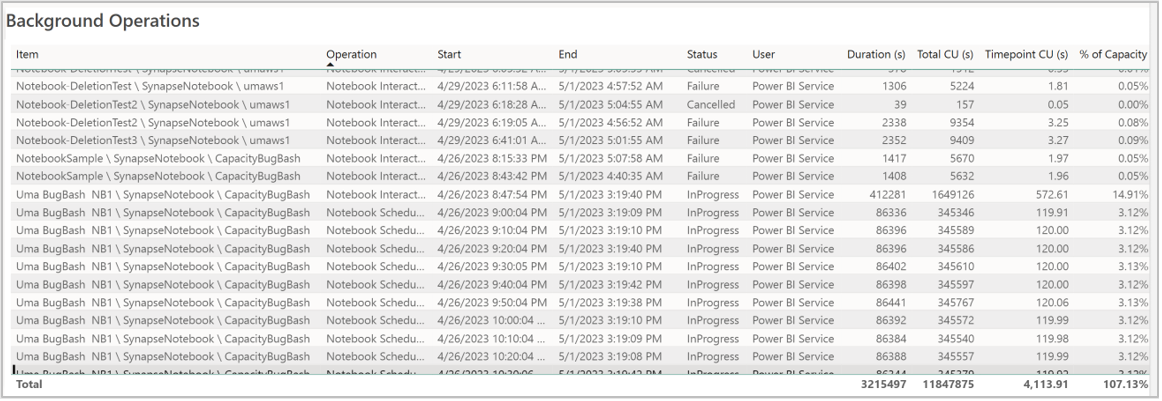

背景作業報告

特定時間點會顯示背景作業。 在報表的資料表中,每個資料列都會參考使用者作業。 檢閱 使用者 資料 行,以識別執行特定作業的人員。 如果您需要特定作業的詳細資訊,您可以使用其 作業標識碼 ,在Microsoft網狀 架構監視中樞中查閱。