監視複製活動

適用於: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

提示

試用 Microsoft Fabric 中的 Data Factory,這是適用於企業的全方位分析解決方案。 Microsoft Fabric 涵蓋從資料移動到資料科學、即時分析、商業智慧和報告的所有項目。 了解如何免費開始新的試用 (部分機器翻譯)!

本文概述如何監視 Azure Data Factory 和 Synapse 管線中的複製活動執行。 本文是根據複製活動概觀一文,該文提供複製活動的一般概觀。 您也可以使用相同方法來監視複製資料工具產生的複製活動,以及刪除活動。

以視覺化方式監視

一旦建立並發佈管線後,您就可以將其與觸發程序建立關聯,或手動啟動特定流程執行。 您可以在使用者體驗中以原生方式監視所有管線執行。 了解以視覺方式監視 Azure Data Factory 和 Synapse 管線的一般監視資訊。

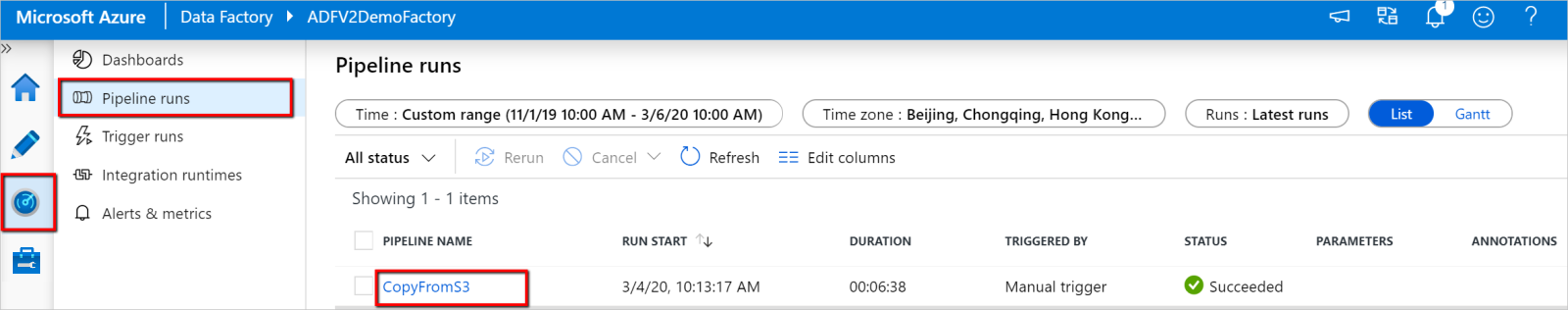

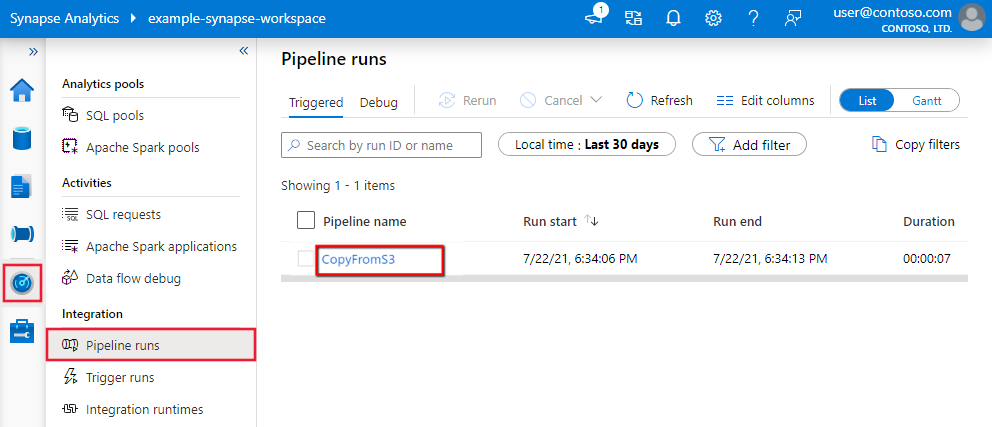

若要監視複製活動執行,請移至您服務執行個體適用的 Data Factory Studio 或 Azure Synapse Studio UI。 在 [監視器] 索引標籤中,您會看到管線執行清單,按一下 [管線名稱] 連結,即可存取管線執行中的活動執行清單。

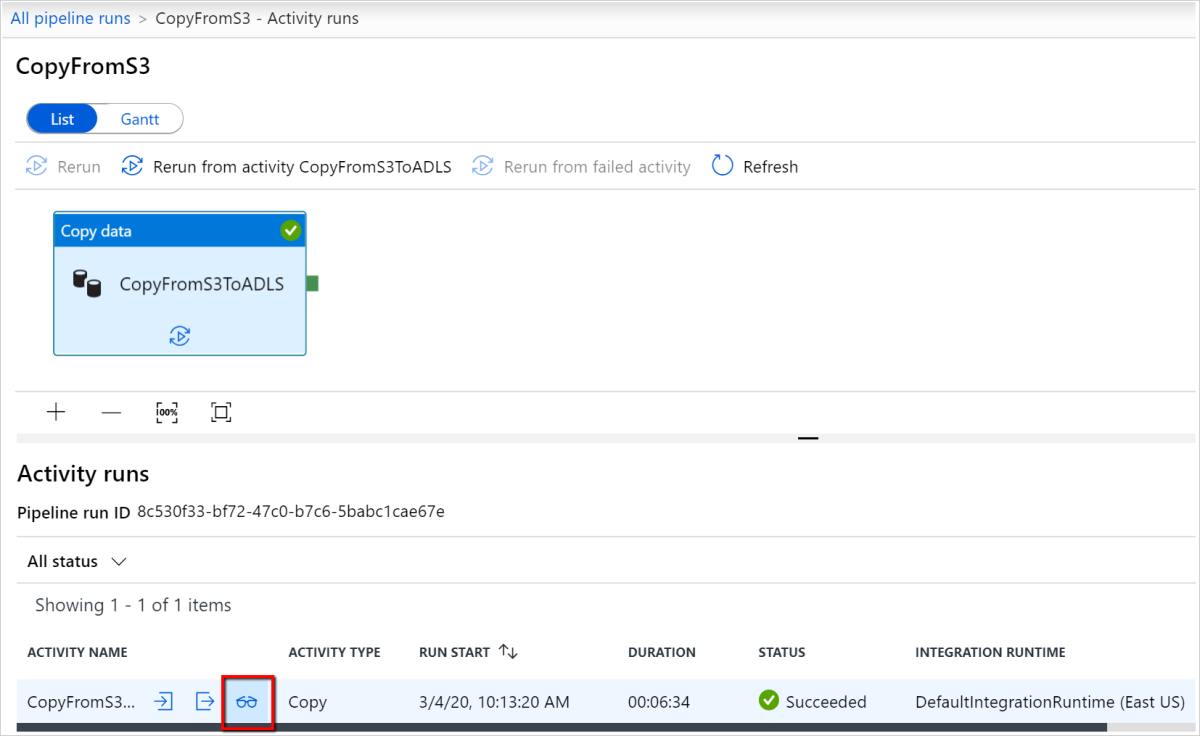

在此層級,您可以看到複製活動輸入、輸出和錯誤 (如果複製活動執行失敗) 的連結,以及持續時間/狀態等統計資料。 按一下複製活動名稱旁的 [詳細資料] 按鈕 (眼鏡),即可讓您深入了解複製活動執行的詳細資料。

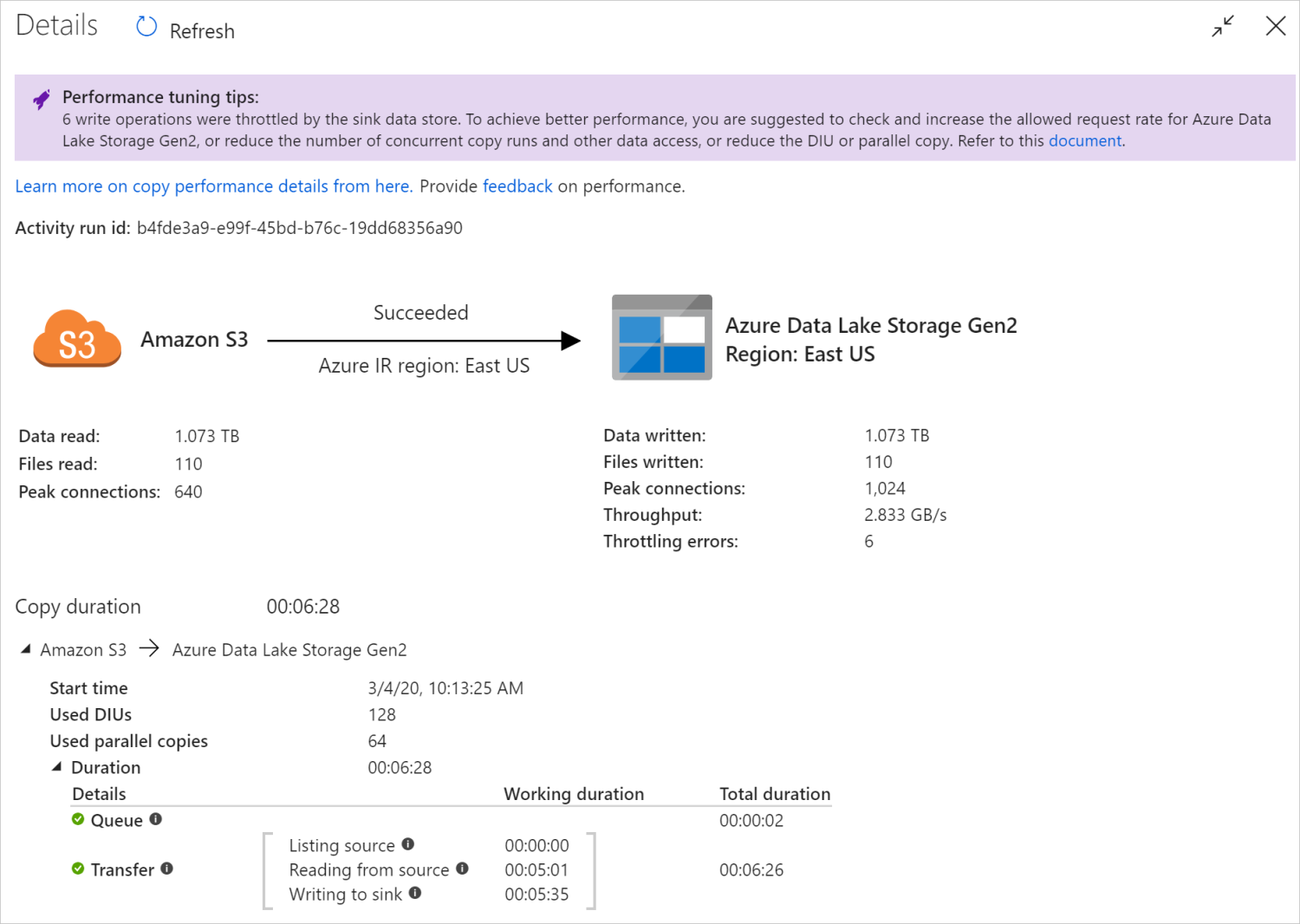

在此圖形化監視檢視中,服務會顯示複製活動執行資訊,包括資料讀取/寫入磁碟區、從來源複製到接收器的檔案/資料列數目、輸送量、適用於複製案例的設定、複製活動經過的步驟,以及對應的持續時間和詳細資料等。 請參閱下表,以取得每個可能的計量及其詳細說明。

在某些情況下,當您執行複製活動時,會在複製活動監視檢視頂端看到「效能微調秘訣」,如範例所示。 秘訣會告訴您服務在特定複製執行中找到的瓶頸,以及變更哪些項目可以提升複製輸送量的建議。 深入了解自動效能微調秘訣。

底部的執行詳細資料和持續時間描述複製活動所經歷的關鍵步驟,這對於排解複製效能問題特別有用。 複製執行的瓶頸是持續時間最長的執行。 如需每個階段所代表的內容和詳細的疑難排解指引,請參閱針對複製活動效能進行疑難排解。

範例:將資料從 Amazon S3 複製到 Azure Data Lake Storage Gen2

以程式設計方式監視

複製活動執行詳細資料和效能特性也會在 [複製活動執行結果]>[輸出] 區段中傳回,用來轉譯 UI 監視檢視。 以下是可能傳回的完整屬性清單。 您只會看到適用於您複製案例的屬性。 如需如何以程式設計方式監視活動執行的詳細資訊,請參閱以程式設計方式監視 Azure Data Factory 或 Synapse 管線。

| 屬性名稱 | 描述 | 輸出中的單位 |

|---|---|---|

| dataRead | 從來源讀取的實際資料量。 | Int64 值,以位元組為單位 |

| dataWritten | 在接收器中寫入/認可的實際資料量。 大小可能不同於 dataRead 大小,因為與每個資料存放區儲存資料的方式相關。 |

Int64 值,以位元組為單位 |

| filesRead | 從檔案型來源讀取的檔案數目。 | Int64 值 (未指定單位) |

| filesWritten | 在檔案型接收器中寫入/認可的檔案數目。 | Int64 值 (未指定單位) |

| filesSkipped | 從檔案型來源略過的檔案數目。 | Int64 值 (未指定單位) |

| dataConsistencyVerification | 資料一致性驗證的詳細資料,您可以在其中查看複製的資料是否已確認在來源和目的地存放區之間保持一致。 如需深入了解,請參閱這篇文章。 | 陣列 |

| sourcePeakConnections | 在複製活動執行期間,建立連至來源資料存放區的並行連線最大數目。 | Int64 值 (未指定單位) |

| sinkPeakConnections | 在複製活動執行期間,建立連至接收資料存放區的並行連線最大數目。 | Int64 值 (未指定單位) |

| rowsRead | 讀取自來源的資料列數。 此計量在以現況複製且不剖析檔案時不適用,例如以下情況: 來源與接收器資料集是二進位格式類型,或是具有相同設定的其他格式類型。 | Int64 值 (未指定單位) |

| rowsCopied | 複製到接收器的資料列數目。 此計量在以現況複製且不剖析檔案時不適用,例如以下情況: 來源與接收器資料集是二進位格式類型,或是具有相同設定的其他格式類型。 | Int64 值 (未指定單位) |

| rowsSkipped | 略過的不相容資料列數目。 您可以將 enableSkipIncompatibleRow 設定為 true,以略過不相容的資料列。 |

Int64 值 (未指定單位) |

| copyDuration | 複製執行的持續時間。 | Int32 值,以秒為單位 |

| throughput | 資料傳輸的速率,計算方式為 dataRead 除以 copyDuration。 |

浮點數,以 KBps 為單位 |

| sourcePeakConnections | 在複製活動執行期間,建立連至來源資料存放區的並行連線最大數目。 | Int32 值 (未指定單位) |

| sinkPeakConnections | 在複製活動執行期間,建立連至接收資料存放區的並行連線最大數目。 | Int32 值 (未指定單位) |

| sqlDwPolyBase | 資料複製到 Azure Synapse Analytics 時,是否使用 PolyBase。 | 布林值 |

| redshiftUnload | 從 Redshift 複製資料時是否使用 UNLOAD。 | 布林值 |

| hdfsDistcp | 從 HDFS 複製資料時是否使用 DistCp。 | 布林值 |

| effectiveIntegrationRuntime | 整合執行階段 (IR) 或用來推動活動執行的執行階段,格式為 <IR name> (<region if it's Azure IR>)。 |

文字 (字串) |

| usedDataIntegrationUnits | 複製期間的有效資料整合單位。 | Int32 值 |

| usedParallelCopies | 複製期間有效的 parallelCopies。 | Int32 值 |

| logPath | Blob 儲存體中略過資料的工作階段記錄路徑。 請參閱容錯。 | 文字 (字串) |

| executionDetails | 複製活動經歷的階段,以及對應步驟、持續時間、設定等詳細資料。 我們不建議您剖析此區段,因為可能會變更。 若要進一步了解此屬性如何協助您了解及疑難排解複製效能,請參閱以視覺化方式監視一節。 | 陣列 |

| perfRecommendation | 複製效能微調秘訣。 如需詳細資訊,請參閱效能微調秘訣。 | 陣列 |

| billingReference | 指定執行的計費耗用量。 深入了解監視活動執行層級的耗用量。 | Object |

| durationInQueue | 複製活動開始執行前的佇列持續時間 (以秒為單位)。 | Object |

範例:

"output": {

"dataRead": 1180089300500,

"dataWritten": 1180089300500,

"filesRead": 110,

"filesWritten": 110,

"filesSkipped": 0,

"sourcePeakConnections": 640,

"sinkPeakConnections": 1024,

"copyDuration": 388,

"throughput": 2970183,

"errors": [],

"effectiveIntegrationRuntime": "DefaultIntegrationRuntime (East US)",

"usedDataIntegrationUnits": 128,

"billingReference": "{\"activityType\":\"DataMovement\",\"billableDuration\":[{\"Managed\":11.733333333333336}]}",

"usedParallelCopies": 64,

"dataConsistencyVerification":

{

"VerificationResult": "Verified",

"InconsistentData": "None"

},

"executionDetails": [

{

"source": {

"type": "AmazonS3"

},

"sink": {

"type": "AzureBlobFS",

"region": "East US",

"throttlingErrors": 6

},

"status": "Succeeded",

"start": "2020-03-04T02:13:25.1454206Z",

"duration": 388,

"usedDataIntegrationUnits": 128,

"usedParallelCopies": 64,

"profile": {

"queue": {

"status": "Completed",

"duration": 2

},

"transfer": {

"status": "Completed",

"duration": 386,

"details": {

"listingSource": {

"type": "AmazonS3",

"workingDuration": 0

},

"readingFromSource": {

"type": "AmazonS3",

"workingDuration": 301

},

"writingToSink": {

"type": "AzureBlobFS",

"workingDuration": 335

}

}

}

},

"detailedDurations": {

"queuingDuration": 2,

"transferDuration": 386

}

}

],

"perfRecommendation": [

{

"Tip": "6 write operations were throttled by the sink data store. To achieve better performance, you are suggested to check and increase the allowed request rate for Azure Data Lake Storage Gen2, or reduce the number of concurrent copy runs and other data access, or reduce the DIU or parallel copy.",

"ReferUrl": "https://go.microsoft.com/fwlink/?linkid=2102534 ",

"RuleName": "ReduceThrottlingErrorPerfRecommendationRule"

}

],

"durationInQueue": {

"integrationRuntimeQueue": 0

}

}

相關內容

請參閱其他複製活動文章:

- 複製活動概觀

- 複製活動效能