通过运行 Spark 作业定义活动转换数据

使用 Microsoft Fabric 数据工厂中的 Spark 作业定义活动可以创建与 Spark 作业定义的连接,并从数据管道运行 Spark 作业定义。

先决条件

若要开始,必须完成以下先决条件:

- 具有有效订阅的租户帐户。 免费创建帐户。

- 创建工作区。

使用 UI 将 Spark 作业定义活动添加到管道

在工作区中创建新的数据管道。

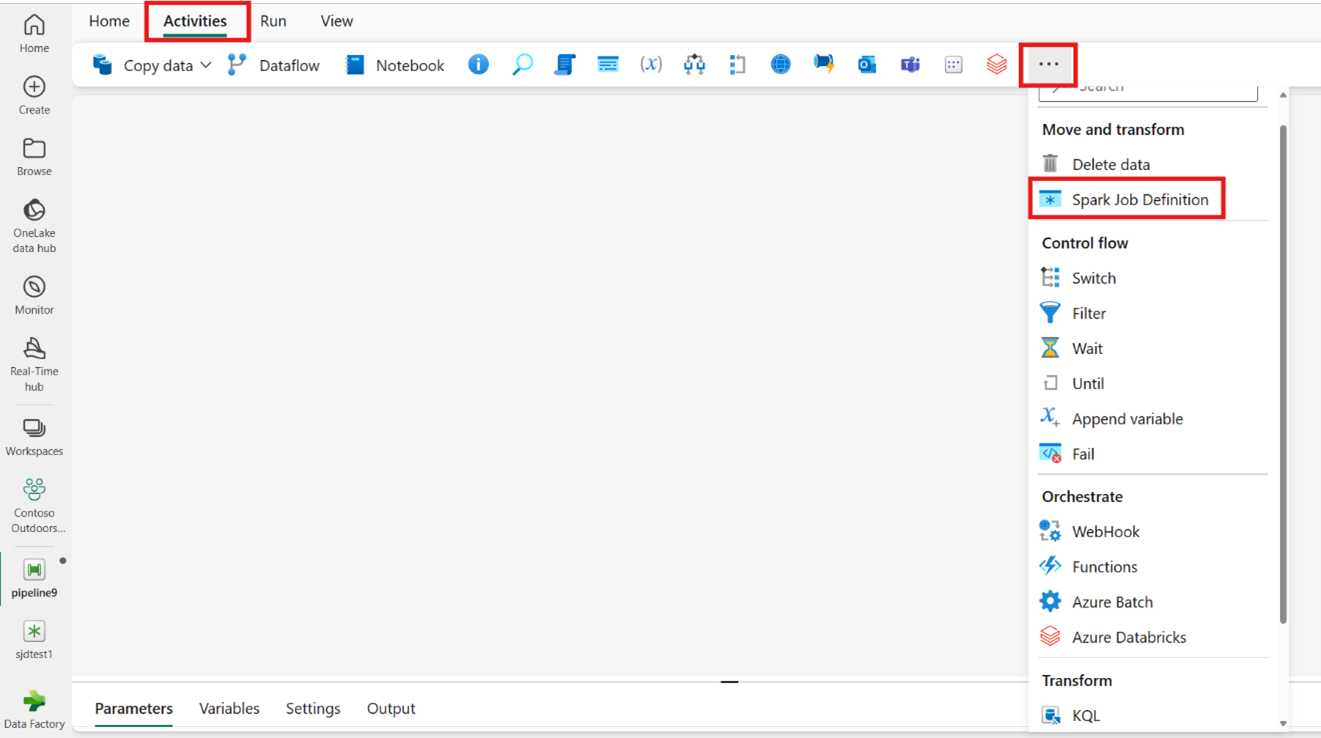

在主屏幕卡片中搜索 Spark 作业定义,然后选择它,或者从活动栏中选择活动,以便将其添加到管道画布中。

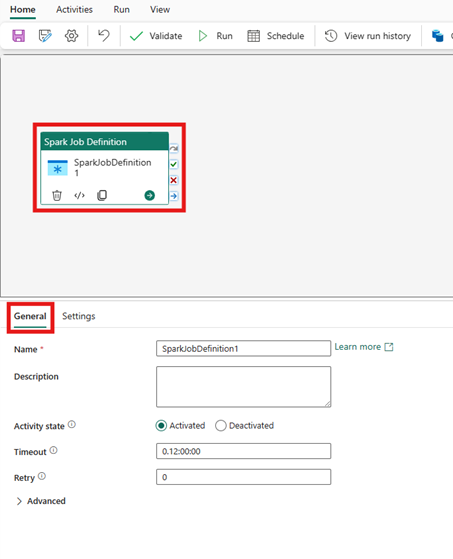

如果尚未选择,请在管道编辑器画布上选择新的 Spark 作业定义活动。

请参阅 常规设置 指南,以配置 常规设置 选项卡中找到的选项。

Spark 作业定义活动设置

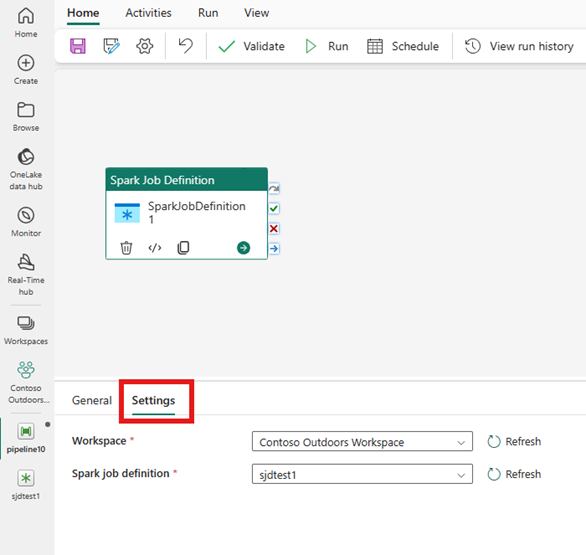

在活动属性窗格中选择“设置” 选项卡,然后选择包含要运行的 Spark 作业定义的 Fabric 工作区。

已知限制

此处列出了 Fabric 数据工厂的 Spark 作业定义活动中的当前限制。 本部分可能会更改。

- 我们目前不支持在活动内创建新的 Spark 作业定义活动(在“设置”下)

- 不提供参数化支持。

- 虽然我们支持通过输出选项卡监视活动,但目前无法更精细地监视 Spark 作业定义。 例如,指向监视页、状态、持续时间和以前的 Spark 作业定义运行的链接不能直接在数据工厂中使用。 但是,可以在 Spark 作业定义监视页中看到更精细的详细信息。

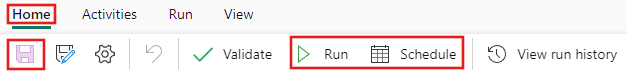

保存并运行,或计划管道

配置管道所需的任何其他活动后,切换到管道编辑器顶部的“开始”选项卡,然后选择保存按钮以保存管道。 选择“运行”来直接运行它,或者选择“计划”进行计划。 还可以在此处查看运行历史记录或配置其他设置。