你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

HX 系列虚拟机概述

适用于:✔️ Linux VM ✔️ Windows VM ✔️ 灵活规模集 ✔️ 统一规模集

HX 系列服务器具有 2 个 96 核 EPYC 9V33X CPU,总共 192 个物理“Zen4”内核,并采用 AMD 3D-V Cache 技术。 HX 上禁用了同时多线程处理技术 (SMT)。 这 192 个内核分为 24 个部分(每个套接字 12 个),每个部分包含 8 个处理器内核,可对 96 MB L3 缓存进行统一访问。 Azure HX 服务器还运行以下 AMD BIOS 设置:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

因此,该服务器使用 4 个 NUMA 域(每个套接字 2 个)引导,每个域的大小为 48 核。 每个 NUMA 都可以直接访问 6 个物理 DRAM 通道。

为了给 Azure 虚拟机监控程序提供运行空间而又不干扰 VM,我们为每台服务器预留 16 个物理内核。

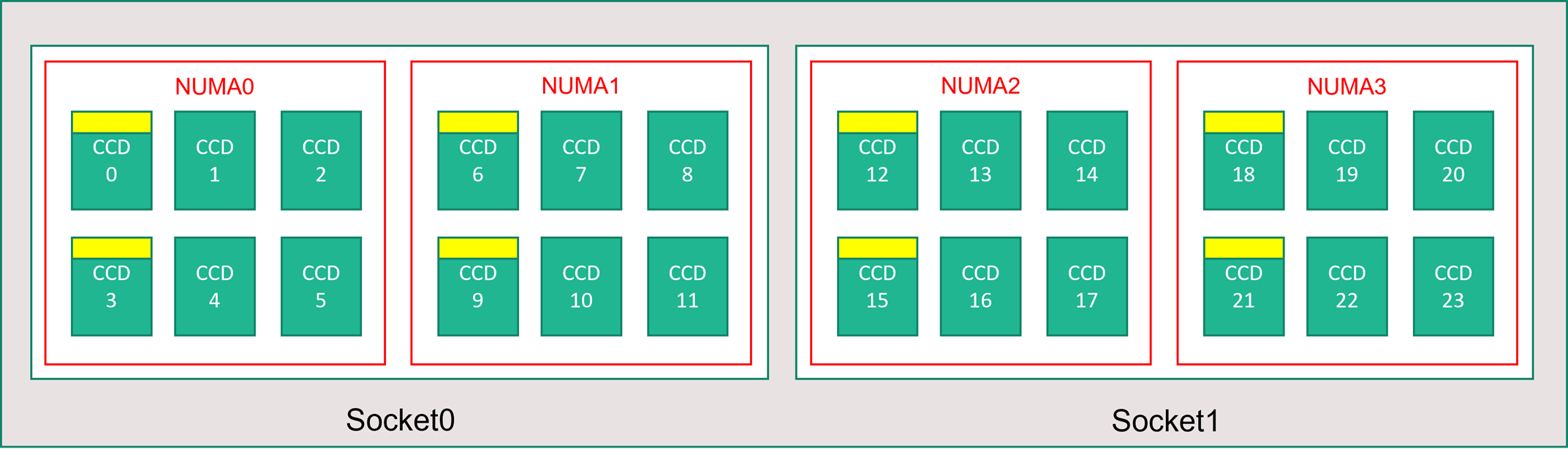

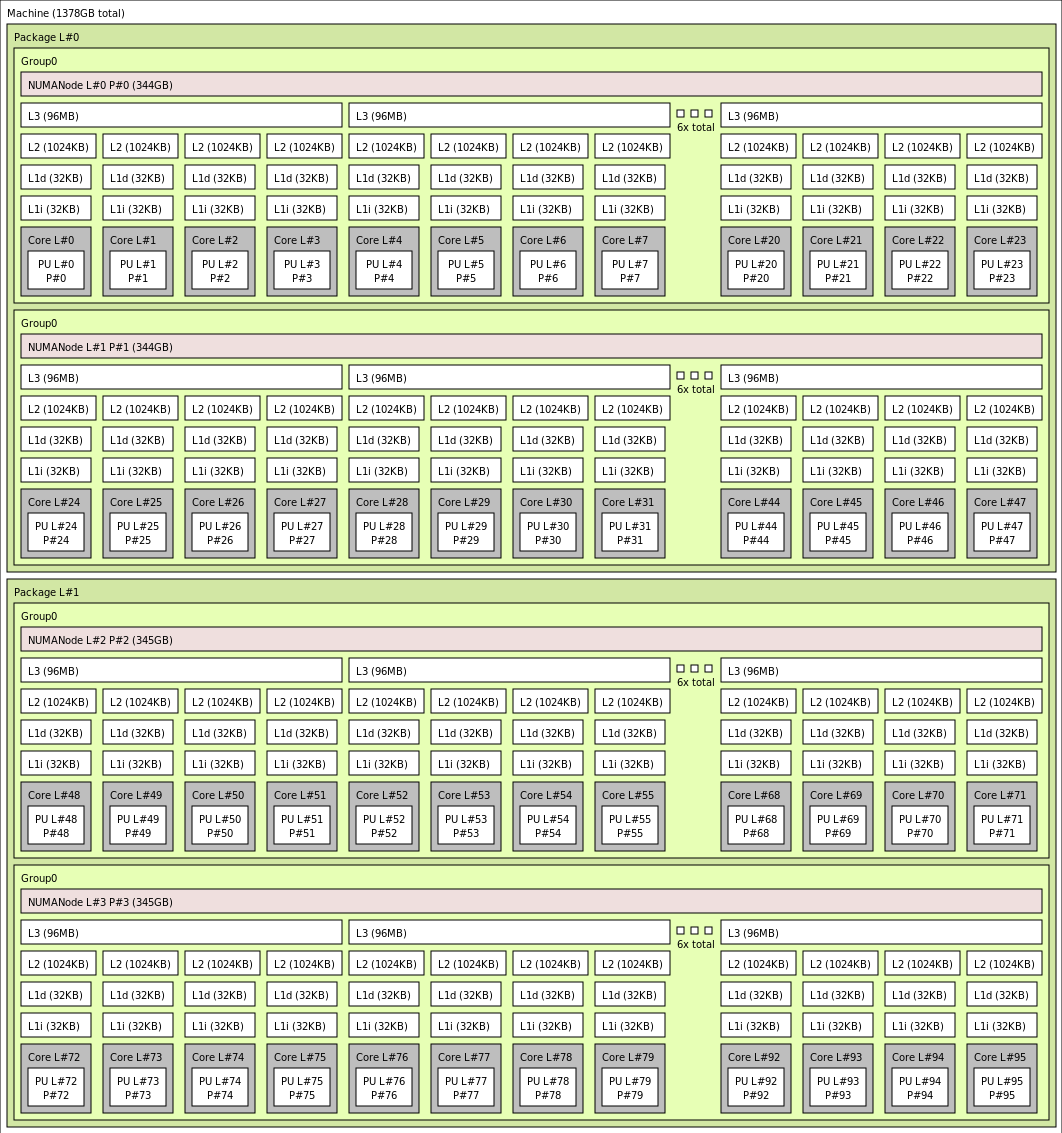

VM 拓扑

下图显示了服务器的拓扑。 我们以对称方式在两个 CPU 插槽上保留这 16 个虚拟机监控程序主机核心(黄色),前 2 个核心来自每个 NUMA 域上特定的 Core Complex Die (CCD),其余核心用于 HX 系列 VM(绿色)。

CCD 边界不同于 NUMA 边界。 在 HX 上,一组六 (6) 个连续的 CCD 配置为一个 NUMA 域,无论是在主机服务器级别上还是在来宾 VM 中。 因此,所有大小的 HX VM 都公开 4 个统一 NUMA 域,这些域将按如下所示对 OS 和应用程序显示,每个域具有不同的核心数,具体取决于特定的 HX VM 大小。

每种大小的 HX VM 与 AMD EPYC 9004 系列中其他 CPU 的物理布局、功能和性能相似,如下所示:

| HX 系列 VM 大小 | NUMA 域 | 每个 NUMA 域的核心 | 与 AMD EPYC 相似 |

|---|---|---|---|

| Standard_HX176rs | 4 | 44 | Dual-socket EPYC 9V33X |

| Standard_HX176-144rs | 4 | 36 | Dual-socket EPYC 9V33X |

| Standard_HX176-96rs | 4 | 24 | Dual-socket EPYC 9V33X |

| Standard_HX176-48rs | 4 | 12 | Dual-socket EPYC 9V33X |

| Standard_HX176-24rs | 4 | 6 | 双插槽 EPYC 9V33X |

注意

受约束的核心 VM 大小仅减少向 VM 公开的物理核心数。 所有全局共享资产(RAM、内存带宽、L3 缓存、GMI 和 xGMI 连接、InfiniBand、Azure 以太网、本地 SSD)保持不变。 这允许客户选择最适合给定的一组工作负荷或软件授权需求的 VM 大小。

每种大小的 HX VM 的虚拟 NUMA 映射会映射到基础物理 NUMA 拓扑。 硬件拓扑没有潜在的误导性抽象。

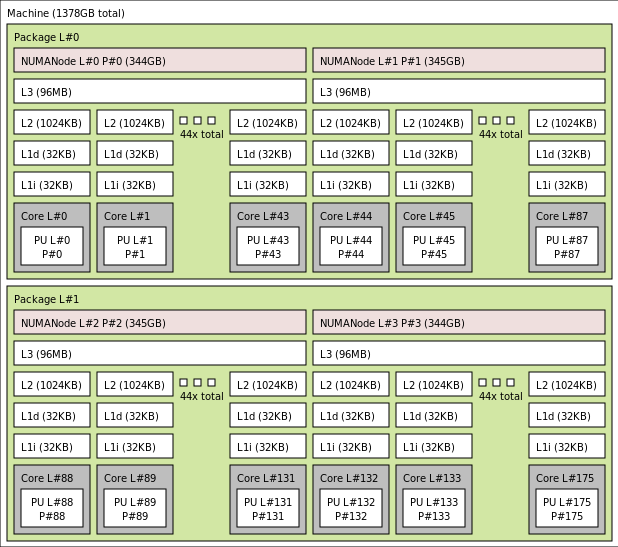

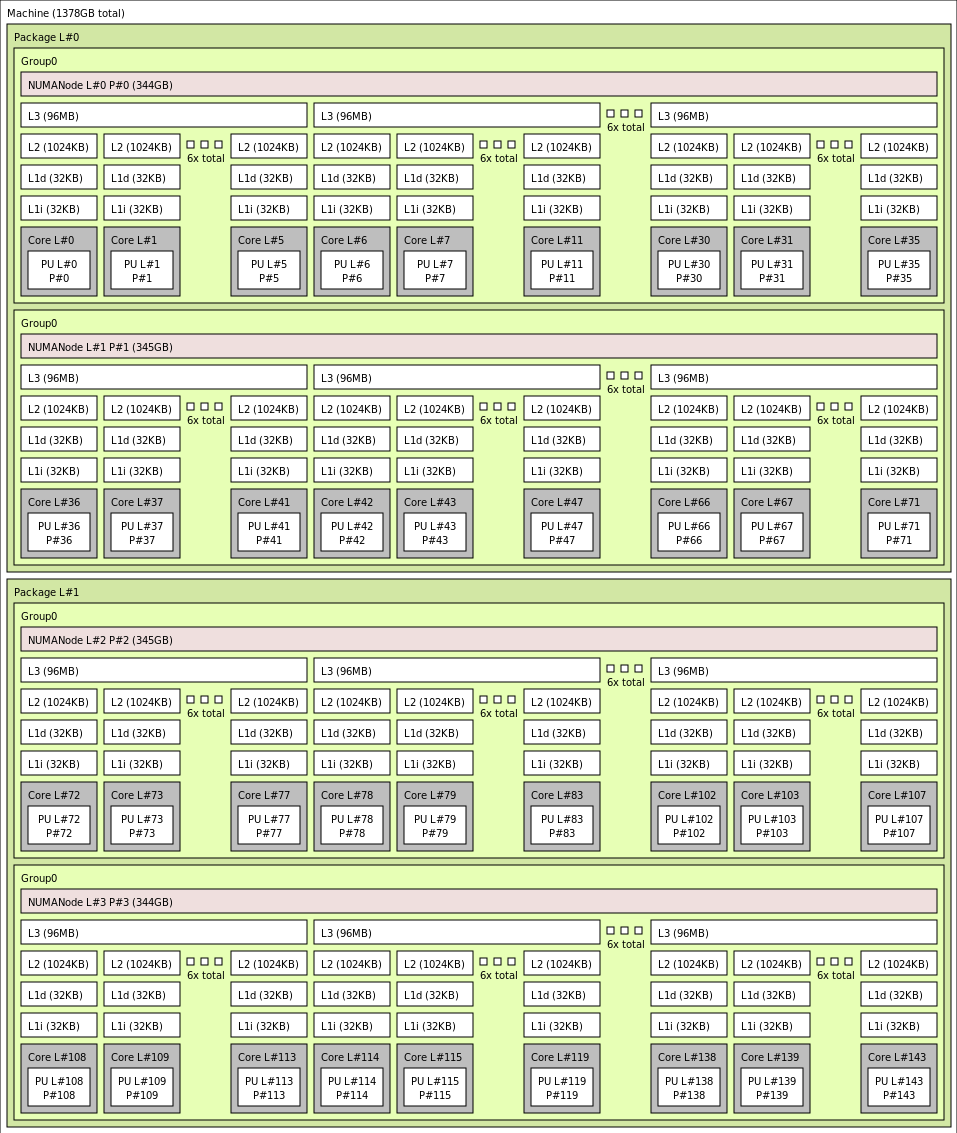

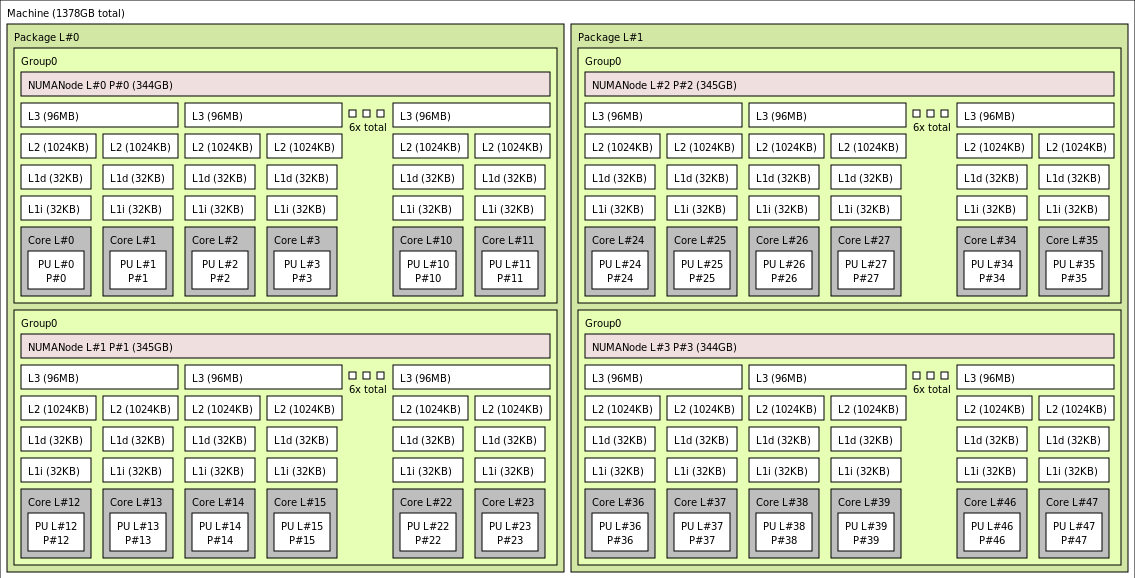

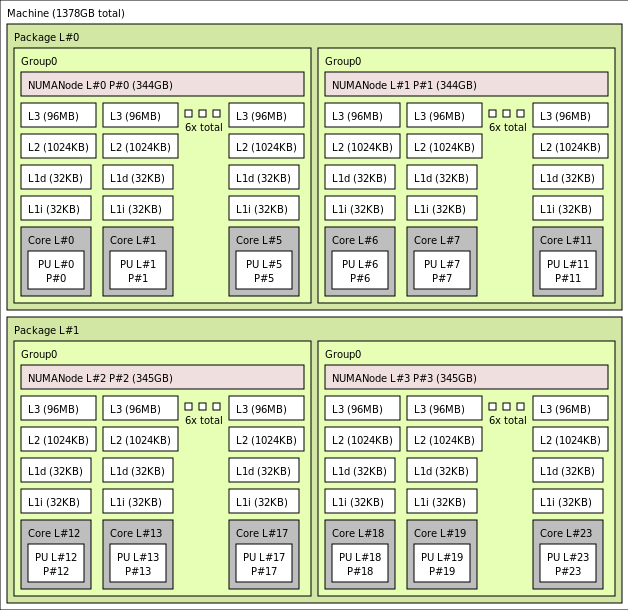

使用 lstopo 输出的各种 HX VM 大小的确切拓扑如下所示:

lstopo-no-graphics --no-io --no-legend --of txt

单击以查看 Standard_HX176rs 的 lstopo 输出

单击以查看 Standard_HX176-144rs 的 lstopo 输出

单击以查看 Standard_HX176-96rs 的 lstopo 输出

单击以查看 Standard_HX176-48rs 的 lstopo 输出

单击以查看 Standard_HX176-24rs 的 lstopo 输出

InfiniBand 网络

HX VM 还具有 NVIDIA Mellanox NDR InfiniBand 网络适配器 (ConnectX-7),其运行速度高达 400 Gb/秒。NIC 通过 SRIOV 传递到 VM,从而使网络流量可以绕过虚拟机监控程序。 因此,客户会在 HX VM 上加载标准的 Mellanox OFED 驱动程序,因为它们会成为裸机环境。

HX VM 支持自适应路由、动态连接的传输(DCT,还有标准 RC 和 UD 传输),以及基于硬件的 MPI 集合到 ConnectX-7 适配器的机载处理器的卸载。 这些功能增强了应用性能、可伸缩性和一致性,我们建议使用。

临时存储

HX VM 具有 3 台物理本地 SSD 设备。 一台设备已预先格式化以用作页面文件,并将在你的 VM 中显示为通用的“SSD”设备。

另外两台较大的 SSD 通过 NVMeDirect 作为未格式化的块 NVMe 设备提供。 由于块 NVMe 设备会绕过虚拟机监控程序,因此它具有更高的带宽、更高的 IOPS 和更低的每 IOP 延迟。

当在条带阵列中配对时,NVMe SSD 可提供高达 12 GB/秒的读取速度和 7 GB/秒的写入速度,以及高达 186,000 IOPS(读取)和 201,000 IOPS(写入)的深度队列深度。

硬件规格

| 硬件规格 | HX 系列 VM |

|---|---|

| 核心数 | 176、144、96、48 或 24(已禁用 SMT) |

| CPU | AMD EPYC 9V33X |

| CPU 频率(非 AVX) | 2.4 GHz 基本频率,3.7 GHz 峰值提升 |

| 内存 | 1.4 TB(每个内核的 RAM 依赖于 VM 大小) |

| 本地磁盘 | 2 个 1.8 TB NVMe(块)、480 GB SSD(页面文件) |

| InfiniBand | 400 Gb/秒 Mellanox ConnectX-7 NDR InfiniBand |

| 网络 | 80 Gb/秒以太网(40 Gb/秒可用)Azure 第二代 SmartNIC |

硬件规格

| 硬件规格 | HX 系列 VM |

|---|---|

| 最大 MPI 作业大小 | 52,800 个核心(单个虚拟机规模集中有 300 个 VM,且 singlePlacementGroup=true) |

| MPI 支持 | HPC-X(2.13 或更高版本)、Intel MPI(2021.7.0 或更高版本)、OpenMPI(4.1.3 或更高版本)、MVAPICH2(2.3.7 或更高版本)、MPICH(4.1 或更高版本) |

| 其他框架 | UCX、libfabric、PGAS 或其他基于 InfiniBand 的运行时 |

| Azure 存储支持 | 标准和高级磁盘(最多 32 个磁盘)、Azure NetApp 文件、Azure 文件存储、Azure HPC 缓存、Azure Managed Lustre 文件系统 |

| 支持和经过验证的 OS | AlmaLinux 8.6、8.7、Ubuntu 20.04+ |

| 推荐的性能操作系统 | AlmaLinux HPC 8.7、Ubuntu-HPC 20.04+ |

| Orchestrator 支持 | Azure CycleCloud、Azure Batch、AKS;群集配置选项 |

注意

- 这些 VM 仅支持第 2 代。

- AMD 的官方内核级支持始于 RHEL 8.6 和 AlmaLinux 8.6,后者是 RHEL 的衍生产品。

- 在 HX 和大于 64(虚拟或物理)核的其他 VM 上,不支持 Windows Server 2012 R2。 有关详细信息,请参阅 Windows Server 上 Hyper-V 支持的 Windows 来宾操作系统。 144 核和 176 核的规模需要 Windows Server 2022,Windows Server 2016 也适用于 24 核、48 核和 96 核的规模,Windows Server 仅适用于 24 核和 48 核的规模。

重要

建议的映像 URN:almalinux:almalinux-hpc:8_7-hpc-gen2:8.7.2023060101。要通过 Azure CLI 部署此映像,请确保包含参数 --plan 8_7-hpc-gen2 --product almalinux-hpc --publisher almalinux。 对于缩放测试,请使用建议的 URN 和新的 HPC-X tarball。

备注

- UCX 1.13 或更高版本中添加了 NDR 支持。 更低的 UCX 版本将报告上述运行时错误。 UCX 错误:活动速度

[1677010492.951559] [updsb-vm-0:2754 :0] ib_iface.c:1549 UCX ERROR Invalid active_speed on mlx5_ib0:1: 128无效。 - Ibstat 显示低速 (SDR):较旧的 Mellanox OFED (MOFED) 版本不支持 NDR,并且可能会报告 IB 速度较慢。 请使用 MOFED 版本 5.6-1.0.3.3 或更高版本。

后续步骤

- 在 Azure 计算技术社区博客上阅读最新公告、HPC 工作负载示例和性能结果。

- 若要从体系结构角度更概略性地看待如何运行 HPC 工作负荷,请参阅 Azure 上的高性能计算 (HPC)。