你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

生成式 AI 应用程序的评估

重要

本文中标记了“(预览版)”的项目目前为公共预览版。 此预览版未提供服务级别协议,不建议将其用于生产工作负载。 某些功能可能不受支持或者受限。 有关详细信息,请参阅 Microsoft Azure 预览版补充使用条款。

在快速发展的人工智能领域,生成式 AI 运营 (GenAIOps) 的集成正在改变组织开发和部署 AI 应用程序的方式。 随着企业越来越依赖 AI 来增强决策、改善客户体验和推动创新,怎么强调可靠评估框架的重要性也不为过。 评估是生成式 AI 生命周期的重要组成部分,它可以建立对以 AI 为中心的应用程序的信心和信任。 在未经精心设计的情况下,这些应用程序可能会生成虚假的、没有根据的、不相关或不连贯的输出,从而导致糟糕的客户体验;更糟的是,它们会传播社会刻板印象,宣传错误信息,使组织遭受恶意攻击,或产生各种其他负面影响。

评估器是评估 AI 响应中内容风险或不良行为的频率和严重性的有用工具。 使用适当的评估器执行迭代的系统性评估可以帮助团队在整个 AI 开发生命周期(从最初的模型选择到后期生产监视)中衡量和解决潜在的响应质量、安全或保障问题。 GenAI Ops 生命周期生产环境中的评估。

通过理解并在每个阶段实施有效的评估策略,组织可以确保其 AI 解决方案不仅能够满足最初的期望,而且还能适应现实环境并在其中取得发展。 让我们深入了解评估如何适应 AI 生命周期的三个关键阶段

基础模型选择

AI 生命周期的第一个阶段涉及到选择适当的基础模型。 生成式 AI 模型在功能、优势和局限性方面有很大的差异,因此确定哪个模型最适合你的特定用例至关重要。 在基础模型评估期间,你可以“货比三家”,根据与应用程序相关的一组条件来测试不同模型的输出,以此比较不同的模型。

此阶段的主要考虑因素可能包括:

- 准确度/质量:该模型在生成相关且连贯的响应方面表现如何?

- 对特定任务的表现:该模型是否可以处理用例所需的提示类型和内容? 模型的延迟和成本如何?

- 偏见和道德考量:该模型是否会生成任何可能传播或宣传不良刻板印象的输出?

- 风险和安全:该模型是否存在任何生成不安全或恶意内容的风险?

你可以浏览 Azure AI Foundry 基准来评估和比较基于公开提供的数据集的模型,同时还可以基于自己的数据重新生成基准结果。 或者,你可以通过所演示的 Azure AI 评估 SDK 来评估众多基础生成式 AI 模型之一,具体请参阅评估模型终结点示例。

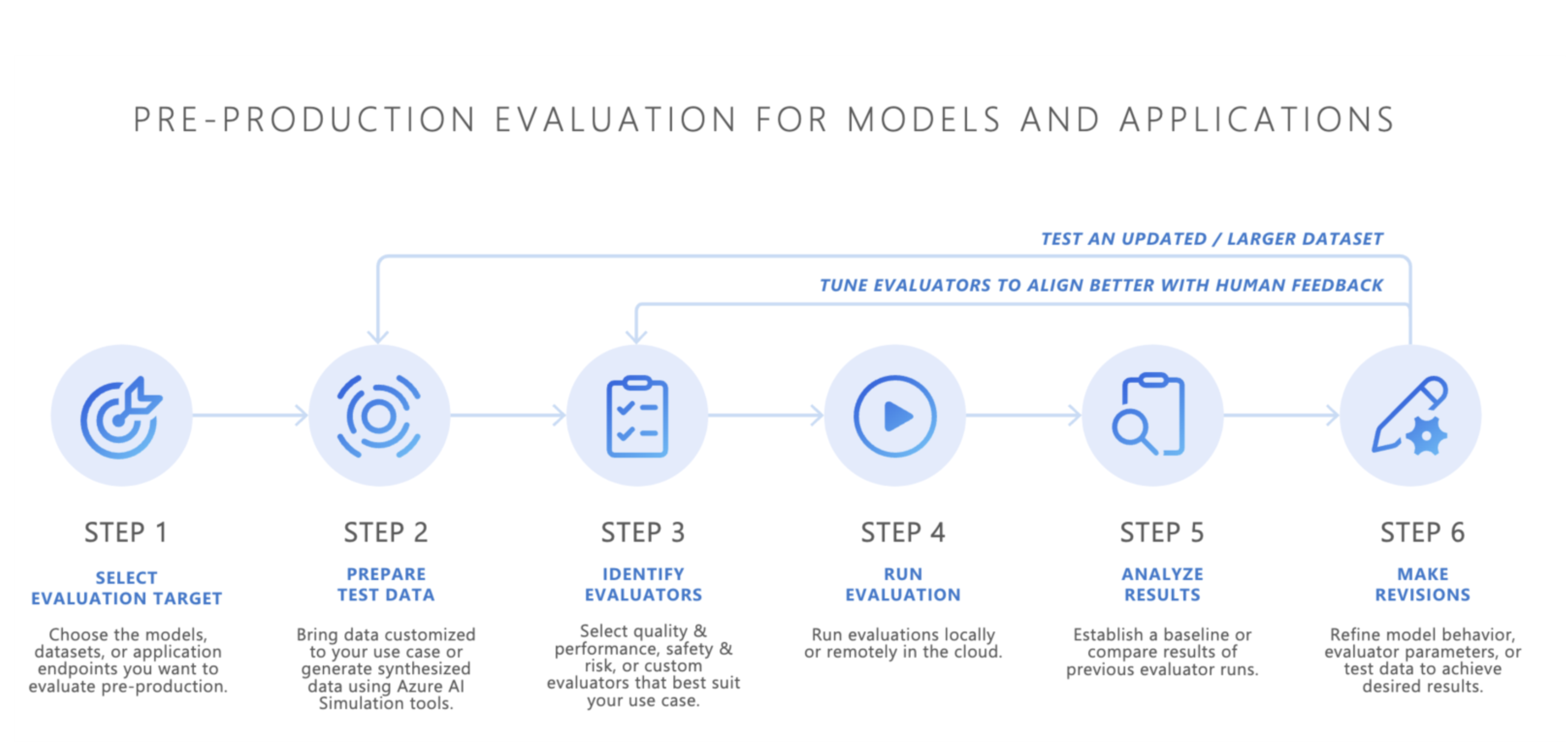

生产前评估

选择基础模型后,下一步是开发 AI 应用程序 — 例如 AI 支持的聊天机器人、检索增强生成 (RAG) 应用程序、代理式 AI 应用程序或任何其他生成式 AI 工具。 在开发之后,生产前评估随即开始。 在生产环境中部署应用程序之前,必须进行严格的测试,以确保模型真正可在现实世界中使用。

生产前评估涉及到:

- 使用评估数据集进行测试:这些数据集模拟真实的用户交互,以确保 AI 应用程序按预期执行。

- 识别极端情况:查找 AI 应用程序的响应质量可能下降或生成不良输出的场景。

- 评估可靠性:确保模型可以处理一系列输入变化,而不会显著降低质量或安全性。

- 衡量关键指标:评估响应依据、相关性和安全性等指标,以确认是否已做好生产准备。

预生产阶段充当最终质量检查,可以减少部署不符合所需性能或安全标准的 AI 应用程序时存在的风险。

- 自带数据:你可以借助 Azure AI Foundry 或 Azure AI 评估 SDK 支持的评估器(包括生成质量、安全性或自定义评估器),使用自己的评估数据对预生产环境中的 AI 应用程序进行评估,并通过 Azure AI Foundry 门户查看结果。

- 模拟器:如果你没有评估数据(测试数据),Azure AI 评估 SDK 的模拟器可以通过生成主题相关的或对抗性查询来为你提供帮助。 这些模拟器将测试模型对适合形势或类似于攻击的查询(极端情况)做出的响应。

或者,你也可以使用 Azure AI Foundry 的评估小组件来测试生成式 AI 应用程序。

实现满意的结果后,便可将 AI 应用程序部署到生产环境中。

生产后监视

部署后,AI 应用程序将进入生产后评估阶段,也称为联机评估或监视。 在此阶段,模型将嵌入到现实产品中,并对实际用户查询做出响应。 监视可确保模型持续按预期运行,并适应用户行为或内容的任何变化。

- 持续性能跟踪:使用关键指标定期衡量 AI 应用程序的响应,以确保一致的输出质量。

- 事件响应:快速响应实际使用过程中可能出现的任何有害、不公平或不适当的输出。

通过持续监视 AI 应用程序在生产环境中的行为,可以保持高质量的用户体验并及时解决出现的任何问题。

结束语

GenAIOps 完全致力于建立一个可靠且可重复的流程来管理生成式 AI 应用程序在整个生命周期内的行为。 从基础模型选择到生产前测试,再到生产后持续监视,评估在每个阶段都发挥着至关重要的作用。 通过系统性地衡量并解决风险并在每一步优化 AI 系统,团队构建的生成式 AI 解决方案不仅功能强大,而且在现实用途中还值得信赖且安全。

速查表:

| 目的 | 处理 | 参数 |

|---|---|---|

| 你的评估目的是什么? | 确定或构建相关的评估器 | - 质量和性能(质量和性能示例笔记本) - 安全与保障(安全与保障示例笔记本) - 自定义(自定义示例笔记本) |

| 应使用哪些数据? | 上传或生成相关的数据集 | 用于衡量质量和性能的通用模拟器(通用模拟器示例笔记本) - 用于衡量安全与保障的对抗模拟器(对抗模拟器示例笔记本) |

| 应该对哪些资源执行评估? | 运行评估 | - 本地运行 - 远程云运行 |

| 我的模型/应用表现如何? | 分析结果 | 查看聚合评分、查看详细信息、为详细信息评分、比较评估运行 |

| 如何做出改进? | 对模型、应用或评估器进行更改 | - 如果评估结果与人工反馈不一致,请调整评估器。 - 如果评估结果与人工反馈一致但不符合质量/安全阈值,请应用有针对性的缓解措施。 |