เชื่อมต่อกับ ADLS และแปลงข้อมูลด้วย Azure Databricks

ในคู่มือนี้ คุณจะ:

สร้างตาราง Delta ในบัญชี Azure Data Lake Storage (ADLS) Gen2 ของคุณโดยใช้ Azure Databricks

สร้างทางลัด OneLake ไปยังตาราง Delta ใน ADLS

ใช้ Power BI เพื่อวิเคราะห์ข้อมูลผ่านทางลัด ADLS

ข้อกำหนดเบื้องต้น

ก่อนที่คุณจะเริ่มต้น คุณต้องมี:

พื้นที่ทํางานที่มีรายการเลคเฮ้าส์

พื้นที่ทํางาน Azure Databricks

บัญชี ADLS Gen2 เพื่อจัดเก็บตาราง Delta

สร้างตาราง Delta สร้างทางลัด และวิเคราะห์ข้อมูล

ใช้สมุดบันทึก Azure Databricks สร้างตาราง Delta ในบัญชี ADLS Gen2 ของคุณ

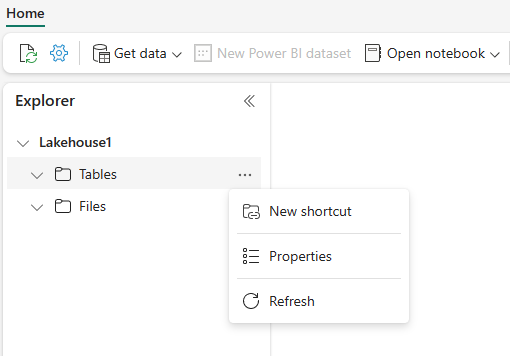

# Replace the path below to refer to your sample parquet data with this syntax "abfss://<storage name>@<container name>.dfs.core.windows.net/<filepath>" # Read Parquet files from an ADLS account df = spark.read.format('Parquet').load("abfss://datasetsv1@olsdemo.dfs.core.windows.net/demo/full/dimension_city/") # Write Delta tables to ADLS account df.write.mode("overwrite").format("delta").save("abfss://datasetsv1@olsdemo.dfs.core.windows.net/demo/adb_dim_city_delta/")ในเลคเฮ้าส์ของคุณ เลือกจุดไข่ปลา (...) ที่อยู่ถัดจาก ตาราง จากนั้นเลือก ทางลัดใหม่

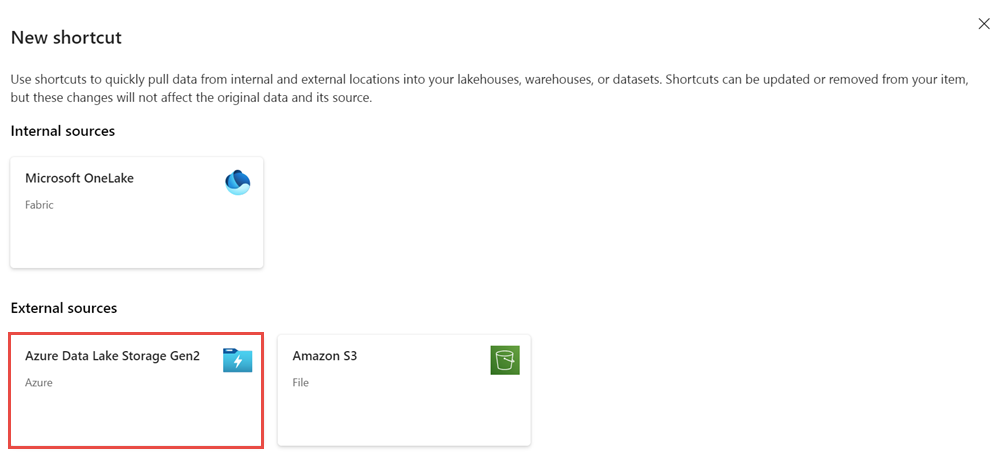

ในหน้าจอทางลัดใหม่ เลือกไทล์ Azure Data Lake Storage รุ่น2

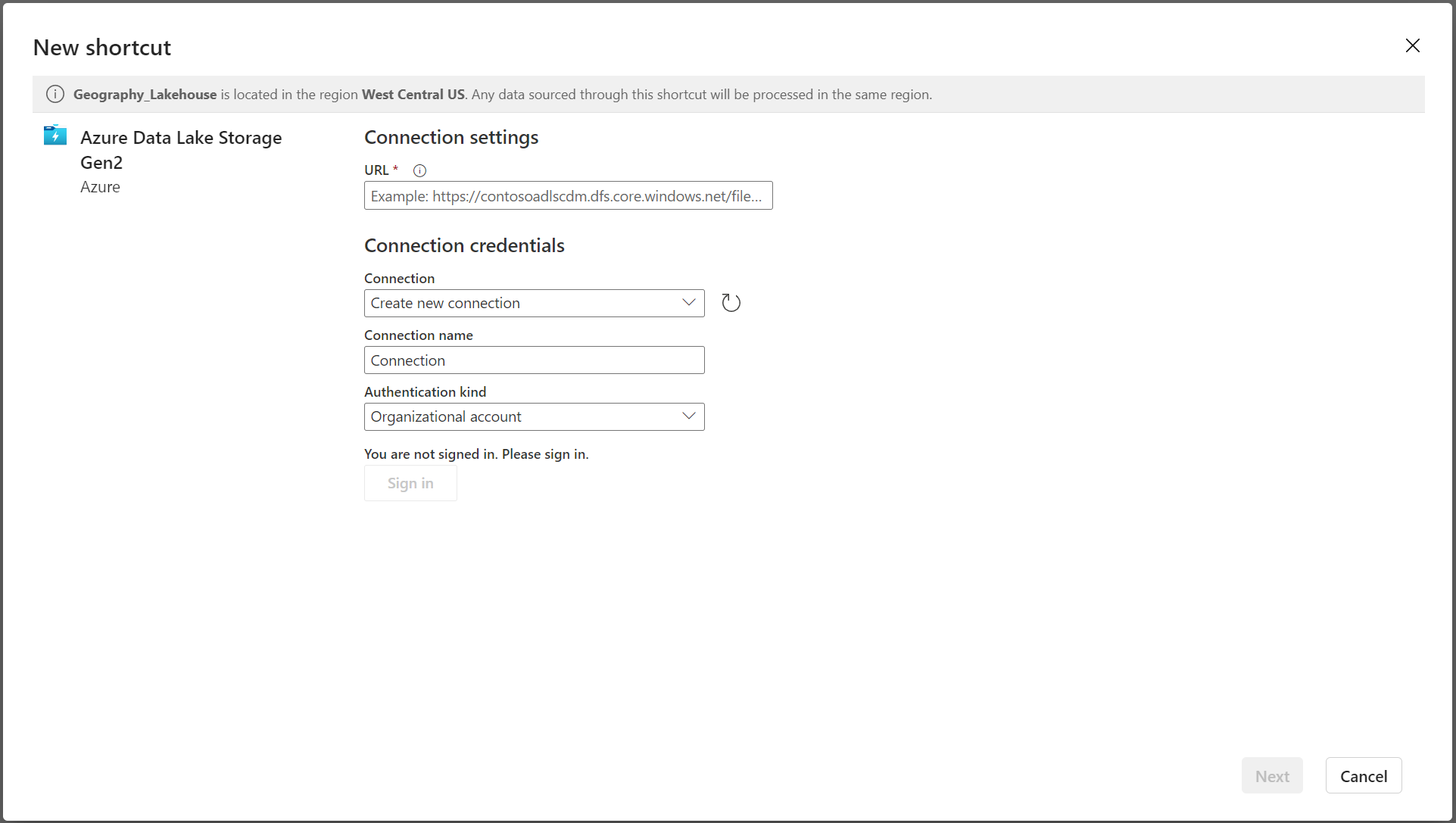

ระบุรายละเอียดการเชื่อมต่อสําหรับทางลัดและเลือก ถัดไป

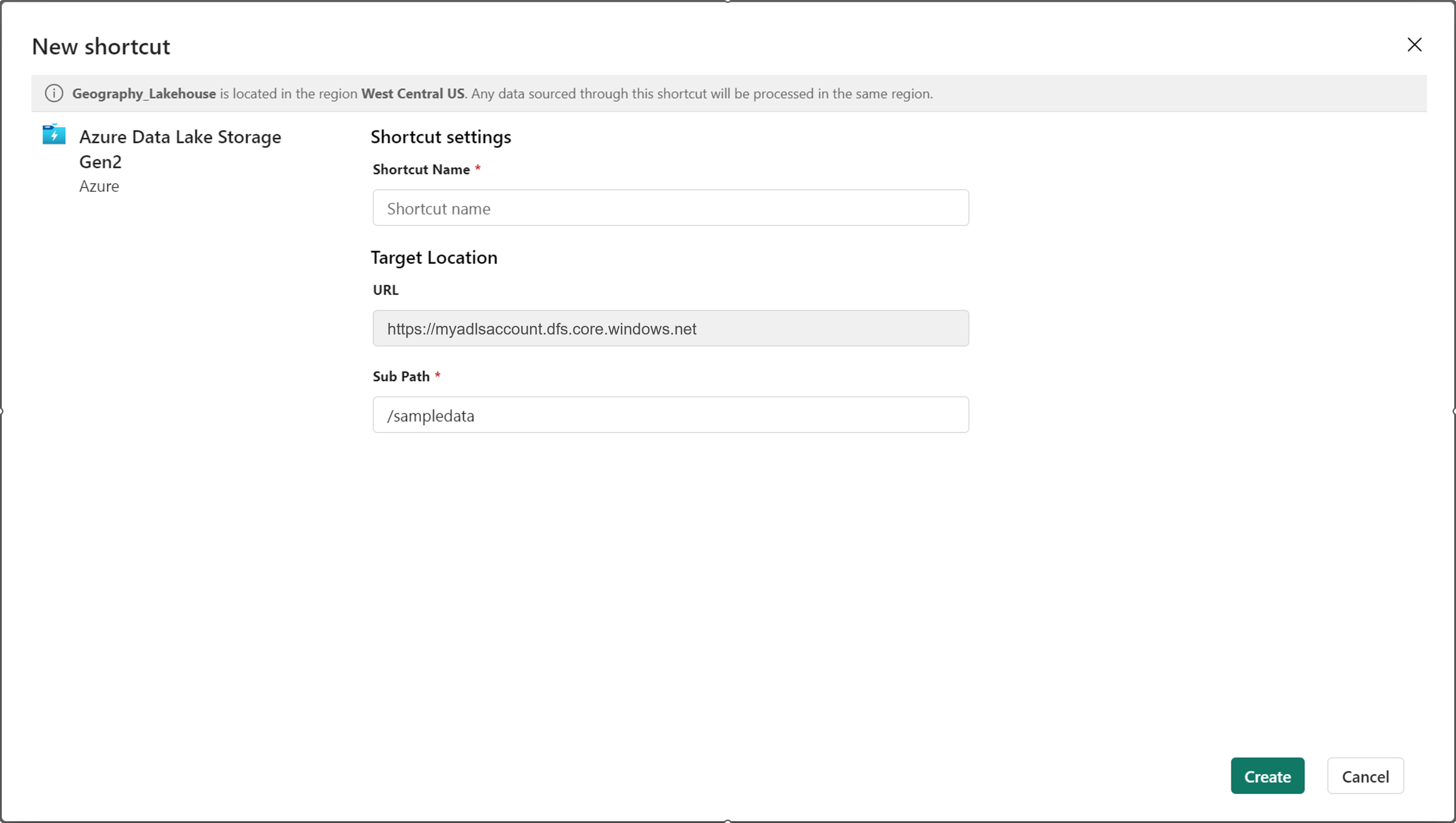

ระบุรายละเอียดทางลัด ใส่ชื่อทางลัดและรายละเอียดเส้นทางย่อย จากนั้นเลือก สร้าง เส้นทางย่อยควรชี้ไปยังไดเรกทอรีที่มีตาราง Delta อยู่

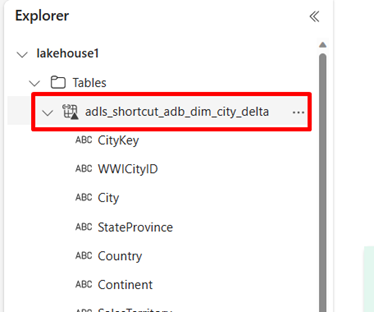

ทางลัดจะปรากฏเป็นตาราง Delta ภายใต้ ตาราง

ตอนนี้คุณสามารถคิวรีข้อมูลนี้ได้โดยตรงจากสมุดบันทึก

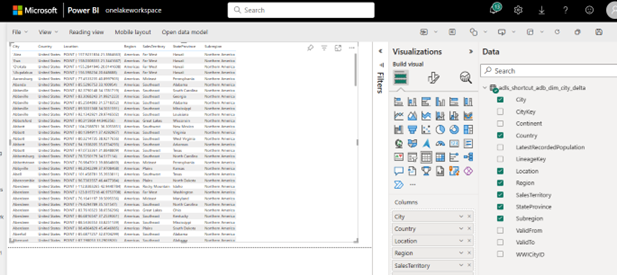

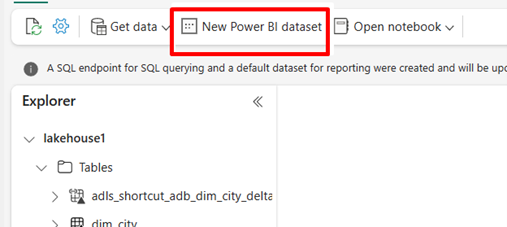

df = spark.sql("SELECT * FROM lakehouse1.adls_shortcut_adb_dim_city_delta LIMIT 1000") display(df)หากต้องการเข้าถึงและวิเคราะห์ตาราง Delta นี้ผ่านทาง Power BI ให้เลือก แบบจําลองความหมาย Power BI ใหม่

เลือกปุ่มลัด จากนั้นเลือกยืนยัน

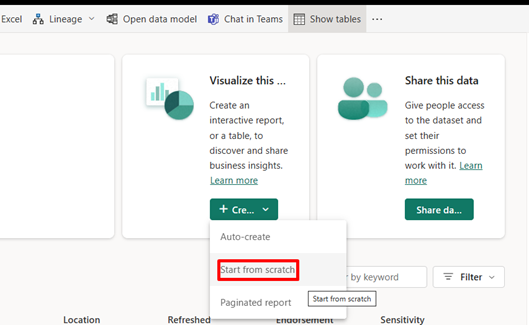

เมื่อข้อมูลถูกเผยแพร่ เลือกเริ่มต้นตั้งแต่เริ่มต้น

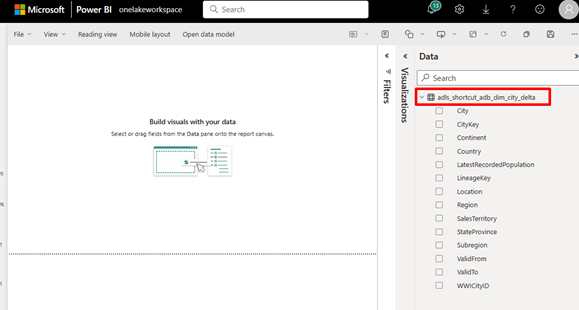

ในประสบการณ์การเขียนรายงาน ข้อมูลปุ่มลัดจะปรากฏเป็นตารางพร้อมกับแอตทริบิวต์ทั้งหมด

หากต้องการสร้างรายงาน Power BI ให้ลากแอตทริบิวต์ไปยังบานหน้าต่างทางด้านซ้าย