นําเข้าข้อมูลลงใน OneLake และวิเคราะห์ด้วย Azure Databricks

ในคู่มือนี้ คุณจะ:

สร้างไปป์ไลน์ในพื้นที่ทํางานและนําเข้าข้อมูลลงใน OneLake ของคุณในรูปแบบ Delta

อ่านและปรับเปลี่ยนตาราง Delta ใน OneLake ด้วย Azure Databricks

ข้อกำหนดเบื้องต้น

ก่อนที่คุณจะเริ่มต้น คุณต้องมี:

พื้นที่ทํางานที่มีรายการเลคเฮ้าส์

พื้นที่ทํางาน Azure Databricks ระดับพรีเมียม เฉพาะพื้นที่ทํางาน Azure Databricks ระดับพรีเมียมเท่านั้นที่สนับสนุนการส่งผ่านข้อมูลประจําตัวของ Microsoft Entra เมื่อสร้างคลัสเตอร์ของคุณ เปิดใช้งานการส่งผ่านข้อมูลประจําตัวของ Azure Data Lake Storage ใน ตัวเลือกขั้นสูง

ชุดข้อมูลตัวอย่าง

นําเข้าข้อมูลและปรับเปลี่ยนตาราง Delta

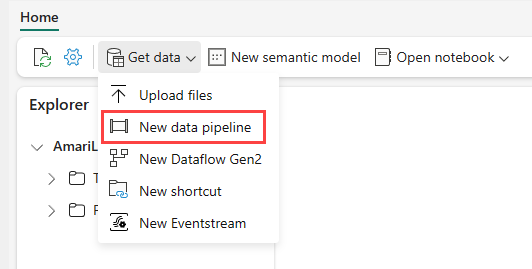

นําทางไปยังเลคเฮ้าส์ของคุณในบริการของ Power BI และเลือก รับข้อมูล จากนั้นเลือก ไปป์ไลน์ข้อมูลใหม่

ในพรอมต์ไปป์ไลน์ใหม่ ใส่ชื่อสําหรับไปป์ไลน์ใหม่จากนั้นเลือก สร้าง

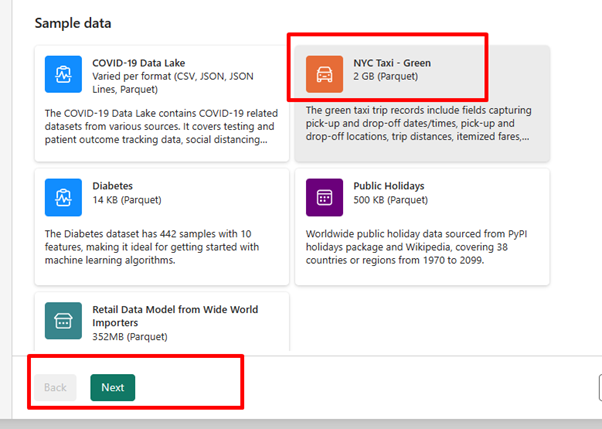

สําหรับแบบฝึกหัดนี้ ให้เลือกข้อมูลตัวอย่าง NYC Taxi - Green เป็นแหล่งข้อมูล จากนั้นเลือก ถัดไป

บนหน้าจอแสดงตัวอย่าง เลือกถัดไป

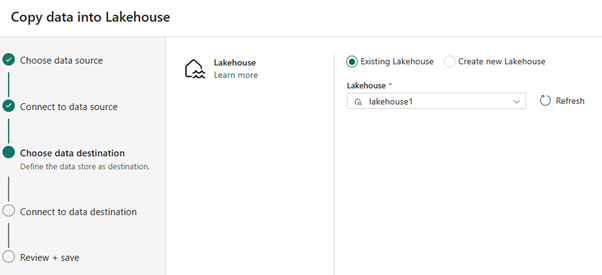

สําหรับปลายทางของข้อมูล เลือกชื่อของเลคเฮาส์ที่คุณต้องการใช้เพื่อจัดเก็บข้อมูลตาราง OneLake Delta คุณสามารถเลือกเลคเฮ้าส์ที่มีอยู่แล้วหรือสร้างขึ้นใหม่

เลือกตําแหน่งที่คุณต้องการจัดเก็บเอาต์พุต เลือก ตาราง เป็นโฟลเดอร์ราก และใส่ "nycsample" เป็นชื่อตาราง

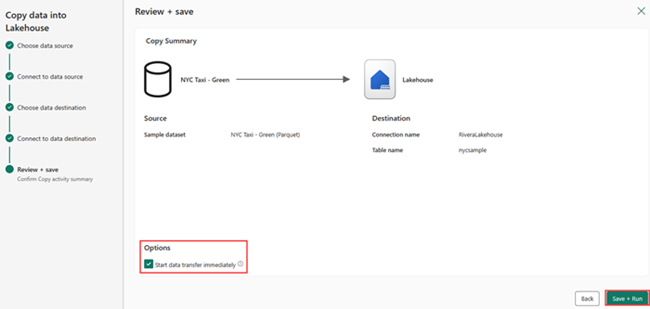

บนหน้าจอ ตรวจสอบ + บันทึก ให้เลือก เริ่มการถ่ายโอนข้อมูลทันที จากนั้นเลือก บันทึก + เรียกใช้

เมื่องานเสร็จสมบูรณ์ นําทางไปยัง lakehouse ของคุณ และดูตาราง delta ที่แสดงรายการภายใต้ /โฟลเดอร์ตาราง

คลิกขวาบนชื่อตารางที่สร้างขึ้น เลือก คุณสมบัติ และคัดลอกเส้นทางระบบไฟล์ Azure Blob (ABFS)

เปิดสมุดบันทึก Azure Databricks ของคุณ อ่านตาราง Delta บน OneLake

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)อัปเดตข้อมูลตาราง Delta โดยการเปลี่ยนค่าเขตข้อมูล

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;