Använda Hive-metaarkiv med Apache Flink® DataStream API

Viktig

Azure HDInsight på AKS drogs tillbaka den 31 januari 2025. Läs mer i det här meddelandet.

Du måste migrera dina arbetsbelastningar till Microsoft Fabric- eller en motsvarande Azure-produkt för att undvika plötsliga uppsägningar av dina arbetsbelastningar.

Viktig

Den här funktionen är för närvarande i förhandsversion. De kompletterande användningsvillkoren för Förhandsversioner av Microsoft Azure innehåller fler juridiska villkor som gäller för Azure-funktioner som är i betaversion, förhandsversion eller annars ännu inte är allmänt tillgängliga. Information om den här specifika förhandsversionen finns i Azure HDInsight på AKS-förhandsversionsinformation. Om du har frågor eller funktionsförslag, skicka en begäran på AskHDInsight med informationen och följ oss för fler uppdateringar i Azure HDInsight Community.

Under årens lopp har Hive Metastore utvecklats till ett de facto-metadatacenter i Hadoop-ekosystemet. Många företag har en separat Hive Metastore-tjänstinstans i sina produktionsmiljöer för att hantera alla sina metadata (Hive- eller icke-Hive-metadata). För användare som har både Hive- och Flink-distributioner gör HiveCatalog det möjligt för dem att använda Hive Metastore för att hantera Flinks metadata.

Hive-versioner som stöds för Apache Flink-kluster i HDInsight på AKS

Hive-version som stöds:

- 3.1

- 3.1.0

- 3.1.1

- 3.1.2

- 3.1.3

Om du skapar ett eget program behöver du följande beroenden i mvn-filen. Det rekommenderas inte att inkludera dessa beroenden i den resulterande jar-filen. Du ska lägga till beroenden vid körning.

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-table-api-java-bridge -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-api-java-bridge</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-connector-hive -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-hive_2.12</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-table-planner -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-planner_2.12</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

Ansluta till Hive

Det här exemplet illustrerar olika kodfragment för att ansluta till hive, med hjälp av Apache Flink i HDInsight på AKS, måste du använda /opt/hive-conf som hive-konfigurationskatalog för att ansluta till Hive-metaarkiv

package contoso.example;

import org.apache.flink.streaming.api.TimeCharacteristic;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.catalog.hive.HiveCatalog;

public class hiveDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// start Table Environment

StreamTableEnvironment tableEnv =

StreamTableEnvironment.create(env);

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

String catalogName = "myhive";

String defaultDatabase = HiveCatalog.DEFAULT_DB;

String hiveConfDir = "/opt/hive-conf";

HiveCatalog hive = new HiveCatalog(catalogName, defaultDatabase, hiveConfDir);

// register HiveCatalog in the tableEnv

tableEnv.registerCatalog("myhive", hive);

// set the HiveCatalog as the current catalog of the session

tableEnv.useCatalog("myhive");

// Create a table in hive catalog

tableEnv.executeSql("create table MyTable (name varchar(32), age int) with ('connector' = 'filesystem', 'path' = 'abfs://flink@contosogen2.dfs.core.windows.net/data/', 'format' = 'csv','csv.field-delimiter' = ',')");

// Create a view in hive catalog

tableEnv.executeSql("create view MyView as select * from MyTable");

// Read from the table and print the results

tableEnv.from("MyTable").execute().print();

// 4. run stream

env.execute("Hive Demo on Flink");

}

}

På Webssh-podden flyttar du planner-jar-filen

Flytta jar-flink-table-planner-loader-1.17.0-*.*.*.jar som finns i /opt to /lib av webssh-poden och flytta ut jar-flink-table-planner-loader-1.17.0-*.*.*.jar från lib. Se till ärendet för fler detaljer. Utför följande steg för att flytta planner-jar-filen.

mv /opt/flink-webssh/lib/flink-table-planner-loader-1.17.0-1.1.8.jar /opt/flink-webssh/opt/

mv /opt/flink-webssh/opt/flink-table-planner_2.12-1.17.0-1.1.8.jar /opt/flink-webssh/lib/

Obs

Du behöver bara flytta en extra planner-jar när du använder Hive-dialekten eller HiveServer2-slutpunkten. Detta är dock den rekommenderade konfigurationen för Hive-integrering.

Mer information finns i Använda Hive Catalog med Apache Flink® i HDInsight på AKS

Paketera jar-filen och ladda upp den till Webssh och kör den

user@sshnode-0 [ ~ ]$ bin/flink run -c contoso.example.hiveDemo -j FlinkSQLServerCDCDemo-1.0-SNAPSHOT.jar

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/flink-webssh/lib/log4j-slf4j-impl-2.17.1.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/hadoop/flink-hadoop-dep-1.17.0-1.1.8.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Job has been submitted with JobID 5c887e1f8e1bfac501168c439a83788f

+----+--------------------------------+-------------+

| op | name | age |

+----+--------------------------------+-------------+

| +I | Jack | 18 |

| +I | mike | 24 |

+----+--------------------------------+-------------+

2 rows in set

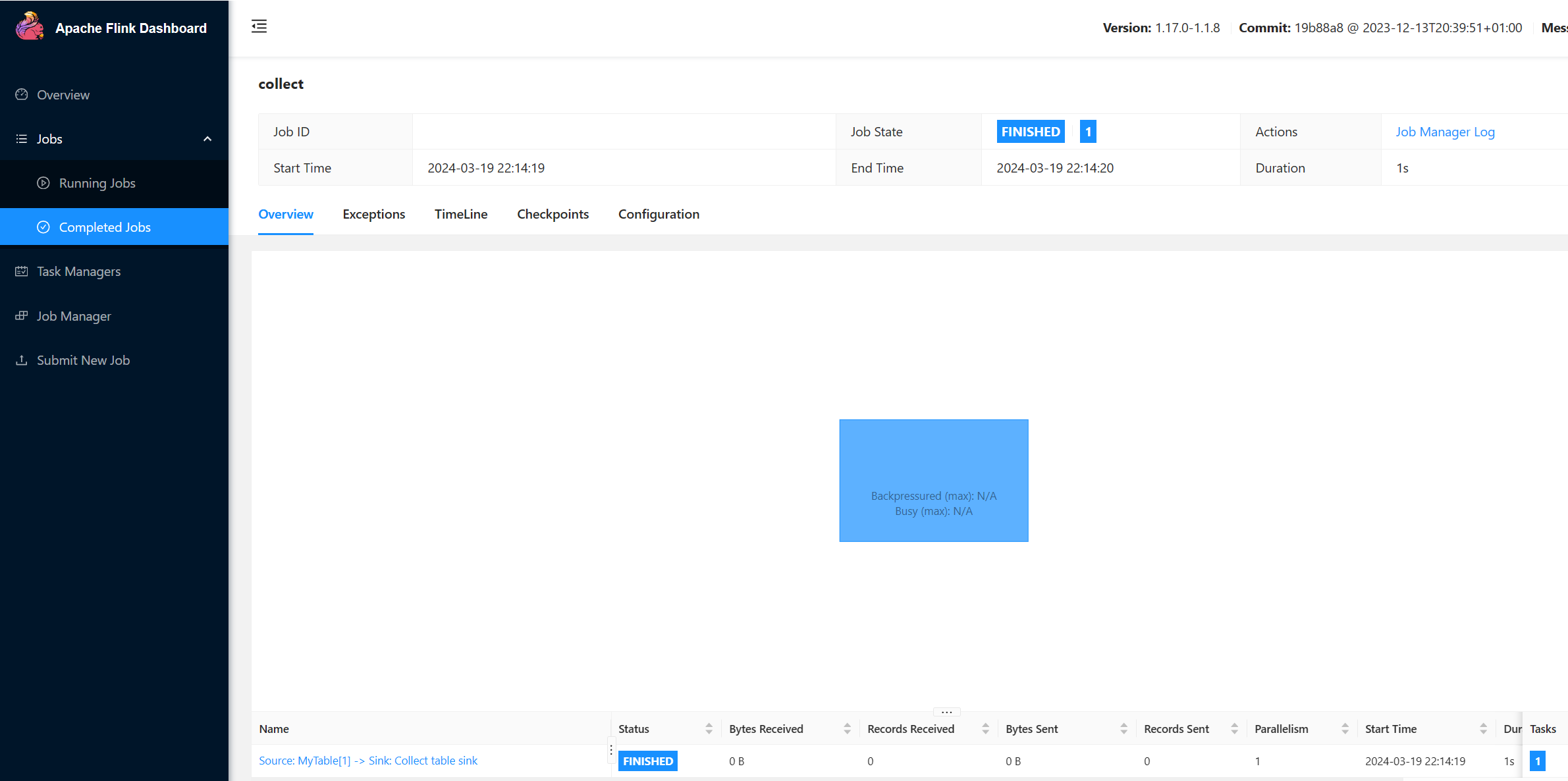

Kontrollera jobb som körs på Flink UI

Kontrollera tabellen i Webssh-användargränssnittet via sql-client.sh

user@sshnode-0 [ ~ ]$ bin/sql-client.sh

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/flink-webssh/lib/log4j-slf4j-impl-2.17.1.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/hadoop/flink-hadoop-dep-1.17.0-1.1.8.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

????????

????????????????

??????? ??????? ?

???? ????????? ?????

??? ??????? ?????

??? ??? ?????

?? ???????????????

?? ? ??? ?????? ?????

????? ???? ????? ?????

??????? ??? ??????? ???

????????? ?? ?? ??????????

???????? ?? ? ?? ???????

???? ??? ? ?? ???????? ?????

???? ? ?? ? ?? ???????? ???? ??

???? ???? ?????????? ??? ?? ????

???? ?? ??? ??????????? ???? ? ? ???

??? ?? ??? ????????? ???? ???

?? ? ??????? ???????? ??? ??

??? ??? ???????????????????? ???? ?

????? ??? ?????? ???????? ???? ??

???????? ??????????????? ??

?? ???? ??????? ??? ?????? ?? ???

??? ??? ??? ??????? ???? ?????????????

??? ????? ???? ?? ?? ???? ???

?? ??? ? ?? ?? ??

?? ?? ?? ?? ????????

?? ????? ?? ??????????? ??

?? ???? ? ??????? ??

??? ????? ?? ???????????

???? ???? ??????? ????????

????? ?? ???? ?????

????????????????????????????????? ?????

______ _ _ _ _____ ____ _ _____ _ _ _ BETA

| ____| (_) | | / ____|/ __ \| | / ____| (_) | |

| |__ | |_ _ __ | | __ | (___ | | | | | | | | |_ ___ _ __ | |_

| __| | | | '_ \| |/ / \___ \| | | | | | | | | |/ _ \ '_ \| __|

| | | | | | | | < ____) | |__| | |____ | |____| | | __/ | | | |_

|_| |_|_|_| |_|_|\_\ |_____/ \___\_\______| \_____|_|_|\___|_| |_|\__|

Welcome! Enter 'HELP;' to list all available commands. 'QUIT;' to exit.

Command history file path: /home/xcao/.flink-sql-history

Flink SQL> CREATE CATALOG myhive WITH (

> 'type' = 'hive'

> );

[INFO] Execute statement succeed.

Flink SQL> USE CATALOG myhive;

[INFO] Execute statement succeed.

Flink SQL> show tables

> ;

+------------+

| table name |

+------------+

| mytable |

| myview |

+------------+

2 rows in set

Flink SQL> SET 'sql-client.execution.result-mode' = 'tableau';

[INFO] Execute statement succeed.

Flink SQL> select * from mytable;

+----+--------------------------------+-------------+

| op | name | age |

+----+--------------------------------+-------------+

| +I | Jack | 18 |

| +I | mike | 24 |

+----+--------------------------------+-------------+

Received a total of 2 rows

Referenser

- Hive läsa & skriva

- Apache, Apache Hive, Hive, Apache Flink, Flink och associerade projektnamn med öppen källkod är varumärken av Apache Software Foundation (ASF).