Mata in data i OneLake och analysera med Azure Databricks

I den här guiden kommer du att:

Skapa en pipeline på en arbetsyta och mata in data i din OneLake i Delta-format.

Läsa och ändra en Delta-tabell i OneLake med Azure Databricks.

Förutsättningar

Innan du börjar måste du ha:

En arbetsyta med ett Lakehouse-objekt.

En Premium Azure Databricks-arbetsyta. Endast Premium Azure Databricks-arbetsytor stöder genomströmning av Microsoft Entra-autentiseringsuppgifter. När du skapar klustret aktiverar du genomströmning av Azure Data Lake Storage-autentiseringsuppgifter i avancerade alternativ.

En exempeldatauppsättning.

Mata in data och ändra Delta-tabellen

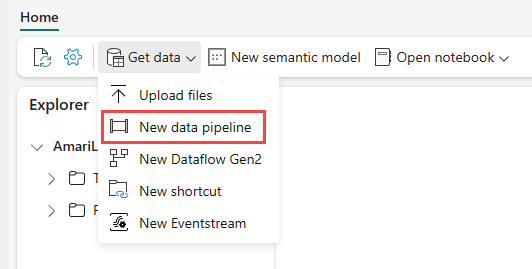

Gå till lakehouse i Power BI-tjänst och välj Hämta data och välj sedan Ny datapipeline.

I kommandotolken Ny pipeline anger du ett namn för den nya pipelinen och väljer sedan Skapa.

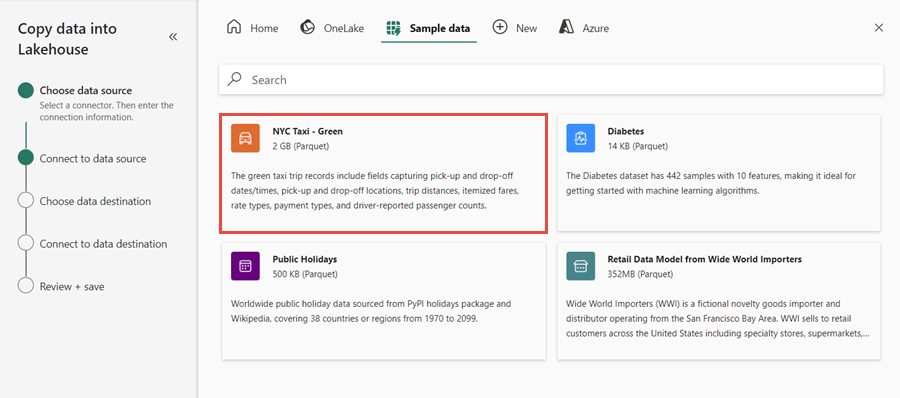

I den här övningen väljer du exempeldata för NYC Taxi – Green som datakälla och väljer sedan Nästa.

På förhandsgranskningsskärmen väljer du Nästa.

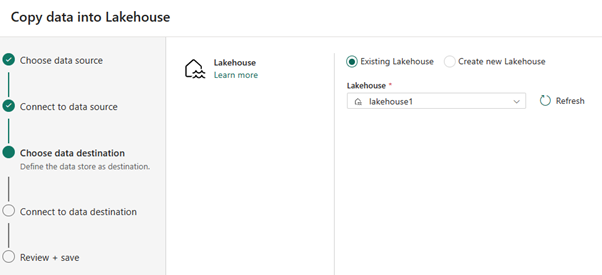

För datamål väljer du namnet på det sjöhus som du vill använda för att lagra OneLake Delta-tabelldata. Du kan välja ett befintligt sjöhus eller skapa ett nytt.

Välj var du vill lagra utdata. Välj Tabeller som rotmapp och ange "nycsample" som tabellnamn.

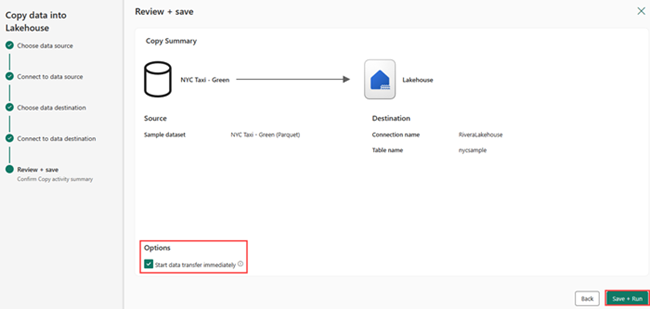

På skärmen Granska + Spara väljer du Starta dataöverföring omedelbart och väljer sedan Spara + Kör.

När jobbet är klart navigerar du till ditt lakehouse och visar deltatabellen som visas under mappen /Tables.

Högerklicka på det skapade tabellnamnet, välj Egenskaper och kopiera sökvägen Azure Blob Filesystem (ABFS).

Öppna din Azure Databricks-notebook-fil. Läs deltatabellen på OneLake.

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)Uppdatera Delta-tabelldata genom att ändra ett fältvärde.

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;