Så här importerar du data till Fabric med hjälp av kopieringsaktiviteten i Azure Data Factory.

Microsoft Fabric Lakehouse-anslutningsappen i Azure Data Factory (ADF) och Azure Synapse Analytics möjliggör både läs- och skrivåtgärder till Microsoft Fabric Lakehouse (både för tabeller och filer). Med den här anslutningsappen kan du använda dina befintliga ADF- och Synapse-pipelines och mappningsdataflöden för att interagera med Fabric Lakehouses. Den här artikeln hjälper dig att konfigurera Microsoft Fabric för att tillåta autentisering med tjänsthuvudnamn och demonstrerar sedan hur Lakehouse Connector används för både att läsa från och skriva till Fabric Lakehouse.

Mer information om Microsoft Fabric Lakehouse finns i Vad är ett sjöhus?

Azure Data Factory Lakehouse-koppling

En ny länkad tjänstanslutning för lakehouse och två nya datauppsättningar är nu tillgängliga för kunder som vill börja läsa från och skriva till Microsoft Fabric Lakehouse. En fullständig guide om Lakehouse Connector finns i Kopiera och transformera data i Microsoft Fabric Lakehouse Files (förhandsversion).

Autentisering

Länkad Azure Data Factory-tjänst

Microsoft Fabric Lakehouse-anslutningsappen kräver en tjänsthuvudnamn (SPN)/appregistrering för autentisering. För att komma igång måste du skapa ett nytt SPN eller använda ett befintligt. Microsoft Fabric ger SPN-åtkomst till antingen specifika säkerhetsgrupper eller för hela organisationen. Om en specifik säkerhetsgrupp är det alternativ som din organisation använder måste det SPN som används i Lakehouse-anslutningsappen tillhöra en säkerhetsgrupp som läggs till i listan över tillåtna.

Anteckning

Power BI API-behörigheter (delegerade) behövs inte

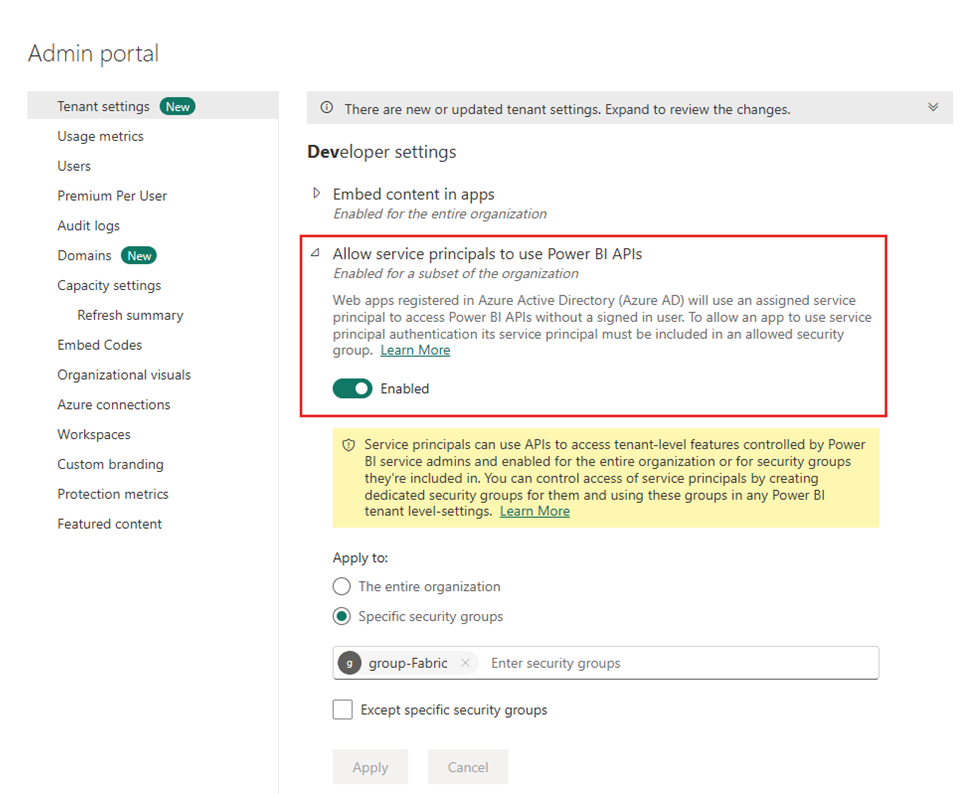

Åtkomst till Power BI-API:er

Från Power BI-administratörsportalen måste Power BI-klientadministratören aktivera Tillåt tjänstens huvudprincipaler att använda Power BI-API:er. Säkerhetsgruppen måste anges under inställningen Tillåt tjänstprincipaler att använda Power BI-API:er, eller så kan du aktivera det för hela organisationen.

En fullständig guide finns i Bädda in Power BI-innehåll i ett inbäddat analysprogram med tjänstens huvudnamn och en programhemlighet.

Not

När du tilldelar säkerhetsgruppen till arbetsytan kan det uppstå en fördröjning för tjänsthuvudnamn att beviljas åtkomst till arbetsytan på grund av cachelagring av behörigheter i Azure. Om du behöver omedelbar åtkomst kan du använda PowerShell för att framtvinga en uppdatering av användarens behörigheter. Det gör du genom att öppna PowerShell som administratör och sedan köra följande kommandon:

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Åtkomst till arbetsyta

När säkerhetsgruppen har lagts till måste säkerhetsgruppen eller tjänstens huvudnamn också läggas till i varje arbetsyta som medlem, deltagare eller administratör. Mer information finns i Ge användare åtkomst till arbetsytor.

Demo: Konfigurera autentisering

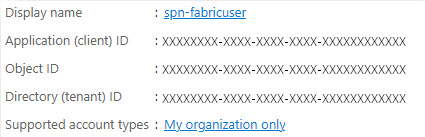

Tjänstens huvudnamn för appregistrering

Skapa eller använda ett befintligt huvudnamn för appregistreringstjänsten (SPN). Följ stegen i Registrera ett program med Microsoft Entra-ID och skapa ett huvudnamn för tjänsten.

Not

Du behöver inte tilldela en omdirigerings-URI.

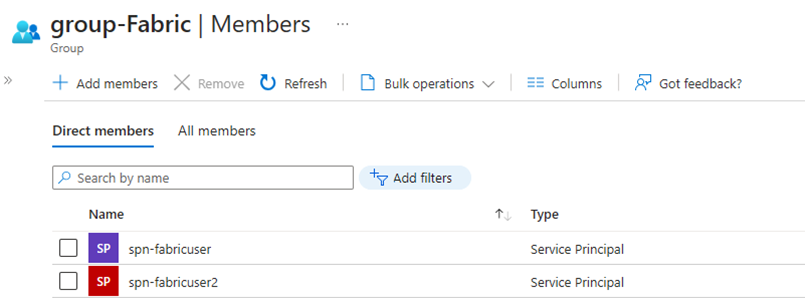

Säkerhetsgrupp

Skapa en ny Microsoft Entra-säkerhetsgrupp eller använd en befintlig och lägg sedan till SPN i den. Följ stegen i Skapa en grundläggande grupp och lägg till medlemmar för att skapa en Microsoft Entra-säkerhetsgrupp.

Power BI-administratörsportalen

I Power BI-administratörsportalengår du till Inställningar för utvecklare och väljer Tillåt att tjänstens huvudnamn använder Power BI-API:eroch aktiverar det. Lägg sedan till säkerhetsgruppen från föregående steg. Mer information om klientinställningarna för Power BI-administratörsportalen finns i Klientinställningar.

Notera

Kontrollera att inställningen Användare kan komma åt data som lagras i OneLake med appar utanför Fabric är aktiverad. Referera till Tillåt appar som körs utanför Fabric att komma åt data via OneLake.

Arbetsyta

Lägg till SPN eller tjänstgruppen till arbetsytan med Member, Contributoreller Admin åtkomst.

Azure Data Factory: Länkad tjänst

Skapa en ny Microsoft Fabric Lakehouse länkad tjänst från Azure Data Factory.

Notera

Om du vill hitta arbetsytan och Lakehouse-ID:t går du till Fabric Lakehouse och identifierar den från URL:en. Exempel: https://.../groups/<Arbetsyte-ID>>/lakehouses/<Lakehouse ID>

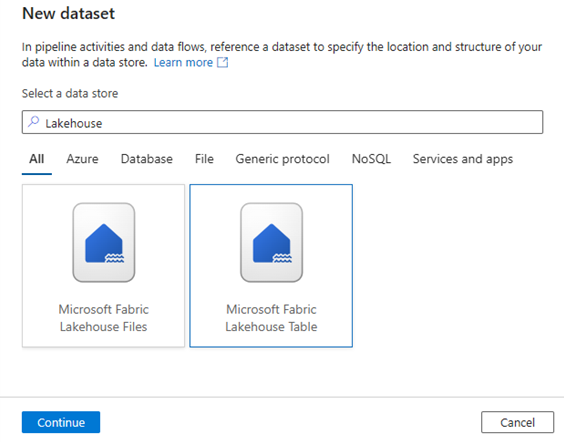

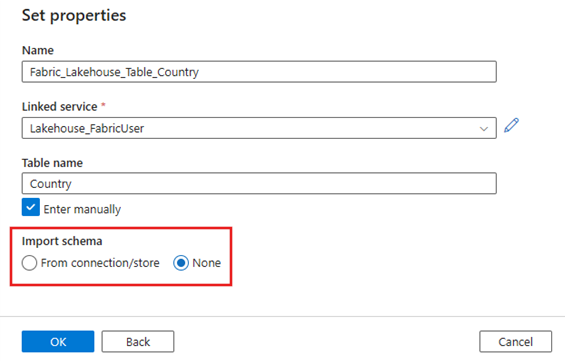

Azure Data Factory: Datauppsättning

Skapa en datauppsättning som refererar till den länkade Microsoft Fabric Lakehouse-tjänsten.

Anmärkning

Välj Ingen för alternativet Importera schema om tabellen inte finns ännu och du anger ett nytt tabellnamn manuellt.

Demo: Skriva till en Fabric Lakehouse-tabell med en ADF-pipeline

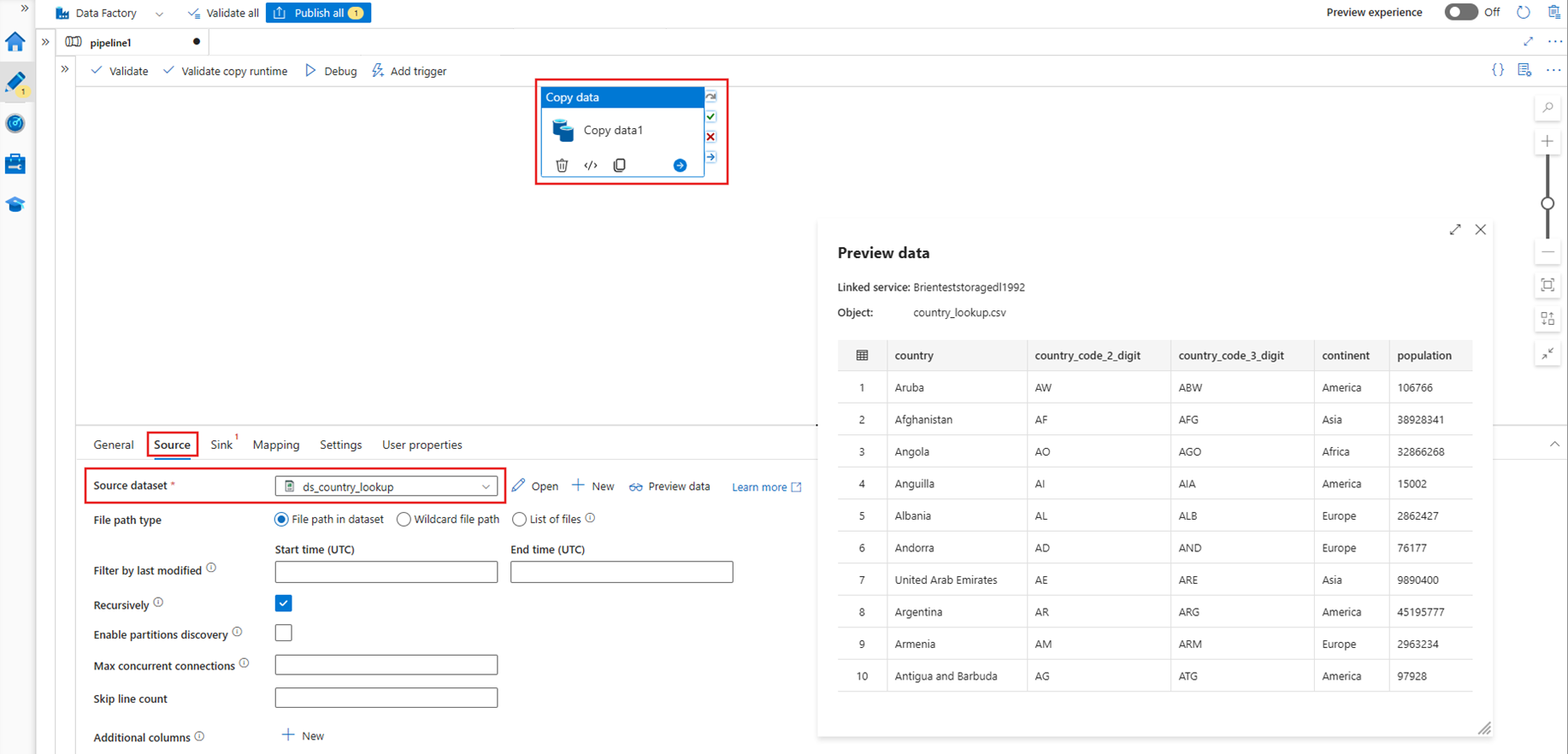

Källa

Skapa en ny pipeline och lägg till en kopieringsaktivitet på pipelinearbetsytan. På fliken Source i aktiviteten Kopiera väljer du en källdatauppsättning som du vill flytta till en Lakehouse-tabell. I det här exemplet refererar vi till en .csv fil från ett Azure Data Lake Storage-konto (ADLS) Gen2.

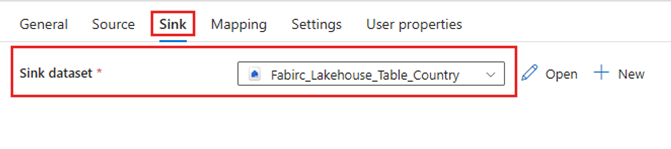

Sjunka

Gå till Kopiera-aktivitetens Destination-flik och välj datauppsättningen Fabric Lakehouse som skapades tidigare.

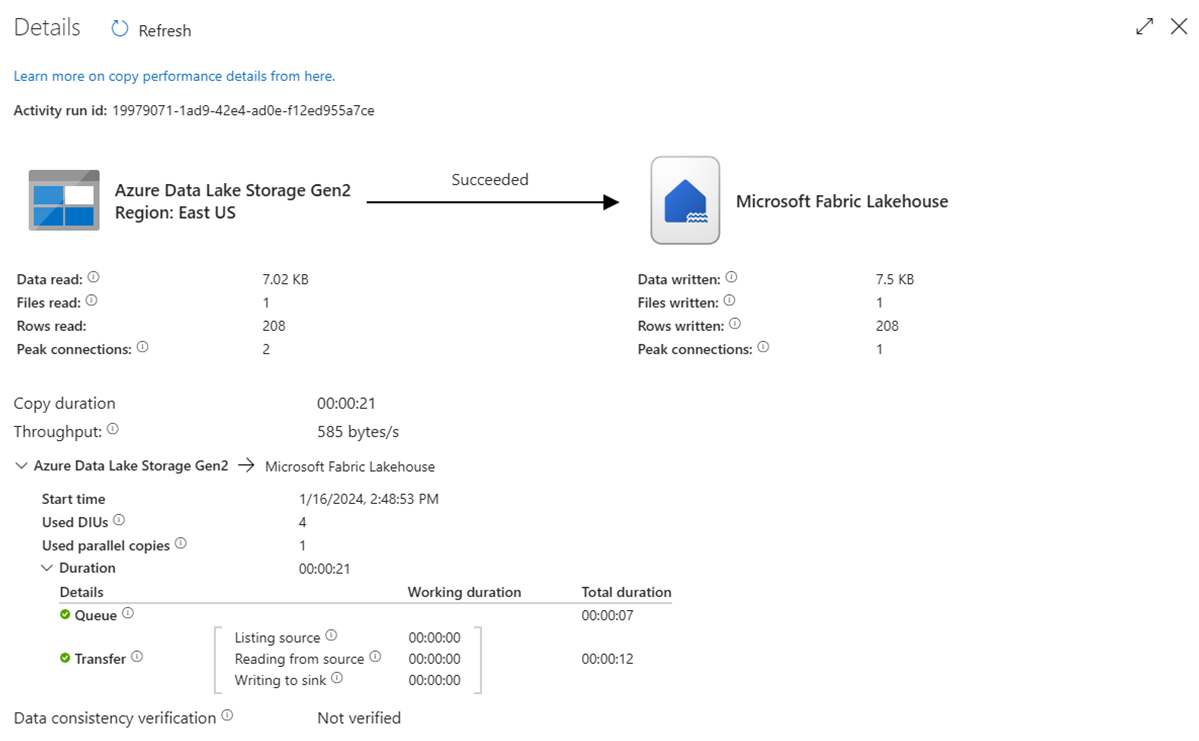

Kör pipelinen

Kör pipelinen för att flytta .csv data till tabellen Fabric Lakehouse.

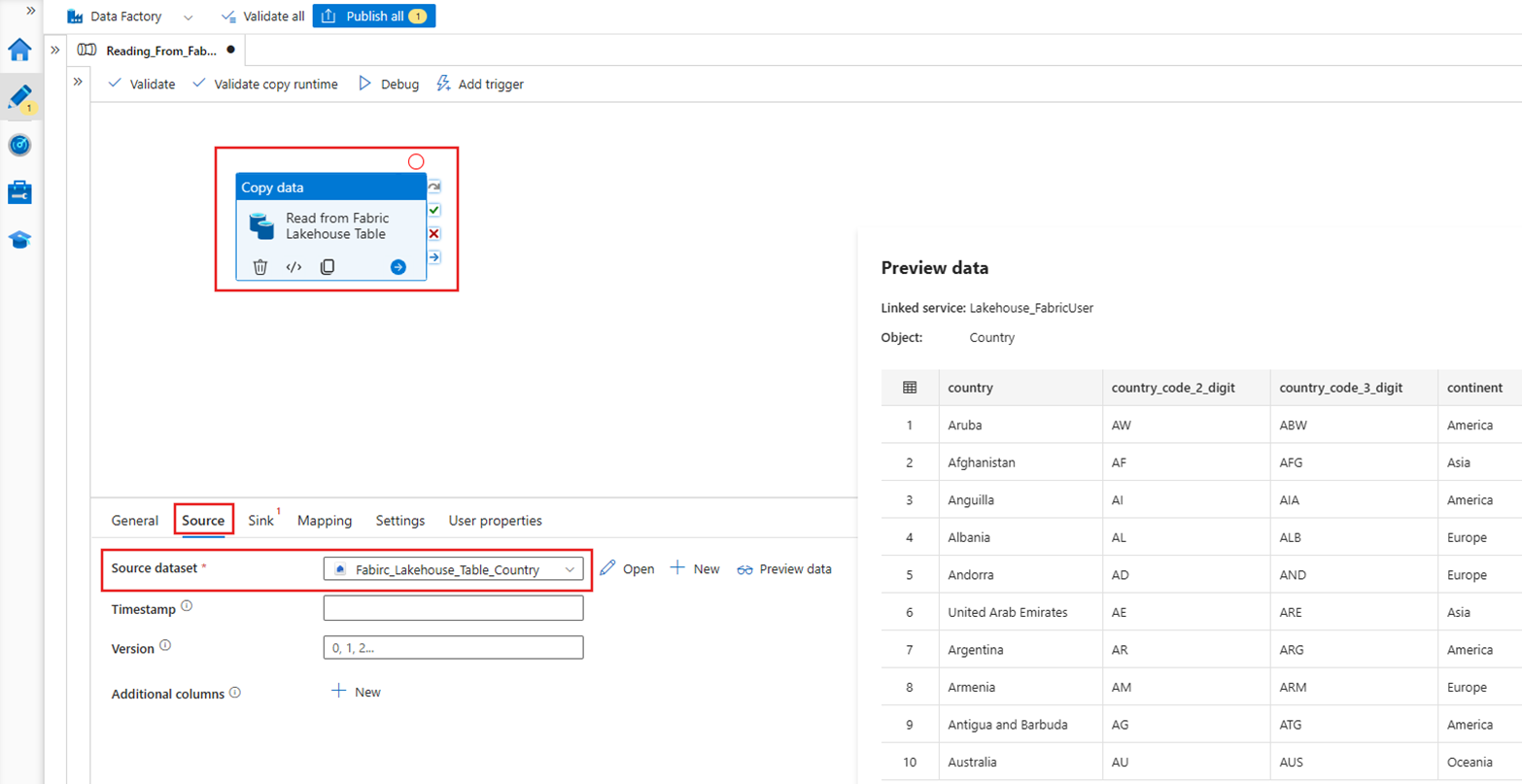

Demo: Läsa från en Fabric Lakehouse-tabell med en ADF-pipeline

I avsnittet ovan visade vi hur du använder ADF för att skriva till en Fabric Lakehouse-tabell. Nu ska vi läsa från en Fabric Lakehouse-tabell och skriva till en Parquet-fil i Azure Data Lake Storage (ADLS) Gen2 med en liknande pipeline.

Källa

Skapa en ny pipeline och lägg till en kopieringsaktivitet på pipelinearbetsytan. På fliken Källa i aktiviteten Kopiera väljer du datauppsättningen Fabric Lakehouse som skapades tidigare.

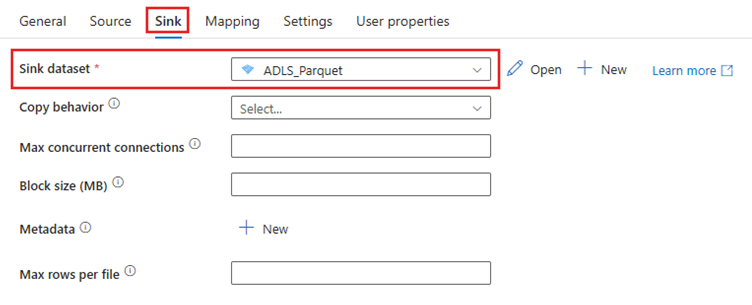

Sjunka

Gå till fliken Kopiera aktivitets mottagare och välj måldatauppsättningen. I det här exemplet är målplatsen Azure Data Lake Storage (Gen2), i form av en Parquet-fil.

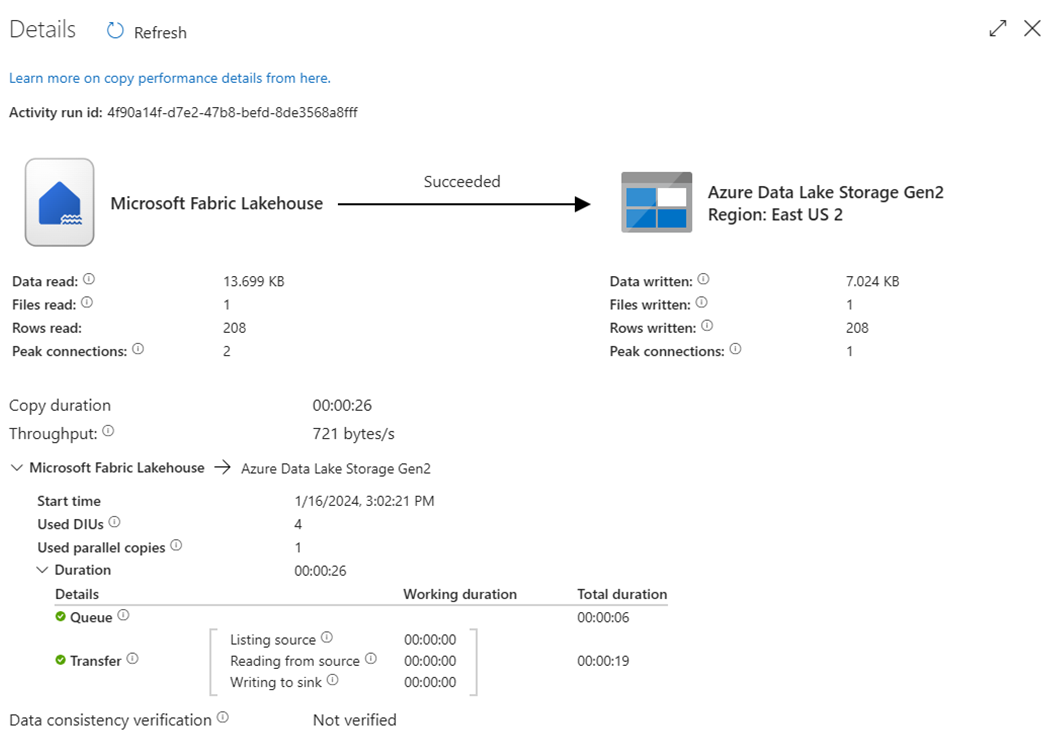

Kör pipelinen

Kör pipelinen för att flytta data från tabellen Fabric Lakehouse till Parquet-filen i ADLS Gen2.

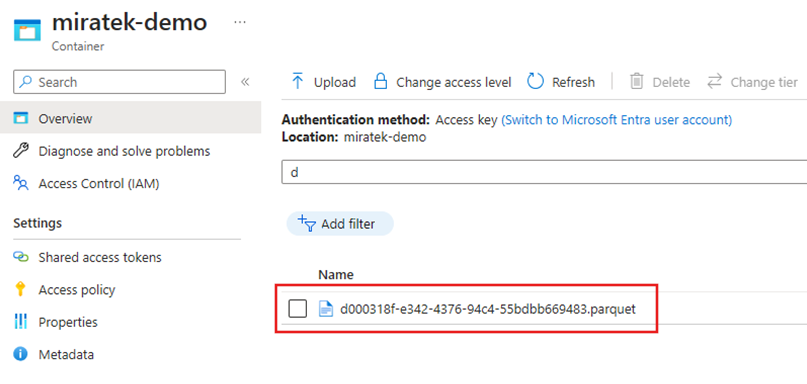

Inspektera Parquet-filen i ADLS Gen2

Data från tabellen Fabric Lakehouse är nu tillgängliga i ADLS Gen2 som en Parquet-fil.

Sammanfattning

I det här avsnittet utforskade vi kraven för Lakehouse Connector med autentisering med tjänstens huvudnamn till en Microsoft Fabric Lakehouse och gick sedan igenom ett exempel på hur man läser från och skriver till Lakehouse från en Azure Data Factory-pipeline. Den här anslutningsappen och funktionerna är också tillgängliga i Azure Data Factory Mapping Data Flows, Azure Synapse Analytics och Azure Synapse Analytics Mapping Data Flows.