Så här kommer du åt lokala datakällor i Data Factory för Microsoft Fabric

Data Factory för Microsoft Fabric är en kraftfull molnbaserad dataintegreringstjänst som gör att du kan skapa, schemalägga och hantera arbetsflöden för olika datakällor. I scenarier där dina datakällor finns lokalt tillhandahåller Microsoft den lokala datagatewayen för att på ett säkert sätt överbrygga klyftan mellan din lokala miljö och molnet. Det här dokumentet vägleder dig genom processen att komma åt lokala datakällor i Data Factory för Microsoft Fabric med hjälp av den lokala datagatewayen.

Skapa en lokal datagateway

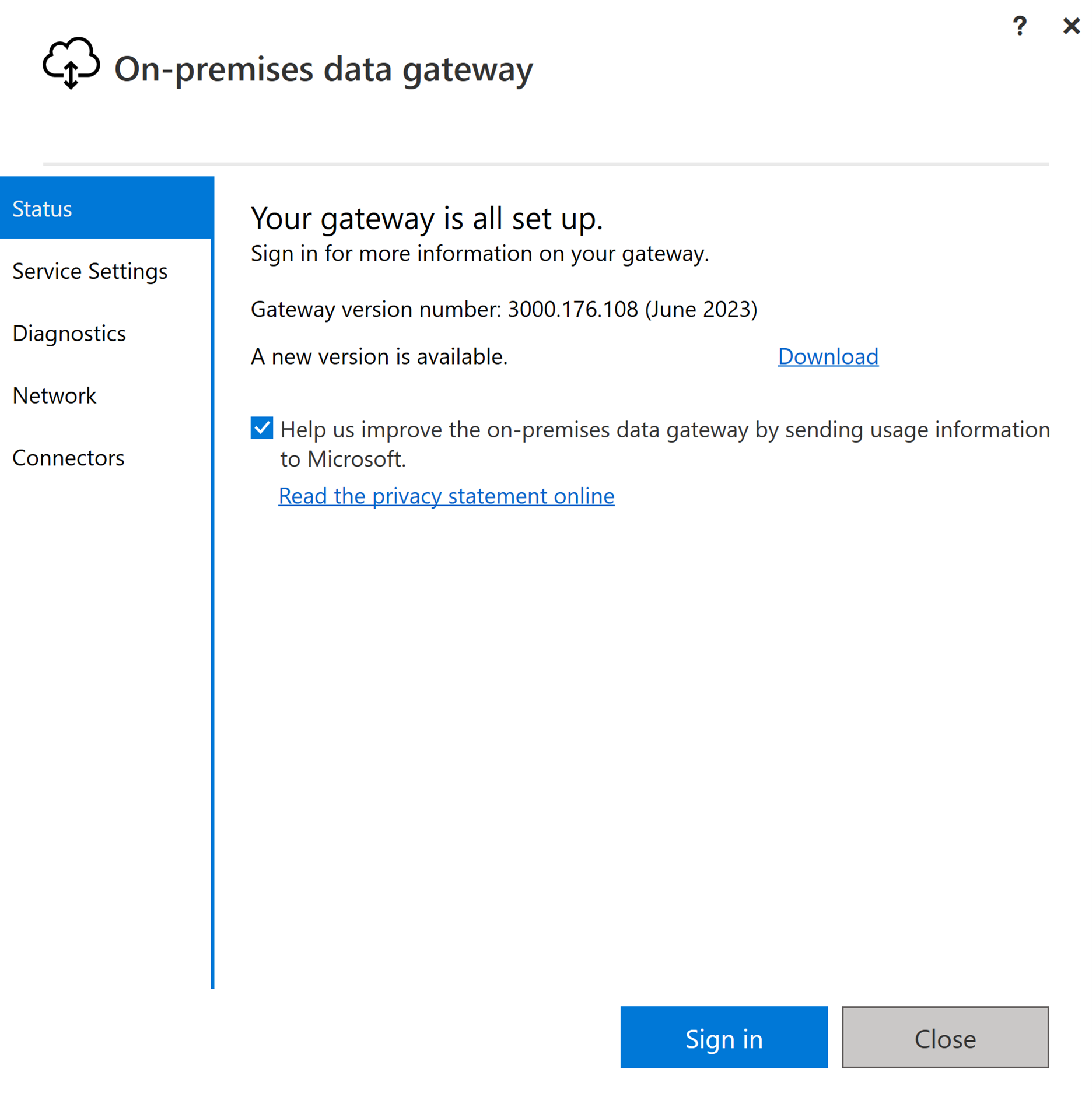

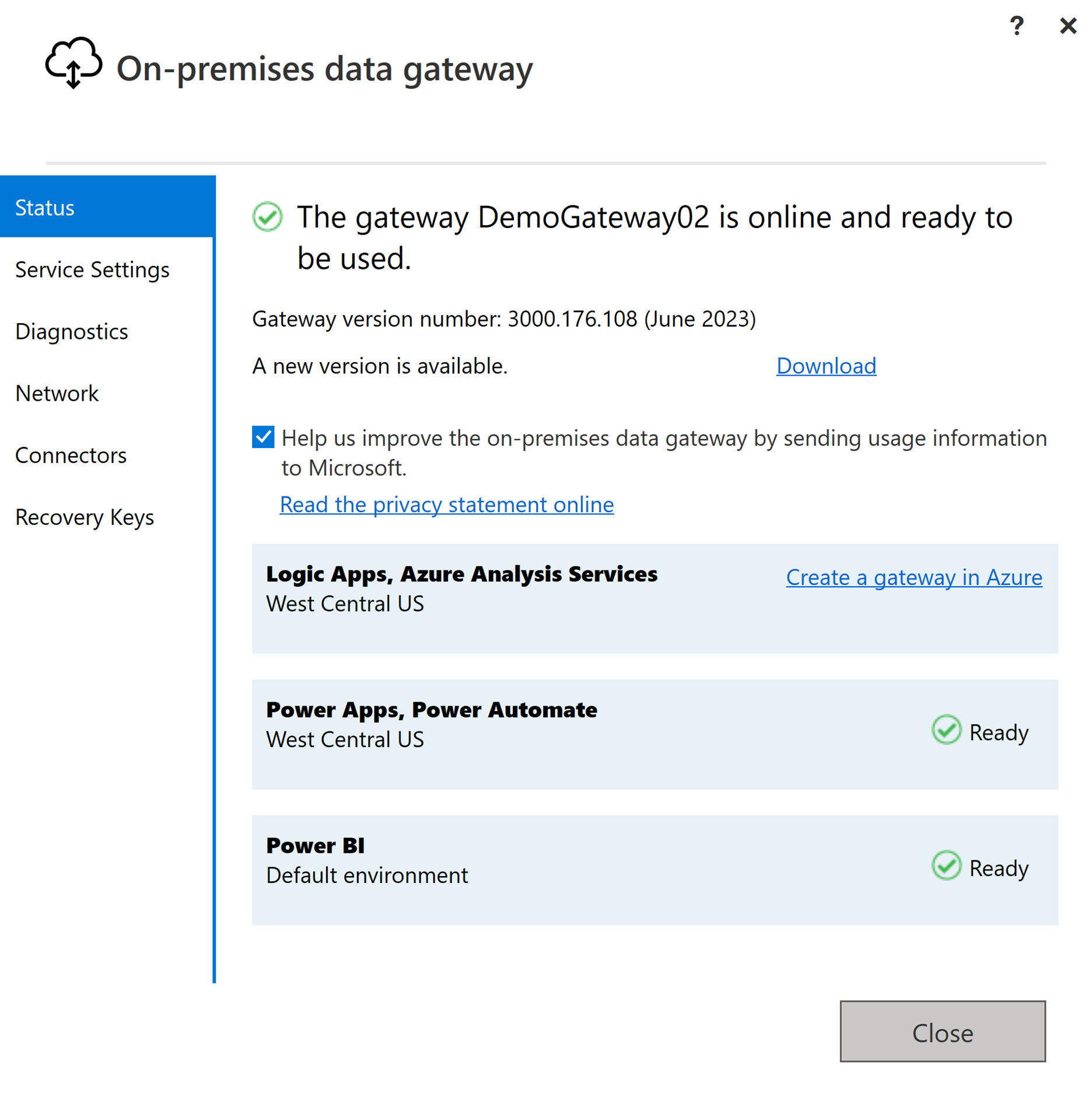

En lokal datagateway är ett program som är utformat för att installeras i en lokal nätverksmiljö. Det ger ett sätt att installera gatewayen direkt på din lokala dator. Detaljerade anvisningar om hur du laddar ned och installerar den lokala datagatewayen finns i Installera en lokal datagateway.

Logga in med ditt användarkonto för att få åtkomst till den lokala datagatewayen, varefter den är förberedd för användning.

Kommentar

En lokal datagateway med en högre version än eller lika med 3000.214.2 krävs för att stödja Infrastruktur-pipelines.

Skapa en anslutning för din lokala datakälla

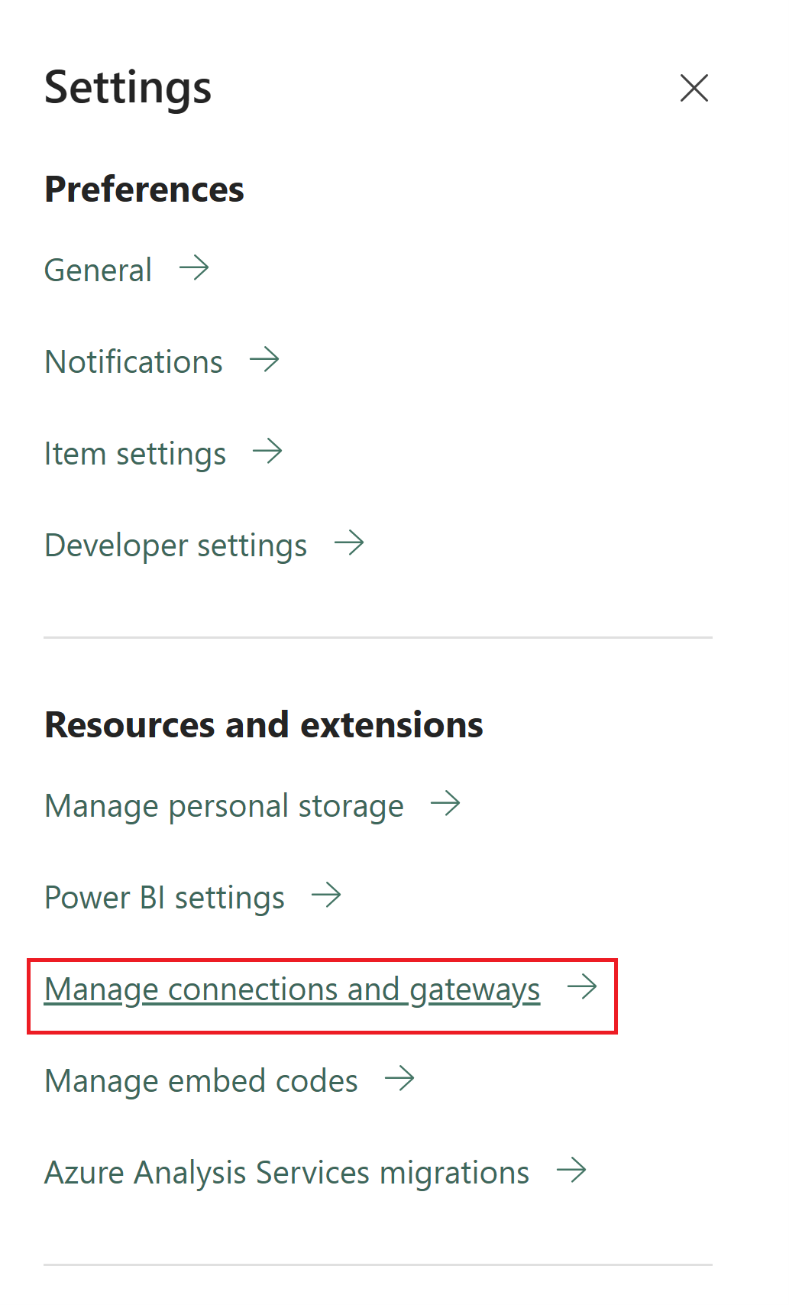

Gå till administratörsportalen och välj inställningsknappen (en ikon som ser ut som en kugghjul) längst upp till höger på sidan. Välj sedan Hantera anslutningar och gatewayer på den nedrullningsbara menyn som visas.

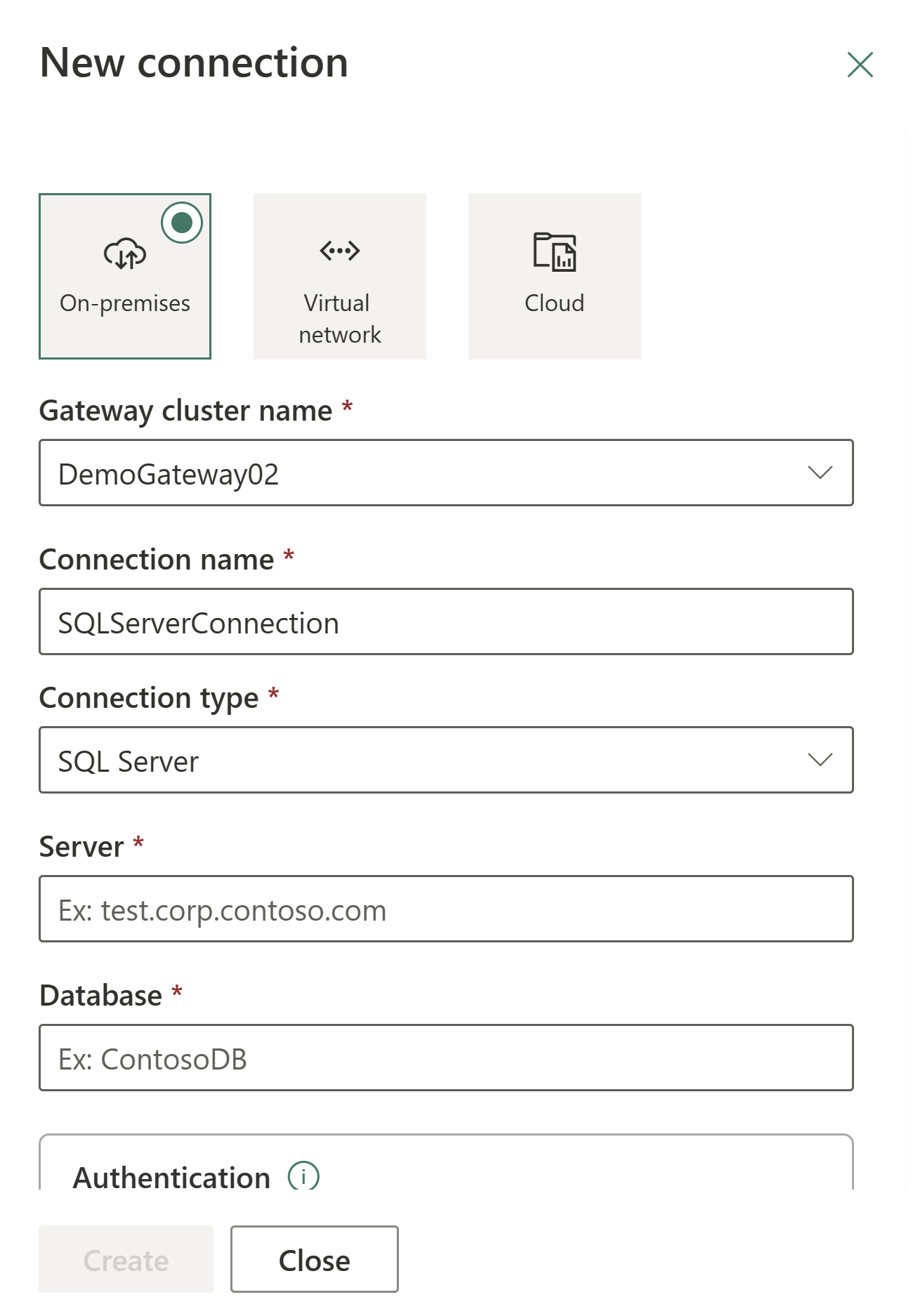

I dialogrutan Ny anslutning som visas väljer du Lokalt och anger sedan ditt gatewaykluster, tillsammans med den associerade resurstypen och relevant information.

Tillgängliga anslutningstyper som stöds för lokala anslutningar är:

- Entra-ID

- Adobe Analytics

- Analysis Services

- Azure Blob Storage

- Azure Data Lake Storage Gen2

- Azure Table Storage

- Essbase

- Fil

- Mapp

- Google Analytics

- IBM DB2

- MySQL

- OData

- ODBC

- OLE DB

- Oracle

- PostgreSQL

- Salesforce

- SAP Business Warehouse Message Server

- SAP Business Warehouse Server

- SAP HANA

- SharePoint

- SQL Server

- Sybase

- Teradata

- Webb

En omfattande lista över anslutningsappar som stöds för lokala datatyper finns i Anslutningsappar för datapipelines i Microsoft Fabric.

Ansluta din lokala datakälla till ett Dataflöde Gen2 i Data Factory för Microsoft Fabric

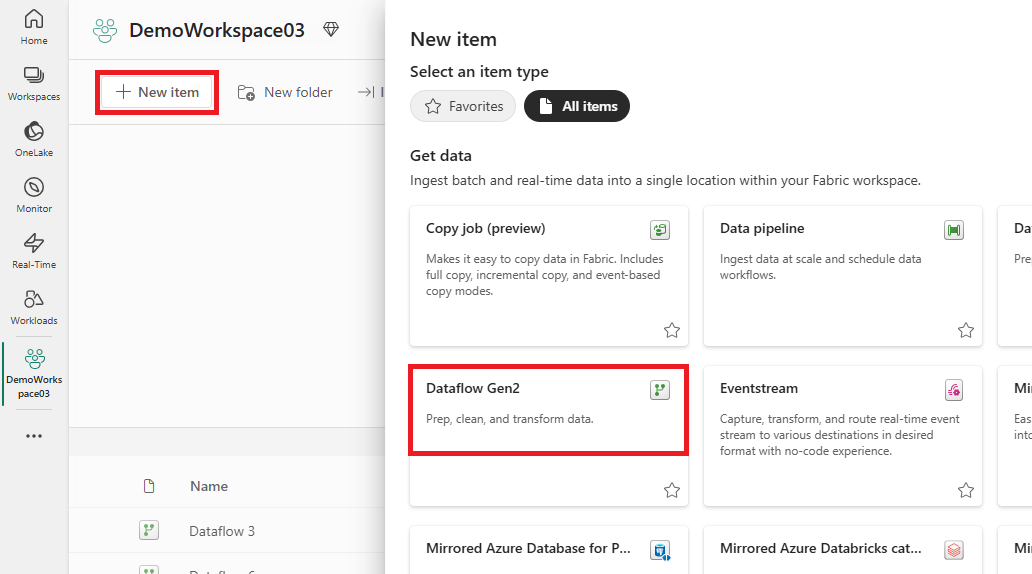

Gå till din arbetsyta och skapa ett Dataflöde Gen2.

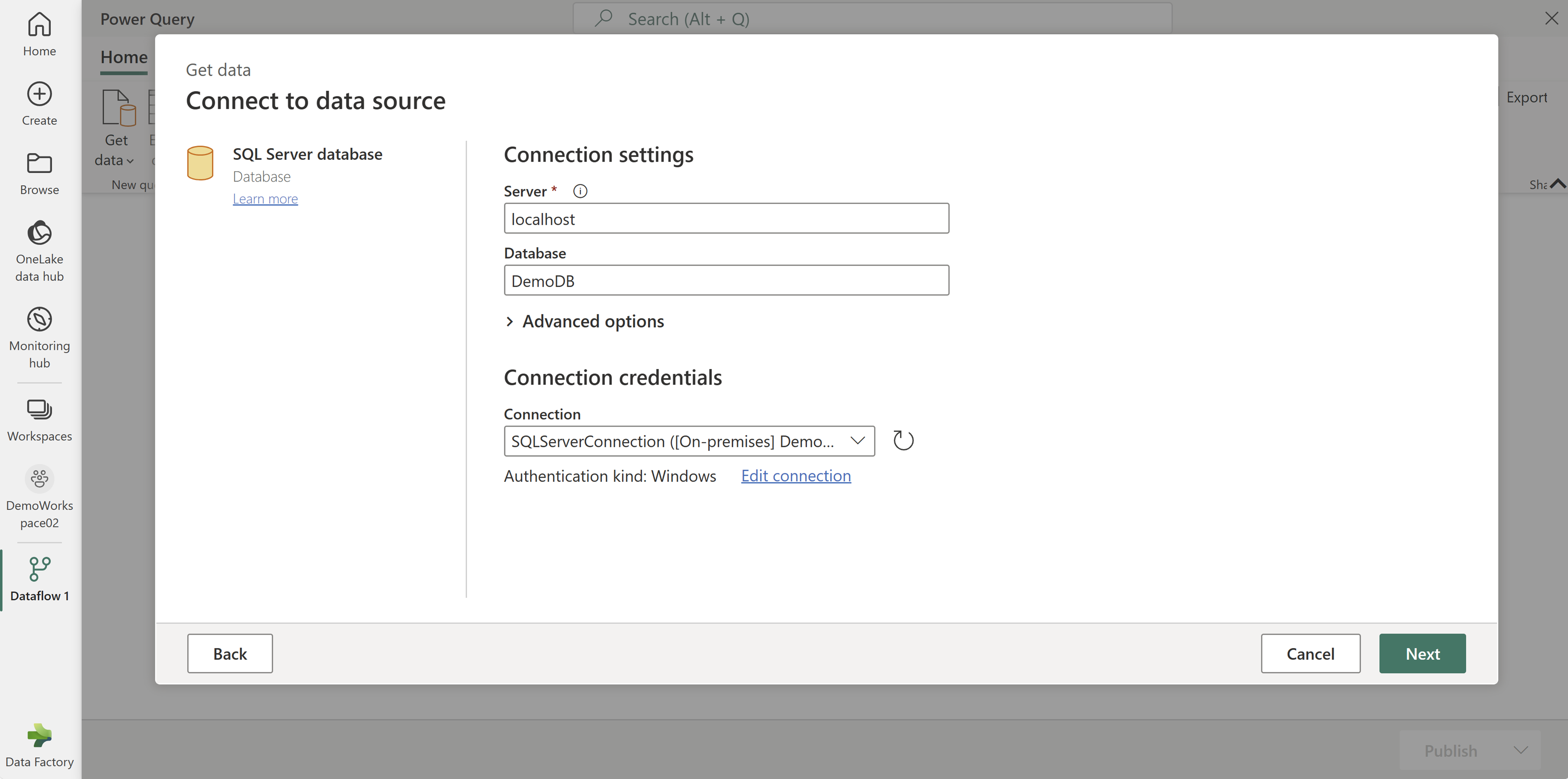

Lägg till en ny källa i dataflödet och välj den anslutning som upprättades i föregående steg.

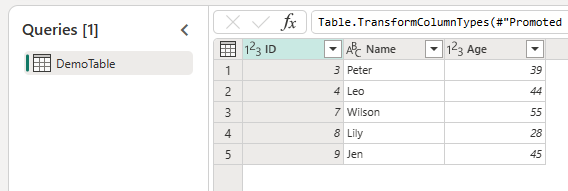

Du kan använda Dataflöde Gen2 för att utföra nödvändiga datatransformeringar baserat på dina krav.

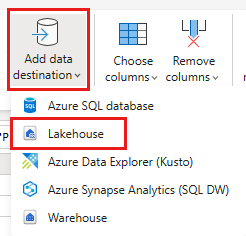

Använd knappen Lägg till datamål på fliken Start i Power Query-redigeraren för att lägga till ett mål för dina data från den lokala källan.

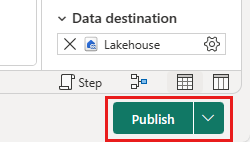

Publicera Dataflöde Gen2.

Nu har du skapat ett Dataflöde Gen2 för att läsa in data från en lokal datakälla till ett molnmål.

Använda lokala data i en pipeline

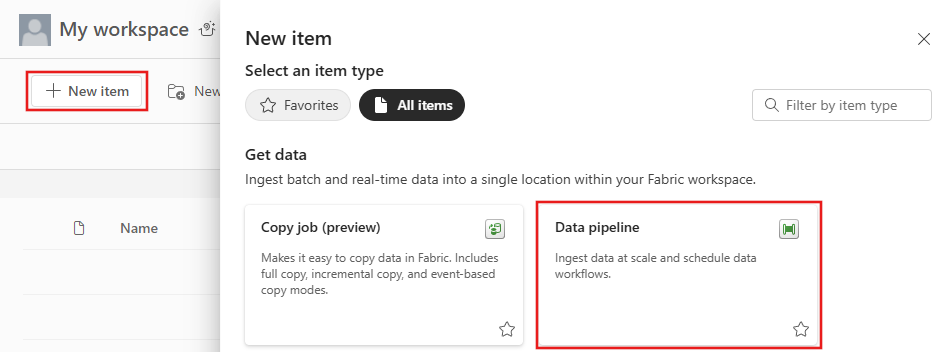

Gå till din arbetsyta och skapa en datapipeline.

Kommentar

Du måste konfigurera brandväggen för att tillåta utgående anslutningar *.frontend.clouddatahub.net från gatewayen för Infrastruktur-pipelinefunktioner.

På fliken Start i pipelineredigeraren väljer du Kopiera data och sedan Använd kopieringsassistenten. Lägg till en ny källa till aktiviteten på sidan Välj datakälla i assistenten och välj sedan anslutningen som upprättades i föregående steg.

Välj ett mål för dina data från den lokala datakällan.

Köra pipelinen.

Nu har du skapat och kört en pipeline för att läsa in data från en lokal datakälla till ett molnmål.

Kommentar

Lokal åtkomst till datorn med den lokala datagatewayen installerad tillåts inte i datapipelines.