Infrastrukturkörning 1.3 (GA)

Infrastrukturkörning erbjuder en sömlös integrering med Azure. Det ger en sofistikerad miljö för både datateknik och datavetenskapsprojekt som använder Apache Spark. Den här artikeln innehåller en översikt över de viktigaste funktionerna och komponenterna i Fabric Runtime 1.3, den senaste körningen för stordataberäkningar.

Microsoft Fabric Runtime 1.3 är den senaste GA-körningsversionen och innehåller följande komponenter och uppgraderingar som är utformade för att förbättra dina databehandlingsfunktioner:

- Apache Spark 3.5

- Operativsystem: Mariner 2.0

- Java: 11

- Scala: 2.12.17

- Python: 3.11

- Delta lake: 3.2

- R: 4.4.1

Dricks

Fabric Runtime 1.3 har stöd för den interna körningsmotorn, vilket avsevärt kan förbättra prestandan utan extra kostnader. Om du vill aktivera den inbyggda körningsmotorn för alla jobb och notebook-filer i din miljö går du till miljöinställningarna, väljer Spark-beräkning, går till fliken Acceleration och markerar Aktivera inbyggd körningsmotor. När du har sparat och publicerat används den här inställningen i hela miljön, så alla nya jobb och notebook-filer ärver automatiskt och drar nytta av de förbättrade prestandafunktionerna.

Använd följande instruktioner för att integrera runtime 1.3 i din arbetsyta och använda dess nya funktioner:

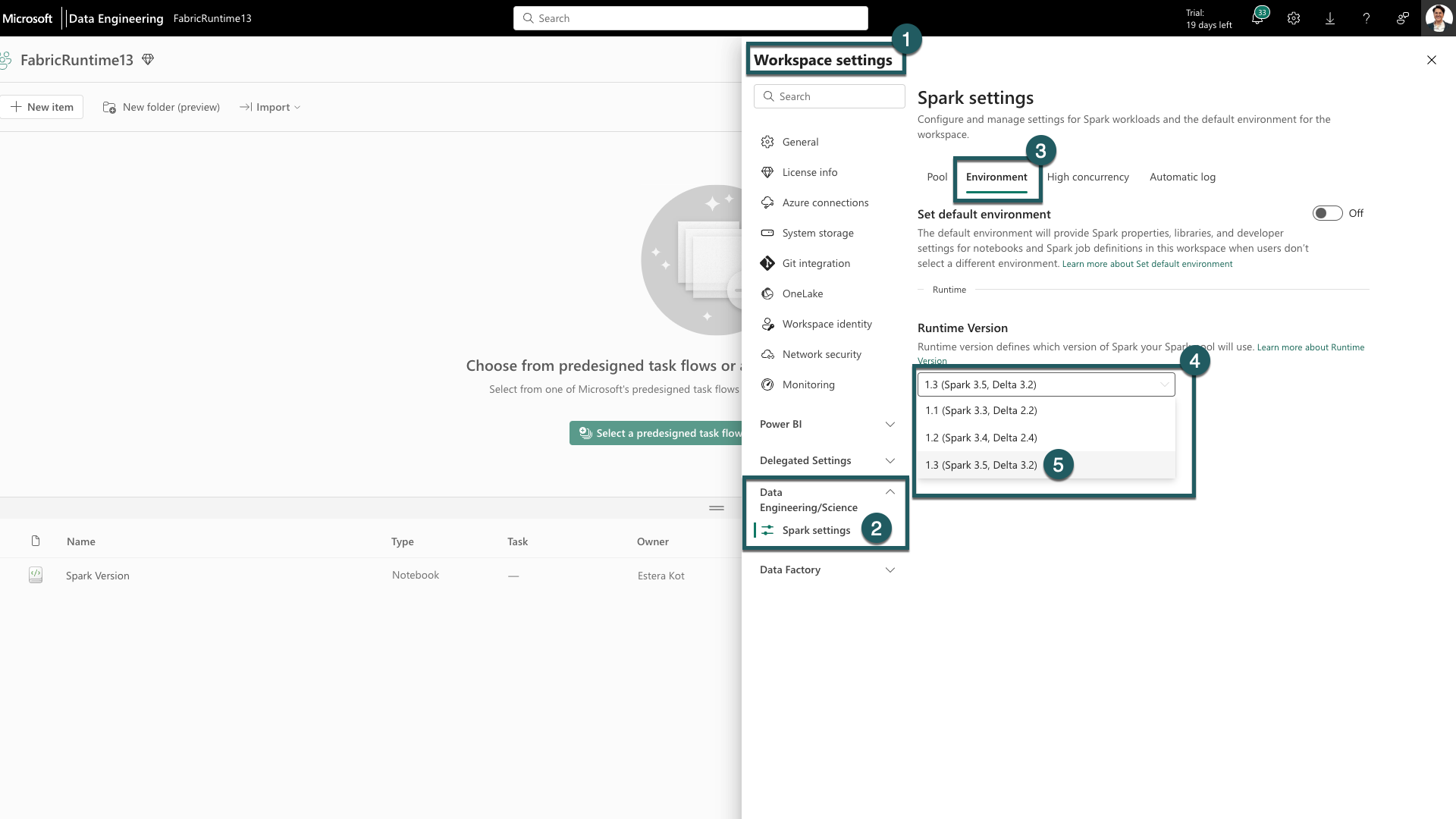

- Gå till fliken Inställningar för arbetsyta i arbetsytan Infrastruktur.

- Gå till fliken Dataingenjör ing/vetenskap och välj Spark-inställningar.

- Välj fliken Miljö.

- Under Körningsversioner expanderar du listrutan.

- Välj 1.3 (Spark 3.5, Delta 3.2) och spara ändringarna. Den här åtgärden anger 1.3 som standardkörning för din arbetsyta.

Nu kan du börja arbeta med de senaste förbättringarna och funktionerna som introducerades i Fabric Runtime 1.3 (Spark 3.5 och Delta Lake 3.2).

Viktiga höjdpunkter

Apache Spark 3.5

Apache Spark 3.5.0 är den sjätte versionen i 3.x-serien. Den här versionen är en produkt av omfattande samarbete inom communityn med öppen källkod som hanterar mer än 1 300 problem som registrerats i Jira.

I den här versionen finns det en uppgradering av kompatibiliteten för strukturerad direktuppspelning. Dessutom breddar den här versionen funktionerna i PySpark och SQL. Den lägger till funktioner som SQL-identifierare-satsen, namngivna argument i SQL-funktionsanrop och inkludering av SQL-funktioner för HyperLogLog ungefärliga aggregeringar. Andra nya funktioner är även Användardefinierade tabellfunktioner i Python, förenkling av distribuerad träning via DeepSpeed och nya strukturerade strömningsfunktioner som vattenstämpelspridning och dropDuplicatesWithinWatermark-åtgärden .

Du kan kontrollera hela listan och detaljerade ändringar här: https://spark.apache.org/releases/spark-release-3-5-0.html.

Delta Spark

Delta Lake 3.2 markerar ett gemensamt åtagande att göra Delta Lake samverkande mellan format, enklare att arbeta med och mer högpresterande. Delta Spark 3.2 bygger på Apache Spark™ 3.5. Delta Spark-mavenartefakten har bytt namn från delta-core till delta-spark.

Du kan kontrollera hela listan och detaljerade ändringar här: https://docs.delta.io/3.2.0/index.html.

Dricks

För uppdaterad information, en detaljerad lista över ändringar och specifika viktig information för Fabric-körningar, kontrollerar och prenumererar du på Spark Runtimes-versioner och -uppdateringar.

Relaterat innehåll

- Läs mer om Apache Spark Runtimes i Infrastruktur – Översikt, Versionshantering, Stöd för flera körningar och uppgradering av Delta Lake Protocol

- Migreringsguide för Spark Core

- Migreringsguider för SQL, datauppsättningar och DataFrame

- Migreringsguide för strukturerad direktuppspelning

- Migreringsguide för MLlib (Machine Learning)

- Migreringsguide för PySpark (Python på Spark)

- Migreringsguide för SparkR (R on Spark)