MLOps och GenAIOps för AI-arbetsbelastningar i Azure

AI-arbetsbelastningsåtgärder fokuserar på kuration av data och förbrukning av dessa data. Åtgärder säkerställer effektivitet i att uppnå och upprätthålla den kvalitet, tillförlitlighet, säkerhet, etik och andra standarder som du prioriterar för arbetsbelastningen.

Arbetsbelastningsuppgifterna kan kategoriseras i tre huvudområden: programutveckling, datahantering och AI-modellhantering. Varje kategori bör använda branschbeprövade driftsmetoder som DevOps, DataOps, MLOps och GenAIOps.

DevOps-aktiviteter omfattar hela livscykelhanteringen för programutveckling genom automatiserade CI/CD-pipelines (kontinuerlig integrering och kontinuerlig distribution) och övervakning. För AI-arbetsbelastningar är dock datapipelinen en av kärnkomponenterna. DataOps, en specialisering av DevOps, fokuserar på att hantera datalivscykeln genom att effektivisera processer som dataextrahering, transformering och inläsning (ETL/ELT). DataOps-utövare mäter vanligtvis dataflödesprestanda och effekten av datarensning och övervakar pipelinen för avvikelser.

AI-arbetsbelastningar är i sig icke-terministiska. Många AI-modeller är benägna att producera olika svar för samma förfrågan under slutsatsdragningen. Dessa arbetsbelastningar behöver processer som kan hantera och anpassa sig till oförutsägbarheten för AI-utdata. DataOps utökas till MLOps, som operationaliserar maskininlärningsarbetsflöden för modellträning och testning. GenAIOps, en specialiserad delmängd av MLOps, riktar sig till generativa AI-lösningar. Det omfattar uppgifter som modellidentifiering och förfina förtränad modeller med berikade data.

Driftaktiviteter överlappar ofta varandra och de olika metoderna gäller i varierande grad. I till exempel diskriminerande AI spelar DataOps en viktig roll, medan DevOps-aktiviteter är mindre framträdande. I generativ AI är driftskvaliteten däremot mer beroende av DevOps än DataOps.

Oavsett är det övergripande målet kapacitetsleverans med effektiva åtgärder under hela utvecklingslivscykeln. De förväntade utfallen är:

- Repeterbara processer med konsekventa resultat.

- Varaktig noggrannhet för modellerna över tid.

- Effektiv styrning som minimerar risker.

- Ändra hanteringsprocesser för att anpassa till modellavvikelse.

Automatisering och övervakning är dina viktigaste operativa strategier för att uppnå dessa mål.

Du måste också upprätta standardiserade processer för AI-komponenter, för rutinmässiga, oplanerade och akuta åtgärder och ha rätt spårningsmekanismer på plats. Utan dessa processer riskerar du att:

- Upprepade fel och icke-reproducerbarhet i databearbetning, modellvärd, grundande datahantering och andra uppgifter.

- Data av låg kvalitet eller inaktuella data som används för modellträning och förfining.

- Påverkar slutanvändarens förtroende för systemet, vilket i värsta fall leder till juridiska problem, efterlevnad eller säkerhetsproblem.

Du måste implementera etablerade processer med rätt uppsättning verktyg. Specialiserade verktyg är tillgängliga för att hantera AI-/maskininlärningsarbetsflöden i olika miljöer.

Den här artikeln fokuserar på designstrategin för åtgärder och innehåller verktygsrekommendationer.

Rekommendationer

Här är sammanfattningen av rekommendationerna i den här artikeln.

| Rekommendation | beskrivning |

|---|---|

| Utforma en effektiv livscykel för arbetsbelastningsåtgärder. | Baserat på komponenterna i din AI-arbetsbelastning gäller olika driftssteg för dess livscykel. Det är viktigt att du förstår de metodtips som är relevanta för ditt scenario och de verktyg som är tillgängliga för att implementera dem. Ta dig tid att lära dig om och implementera viktiga rekommendationer för alla komponenter i din arbetsbelastning. ▪ DataOps ▪ MLOps ▪ GenAIOps ▪ Övervakning |

| Automatisera allt. | Automation säkerställer repeterbarhet och effektivitet i en arbetsbelastnings livscykel. Även om DevOps-processer är en viktig deltagare i detta finns det ytterligare steg som du behöver vidta för att skapa, testa, validera och distribuera dina modeller effektivt. ▪ Automatisering |

| Använd distributionspipelines där det är möjligt. | Distributionspipelines kan hjälpa dig att leverera upprepningsbara infrastrukturdistributioner eller integrera kod kontinuerligt. De är också ett bra verktyg för att skapa och/eller validera modeller innan de befordras till produktion. Genom att implementera distributionspipelines kan du förbättra tillförlitligheten och den övergripande användarupplevelsen för din arbetsbelastning. ▪ Distributionspipelines |

| Förhindra drift och förfall i dina modeller. | Du måste skydda dig mot modellförfall och drift samtidigt som du har en strukturerad process som hjälper dig att acceptera nya modelländringar på ett kontrollerat sätt. Genom att följa rekommendationerna kring modellunderhåll kan du förbli kompatibel, undvika oväntade användarupplevelser och tillhandahålla en mer uppdaterad tjänst. ▪ Modellunderhåll |

Livscykel för arbetsbelastningsåtgärder

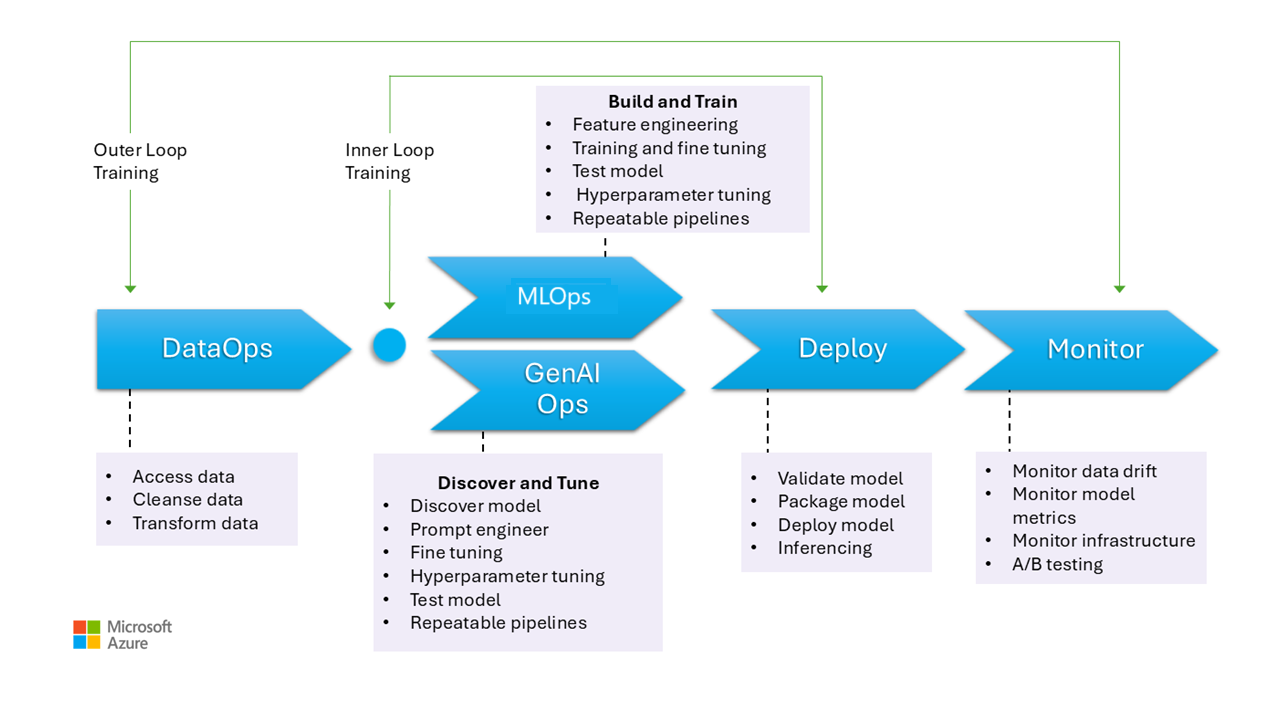

Den här bilden illustrerar driftsstegen för AI-modeller, inklusive datainsamling, rensning av data för att eliminera inkonsekvenser eller fel och transformera data till ett analysbart format. Dessa steg är relevanta för träning av både diskriminerande modeller och grunddata i generativa modeller. Det specifika användningsfallet för generativa träningsmodeller visas dock inte i den här bilden. Det användningsfallet faller utanför den här artikelns omfång.

Stegen i MLOps och GenAIOps är liknande. Den största skillnaden är att fokus, när det gäller GenAIOps, flyttas från träning till att välja rätt modell, fråga teknik och införliva domänspecifik kunskap genom finjustering eller implementering av RAG (Retrieval Augmented Generation).

Även stegen för distribution och övervakning är ganska lika.

I följande avsnitt beskrivs vanliga operativa metoder. De täcker alla steg i livscykeln, från förproduktion till produktion.

DataOps

Data aggregeras från olika produktionsdatakällor och förbearbetas sedan för att ta bort fel och inkonsekvenser och för att hantera saknade värden. Slutligen omvandlas och normaliseras den till ett lämpligt format för träning eller berikning. Aspekter av design beskrivs i artiklarna Träningsdata och Grunddata .

Dataåtgärderna under den här fasen bör vara effektiva eftersom det kan vara svårt att hantera stora mängder data från flera källor och komplexa datapipelines. De metoder som du använder måste se till att den här fasen genererar data av hög kvalitet. Övervaka det här steget för att spåra förloppet mot det acceptabla kvalitetsfältet.

Du måste också se till att data är säkra, med tanke på att data kommer från produktion. Se till att lägre miljöer, till exempel Dev/Test, är lika säkra som produktion för att förhindra eventuella säkerhetsproblem.

Kommentar

Åtgärda data av dålig kvalitet genom att investera i omfattande datarensning under de inledande faserna. Dra nytta av de välkända analysmönstren, som medallion, data mesh och funktionslager, för att utföra uppströms bearbetningsuppgifter. Om de överordnade faserna är ineffektiva måste du förbättra kvaliteten under nedströmsfaserna, vilket leder till ökade arbetsbelastningskostnader eftersom dataförberedelser sker under varje fas.

Information om databearbetningsuppgifter finns i följande artiklar:

Verktyg

Vi rekommenderar att du standardiserar arbetsbelastningens dataorkestreringsverktyg. Verktygen ska kunna tillhandahålla en datapipeline som kan gruppera aktiviteter och som har inbyggd automatisering.

En Azure Data Factory-pipeline kan vara ett första val. Den kan ansluta och bearbeta många datakällor effektivt. Du kan också överväga Azure Synapse Analytics, som kombinerar stordata och informationslager och stöder datasjöar, Apache Spark och Azure Synapse SQL. Den integreras också med Data Factory för ETL.

För att förbereda träningsdata tillhandahåller Azure Machine Learning-pipelines särskilda funktioner som kan automatisera uppgifter som datainsamling och bearbetning.

Tekniker med öppen källkod som Pandas (för dataförberedelse) och Scrapy är populära alternativ.

MLOps

Modellträning är processen att välja lämpliga algoritmer och ge dem förbearbetade historiska data och observationer så att modellen kan lära sig mönster och göra förutsägelser.

Att träna modellen (funktionsteknik) och hyperparameterjustering är iterativa processer och de är dyra. Under varje iteration spårar dataforskare resultat med kombinationer av data, kod och parametrar. Använd repeterbara pipelines för att spåra experiment med minsta manuella arbete tills rätt noggrannhetsnivå uppnås.

En annan operativ utmaning är etablering och skalning av specialiserade beräkningsresurser där experiment utförs. Du bör också paketera och publicera modeller effektivt.

Team kan börja med användargränssnittsbaserad utveckling för att minska utmaningarna och i takt med att de blir mer självsäkra övergår de till en kodbaserad metod.

Verktyg

Vi rekommenderar att du använder verktyg som kan spåra maskininlärningsexperiment genom att samla in information som kodversioner, miljöer, parametrar, körningar och resultat. MLflow är ett sådant ramverk med öppen källkod. Överväg att använda Azure Machine Learning-arbetsytor, som är MLflow-kompatibla och ger ett effektiviserat arbetsflöde som gör det möjligt för dataforskare att hantera produktivitet och reproducerbarhet i sina projekt. Om du vill hantera kodutveckling med källkontrollspårning integrerar du maskininlärningspipelinen med källkontroll som GitHub eller använder filresurser.

Värdberäkningen kan också påverka ditt val av arbetsflödesorkestrerare. Om ditt program finns i Azure Kubernetes Service (AKS) bör du överväga att använda Kubeflow.

Om du funderar på Azure Machine Learning rekommenderar vi att du börjar med Azure Well-Architected Framework-perspektivet på Machine Learning för att se till att du förstår hur produkten kan hjälpa dig med kvalitetsbekymmer för välarkitekterat ramverk för arbetsbelastningen.

En del av fördelen med processen är att optimera personlig tid. Dataexperter behöver vanligtvis specifika verktyg och SDK:er för att effektivt utföra undersökande dataanalys (EDA) och experimentering från sina arbetsstationer. Utvärdera om de fördefinierade alternativen i Azure Machine Learning är lämpliga. Annars lagrar du arbetsstationskonfigurationen eller underhåller godkända VM-avbildningar för det här arbetet. Ett exempel på en avbildning som du kan använda som utgångspunkt är Datavetenskap Virtual Machine (DSVM).

I vissa fall kan användningen av virtuella datorer vara otillåten av principen. Leta efter alternativ, till exempel att lägga till Microsoft Dev Box och Azure Virtual Desktop. Du kan också överväga att använda Docker för att starta datorer som innehåller fördefinierade avbildningar.

Men när det här steget mognar och du behöver utökade experiment går du över till hanterade beräkningsinstanser och föredrar alternativ som är integrerade som en del av arbetsflödet. Utvärdera om du kan använda Azure Machine Learning-beräkningsinstanser för träning och slutsatsdragning i utvecklings- och testsyfte. Beräkningskluster kan hantera stora datamängder och komplexa modeller.

Azure Machine Learning tillhandahåller både kodbaserade lösningar via SDK och lågkodsalternativ som automatiserad maskininlärning och den visuella designern. Python SDK erbjuder flera sätt att träna modeller, var och en med distinkta funktioner. Machine Learning stöder även avancerad optimering och distribuerade databehandlingstekniker som ORTModule, DeepSpeed och LoRA i ONNX Runtime Training för att påskynda träningsprocessen.

GenAIOps

Viktiga aktiviteter under den här fasen börjar med att identifiera och utvärdera befintliga modeller för att identifiera en som är förtränad för det specifika användningsfallet. Det här är en iterativ process. När du har hittat en lämplig modell kan den dra nytta av att förfinas för domänspecifik grundning, vilket även omfattar iterativa steg och kräver en viss orkestreringsnivå.

Integrering och distribution av modeller kräver specialiserade verktyg och metoder som går utöver traditionella MLOps-funktioner, inklusive orkestrering av modeller, vektorindex, prompter och kodblock.

Verktyg

Om du vill hantera identifieringsuppgifter kan du dra nytta av modellkataloger som innehåller modeller från olika leverantörer. Med modellkatalogen i Azure AI Foundry-portalen kan du utvärdera bland utvalda samlingar och distribuera modeller effektivt.

Azure Machine Learning prompt flow kan hjälpa till med utvecklingen av orkestreringskod, aktivera prototyper, experimentera, iterera och fråga teknik. Dessa flöden kan distribueras till azure machine learning-hanterade slutpunkter. Utvärdera om du kan köra och distribuera flödena med din befintliga CI/CD-pipelineteknik.

Distribution

Under den här fasen distribueras modellen till en värd- och slutsatsdragningsplattform eller serverlagret med AI-arbetsbelastningar. API:erna måste paketeras som en skalbar container. Containerplattformen kan vara en hanterad beräknings- eller anpassad värdplattform. Driftmetoder bör säkerställa säker distribution och aktivera återställningar.

Börja med PaaS-lösningar (Plattform som en tjänst) och serverlösa lösningar som Azure OpenAI Service för att förenkla implementering och hantering. Överväg att använda Azure Machine Learning Serverless API för aggregering av slutpunktsåtkomst. Hanterade beräkningskluster är ett genomförbart alternativ för avancerade behov. Självvärdering på AKS är ett annat alternativ. Se till att du har rätt storlek på beräkningen och bibehåller korrekt isolering från andra arbetsbelastningar. Du kan också överväga alternativ som att helt vara värd för din modell som infrastruktur som en tjänst (IaaS). IaaS ger flexibilitet men kan öka driftbelastningen. De här alternativen beskrivs i Programplattform.

Det här steget visar den sista chansen att fånga upp problem innan du flyttar modellen till produktion. Testprocesserna bör innehålla valideringssteg för att se till att modellen är konfigurerad för att tillhandahålla förutsägelser som förväntat.

Du bör integrera modellen i den befintliga produktionsmiljön genom att följa progressiva exponeringsprocesser och använda distributioner sida vid sida. Kanariemodellen är ett vanligt sätt att distribuera nya modeller. Med den här metoden ökar användarbasen gradvis. Blågrön distribution är en annan metod.

Verktyg

Du kan använda Azure Machine Learning-pipelines eller Azure Pipelines för att distribuera dina modeller för slutsatsdragning. Machine Learning innehåller flera funktioner för förenklade åtgärder, inklusive nodetablering, OS-uppdateringar, automatisk skalning, övervakning och isolerade virtuella nätverk.

Machine Learning har också stöd för blågrön distribution, vilket gör att en enskild slutpunkt kan innehålla flera distributioner.

Om du använder andra värdplattformar, till exempel Azure Container Apps eller Azure App Service, ansvarar du för åtgärderna, inklusive etablering och skalning. Använd Azure DevOps, GitHub-pipelines eller ditt val av CI/CD-teknik i dessa fall.

Övervakning

Övervakning är en viktig strategi och tillämpas i alla skeden. Det är en pågående process och fungerar som indata till kvalitetsgrindar som säkerställer att AI-arbetsbelastningar testas noggrant för att upprätthålla konsekvens och tillförlitlighet under hela utvecklingslivscykeln. Modeller måste övervakas ur både drifts- och datavetenskapsperspektiv.

Vi rekommenderar starkt att du har en DataOps inre loopövervakningsprocess som mäter närheten till ett kvalitetsfält för godkännande och söker efter avvikelser.

För förtränad modeller är det också viktigt att övervaka dataavvikelse och prestanda, med primärt fokus på relevans. Utvärdera indata (prompter) och utdata (slutföranden) för att säkerställa att de är relevanta och korrekta. Dessutom bör du vara medveten om säkerhetsrisker, till exempel försök att manipulera modellens beteende genom skadliga uppmaningar. Kontrollera att det finns en grundlig kon tältläge ration som inspekterar data i båda riktningarna och filtrerar bort olämpligt innehåll. Dessa överväganden beskrivs i designområdet ResponsibleAI.

Efter distributionen krävs övervakningsåtgärder för att åtgärda problem som modellförfall. Modeller kan bli inaktuella på grund av ändringar i data eller externa ändringar som kan leda till att modellen ger irrelevanta resultat. Som ett proaktivt mått använder du automatiserade processer för kontinuerlig övervakning och utvärderar och tränar om för att upprätthålla noggrannhet och relevans. Dessutom måste du övervaka infrastruktur- och arbetsbelastningsmått, precis som med andra arbetsbelastningar, för att säkerställa optimala prestanda och tillförlitlighet. Mer information finns i Testa för modellförfall.

Verktyg

Investera i verktyg som gör det enklare att samla in mått från slutsatsdragningsslutpunkter, till exempel Azure Machine Learning Data Collector.

Du behöver också kunna observera modellprestanda, dataavvikelse och säkerhet och kvalitet för generativ AI.

För mer information, se dessa artiklar:

Automation

AI-arbetsbelastningar är komplexa eftersom den övergripande livscykeln omfattar många roller, frekventa ändringar och relaterade steg. Manuella processer kan vara utsatta för fel och inkonsekvenser. Automatisering i hantering av databehandlingsmodeller hjälper till att säkerställa repeterbarhet och effektivitet. Automatisering krävs inte alltid, men det är ett effektivt sätt att hantera dessa komplexiteter. Här är några användningsfall där automatisering kan minska riskerna:

Till skillnad från traditionell koddistribution kräver icke-terministiska modeller och lösningar i AI/maskininlärning iterativ experimentering och träning. När flera team samarbetar kan automatisering, som ett sätt att framtvinga standardiserade processer, bidra till att upprätthålla konsekvens, reproducerbarhet och effektivt samarbete mellan dataforskare, tekniker och driftsteam.

Modelllivscykeln omfattar två huvudsakliga typer av utbildning:

Onlineträning innehåller nya data i modellen ofta, ibland dagligen, för att säkerställa att besluten baseras på den senaste informationen. Den här utbildningen är integrerad i arbetsbelastningen så att modellen uppdateras kontinuerligt som en del av den vanliga processen.

Offlineträning tränar modellen mindre ofta, vilket ger ett längre mellanrum mellan uppdateringar. Träningsprocessen är separat från huvudarbetsbelastningen och utförs asynkront. När den nya modellen är klar integreras den sedan i systemet.

Tillförlitlighet kan komprometteras om uppdateringarna är ovanliga. Om en uppdatering missas kan den skjutas upp utan större problem. Det här begreppet gäller även för jordningsdata. Om du till exempel använder RAG måste du bestämma om du behöver använda nyligen använda data eller om det räcker med lite äldre data. Båda scenarierna handlar om att balansera behovet av uppdaterad information med det praktiska uppdateringsfrekvensen. Du bör utföra onlineträning via automatisering på grund av den frekvens och tillförlitlighet som krävs. För offlineträning måste du, på grund av den frekvens som krävs, motivera automatiseringen genom att utföra en kostnads-nyttoanalys. Dessutom kan du utföra offlineträning med hjälp av billigare resurser, till exempel offlinemaskinvara.

Traditionella DevOps-processer påverkas vanligtvis av strukturella förändringar. I AI och maskininlärning tränas dock modeller på produktionsdata. Modellförfall utgör en betydande risk och kan leda till sämre prestanda över tid om den inte övervakas. Automatisk insamling och analys av prestandamått, aviseringar och omträning av modeller krävs för att upprätthålla modellens effekt. Använd automatisering på ett sätt som kan hjälpa dig att identifiera ändringar i data och modellberoenden för att få en tydlig förståelse för det aktuella tillståndet vid en viss tidpunkt.

Modeller kan tränas med två olika metoder.

- Modellerna tränas i utvecklingsmiljön med fullständiga produktionsdata och endast artefakten befordras via miljöer. Den här metoden kan sänka beräkningskostnaderna, men kräver hårdare säkerhet för att hantera produktionsdata i de lägre miljöerna och kanske inte är möjligt i alla organisationer.

- Modellen tränas i varje miljö. Kodhöjning kan hjälpa till med stabilitet eftersom träningskoden granskas och testas i de lägre miljöerna, men ökar kostnaden för beräkning.

Det finns fördelar och nackdelar med båda metoderna. Att välja rätt metod beror på organisationens prioriteringar och arbetsbelastningens SDLC-metoder (Software Development Life Cycle). Oavsett metod är noggrann testning och utvärdering av modellen före produktionsdistribution viktigt

Din automatiseringskod bör innehålla data härstamning för att stödja granskning genom att tillhandahålla en tydlig post för databearbetningssteg. Den här posten hjälper dig att hantera förväntningar och gör att du kan visa hur beslut har fattats så att du kan åtgärda eventuella problem med resultat.

Distributionspipelines

I AI/maskininlärningsarbetsbelastningar innebär modellutveckling att skapa, validera och främja modeller för att modellera värdplattformar. Det är viktigt att ha distributionspipelines som effektiviserar komplexa arbetsflöden som rör databearbetning, funktionsutveckling, modellträning eller förhöjdhet samt distribution till produktion. Med tanke på ai:s icke-deterministiska karaktär, vilket gör processerna ogenomskinliga, måste du införliva kvalitativa tester i versionspipelines och övervakningssystem.

Även om MLOps och GenAIOps kan kräva distinkta AI-aktiviteter och kärntekniker kan skilja sig åt, är de underliggande begreppen fortfarande lika devops. Vi rekommenderar att du tillämpar metodtips från dina befintliga DevOps-processer. Integrera AI-aktiviteter i din arbetsbelastnings befintliga pipelines.

Vanligtvis omfattar AI-arbetsbelastningar traditionella koddistributioner. Du kan välja att hantera modelldistributionen tillsammans med koden eller separat i sin egen livscykel. Det tidigare tillvägagångssättet är att föredra. Var beredd på att paketera modeller och slutpunkter för slutsatsdragning med arbetsbelastningsdistribution för att hålla AI-åtgärder främst fokuserade på förberedelse av data, träning/finjustering, grunddatahantering och övervakning.

Utvärdera om hur följande tillgångar kan skräddarsys för att täcka hela livscykeln för MLOps och GenAIOps, från förproduktion till produktion:

- IaC-verktyg (Infrastructure-as-code)

- CI/CD-pipelines

- Observerbarhetsstacken för att spåra och identifiera problem

Verktyg

Du kan utöka Azure Pipelines- och GitHub Actions-arbetsflöden, som ofta används för CI/CD, till maskininlärningsmodeller. De hjälper till att distribuera maskininlärningsinfrastruktur, anpassade arbetsbelastningskomponenter, orkestreringskod och modeller. Kombinera Azure Machine Learning-pipelines med Azure DevOps- eller GitHub-pipelines. Mer information finns i Använda Azure Pipelines med Azure Machine Learning.

Två huvudfaktorer påverkar valet av rätt kombination av verktyg: användningsfall och funktioner. Azure Machine Learning-pipelines är till exempel bra för orkestreringen som utförs av dataforskare. Den har en omfattande funktionsuppsättning som stöder återanvändning, cachelagring med mera. Verktygsalternativ finns i Vilken Azure-pipelineteknik ska jag använda?.

Modellunderhåll

AI/ML-landskapet är konkurrenskraftigt med pågående innovation. Nya modeller dyker ofta upp, nya användningsfall identifieras och nya datakällor blir tillgängliga. Därför är modellförfall en vanlig utmaning.

För att förhindra försämrad modellprestanda eller drift över tid måste du implementera automatiserade processer för kontinuerlig övervakning, utvärdering och omträning. Till exempel:

Underhålla en modellkatalog. Automatisera processen med att identifiera nya modeller och uppdatera katalogen.

Anpassa till nya användningsfall. När nya användningsfall läggs till i arbetsbelastningskraven kan du förutse frågorna och justera databearbetningslogik i enlighet med detta.

Införliva nya datakällor. Om nya datakällor potentiellt kan förbättra modellens förutsägelsekraft eller relevans uppdaterar du pipelinen för datainmatning för att ansluta till och hämta data från dessa källor.

Utvärdera efterlevnaden av regelkrav. När du anpassar dig till nya funktioner ska du se till att ändringarna förblir giltiga inom begränsningarna i organisationens eller externa efterlevnadsstandarder.

Implementera en formell process för att spåra kontinuerliga förbättringar och införliva självförbättring som en underprocess inom den cykeln.

Kontinuerlig utveckling

Granska och förbättra verksamheten regelbundet och uppmuntra innovation.

MLOps-mognadsmodellen går från manuella processer till fullständig automatisering. Börja med manuella versioner och övervakning och införliva automatiserade programversioner, träningsmiljöer och distribution i faser som motiveras av omfattande mått. Mer information finns i MLOps-mognadsmodellen.

Mognadsnivåerna för GenAIOps flyttas från grundläggande modeller till strukturerad distribution, gradvis med hjälp av automatiserade optimeringstekniker. Mer information finns i Avancera din mognadsnivå för GenAIOps.