Aktivera loggning i Azure Machine Learning-designerpipelines

I den här artikeln får du lära dig hur du lägger till loggningskod i designerpipelines. Du får också lära dig hur du visar loggarna med hjälp av Azure Machine Learning-studio webbportalen.

Mer information om loggningsmått med hjälp av SDK-redigeringsmiljön finns i Övervaka Azure Machine Learning-experimentkörningar och mått.

Aktivera loggning med Kör Python-skript

Använd komponenten Kör Python-skript för att aktivera loggning i designerpipelines. Även om du kan logga valfritt värde med det här arbetsflödet är det särskilt användbart att logga mått från komponenten Utvärdera modell för att spåra modellprestanda mellan körningar.

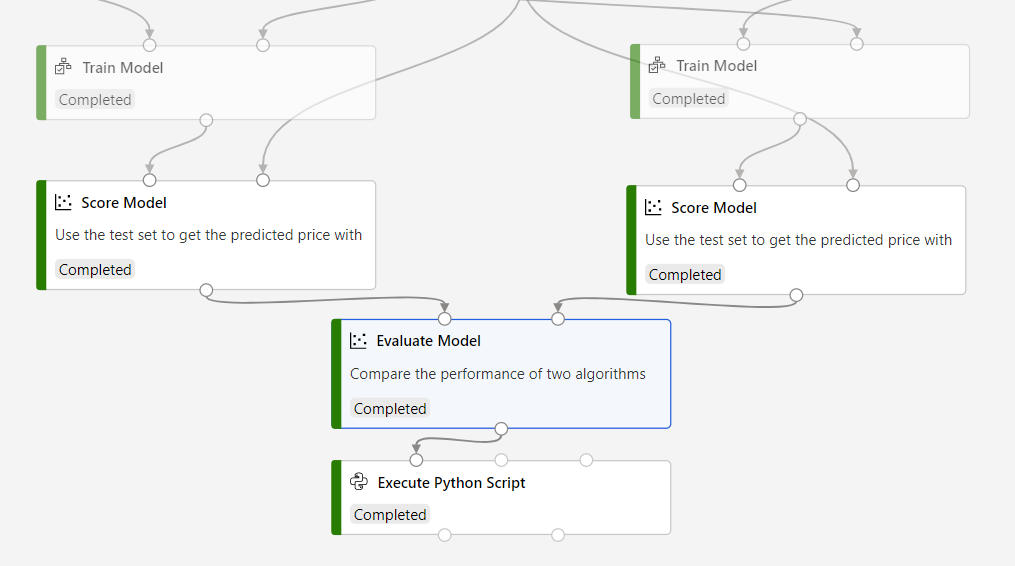

I följande exempel visas hur du loggar det genomsnittliga kvadratfelet för två tränade modeller med hjälp av komponenterna Utvärdera modell och Kör Python-skript.

Anslut en Execute Python Script-komponent till utdata från komponenten Utvärdera modell .

Klistra in följande kod i kör Python-skriptkodredigeraren för att logga det genomsnittliga absoluta felet för din tränade modell. Du kan använda ett liknande mönster för att logga andra värden i designern:

GÄLLER FÖR:

Python SDK azureml v1

Python SDK azureml v1# dataframe1 contains the values from Evaluate Model def azureml_main(dataframe1=None, dataframe2=None): print(f'Input pandas.DataFrame #1: {dataframe1}') from azureml.core import Run run = Run.get_context() # Log the mean absolute error to the parent run to see the metric in the run details page. # Note: 'run.parent.log()' should not be called multiple times because of performance issues. # If repeated calls are necessary, cache 'run.parent' as a local variable and call 'log()' on that variable. parent_run = Run.get_context().parent # Log left output port result of Evaluate Model. This also works when evaluate only 1 model. parent_run.log(name='Mean_Absolute_Error (left port)', value=dataframe1['Mean_Absolute_Error'][0]) # Log right output port result of Evaluate Model. The following line should be deleted if you only connect one Score component to the` left port of Evaluate Model component. parent_run.log(name='Mean_Absolute_Error (right port)', value=dataframe1['Mean_Absolute_Error'][1]) return dataframe1,

Den här koden använder Azure Machine Learning Python SDK för att logga värden. Den använder Run.get_context() för att hämta kontexten för den aktuella körningen. Sedan loggar den värden till den kontexten med metoden run.parent.log(). Den använder parent för att logga värden till den överordnade pipelinekörningen i stället för komponentkörningen.

Mer information om hur du använder Python SDK för att logga värden finns i Aktivera loggning i Azure Machine Learning-träningskörningar.

Visa loggar

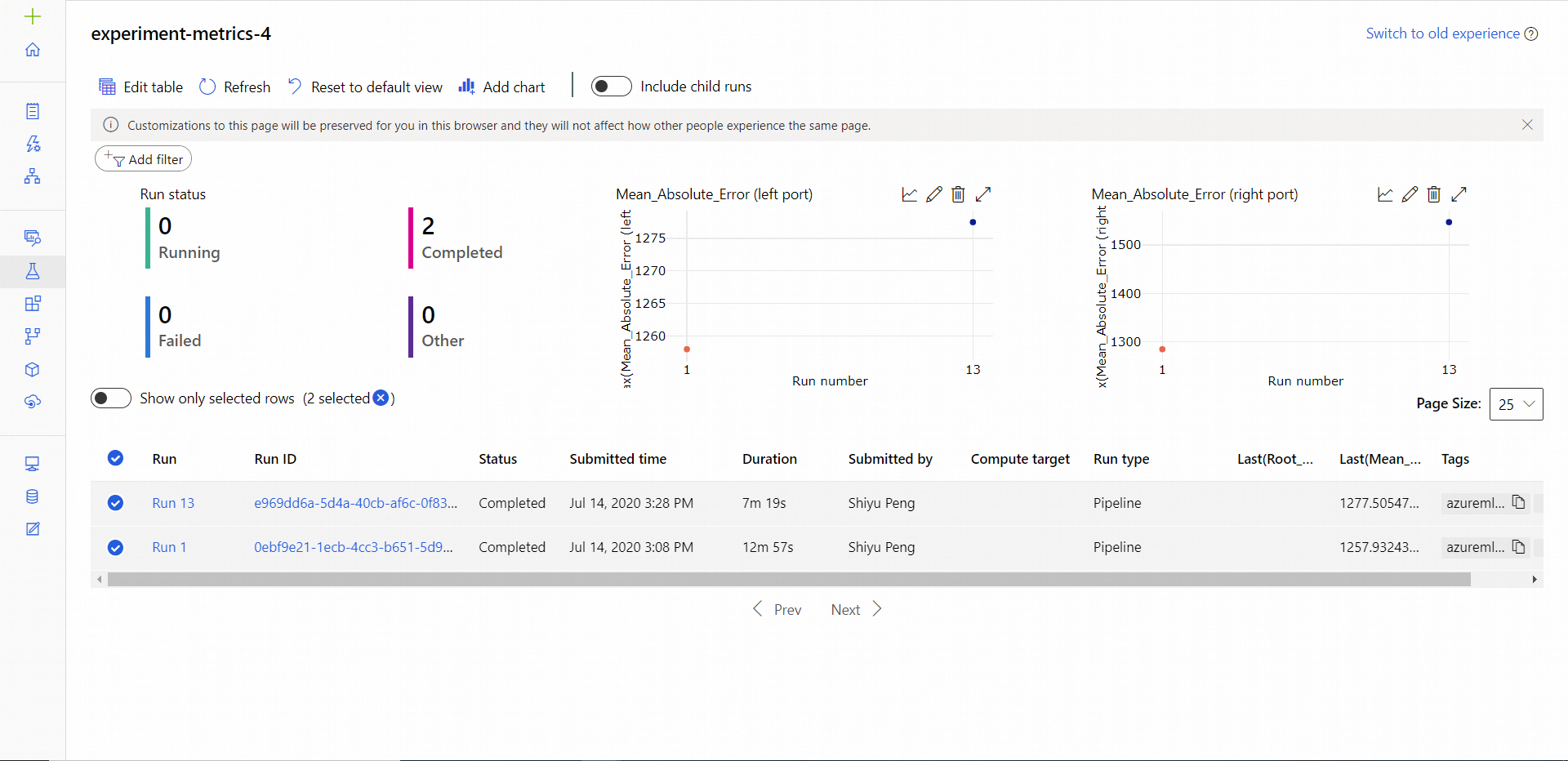

När pipelinekörningen är klar kan du se Mean_Absolute_Error på sidan Experiment.

Gå till avsnittet Jobb .

Välj experimentet.

Välj det jobb i experimentet som du vill visa.

Välj Mått.

Nästa steg

I den här artikeln har du lärt dig hur du använder loggar i designern. Nästa steg finns i följande relaterade artiklar:

- Lär dig hur du felsöker designerpipelines i Felsöka och felsöka ML-pipelines.

- Lär dig hur du använder Python SDK för att logga mått i SDK-redigeringsmiljön. Mer information finns i Aktivera loggning i Azure Machine Learning-träningskörningar.

- Lär dig hur du använder Kör Python-skript i designern.