Lakehouse-referensarkitekturer (ladda ned)

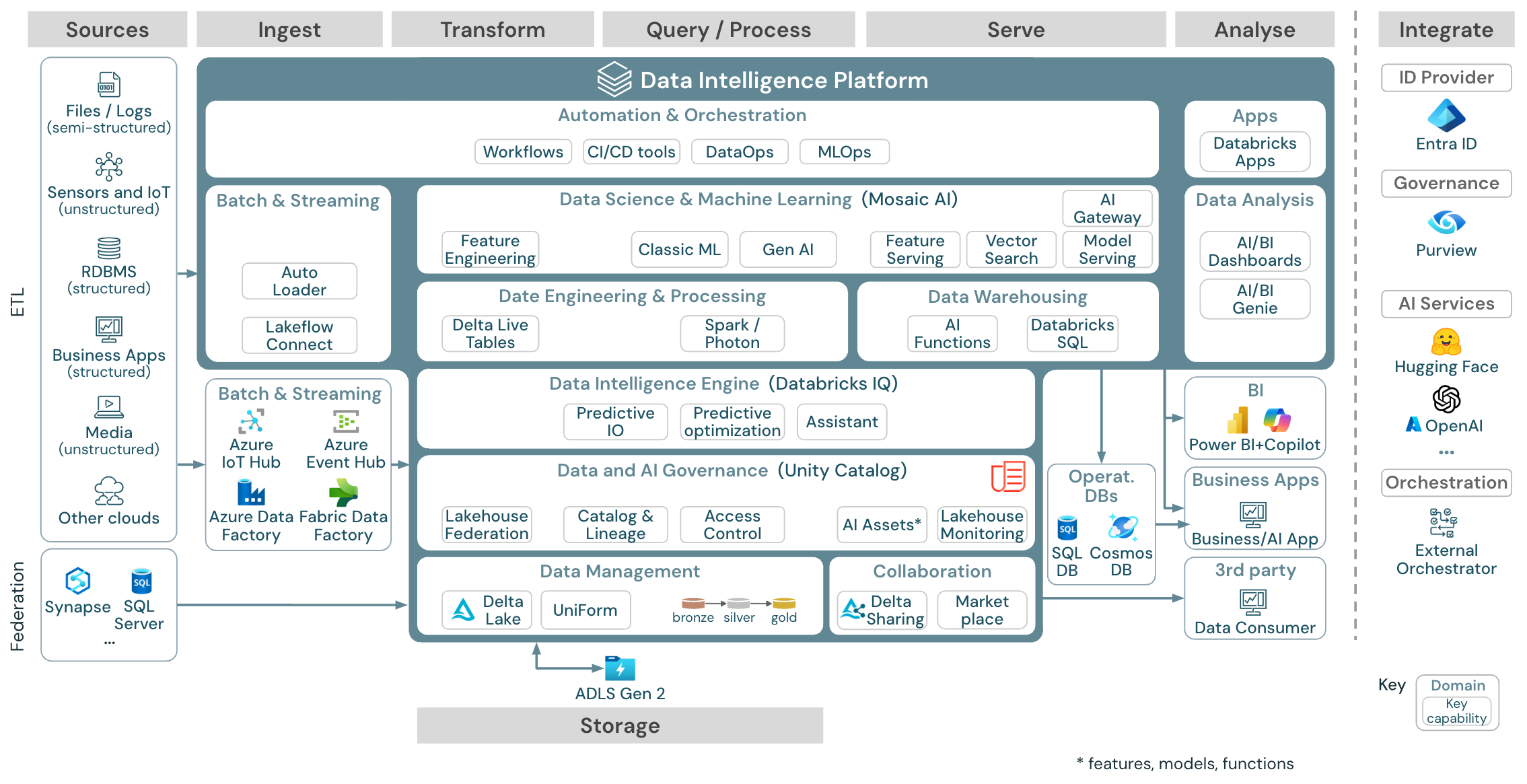

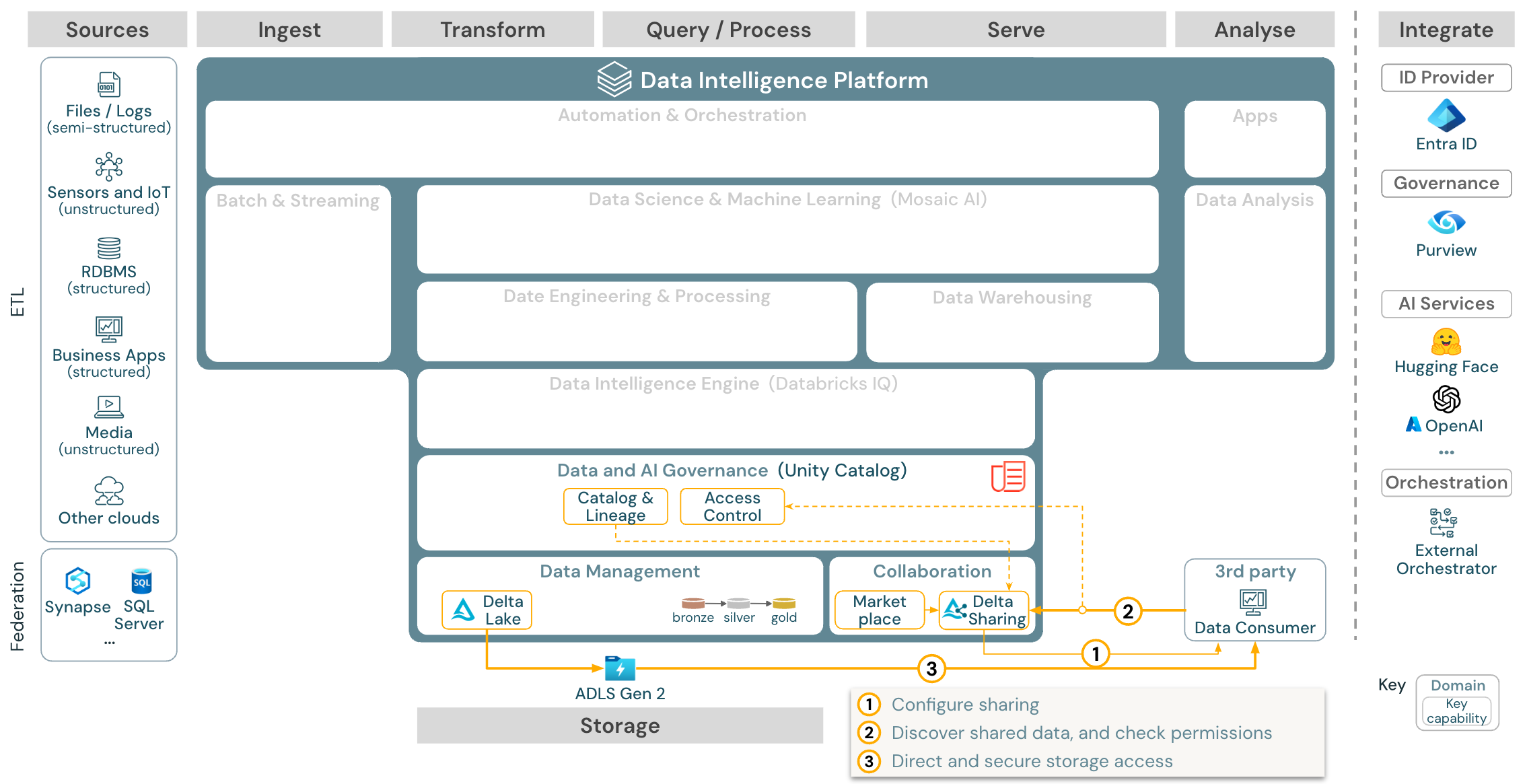

Den här artikeln beskriver arkitekturvägledning för lakehouse när det gäller datakälla, inmatning, transformering, frågekörning och bearbetning, servering, analys och lagring.

Varje referensarkitektur har en nedladdningsbar PDF i formatet 11 x 17 (A3).

Lakehouse på Databricks är en öppen plattform som integreras med ett stort ekosystem med partnerverktyg, men referensarkitekturerna fokuserar bara på Azure-tjänster och Databricks lakehouse. De molnleverantörstjänster som visas är valda för att illustrera begreppen och är inte uttömmande.

Ladda ned: Referensarkitektur för Azure Databricks Lakehouse

Azure-referensarkitekturen visar följande Azure-specifika tjänster för inmatning, lagring, servering och analys:

- Azure Synapse och SQL Server som källsystem för Lakehouse Federation

- Azure IoT Hub och Azure Event Hubs för strömmande inmatning

- Azure Data Factory för batch-inmatning

- Azure Data Lake Storage Gen 2 (ADLS) som objektlagring

- Azure SQL DB och Azure Cosmos DB som driftdatabaser

- Azure Purview som företagskatalog till vilken UC exporterar schema- och ursprungsinformation

- Power BI som BI-verktyg

Organisation av referensarkitekturerna

Referensarkitekturen är strukturerad längs flödesbanorna Källa, Intag, Transformera, Fråga/Bearbeta, Tjäna, Analysoch Lagring:

Källa

Arkitekturen skiljer mellan halvstrukturerade och ostrukturerade data (sensorer och IoT, media, filer/loggar) och strukturerade data (RDBMS, affärsprogram). SQL-källor (RDBMS) kan också integreras i lakehouse och Unity Catalog utan ETL via lakehouse federation. Dessutom kan data läsas in från andra molnleverantörer.

Intag

Data kan matas in i lakehouse genom batch eller strömning.

- Databricks Lakeflow Connect erbjuder inbyggda anslutningar för inmatning från företagsprogram och databaser. Den resulterande inmatningspipelinen styrs av Unity Catalog och drivs av serverlös beräkning och DLT.

- Filer som levereras till molnlagring kan läsas in direkt med Databricks Auto Loader.

- För batchinmatning av data från företagsapplikationer till Delta Lake förlitar sig Databricks lakehouse på partnerinmatningsverktyg med specifika adaptrar för dessa records-system.

- Direktuppspelningshändelser kan matas in direkt från händelseströmningssystem som Kafka med Databricks Structured Streaming. Strömmande källor kan vara sensorer, IoT- eller ändringsprocesser för datainsamling .

Storage

Data lagras vanligtvis i molnlagringssystemet där ETL-pipelines använder medallion-arkitekturen för att lagra data på ett organiserat sätt som Delta-filer/tabeller.

Transformera och Fråga/bearbeta

Databricks lakehouse använder sina motorer Apache Spark och Photon för alla omvandlingar och frågor.

DLT (DLT) är ett deklarativt ramverk för att förenkla och optimera tillförlitliga, underhållsbara och testbara databearbetningspipelines.

Databricks Data Intelligence Platform drivs av Apache Spark och Photon och stöder båda typerna av arbetsbelastningar: SQL-frågor via SQL-lager och SQL-, Python- och Scala-arbetsbelastningar via arbetsytekluster.

För datavetenskap (ML-modellering och Gen AI) tillhandahåller Databricks AI- och Machine Learning-plattformen specialiserade ML-körningar för AutoML och för kodning av ML-jobb. Alla arbetsflöden för datavetenskap och MLOps stöds bäst av MLflow.

Servering

För DWH- och BI-användningsfall tillhandahåller Databricks lakehouse Databricks SQL, informationslagret som drivs av SQL-lager och serverlösa SQL-lager.

För maskininlärning är modellbetjäning en skalbar, realtids- och företagsklassad modellbetjäningskapacitet som finns i Databricks-kontrollplanet. Mosaic AI Gateway är Databricks-lösning för styrning och övervakning av åtkomst till generativa AI-modeller som stöds och deras associerade modell som betjänar slutpunkter.

Driftdatabaser: Externa system, till exempel driftdatabaser, kan användas för att lagra och leverera slutgiltiga dataprodukter till användarprogram.

Samarbete: Affärspartner får säker åtkomst till de data de behöver via Delta Sharing. Databricks Marketplace är ett öppet forum för utbyte av dataprodukter, baserat på Delta Sharing.

Analys

De sista affärsprogrammen finns i denna simbana. Exempel är anpassade klienter som AI-program som är anslutna till Mosaic AI Model Serving för slutsatsdragning i realtid eller program som har åtkomst till data som skickas från lakehouse till en driftdatabas.

För BI-användningsfall använder analytiker vanligtvis BI-verktyg för att komma åt informationslagret. SQL-utvecklare kan dessutom använda Databricks SQL-redigeraren (visas inte i diagrammet) för frågor och instrumentpaneler.

Data Intelligence Platform erbjuder även instrumentpaneler för att skapa datavisualiseringar och dela insikter.

Integrera

- Databricks-plattformen integreras med standardidentitetsprovidrar för användarhantering och enkel inloggning (SSO).

Externa AI-tjänster som OpenAI, LangChain eller HuggingFace kan användas direkt från Databricks Intelligence Platform.

Externa orkestrerare kan använda den omfattande REST-API:n eller alternativt dedikerade anslutningar till externa orkestreringsverktyg som Apache Airflow.

Unity Catalog används för alla data & AI-styrning i Databricks Intelligence Platform och kan integrera andra databaser i dess styrning via Lakehouse Federation.

Dessutom kan Unity Catalog integreras i andra företagskataloger, t.ex. Purview. Kontakta leverantören av företagskatalogen för mer information.

Vanliga funktioner för alla arbetsbelastningar

Dessutom levereras Databricks lakehouse med hanteringsfunktioner som stöder alla arbetsbelastningar:

Data- och AI-styrning

Det centrala data- och AI-styrningssystemet i Databricks Data Intelligence Platform är Unity Catalog. Unity Catalog tillhandahåller en enda plats för att hantera dataåtkomstprinciper som gäller för alla arbetsytor och stöder alla tillgångar som skapats eller används i lakehouse, till exempel tabeller, volymer, funktioner (funktionslager) och modeller (modellregister). Unity Catalog kan också användas för att samla in datalinje mellan frågor som körs på Databricks.

Med Databricks lakehouse monitoring kan du övervaka datakvaliteten i alla dina kontotabeller. Den kan också spåra prestanda för maskininlärningsmodeller och modellbetjäningsslutpunkter.

För observerbarhet är systemtabeller ett Databricks-värdbaserat analyslager för ditt kontos driftdata. Systemtabeller kan användas för historisk observerbarhet i hela ditt konto.

Dataintelligensplattform

Databricks Data Intelligence Platform gör att hela organisationen kan använda data och AI. Den drivs av DatabricksIQ och kombinerar generativ AI med fördelarna med en lakehouse-plattform för att förstå den unika semantiken i din data.

Databricks Assistant finns i Databricks Notebooks, SQL-redigeraren och filredigeraren som en kontextmedveten AI-assistent för utvecklare.

Automation & Orchestration

Databricks-jobb samordnar databearbetning, maskininlärning och analys-pipelines på plattformen Databricks Data Intelligence. DLT- kan du skapa tillförlitliga och underhållsbara ETL-pipelines med deklarativ syntax. Plattformen stöder även CI/CD- och MLOps

Användningsfall på hög nivå för Data Intelligence Platform i Azure

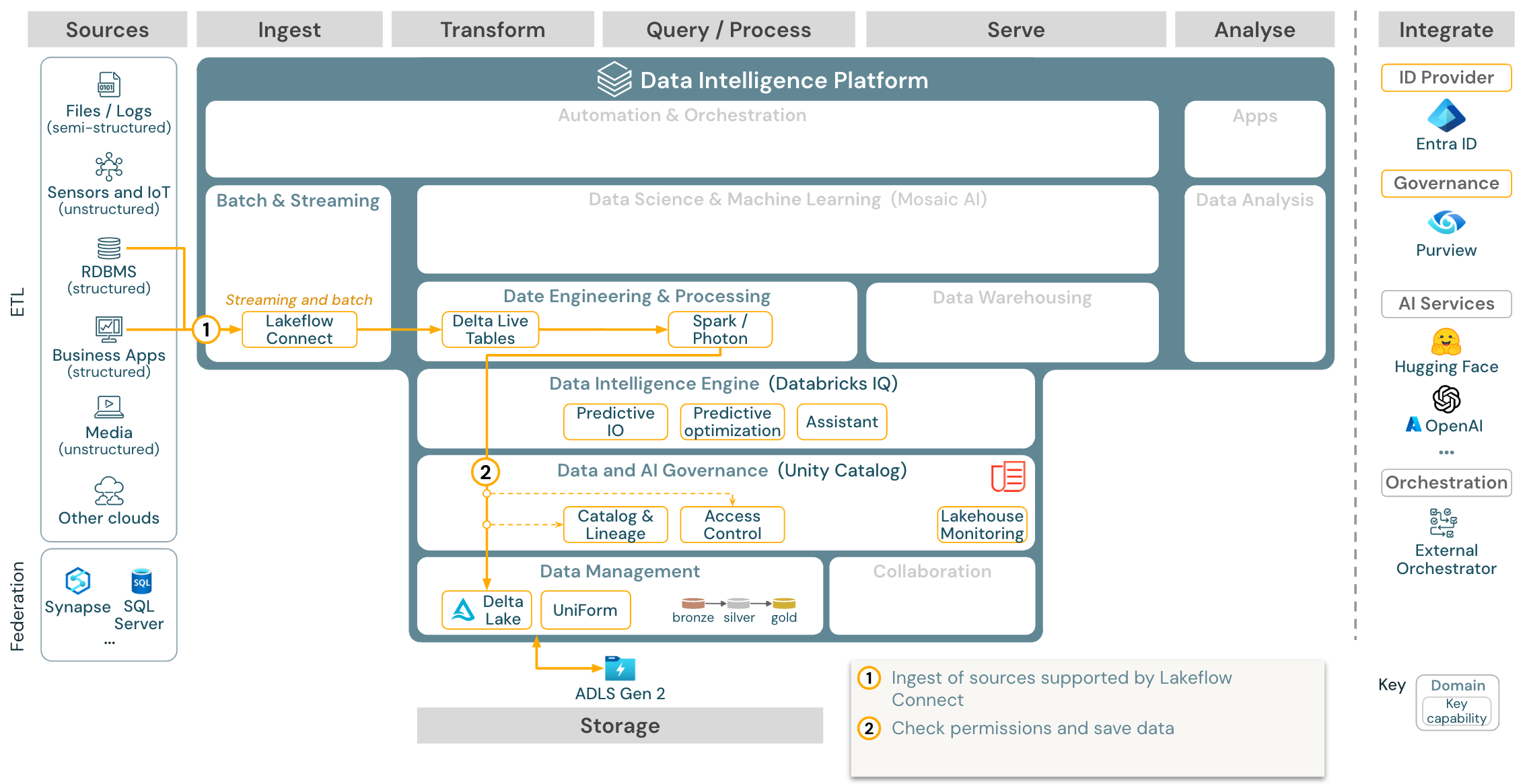

Databricks Lakeflow Connect erbjuder inbyggda anslutningar för att hämta data från företagsapplikationer och databaser. Den resulterande inmatningspipelinen styrs av Unity Catalog och drivs av serverlös beräkning och DLT. Lakeflow Connect utnyttjar effektiva inkrementella läsningar och skrivningar för att göra datainmatningen snabbare, skalbar och mer kostnadseffektiv, medan dina data förblir färska för nedströmsförbrukning.

Användningsfall: Inmatning med Lakeflow Connect:

Ladda ned: Batch ETL-referensarkitektur för Azure Databricks.

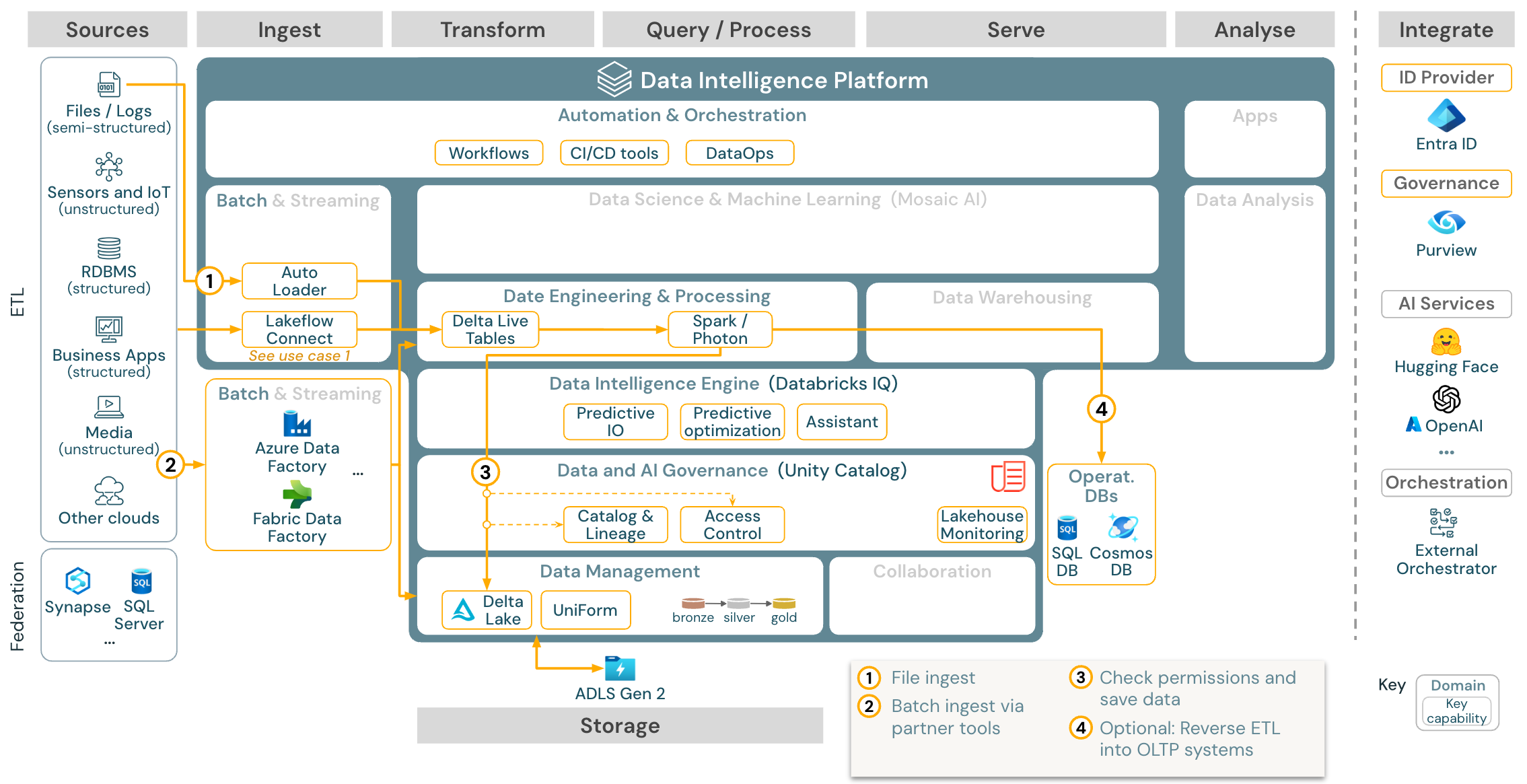

Användningsfall: Batch ETL

Ladda ned: Batch ETL-referensarkitektur för Azure Databricks

Inmatningsverktyg använder källspecifika adaptrar för att läsa data från källan och lagra dem i molnlagringen där Auto Loader kan läsa dem, eller kalla Databricks direkt (till exempel med partnerinmatningsverktyg integrerade i Databricks lakehouse). För att läsa in data kör Databricks ETL och bearbetningsmotorn – via DLT – frågorna. Enkla arbetsflöden eller arbetsflöden med flera flöden kan samordnas av Databricks-jobb och styras av Unity Catalog (åtkomstkontroll, granskning, ursprung och så vidare). Om driftsystem med låg latens kräver åtkomst till specifika gyllene tabeller kan de exporteras till en driftdatabas, till exempel ett RDBMS- eller nyckelvärdeslager i slutet av ETL-pipelinen.

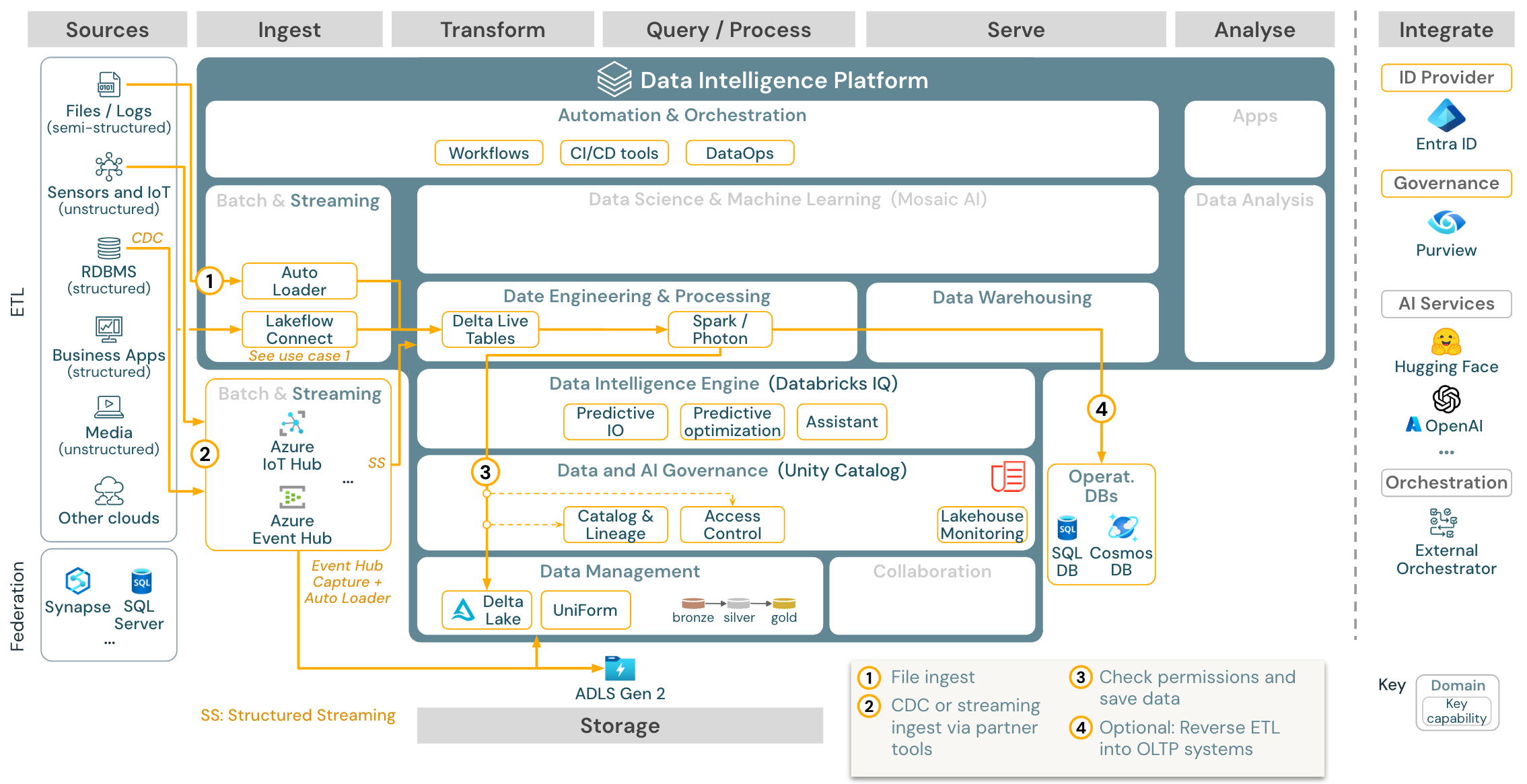

Användningsfall: Strömma och ändra datainsamling (CDC)

Ladda ned: Spark-strukturerad strömningsarkitektur för Azure Databricks

Databricks ETL-motorn använder Spark Structured Streaming för att läsa från händelseköer som Apache Kafka eller Azure Event Hub. De underordnade stegen följer metoden för Batch-användningsfallet ovan.

CDC (Real-Time Change Data Capture) använder vanligtvis en händelsekö för att lagra de extraherade händelserna. Därifrån följer användningsfallet användningsfallet för direktuppspelning.

Om CDC görs i batch där de extraherade posterna lagras i molnlagring först kan Databricks Autoloader läsa dem och användningsfallet följer Batch ETL.

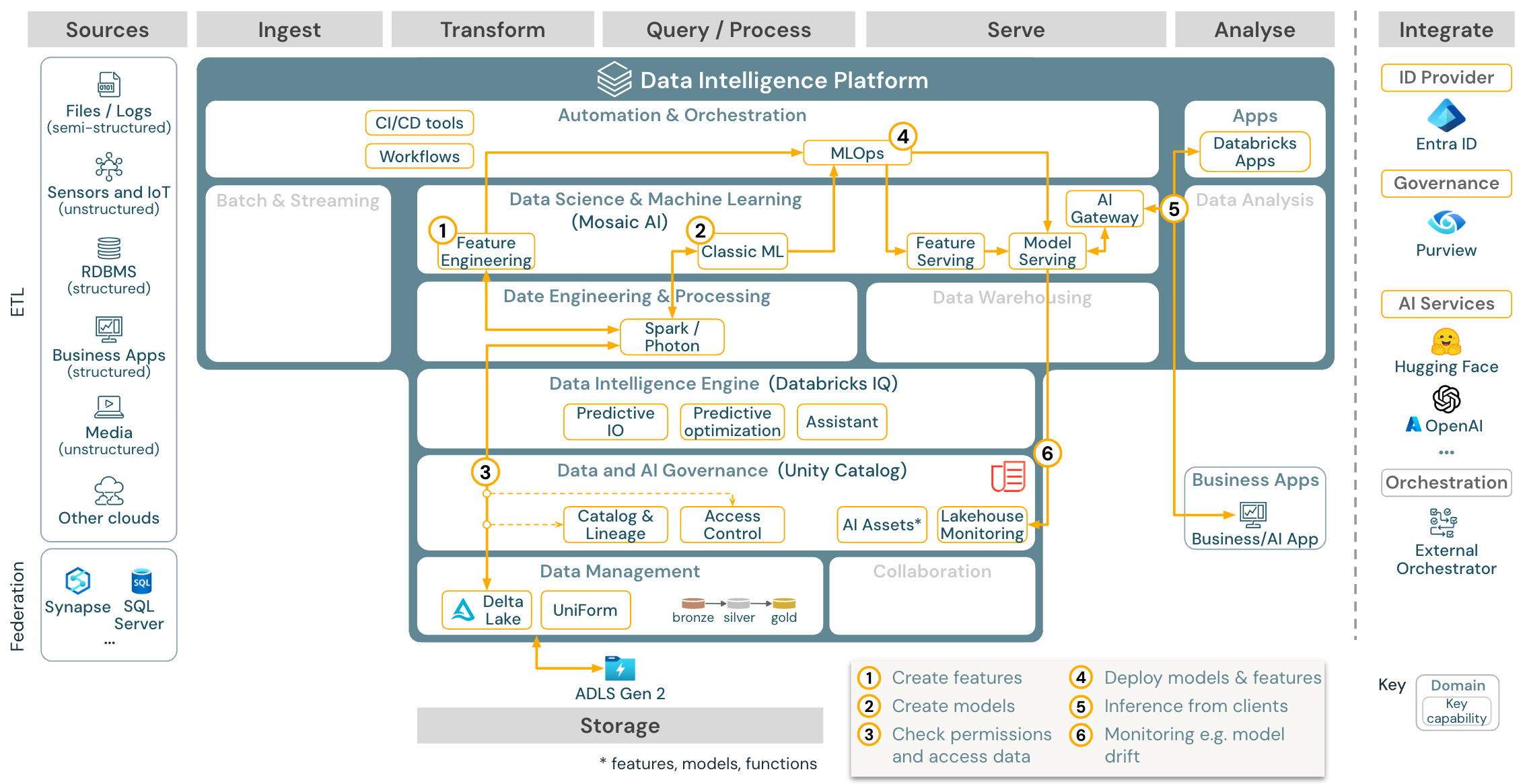

Användningsfall: Maskininlärning och AI

Ladda ned: Referensarkitektur för maskininlärning och AI för Azure Databricks

För maskininlärning tillhandahåller Databricks Data Intelligence Platform Mosaic AI, som levereras med toppmoderna maskin- och djupinlärningsbibliotek. Den innehåller funktioner som Funktionslager och modellregister (både integrerade i Unity Catalog), funktioner med låg kod med AutoML och MLflow-integrering i datavetenskapens livscykel.

Alla datavetenskapsrelaterade tillgångar (tabeller, funktioner och modeller) styrs av Unity Catalog och dataexperter kan använda Databricks-jobb för att samordna sina jobb.

För att distribuera modeller på ett skalbart och företagsbaserat sätt använder du MLOps-funktionerna för att publicera modellerna i modellservern.

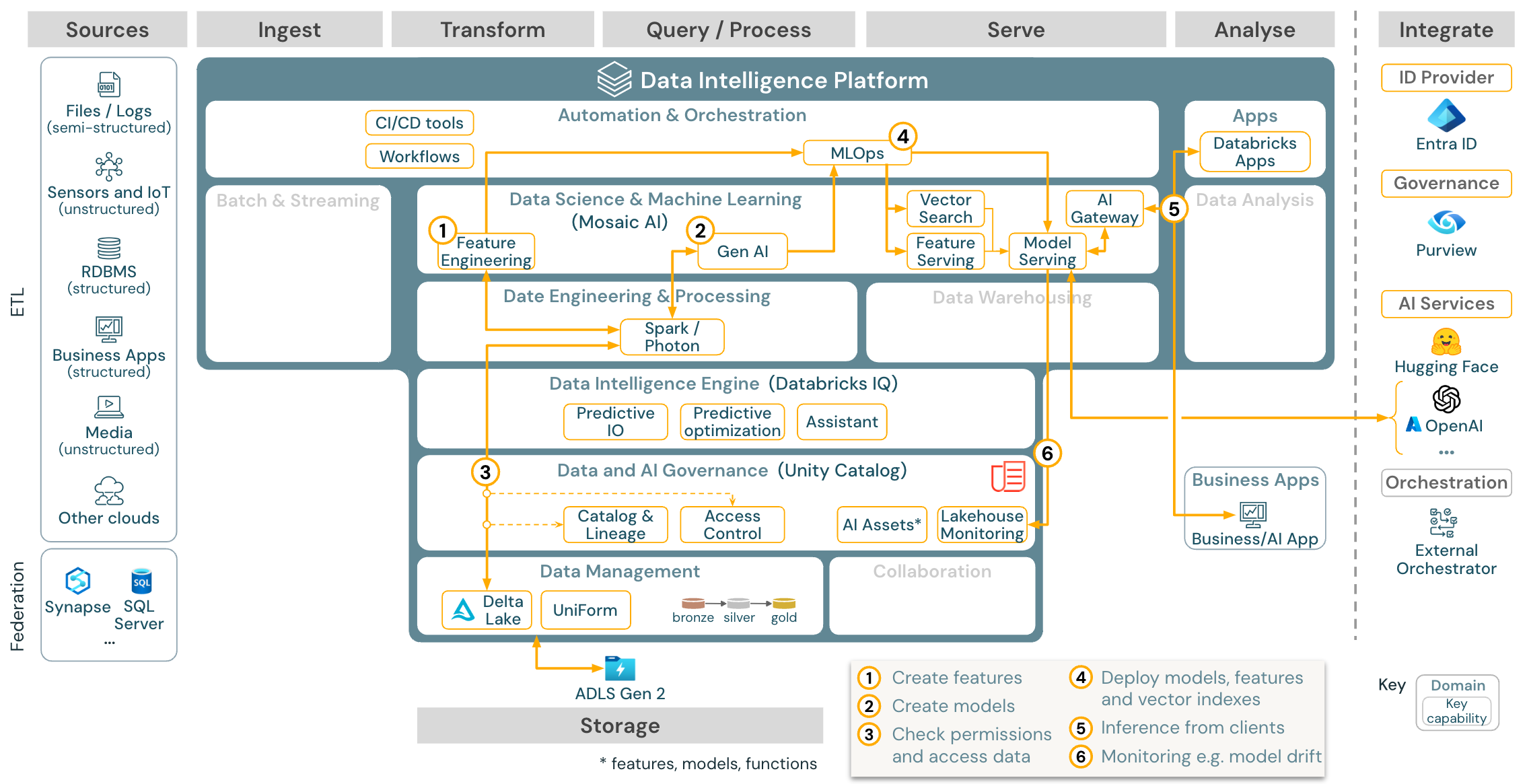

Användningsfall: Generativa AI-agentprogram (Gen AI)

Ladda ned: Gen AI-programreferensarkitektur för Azure Databricks

För generativa AI-användningsfall levereras Mosaic AI med toppmoderna bibliotek och specifika gen-AI-funktioner från snabb teknik till finjustering av befintliga modeller och förträning från grunden. Arkitekturen ovan visar ett exempel på hur vektorsökning kan integreras för att skapa ett gen-AI-program med hjälp av RAG (hämtning av utökad generering).

För att distribuera modeller på ett skalbart och företagsbaserat sätt använder du MLOps-funktionerna för att publicera modellerna i modellservern.

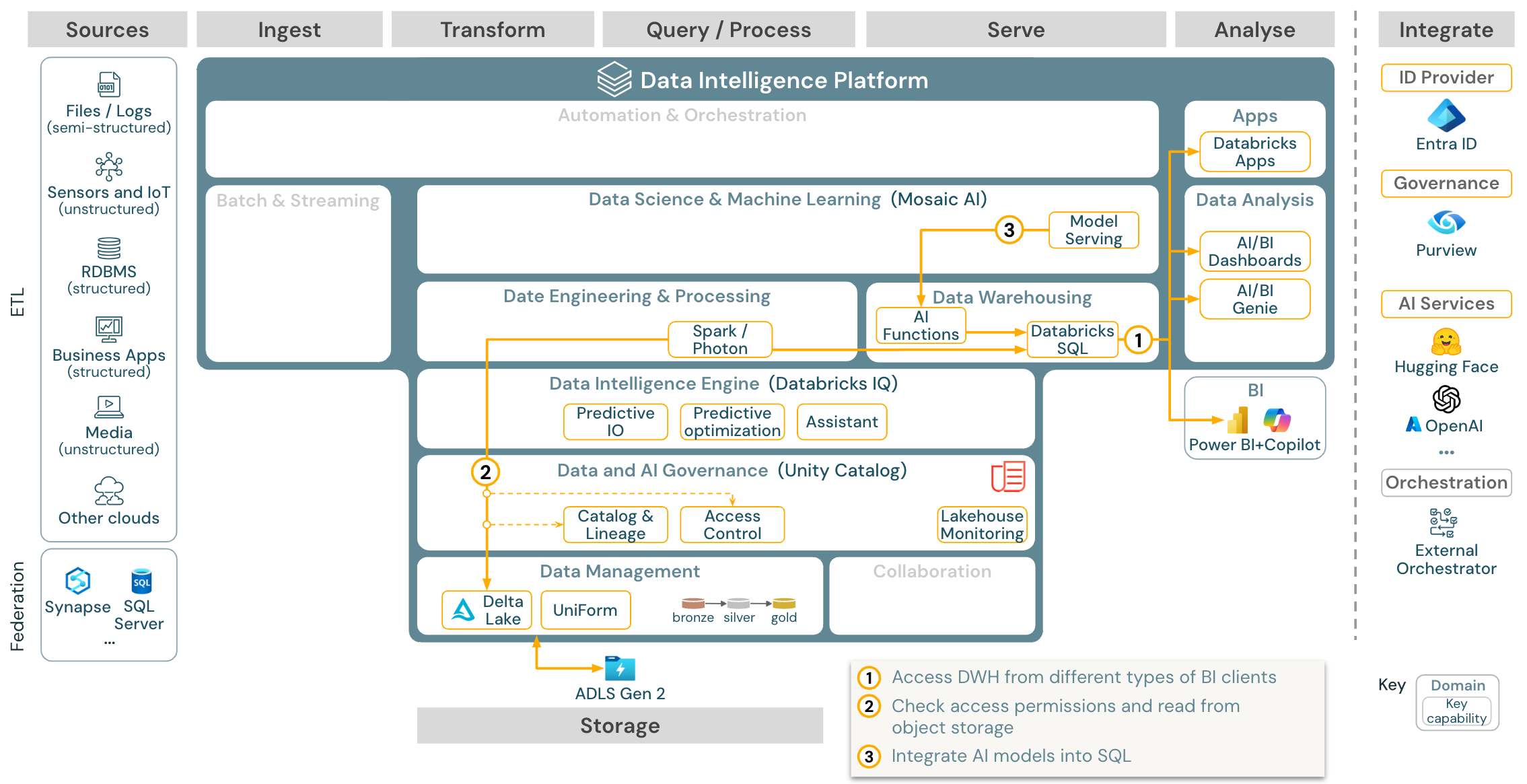

Användningsfall: BI- och SQL-analys

Ladda ned: REFERENSarkitektur för BI- och SQL-analys för Azure Databricks

För BI-användningsfall kan affärsanalytiker använda instrumentpaneler, Databricks SQL-redigeraren eller specifika BI-verktyg som Tableau eller Power BI. I samtliga fall är motorn Databricks SQL (serverlös eller icke-serverlös) och dataidentifiering, utforskning och åtkomstkontroll tillhandahålls av Unity Catalog.

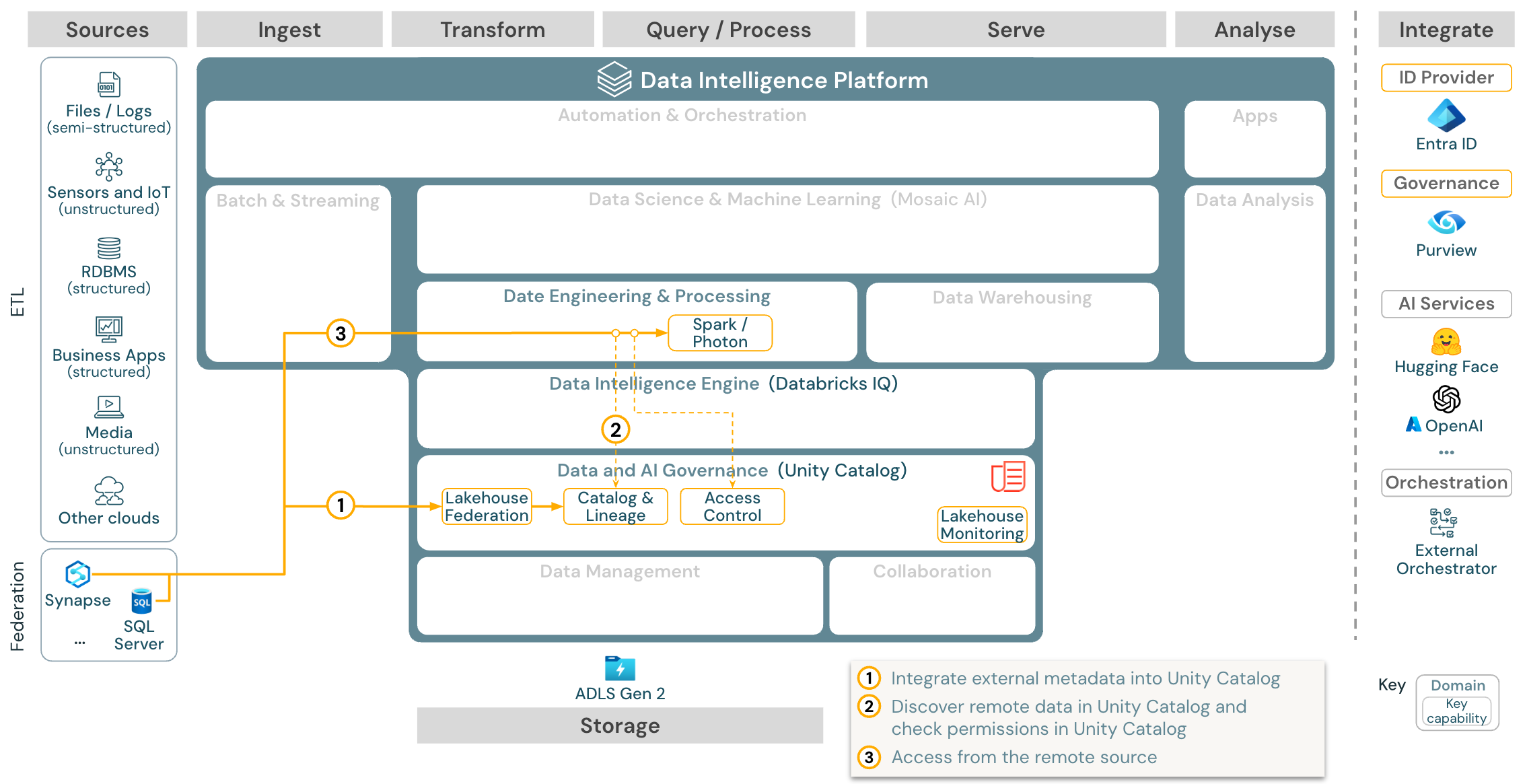

Användningsfall: Lakehouse-federation

Ladda ner: Referensarkitektur för Lakehouse-federationens Azure Databricks

Lakehouse-federationen tillåter att externa DATA SQL-databaser (till exempel MySQL, Postgres, SQL Server eller Azure Synapse) integreras med Databricks.

Alla arbetsbelastningar (AI, DWH och BI) kan dra nytta av detta utan att först behöva ETL-data till objektlagring. Den externa källkatalogen mappas till Unity-katalogen och detaljerad åtkomstkontroll kan tillämpas på åtkomst via Databricks-plattformen.

Användningsfall: Delning av företagsdata

Ladda ned: Referensarkitektur för företagsdatadelning för Azure Databricks

Datadelning i företagsklass tillhandahålls av DeltaDelning. Det ger direkt åtkomst till data i objektlagret som skyddas av Unity Catalog, och Databricks Marketplace är ett öppet forum för utbyte av dataprodukter.