Arbetsflöde för utvärderingsdriven utveckling

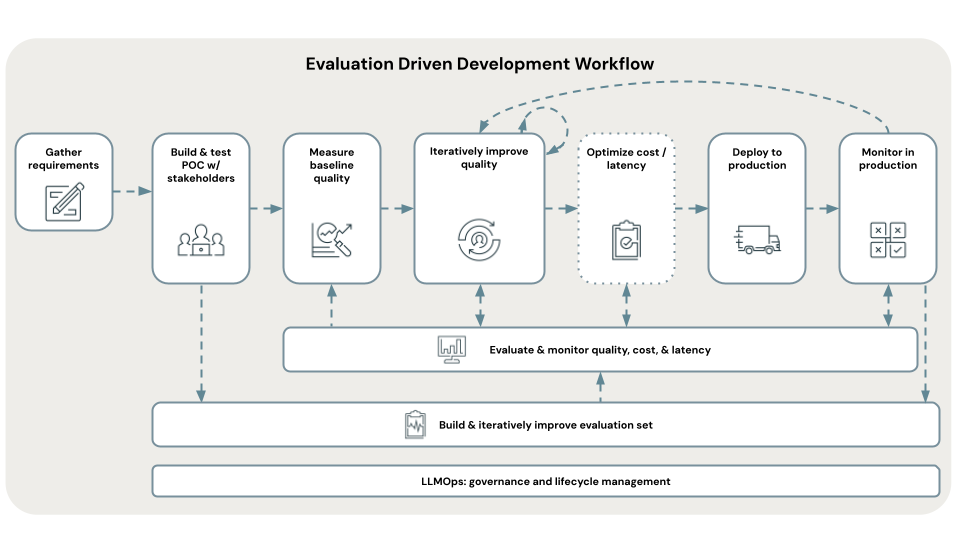

I det här avsnittet går vi igenom databricks rekommenderade arbetsflöde för utveckling för att skapa, testa och distribuera ett HÖGKVALITATIVt RAG-program: utvärderingsdriven utveckling. Det här arbetsflödet baseras på Mosaic Research-teamets rekommenderade metodtips för att skapa och utvärdera HÖGKVALITATIVa RAG-program. Databricks rekommenderar följande utvärderingsdrivna arbetsflöde:

- Definiera kraven.

- Samla in feedback från intressenter om ett snabbt konceptbevis (POC).

- Utvärdera POC:s kvalitet.

- Diagnostisera och åtgärda kvalitetsproblem iterativt.

- Distribuera till produktion.

- Övervaka i produktion.

Det finns två grundläggande begrepp inom utvärderingsdriven utveckling:

Mått: Definiera vad hög kvalitet innebär.

På samma sätt som du anger affärsmål varje år måste du definiera vad hög kvalitet betyder för ditt användningsfall. Mosaic AI Agent Evaluation tillhandahåller en föreslagen uppsättning mått att använda, varav det viktigaste är svarsnoggrannhet eller korrekthet – ger RAG-programmet rätt svar?

Utvärderingsuppsättning: Mät måtten objektivt.

För att objektivt mäta kvalitet behöver du en utvärderingsuppsättning som innehåller frågor med kända och bra svar som verifierats av människor. Den här guiden vägleder dig genom processen att utveckla och iterativt förfina den här utvärderingsuppsättningen.

Förankring mot mått och en utvärderingsuppsättning ger följande fördelar:

- Du kan iterativt och säkert förfina programmets kvalitet under utvecklingen – ingen mer gissning om en ändring resulterade i en förbättring.

- Att anpassa sig till affärsintressenter om programmets beredskap för produktion blir enklare när du med säkerhet kan säga att "vi vet att vårt program svarar rätt på de mest kritiska frågorna till vår verksamhet och inte hallucinerar".

För en stegvis genomgång som illustrerar det utvärderingsdrivna arbetsflödet börjar du med Krav: Samla in krav.