Utvärdera prestanda: Mått som är viktiga

Den här artikeln beskriver hur du mäter prestanda för ett RAG-program för kvaliteten på hämtning, svar och systemprestanda.

Hämtning, svar och prestanda

Med en utvärderingsuppsättning kan du mäta prestandan för ditt RAG-program över ett antal olika dimensioner, inklusive:

- Hämtningskvalitet: Hämtningsmått utvärderar hur rag-programmet hämtar relevanta stöddata. Precision och återkallande är två viktiga hämtningsmått.

- Svarskvalitet: Svarskvalitetsmått utvärderar hur väl RAG-programmet svarar på en användares begäran. Svarsmått kan till exempel mäta om det resulterande svaret är korrekt enligt grundsanningen, hur välgrundat svaret fick den hämtade kontexten (t.ex. hallucinerade LLM?) eller hur säkert svaret var (med andra ord ingen toxicitet).

- Systemprestanda (kostnad och svarstid): Måtten samlar in den totala kostnaden och prestandan för RAG-program. Övergripande svarstid och tokenförbrukning är exempel på kedjeprestandamått.

Det är mycket viktigt att samla in både svars- och hämtningsmått. Ett RAG-program kan svara dåligt trots att rätt kontext hämtas. Det kan också ge bra svar baserat på felaktiga hämtningar. Endast genom att mäta båda komponenterna kan vi korrekt diagnostisera och åtgärda problem i programmet.

Metoder för att mäta prestanda

Det finns två viktiga metoder för att mäta prestanda i dessa mått:

- Deterministisk mätning: Kostnads- och svarstidsmått kan beräknas deterministiskt baserat på programmets utdata. Om utvärderingsuppsättningen innehåller en lista över dokument som innehåller svaret på en fråga kan en delmängd av hämtningsmåtten också beräknas deterministiskt.

- LLM-bedömningsbaserad mätning: I den här metoden fungerar en separat LLM som domare för att utvärdera kvaliteten på RAG-programmets hämtning och svar. Vissa LLM-domare, till exempel korrekt svar, jämför den människomärkta grundsanningen jämfört med appens utdata. Andra LLM-domare, till exempel grundlighet, kräver inte mänsklig mark sanning för att bedöma sina apputdata.

Viktigt!

För att en LLM-domare ska vara effektiv måste den justeras för att förstå användningsfallet. Att göra det kräver noggrann uppmärksamhet för att förstå var domaren fungerar och inte fungerar bra, och sedan justera domaren för att förbättra den i fall där den misslyckas.

Mosaic AI Agent Evaluation tillhandahåller en out-of-the-box-implementering med värdbaserade LLM-domarmodeller för varje mått som beskrivs på den här sidan. Dokumentationen för agentutvärderingen beskriver information om hur dessa mått och domare implementeras och ger funktioner för att finjustera domarna med dina data för att öka deras noggrannhet

Översikt över mått

Nedan visas en sammanfattning av de mått som Databricks rekommenderar för att mäta kvalitet, kostnad och svarstid för ditt RAG-program. Dessa mått implementeras i Mosaic AI Agent Evaluation.

| Dimension | Måttnamn | Fråga | Mätt enligt | Behöver du grundsanning? |

|---|---|---|---|---|

| Hämtning | chunk_relevance/precision | Vilka % av de hämtade segmenten är relevanta för begäran? | LLM-domare | Nej |

| Hämtning | document_recall | Vilka % av faktadokumenten representeras i de hämtade segmenten? | Deterministisk | Ja |

| Hämtning | kontexttillräcklighet | Är de hämtade segmenten tillräckligt för att generera det förväntade svaret? | LLM-domare | Ja |

| Response | korrekthet | Sammantaget, genererade agenten ett korrekt svar? | LLM-domare | Ja |

| Response | relevance_to_query | Är svaret relevant för begäran? | LLM-domare | Nej |

| Response | grundstötning | Är svaret en hallucination eller grundad i sitt sammanhang? | LLM-domare | Nej |

| Response | säkerhet | Finns det skadligt innehåll i svaret? | LLM-domare | Nej |

| Kostnad | total_token_count, total_input_token_count, total_output_token_count | Vad är det totala antalet token för LLM-generationer? | Deterministisk | Nej |

| Svarstid | latency_seconds | Vad är svarstiden för att köra appen? | Deterministisk | Nej |

Så här fungerar hämtningsmått

Hämtningsmått hjälper dig att förstå om din retriever levererar relevanta resultat. Hämtningsmått baseras på precision och återkallande.

| Måttnamn | Besvarad fråga | Details |

|---|---|---|

| Precision | Vilka % av de hämtade segmenten är relevanta för begäran? | Precision är andelen hämtade dokument som faktiskt är relevanta för användarens begäran. En LLM-domare kan användas för att bedöma relevansen för varje hämtat segment för användarens begäran. |

| Återkalla | Vilka % av faktadokumenten representeras i de hämtade segmenten? | Träffsäkerhet är andelen av de faktadokument som representeras i de hämtade segmenten. Det här är ett mått på resultatets fullständighet. |

Precision och träffsäkerhet

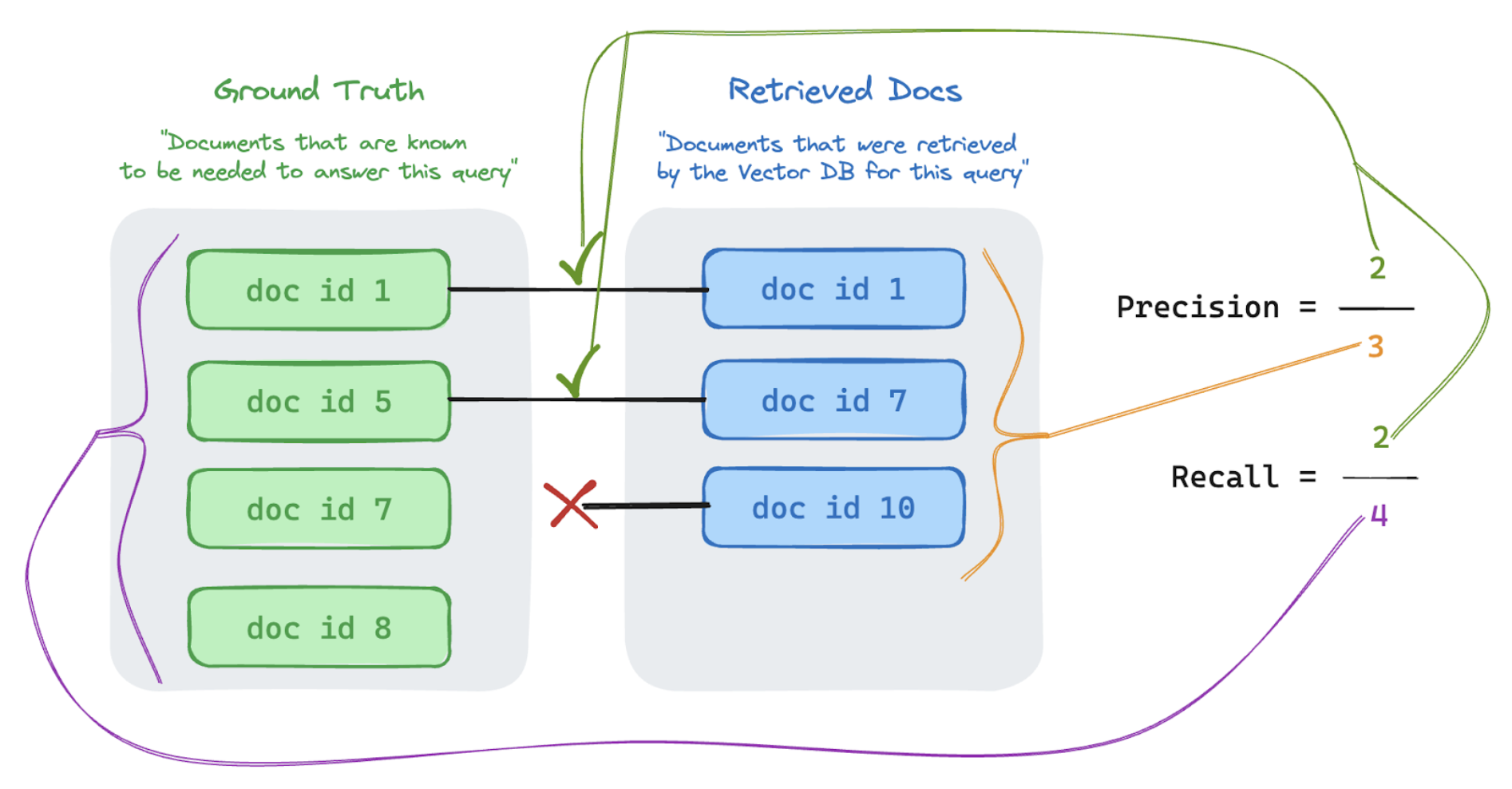

Nedan visas en snabb primer på Precision och återkallande anpassad från den utmärkta Wikipedia-artikeln.

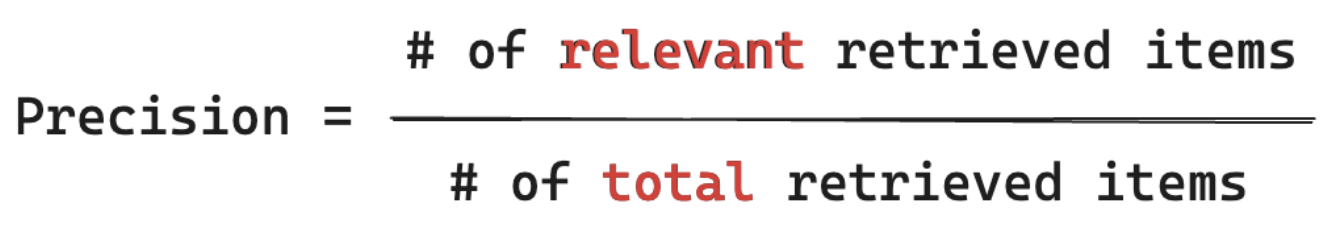

Precisionsformel

Precision mäter "Av de segment som jag hämtade, vilka % av dessa objekt är faktiskt relevanta för min användares fråga?" Databehandlingsprecision kräver inte att du känner till alla relevanta objekt.

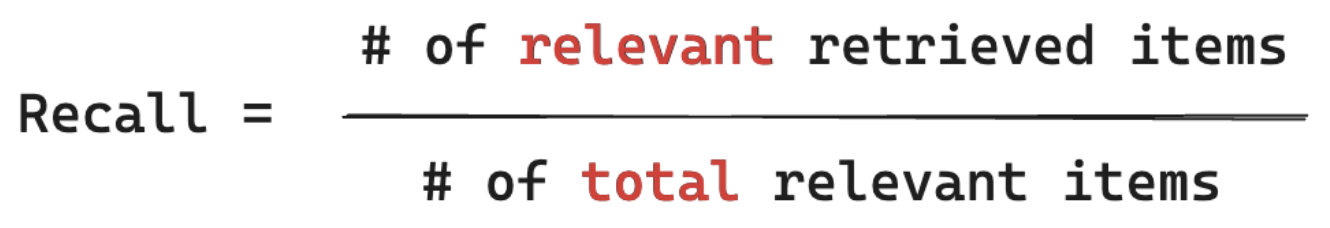

Återkalla formel

Kom ihåg måtten "Av ALLA dokument som jag vet är relevanta för min användares fråga, vilken % hämtade jag ett segment från?" Databehandlingsåterkallning kräver att din grundsanning innehåller alla relevanta objekt. Objekt kan antingen vara ett dokument eller ett segment av ett dokument.

I exemplet nedan var två av de tre hämtade resultaten relevanta för användarens fråga, så precisionen var 0,66 (2/3). De hämtade dokumenten innehöll två av totalt fyra relevanta dokument, så återkallelsen var 0,5 (2/4).