Databricks Runtime 7.4 (EoS)

Kommentar

Stödet för den här Databricks Runtime-versionen har upphört. Information om slutdatumet för support finns i Historik över supportens slut. Alla Databricks Runtime-versioner som stöds finns i Databricks Runtime-versionsanteckningar och kompatibilitet.

Databricks släppte den här versionen i november 2020.

Följande viktig information innehåller information om Databricks Runtime 7.4, som drivs av Apache Spark 3.0.

Nya funktioner

I detta avsnitt:

- Funktioner och förbättringar i Delta Lake

- Automatisk inläsare stöder nu delegering av filaviseringsresurser som konfigurerats till administratörer

-

Ny

USAGEbehörighet ger administratörer större kontroll över behörigheter för dataåtkomst - DBFS FUSE har nu aktiverats för genomströmningsaktiverade kluster

Funktioner och förbättringar i Delta Lake

Den här versionen innehåller följande Delta Lake-funktioner och förbättringar:

- Nytt API gör att Delta Lake kan verifiera att data som läggs till i en table uppfyller begränsningarna

- Nytt API låter dig återställa en Delta-table till en äldre version av table

- Ny startversion tillåter att endast de senaste ändringarna returneras i en Delta Lake-strömningskälla

-

Förbättrad stabilitet i

OPTIMIZE

Med det nya API:et kan Delta Lake verifiera att data som lagts till i en table uppfyller begränsningarna

Delta Lake stöder CHECK nu begränsningar. När detta anges verifierar Delta Lake automatiskt att data som läggs till i en table uppfyller det angivna uttrycket.

Om du vill lägga till CHECK begränsningar använder du ALTER TABLE ADD CONSTRAINTS kommandot . Mer information finns i Begränsningar för Azure Databricks.

Med det nya API:et kan du återställa en Delta-table till en äldre version av table

Nu kan du återställa Delta-tables till äldre versioner med hjälp av kommandot RESTORE:

SQL

RESTORE <table> TO VERSION AS OF n;

RESTORE <table> TO TIMESTAMP AS OF 'yyyy-MM-dd HH:mm:ss';

Python

from delta.tables import DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp('yyyy-MM-dd')

Scala

import io.delta.tables.DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp("yyyy-MM-dd")

RESTORE skapar en ny commit som återställer alla ändringar som gjorts i din table sedan versionen du vill restore. Alla befintliga data och metadata återställs, vilket inkluderar schema, begränsningar, strömmande transaktions-ID: er, COPY INTO metadata och table protokollversion. Mer information finns i RestoretableDelta.

Ny startversion tillåter att endast de senaste ändringarna returneras i en Delta Lake-strömningskälla

Om du bara vill returnera de senaste ändringarna anger du startingVersion som latest. Mer information finns i Ange inledande position.

Förbättrad stabilitet i OPTIMIZE

OPTIMIZE (utan några partition predikat) kan skalas till att köras på tables med tiotals miljoner små filer. Tidigare kunde Apache Spark-drivrutinen få slut på minne och OPTIMIZE skulle inte slutföras.

OPTIMIZE hanterar nu mycket stora tables med tiotals miljoner filer.

Automatisk inläsare stöder nu delegering av filaviseringsresurser som konfigurerats till administratörer

Med ett nytt Scala-API kan administratörer set upp filaviseringsresurser för Auto Loader. Datatekniker kan nu använda sina automatiska inläsningsströmmar med färre behörigheter genom att delegera den första resurskonfigurationen till sina administratörer. Se Konfigurera eller hantera filaviseringsresurser manuellt.

Ny USAGE behörighet ger administratörer större kontroll över behörigheter för dataåtkomst

Om du vill utföra en åtgärd på ett objekt i en databas måste du nu beviljas behörighet för databasen USAGE utöver de behörigheter som krävs för att utföra åtgärden. Behörigheten USAGE beviljas för en databas eller en catalog. Med introduktionen av USAGE privilegiet kan en table ägare inte längre ensidigt besluta att dela den med en annan användare. användaren måste också ha USAGE behörighet på databasen som innehåller table.

I arbetsytorna som har åtkomstkontrollen table aktiverad har users-gruppen automatiskt behörigheten USAGE för rot-CATALOG.

Mer information finns i ANVÄNDNINGsprivilegier.

DBFS FUSE har nu aktiverats för genomströmningsaktiverade kluster

Nu kan du läsa och skriva från DBFS med fuse-monteringen när /dbfs/ du använder ett kluster med hög samtidighet aktiverat för genomströmning av autentiseringsuppgifter. Vanliga monteringar stöds. Monteringar som kräver genomströmning credentials stöds inte.

Förbättringar

Spark SQL stöder IFF och CHARINDEX som synonymer för IF och POSITION

I Databricks Runtime IF() är en synonym för CASE WHEN <cond> THEN <expr1> ELSE <expr2> END

Databricks Runtime stöder IFF() nu som synonym för IF()

SELECT IFF(c1 = 1, 'Hello', 'World'), c1 FROM (VALUES (1), (2)) AS T(c1)

=> (Hello, 1)

(World, 2)

CHARINDEX är ett alternativt namn för POSITION funktionen.

CHARINDEX hittar positionen för den första förekomsten av en sträng i en annan sträng med ett valfritt startindex.

VALUES(CHARINDEX('he', 'hello from hell', 2))

=> 12

Flera utdata per cell aktiverat för Python-notebook-filer som standard

Databricks Runtime 7.1 introducerade stöd för flera utdata per cell i Python-notebook-filer (och %python-celler i icke-Python-notebook-filer), men du var skyldig att aktivera funktionen för din notebook-fil. Den här funktionen är aktiverad som standard i Databricks Runtime 7.4. Se Visa flera utdata per cell.

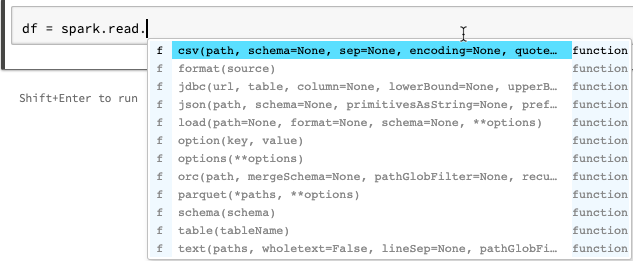

Komplettera automatiskt förbättringar för Python-notebook-filer

Automatisk komplettering för Python visar ytterligare typinformation som genereras från statisk analys av koden med hjälp av Jedi-biblioteket. Du kan trycka på tabbtangenten för att se en list med alternativ.

Förbättrade display Spark ML-vektorer i förhandsversionen av Spark DataFrame

Formatet display visar nu etiketter för vektortyp (gles eller tät), längd, index (för glesa vektorer) och values.

Andra korrigeringar

- Ett hämtningsproblem har åtgärdats med

collections.namedtuplei notebook-filer. - Ett hämtningsproblem med interaktivt definierade klasser och metoder har åtgärdats.

- Åtgärdade en bugg som gjorde att anrop till

mlflow.start_run()misslyckades vid pass-through eller kluster med aktiverad åtkomstkontroll för table.

Biblioteksuppgraderingar

- Uppgraderade Python-bibliotek:

- jedi uppgraderade från 0.14.1 till 0.17.2.

- koalas uppgraderade från 1.2.0 till 1.3.0.

- parso uppgraderad från 0.5.2 till 0.7.0.

- Uppgraderade flera installerade R-bibliotek. Se Installerade R-bibliotek.

Apache Spark

Databricks Runtime 7.4 innehåller Apache Spark 3.0.1. Den här versionen innehåller alla Spark-korrigeringar och förbättringar som ingår i Databricks Runtime 7.3 LTS (EoS) samt följande ytterligare felkorrigeringar och förbättringar som gjorts i Spark:

- [SPARK-33170] [SQL] Lägga till SQL-konfiguration för att styra beteende vid snabba fel i FileFormatWriter

- [SPARK-33136] [SQL] Åtgärda felaktigt växlad parameter i V2WriteCommand.outputResolved

- [SPARK-33134] [SQL] Returnera endast partiella resultat för JSON-rotobjekt

- [SPARK-33038] [SQL] Kombinera AQE initial och aktuell plan s...

- [SPARK-33118] [SQL] CREATE TEMPORARY TABLE fails with location

- [SPARK-33101] [ML] Gör så att LibSVM-format sprider Hadoop-konfiguration från DS-alternativ till underliggande HDFS-filsystem

- [SPARK-33035] [SQL] Uppdaterar föråldrade poster för attributmappning i QueryPlan#transformUpWithNewOutput

- [SPARK-33091] [SQL] Undvik att använda karta i stället för foreach för att undvika potentiell biverkning hos anropare av OrcUtils.readCatalystSchema

- [SPARK-33073] [PYTHON] Förbättra felhanteringen på Fel vid Konvertering av Pandas till Pil

- [SPARK-33043] [ML] Hantera spark.driver.maxResultSize=0 i RowMatrix heuristisk beräkning

- [SPARK-29358] [SQL] Gör unionByName möjligt att fylla saknade columns med null-värden

- [SPARK-32996] [WEB-UI] Hantera tomma ExecutorMetrics i ExecutorMetricsJsonSerializer

- [SPARK-32585] [SQL] Stöd för scala-uppräkning i ScalaReflection

- [SPARK-33019] [CORE] Använd spark.hadoop.mapreduce.fileoutputcommitter.algorithm.version=1 som standard

- [SPARK-33018] [SQL] Åtgärda problem med uppskattningsstatistik om underordnad har 0 byte

- [SPARK-32901] [CORE] Allokera inte minne när du spiller UnsafeExternalSorter

- [SPARK-33015] [SQL] Använda millisToDays() i ComputeCurrentTime-regeln

- [SPARK-33015] [SQL] Beräkna det aktuella datumet endast en gång

- [SPARK-32999] [SQL] Använd Utils.getSimpleName för att undvika att träffa felaktigt klassnamn i TreeNode

- [SPARK-32659] [SQL] Broadcast Array i stället för Set i InSubqueryExec

- [SPARK-32718] [SQL] Remove onödiga nyckelord för intervallenheter

- [SPARK-32886] [WEBUI] åtgärdar länken "odefinierad" i händelsetidsvyn

- [SPARK-32898] [CORE] Åtgärda fel executorRunTime när aktiviteten avlivas före verklig start

- [SPARK-32635] [SQL] Lägga till ett nytt testfall i katalysatormodulen

- [SPARK-32930] [CORE] Ersätt inaktuella isFile/isDirectory-metoder

- [SPARK-32906] [SQL] Struct-fältnamn bör inte ändras efter normalisering av flyttal

- [SPARK-24994] [SQL] Lägg till UnwrapCastInBinaryComparison-optimeraren för att förenkla integralliteral

- [SPARK-32635] [SQL] Åtgärda vikbar spridning

-

[SPARK-32738] [CORE] Bör minska antalet aktiva trådar om ett allvarligt fel inträffar i

Inbox.process - [SPARK-32900] [CORE] Tillåt att UnsafeExternalSorter spills när det finns null-värden

- [SPARK-32897] [PYTHON] Visa inte en utfasningsvarning på SparkSession.builder.getOrCreate

- [SPARK-32715] [CORE] Åtgärda minnesläcka när det inte gick att lagra sändningsdelar

- [SPARK-32715] [CORE] Åtgärda minnesläcka när det inte gick att lagra sändningsdelar

- [SPARK-32872] [CORE] Förhindra att BytesToBytesMap vid MAX_CAPACITY överskrider tröskelvärdet för tillväxt

- [SPARK-32876] [SQL] Ändra standardåterställningsversioner till 3.0.1 och 2.4.7 i HiveExternalCatalogVersionsSuite

- [SPARK-32840] [SQL] Ogiltigt intervallvärde kan hända att det bara är lim med enheten

- [SPARK-32819] [SQL] ignoreNullability-parametern bör vara effektiv rekursivt

- [SPARK-32832] [SS] Använda CaseInsensitiveMap för DataStreamReader/Writer-alternativ

- [SPARK-32794] [SS] Ett sällsynt hörnfallsfel har åtgärdats i mikrobatchmotorn med vissa tillståndskänsliga frågor + no-data-batchar + V1-källor

- [SPARK-32813] [SQL] Get standardkonfiguration av ParquetSource-vektoriserad läsare om ingen aktiv SparkSession

- [SPARK-32823] [WEBBGRÄNSSNITT] Åtgärda huvudrapportering för användargränssnittsresurser

- [SPARK-32824] [CORE] Förbättra felmeddelandet när användaren glömmer .amount i en resurskonfiguration

- [SPARK-32614] [SQL] Använd inte kommentarsbearbetning om kommentaren inte har tagits bort för CSV

- [SPARK-32638] [SQL] Korrigerar referenser när du lägger till alias i WidenSetOperationTypes

- [SPARK-32810] [SQL] CSV/JSON-datakällor bör undvika att globba sökvägar när du härleder schema

- [SPARK-32815] [ML] Åtgärda inläsningsfel för LibSVM-datakälla på filsökvägar med globmetadiagram

- [SPARK-32753] [SQL] Kopiera endast taggar till nod utan taggar

- [SPARK-32785] [SQL] Intervall med dinglande delar bör inte resultera i null

- [SPARK-32764] [SQL] -0.0 ska vara lika med 0,0

- [SPARK-32810] [SQL] CSV/JSON-datakällor bör undvika att globba sökvägar när du härleder schema

- [SPARK-32779] [SQL] Undvik att använda synkroniserat API för SessionCatalog i withClient-flödet, detta leder till DeadLock

- [SPARK-32791] [SQL] Mått som inte är partitionerade table bör inte ha dynamisk partition beskärningstid

- [SPARK-32767] [SQL] Bucket join bör fungera om spark.sql.shuffle.partitions större än bucketnummer

- [SPARK-32788] [SQL] icke-partitionerad table ska inte ha partition filter

- [SPARK-32776] [SS] Limit i strömning bör inte optimeras bort av PropagateEmptyRelation

- [SPARK-32624] [SQL] Åtgärda regression i CodegenContext.addReferenceObj på kapslade Scala-typer

- [SPARK-32659] [SQL] Förbättra testet för beskärning av DPP på icke-atomisk typ

- [SPARK-31511] [SQL] Gör BytesToBytesMap-iteratorer trådsäkra

- [SPARK-32693] [SQL] Jämför två dataramar med samma schema förutom egenskapen nullable

- [SPARK-28612] [SQL] Rätt metoddokument för DataFrameWriterV2.replace()

Underhållsuppdateringar

Se Underhållsuppdateringar för Databricks Runtime 7.4.

Systemmiljö

- Operativsystem: Ubuntu 18.04.5 LTS

- Java: Zulu 8.48.0.53-CA-linux64 (version 1.8.0_265-b11)

- Scala: 2.12.10

- Python: 3.7.5

- R: R version 3.6.3 (2020-02-29)

- Delta Lake 0.7.0

Installerade Python-bibliotek

| Bibliotek | Version | Bibliotek | Version | Bibliotek | Version |

|---|---|---|---|---|---|

| asn1crypto | 1.3.0 | backcall | 0.1.0 | boto3 | 1.12.0 |

| botocore | 1.15.0 | certifi | 2020.6.20 | cffi | 1.14.0 |

| chardet | 3.0.4 | kryptografi | 2.8 | cyklist | 0.10.0 |

| Cython | 0.29.15 | dekoratör | 4.4.1 | docutils | 0.15.2 |

| entrypoints | 0,3 | idna | 2.8 | ipykernel | 5.1.4 |

| ipython | 7.12.0 | ipython-genutils | 0.2.0 | jedi | 0.17.2 |

| jmespath | 0.10.0 | joblib | 0.14.1 | jupyter-client | 5.3.4 |

| jupyter-core | 4.6.1 | kiwisolver | 1.1.0 | Koalas | 1.3.0 |

| matplotlib | 3.1.3 | numpy | 1.18.1 | Pandas | 1.0.1 |

| parso | 0.7.0 | Patsy | 0.5.1 | pexpect | 4.8.0 |

| pickleshare | 0.7.5 | pip | 20.0.2 | prompt-toolkit | 3.0.3 |

| psycopg2 | 2.8.4 | ptyprocess | 0.6.0 | pyarrow | 1.0.1 |

| pycparser | 2,19 | Pygments | 2.5.2 | PyGObject | 3.26.1 |

| pyOpenSSL | 19.1.0 | pyparsing | 2.4.6 | PySocks | 1.7.1 |

| python-apt | 1.6.5+ubuntu0.3 | python-dateutil | 2.8.1 | pytz | 2019.3 |

| pyzmq | 18.1.1 | begäranden | 2.22.0 | s3transfer | 0.3.3 |

| scikit-learn | 0.22.1 | scipy | 1.4.1 | seaborn | 0.10.0 |

| setuptools | 45.2.0 | sex | 1.14.0 | ssh-import-id | 5.7 |

| statsmodels | 0.11.0 | tromb | 6.0.3 | traitlets | 4.3.3 |

| obevakade uppgraderingar | 0,1 | urllib3 | 1.25.8 | virtualenv | 16.7.10 |

| wcwidth | 0.1.8 | hjul | 0.34.2 |

Installerade R-bibliotek

R-bibliotek installeras från Microsoft CRAN-ögonblicksbild på XXXX-XX-XX.

| Bibliotek | Version | Bibliotek | Version | Bibliotek | Version |

|---|---|---|---|---|---|

| askpass | 1,1 | assertthat | 0.2.1 | backportar | 1.1.8 |

| bas | 3.6.3 | base64enc | 0.1-3 | BH | 1.72.0-3 |

| bit | 1.1-15.2 | bit64 | 0.9-7 | blob | 1.2.1 |

| start | 1.3-25 | brygga | 1.0-6 | kvast | 0.7.0 |

| anropare | 3.4.3 | textmarkör | 6.0-86 | cellranger | 1.1.0 |

| Chron | 2.3-55 | klass | 7.3-17 | cli | 2.0.2 |

| clipr | 0.7.0 | cluster | 2.1.0 | codetools | 0.2-16 |

| färgområde | 1.4-1 | commonmark | 1,7 | kompilator | 3.6.3 |

| config | 0,3 | covr | 3.5.0 | krita | 1.3.4 |

| Överhörning | 1.1.0.1 | hårlock | 4.3 | data.table | 1.12.8 |

| datauppsättningar | 3.6.3 | DBI | 1.1.0 | dbplyr | 1.4.4 |

| Desc | 1.2.0 | devtools | 2.3.0 | smälta | 0.6.25 |

| dplyr | 0.8.5 | DT | 0,14 | ellips | 0.3.1 |

| evaluate (utvärdera) | 0,14 | fansi | 0.4.1 | farver | 2.0.3 |

| fastmap | 1.0.1 | forcats | 0.5.0 | foreach | 1.5.0 |

| främmande | 0.8-76 | smida | 0.2.0 | Fs | 1.4.2 |

| Generika | 0.0.2 | ggplot2 | 3.3.2 | Gh | 1.1.0 |

| git2r | 0.27.1 | glmnet | 3.0-2 | globals | 0.12.5 |

| lim | 1.4.1 | Gower | 0.2.2 | grafik | 3.6.3 |

| grDevices | 3.6.3 | gitter | 3.6.3 | gridExtra | 2.3 |

| gsubfn | 0,7 | gtable | 0.3.0 | hamn | 2.3.1 |

| highr | 0,8 | Hms | 0.5.3 | htmltools | 0.5.0 |

| htmlwidgets | 1.5.1 | httpuv | 1.5.4 | httr | 1.4.1 |

| hwriter | 1.3.2 | hwriterPlus | 1.0-3 | ini | 0.3.1 |

| ipred | 0.9-9 | isoband | 0.2.2 | Iteratorer | 1.0.12 |

| jsonlite | 1.7.0 | KernSmooth | 2.23-17 | stickning | 1,29 |

| Märkning | 0,3 | senare | 1.1.0.1 | Galler | 0.20-41 |

| lava | 1.6.7 | lazyeval | 0.2.2 | livscykel | 0.2.0 |

| lubridate | 1.7.9 | magrittr | 1.5 | Markdown | 1,1 |

| MASSA | 7.3-53 | Matris | 1.2-18 | pmise | 1.1.0 |

| metoder | 3.6.3 | mgcv | 1.8-33 | MIME | 0,9 |

| ModelMetrics | 1.2.2.2 | modelr | 0.1.8 | munsell | 0.5.0 |

| nlme | 3.1-149 | nnet | 7.3-14 | numDeriv | 2016.8-1.1 |

| openssl | 1.4.2 | parallel | 3.6.3 | pelare | 1.4.6 |

| pkgbuild | 1.1.0 | pkgconfig | 2.0.3 | pkgload | 1.1.0 |

| plogr | 0.2.0 | plyr | 1.8.6 | berömma | 1.0.0 |

| prettyunits | 1.1.1 | Proc | 1.16.2 | processx | 3.4.3 |

| prodlim | 2019.11.13 | Förlopp | 1.2.2 | Löften | 1.1.1 |

| Proto | 1.0.0 | PS | 1.3.3 | purrr | 0.3.4 |

| r2d3 | 0.2.3 | R6 | 2.4.1 | randomForest | 4.6-14 |

| rappdirs | 0.3.1 | rcmdcheck | 1.3.3 | RColorBrewer | 1.1-2 |

| Rcpp | 1.0.5 | readr | 1.3.1 | readxl | 1.3.1 |

| recept | 0.1.13 | Returmatch | 1.0.1 | rematch2 | 2.1.2 |

| Fjärrkontroller | 2.1.1 | reprex | 0.3.0 | omforma2 | 1.4.4 |

| Rex | 1.2.0 | rjson | 0.2.20 | rlang | 0.4.7 |

| rmarkdown | 2.3 | RODBC | 1.3-16 | roxygen2 | 7.1.1 |

| rpart | 4.1-15 | rprojroot | 1.3-2 | Rserve | 1.8-7 |

| RSQLite | 2.2.0 | rstudioapi | 0,11 | rversioner | 2.0.2 |

| rvest | 0.3.5 | våg | 1.1.1 | väljare | 0.4-2 |

| sessioninfo | 1.1.1 | form | 1.4.4 | skinande | 1.5.0 |

| sourcetools | 0.1.7 | sparklyr | 1.3.1 | SparkR | 3.0.0 |

| rumslig | 7.3-11 | Splines | 3.6.3 | sqldf | 0.4-11 |

| SQUAREM | 2020.3 | statistik | 3.6.3 | stats4 | 3.6.3 |

| stringi | 1.4.6 | stringr | 1.4.0 | överlevnad | 3.2-7 |

| sys | 3.3 | tcltk | 3.6.3 | TeachingDemos | 2.10 |

| testthat | 2.3.2 | tibble | 3.0.3 | tidyr | 1.1.0 |

| avmarkera | 1.1.0 | tidyverse | 1.3.0 | timeDate | 3043.102 |

| tinytex | 0,24 | verktyg | 3.6.3 | usethis | 1.6.1 |

| utf8 | 1.1.4 | verktyg | 3.6.3 | uuid | 0.1-4 |

| vctrs | 0.3.1 | viridisLite | 0.3.0 | morrhår | 0,4 |

| withr | 2.2.0 | xfun | 0,15 | xml2 | 1.3.2 |

| xopen | 1.0.0 | xtable | 1.8-4 | yaml | 2.2.1 |

Installerade Java- och Scala-bibliotek (Scala 2.12-klusterversion)

| Grupp-ID | Artefakt-ID | Version |

|---|---|---|

| antlr | antlr | 2.7.7 |

| com.amazonaws | amazon-kinesis-client | 1.12.0 |

| com.amazonaws | aws-java-sdk-autoscaling | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudformation | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudfront | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudhsm | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudsearch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudtrail | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatchmetrics | 1.11.655 |

| com.amazonaws | aws-java-sdk-codedeploy | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitoidentity | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitosync | 1.11.655 |

| com.amazonaws | aws-java-sdk-config | 1.11.655 |

| com.amazonaws | aws-java-sdk-core | 1.11.655 |

| com.amazonaws | aws-java-sdk-datapipeline | 1.11.655 |

| com.amazonaws | aws-java-sdk-directconnect | 1.11.655 |

| com.amazonaws | aws-java-sdk-directory | 1.11.655 |

| com.amazonaws | aws-java-sdk-dynamodb | 1.11.655 |

| com.amazonaws | aws-java-sdk-ec2 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ecs | 1.11.655 |

| com.amazonaws | aws-java-sdk-efs | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticache | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticbeanstalk | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticloadbalancing | 1.11.655 |

| com.amazonaws | aws-java-sdk-elastictranscoder | 1.11.655 |

| com.amazonaws | aws-java-sdk-emr | 1.11.655 |

| com.amazonaws | aws-java-sdk-glacier | 1.11.655 |

| com.amazonaws | aws-java-sdk-iam | 1.11.655 |

| com.amazonaws | aws-java-sdk-importexport | 1.11.655 |

| com.amazonaws | aws-java-sdk-kinesis | 1.11.655 |

| com.amazonaws | aws-java-sdk-kms | 1.11.655 |

| com.amazonaws | aws-java-sdk-lambda | 1.11.655 |

| com.amazonaws | aws-java-sdk-logs | 1.11.655 |

| com.amazonaws | aws-java-sdk-machinelearning | 1.11.655 |

| com.amazonaws | aws-java-sdk-opsworks | 1.11.655 |

| com.amazonaws | aws-java-sdk-rds | 1.11.655 |

| com.amazonaws | aws-java-sdk-redshift | 1.11.655 |

| com.amazonaws | aws-java-sdk-route53 | 1.11.655 |

| com.amazonaws | aws-java-sdk-s3 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ses | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpledb | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpleworkflow | 1.11.655 |

| com.amazonaws | aws-java-sdk-sns | 1.11.655 |

| com.amazonaws | aws-java-sdk-sqs | 1.11.655 |

| com.amazonaws | aws-java-sdk-ssm | 1.11.655 |

| com.amazonaws | aws-java-sdk-storagegateway | 1.11.655 |

| com.amazonaws | aws-java-sdk-sts | 1.11.655 |

| com.amazonaws | aws-java-sdk-support | 1.11.655 |

| com.amazonaws | aws-java-sdk-swf-libraries | 1.11.22 |

| com.amazonaws | aws-java-sdk-workspaces | 1.11.655 |

| com.amazonaws | jmespath-java | 1.11.655 |

| com.chuusai | shapeless_2.12 | 2.3.3 |

| com.clearspring.analytics | ström | 2.9.6 |

| com.databricks | Rserve | 1.8-3 |

| com.databricks | jets3t | 0.7.1-0 |

| com.databricks.scalapb | compilerplugin_2.12 | 0.4.15-10 |

| com.databricks.scalapb | scalapb-runtime_2.12 | 0.4.15-10 |

| com.esotericsoftware | kryo-skuggad | 4.0.2 |

| com.esotericsoftware | minlog | 1.3.0 |

| com.fasterxml | klasskamrat | 1.3.4 |

| com.fasterxml.jackson.core | jackson-anteckningar | 2.10.0 |

| com.fasterxml.jackson.core | jackson-core | 2.10.0 |

| com.fasterxml.jackson.core | jackson-databind | 2.10.0 |

| com.fasterxml.jackson.dataformat | jackson-dataformat-cbor | 2.10.0 |

| com.fasterxml.jackson.datatype | jackson-datatype-joda | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-paranamer | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-scala_2.12 | 2.10.0 |

| com.github.ben-manes.koffein | koffein | 2.3.4 |

| com.github.fommil | jniloader | 1,1 |

| com.github.fommil.netlib | kärna | 1.1.2 |

| com.github.fommil.netlib | native_ref-java | 1,1 |

| com.github.fommil.netlib | native_ref-java-natives | 1,1 |

| com.github.fommil.netlib | native_system-java | 1,1 |

| com.github.fommil.netlib | native_system-java-natives | 1,1 |

| com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1,1 |

| com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1,1 |

| com.github.joshelser | dropwizard-metrics-hadoop-metrics2-reporter | 0.1.2 |

| com.github.luben | zstd-jni | 1.4.4-3 |

| com.github.wendykierp | JTransforms | 3.1 |

| com.google.code.findbugs | jsr305 | 3.0.0 |

| com.google.code.gson | gson | 2.2.4 |

| com.google.flatbuffers | flatbuffers-java | 1.9.0 |

| com.google.guava | guava | 15.0 |

| com.google.protobuf | protobuf-java | 2.6.1 |

| com.h2database | h2 | 1.4.195 |

| com.helger | profilerare | 1.1.1 |

| com.jcraft | jsch | 0.1.50 |

| com.jolbox | bonecp | 0.8.0.RELEASE |

| com.lihaoyi | sourcecode_2.12 | 0.1.9 |

| com.microsoft.azure | azure-data-lake-store-sdk | 2.2.8 |

| com.microsoft.sqlserver | mssql-jdbc | 8.2.1.jre8 |

| com.ning | compress-lzf | 1.0.3 |

| com.sun.mail | javax.mail | 1.5.2 |

| com.tdunning | json | 1.8 |

| com.thoughtworks.paranamer | paranamer | 2.8 |

| com.trueaccord.lenses | lenses_2.12 | 0.4.12 |

| com.twitter | chill-java | 0.9.5 |

| com.twitter | chill_2.12 | 0.9.5 |

| com.twitter | util-app_2.12 | 7.1.0 |

| com.twitter | util-core_2.12 | 7.1.0 |

| com.twitter | util-function_2.12 | 7.1.0 |

| com.twitter | util-jvm_2.12 | 7.1.0 |

| com.twitter | util-lint_2.12 | 7.1.0 |

| com.twitter | util-registry_2.12 | 7.1.0 |

| com.twitter | util-stats_2.12 | 7.1.0 |

| com.typesafe | config | 1.2.1 |

| com.typesafe.scala-logging | scala-logging_2.12 | 3.7.2 |

| com.univocity | univocity-parsers | 2.9.0 |

| com.zaxxer | HikariCP | 3.1.0 |

| commons-beanutils | commons-beanutils | 1.9.4 |

| commons-cli | commons-cli | 1.2 |

| commons-codec | commons-codec | 1.10 |

| commons-collections | commons-collections | 3.2.2 |

| commons-configuration | commons-configuration | 1.6 |

| commons-dbcp | commons-dbcp | 1.4 |

| commons-digester | commons-digester | 1.8 |

| commons-fileupload | commons-fileupload | 1.3.3 |

| commons-httpclient | commons-httpclient | 3.1 |

| commons-io | commons-io | 2.4 |

| commons-lang | commons-lang | 2,6 |

| commons-logging | commons-logging | 1.1.3 |

| commons-net | commons-net | 3.1 |

| commons-pool | commons-pool | 1.5.4 |

| info.ganglia.gmetric4j | gmetric4j | 1.0.10 |

| io.airlift | aircompressor | 0.10 |

| io.dropwizard.metrics | metrics-core | 4.1.1 |

| io.dropwizard.metrics | metrics-graphite | 4.1.1 |

| io.dropwizard.metrics | metrics-healthchecks | 4.1.1 |

| io.dropwizard.metrics | metrics-jetty9 | 4.1.1 |

| io.dropwizard.metrics | metrics-jmx | 4.1.1 |

| io.dropwizard.metrics | metrics-json | 4.1.1 |

| io.dropwizard.metrics | metrics-jvm | 4.1.1 |

| io.dropwizard.metrics | metrics-servlets | 4.1.1 |

| io.netty | netty-all | 4.1.47.Final |

| jakarta.annotation | jakarta.annotation-api | 1.3.5 |

| jakarta.validation | jakarta.validation-api | 2.0.2 |

| jakarta.ws.rs | jakarta.ws.rs-api | 2.1.6 |

| javax.activation | aktivering | 1.1.1 |

| javax.el | javax.el-api | 2.2.4 |

| javax.jdo | jdo-api | 3.0.1 |

| javax.servlet | javax.servlet-api | 3.1.0 |

| javax.servlet.jsp | jsp-api | 2.1 |

| javax.transaction | jta | 1,1 |

| javax.transaction | transaction-api | 1,1 |

| javax.xml.bind | jaxb-api | 2.2.2 |

| javax.xml.stream | stax-api | 1.0-2 |

| javolution | javolution | 5.5.1 |

| jline | jline | 2.14.6 |

| joda-time | joda-time | 2.10.5 |

| log4j | apache-log4j-extras | 1.2.17 |

| log4j | log4j | 1.2.17 |

| net.razorvine | pyrolit | 4.30 |

| net.sf.jpam | jpam | 1,1 |

| net.sf.opencsv | opencsv | 2.3 |

| net.sf.supercsv | super-csv | 2.2.0 |

| net.snowflake | snowflake-ingest-sdk | 0.9.6 |

| net.snowflake | snowflake-jdbc | 3.12.8 |

| net.snowflake | spark-snowflake_2.12 | 2.8.1-spark_3.0 |

| net.sourceforge.f2j | arpack_combined_all | 0,1 |

| org.acplt.remotetea | remotetea-oncrpc | 1.1.2 |

| org.antlr | ST4 | 4.0.4 |

| org.antlr | antlr-runtime | 3.5.2 |

| org.antlr | antlr4-runtime | 4.7.1 |

| org.antlr | stringtemplate | 3.2.1 |

| org.apache.ant | Ant | 1.9.2 |

| org.apache.ant | ant-jsch | 1.9.2 |

| org.apache.ant | ant-launcher | 1.9.2 |

| org.apache.arrow | pilformat | 0.15.1 |

| org.apache.arrow | pilminne | 0.15.1 |

| org.apache.arrow | pilvektor | 0.15.1 |

| org.apache.avro | avro | 1.8.2 |

| org.apache.avro | avro-ipc | 1.8.2 |

| org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

| org.apache.commons | commons-compress | 1.8.1 |

| org.apache.commons | commons-crypto | 1.0.0 |

| org.apache.commons | commons-lang3 | 3.9 |

| org.apache.commons | commons-math3 | 3.4.1 |

| org.apache.commons | commons-text | 1.6 |

| org.apache.curator | curator-client | 2.7.1 |

| org.apache.curator | curator-framework | 2.7.1 |

| org.apache.curator | curator-recept | 2.7.1 |

| org.apache.derby | Derby | 10.12.1.1 |

| org.apache.directory.api | api-asn1-api | 1.0.0-M20 |

| org.apache.directory.api | api-util | 1.0.0-M20 |

| org.apache.directory.server | apacheds-i18n | 2.0.0-M15 |

| org.apache.directory.server | apacheds-kerberos-codec | 2.0.0-M15 |

| org.apache.hadoop | hadoop-anteckningar | 2.7.4 |

| org.apache.hadoop | hadoop-auth | 2.7.4 |

| org.apache.hadoop | hadoop-client | 2.7.4 |

| org.apache.hadoop | hadoop-common | 2.7.4 |

| org.apache.hadoop | hadoop-hdfs | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-app | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-core | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-api | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-client | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-common | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-server-common | 2.7.4 |

| org.apache.hive | hive-beeline | 2.3.7 |

| org.apache.hive | hive-cli | 2.3.7 |

| org.apache.hive | hive-common | 2.3.7 |

| org.apache.hive | hive-exec-core | 2.3.7 |

| org.apache.hive | hive-jdbc | 2.3.7 |

| org.apache.hive | hive-llap-client | 2.3.7 |

| org.apache.hive | hive-llap-common | 2.3.7 |

| org.apache.hive | hive-metaarkiv | 2.3.7 |

| org.apache.hive | hive-serde | 2.3.7 |

| org.apache.hive | hive-shims | 2.3.7 |

| org.apache.hive | hive-storage-api | 2.7.1 |

| org.apache.hive | hive-vector-code-gen | 2.3.7 |

| org.apache.hive.shims | hive-shims-0.23 | 2.3.7 |

| org.apache.hive.shims | hive-shims-common | 2.3.7 |

| org.apache.hive.shims | hive-shims-scheduler | 2.3.7 |

| org.apache.htrace | htrace-core | 3.1.0-inkubering |

| org.apache.httpcomponents | httpclient | 4.5.6 |

| org.apache.httpcomponents | httpcore | 4.4.12 |

| org.apache.ivy | murgröna | 2.4.0 |

| org.apache.orc | orc-core | 1.5.10 |

| org.apache.orc | orc-mapreduce | 1.5.10 |

| org.apache.orc | orc-shims | 1.5.10 |

| org.apache.parquet | parquet-column | 1.10.1-databricks6 |

| org.apache.parquet | parquet-common | 1.10.1-databricks6 |

| org.apache.parquet | parquet-kodning | 1.10.1-databricks6 |

| org.apache.parquet | parquet-format | 2.4.0 |

| org.apache.parquet | parquet-hadoop | 1.10.1-databricks6 |

| org.apache.parquet | parquet-jackson | 1.10.1-databricks6 |

| org.apache.thrift | libfb303 | 0.9.3 |

| org.apache.thrift | libthrift | 0.12.0 |

| org.apache.velocity | hastighet | 1.5 |

| org.apache.xbean | xbean-asm7-shaded | 4.15 |

| org.apache.yetus | åhörarkommentarer | 0.5.0 |

| org.apache.zookeeper | zookeeper | 3.4.14 |

| org.codehaus.jackson | jackson-core-asl | 1.9.13 |

| org.codehaus.jackson | jackson-jaxrs | 1.9.13 |

| org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

| org.codehaus.jackson | jackson-xc | 1.9.13 |

| org.codehaus.janino | commons-compiler | 3.0.16 |

| org.codehaus.janino | janino | 3.0.16 |

| org.datanucleus | datanucleus-api-jdo | 4.2.4 |

| org.datanucleus | datanucleus-core | 4.1.17 |

| org.datanucleus | datanucleus-rdbms | 4.1.19 |

| org.datanucleus | javax.jdo | 3.2.0-m3 |

| org.eclipse.jetty | jetty-client | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-fortsättning | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-http | 9.4.18.v20190429 |

| org.eclipse.jetty | brygga-io | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-jndi | 9.4.18.v20190429 |

| org.eclipse.jetty | brygga plus | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-proxy | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-security | 9.4.18.v20190429 |

| org.eclipse.jetty | brygga-server | 9.4.18.v20190429 |

| org.eclipse.jetty | brygga-servlet | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-servlets | 9.4.18.v20190429 |

| org.eclipse.jetty | brygga-util | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-webapp | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-xml | 9.4.18.v20190429 |

| org.fusesource.leveldbjni | leveldbjni-all | 1.8 |

| org.glassfish.hk2 | hk2-api | 2.6.1 |

| org.glassfish.hk2 | hk2-locator | 2.6.1 |

| org.glassfish.hk2 | hk2-utils | 2.6.1 |

| org.glassfish.hk2 | osgi-resource-locator | 1.0.3 |

| org.glassfish.hk2.external | aopalliance-repackaged | 2.6.1 |

| org.glassfish.hk2.external | jakarta.inject | 2.6.1 |

| org.glassfish.jersey.containers | jersey-container-servlet | 2.30 |

| org.glassfish.jersey.containers | jersey-container-servlet-core | 2.30 |

| org.glassfish.jersey.core | jersey-client | 2.30 |

| org.glassfish.jersey.core | jersey-common | 2.30 |

| org.glassfish.jersey.core | jersey-server | 2.30 |

| org.glassfish.jersey.inject | jersey-hk2 | 2.30 |

| org.glassfish.jersey.media | jersey-media-jaxb | 2.30 |

| org.hibernate.validator | vilolägesverifierare | 6.1.0.Final |

| org.javassist | javassist | 3.25.0-GA |

| org.jboss.logging | jboss-logging | 3.3.2.Final |

| org.jdbi | jdbi | 2.63.1 |

| org.joda | joda-convert | 1,7 |

| org.jodd | jodd-core | 3.5.2 |

| org.json4s | json4s-ast_2.12 | 3.6.6 |

| org.json4s | json4s-core_2.12 | 3.6.6 |

| org.json4s | json4s-jackson_2.12 | 3.6.6 |

| org.json4s | json4s-scalap_2.12 | 3.6.6 |

| org.lz4 | lz4-java | 1.7.1 |

| org.mariadb.jdbc | mariadb-java-client | 2.1.2 |

| org.objenesis | objenesis | 2.5.1 |

| org.postgresql | postgresql | 42.1.4 |

| org.roaringbitmap | RoaringBitmap | 0.7.45 |

| org.roaringbitmap | Shims | 0.7.45 |

| org.rocksdb | rocksdbjni | 6.2.2 |

| org.rosuda.REngine | REngine | 2.1.0 |

| org.scala-lang | scala-compiler_2.12 | 2.12.10 |

| org.scala-lang | scala-library_2.12 | 2.12.10 |

| org.scala-lang | scala-reflect_2.12 | 2.12.10 |

| org.scala-lang.modules | scala-collection-compat_2.12 | 2.1.1 |

| org.scala-lang.modules | scala-parser-combinators_2.12 | 1.1.2 |

| org.scala-lang.modules | scala-xml_2.12 | 1.2.0 |

| org.scala-sbt | test-interface | 1.0 |

| org.scalacheck | scalacheck_2.12 | 1.14.2 |

| org.scalactic | scalactic_2.12 | 3.0.8 |

| org.scalanlp | breeze-macros_2.12 | 1.0 |

| org.scalanlp | breeze_2.12 | 1.0 |

| org.scalatest | scalatest_2.12 | 3.0.8 |

| org.slf4j | jcl-over-slf4j | 1.7.30 |

| org.slf4j | jul-to-slf4j | 1.7.30 |

| org.slf4j | slf4j-api | 1.7.30 |

| org.slf4j | slf4j-log4j12 | 1.7.30 |

| org.spark-project.spark | oanvänd | 1.0.0 |

| org.springframework | spring-core | 4.1.4.RELEASE |

| org.springframework | spring-test | 4.1.4.RELEASE |

| org.threeten | threeten-extra | 1.5.0 |

| org.tukaani | xz | 1.5 |

| org.typelevel | algebra_2.12 | 2.0.0-M2 |

| org.typelevel | cats-kernel_2.12 | 2.0.0-M4 |

| org.typelevel | machinist_2.12 | 0.6.8 |

| org.typelevel | macro-compat_2.12 | 1.1.1 |

| org.typelevel | spire-macros_2.12 | 0.17.0-M1 |

| org.typelevel | spire-platform_2.12 | 0.17.0-M1 |

| org.typelevel | spire-util_2.12 | 0.17.0-M1 |

| org.typelevel | spire_2.12 | 0.17.0-M1 |

| org.xerial | sqlite-jdbc | 3.8.11.2 |

| org.xerial.snappy | snappy-java | 1.1.7.5 |

| org.yaml | snakeyaml | 1,24 |

| oro | oro | 2.0.8 |

| pl.edu.icm | JLargeArrays | 1.5 |

| software.amazon.ion | ion-java | 1.0.2 |

| stax | stax-api | 1.0.1 |

| xmlenc | xmlenc | 0,52 |