Konfigurera en anslutning för att använda Azure AI-modellinferens i ditt AI-projekt

Viktigt!

Objekt markerade (förhandsversion) i den här artikeln är för närvarande i offentlig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

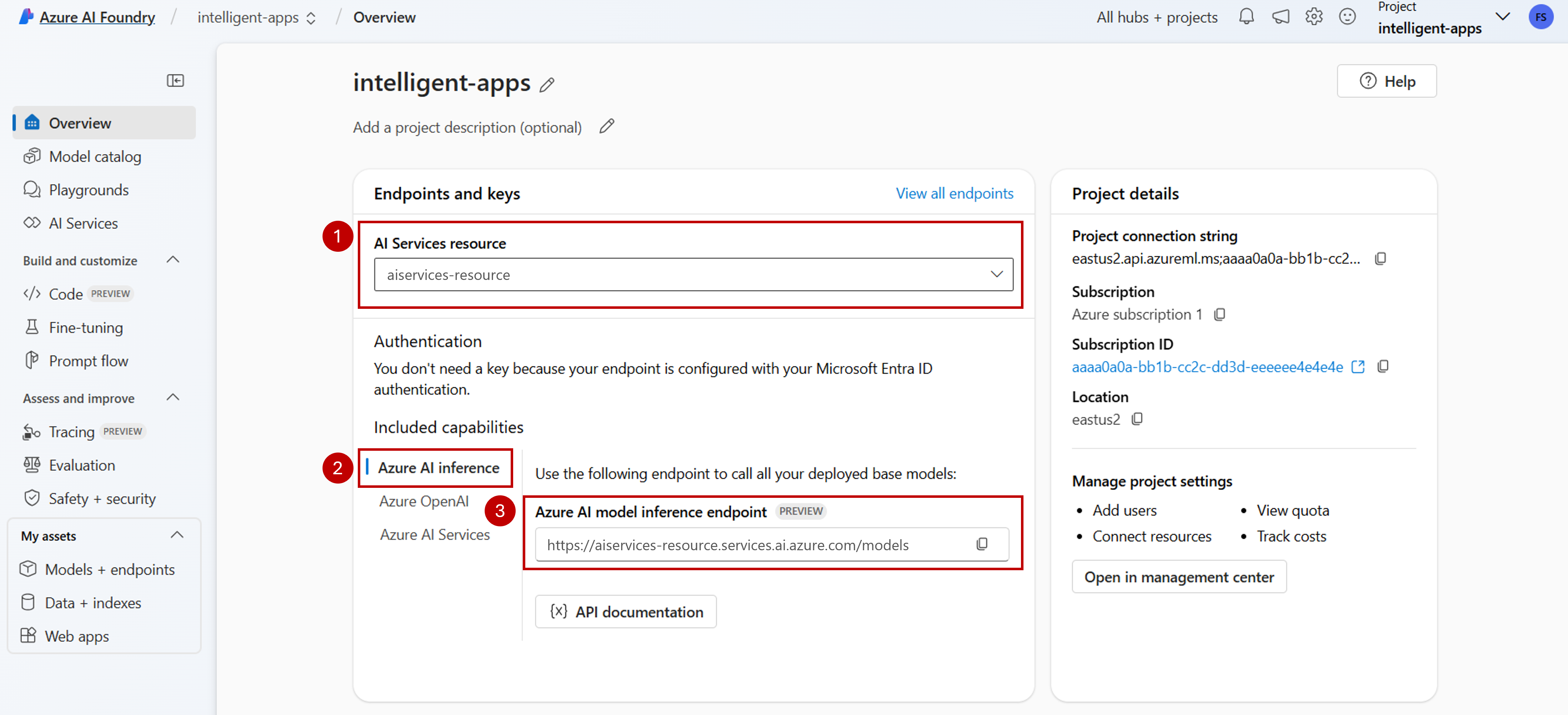

Du kan använda Azure AI-modellinferens i dina projekt i Azure AI Foundry för att skapa nå program och interagera/hantera de tillgängliga modellerna. Om du vill använda azure AI-modellinferenstjänsten i projektet måste du skapa en anslutning till Azure AI Services-resursen.

I följande artikel beskrivs hur du skapar en anslutning till Azure AI Services-resursen för att använda slutpunkten för slutsatsdragning.

Förutsättningar

För att slutföra den här artikeln behöver du:

En Azure-prenumeration Om du använder GitHub-modeller kan du uppgradera din upplevelse och skapa en Azure-prenumeration i processen. Läs Uppgradera från GitHub-modeller till Azure AI-modellinferens om så är fallet.

En Azure AI-tjänstresurs. Mer information finns i Skapa en Azure AI Services-resurs .

- Ett AI-projekt som är anslutet till din Azure AI Services-resurs. Du anropar genom att följa stegen i Konfigurera azure AI-modellinferenstjänsten i mitt projekt i Azure AI Foundry.

Lägg till en anslutning

Du kan skapa en anslutning till en Azure AI-tjänstresurs med hjälp av följande steg:

Gå till Azure AI Foundry Portal.

I det nedre vänstra hörnet på skärmen väljer du Hanteringscenter.

I avsnittet Anslutningar väljer du Ny anslutning.

Välj Azure AI-tjänster.

Leta efter en befintlig Azure AI Services-resurs i din prenumeration i webbläsaren.

Välj Lägg till anslutning.

Den nya anslutningen läggs till i hubben.

Gå tillbaka till projektets landningssida för att fortsätta och välj nu den nya anslutningen som skapats. Uppdatera sidan om den inte visas omedelbart.

Se modelldistributioner i den anslutna resursen

Du kan se de modelldistributioner som är tillgängliga i den anslutna resursen genom att följa dessa steg:

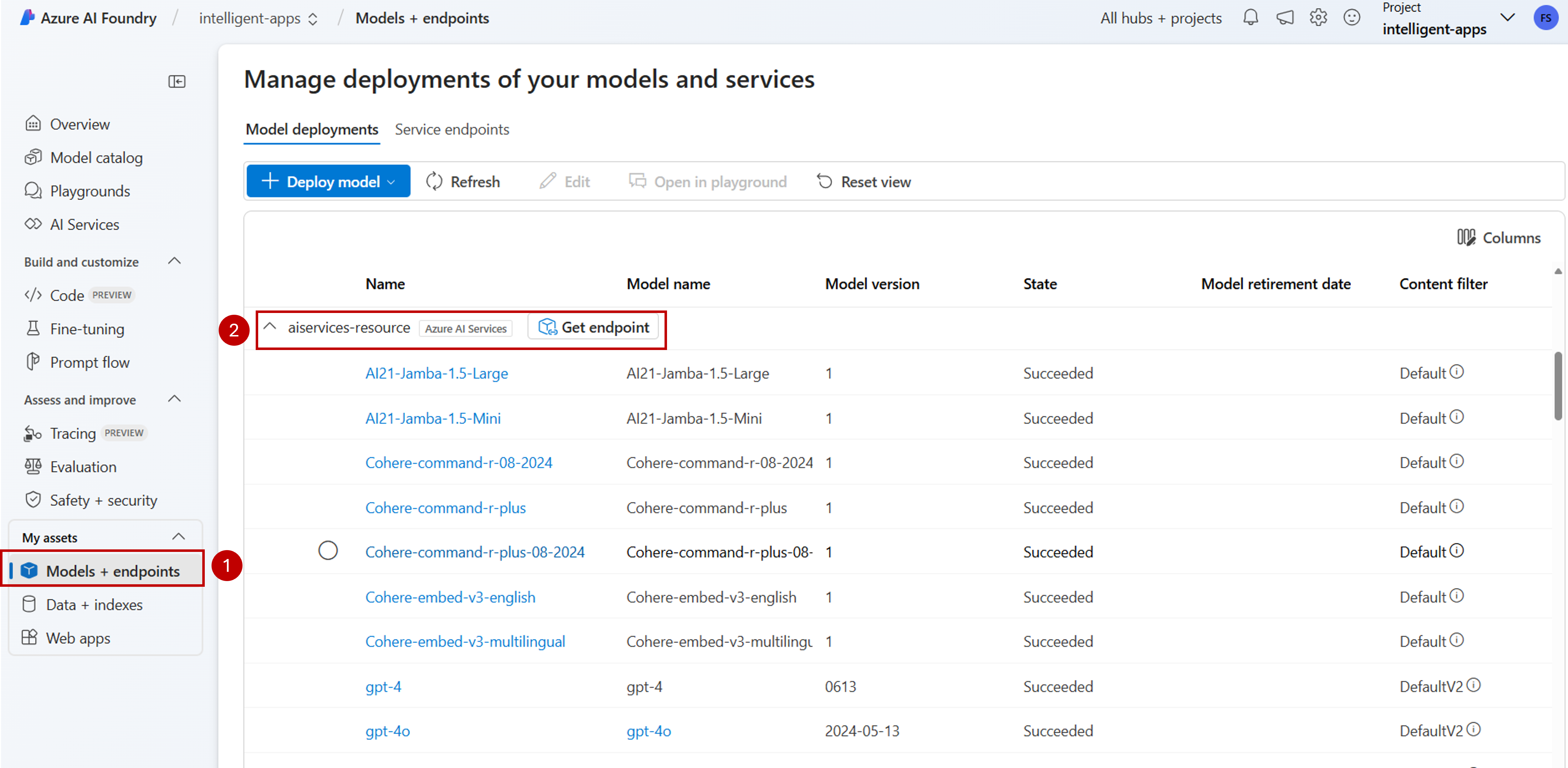

Gå till Azure AI Foundry Portal.

I det vänstra navigeringsfältet väljer du Modeller + slutpunkter.

Sidan visar de modelldistributioner som är tillgängliga för din, grupperade efter anslutningsnamn. Leta upp den anslutning som du just har skapat, som ska vara av typen Azure AI Services.

Välj vilken modelldistribution som helst som du vill inspektera.

Informationssidan visar information om den specifika distributionen. Om du vill testa modellen kan du använda alternativet Öppna på lekplatsen.

Azure AI Foundry Playground visas, där du kan interagera med den angivna modellen.

Viktigt!

Objekt markerade (förhandsversion) i den här artikeln är för närvarande i offentlig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

Du kan använda Azure AI-modellinferens i dina projekt i Azure AI Foundry för att skapa nå program och interagera/hantera de tillgängliga modellerna. Om du vill använda azure AI-modellinferenstjänsten i projektet måste du skapa en anslutning till Azure AI Services-resursen.

I följande artikel beskrivs hur du skapar en anslutning till Azure AI Services-resursen för att använda slutpunkten för slutsatsdragning.

Förutsättningar

För att slutföra den här artikeln behöver du:

En Azure-prenumeration Om du använder GitHub-modeller kan du uppgradera din upplevelse och skapa en Azure-prenumeration i processen. Läs Uppgradera från GitHub-modeller till Azure AI-modellinferens om så är fallet.

En Azure AI-tjänstresurs. Mer information finns i Skapa en Azure AI Services-resurs .

Installera Azure CLI och

mltillägget för Azure AI Foundry:az extension add -n mlIdentifiera följande information:

ditt prenumerations-ID för Azure

Ditt Azure AI Services-resursnamn.

Resursgruppen där Azure AI Services-resursen distribueras.

Lägg till en anslutning

Om du vill lägga till en modell måste du först identifiera den modell som du vill distribuera. Du kan fråga de tillgängliga modellerna på följande sätt:

Logga in på din Azure-prenumeration:

az loginKonfigurera CLI så att det pekar på projektet:

az account set --subscription <subscription> az configure --defaults workspace=<project-name> group=<resource-group> location=<location>Skapa en anslutningsdefinition:

connection.yml

name: <connection-name> type: aiservices endpoint: https://<ai-services-resourcename>.services.ai.azure.com api_key: <resource-api-key>Skapa anslutningen:

az ml connection create -f connection.ymlNu är anslutningen tillgänglig för förbrukning.

Viktigt!

Objekt markerade (förhandsversion) i den här artikeln är för närvarande i offentlig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

Du kan använda Azure AI-modellinferens i dina projekt i Azure AI Foundry för att skapa nå program och interagera/hantera de tillgängliga modellerna. Om du vill använda azure AI-modellinferenstjänsten i projektet måste du skapa en anslutning till Azure AI Services-resursen.

I följande artikel beskrivs hur du skapar en anslutning till Azure AI Services-resursen för att använda slutpunkten för slutsatsdragning.

Förutsättningar

För att slutföra den här artikeln behöver du:

En Azure-prenumeration Om du använder GitHub-modeller kan du uppgradera din upplevelse och skapa en Azure-prenumeration i processen. Läs Uppgradera från GitHub-modeller till Azure AI-modellinferens om så är fallet.

En Azure AI-tjänstresurs. Mer information finns i Skapa en Azure AI Services-resurs .

Ett Azure AI-projekt med en AI Hub.

Installera Azure CLI.

Identifiera följande information:

ditt prenumerations-ID för Azure

Ditt Azure AI Services-resursnamn.

Ditt Resurs-ID för Azure AI Services.

Namnet på den Azure AI Hub där projektet distribueras.

Resursgruppen där Azure AI Services-resursen distribueras.

Lägg till en anslutning

Använd mallen

ai-services-connection-template.bicepför att beskriva anslutningen:ai-services-connection-template.bicep

@description('Name of the hub where the connection will be created') param hubName string @description('Name of the connection') param name string @description('Category of the connection') param category string = 'AIServices' @allowed(['AAD', 'ApiKey', 'ManagedIdentity', 'None']) param authType string = 'AAD' @description('The endpoint URI of the connected service') param endpointUri string @description('The resource ID of the connected service') param resourceId string = '' @secure() param key string = '' resource connection 'Microsoft.MachineLearningServices/workspaces/connections@2024-04-01-preview' = { name: '${hubName}/${name}' properties: { category: category target: endpointUri authType: authType isSharedToAll: true credentials: authType == 'ApiKey' ? { key: key } : null metadata: { ApiType: 'Azure' ResourceId: resourceId } } }Kör distributionen:

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" ENDPOINT_URI="https://<azure-ai-model-inference-name>.services.ai.azure.com" RESOURCE_ID="<resource-id>" HUB_NAME="<hub-name>" az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-connection-template.bicep \ --parameters accountName=$ACCOUNT_NAME hubName=$HUB_NAME endpointUri=$ENDPOINT_URI resourceId=$RESOURCE_ID