Загрузка данных в Fabric с помощью действия копирования в средстве Azure Data Factory

Соединитель Microsoft Fabric Lakehouse в Фабрике данных Azure (ADF) и Azure Synapse Analytics позволяют выполнять операции чтения и записи в Microsoft Fabric Lakehouse (как для таблиц, так и для файлов). Этот соединитель позволяет использовать ваши существующие конвейеры ADF и Synapse, а также потоки данных "Mapping Data Flows" для взаимодействия с Fabric Lakehouses. Эта статья поможет настроить Microsoft Fabric для разрешения проверки подлинности учетной записи службы, а затем демонстрирует коннектор Lakehouse для чтения и записи в Fabric Lakehouse.

Дополнительные сведения о Microsoft Fabric Lakehouse см. в статье Что такое lakehouse?

Соединитель Azure Data Factory Lakehouse

Новый коннектор связанной службы Lakehouse и два новых набора данных теперь доступны для клиентов, которые хотят начать читать из Microsoft Fabric Lakehouse и записывать туда. Для полного руководства по соединителю Lakehouse обратитесь к Копирование и преобразование данных в Microsoft Fabric Lakehouse Files (предварительная версия).

Аутентификация

Связанная служба Фабрики данных Azure

Соединитель Microsoft Fabric Lakehouse требует для аутентификации регистрации служебного принципала (SPN)/приложения. Чтобы приступить к работе, необходимо создать новый SPN (имя субъекта-службы) или использовать существующий. Microsoft Fabric предоставляет SPN-доступ либо к определённым группам безопасности, либо ко всей организации. Если определенная группа безопасности является вариантом, используемым организацией, имя субъекта-службы, используемое в соединителе Lakehouse, должно принадлежать группе безопасности, добавляемой в список разрешений.

Заметка

Разрешения API Power BI (делегированные) не требуются

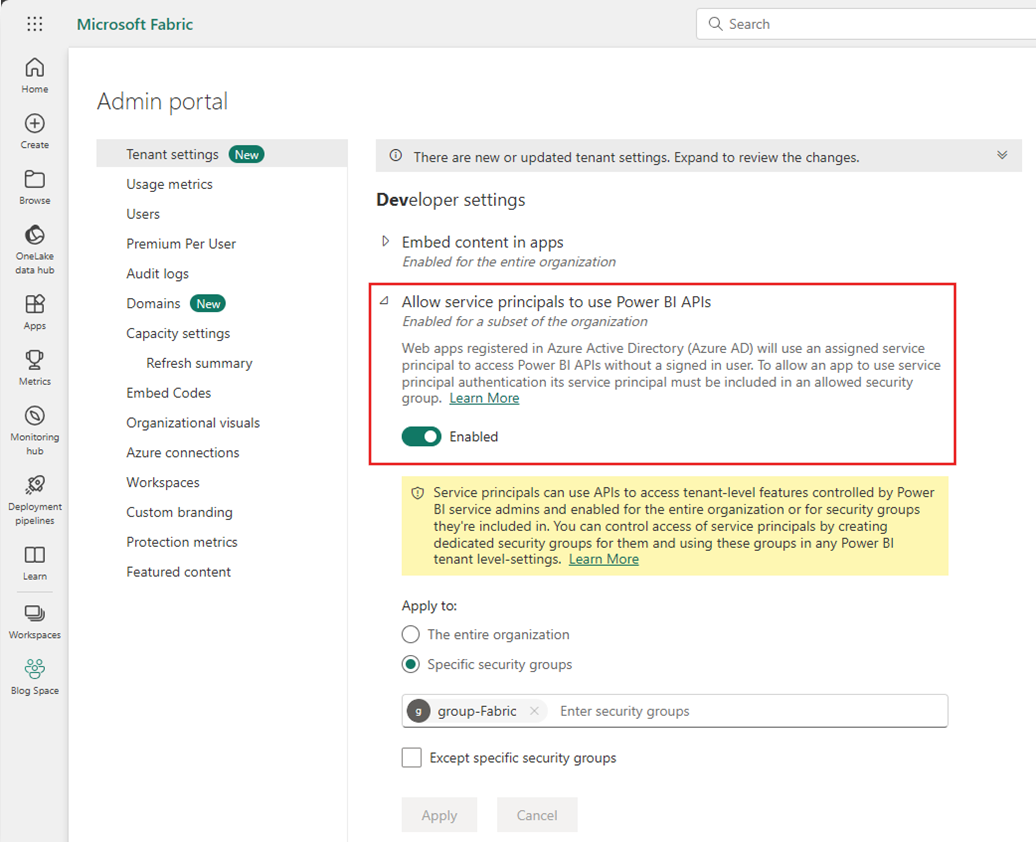

Доступ к API Power BI

На портале администрирования Power BI администратор клиента Power BI должен включить разрешить использование служебными принципалами API Power BI. Группа безопасности должна быть указана в разделе Разрешить субъектам-службам использовать api Power BI или включить для всей организации.

Полное руководство см. в статье Встраивание содержимого Power BI в интегрированное аналитическое приложение с использованием объект-субъекта и секрета приложения.

Заметка

При назначении группы безопасности рабочей области может возникнуть задержка для предоставления субъекту-службе доступа к рабочей области из-за кэширования разрешений в Azure. Если требуется немедленный доступ, можно использовать PowerShell для принудительного обновления разрешений пользователя. Для этого откройте PowerShell от имени администратора, а затем выполните следующие команды:

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Доступ к рабочей области

После добавления группы безопасности группа безопасности или служебный объект также должны быть добавлены в каждую рабочую область в качестве участника, вкладчика или администратора. Дополнительные сведения см. в статье Предоставление пользователям доступа к рабочим областям.

Демонстрация: настройка проверки подлинности

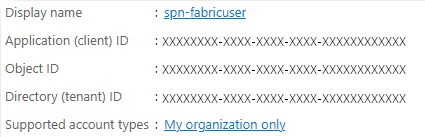

Принципал службы регистрации приложений

Создайте или используйте существующую учетную запись службы для регистрации приложений (SPN). Выполните действия в , чтобы зарегистрировать приложение с помощью Microsoft Entra ID, и создайте служебный принципал.

Заметка

Не нужно устанавливать URI перенаправления.

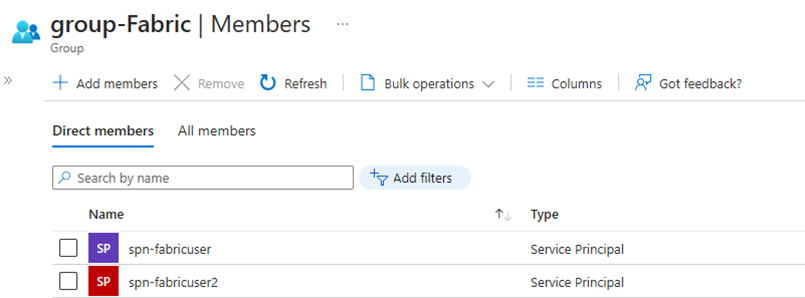

Группа безопасности

Создайте новую группу безопасности Microsoft Entra или используйте существующую, а затем добавьте в неё SPN. Следуя шагам в разделе "создание базовой группы и добавление участников", создайте группу безопасности Microsoft Entra.

Портал администрирования Power BI

На портале администрирования Power BIперейдите к параметрам разработчика и выберите Разрешить субъектам-службам использоватьAPI Power BI, а затем включите его. Затем добавьте группу безопасности из предыдущего шага. Для получения дополнительной информации о параметрах клиента в портале администрирования Power BI см. параметры клиента.

Заметка

Убедитесь, что параметр Пользователи могут получать доступ к данным, хранящимся в OneLake, с использованием внешних для Fabric приложений включен. Дополнительные сведения см. в статье Разрешить приложениям, работающим за пределами Fabric, получать доступ к данным через OneLake.

Рабочая область

Добавьте SPN или группу служб в рабочую область с доступом участника , участника или администратора .

Фабрика данных Azure: связанная служба

Из фабрики данных Azureсоздайте новую связанную службу Microsoft Fabric Lakehouse.

Заметка

Чтобы найти идентификаторы рабочей области и Lakehouse, перейдите к Fabric Lakehouse и определите его по URL-адресу. Например: https://.../groups/<Workspace ID>>/lakehouses/<Lakehouse ID>

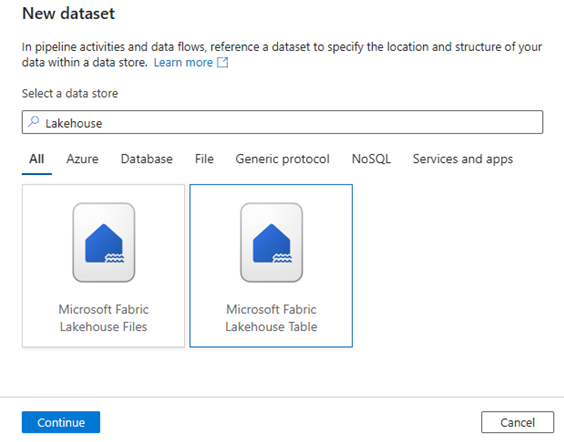

Фабрика данных Azure: набор данных

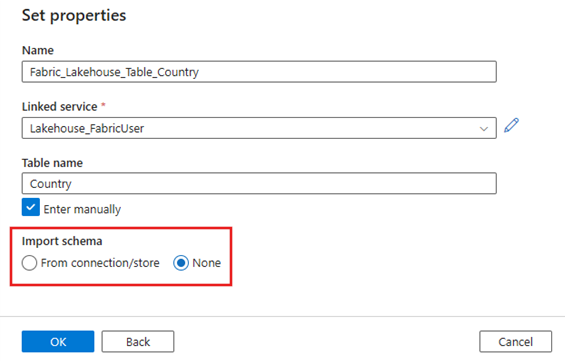

Создайте набор данных, ссылающийся на связанную службу Microsoft Fabric Lakehouse.

Заметка

Выберите None для опции импорта схемы , если таблица еще не существует и вы вручную задаете новое имя для этой таблицы.

Демо: Запись в таблицу Fabric Lakehouse через конвейер ADF

Источник

Создайте новый проект конвейера и добавьте операцию копирования в рабочую область конвейера. На вкладке Источник действия копирования выберите исходный набор данных, который вы хотите переместить в таблицу типа Lakehouse. В этом примере мы ссылаемся на файл .csv из учетной записи Azure Data Lake Storage (ADLS) 2-го поколения.

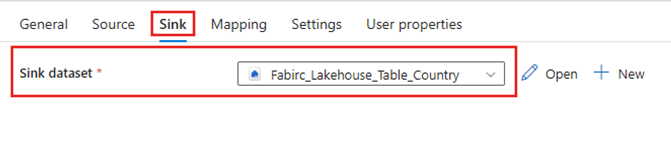

Тонуть

Перейдите на вкладку приемника действия копирования и выберите созданный ранее набор данных Fabric Lakehouse.

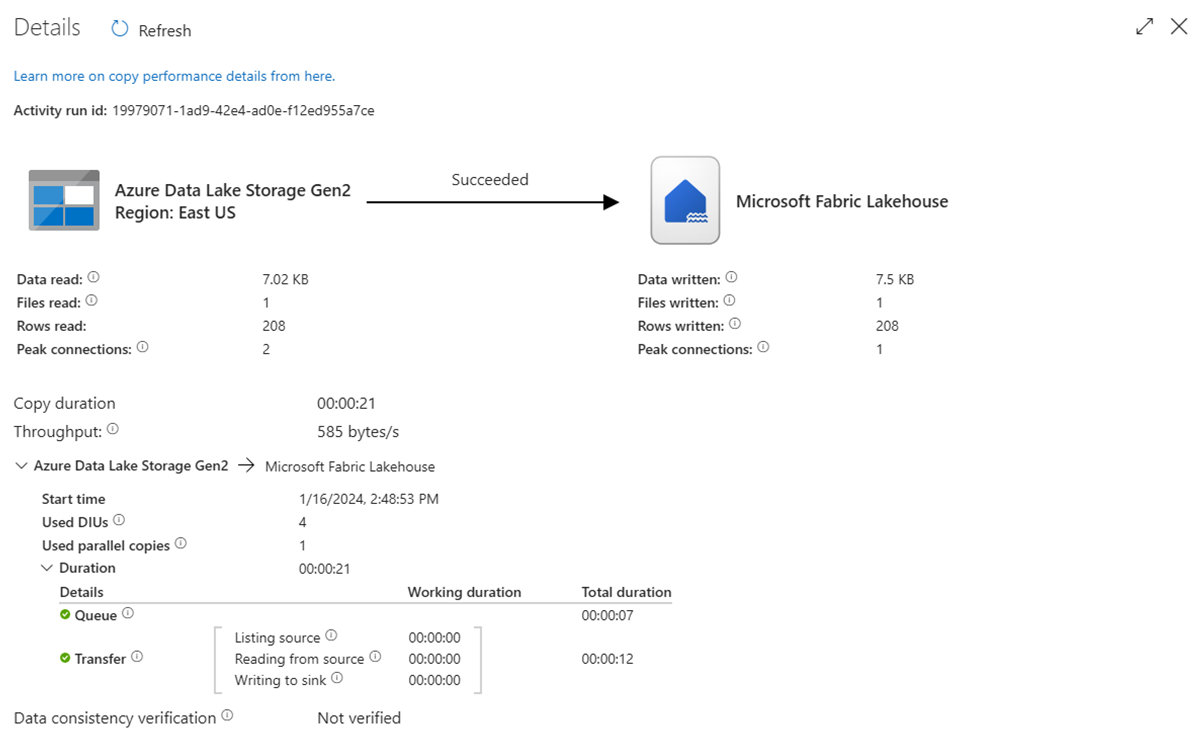

Запуск конвейера

Запустите конвейер, чтобы переместить данные .csv в таблицу Fabric Lakehouse.

Пример: чтение из таблицы Fabric Lakehouse с помощью конвейера Azure Data Factory

В приведенном выше разделе показано, как использовать ADF для записи в таблицу Fabric Lakehouse. Теперь давайте прочитаем таблицу Fabric Lakehouse и запишем в файл Parquet в хранилище данных Azure Data Lake Storage (ADLS) второго поколения с аналогичным конвейером обработки данных.

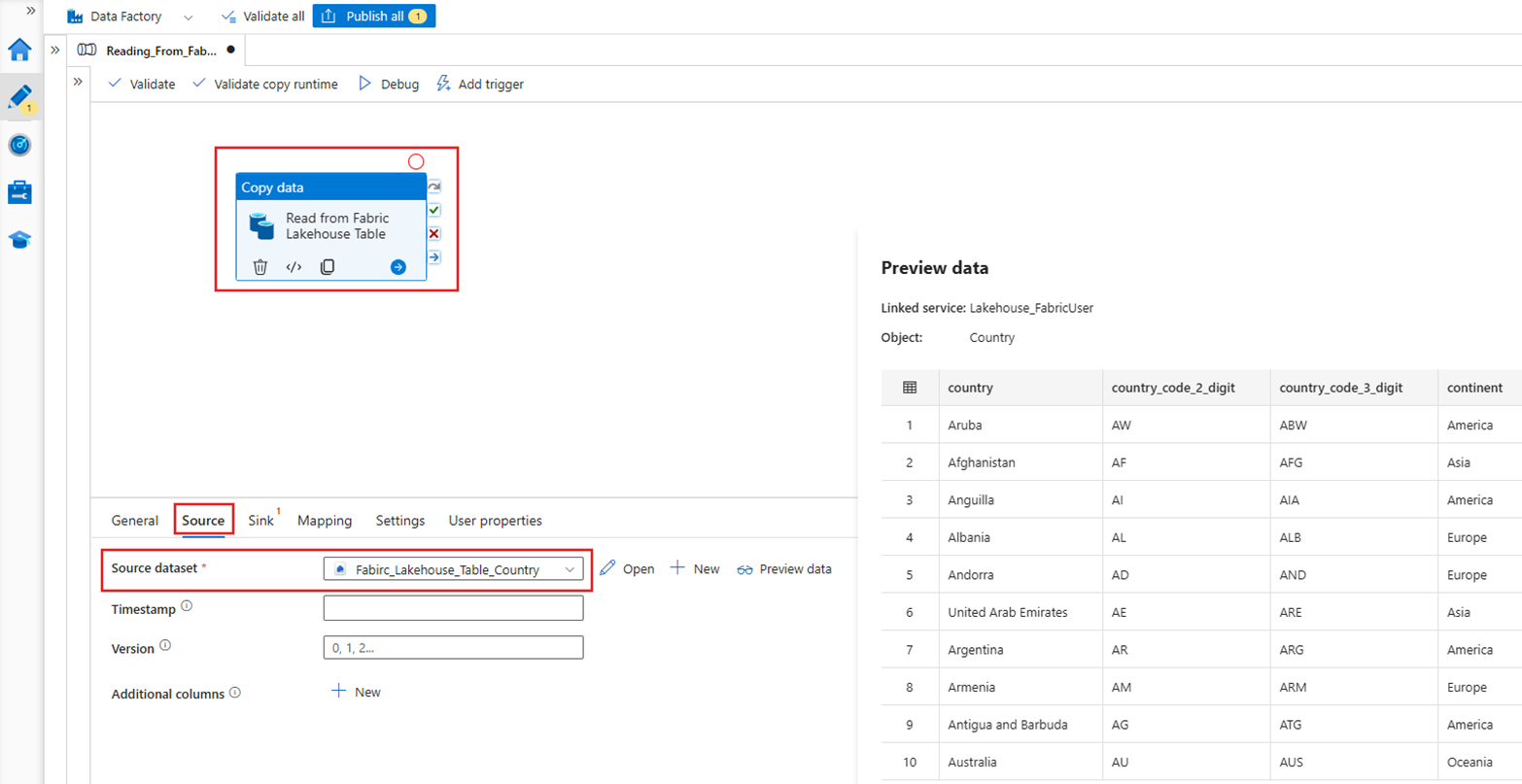

Источник

Создайте новый конвейер данных и добавьте операцию копирования на холст конвейера. На вкладке Источник операции копирования выберите созданный ранее набор данных Fabric Lakehouse.

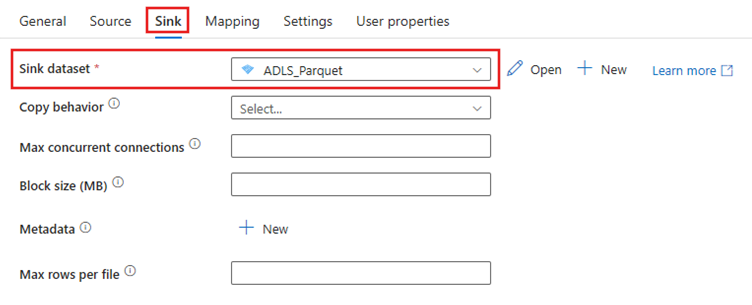

Тонуть

Перейдите на вкладку приемника действия копирования и выберите целевой набор данных. В этом примере назначение — Azure Data Lake Storage (2-го поколения) в качестве файла Parquet.

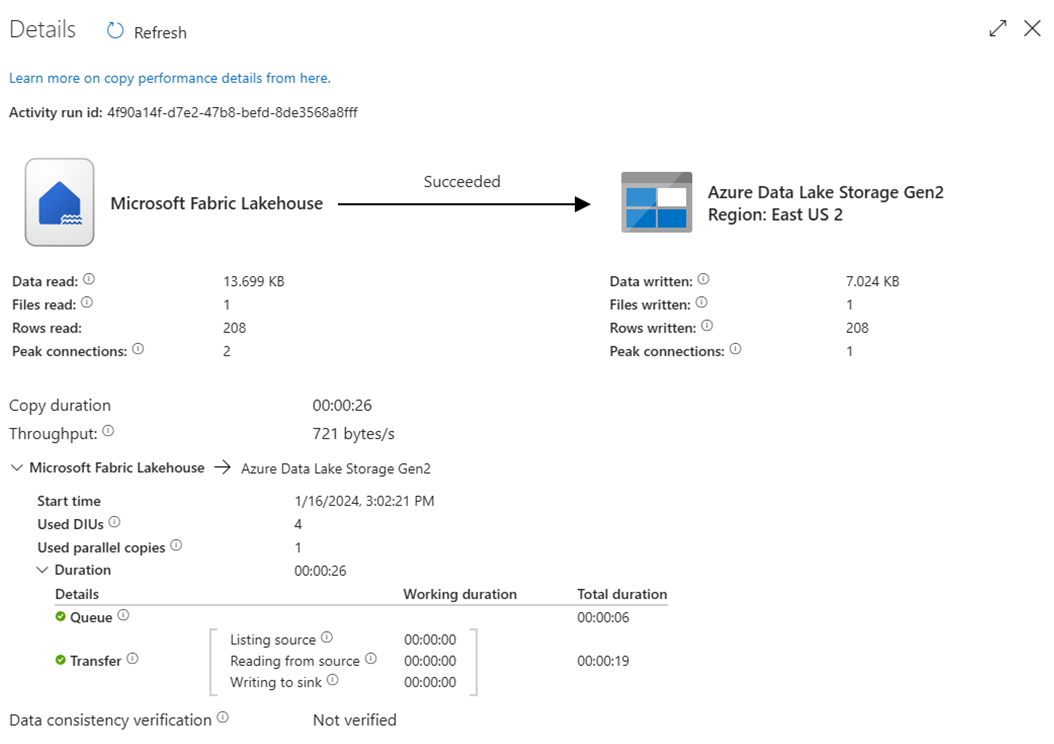

Запуск конвейера

Активируйте конвейер, чтобы переместить данные из таблицы Fabric Lakehouse в файл в формате Parquet в ADLS Gen2.

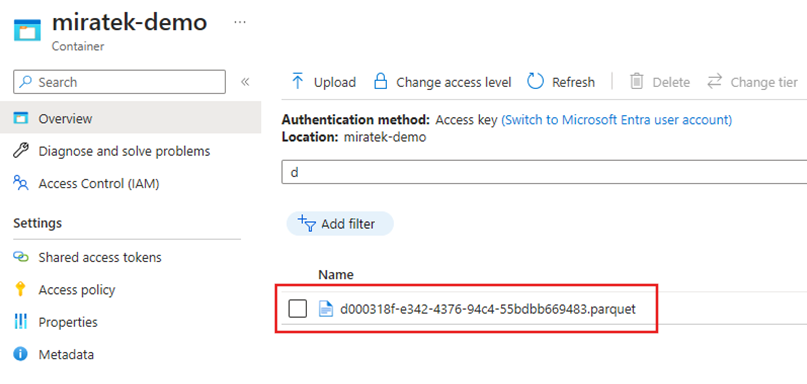

Проверка файла Parquet в Azure Data Lake Storage второго поколения

Данные из таблицы Fabric Lakehouse теперь доступны в ADLS Gen2 как файл Parquet.

Сводка

В этом разделе мы изучили требования соединителя Lakehouse с помощью проверки подлинности субъекта-службы в Microsoft Fabric Lakehouse, а затем изучили пример чтения и записи в Lakehouse из конвейера Фабрики данных Azure. Этот соединитель и возможности также доступны в потоках данных сопоставления в Azure Data Factory, Azure Synapse Analytics и Azure Synapse Analytics Mapping Data Flows.