Параметры получения данных в Fabric Lakehouse

Интерфейс получения данных охватывает все пользовательские сценарии для переноса данных в lakehouse, например:

- Подключение к существующему SQL Server и копирование данных в таблицу Delta в lakehouse.

- Отправка файлов с компьютера.

- Копирование и объединение нескольких таблиц из других озерных домов в новую таблицу Delta.

- Подключение к источнику потоковой передачи для посадки данных в лейкхаусе.

- Ссылка на данные без копирования из других внутренних озерных домов или внешних источников.

Различные способы загрузки данных в lakehouse

В Microsoft Fabric есть несколько способов получить данные в lakehouse:

- Отправка файлов с локального компьютера

- Запуск средства копирования в конвейерах

- Настройка потока данных

- Библиотеки Apache Spark в коде записной книжки

- Потоковая передача событий в режиме реального времени с помощью Eventstream

- Получение данных из Eventhouse

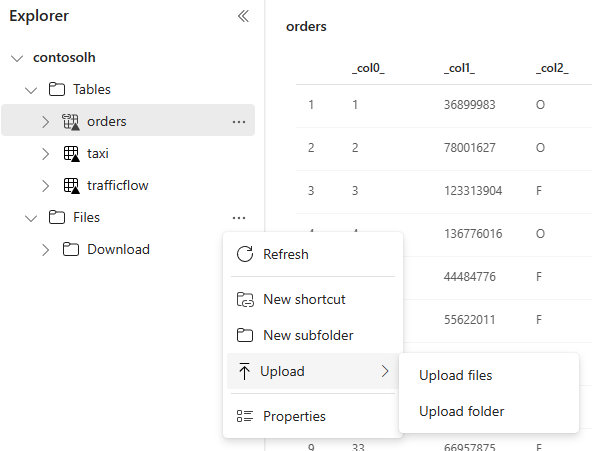

Отправка локального файла

Вы также можете передать данные, хранящиеся на локальном компьютере. Это можно сделать непосредственно в обозревателе Lakehouse.

Копирование средства в конвейерах

Средство копирования — это высокомасштабируемое решение Интеграция данных, которое позволяет подключаться к разным источникам данных и загружать данные в исходном формате или преобразовывать их в таблицу Delta. Средство копирования — это часть действий конвейеров, которые можно изменить несколькими способами, например планирование или активация на основе события. Дополнительные сведения см. в разделе "Копирование данных с помощью действия копирования".

Потоки данных

Для пользователей, знакомых с потоками данных Power BI, то же средство доступно для загрузки данных в lakehouse. Вы можете быстро получить доступ к нему из параметра "Получить данные" обозревателя Lakehouse и загрузить данные из более чем 200 соединителей. Дополнительные сведения см . в кратком руководстве. Создание первого потока данных для получения и преобразования данных.

Код записной книжки

Вы можете использовать доступные библиотеки Spark для подключения к источнику данных напрямую, загрузить данные в кадр данных, а затем сохранить его в lakehouse. Этот метод является самым открытым способом загрузки данных в lakehouse, который пользовательский код полностью управляет.

Примечание.

Внешние таблицы Delta, созданные с помощью кода Spark, не будут отображаться в конечной точке аналитики SQL. Используйте сочетания клавиш в пространстве таблиц, чтобы внешние таблицы Delta отображались для конечной точки аналитики SQL.

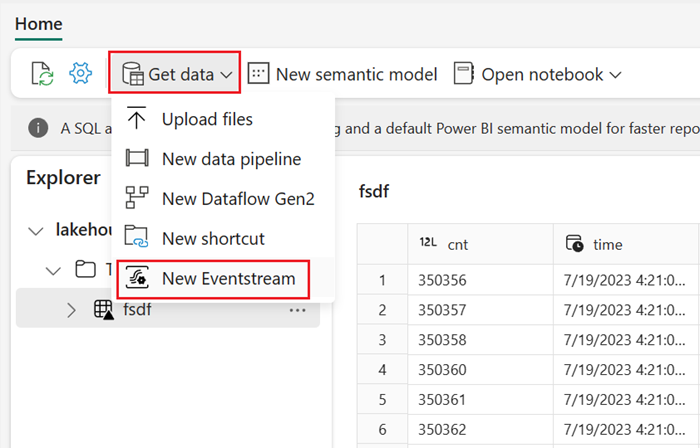

Потоковая передача событий в режиме реального времени с помощью Eventstream

С помощью Eventstream можно получать, обрабатывать и маршрутизировать большие объемы событий в режиме реального времени из различных источников.

Чтобы узнать, как добавить Lakehouse в качестве места назначения для Eventstream, см. статью "Получение данных из Eventstream" в lakehouse.

Для оптимальной производительности потоковой передачи можно передавать данные из Eventstream в хранилище событий, а затем включить доступность OneLake.

Получение данных из Eventhouse

Если включить доступность OneLake для данных в Eventhouse, в OneLake создается разностная таблица. К этой таблице Delta можно получить доступ к озеру с помощью ярлыка. Дополнительные сведения см. в разделе "Сочетания клавиш OneLake". Дополнительные сведения см. в статье о доступности Eventhouse OneLake.

Рекомендации при выборе подхода к загрузке данных

| Вариант использования | Рекомендация |

|---|---|

| Отправка небольших файлов с локального компьютера | Использование локальной отправки файлов |

| Небольшие данные или конкретный соединитель | Использование потоков данных |

| Большой источник данных | Использование средства копирования в конвейерах |

| Сложные преобразования данных | Использование кода записной книжки |

| Потоковая передача данных | Использование eventstream для потоковой передачи данных в Eventhouse; включение доступности OneLake и создание ярлыка из Lakehouse |

| Данные временных рядов | Получение данных из Eventhouse |

Связанный контент

- Изучение данных в lakehouse с помощью записной книжки

- Краткое руководство. Создание первого конвейера для копирования данных

- Копирование данных с помощью действия копирования

- Перемещение данных из базы данных SQL Azure в Lakehouse с помощью помощника по копированию

- Добавление назначения Lakehouse в поток событий

- Доступность Eventhouse OneLake