Отправка пакетного запуска для оценки потока

Пакетный запуск выполняет поток запроса с большим набором данных и создает выходные данные для каждой строки данных. Чтобы оценить, насколько хорошо выполняется поток запроса с большим набором данных, можно отправить пакетный запуск и использовать методы оценки для создания показателей производительности и метрик.

После завершения пакетного потока методы оценки автоматически выполняются для вычисления показателей и метрик. Вы можете использовать метрики оценки для оценки выходных данных потока в отношении ваших критериев производительности и целей.

В этой статье описывается, как отправить пакетное выполнение и использовать метод оценки для измерения качества выходных данных потока. Вы узнаете, как просмотреть результат оценки и метрики, а также как начать новый раунд оценки с другим методом или подмножеством вариантов.

Необходимые компоненты

Чтобы запустить пакетный поток с помощью метода оценки, вам потребуется следующее:

Рабочий поток запроса Машинное обучение Azure, для которого требуется проверить производительность.

Тестовый набор данных, используемый для пакетного выполнения.

Тестовый набор данных должен находиться в формате CSV, TSV или JSONL и должен содержать заголовки, соответствующие входным именам потока. Однако можно сопоставить различные столбцы набора данных с входными столбцами во время процесса установки оценки.

Создание и отправка пакета оценки

Чтобы отправить пакетный запуск, выберите набор данных для тестирования потока. Вы также можете выбрать метод оценки, чтобы вычислить метрики для выходных данных потока. Если вы не хотите использовать метод оценки, можно пропустить шаги оценки и запустить пакетный запуск без вычисления метрик. Вы также можете выполнить раунд оценки позже.

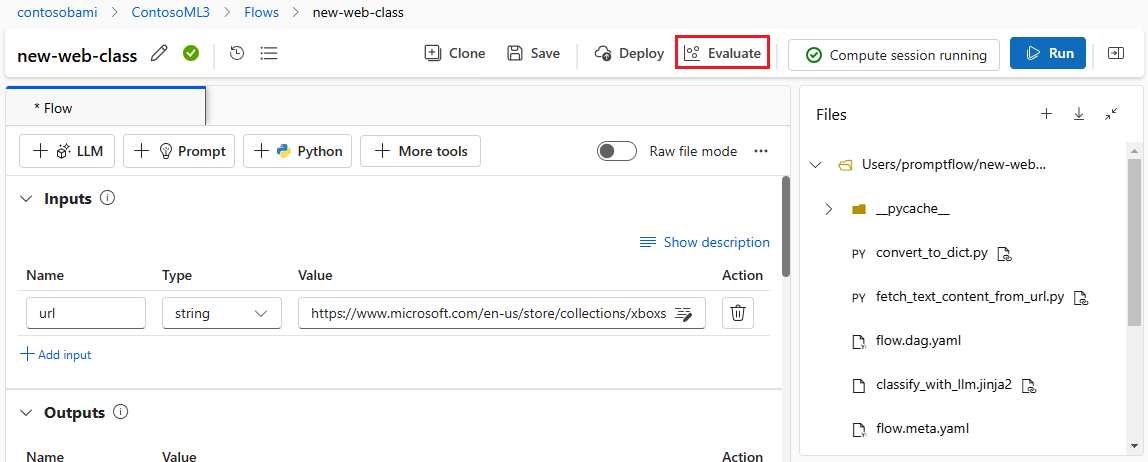

Чтобы запустить пакетный запуск с оценкой или без нее, выберите " Оценить " в верхней части страницы потока запроса.

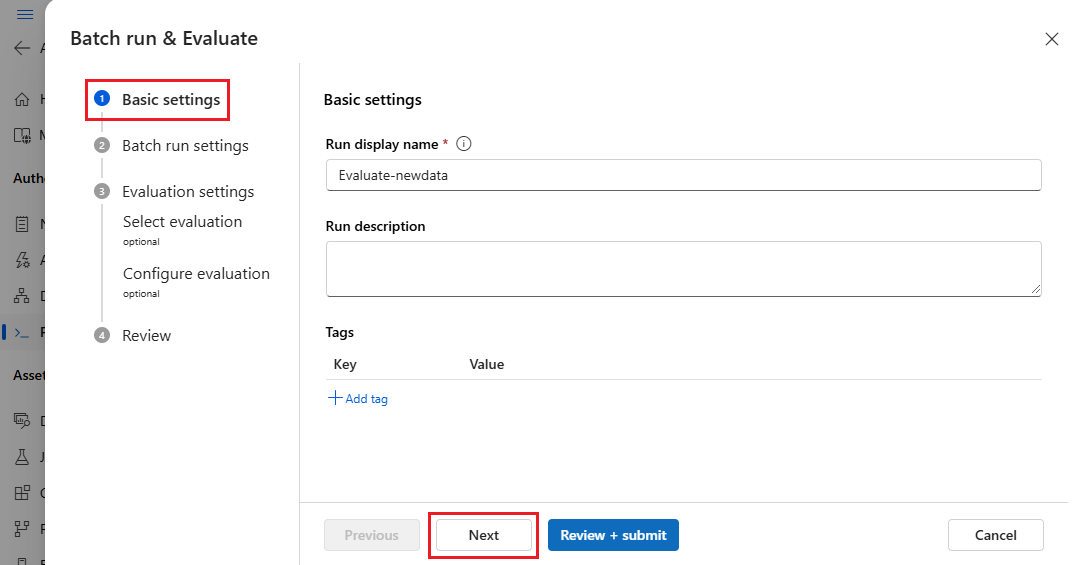

На странице "Базовые параметры" мастера выполнения пакетной службы и оценки настройте отображаемое имя запуска при необходимости и при необходимости укажите описание и теги запуска. Выберите Далее.

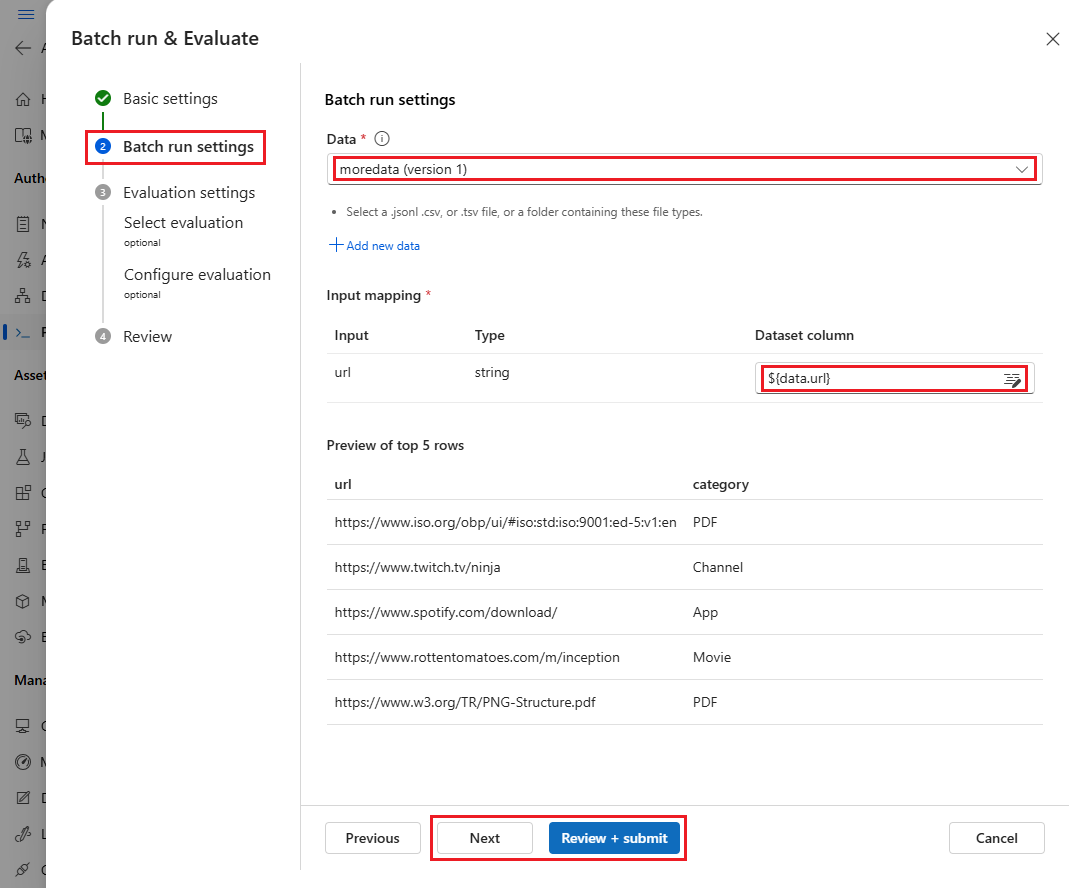

На странице параметров выполнения пакетной службы выберите набор данных для использования и настройки сопоставления входных данных.

Поток запросов поддерживает сопоставление входных данных потока с определенным столбцом данных в наборе данных. Столбец набора данных можно назначить определенному входу с помощью

${data.<column>}. Если вы хотите назначить константное значение входным данным, можно ввести это значение напрямую.Чтобы пропустить шаги оценки и запустить пакетный запуск без использования метода оценки, нажмите кнопку "Проверить и отправить " на этом этапе. Затем пакетный запуск создает отдельные выходные данные для каждого элемента в наборе данных. Вы можете вручную проверить выходные данные или экспортировать их для дальнейшего анализа.

В противном случае, чтобы проверить производительность этого запуска, нажмите кнопку "Далее". Вы также можете добавить новый раунд оценки в завершенный пакетный запуск.

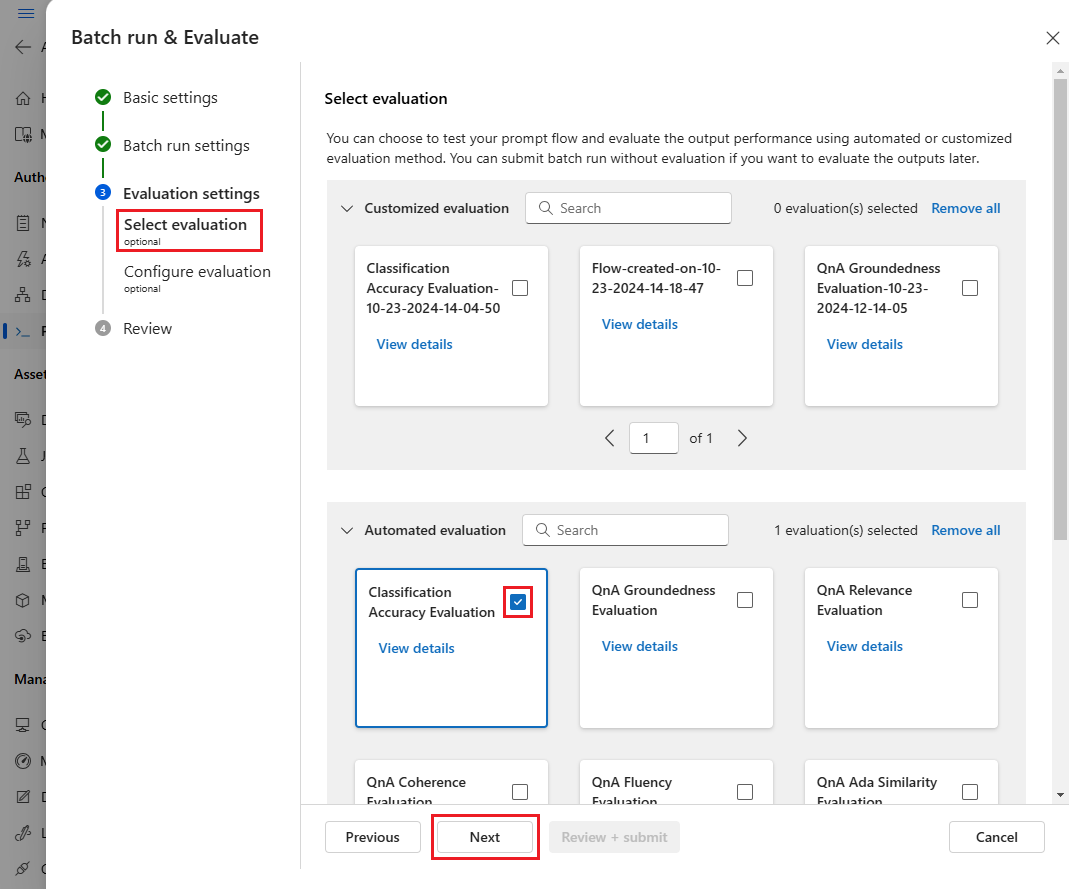

На странице "Выбор оценки" выберите одну или несколько настраиваемых или встроенных вычислений для выполнения. Нажмите кнопку "Просмотреть сведения", чтобы просмотреть дополнительные сведения о методе оценки, например метрики, которые он создает, и подключения и необходимые входные данные.

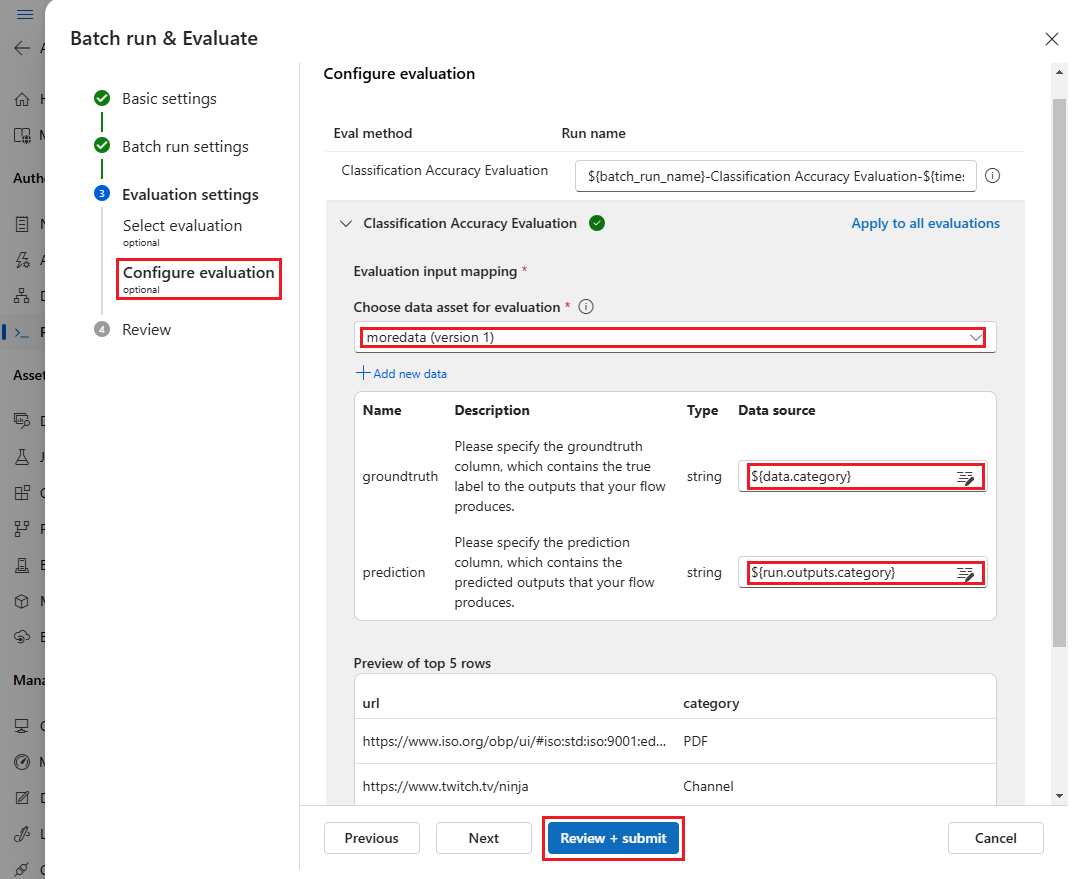

Затем на экране настройки оценки укажите источники необходимых входных данных для оценки. Например, столбец правды земли может поступать из набора данных. По умолчанию оценка использует тот же набор данных, что и общий пакетный запуск. Однако если соответствующие метки или целевые значения правды находятся в другом наборе данных, его можно использовать.

Примечание.

Если метод оценки не требует данных из набора данных, выбор набора данных является необязательной конфигурацией, которая не влияет на результаты оценки. Вам не нужно выбирать набор данных или ссылаться на столбцы набора данных в разделе сопоставления входных данных.

В разделе сопоставления входных данных оценки укажите источники необходимых входных данных для оценки.

- Если данные из тестового набора данных заданы в качестве

${data.[ColumnName]}источника. - Если данные выводятся из выходных данных выполнения, задайте источник в качестве

${run.outputs.[OutputName]}источника.

- Если данные из тестового набора данных заданы в качестве

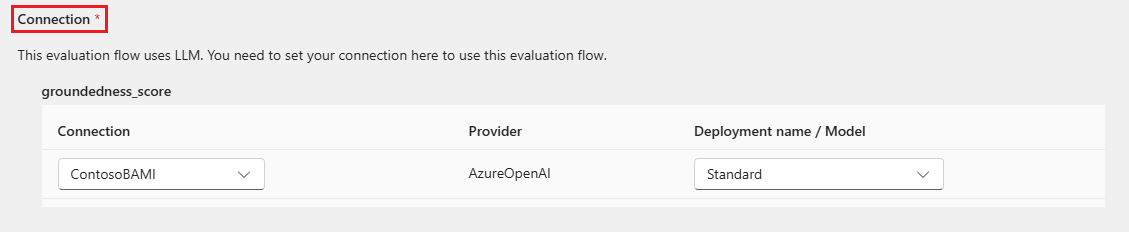

Для некоторых методов оценки требуются большие языковые модели (LLM), такие как GPT-4 или GPT-3, или требуются другие подключения для использования учетных данных или ключей. Для этих методов необходимо ввести данные подключения в разделе "Подключение " в нижней части этого экрана, чтобы использовать поток оценки. Дополнительные сведения см. в разделе "Настройка подключения".

Выберите "Рецензирование и отправка ", чтобы просмотреть параметры, а затем нажмите кнопку "Отправить ", чтобы запустить пакетный запуск с помощью оценки.

Примечание.

- Некоторые процессы оценки используют множество маркеров, поэтому рекомендуется использовать модель, которая может поддерживать >токены =16k.

- Пакетные запуски имеют максимальную длительность 10 часов. Если пакетный запуск превышает это ограничение, он завершает работу и отображается как сбой. Отслеживайте емкость LLM, чтобы избежать регулирования. При необходимости рассмотрите возможность уменьшения размера данных. Если у вас по-прежнему возникли проблемы, отправьте форму обратной связи или запрос на поддержку.

Просмотр результатов оценки и метрик

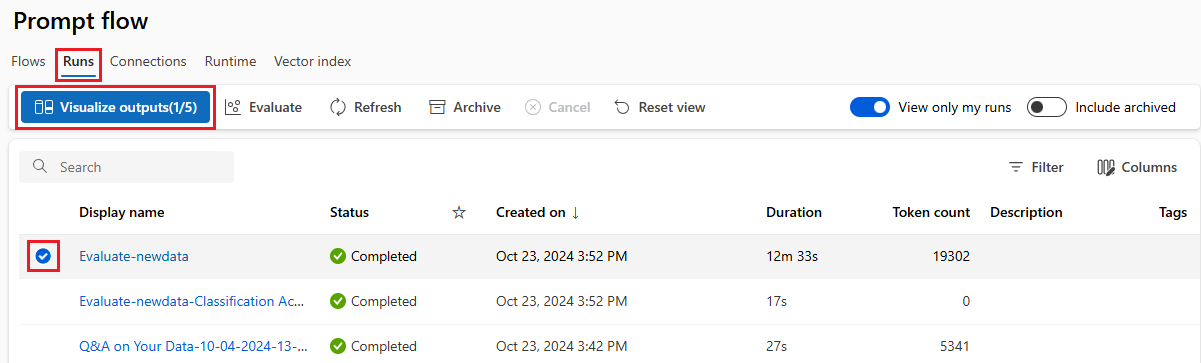

Список отправленных пакетных запусков можно найти на вкладке "Запуски" на странице потока запроса Студия машинного обучения Azure.

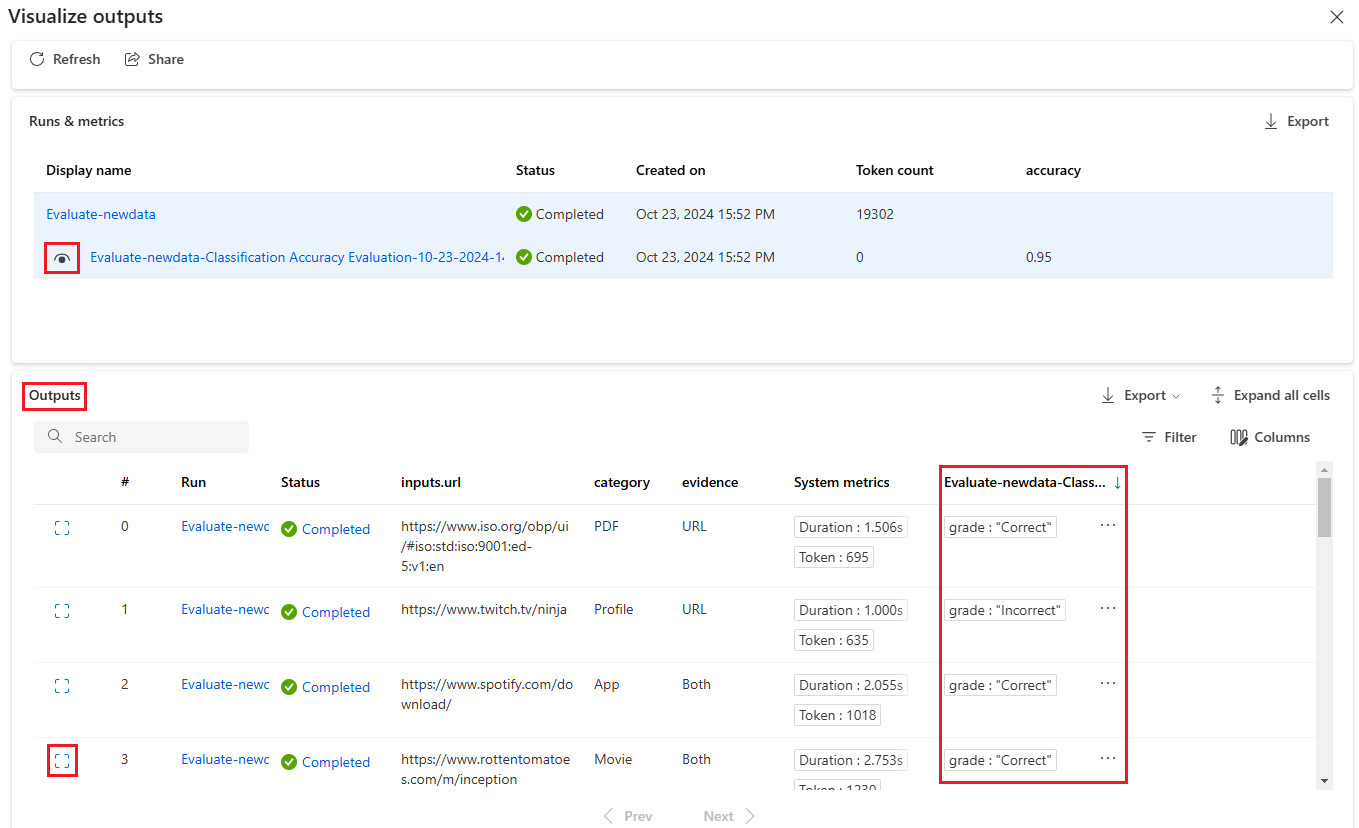

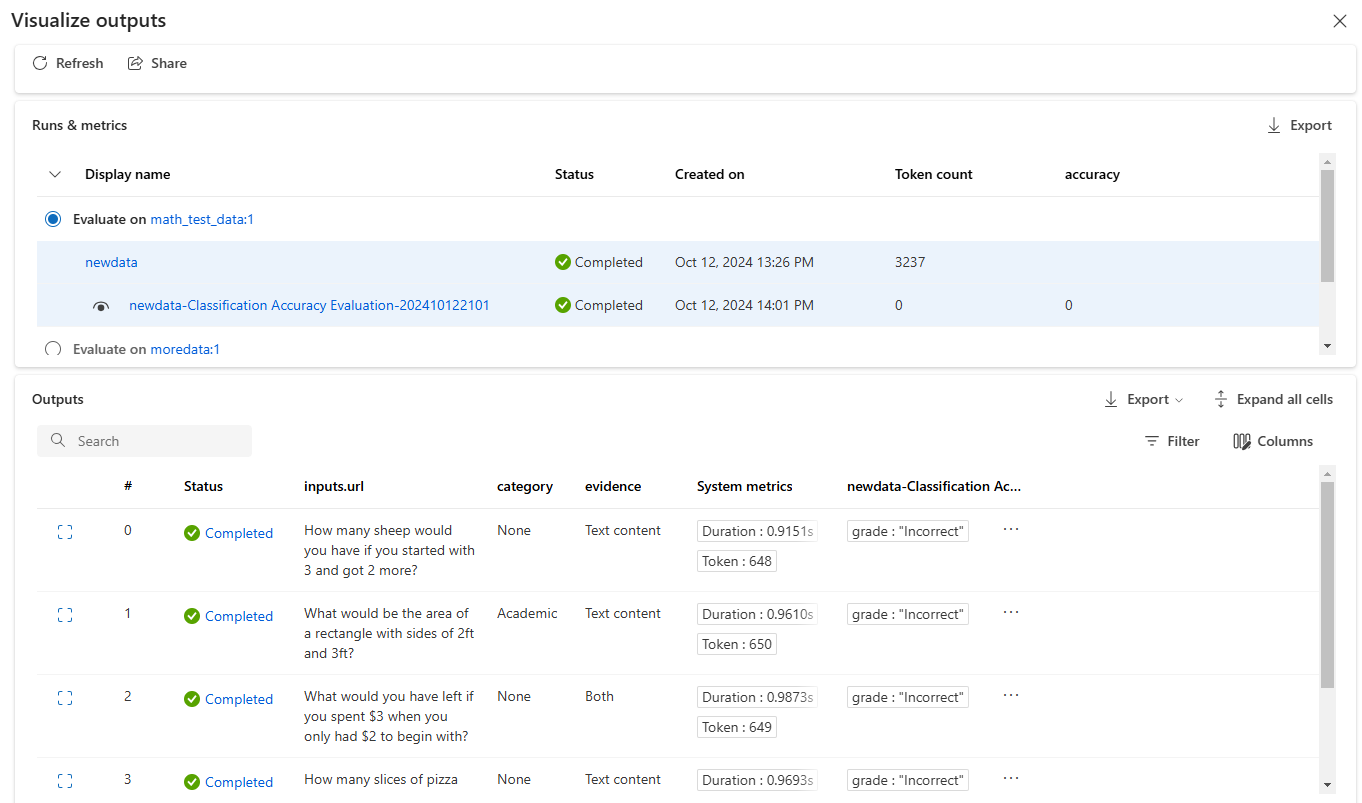

Чтобы проверить результаты пакетного выполнения, выберите выполнение и выберите "Визуализировать выходные данные".

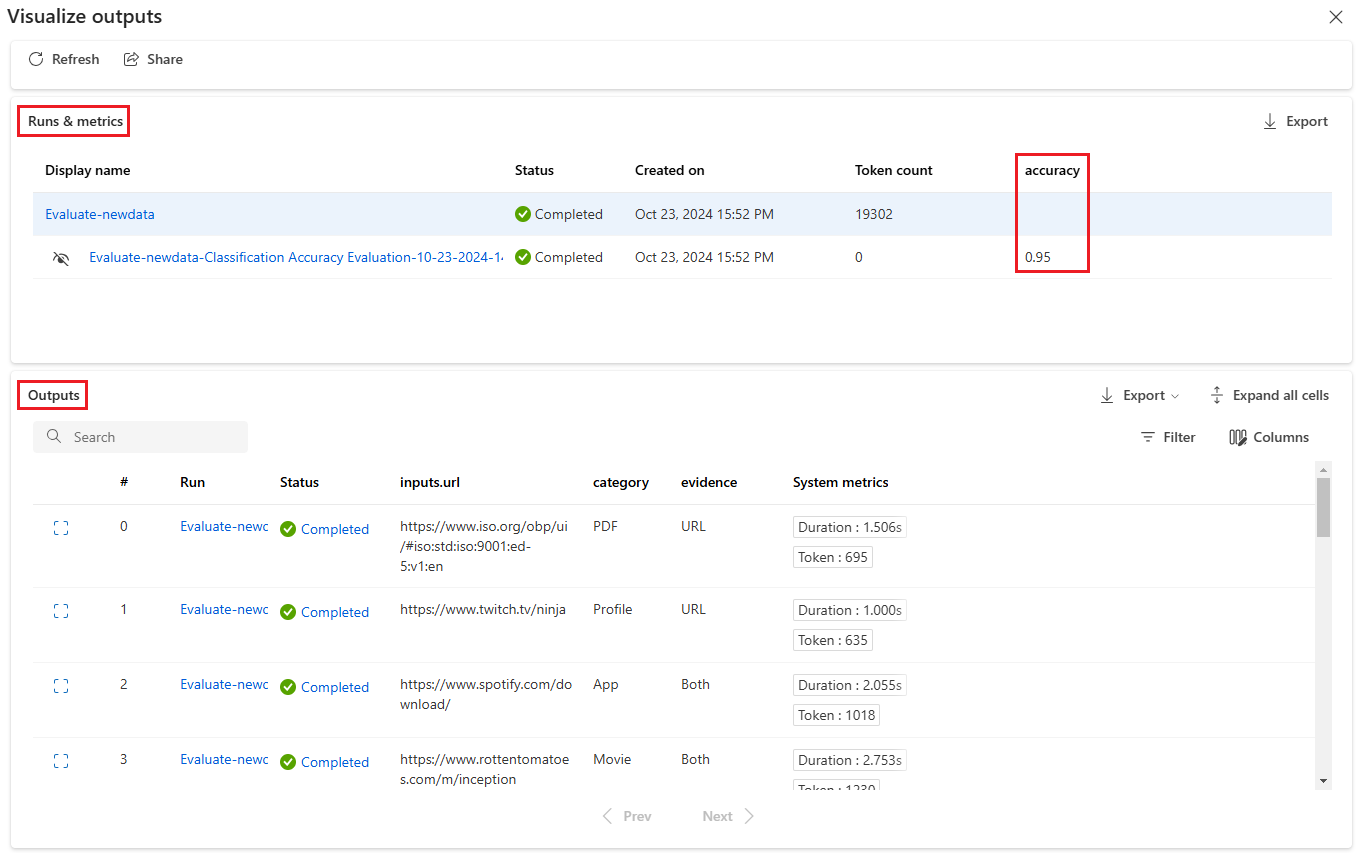

На экране вывода визуализации в разделе "Запуски и метрики" отображаются общие результаты для выполнения пакетной службы и выполнения оценки. В разделе "Выходные данные" показана строка входных данных выполнения в таблице результатов, которая также содержит идентификатор строки, состояние и системные метрики.

Если вы включите значок представления рядом с выполнением оценки в разделе "Запуски и метрики", в таблице "Выходные данные" также отображается оценка или оценка для каждой строки.

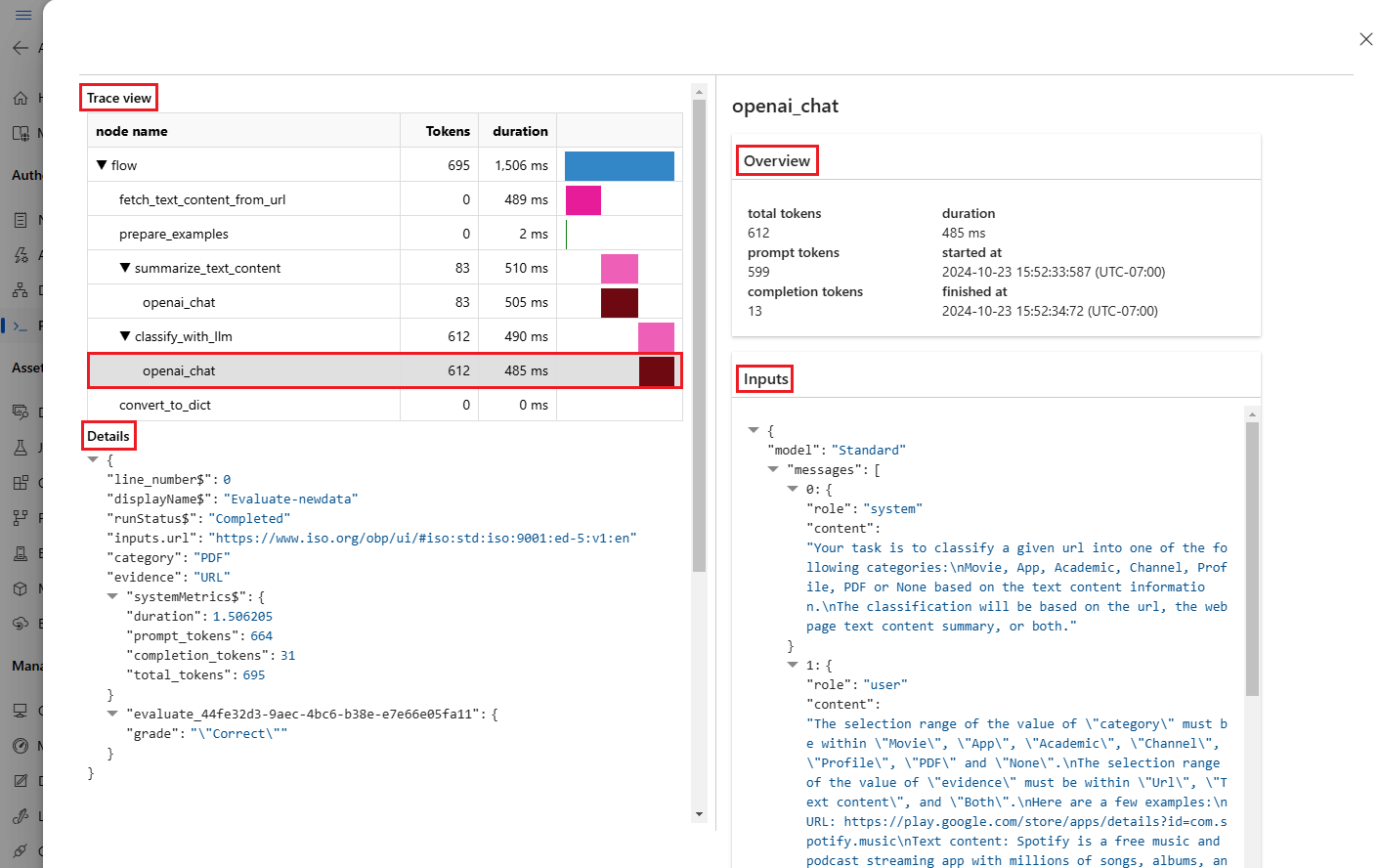

Щелкните значок сведений о представлении рядом с каждой строкой в таблице выходных данных, чтобы наблюдать и отлаживать представление трассировки и сведения для этого тестового случая. В представлении трассировки отображаются такие сведения, как количество маркеров и длительность этого случая. Разверните и выберите любой шаг, чтобы просмотреть обзор и входные данные для этого шага.

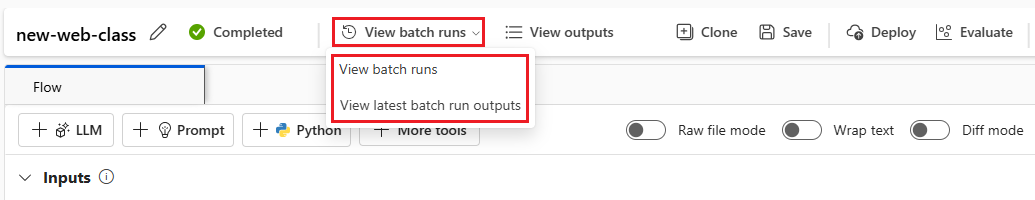

Вы также можете просмотреть результаты выполнения оценки из протестированного потока запроса. В разделе "Просмотр пакетных запусков" выберите "Просмотр пакетных запусков", чтобы просмотреть список пакетных запусков для потока или просмотреть последние выходные данные пакетного запуска, чтобы просмотреть выходные данные для последнего запуска.

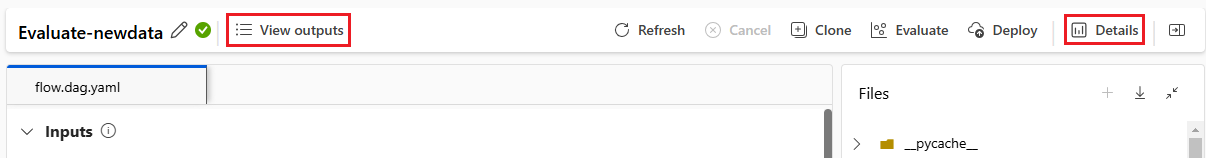

В списке пакетного запуска выберите имя пакетного запуска, чтобы открыть страницу потока для этого запуска.

На странице потока для выполнения оценки выберите "Просмотреть выходные данные " или "Сведения ", чтобы просмотреть сведения о потоке. Вы также можете клонировать поток для создания нового потока или развернуть его в качестве сетевой конечной точки.

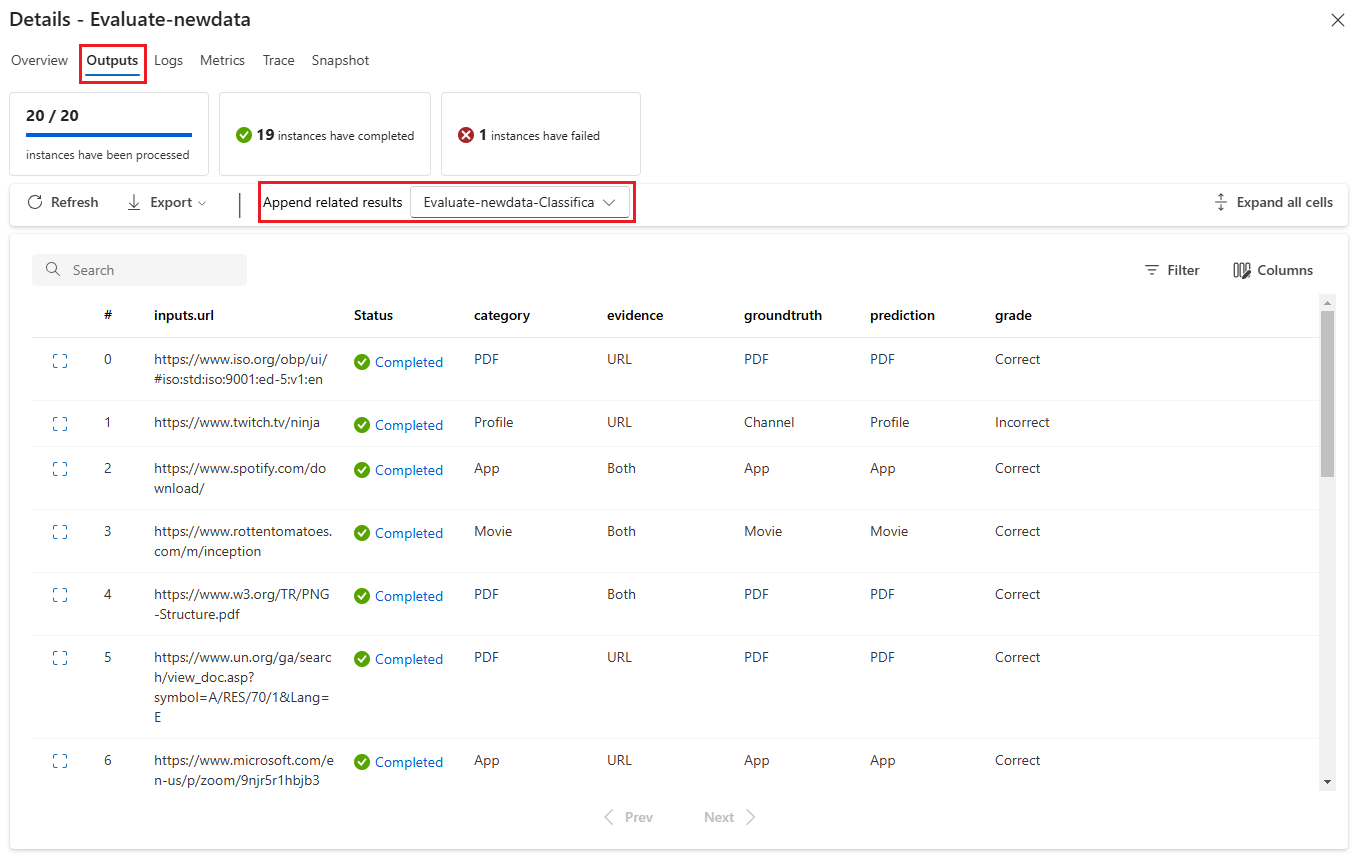

На экране сведений:

На вкладке "Обзор" отображаются подробные сведения о выполнении, включая свойства выполнения, входной набор данных, выходной набор данных, теги и описание.

На вкладке "Выходные данные" отображается сводка результатов в верхней части страницы , за которой следует таблица результатов пакетного выполнения. Если выбрать выполнение оценки рядом с соответствующими результатами добавления, в таблице также отображаются результаты выполнения оценки.

На вкладке "Журналы" показаны журналы выполнения, которые могут быть полезны для подробной отладки ошибок выполнения. Файлы журнала можно скачать.

Вкладка "Метрики" содержит ссылку на метрики для выполнения.

На вкладке "Трассировка" отображаются подробные сведения, такие как количество маркеров и длительность для каждого тестового случая. Разверните и выберите любой шаг, чтобы просмотреть обзор и входные данные для этого шага.

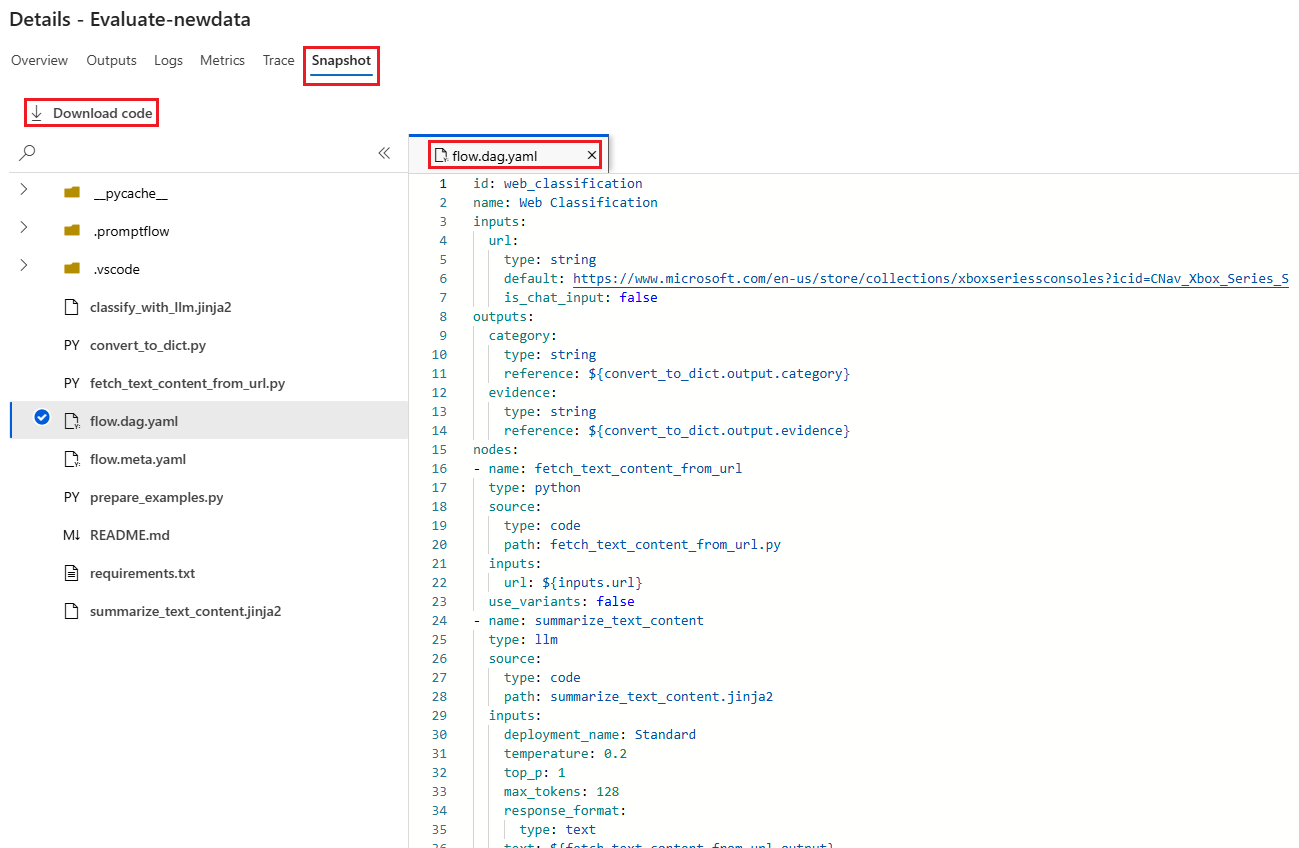

На вкладке "Моментальный снимок" отображаются файлы и код из запуска. Вы можете просмотреть определение потока flow.dag.yaml и скачать любой из файлов.

Запуск нового раунда оценки для того же запуска

Вы можете запустить новый раунд оценки, чтобы вычислить метрики для завершенного пакетного запуска без повторного запуска потока. Этот процесс экономит затраты на повторное выполнение потока и полезен в следующих сценариях:

- Вы не выбрали метод оценки при отправке пакетного запуска и теперь хотите оценить производительность выполнения.

- Вы использовали метод оценки для вычисления определенной метрики и теперь хотите вычислить другую метрику.

- Предыдущий запуск оценки завершился сбоем, но пакетный запуск успешно создал выходные данные и повторите попытку оценки.

Чтобы начать еще один раунд оценки, выберите "Оценить " в верхней части страницы потока выполнения пакетной службы. Откроется мастер создания оценки на экране "Выбор оценки ". Завершите настройку и отправьте новый запуск оценки.

Новый запуск отображается в списке выполнения потока запроса, и вы можете выбрать несколько строк в списке, а затем выбрать визуализацию выходных данных для сравнения выходных данных и метрик.

Сравнение журнала выполнения оценки и метрик

При изменении потока для повышения производительности можно отправить несколько пакетных запусков, чтобы сравнить производительность различных версий потока. Вы также можете сравнить метрики, вычисляемые различными методами оценки, чтобы увидеть, какой метод подходит для потока.

Чтобы проверить журнал выполнения пакета потока, выберите "Просмотреть пакет" в верхней части страницы потока. Для проверки сведений можно выбрать каждый запуск. Вы также можете выбрать несколько запусков и выбрать визуализацию выходных данных, чтобы сравнить метрики и выходные данные этих запусков.

Общие сведения о встроенных метриках оценки

Машинное обучение Azure поток запросов предоставляет несколько встроенных методов оценки, которые помогут оценить производительность выходных данных потока. Каждый метод оценки вычисляет различные метрики. В следующей таблице описаны доступные встроенные методы оценки.

| Метод оценки | Метрическая | Description | Требуется подключение? | Требуемые входные данные | Оценка значений |

|---|---|---|---|---|---|

| Оценка точности классификации | Правильность | Измеряет производительность системы классификации, сравнивая выходные данные с правдой | No | прогнозирование, земная правда | В диапазоне [0, 1] |

| Оценка заземления QnA | Соответствие эталонным данным | Измеряет, насколько прогнозируемые ответы модели находятся в источнике входных данных. Даже если ответы LLM являются точными, они не отображаются, если они не проверяются по источнику. | Да | вопрос, ответ, контекст (без правды) | От 1 до 5, с 1 = худшим и 5 = лучшим |

| Оценка сходства GPT QnA | Сходство GPT | Измеряет сходство между ответами на правду, предоставленными пользователем, и прогнозируемым моделью с помощью модели GPT | Да | вопрос, ответ, земная истина (контекст не нужен) | От 1 до 5, с 1 = худшим и 5 = лучшим |

| Оценка релевантности QnA | С сортировкой по релевантности | Измеряет, насколько релевантны прогнозируемые ответы модели на вопросы | Да | вопрос, ответ, контекст (без правды) | От 1 до 5, с 1 = худшим и 5 = лучшим |

| Оценка согласованности QnA | Согласованность | Измеряет качество всех предложений в прогнозируемом ответе модели и их соответствие естественно | Да | вопрос, ответ (нет оснований или контекста) | От 1 до 5, с 1 = худшим и 5 = лучшим |

| Оценка fluency QnA | Беглость | Измеряет грамматическую и лингвистическую правильность прогнозируемого ответа модели | Да | вопрос, ответ (нет оснований или контекста) | От 1 до 5, с 1 = худшим и 5 = лучшим |

| Оценка показателей QnA F1 | Оценка F1 | Измеряет соотношение количества общих слов между прогнозом модели и правдой земли | No | вопрос, ответ, земная истина (контекст не нужен) | В диапазоне [0, 1] |

| Оценка сходства QnA Ada | Сходство Ada | Вычисляет внедрение предложений (документ) с помощью API внедрения Ada embeddings для исходной истины и прогнозирования, а затем вычисляет косинус сходство между ними (одно число с плавающей запятой) | Да | вопрос, ответ, земная истина (контекст не нужен) | В диапазоне [0, 1] |

Повышение производительности потока

Если выполнение завершается сбоем, проверьте выходные данные и данные журнала и отладите любой сбой потока. Чтобы исправить поток или повысить производительность, попробуйте изменить запрос потока, системное сообщение, параметры потока или логику потока.

Техника подсказок

Создание запроса может быть сложной задачей. Дополнительные сведения о принципах создания запросов см. в разделе "Обзор запросов". Чтобы узнать, как создать запрос, который поможет достичь ваших целей, см . статью "Методы разработки запросов".

Системное сообщение

Вы можете использовать системное сообщение, иногда называемое метапроиспытом или системным запросом, чтобы управлять поведением системы ИИ и повысить производительность системы. Чтобы узнать, как повысить производительность потока с помощью системных сообщений, см . пошаговые инструкции по разработке системных сообщений.

Золотые наборы данных

Создание copilot, использующего LLM, обычно включает приземление модели в реальности с помощью исходных наборов данных. Золотой набор данных помогает гарантировать, что LLM обеспечивают наиболее точные и полезные ответы на запросы клиентов.

Золотой набор данных представляет собой коллекцию реалистичных вопросов клиентов и экспертно созданных ответов, которые служат средством проверки качества для LLMs, которые используются в вашем copilot. Золотые наборы данных не используются для обучения LLM или внедрения контекста в запрос LLM, но для оценки качества ответов, генерируемых LLM.

Если ваш сценарий включает в себя copilot или вы создаете собственный copilot, ознакомьтесь с подробными рекомендациями и рекомендациями по созданию золотых наборов данных.