Каталог моделей и коллекции

Каталог моделей в Студия машинного обучения Azure — это центр для обнаружения и использования широкого спектра моделей, позволяющих создавать приложения сгенерируемым искусственным интеллектом. Каталог моделей содержит сотни моделей от поставщиков моделей, таких как служба Azure OpenAI, Mistral, Meta, Cohere, NVIDIA, Hugging Face, включая модели, обученные корпорацией Майкрософт. Модели от поставщиков, отличных от корпорации Майкрософт, являются продуктами, отличными от Майкрософт, как определено в условиях продукта Майкрософт, и соответствуют условиям, предоставленным моделью.

Коллекции моделей

Модели организованы коллекциями в каталоге моделей. В каталоге моделей существует три типа коллекций:

- Модели, курируемые Azure AI: самые популярные сторонние открытые модели веса и собственные модели упакованы и оптимизированы для эффективной работы на платформе ИИ Azure. Использование этих моделей распространяется на условия лицензии поставщика моделей, предоставляемые моделью. При развертывании в Машинном обучении Azure доступность модели регулируется применимым соглашением об уровне обслуживания Azure, и Microsoft предоставляет поддержку по вопросам развертывания. Модели от партнеров, таких как Meta, NVIDIA, Mistral AI, являются примерами моделей, доступных в коллекции "Курируемый Azure AI" в каталоге. Эти модели можно обозначить зеленой галочкой на плитках моделей в каталоге, или вы можете отфильтровать их по коллекции "Курируемый ИИ Azure".

- Модели Azure OpenAI, доступные исключительно в Azure: флагманские модели Azure OpenAI через коллекцию Azure OpenAI через интеграцию со службой Azure OpenAI. Эти модели поддерживаются Microsoft, и их использование регулируется условиями продукта и соглашением об уровне обслуживания для службы Azure OpenAI.

- Открытые модели из концентратора распознавания лиц Hugging: сотни моделей из концентратора HuggingFace доступны через коллекцию Hugging Face для вывода в режиме реального времени с сетевыми конечными точками. Hugging face создает и поддерживает модели, перечисленные в коллекции HuggingFace. Для получения помощи воспользуйтесь форумом HuggingFace или службой поддержки HuggingFace. Узнайте больше о развертывании моделей из Hugging Face.

Предлагая дополнения к каталогу моделей: вы можете отправить запрос на добавление модели в каталог моделей с помощью этой формы.

Общие сведения о возможностях каталога моделей

Сведения о моделях Azure OpenAI см. в службе Azure OpenAI.

Для моделей , управляемых с помощью ИИ Azure и Открытых моделей из концентратора распознавания лиц, некоторые из них можно развернуть с помощью управляемого вычислительного параметра, а некоторые из них доступны для развертывания с помощью бессерверных API с выставлением счетов по мере использования. Эти модели можно обнаружить, сравнить, оценить, точно настроить (при поддержке) и развернуть в масштабе и интегрировать в приложения Генерированного ИИ с корпоративным классом безопасности и управления данными.

- Обнаружение: просмотр карточек модели, пример вывода и просмотр примеров кода для оценки, точной настройки или развертывания модели.

- Сравнение: сравнивайте тесты между моделями и наборами данных, доступными в отрасли, чтобы оценить, какой из них соответствует вашему бизнес-сценарию.

- Оценка. Оцените, подходит ли модель для конкретной рабочей нагрузки, предоставив собственные тестовые данные. Метрики оценки позволяют легко визуализировать, насколько хорошо выбранная модель работает в вашем сценарии.

- Тонкой настройки. Настройка точной настройки моделей с помощью собственных обучающих данных и выбор оптимальной модели путем сравнения метрик во всех заданиях точной настройки. Встроенные оптимизации ускоряют настройку и сокращают объем памяти и вычислительные ресурсы, необходимые для точной настройки.

- Развертывание: развертывание предварительно обученных моделей или точно настроенных моделей для вывода. Можно также скачать модели, которые можно развернуть для управляемых вычислений.

Развертывание модели: управляемые вычислительные ресурсы и бессерверный API (оплата по мере использования)

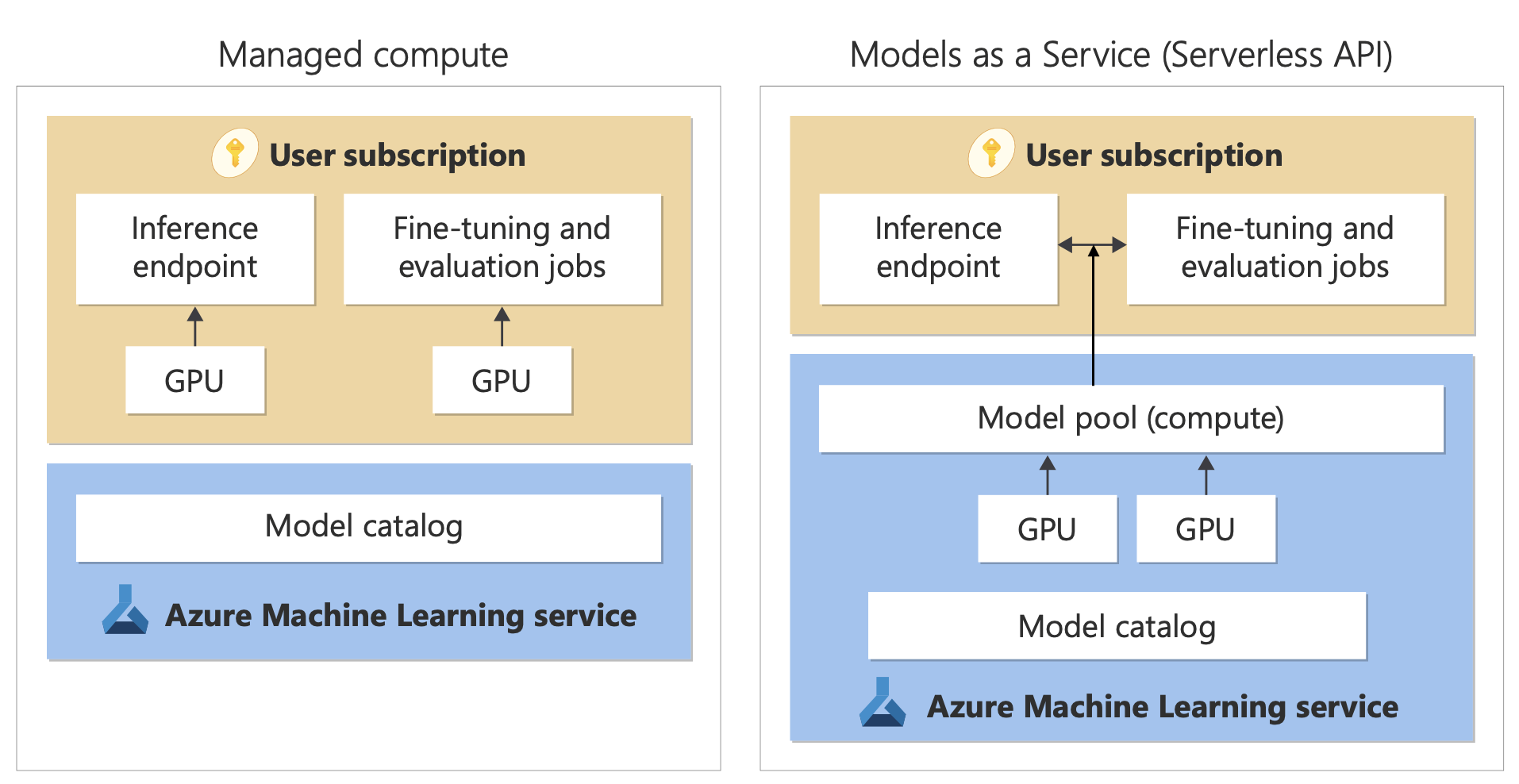

Каталог моделей предлагает два различных способа развертывания моделей из каталога: управляемый вычислительный и бессерверные API. Для каждой модели доступны различные варианты развертывания. В приведенных ниже таблицах содержатся дополнительные сведения о функциях вариантов развертывания и вариантах, предусмотренных для определенных моделей. Получите дополнительные сведения об обработке данных и вариантах развертывания.

| Компоненты | Управляемые вычисления | Бессерверный API (оплата по мере использования) |

|---|---|---|

| Интерфейс развертывания и выставление счетов | Весовые коэффициенты для моделей развертываются в выделенных виртуальных машинах с управляемыми сетевыми конечными точками. Управляемая конечная точка в сети, которая может иметь одно или несколько развертываний, предоставляет REST API для вывода. Плата взимается за базовые часы виртуальных машин, используемые развертываниями. | Доступ к моделям осуществляется через развертывание, которое подготавливает API для доступа к модели. API предоставляет доступ для вывода к модели, размещенной в центральном пуле GPU, управляемом корпорацией Microsoft. Этот режим доступа называется «Модели как услуга». Взимается плата за входные и выходные данные в API, обычно в маркерах; перед развертыванием предоставляются сведения о ценах. |

| Проверка подлинности API | Ключи и проверка подлинности Microsoft Entra ID Подробнее. | Только ключи. |

| Безопасность содержимого | Используйте API сервиса безопасности содержимого Azure. | Фильтры безопасности содержимого ИИ Azure доступны как интегрированные с API вывода. Фильтры безопасности содержимого ИИ Azure могут оплачиваться отдельно. |

| Сетевая изоляция | Управляемая виртуальная сеть с конечными точками в сети. Подробнее. |

Параметры развертывания

| Модель | Управляемые вычисления | Бессерверный API (оплата по мере использования) |

|---|---|---|

| Модели семейства Llama | Лама-3.3-70B-Instruct Лама-2-7b Лама-2-7b-чат Лама-2-13b Ллома-2-13b-чат Лама-2-70b Ллома-2-70b-чат Лама-3-8B-Instruct Лама-3-70B-Instruct Лама-3-8B Llama-3-70B |

Лама-3.3-70B-Instruct Лама-3-70B-Instruct Лама-3-8B-Instruct Лама-2-7b Лама-2-7b-чат Лама-2-13b Ллома-2-13b-чат Лама-2-70b Llama-2-70b-chat |

| Модели семейства Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Мистраль-большой (2402) Мистраль-большой (2407) Мистраль-маленький Министерство-3B Мистраль-Эмо |

| Модели семейства Cohere | Недоступно | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-многоязычный Cohere-rerank-v3-english Cohere-rerank-v3-многоязычный |

| JAIS | Недоступно | jais-30b-chat |

| Семейные модели Phi-3 | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-instruct Phi-3.5-MoE-Instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-instruct Phi-3.5-MoE-Instruct |

| Nixtla | Недоступно | TimeGEN-1 |

| Другие модели | Доступно | Недоступно |

Управляемые вычисления

Возможность развертывания моделей с управляемыми вычислительными ресурсами на платформах возможностей Машинное обучение Azure для обеспечения простой интеграции во всем жизненном цикле GenAIOps (иногда называемых LLMOps) широкой коллекции моделей в каталоге моделей.

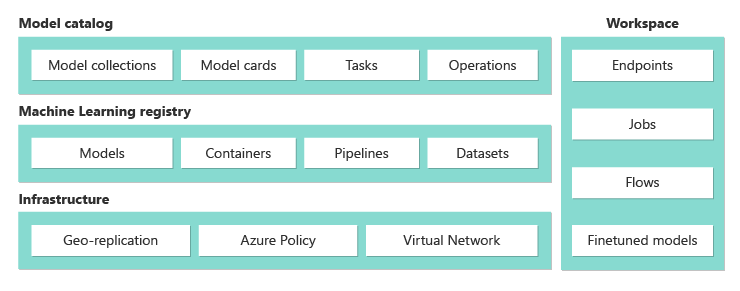

Как модели предоставляются для управляемой вычислительной среды?

Модели предоставляются с помощью реестров Машинного обучения Azure, которые обеспечивают Машинному обучению первоочередной доступ к размещению и распространению ресурсов Машинного обучения, таких как весовые коэффициенты для моделей, среды выполнения контейнеров для запуска моделей, конвейеры для оценки и тонкой настройки моделей, а также наборы данных для тестирования и демонстрации примеров. Эти реестры Машинного обучения создаются на основе высокомасштабируемой, готовой к корпоративному использованию инфраструктуры, которая

предоставляет артефакты модели доступа с низкой задержкой во всех регионах Azure благодаря встроенной георепликации;

поддерживает корпоративные требования к безопасности, например, ограничение доступа к моделям за счет Политики Azure и безопасное развертывание с управляемыми виртуальными сетями.

Оценка и настройка моделей, развернутых с помощью управляемых вычислений

Выполнить оценку и настройку можно в коллекции «Подобрано ИИ Azure» Машинного обучения Azure с помощью конвейеров Машинного обучения Azure. Можно выбрать один из двух вариантов: предоставить собственный код для оценки и настройки и просто получить доступ к весовым коэффициентам модели или использовать компоненты Машинного обучения Azure, которые предлагают встроенные возможности оценки и настройки. Для получения дополнительных сведений перейдите по этой ссылке.

Развертывание моделей вывода с помощью управляемых вычислений

Модели, доступные для развертывания с управляемыми вычислительными ресурсами, можно развернуть для Машинное обучение Azure сетевых конечных точек для вывода в режиме реального времени или использовать для Машинное обучение Azure пакетного вывода для пакетной обработки данных. При развертывании на управляемых вычислительных ресурсах требуется квота виртуальной машины в подписке Azure для конкретных номеров SKU, необходимых для оптимального запуска модели. Некоторые модели позволяют развертывать временно общую квоту для тестирования модели. Дополнительные сведения о развертывании моделей:

- Развертывание моделей Meta Llama

- Развертывание открытых моделей, созданных СИ Azure

- Развертывание моделей распознавания лиц

Создание приложений на основе генеративного ИИ с помощью управляемой вычислительной среды

Поток запросов располагает возможностями для создания прототипов, экспериментирования, итерации и развертывания ваших приложений ИИ. Развертываемые в управляемой вычислительной среде модели можно использовать в потоке запросов с помощью средства Open Model LLM. Вы также можете использовать REST API, предоставляемый управляемой вычислительной средой в популярных инструментах для работы с LLM, таких как LangChain с расширением «Машинное обучение Azure».

Безопасность содержимого для моделей, развернутых с помощью управляемой вычислительной среды

Служба "Безопасность содержимого ИИ Azure" (AACS) доступна для использования с моделями, развернутыми для управляемых вычислений на экране для различных категорий вредного содержимого, таких как сексуальное содержимое, насилие, ненависть, а также дополнительные угрозы, такие как обнаружение рисков в тюрьме и обнаружение защищенного текста. Эту записную книжку можно использовать для справки по интеграции с AACS для Llama 2 или использовать средство "Безопасность содержимого ( текст) в потоке запросов для передачи ответов от модели в AACS для проверки. Вы будете выставляться отдельно по тарифам AACS для такого использования.

Работа с моделями, не в каталоге моделей

Для моделей, недоступных в каталоге моделей, Машинное обучение Azure предоставляет открытую и расширяемую платформу для работы с моделями вашего выбора. Модель можно использовать с любой платформой или средой выполнения с помощью открытых и расширяемых возможностей платформы Машинное обучение Azure, таких как Машинное обучение Azure среды для контейнеров, которые могут упаковыть платформы и среды выполнения и Машинное обучение Azure конвейеры. для кода для оценки или точной настройки моделей. См. в этой записной книжке пример ссылки на импорт моделей и работу со встроенными средами выполнения и конвейерами.

Бессерверные API с выставлением счетов по мере использования

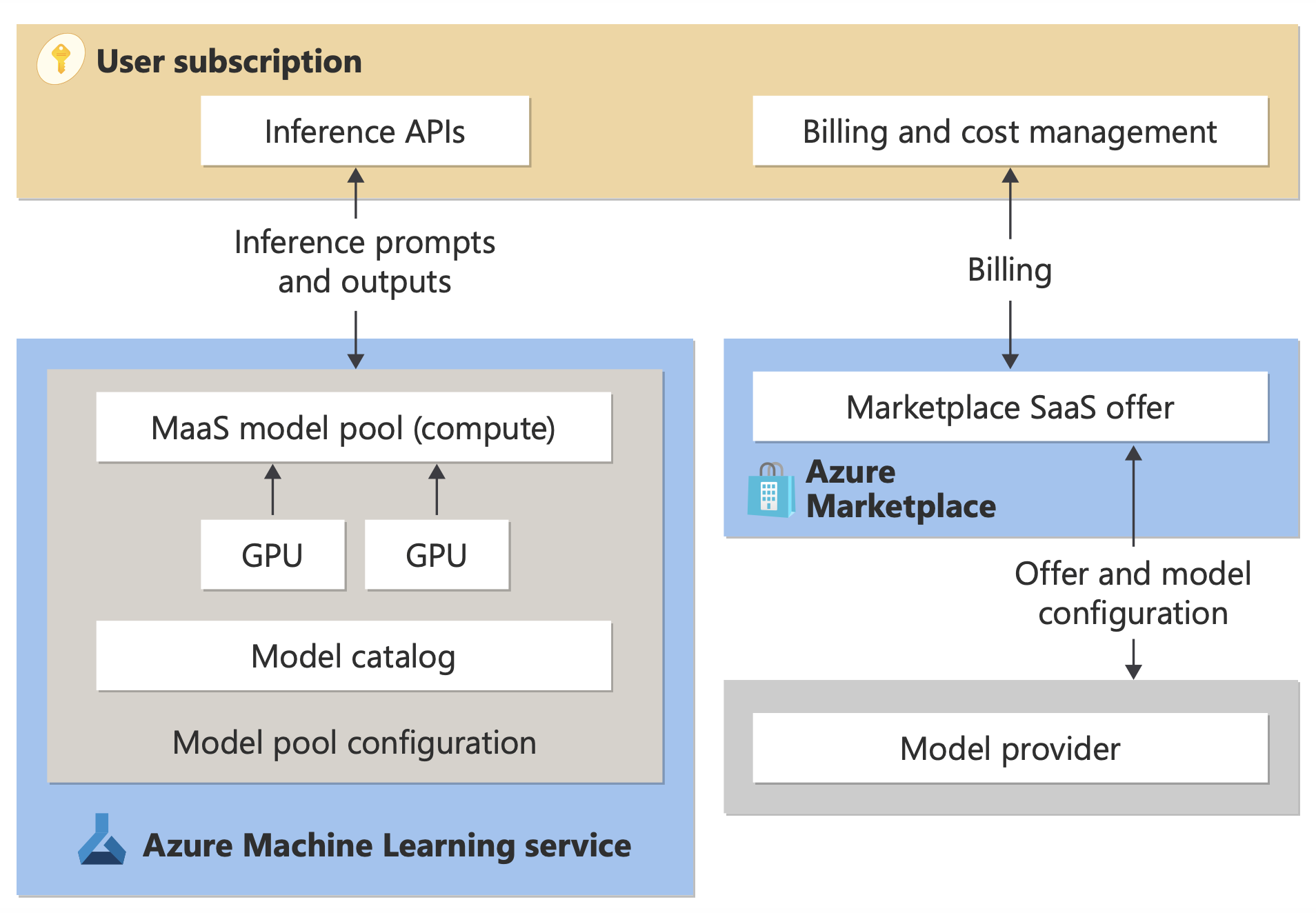

Некоторые модели в каталоге моделей можно развернуть как бессерверные API с выставлением счетов по мере использования; этот метод развертывания называется Models-as-a Service (MaaS). Модели, доступные через MaaS, размещаются в инфраструктуре, управляемой корпорацией Майкрософт, которая обеспечивает доступ на основе API к модели поставщика моделей. Доступ на основе API может значительно сократить затраты на доступ к модели и значительно упростить процесс подготовки. Большинство моделей MaaS приходят с ценами на основе токенов.

Как доступны сторонние модели в MaaS?

Модели, которые можно развертывать в качестве бессерверных API с оплатой по мере использования, предлагаются поставщиком моделей. Однако они размещаются в управляемой корпорацией Майкрософт инфраструктуре Azure, и доступ к ним осуществляется через API. Поставщики моделей определяют условия лицензии и задают цену на использование своих моделей, а служба Машинное обучение Azure управляет инфраструктурой размещения, делает интерфейсы API вывода доступными и выступает в качестве обработчика данных для запросов, отправленных и выходных данных содержимого моделями, развернутыми с помощью MaaS. Дополнительные сведения об обработке данных для MaaS см. в статье о конфиденциальности данных.

Оплата использования модели в MaaS

Интерфейс обнаружения, подписки и потребления моделей, развернутых с помощью MaaS, находится на портале Azure AI Foundry и Студия машинного обучения Azure. Пользователи принимают условия лицензии для использования моделей, а во время развертывания предоставляются сведения о ценах на потребление. Счета за модели сторонних поставщиков выставляются через Azure Marketplace в соответствии с условиями использования коммерческой платформы; модели от Майкрософт выставляются с помощью счетчиков Azure в качестве служб потребления первой стороны. Как описано в условиях продукта, службы потребления первой стороны покупаются с помощью счетчиков Azure, но не применяются к условиям обслуживания Azure. Использование этих моделей распространяется на условия лицензии.

Развертывание моделей вывода с помощью MaaS

Развертывание модели с помощью MaaS позволяет пользователям получать доступ к готовым к использованию API вывода без необходимости настраивать инфраструктуру или подготавливать графические процессоры, экономя время и ресурсы. Эти API можно интегрировать с несколькими средствами LLM и использованием, как описано в предыдущем разделе.

Детализируйте модели с помощью MaaS с оплатой по мере использования

Для моделей, доступных с помощью MaaS и поддержки точной настройки, пользователи могут воспользоваться преимуществами размещенной точной настройки с оплатой по мере использования для настройки моделей с использованием предоставленных данных. Дополнительные сведения см. в статье о точной настройке модели Llama 2 на портале Azure AI Foundry.

RAG с моделями, развернутыми с помощью MaaS

Azure AI Foundry позволяет пользователям использовать векторные индексы и получение дополненного поколения. Модели, которые можно развернуть как бессерверные API, можно использовать для создания внедрения и вывода на основе пользовательских данных для создания ответов, относящихся к их варианту использования. Дополнительные сведения см. в разделе "Получение дополненного поколения" и индексов.

Региональная доступность предложений и моделей

Выставление счетов pPay по мере использования доступно только пользователям, подписка Azure которой принадлежит учетной записи выставления счетов в стране или регионе, где поставщик модели сделал предложение доступным. Если предложение доступно в соответствующем регионе, пользователь должен иметь концентратор или проект в регионе Azure, где модель доступна для развертывания или тонкой настройки, как применимо. Подробные сведения см. в разделе "Доступность регионов" для моделей в конечных точках API без сервера.

Безопасность содержимого для моделей, развернутых с помощью MaaS

Внимание

Эта функция сейчас доступна в виде общедоступной предварительной версии. Эта предварительная версия предоставляется без соглашения об уровне обслуживания. Ее не следует использовать для производственных рабочих нагрузок. Некоторые функции могут не поддерживаться или их возможности могут быть ограничены.

Дополнительные сведения см. в статье Дополнительные условия использования Предварительных версий Microsoft Azure.

Для языковых моделей, развернутых с помощью бессерверных API, Azure AI реализует конфигурацию по умолчанию фильтров модерации текста безопасности содержимого ИИ Azure, которые обнаруживают вредное содержимое, например ненависть, самоповредение, сексуальное и насильственное содержимое. Дополнительные сведения о фильтрации содержимого (предварительная версия) см. в статьях "Безопасность содержимого ИИ Azure".

Совет

Фильтрация содержимого (предварительная версия) недоступна для определенных типов моделей, развернутых через бессерверные API. Эти типы моделей включают внедрение моделей и моделей временных рядов.

Фильтрация содержимого (предварительная версия) выполняется синхронно, так как процессы службы запрашивают создание содержимого. Вы можете выставлять счета отдельно в соответствии с ценами на безопасность содержимого искусственного интеллекта Azure для такого использования. Вы можете отключить фильтрацию содержимого (предварительная версия) для отдельных бессерверных конечных точек:

- Во время первого развертывания языковой модели

- Позже, выбрав переключатель фильтрации содержимого на странице сведений о развертывании

Предположим, вы решите использовать API, отличный от API вывода модели ИИ Azure, для работы с моделью, развернутой через бессерверный API. В такой ситуации фильтрация содержимого (предварительная версия) не включена, если только вы не реализуете его отдельно с помощью безопасности содержимого ИИ Azure.

Сведения о начале работы с безопасностью содержимого ИИ Azure см . в кратком руководстве по анализу текстового содержимого. Если при работе с моделями, развернутыми через бессерверные API, не используется фильтрация содержимого (предварительная версия), то при работе с моделями, развернутыми через бессерверные API, возникает более высокий риск предоставления пользователям вредного содержимого.

Сетевая изоляция для моделей, развернутых с помощью бессерверных API

Конечные точки для моделей, развернутых как бессерверные API, следуют параметру флага доступа к общедоступной сети (PNA) рабочей области, в которой существует развертывание. Чтобы защитить конечную точку MaaS, отключите флаг PNA в рабочей области. Вы можете защитить входящий трафик от клиента к конечной точке с помощью частной конечной точки для рабочей области.

Чтобы задать флаг PNA для рабочей области, выполните следующие действия.

- Переход на портал Azure.

- Найдите Машинное обучение Azure и выберите рабочую область из списка рабочих областей.

- На странице "Обзор" перейдите в раздел "Параметры сети" с помощью области навигации>слева.

- На вкладке "Общедоступный доступ" можно настроить параметры для флага доступа к общедоступной сети.

- Сохранение изменений. Для распространения изменений может потребоваться до пяти минут.

Ограничения

- Если у вас есть рабочая область с частной конечной точкой, созданной до 11 июля 2024 г., новые конечные точки MaaS, добавленные в эту рабочую область, не будут следовать его конфигурации сети. Вместо этого необходимо создать частную конечную точку для рабочей области и создать новые бессерверные развертывания API в рабочей области, чтобы новые развертывания могли следовать конфигурации сети рабочей области.

- Если у вас есть рабочая область с развертываниями MaaS, созданными до 11 июля 2024 г., и вы включите частную конечную точку в этой рабочей области, существующие развертывания MaaS не будут соответствовать конфигурации сети рабочей области. Для развертывания бессерверных API в рабочей области, чтобы следовать конфигурации рабочей области, необходимо снова создать развертывания.

- В настоящее время поддержка данных недоступна для развертываний MaaS в частных рабочих областях, так как в частных рабочих областях флаг PNA отключен.

- Любое изменение конфигурации сети (например, включение или отключение флага PNA) может занять до пяти минут для распространения.