MLOps e GenAIOps para cargas de trabalho de IA no Azure

As operações de carga de trabalho de IA estão centradas na curadoria de dados e no consumo desses dados. As operações garantem eficiência na obtenção e manutenção da qualidade, confiabilidade, segurança, ética e outros padrões que você prioriza para a carga de trabalho.

As tarefas de carga de trabalho podem ser categorizadas em três áreas principais: desenvolvimento de aplicativos, tratamento de dados e gerenciamento de modelos de IA. Cada categoria deve adotar metodologias operacionais comprovadas pelo setor, como DevOps, DataOps, MLOps e GenAIOps.

As atividades de DevOps abrangem todo o gerenciamento do ciclo de vida de desenvolvimento de aplicativos por meio de pipelines e monitoramento automatizados de integração contínua e implantação contínua (CI/CD). No entanto, para cargas de trabalho de IA, o pipeline de dados é um dos componentes principais. DataOps, uma especialização de DevOps, concentra-se no gerenciamento do ciclo de vida dos dados simplificando processos como extração, transformação e carregamento de dados (ETL/ELT). Os profissionais de DataOps normalmente medem o desempenho do fluxo de dados e a eficácia da limpeza de dados e monitoram o pipeline em busca de anomalias.

As cargas de trabalho de IA são inerentemente não determinísticas. Muitos modelos de IA são propensos a produzir respostas diferentes para a mesma pergunta durante a inferência. Essas cargas de trabalho precisam de processos que possam gerenciar e se adaptar à imprevisibilidade das saídas de IA. O DataOps se estende ao MLOps, que operacionaliza fluxos de trabalho de aprendizado de máquina para treinamento e teste de modelos. GenAIOps, um subconjunto especializado de MLOps, tem como alvo soluções de IA generativa. Envolve tarefas como descoberta de modelos e refinamento de modelos pré-treinados com dados enriquecidos.

As atividades operacionais sobrepõem-se frequentemente e as diferentes metodologias aplicam-se em graus diferentes. Por exemplo, na IA discriminativa, o DataOps desempenha um papel importante, enquanto as atividades de DevOps são menos proeminentes. Por outro lado, na IA generativa, a excelência operacional depende mais do DevOps do que do DataOps.

Independentemente disso, o objetivo geral é a entrega de capacidade com operações eficientes durante todo o ciclo de vida do desenvolvimento. Os resultados esperados são:

- Processos repetíveis com resultados consistentes.

- Precisão sustentada dos modelos ao longo do tempo.

- Governança eficaz que minimiza os riscos.

- Processos de gestão da mudança para adaptação à deriva do modelo.

A automação e o monitoramento são suas principais estratégias operacionais para atingir esses objetivos.

Você também precisa estabelecer processos padronizados para componentes de IA, para operações de rotina, não planejadas e de emergência, e ter mecanismos de rastreamento adequados em vigor. Sem esses processos, você corre o risco de:

- Erros repetidos e não reprodutibilidade no processamento de dados, hospedagem de modelos, gerenciamento de dados de aterramento e outras tarefas.

- Dados obsoletos ou de baixa qualidade usados para treinamento e refinamento de modelos.

- Afetando a confiança do usuário final no sistema, na pior das hipóteses, levando a problemas legais, de conformidade ou de segurança.

Você deve implementar processos estabelecidos com o conjunto certo de ferramentas. Ferramentas especializadas estão disponíveis para gerenciar fluxos de trabalho de IA / aprendizado de máquina em todos os ambientes.

Este artigo se concentra na estratégia de design para operações e fornece recomendações de ferramentas.

Recomendações

Aqui está o resumo das recomendações fornecidas neste artigo.

| Recomendação | Description |

|---|---|

| Projete um ciclo de vida de operações de carga de trabalho eficiente. | Com base nos componentes da sua carga de trabalho de IA, diferentes estágios operacionais serão aplicados ao seu ciclo de vida. É importante que você entenda as melhores práticas relevantes para o seu cenário e as ferramentas disponíveis para implementá-las. Aproveite o tempo para aprender e implementar as principais recomendações para todos os componentes da sua carga de trabalho. ▪ DataOps ▪ MLOps ▪ GenAIOps ▪ Monitorização |

| Automatize tudo. | A automação garante repetibilidade e eficiência no ciclo de vida de uma carga de trabalho. Embora os processos de DevOps sejam um contribuinte fundamental para isso, há etapas adicionais que você precisa seguir para criar, testar, validar e implantar seus modelos de forma eficiente. ▪ Automação |

| Utilize pipelines de implantação sempre que possível. | Os pipelines de implantação podem ajudá-lo a fornecer implantações de infraestrutura repetíveis ou integrar código continuamente. Eles também são uma ótima ferramenta para criar e/ou validar modelos antes de promovê-los para a produção. A implementação de pipelines de implantação ajuda a melhorar a confiabilidade, bem como a experiência geral do usuário de sua carga de trabalho. ▪ Pipelines de implantação |

| Previna a deriva e a deterioração nos seus modelos. | Você deve se proteger contra o decaimento e a deriva do modelo e, ao mesmo tempo, ter um processo estruturado que o ajude a aceitar novas alterações de modelo de forma controlada. Seguir as recomendações em torno da manutenção do modelo ajuda você a permanecer em conformidade, evitar experiências de usuário inesperadas e fornecer um serviço mais atualizado. ▪ Manutenção de modelos |

Ciclo de vida das operações de carga de trabalho

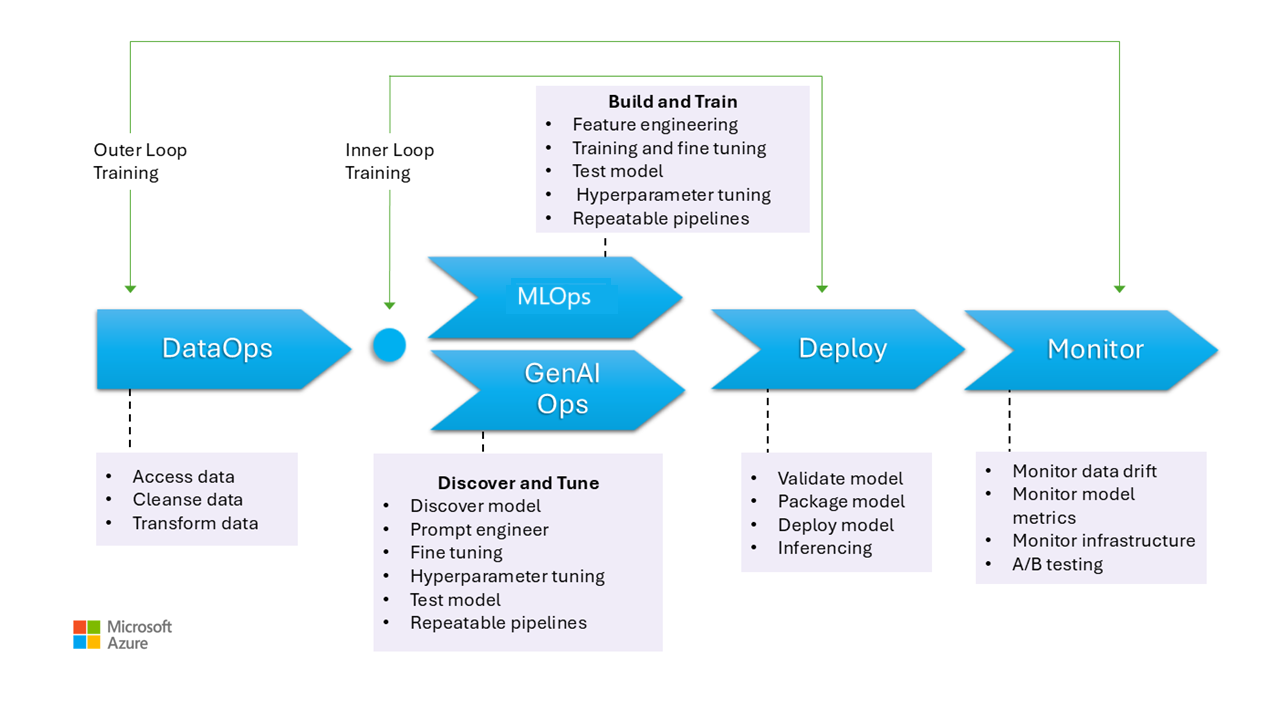

Esta imagem ilustra as etapas operacionais dos modelos de IA, incluindo a coleta de dados, a limpeza de dados para eliminar inconsistências ou erros e a transformação de dados em um formato analisável. Essas etapas são relevantes para treinar modelos discriminativos e fundamentar dados em modelos generativos. No entanto, o caso de uso específico de modelos generativos de treinamento não é retratado nesta imagem. Esse caso de uso não se enquadra no âmbito deste artigo.

Os estágios de MLOps e GenAIOps são semelhantes. A principal diferença é que, no caso do GenAIOps, o foco muda do treinamento para a seleção do modelo certo, engenharia imediata e incorporação de conhecimento específico do domínio por meio de ajuste fino ou implementação da Geração Aumentada de Recuperação (RAG).

Mesmo as etapas de implantação e monitoramento são bastante semelhantes.

As secções seguintes descrevem as práticas operacionais comuns. Abrangem todas as fases do ciclo de vida, desde a pré-produção até à produção.

DataOps

Os dados são agregados de várias fontes de dados de produção e, em seguida, pré-processados para remover erros e inconsistências e para lidar com valores ausentes. Finalmente, é transformado e normalizado em um formato adequado para treinamento ou enriquecimento. Os aspetos do design são descritos nos artigos Dados de treinamento e Dados de aterramento .

Os processos de operações de dados durante esse estágio devem ser eficientes, pois lidar com grandes volumes de dados de várias fontes e pipelines de dados complexos pode ser um desafio. As abordagens adotadas precisam garantir que essa fase produza dados de alta qualidade. Monitore este estágio para acompanhar o progresso em direção à barra de qualidade aceitável.

Você também precisa garantir que os dados estejam seguros, dado que os dados são da produção. Certifique-se de que ambientes inferiores, como Desenvolvimento/Teste, sejam tão seguros quanto a produção para ajudar a evitar quaisquer problemas de segurança.

Nota

Aborde dados de baixa qualidade investindo em limpeza extensiva de dados durante as fases iniciais. Aproveite os padrões de análise bem conhecidos, como medalhão, malha de dados e repositórios de recursos, para realizar tarefas de processamento upstream. Se as fases upstream forem ineficazes, você precisará melhorar a qualidade durante as fases downstream, o que leva ao aumento dos custos da carga de trabalho porque a preparação dos dados ocorre durante cada estágio.

Para obter informações sobre tarefas de processamento de dados, consulte estes artigos:

Ferramentas

Recomendamos que você padronize as ferramentas de orquestração de dados da sua carga de trabalho. As ferramentas devem ser capazes de fornecer um pipeline de dados que possa agrupar atividades e que tenha automação integrada.

Um pipeline do Azure Data Factory pode ser uma escolha inicial. Ele pode conectar e processar muitas fontes de dados de forma eficiente. Você também pode considerar o Azure Synapse Analytics, que combina big data e data warehousing e dá suporte a data lakes, Apache Spark e Azure Synapse SQL. Ele também se integra com o Data Factory para ETL.

Para preparar dados de treinamento, os pipelines do Azure Machine Learning fornecem recursos especializados que podem automatizar tarefas como coleta e processamento de dados.

Tecnologias de código aberto como Pandas (para preparação de dados) e Scrapy são escolhas populares.

MLOps

O treinamento de modelos é o processo de selecionar algoritmos apropriados e fornecer-lhes dados históricos pré-processados e observações para permitir que o modelo aprenda padrões e faça previsões.

Treinar o modelo (engenharia de recursos) e o ajuste de hiperparâmetros são processos iterativos e caros. Durante cada iteração, os cientistas de dados rastreiam os resultados com combinações de dados, código e parâmetros. Use pipelines repetíveis para rastrear experimentos com o mínimo de esforço manual até que o nível certo de precisão seja alcançado.

Outro desafio operacional é provisionar e dimensionar recursos computacionais especializados onde os experimentos são conduzidos. Além disso, você deve empacotar e publicar modelos de forma eficiente.

As equipes podem começar com o desenvolvimento baseado em interface do usuário para reduzir os desafios e, à medida que se tornam mais confiantes, fazer a transição para uma abordagem baseada em código.

Ferramentas

Recomendamos que você use ferramentas que possam rastrear experimentos de aprendizado de máquina capturando detalhes como versões de código, ambientes, parâmetros, execuções e resultados. O MLflow é uma dessas estruturas de código aberto. Considere usar espaços de trabalho do Azure Machine Learning, que são compatíveis com MLflow e fornecem um fluxo de trabalho simplificado que permite que cientistas de dados gerenciem a produtividade e a reprodutibilidade em seus projetos. Para gerenciar o desenvolvimento de código com rastreamento de controle do código-fonte, integre o pipeline de aprendizado de máquina com o controle do código-fonte, como o GitHub, ou use compartilhamentos de arquivos.

A computação de hospedagem também pode influenciar sua escolha de um orquestrador de fluxo de trabalho. Se seu aplicativo estiver hospedado no Serviço Kubernetes do Azure (AKS), considere usar o Kubeflow.

Se você estiver considerando o Aprendizado de Máquina do Azure, recomendamos que comece com a perspetiva do Azure Well-Architected Framework no Machine Learning para garantir que você entenda como o produto pode ajudá-lo com as preocupações de qualidade do Well-Architected Framework da carga de trabalho.

Parte do benefício do processo é otimizar o tempo pessoal. Os cientistas de dados normalmente precisam de ferramentas e SDKs específicos para conduzir efetivamente a análise exploratória de dados (EDA) e a experimentação a partir de suas estações de trabalho. Avalie se as opções pré-criadas no Azure Machine Learning são adequadas. Caso contrário, armazene a configuração da estação de trabalho ou mantenha imagens de VM aprovadas para este trabalho. Um exemplo de uma imagem que você pode usar como ponto de partida é a Máquina Virtual de Ciência de Dados (DSVM).

Em certos casos, o uso de VMs pode não ser permitido pela política. Procure alternativas, como adicionar o Microsoft Dev Box e a Área de Trabalho Virtual do Azure. Você também pode considerar o uso do Docker para inicializar máquinas que contenham imagens pré-criadas.

No entanto, à medida que esse estágio amadurece e você precisa de experimentos estendidos, mude para instâncias de computação gerenciadas e prefira opções integradas como parte do fluxo de trabalho. Avalie se você pode usar instâncias de computação do Azure Machine Learning para treinamento e inferência para fins de desenvolvimento e teste. Os clusters de computação podem lidar com grandes conjuntos de dados e modelos complexos.

O Azure Machine Learning fornece soluções baseadas em código por meio do SDK e opções de baixo código, como aprendizado de máquina automatizado e o designer visual. O Python SDK oferece várias maneiras de treinar modelos, cada uma com recursos distintos. O Machine Learning também suporta otimização avançada e tecnologias de computação distribuída, como ORTModule, DeepSpeed e LoRA do ONNX Runtime Training para acelerar o processo de treinamento.

GenAIOps

As principais atividades durante esta etapa começam com a descoberta e avaliação de modelos existentes para identificar um que é pré-treinado para o caso de uso específico. Este é um processo iterativo. Depois de encontrar um modelo adequado, ele pode se beneficiar de ser refinado para fundamentação específica do domínio, que também envolve etapas iterativas e requer um certo nível de orquestração.

A integração e a implantação de modelos exigem ferramentas e práticas especializadas que vão além dos recursos tradicionais de MLOps, incluindo a orquestração de modelos, índices vetoriais, prompts e blocos de código.

Ferramentas

Para lidar com tarefas de descoberta, aproveite os catálogos de modelos que incluem modelos de vários provedores. O catálogo de modelos no portal do Azure AI Foundry permite avaliar entre coleções selecionadas e implantar modelos de forma eficiente.

O fluxo de prompt do Aprendizado de Máquina do Azure pode ajudar no desenvolvimento de código de orquestração, habilitando a criação de protótipos, a experimentação, a iteração e a engenharia de prompts. Esses fluxos podem ser implantados em pontos de extremidade gerenciados do Azure Machine Learning. Avalie se você pode executar e implantar os fluxos com sua tecnologia de pipeline de CI/CD existente.

Implementação

Durante esse estágio, o modelo é implantado em uma plataforma de hospedagem e inferência ou na camada de serviço de cargas de trabalho de IA. As APIs precisam ser empacotadas como um contêiner escalável. A plataforma de contêiner pode ser uma computação gerenciada ou uma plataforma de hospedagem personalizada. As práticas operacionais devem garantir uma implantação segura e permitir reversões.

Comece com plataforma como serviço (PaaS) e soluções sem servidor, como o Azure OpenAI Service, para simplificar a adoção e o gerenciamento. Considere usar a API Serverless do Azure Machine Learning para agregar o acesso ao ponto de extremidade. Os clusters de computação gerenciados são uma opção viável para necessidades avançadas. Auto-hospedagem no AKS é outra opção. Certifique-se de dimensionar corretamente sua computação e manter o isolamento adequado de outras cargas de trabalho. Você também pode considerar opções como hospedar totalmente seu modelo como infraestrutura como serviço (IaaS). A IaaS oferece flexibilidade, mas pode adicionar carga operacional. Essas opções são descritas em Plataforma de aplicativos.

Esta etapa apresenta a última chance de detetar problemas antes de mover o modelo para a produção. Os processos de teste devem incluir etapas de validação para garantir que o modelo esteja configurado para fornecer previsões conforme o esperado.

Você deve integrar o modelo ao ambiente de produção existente seguindo processos de exposição progressiva e usando implantações lado a lado. O modelo canário é uma maneira comum de lançar novos modelos. Com este método, a base de usuários é aumentada gradualmente. A implantação azul-verde é outro método.

Ferramentas

Você pode usar os pipelines do Azure Machine Learning ou os Pipelines do Azure para implantar seus modelos para inferência. O Machine Learning fornece vários recursos para operações simplificadas, incluindo provisionamento de nós, atualizações do sistema operacional, dimensionamento automático, monitoramento e redes virtuais isoladas.

O Machine Learning também suporta a implantação azul-verde, que permite que um único ponto de extremidade contenha várias implantações.

Se você usar outras plataformas de hospedagem, como os Aplicativos de Contêiner do Azure ou o Serviço de Aplicativo do Azure, será responsável pelas operações, incluindo provisionamento e dimensionamento. Use o Azure DevOps, pipelines do GitHub ou sua escolha de tecnologia CI/CD nesses casos.

Monitorização

A monitorização é uma estratégia fundamental e aplicada em todas as fases. É um processo contínuo e serve como uma entrada para portas de qualidade que garantem que as cargas de trabalho de IA sejam rigorosamente testadas para manter a consistência e a confiabilidade durante todo o ciclo de vida do desenvolvimento. Os modelos devem ser monitorados tanto do ponto de vista operacional quanto da ciência de dados.

É altamente recomendável que você tenha um processo de monitoramento de loop interno DataOps que meça a proximidade de uma barra de qualidade de aceitação e verifique se há anomalias.

Para modelos pré-treinados, também é importante monitorar o desvio de dados e o desempenho, com foco principal na relevância. Avalie as entradas (prompts) e as saídas (conclusão) para garantir que sejam relevantes e precisas. Além disso, esteja ciente dos riscos de segurança, como tentativas de manipular o comportamento do modelo por meio de prompts mal-intencionados. Certifique-se de que há uma moderação de conteúdo completa que inspeciona os dados em ambas as direções e filtra o conteúdo impróprio. Essas considerações são descritas na área de design do ResponsibleAI.

Após a implantação, as operações de monitoramento são necessárias para resolver problemas como a deterioração do modelo. Os modelos podem tornar-se obsoletos devido a alterações nos dados ou alterações externas que podem fazer com que o modelo produza resultados irrelevantes. Como medida proativa, use processos automatizados para monitoramento contínuo e avalie e treine novamente para manter a precisão e a relevância. Além disso, você precisa monitorar as métricas de infraestrutura e carga de trabalho, como faria com qualquer outra carga de trabalho, para ajudar a garantir o desempenho e a confiabilidade ideais. Para obter mais informações, consulte Testando a deterioração do modelo.

Ferramentas

Invista em ferramentas que facilitem a coleta de métricas de pontos de extremidade de inferência, como o coletor de dados do Azure Machine Learning.

Você também precisa de observabilidade do desempenho do modelo, desvio de dados e segurança e qualidade para IA generativa.

Para mais informações, consulte estes artigos:

Automatização

As cargas de trabalho de IA são complexas porque o ciclo de vida geral envolve muitas funções, mudanças frequentes e etapas inter-relacionadas. Os processos manuais podem ser propensos a erros e inconsistências. A automação na hospedagem de modelos de processamento de dados ajuda a garantir a repetibilidade e a eficiência. A automação nem sempre é necessária, mas é uma maneira eficaz de gerenciar essas complexidades. Aqui estão alguns casos de uso em que a automação pode mitigar riscos:

Ao contrário da implantação de código tradicional, modelos e soluções não determinísticas em IA / aprendizado de máquina exigem experimentação iterativa e treinamento. Quando várias equipes colaboram, a automação, como forma de impor processos padronizados, pode ajudar a manter a consistência, a reprodutibilidade e a colaboração efetiva entre cientistas de dados, engenheiros e equipes de operações.

O ciclo de vida do modelo envolve dois tipos principais de treinamento:

O treinamento on-line incorpora dados recentes no modelo com frequência, às vezes diariamente, para garantir que as decisões sejam baseadas nas informações mais recentes. Esta formação é integrada na carga horária para que o modelo seja continuamente atualizado como parte do processo regular.

O treinamento off-line treina o modelo com menos frequência, permitindo um intervalo maior entre as atualizações. O processo de treinamento é separado da carga de trabalho principal e é feito de forma assíncrona. Depois que o novo modelo estiver pronto, ele é integrado ao sistema.

A fiabilidade pode ser comprometida se as atualizações forem pouco frequentes. Se uma atualização for perdida, ela pode ser adiada sem grandes problemas. Este conceito também se aplica aos dados de aterramento. Por exemplo, se você usa RAG, deve decidir se precisa usar dados recentes ou se dados um pouco mais antigos são suficientes. Ambos os cenários envolvem equilibrar a necessidade de informações atualizadas com a praticidade da frequência de atualização. Você deve realizar treinamento on-line via automação devido à frequência e confiabilidade necessárias. Para o treinamento off-line, devido à frequência necessária, você precisa justificar a automação realizando uma análise de custo-benefício. Além disso, você pode realizar treinamento offline usando recursos mais baratos, como hardware offline.

Os processos tradicionais de DevOps normalmente são afetados por mudanças estruturais. No entanto, em IA e aprendizado de máquina, os modelos são treinados em dados de produção. A deterioração do modelo representa um risco significativo e pode levar à diminuição do desempenho ao longo do tempo se não for monitorizada. A coleta e a análise automatizadas de métricas de desempenho, alertas e retreinamento de modelos são necessárias para manter a eficácia do modelo. Use a automação de uma forma que possa ajudá-lo a detetar alterações nos dados e nas dependências do modelo para obter uma compreensão clara do estado atual a qualquer momento.

Os modelos podem ser treinados com duas abordagens distintas.

- Os modelos são treinados no ambiente de desenvolvimento com dados completos de produção e apenas o artefato é promovido através de ambientes. Essa abordagem pode reduzir os custos computacionais, mas requer maior segurança para lidar com dados de produção em ambientes mais baixos e pode não ser possível em todas as organizações.

- O modelo é treinado em cada ambiente. A promoção de código pode ajudar na estabilidade porque o código de treinamento é revisado e testado nos ambientes inferiores, mas aumenta o custo de computação.

Cada uma destas abordagens tem os seus prós e contras. A escolha da abordagem certa depende das prioridades da sua organização e das práticas do Ciclo de Vida de Desenvolvimento de Software (SDLC) da sua organização. Independentemente do método, testes completos e avaliação do modelo antes da implantação da produção são essenciais

Seu código de automação deve incorporar linhagem de dados para dar suporte à auditabilidade , fornecendo um registro claro dos estágios de processamento de dados. Este registo ajuda-o a gerir as expectativas e permite-lhe demonstrar como as decisões foram tomadas para que possa abordar quaisquer preocupações sobre os resultados.

Pipelines de implementação

Em cargas de trabalho de IA/machine learning, o desenvolvimento de modelos envolve a criação, validação e promoção de modelos para modelar plataformas de hospedagem. É importante ter pipelines de implantação que simplifiquem fluxos de trabalho complexos relacionados ao processamento de dados, engenharia de recursos, treinamento ou aumento de modelos e implantação em produção. Dada a natureza não determinística da IA, que torna os processos opacos, você precisa incorporar testes qualitativos em pipelines de liberação e sistemas de monitoramento.

Embora MLOps e GenAIOps possam exigir atividades de IA distintas e as tecnologias centrais possam diferir, os conceitos subjacentes permanecem semelhantes aos do DevOps. Recomendamos que você aplique as práticas recomendadas de seus processos de DevOps existentes. Integre atividades de IA nos pipelines existentes da sua carga de trabalho.

Normalmente, as cargas de trabalho de IA envolvem implantações de código tradicionais. Você pode optar por lidar com a implantação do modelo ao lado do código ou separadamente em seu próprio ciclo de vida. A primeira abordagem é preferível. Esteja preparado para empacotar modelos e pontos de extremidade de inferência com implantação de carga de trabalho para manter as operações de IA focadas principalmente na preparação de dados, treinamento/ajuste fino, gerenciamento de dados de aterramento e monitoramento.

Reavalie como os seguintes ativos podem ser adaptados para cobrir todo o ciclo de vida de MLOps e GenAIOps, desde a pré-produção até a produção:

- Ferramentas de infraestrutura como código (IaC)

- Pipelines de CI/CD

- A pilha de observabilidade para rastrear e identificar problemas

Ferramentas

Você pode estender os fluxos de trabalho do Azure Pipelines e GitHub Actions, comumente usados para CI/CD, para modelos de aprendizado de máquina. Eles ajudam a implantar infraestrutura de aprendizado de máquina, componentes de carga de trabalho personalizados, código de orquestração e modelos. Combine pipelines do Azure Machine Learning com pipelines do Azure DevOps ou GitHub. Para obter mais informações, consulte Usar o Azure Pipelines com o Azure Machine Learning.

Dois fatores principais influenciam a sua escolha da combinação certa de ferramentas: caso de uso e recursos. Por exemplo, os pipelines do Azure Machine Learning são ótimos para a orquestração executada por cientistas de dados. Ele tem um rico conjunto de recursos que suporta reutilização, cache e muito mais. Para opções de ferramentas, consulte Qual tecnologia de pipeline do Azure devo usar?.

Manutenção do modelo

O cenário de IA/ML é competitivo com a inovação contínua. Novos modelos surgem com frequência, novos casos de uso são descobertos e novas fontes de dados ficam disponíveis. Como resultado, a decadência do modelo é um desafio comum.

Para evitar a degradação ou desvio do desempenho do modelo ao longo do tempo, você precisa implementar processos automatizados para monitoramento, avaliação e reciclagem contínuos. Por exemplo:

Manter um catálogo de modelos. Automatize o processo de descoberta de novos modelos e atualização do catálogo.

Adapte-se a novos casos de uso. À medida que novos casos de uso são adicionados aos requisitos de carga de trabalho, antecipe as consultas e ajuste sua lógica de processamento de dados de acordo.

Incorporar novas fontes de dados. Se novas fontes de dados puderem potencialmente aumentar o poder preditivo ou a relevância do seu modelo, atualize seu pipeline de ingestão de dados para se conectar e extrair dados dessas fontes.

Avalie a conformidade com os requisitos regulamentares. Ao se adaptar a novos recursos, certifique-se de que as alterações permaneçam válidas dentro das restrições dos padrões de conformidade organizacionais ou externos.

Implementar um processo formal para acompanhar a melhoria contínua e incorporar o autoaperfeiçoamento como um subprocesso dentro desse ciclo.

Evolução contínua

Rever e melhorar regularmente as operações e incentivar a inovação.

O modelo de maturidade MLOps progride de processos manuais para automação total. Comece com compilações e monitoramento manuais e incorpore compilações automatizadas de aplicativos, ambientes de treinamento e implantação em fases, conforme justificado por métricas abrangentes. Para obter mais informações, consulte Modelo de maturidade MLOps.

Os níveis de maturidade do GenAIOps passam de modelos básicos para implantação estruturada, usando progressivamente técnicas de otimização automatizada. Para obter mais informações, consulte Avançar seu nível de maturidade para GenAIOps.