IA responsável em cargas de trabalho do Azure

O objetivo da IA responsável na conceção da carga de trabalho é ajudar a garantir que a utilização de algoritmos de IA é justa, transparentee inclusivo. Os princípios de segurança do Microsoft Azure Well-Architected Framework estão inter-relacionados e se concentram na confidencialidade e na integridade. Devem existir medidas de segurança para manter a privacidade do utilizador, proteger os dados e salvaguardar a integridade do desenho ou modelo. O design não deve ser usado indevidamente para fins não intencionais.

Em cargas de trabalho de IA, os modelos geralmente usam lógica opaca para tomar decisões. Os usuários devem confiar na funcionalidade do sistema e se sentir confiantes de que os modelos tomam essas decisões de forma responsável. Comportamentos inaceitáveis, como manipulação, toxicidade de conteúdo, violação de IP e respostas fabricadas, devem ser evitados.

Considere um caso de uso em que uma empresa de entretenimento de mídia deseja fornecer recomendações usando modelos de IA. Se a empresa não implementar IA responsável e protocolos de segurança adequados, um agente mal-intencionado pode assumir o controle dos modelos. O modelo pode recomendar conteúdo que cause danos. Para a organização, esse comportamento pode resultar em danos à marca, ambientes inseguros e problemas legais. Portanto, manter uma vigilância adequada durante todo o ciclo de vida do sistema é essencial e inegociável.

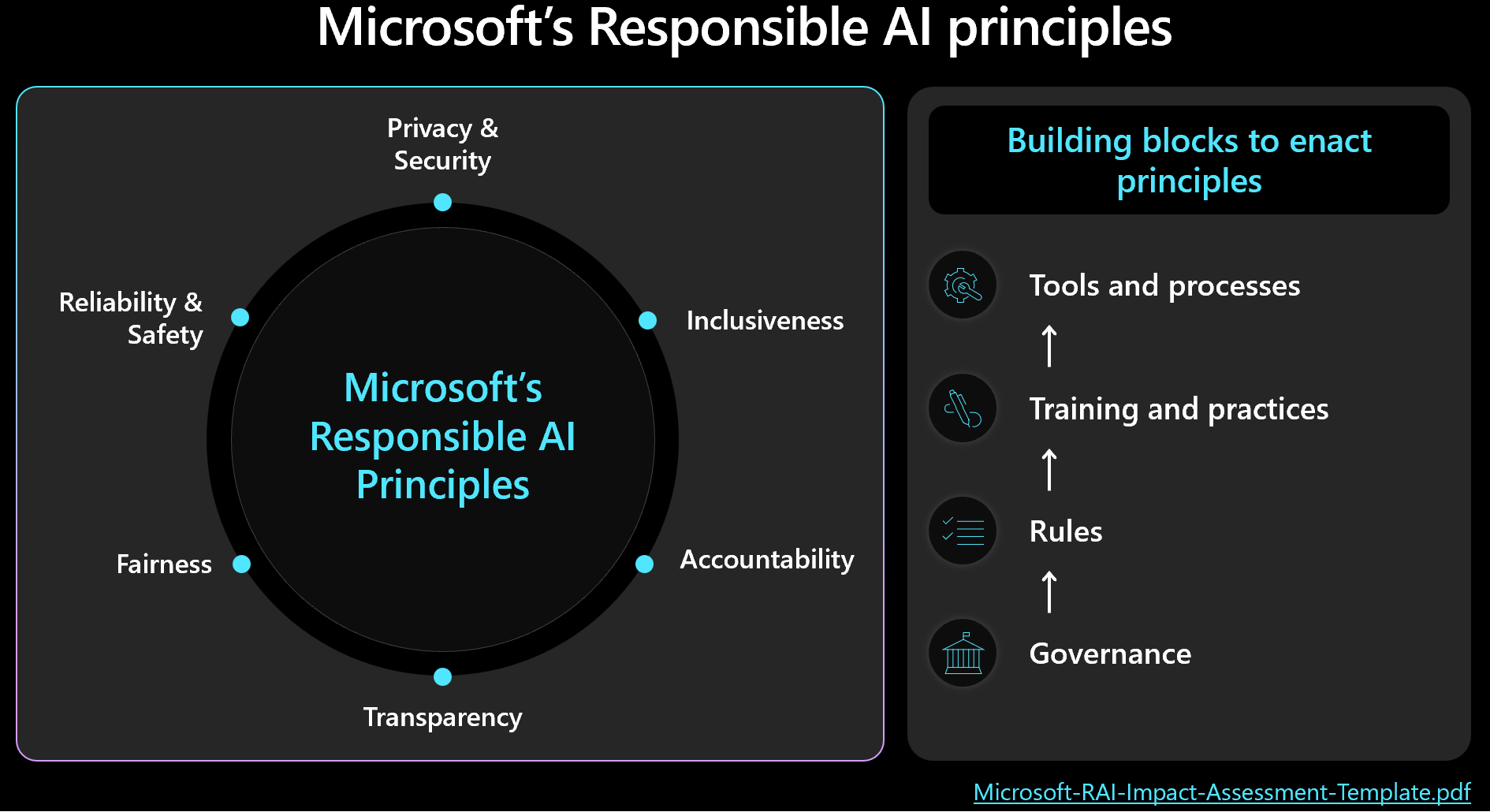

Você deve priorizar a segurança e o gerenciamento da carga de trabalho e ter em mente os resultados humanos ao tomar decisões de projeto. Familiarize-se com a estrutura da Microsoft para de IA responsável e garanta que você meça e implemente os princípios da estrutura em seu design. A imagem a seguir mostra os principais conceitos da estrutura.

Importante

A precisão das previsões e as métricas para uma IA responsável estão normalmente interligadas. Ao melhorar a precisão de um modelo, pode melhorar a sua equidade e alinhamento com a realidade. A IA responsável frequentemente se alinha com a precisão, mas a precisão por si só não inclui todas as considerações de segurança. É crucial validar estes princípios de forma responsável.

Este artigo fornece recomendações sobre a tomada de decisões responsáveis, validando a entrada do usuário e ajudando a garantir uma experiência segura do usuário. Ele também fornece orientação sobre segurança de dados para ajudar a proteger os dados do usuário.

Recomendações

A tabela a seguir resume as recomendações neste artigo.

| Recomendação | Description |

|---|---|

| Desenvolver políticas que apliquem práticas morais em cada etapa do ciclo de vida. | Inclua itens da lista de verificação que indiquem explicitamente os requisitos de segurança e sejam adaptados ao contexto da carga de trabalho. Os exemplos incluem transparência de dados do usuário, configuração de consentimento e procedimentos sobre como lidar com o direito a ser esquecido (RTBF). ▪ Desenvolva as suas políticas para uma IA responsável ▪ Reforçar a governação das políticas para uma IA responsável |

| Proteja os dados do usuário com o objetivo de maximizar a privacidade. | Recolher apenas o necessário e com o devido consentimento do utilizador. Aplique controles técnicos para proteger os perfis dos usuários, seus dados e o acesso a esses dados. ▪ Tratar os dados do utilizador de forma adequada ▪ Inspecionar dados de entrada e saída |

| Mantenha as decisões de IA claras e compreensíveis. | Explique claramente como funcionam os algoritmos de recomendação. Forneça aos usuários informações sobre o uso de dados e a tomada de decisões algorítmicas para ajudá-los a entender e confiar no processo. ▪ Torne a experiência do usuário segura |

Desenvolver políticas para uma IA responsável

Documente a sua abordagem à utilização responsável da IA. Indique explicitamente as políticas que você aplica em cada estágio do ciclo de vida para que a equipe de carga de trabalho entenda suas responsabilidades. Os padrões da Microsoft para IA responsável fornecem diretrizes, mas você deve definir o que essas diretrizes significam especificamente para o seu contexto.

Por exemplo, as políticas devem incluir itens de lista de verificação para mecanismos que suportem a transparência de dados do usuário e a configuração de consentimento. Idealmente, estes mecanismos deveriam permitir que os utilizadores optassem por não incluir dados. Pipelines de dados, análises, treinamento de modelos e outras etapas devem respeitar essa escolha. Outro exemplo são os procedimentos para lidar com o RTBF. Consulte o departamento de ética e a equipa jurídica da sua organização para tomar decisões informadas.

Crie políticas transparentes para o uso de dados e a tomada de decisões algorítmicas para ajudar os usuários a entender e confiar no processo. Documente essas decisões para manter um histórico claro de possíveis litígios futuros.

A implementação responsável da IA inclui três funções principais: a equipa de investigação, a equipa de políticas e a equipa de engenharia. A colaboração entre estas equipas deve ser operacionalizada. Se a sua organização já tiver uma equipa, utilize o seu trabalho. Caso contrário, estabeleça essas práticas você mesmo.

Cada equipa deve ter as suas próprias responsabilidades. Por exemplo:

A equipa de pesquisa conduz a descoberta de riscos consultando diretrizes organizacionais, padrões do setor, leis, regulamentos e táticas conhecidas da equipa red team.

A equipe de políticas desenvolve políticas específicas para a carga de trabalho. Eles incorporam diretrizes da organização-mãe e regulamentos governamentais.

A equipe de engenharia implementa as políticas em seus processos e entregas. A equipa valida e testa a adesão.

Cada equipe formaliza suas diretrizes, mas a equipe de carga de trabalho deve ser responsável por suas próprias práticas documentadas. A equipe deve documentar claramente quaisquer etapas extras ou desvios intencionais para garantir que não haja ambiguidade sobre o que é permitido. A equipe também deve ser transparente sobre quaisquer possíveis deficiências ou resultados inesperados na solução.

Reforçar a governação das políticas para uma IA responsável

Projete sua carga de trabalho para estar em conformidade com a governança organizacional e regulatória. Por exemplo, se a transparência for um requisito organizacional, determine como ela se aplica à sua carga de trabalho. Identifique áreas em seu design, ciclo de vida, código ou outros componentes onde você deve introduzir recursos de transparência para atender a esse padrão.

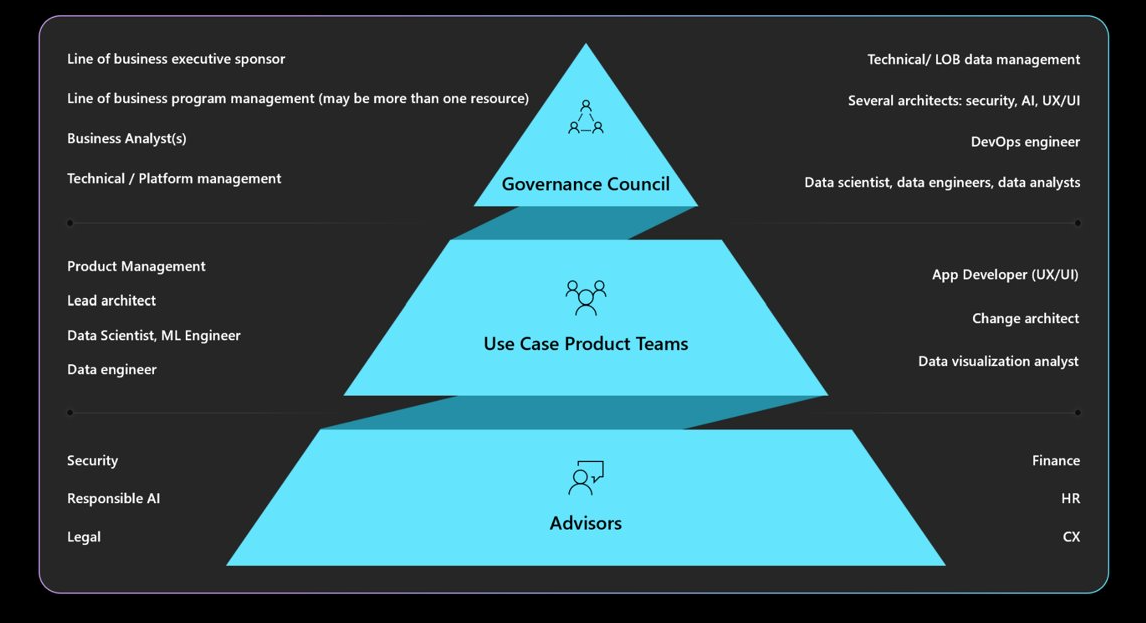

Compreenda a governança, a prestação de contas, os conselhos de revisão e os mandatos de relatórios necessários. Certifique-se de que seu conselho de governança aprove e assine projetos de carga de trabalho para evitar redesigns e mitigar preocupações de segurança ou privacidade. Talvez seja necessário passar por várias camadas de aprovação. O diagrama a seguir descreve uma estrutura de governança típica em uma organização.

Para obter mais informações sobre políticas organizacionais e aprovadores, consulte Definir uma estratégia de IA responsável.

Torne a experiência do usuário segura

As experiências dos utilizadores devem basear-se nas orientações da indústria. Use o Microsoft Human-AI Experiences Design Library, que inclui princípios e fornece diretrizes de implementação. Ele também fornece exemplos de produtos da Microsoft e outras fontes do setor.

Há responsabilidades de carga de trabalho ao longo do ciclo de vida da interação do usuário. Eles começam com a intenção de um usuário de usar o sistema e continuam durante uma sessão e durante quaisquer interrupções causadas por erros do sistema. Considere as seguintes práticas:

Construa transparência. Sensibilizar os utilizadores para a forma como o sistema gera respostas às suas consultas.

Inclua links para fontes de dados que o modelo consulta para previsões. Esta prática aumenta a confiança do utilizador, mostrando-lhe a origem da informação. A conceção de dados deve incluir estas fontes nos metadados. Por exemplo, quando o orquestrador em um aplicativo de recuperação aumentada executa uma pesquisa, ele recupera 20 partes de documento e envia as 10 partes principais para o modelo como contexto. Os 10 primeiros blocos pertencem a três documentos diferentes. A interface do usuário pode então fazer referência a esses três documentos de origem quando exibe a resposta do modelo. Essa transparência aumenta a confiança do usuário.

A transparência se torna mais importante quando você usa agentes, que atuam como intermediários entre interfaces front-end e sistemas back-end. Por exemplo, em um sistema de tíquetes, o código de orquestração interpreta a intenção do usuário e faz chamadas de interface de programação de aplicativo (API) para agentes para recuperar as informações necessárias. Expor essas interações ajuda a conscientizar o usuário sobre as ações do sistema.

Para fluxos de trabalho automatizados que incluem vários agentes, crie arquivos de log que registrem cada etapa. Os ficheiros de registo podem ajudá-lo a identificar e corrigir erros. Eles também dão aos usuários uma explicação para as decisões, o que operacionaliza a transparência.

Atenção

Ao implementar recomendações de transparência, evite sobrecarregar o usuário com muitas informações. Adote uma abordagem gradual usando métodos de interface do usuário minimamente perturbadores.

Por exemplo, exiba uma dica de ferramenta que mostre uma pontuação de confiança do modelo. Você pode incorporar links, como links para documentos de origem, que os usuários podem selecionar para obter mais detalhes. Esse método iniciado pelo usuário mantém a interface do usuário sem interrupções e permite que os usuários busquem mais informações somente se assim desejarem.

Recolha feedback. Implementar mecanismos de feedback.

Evite sobrecarregar os utilizadores com questionários extensos após cada resposta. Em vez disso, use mecanismos de feedback rápidos e simples, como polegares para cima ou polegares para baixo, ou um sistema de classificação para aspetos específicos da resposta em uma escala de 1 a 5. Esses métodos ajudam a melhorar o sistema ao longo do tempo e permitem feedback granular sem serem intrusivos. Esteja atento a possíveis problemas de equidade no feedback, pois pode haver razões secundárias por trás das respostas do usuário.

A implementação de um mecanismo de feedback afeta a arquitetura devido à necessidade de armazenamento de dados. Trate o feedback como dados do usuário e aplique níveis de controle de privacidade conforme necessário.

Além do feedback da resposta, colete feedback sobre a eficácia da experiência do usuário. Colete métricas de envolvimento através da sua pilha de monitoramento do sistema.

Operacionalizar as medidas de segurança de conteúdo

Integre a segurança de conteúdo em cada estágio do ciclo de vida da IA usando código de solução personalizado, ferramentas apropriadas e práticas de segurança eficazes. Considere as seguintes estratégias:

Anonimizar dados. À medida que os dados passam da ingestão para o treinamento ou avaliação, implemente verificações ao longo do caminho para minimizar o risco de vazamento de informações pessoais e evitar a exposição bruta de dados do usuário.

Conteúdo moderado. Use a API de segurança de conteúdo que avalia solicitações e respostas em tempo real. Certifique-se de que essas APIs estejam acessíveis.

Identificar e mitigar ameaças. Aplique práticas de segurança bem conhecidas aos seus cenários de IA. Por exemplo, conduza a modelagem de ameaças e, em seguida, documente as ameaças e como você as atenuou. Práticas de segurança típicas, como exercícios de equipe vermelha, aplicam-se a cargas de trabalho de IA. As equipas vermelhas podem testar se os modelos podem ser manipulados para gerar conteúdo nocivo. Estas atividades devem ser integradas nas operações de IA.

Para obter informações, consulte Plano de ataque simulado para grandes modelos de linguagem e as suas aplicações.

Use as métricas certas. Use métricas que meçam efetivamente o comportamento do modelo. As métricas variam dependendo do tipo de modelo de IA. Em alguns casos, a medição de modelos generativos pode não se aplicar a modelos de regressão. Por exemplo, um modelo prevê a expectativa de vida e os resultados afetam as taxas de seguro. As questões de equidade neste modelo podem resultar em danos relacionados com a equidade. Esse problema decorre de desvios nos testes de métricas principais porque as métricas de equidade e precisão normalmente estão interconectadas. Melhore a precisão para ajudar a reduzir os danos relacionados à equidade.

Adicione a instrumentação apropriada. Os resultados do modelo de IA devem ser explicáveis. Você precisa justificar e rastrear como as inferências são feitas, incluindo os dados de treinamento, as características calculadas e os dados de base. Na IA discriminativa, você pode justificar decisões passo a passo. No entanto, para modelos generativos, explicar os resultados pode ser complexo. Documentar o processo de tomada de decisão para abordar potenciais implicações legais e proporcionar transparência.

Você deve implementar esse aspeto de explicabilidade ao longo de todo o ciclo de vida da IA. Limpeza de dados, linhagem, critérios de seleção e processamento são etapas críticas onde as decisões devem ser rastreadas.

Ferramentas

Integre ferramentas para segurança de conteúdo e rastreabilidade de dados, como Microsoft Purview. As APIs de Segurança de Conteúdo da IA do Azure podem ser chamadas a partir do seu teste para facilitar os testes de segurança de conteúdo.

O Azure AI Foundry fornece métricas que avaliam o comportamento do modelo. Para obter mais informações, consulte Métricas de avaliação e monitoramento para IA generativa.

Para modelos de treinamento, consulte as métricas de que o Azure Machine Learning fornece.

Inspecionar dados de entrada e saída

Ataques de injeção imediata, como jailbreak, são uma preocupação comum para cargas de trabalho de IA. Nesse caso, alguns usuários podem tentar usar indevidamente o modelo para fins não intencionais. Para ajudar a garantir a segurança, inspeciona dados para evitar ataques e filtra conteúdo impróprio. Aplique essa análise à entrada do usuário e às respostas do sistema para ajudar a garantir uma moderação completa do conteúdo nos fluxos de entrada e saída.

Em alguns casos, você precisa fazer várias invocações de modelo, como por meio do Serviço Azure OpenAI, para atender a uma única solicitação de cliente. Nesses cenários, aplicar verificações de segurança de conteúdo a cada chamada pode ser caro e desnecessário. Considere centralizar esse trabalho na arquitetura, mantendo a segurança como uma responsabilidade do lado do servidor. Suponha que uma arquitetura tenha um gateway na frente do ponto de extremidade de inferência do modelo para descarregar recursos de back-end específicos. Você pode projetar esse gateway para lidar com verificações de segurança de conteúdo para solicitações e respostas que o back-end pode não suportar nativamente. Embora um gateway seja uma solução comum, uma camada de orquestração pode lidar com essas tarefas de forma eficaz em arquiteturas mais simples. Em ambos os casos, você pode aplicar seletivamente essas verificações quando necessário, o que otimiza o desempenho e o custo.

As inspeções devem ser multimodais e abranger vários formatos. Quando você usa entradas multimodais, como imagens, é importante analisá-las em busca de mensagens ocultas que possam ser prejudiciais ou violentas. Essas mensagens podem não ser imediatamente visíveis, por isso exigem uma inspeção cuidadosa. Use ferramentas como APIs de segurança de conteúdo para essa finalidade.

Para ajudar a aplicar as políticas de privacidade e segurança de dados, inspecione os dados do usuário e os dados de aterramento para verificar a conformidade com as regulamentações de privacidade. Certifique-se de que os dados são limpos ou filtrados à medida que fluem pelo sistema. Por exemplo, os dados de conversas anteriores de suporte ao cliente podem servir como dados de base. Estes dados devem ser higienizados antes da reutilização.

Lidar com os dados do usuário adequadamente

As práticas responsáveis envolvem o tratamento cuidadoso da gestão de dados dos utilizadores. Esse gerenciamento inclui saber quando usar os dados e quando evitar depender dos dados do usuário.

Pratique a inferência sem compartilhar dados do usuário. Para compartilhar com segurança os dados do usuário com outras organizações para obter informações, use um modelo de câmara de compensação. Nesse cenário, as organizações fornecem dados a um parceiro confiável que treina o modelo usando os dados agregados. Então, todas as instituições podem usar esse modelo e compartilhar insights sem expor conjuntos de dados individuais. O objetivo é usar os recursos de inferência do modelo sem compartilhar dados detalhados de treinamento.

Promover a diversidade e a inclusão. Quando os dados do usuário forem necessários, use uma gama diversificada de dados, incluindo gêneros e criadores sub-representados, para mitigar os danos relacionados à equidade. Implemente recursos que incentivem os usuários a explorar conteúdo novo e variado. Monitore o uso continuamente e ajuste as recomendações para evitar a representação excessiva de qualquer tipo de conteúdo.

Respeite a RTBF. Evite usar dados do usuário sempre que possível. Ajude a garantir a conformidade com o RTBF, adotando as medidas necessárias para garantir que os dados do usuário sejam excluídos diligentemente.

Para ajudar a garantir a conformidade, pode haver solicitações para remover dados do usuário do sistema. Para modelos menores, você pode remover dados do usuário treinando novamente o modelo usando dados que excluem informações pessoais. Para modelos maiores, que podem consistir em vários modelos menores e treinados independentemente, o processo é mais complexo e o custo e o esforço são significativos. Procure orientação legal e ética sobre como lidar com essas situações e certifique-se de incluir a orientação em suas políticas de parade IA responsável.

Reter dados de forma responsável. Quando a eliminação de dados não for possível, obtenha o consentimento explícito do utilizador para a recolha de dados e forneça políticas de privacidade claras. Recolher e reter dados apenas quando for absolutamente necessário. Tenha operações para remover dados de forma agressiva quando eles não forem mais necessários. Por exemplo, limpe o histórico de bate-papo assim que possível e anonimize dados confidenciais antes da retenção. Use métodos avançados de criptografia para esses dados em repouso.

Apoie a explicabilidade. Trace decisões no sistema para dar suporte aos requisitos de explicabilidade. Desenvolver explicações claras sobre como funcionam os algoritmos de recomendação. Forneça aos usuários informações sobre por que um conteúdo específico é recomendado a eles. O objetivo é garantir que as cargas de trabalho de IA e seus resultados sejam transparentes e justificáveis, detalhando como tomam decisões, quais dados usam e como os modelos foram treinados.

Criptografar dados do usuário. Os dados de entrada devem ser criptografados em todos os estágios do pipeline de processamento de dados a partir do momento em que o usuário insere dados. Esses estágios incluem dados à medida que se movem de um ponto para outro, dados armazenados e dados inferidos, se necessário. Equilibre segurança e funcionalidade e procure manter dados privados durante todo o seu ciclo de vida.

Forneça controles de acesso robustos. Vários tipos de identidades podem potencialmente acessar dados do usuário. Implemente o controle de acesso baseado em função para o plano de controle e o plano de dados para que ele cubra a comunicação entre usuários e sistemas.

Mantenha uma segmentação de usuários adequada para proteger a privacidade. Por exemplo, o Microsoft 365 Copilot pode pesquisar e fornecer respostas com base em documentos e e-mails específicos de um usuário, garantindo que apenas o conteúdo relevante para esse usuário seja acessado.

Reduza a área de superfície. Uma estratégia fundamental do pilar Segurança do Well-Architected Framework é minimizar a superfície de ataque e fortalecer os recursos. Você deve aplicar essa estratégia às práticas padrão de segurança de endpoints, controlando rigorosamente os pontos de extremidade da API, expondo apenas dados essenciais e evitando informações estranhas nas respostas. Equilibre a escolha de design entre flexibilidade e controlo.

Certifique-se de que não existem pontos de extremidade anónimos. Em geral, evite dar aos usuários mais controle do que o necessário. Na maioria dos cenários, os usuários não precisam ajustar hiperparâmetros, exceto em ambientes experimentais. Para casos de uso típicos, como interagir com um agente virtual, os usuários devem controlar apenas aspetos essenciais para ajudar a garantir a segurança, limitando o controle desnecessário.

Para obter mais informações, consulte Design de aplicativos para cargas de trabalho de IA no Azure.