Guia de início rápido: criar um trabalho do Stream Analytics usando o Azure PowerShell

O módulo do Azure PowerShell é usado para criar e gerenciar recursos do Azure usando cmdlets ou scripts do PowerShell. Este guia de início rápido mostra como usar o módulo do Azure PowerShell para implantar e executar um trabalho do Azure Stream Analytics.

O trabalho de exemplo lê dados de streaming de um dispositivo do Hub IoT. Os dados de entrada são gerados por um simulador online do Raspberry Pi. O trabalho do Stream Analytics transforma os dados usando a linguagem de consulta do Stream Analytics para filtrar mensagens com temperatura superior a 27°. Em seguida, ele grava os eventos de saída resultantes em um arquivo em um armazenamento de blob.

Antes de começar

- Se não tiver uma subscrição do Azure, crie uma conta gratuita.

- Este início rápido requer o módulo do Azure PowerShell. Execute

Get-Module -ListAvailable Azpara localizar a versão instalada no computador local. Se precisar de instalar ou atualizar, veja Install Azure PowerShell module(Instalar o módulo do Azure PowerShell). - Algumas ações do Hub IoT não são suportadas pelo Azure PowerShell e devem ser concluídas usando a CLI do Azure versão 2.0.70 ou posterior e a extensão IoT para CLI do Azure. Instale a CLI do Azure e use

az extension add --name azure-iotpara instalar a extensão IoT.

Iniciar sessão no Azure

Entre na sua assinatura do Azure com o Connect-AzAccount comando e insira suas credenciais do Azure no navegador pop-up:

# Connect to your Azure account

Connect-AzAccount

Se você tiver mais de uma assinatura, selecione a assinatura que deseja usar para este início rápido executando os cmdlets a seguir. Certifique-se de que substitui <your subscription name> pelo nome da sua subscrição:

# List all available subscriptions.

Get-AzSubscription

# Select the Azure subscription you want to use to create the resource group and resources.

Get-AzSubscription -SubscriptionName "<your subscription name>" | Select-AzSubscription

Criar um grupo de recursos

Crie um grupo de recursos do Azure com New-AzResourceGroup. Um grupo de recursos é um contentor lógico no qual os recursos do Azure são implementados e geridos.

$resourceGroup = "StreamAnalyticsRG"

$location = "WestUS2"

New-AzResourceGroup `

-Name $resourceGroup `

-Location $location

Preparar os dados de entrada

Antes de definir o trabalho do Stream Analytics, prepare os dados configurados como entrada do mesmo.

O seguinte bloco de código da CLI do Azure tem muitos comandos para preparar os dados de entrada exigidos pelo trabalho. Analise as seções a seguir para entender o código.

Na janela do PowerShell, execute o

az logincomando para entrar na sua conta do Azure.Quando você entra com êxito, a CLI do Azure retorna uma lista de suas assinaturas. Copie a assinatura que você está usando para este início rápido e execute o

az account setcomando para selecionar essa assinatura. Escolha a mesma assinatura selecionada na seção anterior com o PowerShell. Certifique-se de substituir<your subscription name>pelo nome da sua assinatura.az login az account set --subscription "<your subscription>"Crie um Hub IoT usando o

az iot hub createcomando. Este exemplo cria um Hub IoT chamado MyASAIoTHub. Como os nomes do Hub IoT são exclusivos, você precisa criar seu próprio nome para o Hub IoT. Defina o SKU como F1 para usar o nível gratuito se ele estiver disponível com sua assinatura. Caso contrário, escolha o próximo nível mais baixo.az iot hub create --name "MyASAIoTHub" --resource-group $resourceGroup --sku S1Depois que o hub IoT tiver sido criado, obtenha a cadeia de conexão do Hub IoT usando o comando az iot hub connection-string show . Copie toda a cadeia de conexão e salve-a. Você precisa dele quando adiciona o Hub IoT como uma entrada ao seu trabalho do Stream Analytics.

az iot hub connection-string show --resource-group $resourceGroup --hub-name "MyASAIoTHub"Adicione um dispositivo ao Hub IoT usando o

az iot hub device-identity createcomando. Este exemplo cria um dispositivo chamado MyASAIoTDevice.az iot hub device-identity create --resource-group $resourceGroup --hub-name "MyASAIoTHub" --device-id "MyASAIoTDevice"Obtenha a cadeia de conexão do dispositivo usando o

az iot hub device-identity connection-string showcomando. Copie toda a cadeia de conexão e salve-a para quando criar o simulador do Raspberry Pi.az iot hub device-identity connection-string show --resource-group $resourceGroup --hub-name "MyASAIoTHub" --device-id "MyASAIoTDevice" --output tableExemplo de saída:

HostName=MyASAIoTHub.azure-devices.net;DeviceId=MyASAIoTDevice;SharedAccessKey=a2mnUsg52+NIgYudxYYUNXI67r0JmNubmfVafojG8=

Criar armazenamento de blob

O seguinte bloco de código do Azure PowerShell usa comandos para criar armazenamento de blob que é usado para saída de trabalho. Reveja as secções para compreender o código.

Crie uma conta de armazenamento padrão de uso geral usando o cmdlet New-AzStorageAccount . Este exemplo cria uma conta de armazenamento chamada myasaquickstartstorage com LRS (armazenamento com redundância local) e criptografia de blob (habilitada por padrão).

Obtenha o contexto da conta de armazenamento

$storageAccount.Contextque define a conta de armazenamento a ser utilizada. Ao trabalhar com contas de armazenamento, referencia o contexto em vez de fornecer repetidamente as credenciais.Crie um contêiner de armazenamento usando New-AzStorageContainer.

Copie a chave de armazenamento que é saída pelo código e salve essa chave para criar a saída do trabalho de streaming mais tarde.

$storageAccountName = "myasaquickstartstorage" $storageAccount = New-AzStorageAccount ` -ResourceGroupName $resourceGroup ` -Name $storageAccountName ` -Location $location ` -SkuName Standard_LRS ` -Kind Storage $ctx = $storageAccount.Context $containerName = "container1" New-AzStorageContainer ` -Name $containerName ` -Context $ctx $storageAccountKey = (Get-AzStorageAccountKey ` -ResourceGroupName $resourceGroup ` -Name $storageAccountName).Value[0] Write-Host "The <storage account key> placeholder needs to be replaced in your output json files with this key value:" Write-Host $storageAccountKey -ForegroundColor Cyan

Criar uma tarefa do Stream Analytics

Crie um trabalho do Stream Analytics com o cmdlet New-AzStreamAnalyticsJob . Este cmdlet usa o nome do trabalho, o nome do grupo de recursos, o local e o nome da sku como parâmetros. O nome do trabalho pode ser qualquer nome amigável que o identifique. Pode ter caracteres alfanuméricos, hífenes e sublinhados apenas e deve ter entre 3 e 63 caracteres.

Execute o New-AzStreamAnalyticsJob cmdlet.

$jobName = "MyStreamingJob"

New-AzStreamAnalyticsJob `

-ResourceGroupName $resourceGroup `

-Name $jobName `

-Location centralus `

-SkuName Standard

Configurar a entrada da tarefa

Adicione uma entrada ao seu trabalho usando o cmdlet New-AzStreamAnalyticsInput . Este cmdlet utiliza o nome da tarefa, o nome da entrada da tarefa, o nome do grupo de recursos e a definição de entrada da tarefa como parâmetros. A definição da entrada do trabalho é um ficheiro JSON que contém as propriedades necessárias para configurar essa entrada. Neste exemplo, você cria um armazenamento de blob como uma entrada.

No computador local, crie um ficheiro denominado JobInputDefinition.json e adicione os seguintes dados JSON ao mesmo.

Importante

- Substitua

accesspolicykeySharedAccessKeypela parte da cadeia de conexão do Hub IoT salva em uma seção anterior. - Se você usou um nome diferente para o hub IoT, atualize o valor para

iotHubNamespace.

{

"properties": {

"type": "Stream",

"datasource": {

"type": "Microsoft.Devices/IotHubs",

"properties": {

"iotHubNamespace": "MyASAIoTHub",

"sharedAccessPolicyName": "iothubowner",

"sharedAccessPolicyKey": "accesspolicykey",

"endpoint": "messages/events",

"consumerGroupName": "$Default"

}

},

"compression": {

"type": "None"

},

"serialization": {

"type": "Json",

"properties": {

"encoding": "UTF8"

}

}

},

"name": "IoTHubInput",

"type": "Microsoft.StreamAnalytics/streamingjobs/inputs"

}

Defina a $jobInputDefinitionFile variável PowerShell para o caminho onde você armazenou o arquivo JSON de definição de entrada de trabalho.

$jobInputDefinitionFile = "C:\JobInputDefinition.json"

Em seguida, execute o New-AzStreamAnalyticsInput cmdlet para criar uma entrada do Hub IoT do Azure para o trabalho do Stream Analytics.

$jobInputName = "IoTHubInput"

New-AzStreamAnalyticsInput `

-ResourceGroupName $resourceGroup `

-JobName $jobName `

-File $jobInputDefinitionFile `

-Name $jobInputName

Configurar a saída da tarefa

Adicione uma saída ao seu trabalho usando o cmdlet New-AzStreamAnalyticsOutput . Este cmdlet utiliza o nome da tarefa, o nome da saída da tarefa, o nome do grupo de recursos e a definição de saída da tarefa como parâmetros. A definição da saída do trabalho é um ficheiro JSON que contém as propriedades necessárias para configurar essa saída. Este exemplo utiliza o armazenamento de blobs como saída.

No computador local, crie um ficheiro denominado JobOutputDefinition.json e adicione os seguintes dados JSON ao mesmo.

Importante

Substitua o valor for accountKey pela chave de acesso da sua conta de armazenamento que é o valor armazenado no $storageAccountKey valor.

{

"properties": {

"datasource": {

"type": "Microsoft.Storage/Blob",

"properties": {

"storageAccounts": [

{

"accountName": "asaquickstartstorage",

"accountKey": "<storage account key>"

}

],

"container": "container1",

"pathPattern": "output/",

"dateFormat": "yyyy/MM/dd",

"timeFormat": "HH"

}

},

"serialization": {

"type": "Json",

"properties": {

"encoding": "UTF8",

"format": "LineSeparated"

}

}

},

"name": "BlobOutput",

"type": "Microsoft.StreamAnalytics/streamingjobs/outputs"

}

Defina a $jobOutputDefinitionFile variável PowerShell para o caminho onde você armazenou o arquivo JSON de definição de saída de trabalho.

$jobOutputDefinitionFile = "C:\JobOutputDefinition.json"

Em seguida, execute o New-AzStreamAnalyticsOutput cmdlet para criar uma saída de Armazenamento de Blob do Azure para o trabalho do Stream Analytics.

$jobOutputName = "BlobOutput"

New-AzStreamAnalyticsOutput `

-ResourceGroupName $resourceGroup `

-JobName $jobName `

-File $jobOutputDefinitionFile `

-Name $jobOutputName

Definir a consulta de transformação

Adicione uma transformação ao seu trabalho usando o cmdlet New-AzStreamAnalyticsTransformation . Este cmdlet utiliza o nome da tarefa, o nome da transformação da tarefa, o nome do grupo de recursos e a definição de transformação da tarefa como parâmetros. No computador local, crie um ficheiro denominado JobTransformationDefinition.json e adicione os seguintes dados JSON ao mesmo. O ficheiro JSON contém um parâmetro de consulta que define a consulta de transformação:

{

"name":"MyTransformation",

"type":"Microsoft.StreamAnalytics/streamingjobs/transformations",

"properties":{

"streamingUnits":1,

"script":null,

"query":"SELECT * INTO BlobOutput FROM IoTHubInput WHERE Temperature > 27"

}

}

Execute novamente o cmdlet New-AzStreamAnalyticsTransformation.

$jobTransformationName = "MyJobTransformation"

$jobTransformationDefinitionFile = "C:\JobTransformationDefinition.json"

New-AzStreamAnalyticsTransformation `

-ResourceGroupName $resourceGroup `

-JobName $jobName `

-Query "SELECT * INTO BlobOutput FROM IoTHubInput WHERE Temperature > 27" `

-StreamingUnit 1 `

-Name $jobTransformationName

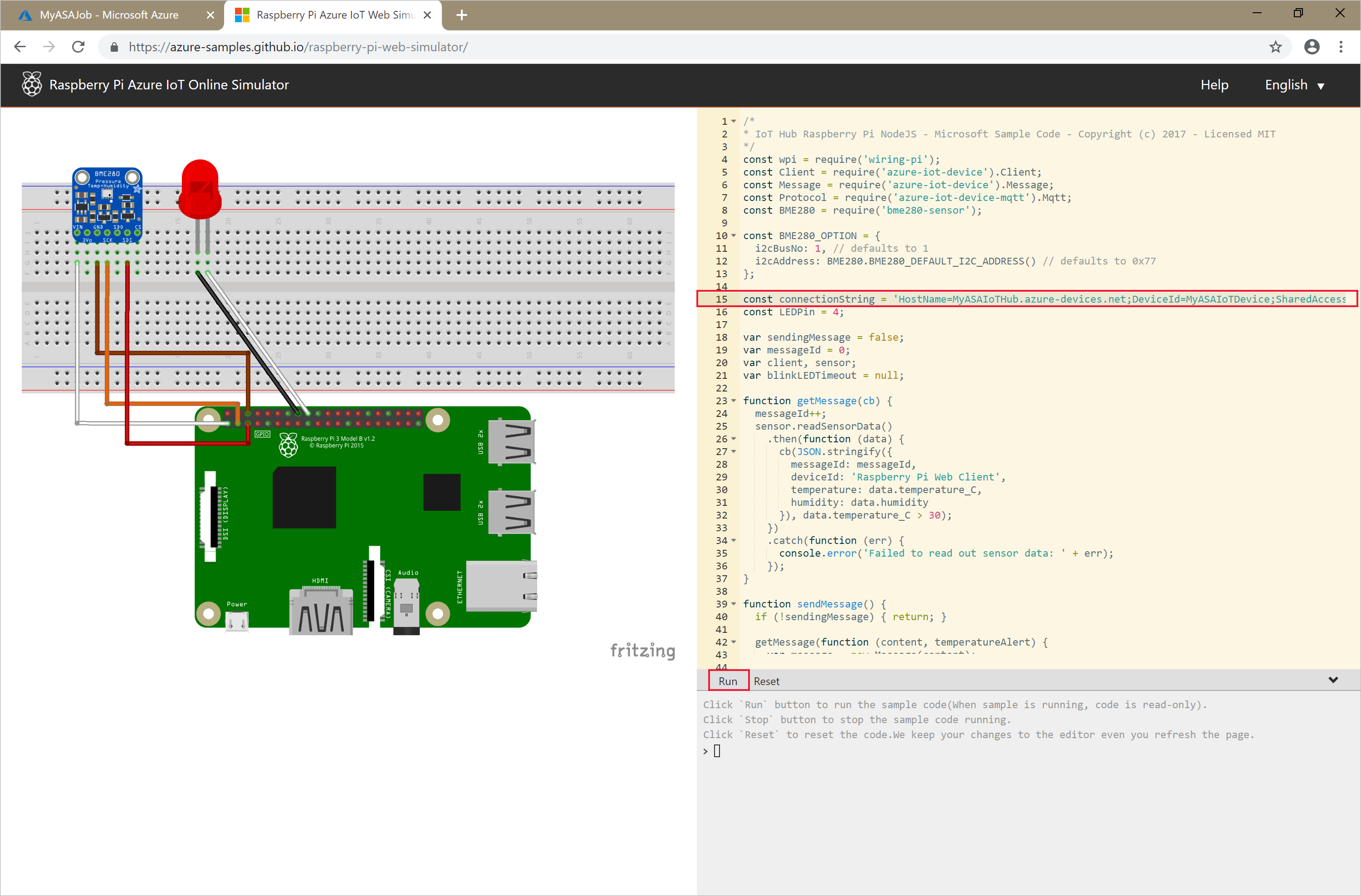

Execute o simulador de IoT

Abra o Simulador do Raspberry Pi Azure IoT Online.

Substitua o espaço reservado na Linha 15 por toda a cadeia de conexão do Dispositivo do Hub IoT do Azure que você salvou em uma seção anterior.

Clique em Executar. A saída deve mostrar os dados do sensor e as mensagens que estão sendo enviadas para o Hub IoT.

Iniciar a tarefa do Stream Analytics e verificar a saída

Inicie o trabalho usando o cmdlet Start-AzStreamAnalyticsJob . Este cmdlet utiliza o nome da tarefa, o nome do grupo de recursos, o modo de início da saída e a hora de início como parâmetros. OutputStartMode aceita os valores JobStartTimeCustomTime ou LastOutputEventTime. Para obter mais informações sobre ao que cada um destes valores se refere, veja a secção parameters (parâmetros) na documentação do PowerShell.

Depois de executar o cmdlet seguinte, devolve True como a saída, se o trabalho for iniciado. No contentor de armazenamento, é criada uma pasta de saída com os dados transformados.

Start-AzStreamAnalyticsJob `

-ResourceGroupName $resourceGroup `

-Name $jobName `

-OutputStartMode 'JobStartTime'

Clean up resources (Limpar recursos)

Quando já não for necessário, elimine o grupo de recursos, a tarefa de transmissão em fluxo e todos os recursos relacionados. A eliminação da tarefa evita a faturação das unidades de transmissão em fluxo consumidas pela tarefa. Se estiver a planear utilizar o trabalho no futuro, pode ignorar a eliminação e parar o trabalho por agora. Se você não quiser continuar a usar esse trabalho, exclua todos os recursos criados por este início rápido executando o seguinte cmdlet:

Remove-AzResourceGroup `

-Name $resourceGroup

Próximos passos

Neste início rápido, implementou uma tarefa simples do Stream Analytics com o PowerShell. Também pode implementar tarefas do Stream Analytics com o portal do Azure e o Visual Studio.

Para saber mais sobre como configurar outras origens de entrada e efetuar a deteção em tempo real, avance para o seguinte artigo: