Usar o modelo de aprendizado profundo do Microsoft Cognitive Toolkit com o cluster Azure HDInsight Spark

Neste artigo, você executa as etapas a seguir.

Execute um script personalizado para instalar o Microsoft Cognitive Toolkit em um cluster do Azure HDInsight Spark.

Carregue um Bloco de Anotações Jupyter no cluster do Apache Spark para ver como aplicar um modelo de aprendizado profundo treinado do Microsoft Cognitive Toolkit a arquivos em uma Conta de Armazenamento de Blob do Azure usando a API Python do Spark (PySpark)

Pré-requisitos

Um cluster do Apache Spark no HDInsight. Consulte Criar um cluster do Apache Spark.

Familiaridade com a utilização de Jupyter Notebooks com o Spark no HDInsight. Para obter mais informações, consulte Carregar dados e executar consultas com o Apache Spark no HDInsight.

Como flui esta solução?

Esta solução está dividida entre este artigo e um Jupyter Notebook que você carrega como parte deste artigo. Neste artigo, conclua as seguintes etapas:

- Execute uma ação de script em um cluster HDInsight Spark para instalar o Microsoft Cognitive Toolkit e pacotes Python.

- Carregue o Jupyter Notebook que executa a solução para o cluster HDInsight Spark.

As etapas restantes a seguir são abordadas no Jupyter Notebook.

- Carregue imagens de amostra em um conjunto de dados distribuído resiliente do Spark ou RDD.

- Carregue módulos e defina predefinições.

- Baixe o conjunto de dados localmente no cluster do Spark.

- Converta o conjunto de dados em um RDD.

- Classifique as imagens usando um modelo treinado do Kit de Ferramentas Cognitivas.

- Faça o download do modelo treinado do Kit de Ferramentas Cognitivas para o cluster do Spark.

- Defina funções a serem usadas pelos nós de trabalho.

- Classifique as imagens nos nós de trabalho.

- Avalie a precisão do modelo.

Instalar o Microsoft Cognitive Toolkit

Você pode instalar o Microsoft Cognitive Toolkit em um cluster do Spark usando a ação de script. A ação de script usa scripts personalizados para instalar componentes no cluster que não estão disponíveis por padrão. Você pode usar o script personalizado do portal do Azure, usando o SDK do HDInsight .NET ou o Azure PowerShell. Você também pode usar o script para instalar o kit de ferramentas como parte da criação do cluster ou depois que o cluster estiver instalado e em execução.

Neste artigo, usamos o portal para instalar o kit de ferramentas, após a criação do cluster. Para obter outras maneiras de executar o script personalizado, consulte Personalizar clusters HDInsight usando a Ação de Script.

Utilizar o portal do Azure

Para obter instruções sobre como usar o portal do Azure para executar ações de script, consulte Personalizar clusters HDInsight usando a Ação de Script. Certifique-se de fornecer as seguintes entradas para instalar o Microsoft Cognitive Toolkit. Use os seguintes valores para sua ação de script:

| Property | valor |

|---|---|

| Tipo de script | - Personalizado |

| Nome | Instalar o MCT |

| Bash script URI | https://raw.githubusercontent.com/Azure-Samples/hdinsight-pyspark-cntk-integration/master/cntk-install.sh |

| Tipo(s) de nó(s): | Chefe, Trabalhador |

| Parâmetros | Nenhuma |

Carregar o Jupyter Notebook no cluster do Azure HDInsight Spark

Para usar o Microsoft Cognitive Toolkit com o cluster do Azure HDInsight Spark, você deve carregar o Jupyter Notebook CNTK_model_scoring_on_Spark_walkthrough.ipynb no cluster do Azure HDInsight Spark. Este notebook está disponível no GitHub em https://github.com/Azure-Samples/hdinsight-pyspark-cntk-integration.

Faça o download e descompacte https://github.com/Azure-Samples/hdinsight-pyspark-cntk-integration.

Em um navegador da Web, navegue até

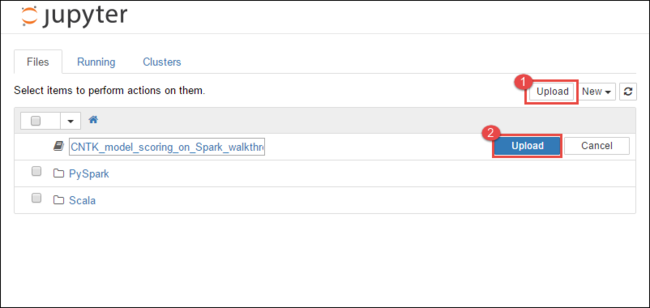

https://CLUSTERNAME.azurehdinsight.net/jupyter, ondeCLUSTERNAMEé o nome do cluster.No Jupyter Notebook, selecione Carregar no canto superior direito e, em seguida, navegue até o download e selecione o arquivo

CNTK_model_scoring_on_Spark_walkthrough.ipynb.

Selecione Carregar novamente.

Depois que o bloco de anotações for carregado, clique no nome do bloco de anotações e siga as instruções no próprio bloco de anotações sobre como carregar o conjunto de dados e executar o artigo.

Consulte também

Cenários

- Apache Spark com BI: execute análise de dados interativa usando o Spark no HDInsight com ferramentas de BI

- Apache Spark com Machine Learning: use o Spark no HDInsight para analisar a temperatura do edifício usando dados de HVAC

- Apache Spark com Machine Learning: use o Spark no HDInsight para prever resultados de inspeção de alimentos

- Análise de log do site usando o Apache Spark no HDInsight

- Análise de dados de telemetria do Application Insight usando o Apache Spark no HDInsight

Criar e executar aplicações

- Criar uma aplicação autónoma com o Scala

- Executar trabalhos remotamente em um cluster Apache Spark usando o Apache Livy

Ferramentas e extensões

- Utilizar o Plug-in das Ferramentas do HDInsight para o IntelliJ IDEA para criar e submeter aplicações do Spark Scala

- Use o plug-in HDInsight Tools para IntelliJ IDEA para depurar aplicativos Apache Spark remotamente

- Usar blocos de anotações Apache Zeppelin com um cluster Apache Spark no HDInsight

- Kernels disponíveis para o Jupyter Notebook no cluster Apache Spark para HDInsight

- Use pacotes externos com o Jupyter Notebooks

- Instalar o Jupyter no computador e ligar a um cluster do Spark do HDInsight