Gestão da postura de segurança da IA

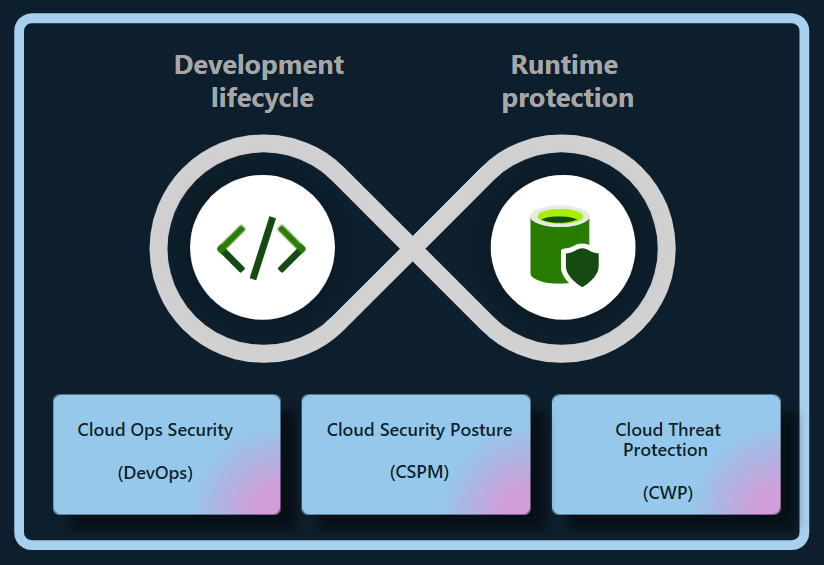

O plano Defender Cloud Security Posture Management (CSPM) no Microsoft Defender for Cloud fornece recursos de gerenciamento de postura de segurança de IA que protegem aplicativos de IA generativos criados pela empresa, em nuvem múltipla ou híbrida (atualmente Azure e AWS), durante todo o ciclo de vida do aplicativo. O Defender for Cloud reduz o risco de cargas de trabalho de IA entre nuvens ao:

- Descobrindo a lista de materiais de IA generativa (AI BOM), que inclui componentes de aplicativos, dados e artefatos de IA do código para a nuvem.

- Fortalecer a postura de segurança de aplicativos de IA generativa com recomendações integradas e explorando e remediando riscos de segurança.

- Usando a análise de caminho de ataque para identificar e remediar riscos.

Importante

Para habilitar os recursos de gerenciamento de postura de segurança de IA em uma conta da AWS que:

- Está ligado à sua conta do Azure.

- Tem o Defender CSPM ativado.

- Tem o tipo de permissões definido como Acesso com privilégios mínimos.

Você deve reconfigurar as permissões nesse conector para habilitar as permissões relevantes usando estas etapas:

- No Portal do Azure, navegue até a página Configurações de ambiente e selecione o conector da AWS apropriado.

- Selecione Configurar acesso.

- Verifique se o tipo de permissões está definido como Acesso com privilégios mínimos.

- Siga os passos 5 a 8 para concluir a configuração.

Descubra aplicativos de IA generativos

O Defender for Cloud descobre cargas de trabalho de IA e identifica detalhes da lista técnica de IA da sua organização. Essa visibilidade permite identificar e abordar vulnerabilidades e proteger aplicativos generativos de IA contra ameaças potenciais.

O Defenders for Cloud descobre automaticamente e continuamente cargas de trabalho de IA implantadas nos seguintes serviços:

- Azure OpenAI Service

- Azure Machine Learning

- Substrato rochoso amazônico

O Defender for Cloud também pode descobrir vulnerabilidades dentro de dependências de bibliotecas de IA generativas, como TensorFlow, PyTorch e Langchain, verificando o código-fonte em busca de configurações incorretas de Infraestrutura como Código (IaC) e imagens de contêiner em busca de vulnerabilidades. Atualizar ou corrigir regularmente as bibliotecas pode evitar exploits, protegendo aplicativos generativos de IA e mantendo sua integridade.

Com esses recursos, o Defender for Cloud oferece visibilidade total das cargas de trabalho de IA do código para a nuvem.

Reduza os riscos para aplicativos de IA generativa

O Defender CSPM fornece informações contextuais sobre a postura de segurança de IA de uma organização. Você pode reduzir os riscos em suas cargas de trabalho de IA usando recomendações de segurança e análise de caminho de ataque.

Explore os riscos usando recomendações

O Defender for Cloud avalia cargas de trabalho de IA e emite recomendações sobre identidade, segurança de dados e exposição à Internet para identificar e priorizar problemas críticos de segurança em cargas de trabalho de IA.

Detetar configurações incorretas do IaC

A segurança do DevOps deteta configurações incorretas do IaC, que podem expor aplicativos generativos de IA a vulnerabilidades de segurança, como controles de acesso superexpostos ou serviços publicamente expostos inadvertidos. Essas configurações incorretas podem levar a violações de dados, acesso não autorizado e problemas de conformidade, especialmente ao lidar com regulamentos rígidos de privacidade de dados.

O Defender for Cloud avalia a configuração de seus aplicativos de IA generativos e fornece recomendações de segurança para melhorar a postura de segurança de IA.

As configurações incorretas detetadas devem ser corrigidas no início do ciclo de desenvolvimento para evitar problemas mais complexos mais tarde.

As verificações de segurança atuais do IaC AI incluem:

- Usar pontos de extremidade privados do Serviço Azure AI

- Restringir pontos de extremidade do Serviço de IA do Azure

- Usar a identidade gerenciada para contas de serviço do Azure AI

- Usar autenticação baseada em identidade para Contas de Serviço do Azure AI

Explore os riscos com a análise do caminho de ataque

A análise de caminhos de ataque deteta e mitiga riscos para cargas de trabalho de IA, particularmente durante os estágios de aterramento (vinculando modelos de IA a dados específicos) e ajuste fino (ajuste de um modelo pré-treinado em um conjunto de dados específico para melhorar seu desempenho em uma tarefa relacionada), onde os dados podem ser expostos.

Ao monitorar cargas de trabalho de IA continuamente, a análise do caminho de ataque pode identificar fraquezas e vulnerabilidades potenciais e seguir com recomendações. Além disso, ele se estende aos casos em que os dados e os recursos de computação são distribuídos pelo Azure, AWS e GCP.