Transformar dados usando a atividade do Hadoop Hive no Azure Data Factory ou no Synapse Analytics

APLICA-SE A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

A atividade do Hive do HDInsight em um pipeline do Azure Data Factory ou do Synapse Analytics executa consultas do Hive por conta própria ou sob demanda. Este artigo baseia-se no artigo de atividades de transformação de dados, que apresenta uma visão geral da transformação de dados e das atividades de transformação suportadas.

Se você é novo no Azure Data Factory e no Synapse Analytics, leia os artigos de introdução do Azure Data Factory ou do Synapse Analytics e faça o Tutorial: transformar dados antes de ler este artigo.

Adicionar uma atividade do Hive do HDInsight a um pipeline com a interface do usuário

Para usar uma atividade do HDInsight Hive para o Azure Data Lake Analytics em um pipeline, conclua as seguintes etapas:

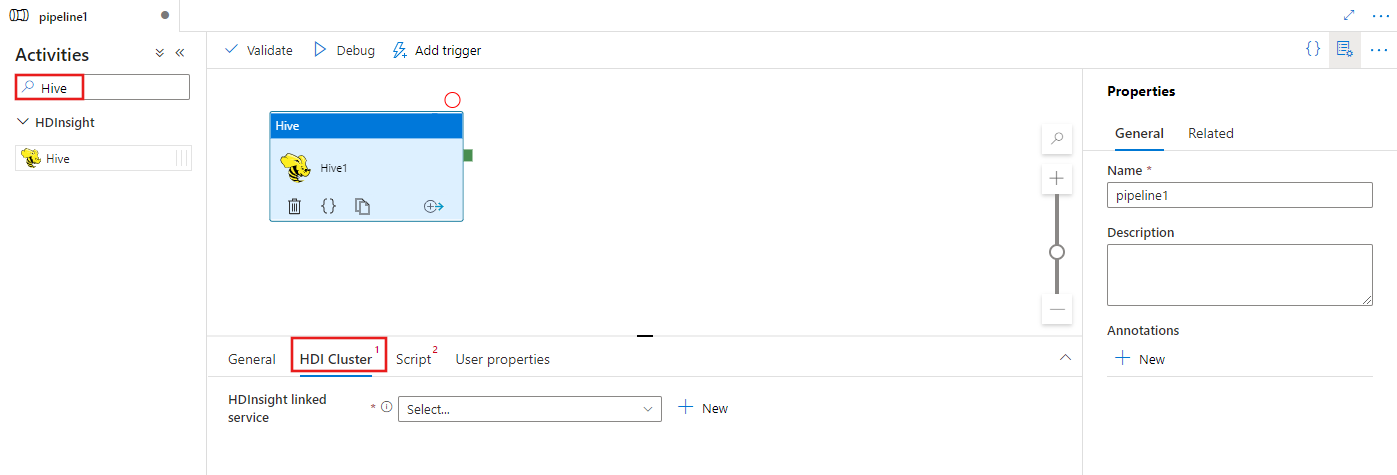

Procure Hive no painel Atividades do pipeline e arraste uma atividade do Hive para a tela do pipeline.

Selecione a nova atividade do Hive na tela, se ainda não estiver selecionada.

Selecione a guia Cluster HDI para selecionar ou criar um novo serviço vinculado a um cluster HDInsight que será usado para executar a atividade do Hive.

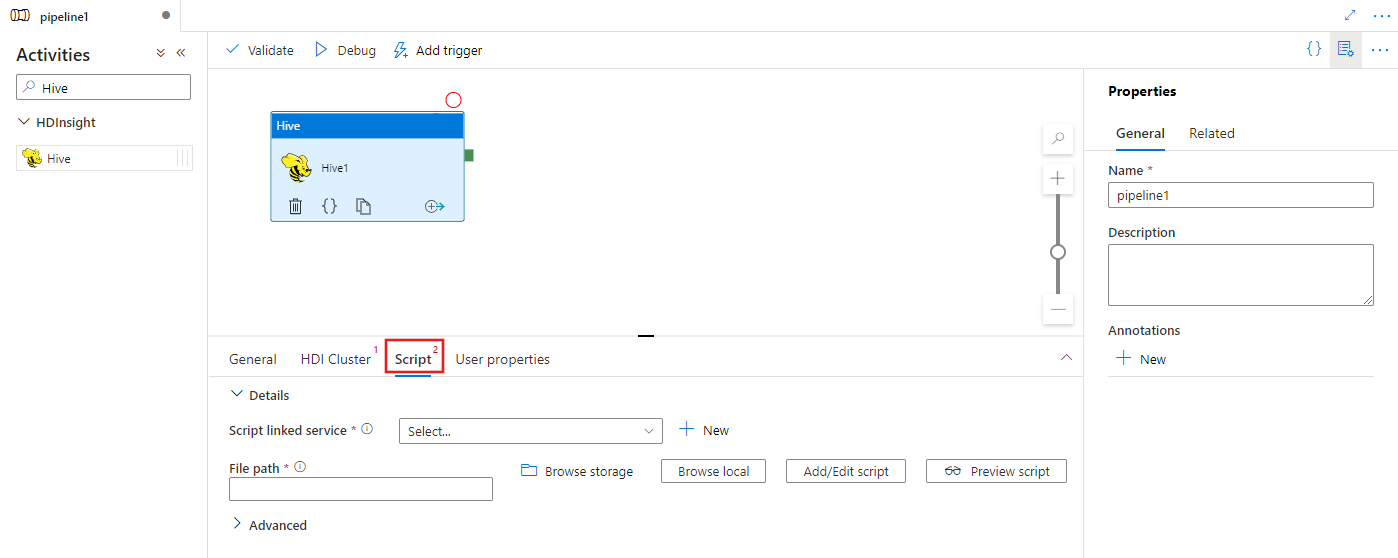

Selecione a guia Script para selecionar ou criar um novo serviço vinculado de armazenamento e um caminho dentro do local de armazenamento, que hospedará o script.

Sintaxe

{

"name": "Hive Activity",

"description": "description",

"type": "HDInsightHive",

"linkedServiceName": {

"referenceName": "MyHDInsightLinkedService",

"type": "LinkedServiceReference"

},

"typeProperties": {

"scriptLinkedService": {

"referenceName": "MyAzureStorageLinkedService",

"type": "LinkedServiceReference"

},

"scriptPath": "MyAzureStorage\\HiveScripts\\MyHiveScript.hql",

"getDebugInfo": "Failure",

"arguments": [

"SampleHadoopJobArgument1"

],

"defines": {

"param1": "param1Value"

}

}

}

Detalhes da sintaxe

| Property | Descrição | Obrigatório |

|---|---|---|

| nome | Nome da atividade | Sim |

| descrição | Texto que descreve para que serve a atividade | Não |

| tipo | Para Hive Activity, o tipo de atividade é HDinsightHive | Sim |

| linkedServiceName | Referência ao cluster HDInsight registrado como um serviço vinculado. Para saber mais sobre esse serviço vinculado, consulte o artigo Serviços vinculados de computação. | Sim |

| scriptLinkedService | Referência a um Serviço Vinculado de Armazenamento do Azure usado para armazenar o script do Hive a ser executado. Somente o Armazenamento de Blobs do Azure e os serviços vinculados ADLS Gen2 são suportados aqui. Se você não especificar esse Serviço Vinculado, o Serviço Vinculado de Armazenamento do Azure definido no Serviço Vinculado do HDInsight será usado. | Não |

| scriptPath | Forneça o caminho para o arquivo de script armazenado no Armazenamento do Azure referido por scriptLinkedService. O nome do arquivo diferencia maiúsculas de minúsculas. | Sim |

| getDebugInfo | Especifica quando os arquivos de log são copiados para o Armazenamento do Azure usado pelo cluster HDInsight (ou) especificado pelo scriptLinkedService. Valores permitidos: Nenhum, Sempre ou Falha. Valor padrão: Nenhum. | Não |

| Argumentos | Especifica uma matriz de argumentos para um trabalho Hadoop. Os argumentos são passados como argumentos de linha de comando para cada tarefa. | Não |

| define | Especifique parâmetros como pares chave/valor para referência dentro do script Hive. | Não |

| queryTimeout | Valor de tempo limite de consulta (em minutos). Aplicável quando o cluster HDInsight está com o Pacote de Segurança Empresarial ativado. | Não |

Nota

O valor padrão para queryTimeout é 120 minutos.

Conteúdos relacionados

Consulte os seguintes artigos que explicam como transformar dados de outras maneiras: