Ponto de extremidade de inferência de modelo nos Serviços de IA do Azure

A inferência de modelo de IA do Azure nos serviços de IA do Azure permite que os clientes consumam os modelos mais poderosos de provedores de modelos principais usando um único ponto de extremidade e credenciais. Isso significa que você pode alternar entre modelos e consumi-los do seu aplicativo sem alterar uma única linha de código.

O artigo explica como os modelos são organizados dentro do serviço e como usar o ponto de extremidade de inferência para invocá-los.

Implementações

A inferência de modelo de IA do Azure disponibiliza modelos usando o conceito de implantação . As implantações são uma maneira de dar um nome a um modelo em determinadas configurações. Em seguida, você pode invocar essa configuração de modelo indicando seu nome em suas solicitações.

Captura de implantações:

- Um nome de modelo

- Uma versão do modelo

- Um tipode provisionamento/capacidade 1

- Uma configuraçãode filtragem de conteúdo 1

- Uma configuraçãolimitadora de taxa 1

1 As configurações podem variar dependendo do modelo selecionado.

Um recurso de serviços de IA do Azure pode ter quantas implantações de modelo forem necessárias e elas não incorrem em custo, a menos que a inferência seja executada para esses modelos. As implantações são recursos do Azure e, portanto, estão sujeitas às políticas do Azure.

Para saber mais sobre como criar implantações, consulte Adicionar e configurar implantações de modelo.

Ponto de extremidade de inferência da IA do Azure

O ponto de extremidade de inferência da IA do Azure permite que os clientes usem um único ponto de extremidade com a mesma autenticação e esquema para gerar inferência para os modelos implantados no recurso. Este ponto de extremidade segue a API de inferência de modelo de IA do Azure que todos os modelos na inferência de modelo de IA do Azure suportam. Suporta as seguintes modalidades:

- Incorporações de texto

- Incorporação de imagens

- Conclusão do chat

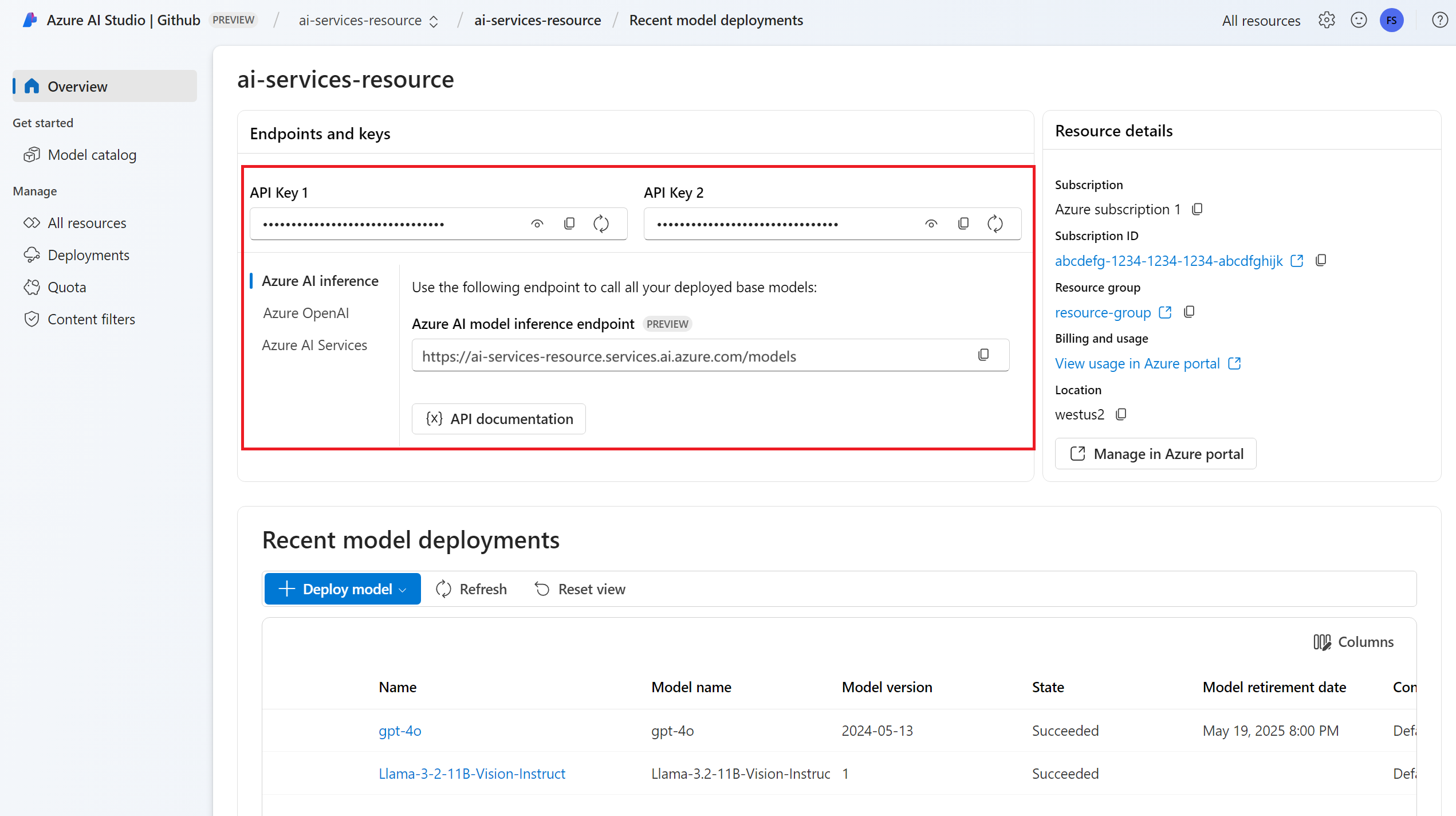

Você pode ver a URL e as credenciais do ponto de extremidade na seção Visão geral :

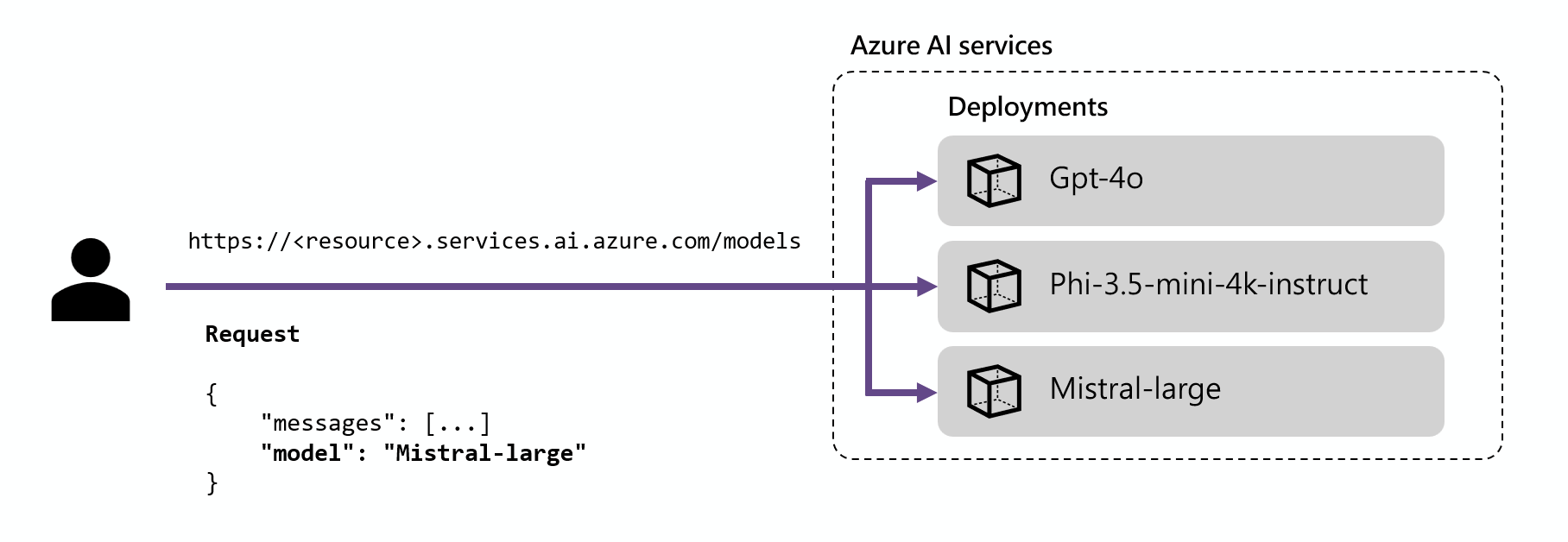

Encaminhamento

O ponto de extremidade de inferência roteia solicitações para uma determinada implantação fazendo a correspondência entre o parâmetro name dentro da solicitação e o nome da implantação. Isso significa que as implantações funcionam como um alias de um determinado modelo em determinadas configurações. Essa flexibilidade permite que você implante um determinado modelo várias vezes no serviço, mas sob configurações diferentes, se necessário.

Por exemplo, se você criar uma implantação chamada Mistral-large, essa implantação poderá ser invocada como:

Instale o pacote azure-ai-inference usando seu gerenciador de pacotes, como pip:

pip install azure-ai-inference

Em seguida, você pode usar o pacote para consumir o modelo. O exemplo a seguir mostra como criar um cliente para consumir finalizações de chat:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Explore nossos exemplos e leia a documentação de referência da API para começar.

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Gorjeta

O roteamento de implantação não diferencia maiúsculas de minúsculas.

SDKs

O ponto de extremidade de inferência do modelo de IA do Azure é suportado por vários SDKs, incluindo o SDK de Inferência do Azure AI, o SDK do Azure AI Foundry e o SDK do Azure OpenAI, que estão disponíveis em vários idiomas. Várias integrações também são suportadas em frameworks populares como LangChain, LangGraph, Llama-Index, Semantic Kernel e AG2. Consulte linguagens de programação e SDKs suportados para obter detalhes.

Ponto de extremidade de inferência do Azure OpenAI

Os modelos do Azure OpenAI implantados em serviços de IA também dão suporte à API do Azure OpenAI. Esta API expõe todos os recursos dos modelos OpenAI e suporta recursos adicionais, como assistentes, threads, arquivos e inferência em lote.

Os pontos de extremidade de inferência do Azure OpenAI funcionam no nível de implantação e eles têm sua própria URL associada a cada um deles. No entanto, o mesmo mecanismo de autenticação pode ser usado para consumi-los. Saiba mais na página de referência da API OpenAI do Azure

Cada implantação tem uma URL que é as concatenações da URL base do Azure OpenAI e a rota /deployments/<model-deployment-name>.

Importante

Não há nenhum mecanismo de roteamento para o ponto de extremidade do Azure OpenAI, pois cada URL é exclusiva para cada implantação de modelo.

SDKs

O ponto de extremidade do Azure OpenAI é suportado pelo SDK do OpenAI (AzureOpenAIclasse) e pelos SDKs do Azure OpenAI, que estão disponíveis em vários idiomas. Consulte os idiomas suportados para obter detalhes.