Acessar o cliente Apache Flink® CLI usando Secure Shell (SSH) no HDInsight em clusters AKS com o portal do Azure

Nota

Vamos desativar o Azure HDInsight no AKS em 31 de janeiro de 2025. Antes de 31 de janeiro de 2025, você precisará migrar suas cargas de trabalho para o Microsoft Fabric ou um produto equivalente do Azure para evitar o encerramento abrupto de suas cargas de trabalho. Os clusters restantes na sua subscrição serão interrompidos e removidos do anfitrião.

Apenas o apoio básico estará disponível até à data da reforma.

Importante

Esta funcionalidade está atualmente em pré-visualização. Os Termos de Utilização Suplementares para Pré-visualizações do Microsoft Azure incluem mais termos legais que se aplicam a funcionalidades do Azure que estão em versão beta, em pré-visualização ou ainda não disponibilizadas para disponibilidade geral. Para obter informações sobre essa visualização específica, consulte Informações de visualização do Azure HDInsight no AKS. Para perguntas ou sugestões de recursos, envie uma solicitação no AskHDInsight com os detalhes e siga-nos para obter mais atualizações na Comunidade do Azure HDInsight.

Este exemplo orienta como inserir o cliente Apache Flink CLI no HDInsight em clusters AKS usando SSH no portal do Azure, abordamos SQL e Flink DataStream.

Pré-requisitos

- É necessário selecionar SSH durante a criação do Flink Cluster

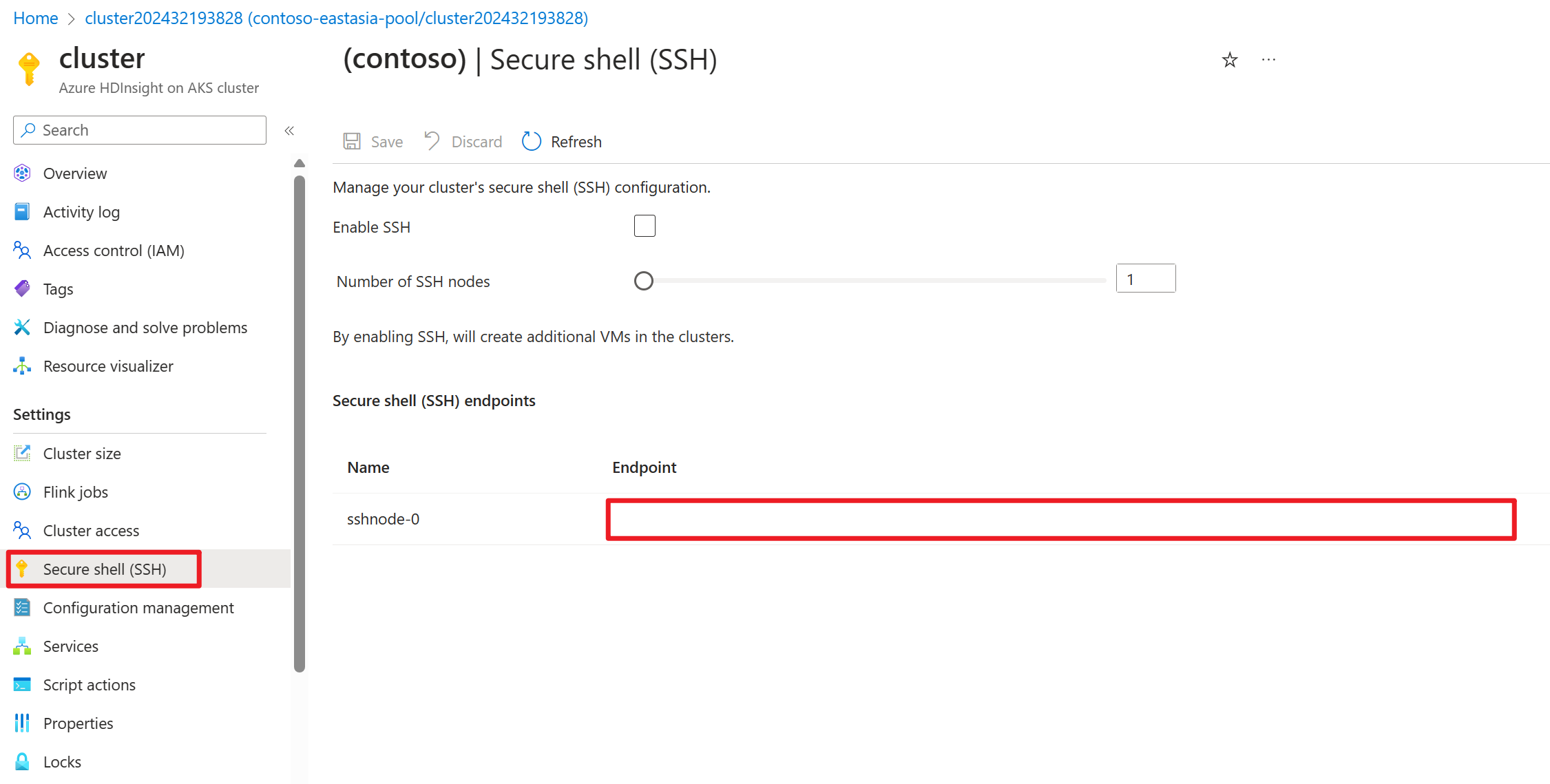

Conectando-se ao SSH a partir do portal do Azure

Depois que o cluster Flink for criado, você poderá observar no painel esquerdo a opção Configurações para acessar o Secure Shell

Apache Flink SQL

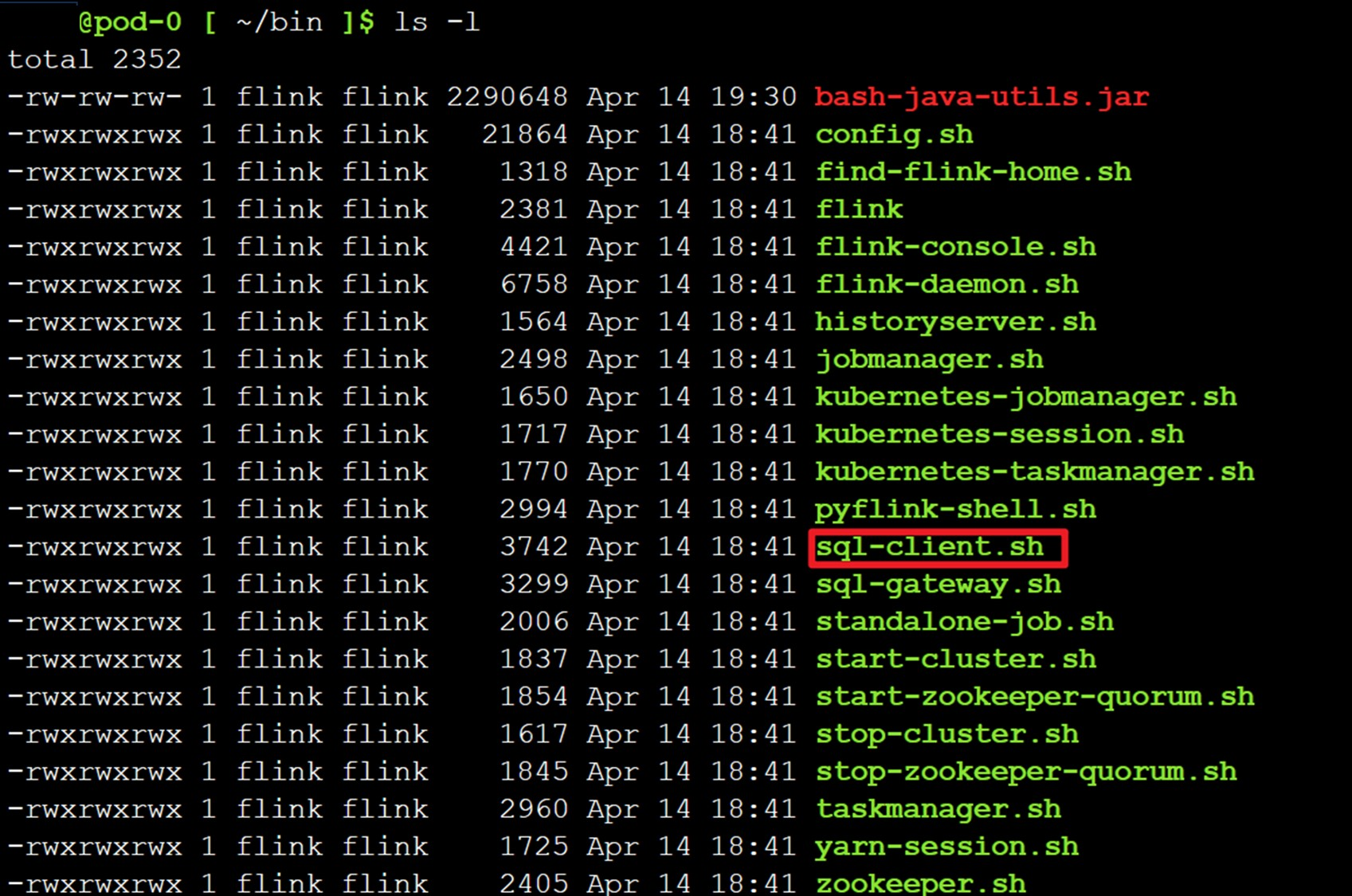

Conectando-se ao cliente SQL

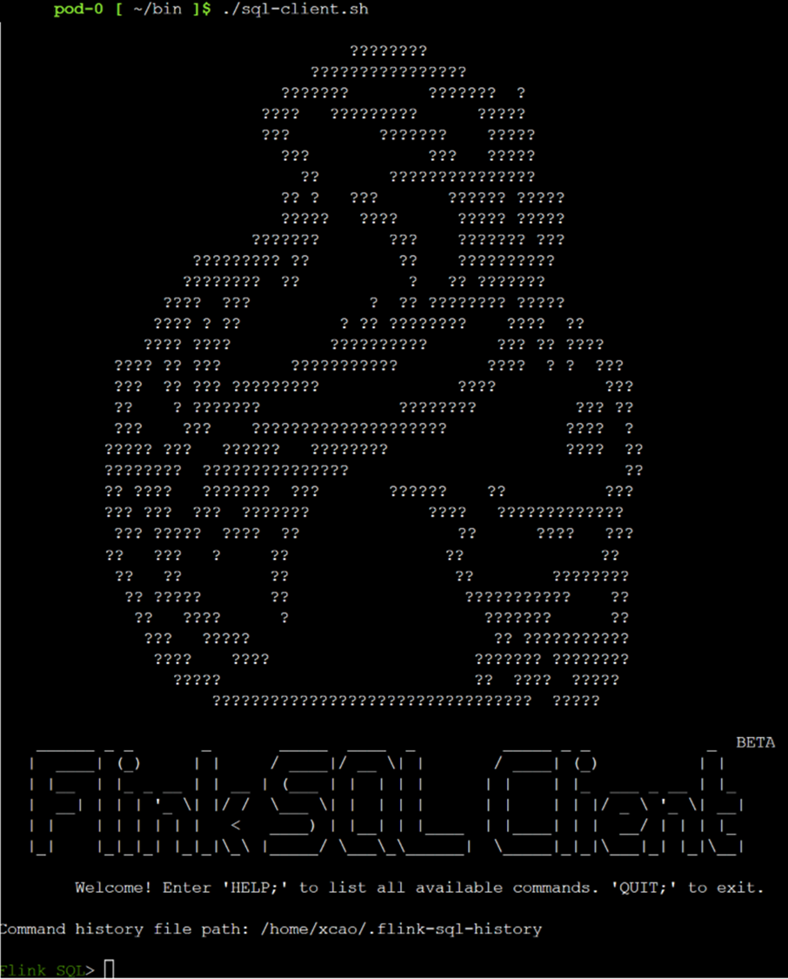

É necessário alterar o diretório para /opt/flink-webssh/bin e, em seguida, executar ./sql-client.sh

Agora você está no SQL Client no Flink

Consulte este documento para realizar mais alguns testes.

Apache Flink DataStream

Flink fornece uma interface de linha de comando (CLI) bin/flink para executar programas que são empacotados como arquivos JAR e para controlar sua execução.

A CLI faz parte do Secure Shell (SSH) e se conecta ao JobManager em execução e usa as configurações de cliente especificadas em conf/flink-conf.yaml.

Enviar um trabalho significa carregar o JAR do trabalho para o pod SSH e iniciar a execução do trabalho. Para ilustrar um exemplo para este artigo, selecionamos um trabalho de longa duração como examples/streaming/StateMachineExample.jar.

Nota

Para gerenciar dependências, a expectativa é construir e enviar um pote gordo para o trabalho.

Carregue o frasco de trabalho gordo da ABFS para o webssh.

Com base no seu caso de uso, é necessário editar as configurações do cliente usando o gerenciamento de configuração do Flink em flink-client-configs.

Vamos correr StateMachineExample.jar

./bin/flink run \ --detached \ ./examples/streaming/StateMachineExample.jar

Nota

Enviar o trabalho usando --detached fará com que o comando retorne após o envio ser feito. A saída contém a ID do trabalho recém-enviado.

Referência

- Flink Cliente SQL

- Apache, Apache Flink, Flink e nomes de projetos de código aberto associados são marcas comerciais da Apache Software Foundation (ASF).