Gerenciamento de configuração do Apache Flink® no HDInsight no AKS

Nota

Vamos desativar o Azure HDInsight no AKS em 31 de janeiro de 2025. Antes de 31 de janeiro de 2025, você precisará migrar suas cargas de trabalho para o Microsoft Fabric ou um produto equivalente do Azure para evitar o encerramento abrupto de suas cargas de trabalho. Os clusters restantes na sua subscrição serão interrompidos e removidos do anfitrião.

Apenas o apoio básico estará disponível até à data da reforma.

Importante

Esta funcionalidade está atualmente em pré-visualização. Os Termos de Utilização Suplementares para Pré-visualizações do Microsoft Azure incluem mais termos legais que se aplicam a funcionalidades do Azure que estão em versão beta, em pré-visualização ou ainda não disponibilizadas para disponibilidade geral. Para obter informações sobre essa visualização específica, consulte Informações de visualização do Azure HDInsight no AKS. Para perguntas ou sugestões de recursos, envie uma solicitação no AskHDInsight com os detalhes e siga-nos para obter mais atualizações na Comunidade do Azure HDInsight.

O HDInsight no AKS fornece um conjunto de configurações padrão do Apache Flink para a maioria das propriedades e algumas com base em perfis de aplicativos comuns. No entanto, caso seja necessário ajustar as propriedades de configuração do Flink para melhorar o desempenho de determinados aplicativos com uso de estado, paralelismo ou configurações de memória, você pode alterar a configuração do trabalho do Flink usando a seção Trabalhos do Flink no HDInsight no cluster AKS.

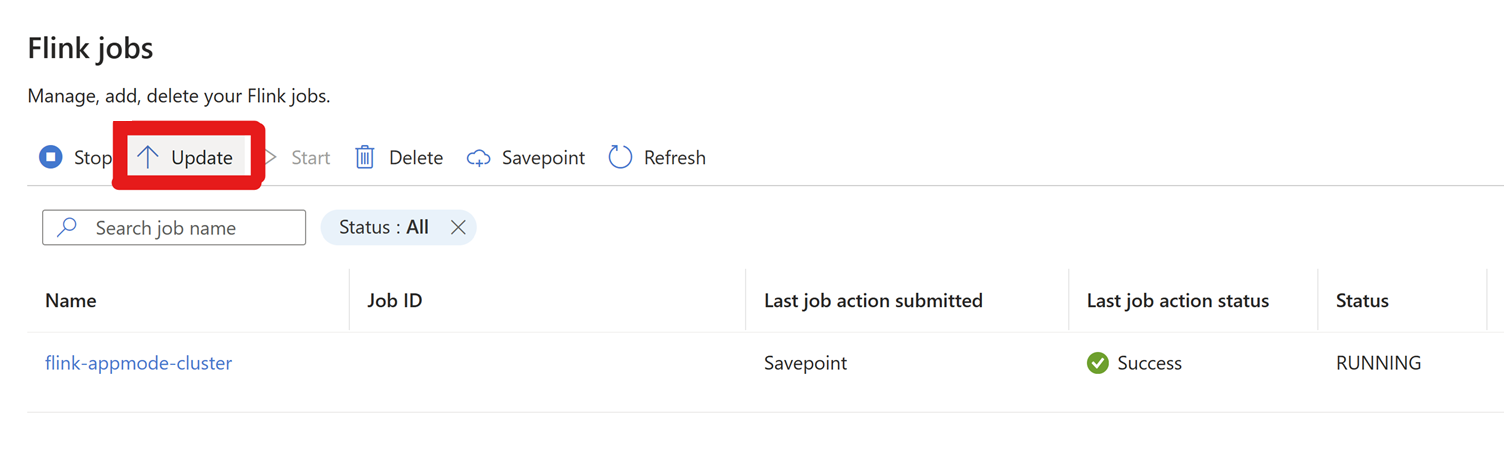

Vá para Configurações > Flink Jobs > Clique em Atualizar.

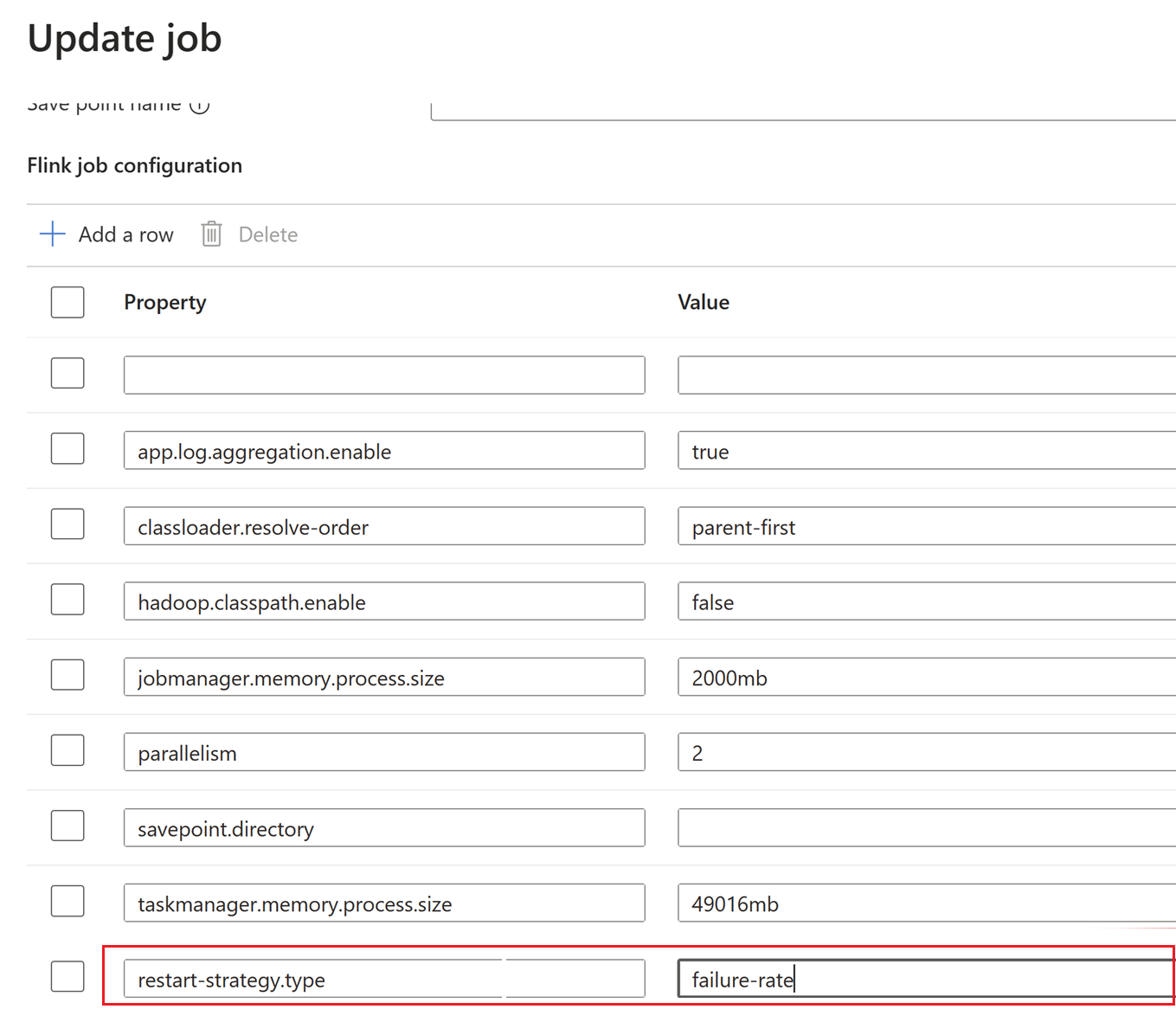

Clique em + Adicionar uma linha para editar a configuração.

Aqui, o intervalo de pontos de verificação é alterado no nível do Cluster.

Atualize as alterações clicando em OK e, em seguida, em Guardar.

Uma vez salvas, as novas configurações são atualizadas em poucos minutos (~5 minutos).

Configurações, que podem ser atualizadas usando as Definições de Gerenciamento de Configuração.

processMemory size:As configurações padrão para o tamanho da memória de processo ou gerenciador de tarefas e gerenciador de tarefas seria a memória configurada pelo usuário durante a criação do cluster.

Esse tamanho pode ser configurado usando a propriedade de configuração abaixo. Para alterar a memória de processo do gerenciador de tarefas, use esta configuração.

taskmanager.memory.process.size : <value>Exemplo:

taskmanager.memory.process.size : 2000mbPara gestor de emprego

jobmanager.memory.process.size : <value>Nota

A memória de processo máxima configurável é igual à memória configurada para

jobmanager/taskmanager.

Intervalo do ponto de verificação

O intervalo de pontos de verificação determina a frequência com que o Flink aciona um ponto de verificação. Definido em milissegundos e pode ser definido usando a seguinte propriedade de configuração

execution.checkpoint.interval: <value>

A configuração padrão é 60.000 milissegundos (1 min), esse valor pode ser alterado conforme desejado.

Back-end de estado

O back-end de estado determina como o Flink gerencia e persiste o estado do seu aplicativo. Isso afeta a forma como os pontos de verificação são armazenados. Você pode configurar o back-end 'state usando a seguinte propriedade:

state.backend: <value>

Por padrão, os clusters Apache Flink no HDInsight no AKS usam o Rocks DB.

Caminho de armazenamento do ponto de verificação

Permitimos pontos de verificação persistentes por padrão, armazenando os pontos de verificação no abfs armazenamento conforme configurado pelo usuário. Mesmo que o trabalho falhe, uma vez que os pontos de verificação são persistentes, ele pode ser facilmente iniciado com o ponto de verificação mais recente.

state.checkpoints.dir: <path> Substitua <path> pelo caminho desejado onde os pontos de verificação foram armazenados.

Por padrão, armazenado na conta de armazenamento (ABFS), configurada pelo usuário. Esse valor pode ser alterado para qualquer caminho desejado, desde que os pods Flink possam acessá-lo.

Máximo de pontos de verificação simultâneos

Você pode limitar o número máximo de pontos de verificação simultâneos definindo a seguinte propriedade: checkpoint.max-concurrent-checkpoints: <value>

Substitua <value> pelo número máximo desejado de pontos de verificação simultâneos. Por exemplo, 1 para permitir apenas um ponto de verificação de cada vez.

Máximo de pontos de verificação retidos

Você pode limitar o número máximo de pontos de verificação a serem retidos definindo a seguinte propriedade: state.checkpoints.num-retained: <value> Substitua <value> pelo número máximo desejado. Por padrão, mantemos no máximo cinco pontos de verificação.

Caminho de armazenamento do ponto de salvamento

Permitimos savepoints persistentes por padrão, armazenando os savepoints no abfs armazenamento (conforme configurado pelo usuário). Se o usuário quiser parar e depois iniciar o trabalho com um determinado savepoint, ele pode configurar esse local.

state.checkpoints.dir: <path> Substitua <path> pelo caminho desejado onde os savepoints foram armazenados.

Por padrão, armazenado na conta de armazenamento, configurado pelo usuário. (Apoiamos a ABFS). Esse valor pode ser alterado para qualquer caminho desejado, desde que os pods Flink possam acessá-lo.

Alta disponibilidade do gestor de empregos

No HDInsight no AKS, o Flink usa o Kubernetes como back-end. Mesmo que o Job Manager falhe no intervalo devido a qualquer problema conhecido/desconhecido, o pod é reiniciado em poucos segundos. Assim, mesmo que o trabalho seja reiniciado devido a esse problema, ele será recuperado de volta do ponto de verificação mais recente.

FAQ

Por que o Job falha no meio? Mesmo que os trabalhos falhem abruptamente, se os pontos de verificação estiverem acontecendo continuamente, o trabalho será reiniciado por padrão a partir do ponto de verificação mais recente.

Mudar a estratégia de emprego pelo meio? Há casos de uso, onde o trabalho precisa ser modificado durante a produção devido a algum bug de nível de trabalho. Durante esse tempo, o usuário pode parar o trabalho, que automaticamente pegaria um savepoint e o salvaria no local do savepoint.

Clique e

savepointaguardesavepointaté ser concluído.Após a conclusão do savepoint, clique em iniciar e a guia Iniciar trabalho aparecerá. Selecione o nome do ponto de salvamento na lista suspensa. Edite todas as configurações, se necessário. E clique em OK.

Como o savepoint é fornecido no trabalho, o Flink sabe por onde começar a processar os dados.

Referência

- Configurações do Apache Flink

- Apache, Apache Kafka, Kafka, Apache Flink, Flink e nomes de projetos de código aberto associados são marcas comerciais da Apache Software Foundation (ASF).