Avaliar Modelo

Importante

O suporte para o Machine Learning Studio (clássico) terminará em 31 de agosto de 2024. É recomendável fazer a transição para o Azure Machine Learning até essa data.

A partir de 1º de dezembro de 2021, você não poderá criar recursos do Machine Learning Studio (clássico). Até 31 de agosto de 2024, você pode continuar usando os recursos existentes do Machine Learning Studio (clássico).

- Confira informações sobre como mover projetos de machine learning do ML Studio (clássico) para o Azure Machine Learning.

- Saiba mais sobre o Azure Machine Learning.

A documentação do ML Studio (clássico) está sendo desativada e pode não ser atualizada no futuro.

Avalia os resultados de um modelo de classificação ou regressão com métricas padrão

Categoria: Machine Learning/Avaliar

Observação

Aplica-se a: somente Machine Learning Studio (clássico)

Módulos semelhantes do tipo "arrastar e soltar" estão disponíveis no designer do Azure Machine Learning.

Visão geral do módulo

Este artigo descreve como usar o módulo Avaliar Modelo no Machine Learning Studio (clássico) para medir a precisão de um modelo treinado. Você fornece um conjunto de dados que contém pontuações geradas por um modelo, e o módulo Avaliar modelo calcula um conjunto de métricas de avaliação padrão do setor.

As métricas retornadas por Avaliar modelo dependem do tipo de modelo em avaliação:

Para modelos de recomendação, use o módulo Avaliar Recomendador .

Dica

Se você não estiver familiarizado com a avaliação do modelo, recomendamos estes exemplos na Galeria de IA do Azure, que criam um modelo e explicam como usar as métricas relacionadas:

- Comparar modelos de regressão

- Comparar classificadores binários

- Comparar classificadores de várias classes

Também recomendamos a série de vídeos do Dr. Stephen Elston, como parte do curso de machine learning da EdX.

Como usar Avaliar modelo

Há três maneiras de usar o módulo Avaliar Modelo :

- Gere pontuações sobre seus dados de treinamento e avalie o modelo com base nessas pontuações

- Gerar pontuações no modelo, mas comparar essas pontuações com as pontuações em um conjunto de teste reservado

- Comparar pontuações para dois modelos diferentes, mas relacionados, usando o mesmo conjunto de dados

Usar os dados de treinamento

Para avaliar um modelo, você deve se conectar a um conjunto de dados que contém um conjunto de colunas de entrada e classificações. Se nenhum outro dado estiver disponível, você poderá usar o conjunto de dados original.

- Conexão a saída do datset pontuado do Modelo de Pontuação para a entrada do Modelo de Avaliação.

- Clique no módulo Avaliar Modelo e selecione Executar selecionado para gerar as pontuações de avaliação.

Usar dados de teste

Um cenário comum no machine learning é separar o conjunto de dados original em conjuntos de dados de treinamento e teste, usando o módulo Dividir ou o módulo Partição e Exemplo .

- Conexão a saída do conjunto de dados pontuado do Modelo de Pontuação à entrada do Modelo de Avaliação.

- Conexão a saída do módulo Dividir Dados que contém os dados de teste para a entrada à direita do Modelo de Avaliação.

- Clique no módulo Avaliar Modelo e selecione Executar selecionado para gerar as pontuações de avaliação.

Comparar pontuações de dois modelos

Você também pode conectar um segundo conjunto de pontuações ao Modelo de Avaliação. As pontuações podem ser um conjunto de avaliação compartilhado que tem resultados conhecidos ou um conjunto de resultados de um modelo diferente para os mesmos dados.

This featureEste recurso é útil pois você pode comparar facilmente resultados de dois modelos diferentes nos mesmos dados. Ou, você pode comparar pontuações de duas execuções diferentes sobre os mesmos dados com parâmetros diferentes.

- Conexão a saída do datset pontuado do Modelo de Pontuação para a entrada do Modelo de Avaliação.

- Conexão a saída do módulo Modelo de Pontuação para o segundo modelo à entrada à direita do Modelo de Avaliação.

- Clique com o botão direito do mouse em Avaliar Modelo e selecione Executar selecionado para gerar as pontuações de avaliação.

Resultados

Depois de executar o Modelo de Avaliação, clique com o botão direito do mouse no módulo e selecione Os resultados da avaliação para ver os resultados. Você pode:

- Salve os resultados como um conjunto de dados para facilitar a análise com outras ferramentas

- Gerar uma visualização na interface do Studio (clássico)

Se você conectar conjuntos de dados a ambas as entradas de Avaliar modelo, os resultados conterão as métricas para o conjunto de dados ou ambos os modelos. O modelo ou dados anexados à porta esquerda é apresentado primeiro no relatório, seguido pelas métricas do conjunto de dados ou modelo anexado à porta direita.

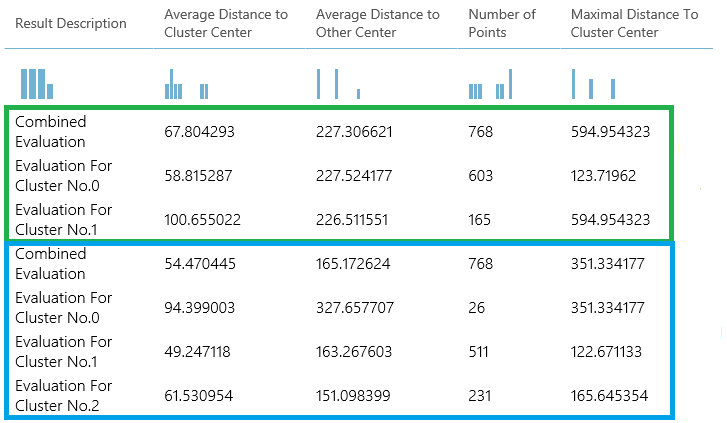

Por exemplo, a imagem a seguir representa uma comparação de resultados de dois modelos de clustering criados com os mesmos dados, mas com parâmetros diferentes.

Como esse é um modelo de clustering, os resultados da avaliação são diferentes da comparação de pontuações de dois modelos de regressão ou de dois modelos de classificação. No entanto, a apresentação geral é a mesma.

Métricas

Esta seção descreve as métricas retornadas para os tipos específicos de modelos com suporte para uso com Avaliar modelo:

Métricas para modelos de classificação

As métricas a seguir são relatadas ao avaliar modelos de classificação. Se você comparar modelos, eles serão classificados pela métrica selecionada para avaliação.

Precisão mede a qualidade de um modelo de classificação como a proporção entre os resultados verdadeiros com o total de casos.

A precisão é a proporção entre os resultados verdadeiros com os resultados positivos.

Recall é a fração de todos os resultados corretos retornados pelo modelo.

A pontuação F é calculada como a média ponderada da precisão e recall entre 0 e 1, onde a pontuação F ideal seria 1.

AUC mede a área sob a curva plotada com verdadeiros positivos no eixo y e falsos positivos no eixo x. Essa métrica é útil porque ele fornece um único número que permite comparar modelos de tipos diferentes.

Perda de registro médio é uma pontuação única usada para expressar a penalidade por resultados errados. Ela é calculada como a diferença entre duas distribuições de probabilidade: o verdadeiro e no modelo.

Perda de log de treinamento é uma pontuação única que representa a vantagem do classificador sobre uma predição aleatória. A perda de log mede a incerteza do seu modelo comparando as probabilidades que ele gera com os valores conhecidos (valor de referência) nos rótulos. O objetivo é minimizar a perda de log do modelo como um todo.

Métricas para modelos de regressão

As métricas retornadas para modelos de regressão geralmente são projetadas para estimar a quantidade de erros. Um modelo é considerado adequado para os dados se a diferença entre os valores observados e previstos for pequena. No entanto, observar o padrão dos resíduos (a diferença entre qualquer ponto previsto e seu valor real correspondente) pode fornecer muitas informações sobre o desvio potencial de um modelo.

As métricas a seguir são relatadas para avaliar modelos de regressão. Quando você compara modelos, eles são classificados pela métrica selecionada para avaliação.

A probabilidade de log negativo mede a função de perda, uma pontuação inferior é melhor. Observe que essa métrica só é calculada para Regressão Linear Bayesiana e Regressão da Floresta de Decisão; para outros algoritmos, o valor é

Infinityo que significa para nada.Erro absoluto médio (MAE) mede a distância das previsões dos resultados reais, assim, quanto menor esse valor, melhor.

Raiz do quadrado médio (RMSE) cria um valor único que resume o erro no modelo. Ao elevar a diferença ao quadrado, a métrica desconsidera a diferença entre uma previsão abaixo e uma previsão acima do valor real.

Erro relativo absoluto (RAE) é a diferença relativa absoluta entre os valores esperado e real. Ele é relativo porque a diferença média é dividida pela média aritmética.

Erro relativo ao quadrado (RSE) normaliza similarmente o erro ao quadrado total dos valores previstos ao dividir pelo erro total ao quadrado dos valores reais.

O MZOE (Erro Médio zero um) indica se a previsão estava correta ou não. Em outras palavras:

ZeroOneLoss(x,y) = 1quandox!=y; caso contrário0.Coeficiente de determinação, frequentemente chamado de R2, representa o poder de previsão do modelo como um valor entre 0 e 1. Zero significa que o modelo é aleatório (não explica nada) e 1 significa que há um ajuste perfeito. No entanto, deve-se ter cuidado ao interpretar valores de R2, pois valores baixos podem ser totalmente normais e valores altos podem ser suspeitos.

Métricas para modelos de clustering

Como os modelos de clustering diferem significativamente dos modelos de classificação e regressão em muitos aspectos, Avaliar modelo também retorna um conjunto diferente de estatísticas para modelos de clustering.

As estatísticas retornadas para um modelo de clustering descrevem quantos pontos de dados foram atribuídos a cada cluster, o valor de separação entre clusters e a densidade dos pontos de dados dentro de cada cluster.

As estatísticas para o modelo de clustering são calculadas em média em todo o conjunto de dados, com linhas adicionais contendo as estatísticas por cluster.

Por exemplo, os resultados a seguir mostram uma parte dos resultados de um experimento de exemplo que agrupa os dados no conjunto de dados de classificação binária de diabetes indiano PIMA, que está disponível no Machine Learning Studio (clássico).

| Descrição do resultado | Distância Média para o Centro de Cluster | Distância média para outro centro | Número de pontos | Distância máxima para o Centro de Cluster |

|---|---|---|---|---|

| Avaliação Combinada | 55.915068 | 169.897505 | 538 | 303.545166 |

| Avaliação do cluster nº 0 | 0 | 1 | 570 | 0 |

| Avaliação para cluster nº 1 | 0 | 1 | 178 | 0 |

| Avaliação do cluster nº 2 | 0 | 1 | 178 | 0 |

Nesses resultados, você obtém as seguintes informações:

O módulo Clustering de Varredura cria vários modelos de clustering, listados em ordem de precisão. Para simplificar, mostramos apenas o modelo mais bem classificado aqui. Os modelos são medidos usando todas as métricas possíveis, mas os modelos são classificados usando a métrica especificada. Se você alterou a métrica, um modelo diferente poderá ser classificado mais alto.

A pontuação de Avaliação Combinada na parte superior de cada seção de resultados lista as pontuações médias para os clusters criados nesse modelo específico.

Esse modelo mais bem classificado passou a criar três clusters; outros modelos podem criar dois clusters ou quatro clusters. Portanto, essa pontuação de avaliação combinada ajuda você a comparar modelos com um número diferente de clusters.

As pontuações na coluna Distância média ao centro de cluster representam a proximidade de todos os pontos em um cluster ao centroide desse cluster.

As pontuações na coluna Distância média a outros centros representam a proximidade, em média, de cada ponto no coluna em relação aos centroides de todos os outros clusters.

Você pode escolher qualquer uma das quatro métricas para medir essa distância, mas todas as medidas devem usar a mesma métrica.

A coluna Número de pontos mostra quantos pontos de dados foram atribuídos a cada cluster, juntamente com o número total geral de pontos de dados em qualquer cluster.

Se o número de pontos de dados atribuídos a clusters for menor que o número total de pontos de dados disponíveis, isso significará que não foi possível atribuir os pontos de dados a um cluster.

As pontuações na coluna, Distância Máxima até o Centro de Cluster, representam a soma das distâncias entre cada ponto e o centroide do cluster desse ponto.

Se esse número for alto, pode significar que o cluster é amplamente disperso. Você deve examinar essa estatística junto com a Distância Média para o Centro de Cluster para determinar a disseminação do cluster.

Exemplos

Para obter exemplos de como gerar, visualizar e interpretar métricas de avaliação, consulte esses experimentos de exemplo na Galeria de IA do Azure. Essas experiências demonstram como criar vários modelos e usar Avaliar Modelo para determinar qual modelo é o melhor.

Comparar classificadores binários: explica como comparar o desempenho de diferentes classificadores criados usando os mesmos dados.

Comparar classificadores de várias classes: demonstra como comparar a precisão de diferentes modelos de classificação criados no conjunto de dados de reconhecimento de letras.

Comparar Regressores: orienta você pelo processo de avaliação de diferentes modelos de regressão.

Estimativa de demanda: saiba como combinar métricas de avaliação de vários modelos.

Previsão de relação do cliente: demonstra como avaliar vários modelos relacionados.

Entradas esperadas

| Nome | Tipo | Descrição |

|---|---|---|

| Conjunto de dados classificado | Tabela de Dados | Conjunto de dados classificado |

| Conjunto de dados classificado a ser comparado | Tabela de Dados | Conjunto de dados classificado a ser comparado (opcional) |

Saídas

| Nome | Tipo | Descrição |

|---|---|---|

| Resultados de avaliação | Tabela de Dados | Resultado da avaliação de dados |

Exceções

| Exceção | Descrição |

|---|---|

| Erro 0003 | Ocorrerá uma exceção se uma ou mais das entradas for nula ou estiver vazia. |

| Erro 0013 | Ocorrerá uma exceção se passado para aprendiz do módulo tiver um tipo inválido. |

| Erro 0020 | Ocorrerá uma exceção se o número de colunas em alguns dos conjuntos de dados transmitidos para o módulo for muito pequeno. |

| Erro 0021 | Ocorrerá uma exceção se o número de linhas em alguns dos conjuntos de dados passados para o módulo for muito pequeno. |

| Erro 0024 | Ocorrerá uma exceção se o conjunto de dados não contiver uma coluna de rótulo. |

| Erro 0025 | Ocorrerá uma exceção se o conjunto de dados não contiver uma coluna de pontuação. |

Confira também

Modelo de validação cruzada

Avaliar o Sistema de Recomendação

Avaliar

Pontuar Modelo